Cloud TPU (Tensor Processing Units)

Accélérez le développement de l'IA avec les TPU Google Cloud

Vous ne savez pas si les TPU sont la réponse à vos besoins ? Découvrez quand utiliser des GPU ou des CPU sur des instances Compute Engine pour exécuter vos charges de travail de machine learning.

Présentation

Qu'est-ce qu'un TPU (Tensor Processing Unit) ?

Les TPU Google Cloud sont des accélérateurs d'IA conçus sur mesure, et optimisés pour l'entraînement et l'inférence de modèles d'IA. Ils conviennent parfaitement à différents cas d'utilisation, tels que les agents, la génération de code, la génération de contenu multimédia, la synthèse vocale, les services de vision, les moteurs de recommandations, les modèles de personnalisation, etc. Les TPU alimentent Gemini et toutes les applications de Google optimisées par l'IA, comme la recherche, Photos et Maps, qui comptent plus d'un milliard d'utilisateurs.

Quels sont les avantages des Cloud TPU ?

Les Cloud TPU sont conçus pour évoluer à moindre coût pour un large éventail de charges de travail d'IA, y compris pour l'entraînement, le réglage et l'inférence. Les Cloud TPU offrent la polyvalence nécessaire pour accélérer les charges de travail sur les principaux frameworks d'IA, y compris PyTorch, JAX et TensorFlow. Orchestrez de manière transparente les charges de travail d'IA à grande échelle grâce à l'intégration de Cloud TPU dans Google Kubernetes Engine (GKE). Utilisez le planificateur de charges de travail dynamique pour améliorer l'évolutivité des charges de travail en planifiant simultanément tous les accélérateurs nécessaires. Les clients qui cherchent le moyen le plus simple de développer des modèles d'IA peuvent également exploiter les Cloud TPU dans Vertex AI, une plate-forme d'IA entièrement gérée.

Quand utiliser les Cloud TPU ?

En quoi les Cloud TPU sont-ils différents des GPU ?

Un GPU est un processeur spécialisé initialement conçu pour manipuler des éléments graphiques réalisés par ordinateur. Grâce à sa structure parallèle, il constitue une solution idéale pour les algorithmes qui traitent de grands blocs de données qu'on rencontre couramment dans les charges de travail d'IA. En savoir plus

Un TPU est un circuit intégré propre à une application (ASIC) spécialement développé par Google pour les réseaux de neurones. Il possède des fonctionnalités spécialisées, telles que l'unité de multiplication de matrice (MXU) et une topologie d'interconnexion propriétaire, ce qui le rend idéal pour accélérer l'entraînement et l'inférence de l'IA.

Versions de Cloud TPU

| Version de Cloud TPU | Description | Qui peut en bénéficier ? |

|---|---|---|

Ironwood | Notre TPU le plus puissant et le plus efficace à ce jour, pour l'entraînement et l'inférence à grande échelle | Le TPU Ironwood sera en disponibilité générale au quatrième trimestre 2025 |

Trillium | TPU de sixième génération. Amélioration de l'efficacité énergétique et des performances de calcul maximales par puce pour l'entraînement et l'inférence | Trillium est en disponibilité générale en Amérique du Nord (région US East), en Europe (région West) et en Asie (région Northeast). |

Cloud TPU v5p | TPU puissant pour créer des modèles de fondation volumineux et complexes | Cloud TPU v5p est en disponibilité générale en Amérique du Nord (région "us-east") |

Cloud TPU v5e | TPU économique et accessible pour les charges de travail d'entraînement et d'inférence à moyenne et grande échelle | Cloud TPU v5e est en disponibilité générale en Amérique du Nord (régions Centre/Est/Sud/Ouest des États-Unis), en Europe (région Ouest) et en Asie (région Sud-Est). |

Informations supplémentaires sur les versions de Cloud TPU

Ironwood

Notre TPU le plus puissant et le plus efficace à ce jour, pour l'entraînement et l'inférence à grande échelle

Le TPU Ironwood sera en disponibilité générale au quatrième trimestre 2025

Trillium

TPU de sixième génération. Amélioration de l'efficacité énergétique et des performances de calcul maximales par puce pour l'entraînement et l'inférence

Trillium est en disponibilité générale en Amérique du Nord (région US East), en Europe (région West) et en Asie (région Northeast).

Cloud TPU v5p

TPU puissant pour créer des modèles de fondation volumineux et complexes

Cloud TPU v5p est en disponibilité générale en Amérique du Nord (région "us-east")

Cloud TPU v5e

TPU économique et accessible pour les charges de travail d'entraînement et d'inférence à moyenne et grande échelle

Cloud TPU v5e est en disponibilité générale en Amérique du Nord (régions Centre/Est/Sud/Ouest des États-Unis), en Europe (région Ouest) et en Asie (région Sud-Est).

Informations supplémentaires sur les versions de Cloud TPU

Fonctionnement

Découvrez la magie des TPU Google Cloud, y compris une vue exceptionnelle des centres de données où se déroule toute l'action. Nos clients utilisent des Cloud TPU pour exécuter certaines des charges de travail d'IA les plus importantes au monde, et cette puissance ne se résume pas à une simple puce. Dans cette vidéo, découvrez les composants du système TPU : mise en réseau de centres de données, commutateurs de circuits optiques, systèmes de refroidissement à eau, vérification de la sécurité biométrique, etc.

Découvrez la magie des TPU Google Cloud, y compris une vue exceptionnelle des centres de données où se déroule toute l'action. Nos clients utilisent des Cloud TPU pour exécuter certaines des charges de travail d'IA les plus importantes au monde, et cette puissance ne se résume pas à une simple puce. Dans cette vidéo, découvrez les composants du système TPU : mise en réseau de centres de données, commutateurs de circuits optiques, systèmes de refroidissement à eau, vérification de la sécurité biométrique, etc.

Utilisations courantes

Exécutez des charges de travail d'entraînement d'IA à grande échelle

Scaling de votre modèle

L'entraînement des LLM semble souvent relever de l'alchimie, mais il n'est pas impossible de comprendre et d'optimiser les performances de vos modèles. Ce livre vise à démystifier la science du scaling des modèles de langage sur les TPU : comment les TPU fonctionnent et communiquent entre eux, comment les LLM s'exécutent sur du matériel réel, et comment charger en paralléle vos modèles pendant l'entraînement et l'inférence afin qu'ils s'exécutent efficacement à grande échelle.

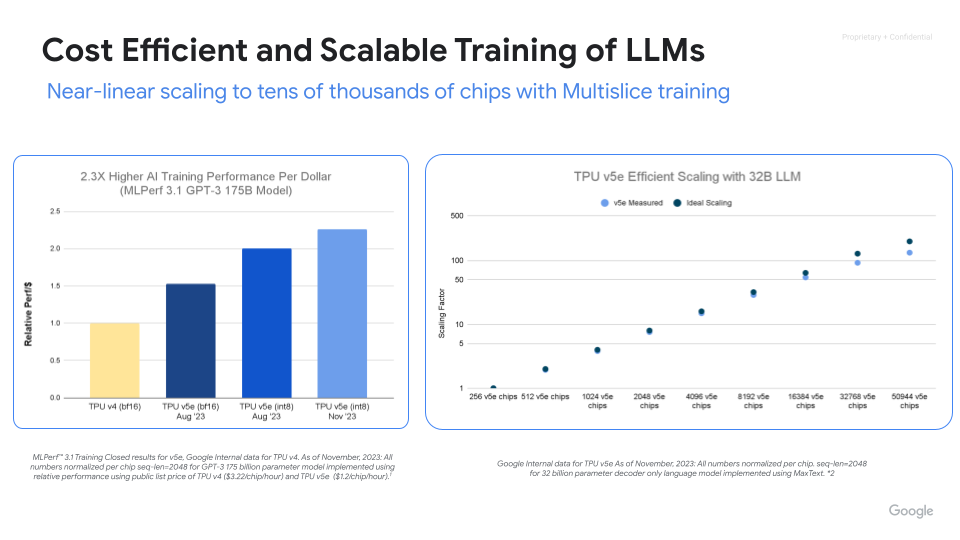

Entraînement d'IA performant, évolutif et efficace

Maximisez les performances, l'efficacité et le retour sur investissement avec les Cloud TPU.Exploitez des milliers de chips avec l'entraînement multitranche Cloud TPU.Mesurez et améliorez la productivité lors de l'entraînement de ML à grande échelle avec ML Goodput Measurement.Lancez-vous rapidement avec MaxText et MaxDiffusion, des déploiements de référence Open Source pour l'entraînement de modèles à grande échelle.

Guides pratiques

Scaling de votre modèle

L'entraînement des LLM semble souvent relever de l'alchimie, mais il n'est pas impossible de comprendre et d'optimiser les performances de vos modèles. Ce livre vise à démystifier la science du scaling des modèles de langage sur les TPU : comment les TPU fonctionnent et communiquent entre eux, comment les LLM s'exécutent sur du matériel réel, et comment charger en paralléle vos modèles pendant l'entraînement et l'inférence afin qu'ils s'exécutent efficacement à grande échelle.

Autres ressources

Entraînement d'IA performant, évolutif et efficace

Maximisez les performances, l'efficacité et le retour sur investissement avec les Cloud TPU.Exploitez des milliers de chips avec l'entraînement multitranche Cloud TPU.Mesurez et améliorez la productivité lors de l'entraînement de ML à grande échelle avec ML Goodput Measurement.Lancez-vous rapidement avec MaxText et MaxDiffusion, des déploiements de référence Open Source pour l'entraînement de modèles à grande échelle.

Ajustez les modèles d'IA de base

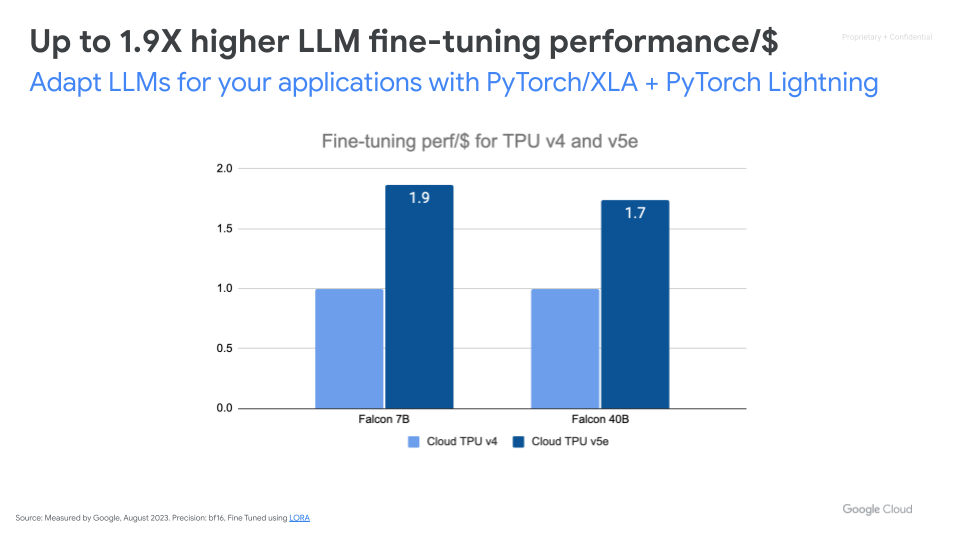

Adaptez les LLM à vos applications avec Pytorch/XLA

Affinez efficacement les modèles de fondation en exploitant vos propres données d'entraînement correspondant à votre cas d'utilisation. Cloud TPU v5e offre des performances de réglage de LLM jusqu'à 1,9 fois supérieures pour chaque dollar dépensé par rapport à Cloud TPU v4.

Autres ressources

Adaptez les LLM à vos applications avec Pytorch/XLA

Affinez efficacement les modèles de fondation en exploitant vos propres données d'entraînement correspondant à votre cas d'utilisation. Cloud TPU v5e offre des performances de réglage de LLM jusqu'à 1,9 fois supérieures pour chaque dollar dépensé par rapport à Cloud TPU v4.

Diffusez des charges de travail d'inférence d'IA à grande échelle

Inférence hautes performances, évolutive et économique

Accélérez l'inférence de l'IA avec vLLM et MaxDiffusion. vLLM est un moteur d'inférence Open Source populaire, conçu pour atteindre un débit élevé et une faible latence pour l'inférence de grands modèles de langage (LLM). Basé sur tpu-inference, vLLM propose désormais vLLM TPU pour l'inférence LLM à haut débit et à faible latence. Il rassemble JAX et PyTorch, ce qui lui permet de prendre en charge un plus grand nombre de modèles (Gemma, Llama, Qwen) et des fonctionnalités améliorées. MaxDiffusion optimise l'inférence des modèles de diffusion sur les Cloud TPU pour obtenir des performances élevées.

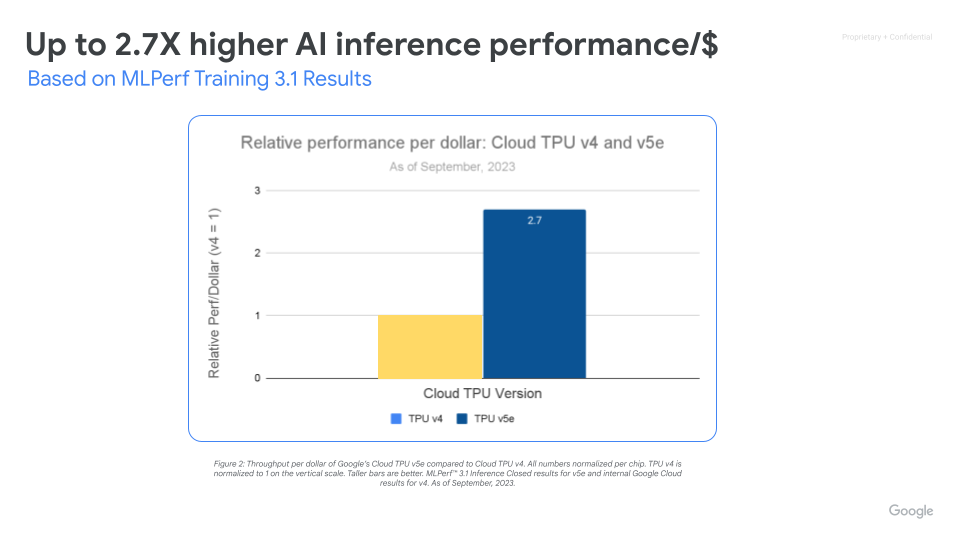

Maximisez vos performances/$ grâce à l'infrastructure AI Infrastructure évolutive

Cloud TPU v5e permet des inférences hautes performances et économiques pour un large éventail de charges de travail d'IA, y compris les derniers modèles LLM et d'IA générative. TPU v5e offre des performances de débit jusqu'à 2,5 fois supérieures par dollar et jusqu'à 1,7 fois plus vite qu'avec Cloud TPU v4. Chaque puce de TPU v5e assure jusqu'à 393 000 milliards d'opérations int8 par seconde, ce qui permet à des modèles complexes de réaliser des prédictions rapides. Un pod de TPU v5e fournit jusqu'à 100 quadrillions d'opérations int8 par seconde, soit 100 pétaOps de puissance de calcul.

Guides pratiques

Inférence hautes performances, évolutive et économique

Accélérez l'inférence de l'IA avec vLLM et MaxDiffusion. vLLM est un moteur d'inférence Open Source populaire, conçu pour atteindre un débit élevé et une faible latence pour l'inférence de grands modèles de langage (LLM). Basé sur tpu-inference, vLLM propose désormais vLLM TPU pour l'inférence LLM à haut débit et à faible latence. Il rassemble JAX et PyTorch, ce qui lui permet de prendre en charge un plus grand nombre de modèles (Gemma, Llama, Qwen) et des fonctionnalités améliorées. MaxDiffusion optimise l'inférence des modèles de diffusion sur les Cloud TPU pour obtenir des performances élevées.

Autres ressources

Maximisez vos performances/$ grâce à l'infrastructure AI Infrastructure évolutive

Cloud TPU v5e permet des inférences hautes performances et économiques pour un large éventail de charges de travail d'IA, y compris les derniers modèles LLM et d'IA générative. TPU v5e offre des performances de débit jusqu'à 2,5 fois supérieures par dollar et jusqu'à 1,7 fois plus vite qu'avec Cloud TPU v4. Chaque puce de TPU v5e assure jusqu'à 393 000 milliards d'opérations int8 par seconde, ce qui permet à des modèles complexes de réaliser des prédictions rapides. Un pod de TPU v5e fournit jusqu'à 100 quadrillions d'opérations int8 par seconde, soit 100 pétaOps de puissance de calcul.

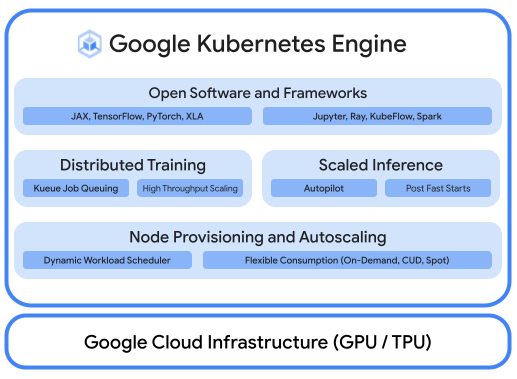

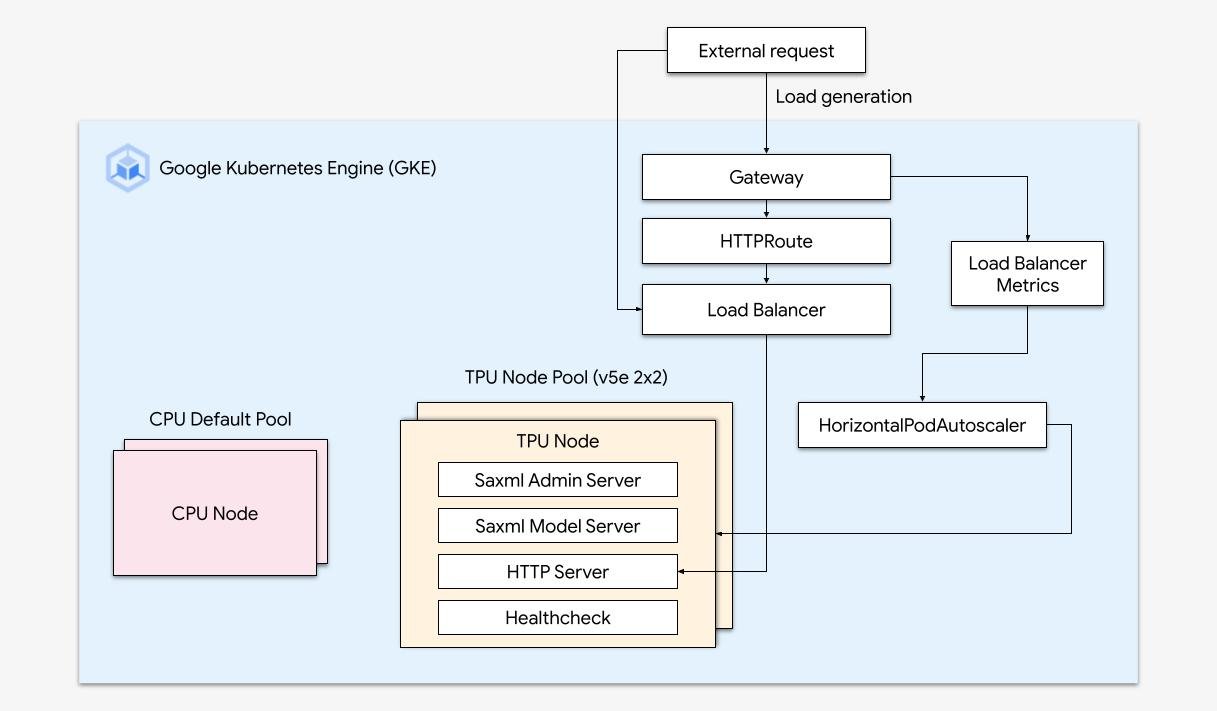

Cloud TPU dans GKE

Exécuter des charges de travail d'IA optimisées avec l'orchestration de plates-formes

Une plate-forme de ML et d'IA robuste offre les éléments suivants : (i) orchestration d'infrastructure compatible avec les GPU pour l'entraînement et l'inférence des charges de travail à grande échelle, (ii) intégration flexible avec des frameworks de calcul et de traitement des données distribués, et (iii) possibilité pour plusieurs équipes d'utiliser la même infrastructure dans l'optique d'optimiser l'utilisation des ressources.

Scaling facile avec GKE

Alliez la puissance des Cloud TPU à la flexibilité et l'évolutivité de GKE pour créer et déployer des modèles de machine learning plus rapidement et plus facilement que jamais. Grâce aux Cloud TPU disponibles dans GKE, vous pouvez désormais disposer d'un environnement opérationnel cohérent unique pour toutes vos charges de travail et standardiser les pipelines MLOps automatisés.

Guides pratiques

Exécuter des charges de travail d'IA optimisées avec l'orchestration de plates-formes

Une plate-forme de ML et d'IA robuste offre les éléments suivants : (i) orchestration d'infrastructure compatible avec les GPU pour l'entraînement et l'inférence des charges de travail à grande échelle, (ii) intégration flexible avec des frameworks de calcul et de traitement des données distribués, et (iii) possibilité pour plusieurs équipes d'utiliser la même infrastructure dans l'optique d'optimiser l'utilisation des ressources.

Autres ressources

Scaling facile avec GKE

Alliez la puissance des Cloud TPU à la flexibilité et l'évolutivité de GKE pour créer et déployer des modèles de machine learning plus rapidement et plus facilement que jamais. Grâce aux Cloud TPU disponibles dans GKE, vous pouvez désormais disposer d'un environnement opérationnel cohérent unique pour toutes vos charges de travail et standardiser les pipelines MLOps automatisés.

Cloud TPU dans Vertex AI

Vertex AI Training et Predictions avec des Cloud TPU

Pour les clients qui cherchent le moyen le plus simple de développer des modèles d'IA, vous pouvez déployer Cloud TPU v5e avec Vertex AI, une plate-forme de bout en bout permettant de créer des modèles d'IA sur une infrastructure entièrement gérée et conçue spécialement pour la diffusion à faible latence et l'entraînement hautes performances.

Autres ressources

Vertex AI Training et Predictions avec des Cloud TPU

Pour les clients qui cherchent le moyen le plus simple de développer des modèles d'IA, vous pouvez déployer Cloud TPU v5e avec Vertex AI, une plate-forme de bout en bout permettant de créer des modèles d'IA sur une infrastructure entièrement gérée et conçue spécialement pour la diffusion à faible latence et l'entraînement hautes performances.

Tarification

| Tarifs de Cloud TPU | Tous les tarifs de Cloud TPU sont calculés par puce-heure | ||

|---|---|---|---|

| Version de Cloud TPU | Tarif d'évaluation (USD) | Engagement sur un an (USD) | Engagement sur trois ans (USD) |

Trillium | À partir de 2,7000 $ par puce heure | À partir de 1,8900 $ par puce heure | À partir de 1,2200 $ par puce heure |

Cloud TPU v5p | À partir de 4,2000 $ par puce heure | À partir de 2,9400 $ par puce heure | À partir de 1,8900 $ par puce heure |

Cloud TPU v5e | À partir de 1,2000 $ par puce heure | À partir de 0,8400 $ par puce heure | À partir de 0,5400 $ par puce heure |

Les tarifs de Cloud TPU varient selon le produit et la région.

Tarifs de Cloud TPU

Tous les tarifs de Cloud TPU sont calculés par puce-heure

Trillium

Starting at

2,7000 $

par puce heure

Starting at

1,8900 $

par puce heure

Starting at

1,2200 $

par puce heure

Cloud TPU v5p

Starting at

4,2000 $

par puce heure

Starting at

2,9400 $

par puce heure

Starting at

1,8900 $

par puce heure

Cloud TPU v5e

Starting at

1,2000 $

par puce heure

Starting at

0,8400 $

par puce heure

Starting at

0,5400 $

par puce heure

Les tarifs de Cloud TPU varient selon le produit et la région.