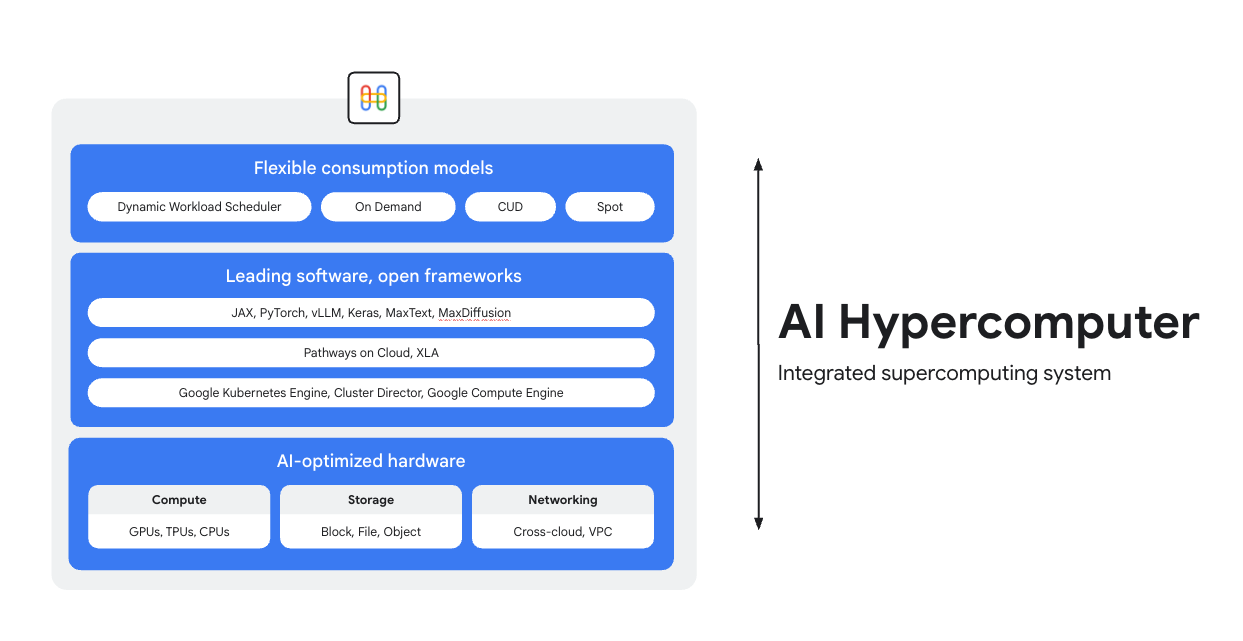

在 AI 超级计算机上进行训练、调优和部署

AI Hypercomputer 是 Google Cloud 上每个 AI 工作负载背后的集成式超级计算系统。它由硬件、软件和使用模式组成,旨在简化 AI 部署、提升系统级效率并优化成本。

概览

AI 优化型硬件

领先的软件,开放式框架

借助业界领先的软件,充分发挥硬件性能。该软件集成了开放框架、库和编译器,有助于提高 AI 开发、集成与管理效率。

- 支持 PyTorch、JAX、Keras、vLLM、Megatron-LM、NeMo Megatron、MaxText、MaxDiffusion 等。

- 与 XLA 编译器深度集成,可实现不同加速器之间的互操作性;Pathways on Cloud 则可让您使用同一个支持 Google 内部大规模训练与推理基础设施的分布式运行时。

- 所有这些都可部署在您选择的环境中,无论是 Google Kubernetes Engine、Cluster Director 还是 Google Compute Engine。

灵活的使用模式

常见用途

以经济高效的方式大规模部署模型

最大化推理工作负载的性价比和可靠性

推理正在迅速变得更加多样和复杂,主要体现在以下三个方面:

- 首先,我们与 AI 的交互方式正在发生变化。现在的对话拥有更长、更丰富的上下文内容。

- 其次,复杂推理和多步推理正推动混合专家模型 (MoE) 的普及。这正在重新定义从初始输入到最终输出的内存和计算资源的扩展方式。

- 最后,很明显,真正的价值不仅在于每美元可获得的词元数量,更在于回答的实用性。模型是否具备相应的专业能力?它是否准确回答了关键业务问题?因此,我们认为客户需要更优的衡量标准,应重点关注系统运营的总成本,而非处理器的价格。

探索 AI 推理资源

- AI 推理是什么?我们提供了涵盖类型、对比和使用场景的全面指南

- 借助 GKE Inference Quickstart 运行最佳实践推理 recipe

- 参加在 Cloud Run 上进行 AI 推理的课程

- 观看此视频,了解实现经济高效 AI 推理的秘诀

- 了解如何加速 AI 推理型工作负载

AI 让体育迷变身运动套装设计师

PUMA 与 Google Cloud 合作以利用其集成式 AI 基础设施 (AI Hypercomputer),通过本次合作可以使用 Gemini 处理用户提示并使用动态工作负载调度器在 GPU 上动态扩缩推理,从而大幅降低成本和生成时间。

影响:

- 他们将 AI 生成运动装备的时间从 2-5 分钟缩短到了 30 秒。这将该平台转变为真正互动的快速体验,吸引用户保持互动。

- 短短 10 天内,粉丝们就创建了 18 万套运动装备,并投出了 170 万次评分。

- 这个项目为 PUMA 开辟了一种与其社群建立联系的新方式。它成功地将粉丝转变为积极的共同创作者,超越了简单的品牌与消费者的关系,让公司可以直接、实时地洞察最热情的消费者的创意需求。

方法指南

最大化推理工作负载的性价比和可靠性

推理正在迅速变得更加多样和复杂,主要体现在以下三个方面:

- 首先,我们与 AI 的交互方式正在发生变化。现在的对话拥有更长、更丰富的上下文内容。

- 其次,复杂推理和多步推理正推动混合专家模型 (MoE) 的普及。这正在重新定义从初始输入到最终输出的内存和计算资源的扩展方式。

- 最后,很明显,真正的价值不仅在于每美元可获得的词元数量,更在于回答的实用性。模型是否具备相应的专业能力?它是否准确回答了关键业务问题?因此,我们认为客户需要更优的衡量标准,应重点关注系统运营的总成本,而非处理器的价格。

其他资源

探索 AI 推理资源

- AI 推理是什么?我们提供了涵盖类型、对比和使用场景的全面指南

- 借助 GKE Inference Quickstart 运行最佳实践推理 recipe

- 参加在 Cloud Run 上进行 AI 推理的课程

- 观看此视频,了解实现经济高效 AI 推理的秘诀

- 了解如何加速 AI 推理型工作负载

客户案例

AI 让体育迷变身运动套装设计师

PUMA 与 Google Cloud 合作以利用其集成式 AI 基础设施 (AI Hypercomputer),通过本次合作可以使用 Gemini 处理用户提示并使用动态工作负载调度器在 GPU 上动态扩缩推理,从而大幅降低成本和生成时间。

影响:

- 他们将 AI 生成运动装备的时间从 2-5 分钟缩短到了 30 秒。这将该平台转变为真正互动的快速体验,吸引用户保持互动。

- 短短 10 天内,粉丝们就创建了 18 万套运动装备,并投出了 170 万次评分。

- 这个项目为 PUMA 开辟了一种与其社群建立联系的新方式。它成功地将粉丝转变为积极的共同创作者,超越了简单的品牌与消费者的关系,让公司可以直接、实时地洞察最热情的消费者的创意需求。

运行大规模 AI 训练和预训练

强大、可伸缩且高效的 AI 训练

训练工作负载需在紧密耦合的集群中跨数千个节点以高度同步的作业形式运行。单个降级节点可能会中断整个作业,进而延迟产品上市时间。您需要执行的操作:

- 确保快速设置集群,并针对相关工作负载进行优化调整

- 预测故障并快速进行排查

- 即使发生故障,也能继续运行工作负载

我们希望让客户非常轻松地在 Google Cloud 上部署和扩缩训练工作负载。

强大、可伸缩且高效的 AI 训练

如需创建 AI 集群,请先从我们的任一教程入手:

- 使用 GPU(A4 虚拟机)和 Cluster Toolkit 创建 Slurm 集群

- 使用 Cluster Director for GKE 或 Cluster Toolkit 创建 GKE 集群

Moloco 构建了一个广告投放平台,每天处理数十亿个请求

Moloco 依靠 AI Hypercomputer 的完全集成式堆栈,在 TPU 和 GPU 等高级硬件上自动扩缩,这让 Moloco 工程师得以解放出来;同时,与 Google 业界领先的数据平台集成,为 AI 工作负载创建了一个统一连贯的端到端系统。

在推出首个深度学习模型后,Moloco 实现了爆发式增长和盈利,在 2 年半的时间里增长了 5 倍,并实现了以下目标:

- 借助 GKE 上的 Cloud TPU,将模型训练速度提升至原来的 10 倍,同时将训练成本降低至原来的 1/4

- 扩展后可为 1,000 多名内部用户提供服务,让他们能够访问全球规模的机器学习系统,帮助他们从自己的数据中找到盈利增长点

方法指南

其他资源

强大、可伸缩且高效的 AI 训练

如需创建 AI 集群,请先从我们的任一教程入手:

- 使用 GPU(A4 虚拟机)和 Cluster Toolkit 创建 Slurm 集群

- 使用 Cluster Director for GKE 或 Cluster Toolkit 创建 GKE 集群

客户案例

Moloco 构建了一个广告投放平台,每天处理数十亿个请求

Moloco 依靠 AI Hypercomputer 的完全集成式堆栈,在 TPU 和 GPU 等高级硬件上自动扩缩,这让 Moloco 工程师得以解放出来;同时,与 Google 业界领先的数据平台集成,为 AI 工作负载创建了一个统一连贯的端到端系统。

在推出首个深度学习模型后,Moloco 实现了爆发式增长和盈利,在 2 年半的时间里增长了 5 倍,并实现了以下目标:

- 借助 GKE 上的 Cloud TPU,将模型训练速度提升至原来的 10 倍,同时将训练成本降低至原来的 1/4

- 扩展后可为 1,000 多名内部用户提供服务,让他们能够访问全球规模的机器学习系统,帮助他们从自己的数据中找到盈利增长点

部署和编排 AI 应用

借助领先的 AI 编排软件和开放框架,提供由 AI 赋能的体验

Google Cloud 提供包含常见操作系统、框架、库和驱动的镜像。AI Hypercomputer 会优化这些预配置镜像,以更好地支持您的 AI 工作负载。

- AI 和机器学习框架与库:使用 Deep Learning Software Layer (DLSL) Docker 映像在 Google Kubernetes Engine (GKE) 集群上运行 NeMO 和 MaxText 等机器学习模型。

- 集群部署和 AI 编排:您可以将 AI 工作负载部署至 GKE 集群、Slurm 集群或 Compute Engine 实例;如需了解详情,请参阅虚拟机和集群创建概览

探索软件资源

- Pathways on Cloud 是一种用于构建大规模、多任务且稀疏激活的机器学习系统的架构。

- 借助我们的 Goodput recipe,优化您的机器学习效率

- 通过拓扑感知调度安排 GKE 工作负载

- 尝试我们的基准测试 recipe,在 GPU 上运行 DeepSeek、Mixtral、Llama 和 GPT 模型

- 选择一种使用选项,以更高效地获取和使用计算资源

Priceline:助力旅客打造独特的体验

“与 Google Cloud 合作采用生成式 AI 后,我们通过聊天机器人就能提供定制旅行规划服务。我们的目标不仅仅是为客户安排行程,还要协助他们打造独特的旅行体验。”Martin Brodbeck,Priceline 首席技术官

方法指南

借助领先的 AI 编排软件和开放框架,提供由 AI 赋能的体验

Google Cloud 提供包含常见操作系统、框架、库和驱动的镜像。AI Hypercomputer 会优化这些预配置镜像,以更好地支持您的 AI 工作负载。

- AI 和机器学习框架与库:使用 Deep Learning Software Layer (DLSL) Docker 映像在 Google Kubernetes Engine (GKE) 集群上运行 NeMO 和 MaxText 等机器学习模型。

- 集群部署和 AI 编排:您可以将 AI 工作负载部署至 GKE 集群、Slurm 集群或 Compute Engine 实例;如需了解详情,请参阅虚拟机和集群创建概览

其他资源

探索软件资源

- Pathways on Cloud 是一种用于构建大规模、多任务且稀疏激活的机器学习系统的架构。

- 借助我们的 Goodput recipe,优化您的机器学习效率

- 通过拓扑感知调度安排 GKE 工作负载

- 尝试我们的基准测试 recipe,在 GPU 上运行 DeepSeek、Mixtral、Llama 和 GPT 模型

- 选择一种使用选项,以更高效地获取和使用计算资源

客户案例

Priceline:助力旅客打造独特的体验

“与 Google Cloud 合作采用生成式 AI 后,我们通过聊天机器人就能提供定制旅行规划服务。我们的目标不仅仅是为客户安排行程,还要协助他们打造独特的旅行体验。”Martin Brodbeck,Priceline 首席技术官

常见问题解答

与仅使用单个云服务相比,AI Hypercomputer 有何不同?

虽然各项服务提供特定功能,但 AI Hypercomputer 提供了一个集成系统,其中的硬件、软件与使用模式经过协同设计,可实现最佳运行效果。这种集成在性能、成本和上市时间方面带来了系统级的效率提升,而通过拼接不同的服务往往难以达到这一效果。它简化了复杂系统,并为 AI Infrastructure 提供全面的解决方案。

AI Hypercomputer 能在混合云或多云环境中使用吗?

没错,AI Hypercomputer 在设计时充分考虑了灵活性。Cross-Cloud Interconnect 等技术可为本地数据中心与其他云平台提供高带宽连接,从而加速混合云与多云 AI 策略的实施。我们采用开放标准,并集成主流第三方软件,使您能够构建跨多个环境的解决方案,并按需更换服务。

AI Hypercomputer 如何保障 AI 工作负载的安全?

安全性是 AI Hypercomputer 的核心组成部分。它受益于 Google Cloud 的多层安全模型。具体功能包括 Titan 安全微控制器(确保系统从可信状态启动)、RDMA 防火墙(在训练期间实现 TPU/GPU 之间的零信任网络连接),以及与 Model Armor 等 AI 安全解决方案的集成。这些功能还辅以诸如安全 AI 框架等稳健的基础设施安全政策与原则。

如何最简单地将 AI Hypercomputer 用作基础设施?

- 如果您不想管理虚拟机,建议您从 Google Kubernetes Engine (GKE) 入手

- 如果您需要使用多个调度器,或者无法使用 GKE,建议使用 Cluster Director

- 如果您希望完全掌控基础设施,唯一的实现方式是直接使用虚拟机,而 Compute Engine 是您的最佳选择

它仅适用于大型或高规模的工作负载吗?

否。AI Hypercomputer 可用于任意规模的工作负载。即使是较小规模的工作负载,也能充分发挥集成系统的各项优势,例如高效性和部署简化。AI Hypercomputer 还可在客户业务扩展过程中提供支持,从小型概念验证和试验阶段到大规模生产部署,始终保持灵活应对。

AI Hypercomputer 是在 Google Cloud 上启动 AI 工作负载的最简便方式吗?

对于大多数客户而言,像 Vertex AI 这样的托管式 AI 平台是最简单的 AI 入门方式,因为其中内置了所有工具、模板和模型。此外,Vertex AI 由 AI Hypercomputer 提供支持,并以对您有利的方式进行了优化。Vertex AI 是最便捷的入门途径,因为它提供了最简化的体验。如果您希望自行配置和优化基础设施的每个组件,则可以将 AI Hypercomputer 的各个组件作为基础设施访问,并按您的需求进行组装。

由于 AI Hypercomputer 是一套可组合系统,存在众多选项 - 您是否为每种使用场景都提供了最佳实践?

是的,我们正在 GitHub 中构建一个 recipe 库。您还可以使用 Cluster Toolkit 获取预构建的集群蓝图。

将 AI Hypercomputer 用作 IaaS 时,有哪些可用选项?

AI 优化型硬件

存储

- 训练:Managed Lustre 非常适合对吞吐量和容量要求严苛的 AI 训练,支持 PB 级容量。GCS Fuse(可选搭配 Anywhere Cache)适用于容量较大、延迟要求较宽松的场景。两者均可与 GKE 和 Cluster Director 集成。

- 推理:GCS Fuse 搭配 Anywhere Cache 提供了简便的解决方案。如需更高性能,请考虑使用 Hyperdisk ML。如果在同一可用区中使用 Managed Lustre 进行训练,也可将其用于推理。

网络

- 训练:可利用 VPC 中的 RDMA 网络,以及 Cloud Interconnect 和 Cross-Cloud Interconnect 等高带宽技术,实现快速数据传输。

- 推理:利用 GKE Inference Gateway 和增强型 Cloud Load Balancing 等方案,实现低延迟模型服务。Model Armor 可集成用于提升 AI 的安全性与防护能力。

计算:可使用 Google Cloud TPU (Trillium)、NVIDIA GPU (Blackwell) 和 CPU (Axion)。这样,您就可以根据具体工作负载的吞吐量、延迟或 TCO 需求进行优化。

领先的软件和开放式框架

- 机器学习框架和库:PyTorch、JAX、TensorFlow、Keras、vLLM、JetStream、MaxText、LangChain、Hugging Face、NVIDIA(CUDA、NeMo、Triton)等多种开源和第三方选项。

- 编译器、运行时和工具:XLA(用于提升性能和互操作性)、Pathways on Cloud、Multislice Training、Cluster Toolkit(用于预构建集群蓝图)等多种开源和第三方选项。

- 编排:Google Kubernetes Engine (GKE)、Cluster Director(适用于 Slurm、非托管式 Kubernetes 和自带调度器)以及 Google Compute Engine (GCE)。

使用模式:

- 按需:随用随付。

- 承诺使用折扣 (CUD):长期承诺可大幅节省费用(高达 70%)。

- Spot 虚拟机:非常适用于容错型批处理作业,最多可享 91% 折扣。

- 动态工作负载调度器 (DWS):针对批处理和容错作业,最多可节省 50% 成本。