Bei der Funktion generativer Fallback werden die neuesten generativen Large Language Models (LLMs) von Google verwendet, um Antworten von virtuellen Kundenservicemitarbeitern zu generieren, wenn die Eingabe des Endnutzers nicht mit einem Intent oder Parameter für das Ausfüllen von Formularen übereinstimmt.

Die Funktion kann mit einem Textprompt konfiguriert werden, der dem LLM mitteilt, wie er reagieren soll. Sie können einen vordefinierten Textprompt verwenden oder eigene Prompts hinzufügen. Mit dem vordefinierten Prompt kann der virtuelle Kundenservicemitarbeiter einfache Unterhaltungssituationen bewältigen. Beispiel:

- Begrüßen und verabschieden Sie sich vom Nutzer.

- Wiederhole, was der Kundenservicemitarbeiter gesagt hat, falls der Nutzer es nicht verstanden hat.

- Lege auf, wenn der Nutzer darum bittet.

- Fassen Sie die Unterhaltung zusammen.

Sie können den generativen Fallback für Event-Handler bei Nichtübereinstimmung aktivieren, die in Abläufen, auf Seiten oder bei der Parameterausfüllung verwendet werden. Wenn der generative Fallback für ein No-Match-Ereignis aktiviert ist, versucht Konversations-Agents (Dialogflow CX), jedes Mal, wenn dieses Ereignis ausgelöst wird, eine generierte Antwort zu erstellen, die dem Nutzer vorgelesen wird. Wenn die Antwortgenerierung fehlschlägt, wird stattdessen die reguläre vorgeschriebene Kundenservicemitarbeiterantwort ausgegeben.

Beschränkungen

Die Funktion ist in den von der Gemini API unterstützten Sprachen verfügbar.

Generativen Fallback aktivieren

Sie können den generativen Fallback in Ihrem Agenten für Event-Handler bei Nichtübereinstimmung aktivieren, die in der Ablauf-, Seiten- oder Parameterausführung verwendet werden können.

Generischen Fallback für Ereignisse ohne Übereinstimmung für einen gesamten Ablauf aktivieren:

- Rufen Sie die Dialogflow CX Console auf.

- Wählen Sie ein Projekt aus.

- Wählen Sie einen Kundenservicemitarbeiter und dann einen Ablauf aus.

- Klicken Sie auf die Startseite des Navigationspfads, um sie zu maximieren.

- Klicken Sie unter Ereignishandler auf sys.no-match-default.

- Klicken Sie unter Kundenservicemitarbeiterantworten auf Generativen Fallback aktivieren.

- Klicken Sie auf Speichern.

Aktivieren Sie den generativen Fallback für bestimmte Ereignisse ohne Übereinstimmung:

- Rufen Sie den Ziel-No-Match-Ereignis-Handler auf (alle Ereignisse, die mit No-Match beginnen, z. B. No-Match default, No-Match 1 usw.).

- Klicken Sie unter Kundenservicemitarbeiterantworten auf Generativen Fallback aktivieren.

- Klicken Sie auf Speichern.

Generativen Fallback konfigurieren

Wie oben erwähnt, leitet die Funktion generativer Fallback eine Anfrage an ein Large Language Model weiter, um die generierte Antwort zu erstellen. Die Anfrage hat die Form eines Textprompts, der eine Mischung aus natürlicher Sprache und Informationen zum aktuellen Status des Kundenservicemitarbeiters und der Unterhaltung ist. Der Prompt und die generierte Antwort werden mit einer Liste von verbotenen Begriffen verglichen. Wenn sie eine verbotene Wortgruppe enthalten oder anderweitig als unsicher eingestuft werden, ist die Generierung nicht erfolgreich und stattdessen wird die reguläre vorgeschriebene Antwort (unter Kundenservicemitarbeiter sagt in derselben Ausführung) ausgegeben.

Die Funktion kann auf verschiedene Arten konfiguriert werden:

- Wählen Sie einen vordefinierten Prompt aus.

- Sie haben die Option, eine benutzerdefinierte Aufforderung zu formulieren.

- Fügen Sie der Liste der verbotenen Wortgruppen Wortgruppen hinzu oder entfernen Sie sie daraus.

Beim Erstellen eines Prompts können Sie neben einer Beschreibung in natürlicher Sprache, welche Art von Kontext generiert werden soll, auch die folgenden Platzhalter verwenden:

| Begriff | Definition |

|---|---|

| $conversation | Die Unterhaltung zwischen dem Kundenservicemitarbeiter und dem Nutzer, ausgenommen die letzte Nutzeräußerung. |

| ${conversation USER:"<user prefix>" AI:"<agent prefix>" TURNS:<turn count>} | Eine parametrisierte Version des Platzhalters $conversation. Sie können das Präfix des Endnutzers (USER), das Präfix des Kundenservicemitarbeiters (AI) und die Anzahl der vorherigen Unterhaltungsrunden, die eingeschlossen werden sollen (TURNS), anpassen. Alle Platzhalterparameterwerte müssen angegeben werden. Beispiel: ${conversation USER:"Human says:" AI:"Agent says:" TURNS:4} |

| $last-user-utterance | Die letzte Nutzeräußerung. |

| $flow-description | Die Ablaufbeschreibung des aktiven Ablaufs. |

| $route-descriptions | Die Intent-Beschreibungen der aktiven Intents. |

Achten Sie auf einen guten Fluss und eine gute Beschreibung der Absicht.

Vordefinierten Prompt auswählen

- Gehen Sie in den Einstellungen für Kundenservicemitarbeiter zum Tab Generative KI und dann zum Untertab Generativer Fallback.

- Wählen Sie eine der Optionen im Drop-down-Menü Vorlage aus.

- Klicken Sie auf Speichern.

Die Funktion bietet zwei Vorlagenvorschläge: die Standardvorlage (nicht sichtbar) und die Beispielvorlage, die als Leitfaden für das Erstellen eigener Vorschläge dienen kann.

Eigenen Prompt definieren

- Gehen Sie in den Einstellungen für Kundenservicemitarbeiter zum Tab Generative KI und dann zum Untertab Generativer Fallback.

- Wählen Sie im Drop-down-Menü Vorlage die Option + Neue Vorlage aus.

- Fügen Sie einen Vorlagennamen hinzu.

- Fügen Sie einen Textprompt hinzu.

- Klicken Sie auf Speichern.

Sie können auch mit der Bearbeitung der Vorlage Beispiel beginnen und sie als neue Vorlage speichern:

- Wählen Sie im Drop-down-Menü Vorlage die Option Beispiel aus.

- Klicken Sie auf Bearbeiten.

- Bearbeiten Sie den Vorlagennamen.

- Bearbeiten Sie den Textprompt.

- Klicken Sie auf Speichern.

Liste der verbotenen Wortgruppen ändern

- Rufen Sie in den Kundenservicemitarbeiter-Einstellungen den Tab Generative KI und dann den Untertab Allgemein auf.

- Prüfen, ergänzen oder entfernen Sie im Abschnitt Gesperrte Wortgruppen die gewünschten Wortgruppen.

- Klicken Sie auf Speichern.

Generativen Fallback testen

Sie können die Funktion generativer Fallback im Simulator testen. Wenn eine Nutzeräußerung zu einem No-Match-Ereignis in einem Fluss/auf einer Seite führt, bei dem das No-Match-Ereignis so konfiguriert wurde, dass eine generative Antwort generiert wird (und die Generierung erfolgreich ist), gibt der Bot die generierte Antwort aus.

Codelab

Weitere Informationen finden Sie auch im Codelab zum generativen Fallback.

Fehlerbehebung

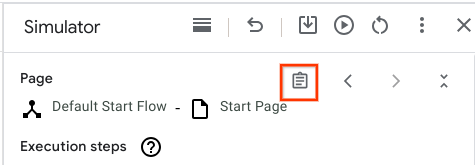

Wenn Sie die Funktion debuggen möchten, können Sie den aufgelösten LLM-Eingabeprompt (Large Language Model) im Dialogflow Console-Simulator prüfen:

Klicken Sie auf die Schaltfläche Originalantwort:

Suchen Sie das Feld Generative Fallback Prompt (Generativer Fallback-Prompt). Lesen Sie diese Felder als Nur-Text und prüfen Sie, ob die LLM-Eingabe sinnvoll ist. Wenn ein Satz

$enthält, prüfen Sie die Simulatoreingabe und klären Sie, ob das$in den Prompts beabsichtigt ist.$inprice is $10ist beispielsweise wahrscheinlich beabsichtigt, währendvisit $citywahrscheinlich nicht beabsichtigt ist und entweder auf Missbrauch oder einen Fehler hinweisen könnte. Wenn du dir nicht sicher bist, wende dich an den Support.Wenn Sie eine andere Promptvorlage als die Standardvorlage verwenden, das Feld „Generative Fallback Prompt“ aber nicht sehen, wenden Sie sich an den Support.