Auf dieser Seite wird beschrieben, wie Sie die Dataproc-Image-Version ändern, die von Ihrer Cloud Data Fusion-Instanz verwendet wird. Sie können das Bild auf Instanz-, Namespace- oder Pipelineebene ändern.

Hinweise

Beenden Sie alle Echtzeit-Pipelines und Replikationsjobs in der Cloud Data Fusion-Instanz. Wenn eine Echtzeit-Pipeline oder ‑Replikation ausgeführt wird, wenn Sie die Dataproc-Image-Version ändern, werden die Änderungen nicht auf die Pipeline-Ausführung angewendet.

Wenn Checkpointing für Echtzeit-Pipelines aktiviert ist, führt das Beenden der Pipelines nicht zu Datenverlust. Bei Replikationsjobs führt das Beenden und Starten des Replikationsjobs nicht zu Datenverlusten, solange die Datenbanklogs verfügbar sind.

Konsole

Rufen Sie die Seite Cloud Data Fusion-Instanzen auf und öffnen Sie die Instanz, in der Sie eine Pipeline beenden müssen.

Öffnen Sie jede Echtzeitpipeline in Pipeline Studio und klicken Sie auf Beenden.

Öffnen Sie jeden Replikationsjob auf der Seite Replicate (Replizieren) und klicken Sie auf Stop (Beenden).

REST API

Verwenden Sie den folgenden REST API-Aufruf, um alle Pipelines abzurufen:

GET -H "Authorization: Bearer ${AUTH_TOKEN}" \ "${CDAP_ENDPOINT}/v3/namespaces/NAMESPACE_ID/apps"Ersetzen Sie

NAMESPACE_IDdurch den Namen Ihres Namespace.Verwenden Sie den folgenden REST API-Aufruf, um eine Echtzeit-Pipeline zu beenden:

POST -H "Authorization: Bearer ${AUTH_TOKEN}" \ "${CDAP_ENDPOINT}/v3/namespaces/NAMESPACE_ID/apps/PIPELINE_NAME/spark/DataStreamsSparkStreaming/stop"Ersetzen Sie NAMESPACE_ID durch den Namen Ihres Namespace und PIPELINE_NAME durch den Namen der Echtzeitpipeline.

Verwenden Sie den folgenden REST API-Aufruf, um einen Replikationsjob zu beenden:

POST -H "Authorization: Bearer ${AUTH_TOKEN}" \ "${CDAP_ENDPOINT}/v3/namespaces/NAMESPACE_ID/apps/REPLICATION_JOB_NAME/workers/DeltaWorker/stop"Ersetzen Sie NAMESPACE_ID durch den Namen Ihres Namespace und REPLICATION_JOB_NAME durch den Namen des Replikationsjobs.

Weitere Informationen finden Sie unter Echtzeitpipelines beenden und Replikationsjobs beenden.

Standardversion von Dataproc in Cloud Data Fusion prüfen und überschreiben

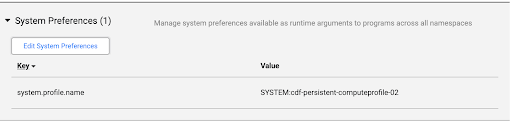

Klicken Sie auf Systemadministrator > Konfiguration > Systemeinstellungen.

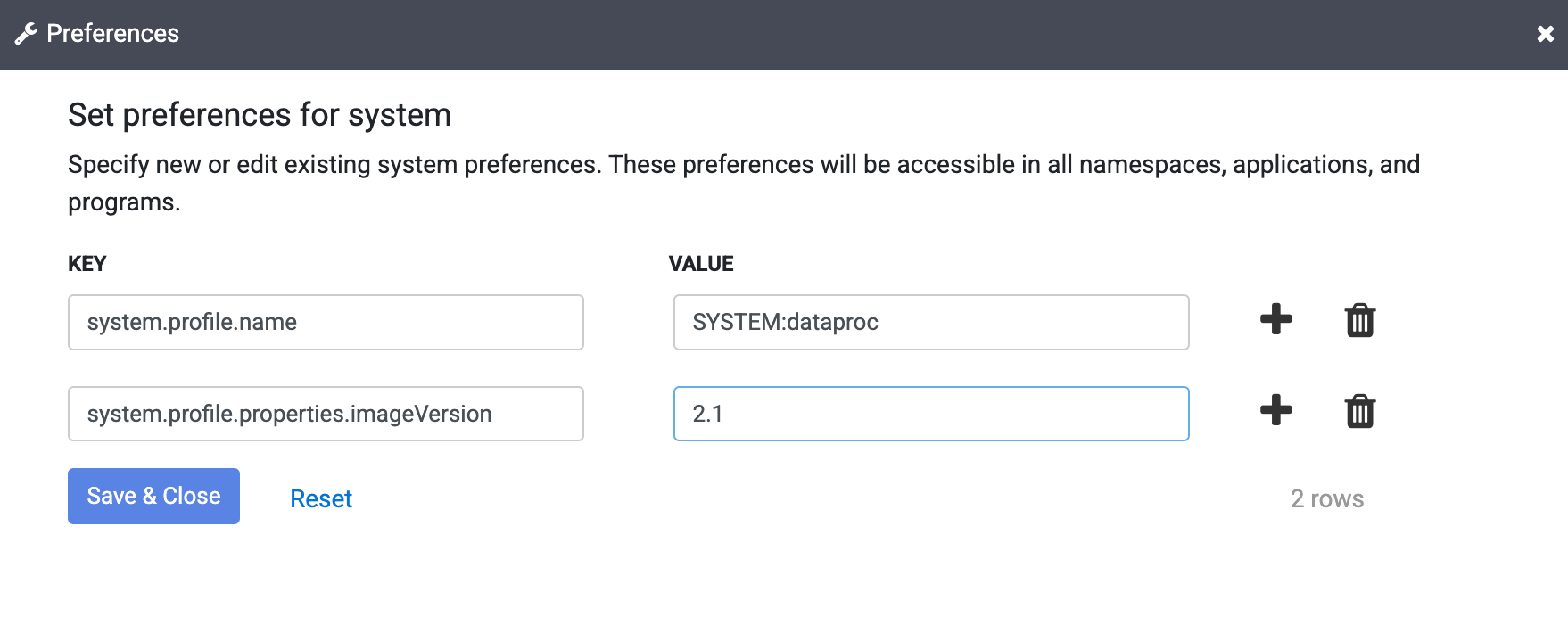

Wenn in den Systemeinstellungen kein Dataproc-Image angegeben ist oder Sie die Einstellung ändern möchten, klicken Sie auf Systemeinstellungen bearbeiten.

Geben Sie im Feld Schlüssel den folgenden Text ein:

system.profile.properties.imageVersionGeben Sie das ausgewählte Dataproc-Image in das Wertfeld ein, z. B.

2.1.Klicken Sie auf Speichern & schließen.

Diese Änderung wirkt sich auf die gesamte Cloud Data Fusion-Instanz aus, einschließlich aller Namespaces und Pipelineausführungen, sofern die Eigenschaft für die Image-Version nicht in einem Namespace, einer Pipeline oder einem Laufzeitargument in Ihrer Instanz überschrieben wird.

Dataproc-Image-Version ändern

Die Image-Version kann in der Cloud Data Fusion-Weboberfläche in den Compute-Konfigurationen, Namespace-Einstellungen oder Pipeline-Laufzeitargumenten festgelegt werden.

Bild in den Namespace-Einstellungen ändern

Wenn Sie die Bildversion in Ihren Namespace-Eigenschaften überschrieben haben, gehen Sie so vor:

Klicken Sie auf Systemadministrator > Konfiguration > Namespaces.

Öffnen Sie die einzelnen Namespaces und klicken Sie auf Einstellungen.

Prüfen Sie, ob es eine Überschreibung mit dem Schlüssel

system.profile.properties.imageVersionund einem falschen Wert für die Bildversion gibt.Klicken Sie auf Beenden.

Bild in „System Compute-Profile“ ändern

Klicken Sie auf Systemadministrator > Konfiguration.

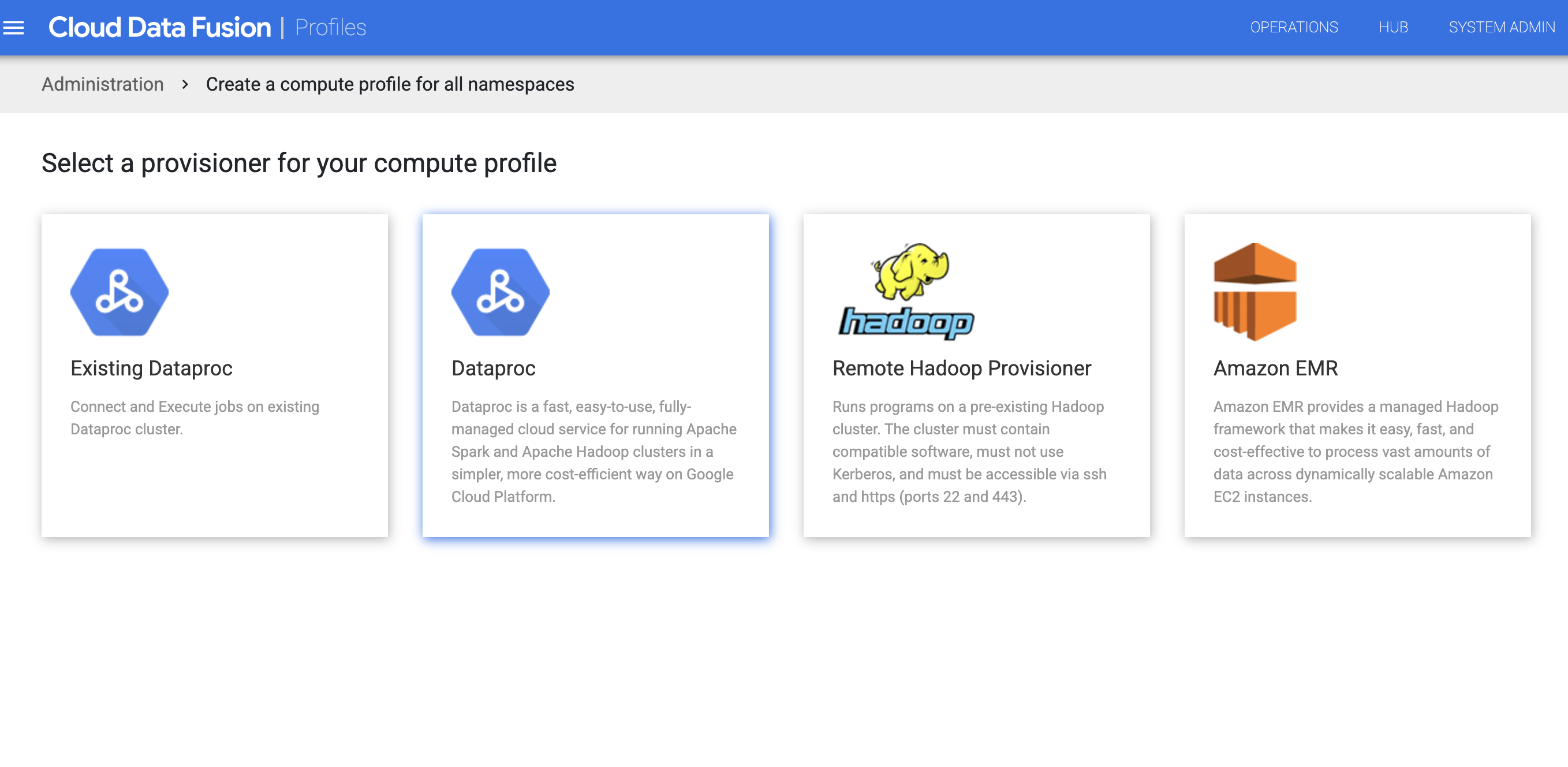

Klicken Sie auf „System“ Compute Profiles > Create New Profile (System > Rechenprofile > Neues Profil erstellen).

Wählen Sie den Dataproc-Bereitsteller aus.

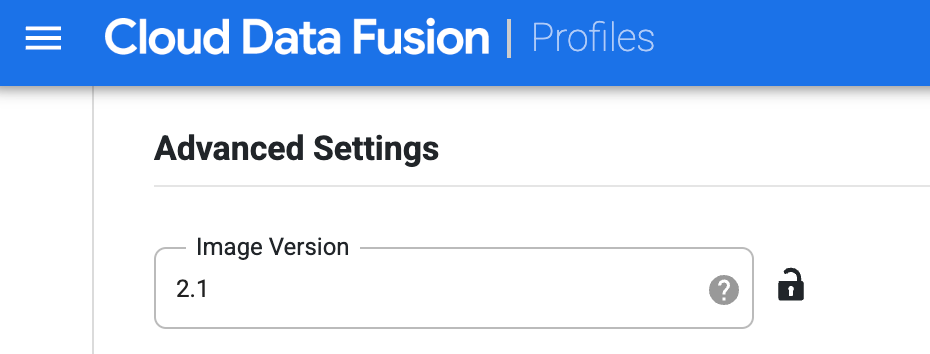

Erstellen Sie das Profil für Dataproc. Geben Sie im Feld Image-Version eine Dataproc-Image-Version ein.

Wählen Sie dieses Rechenprofil aus, wenn Sie die Pipeline auf der Seite Studio ausführen. Klicken Sie auf der Seite für den Pipeline-Lauf auf Konfigurieren > Compute-Konfiguration und wählen Sie dieses Profil aus.

Wählen Sie das Dataproc-Profil aus und klicken Sie auf Speichern.

Klicken Sie auf Beenden.

Bild in Pipeline-Laufzeitargumenten ändern

Wenn Sie die Bildversion mit einer Eigenschaft in den Laufzeitargumenten Ihrer Pipeline überschrieben haben, gehen Sie so vor:

Klicken Sie auf das Menü > Liste.

Wählen Sie auf der Seite Liste die Pipeline aus, die Sie aktualisieren möchten.

Die Pipeline wird auf der Seite Studio geöffnet.

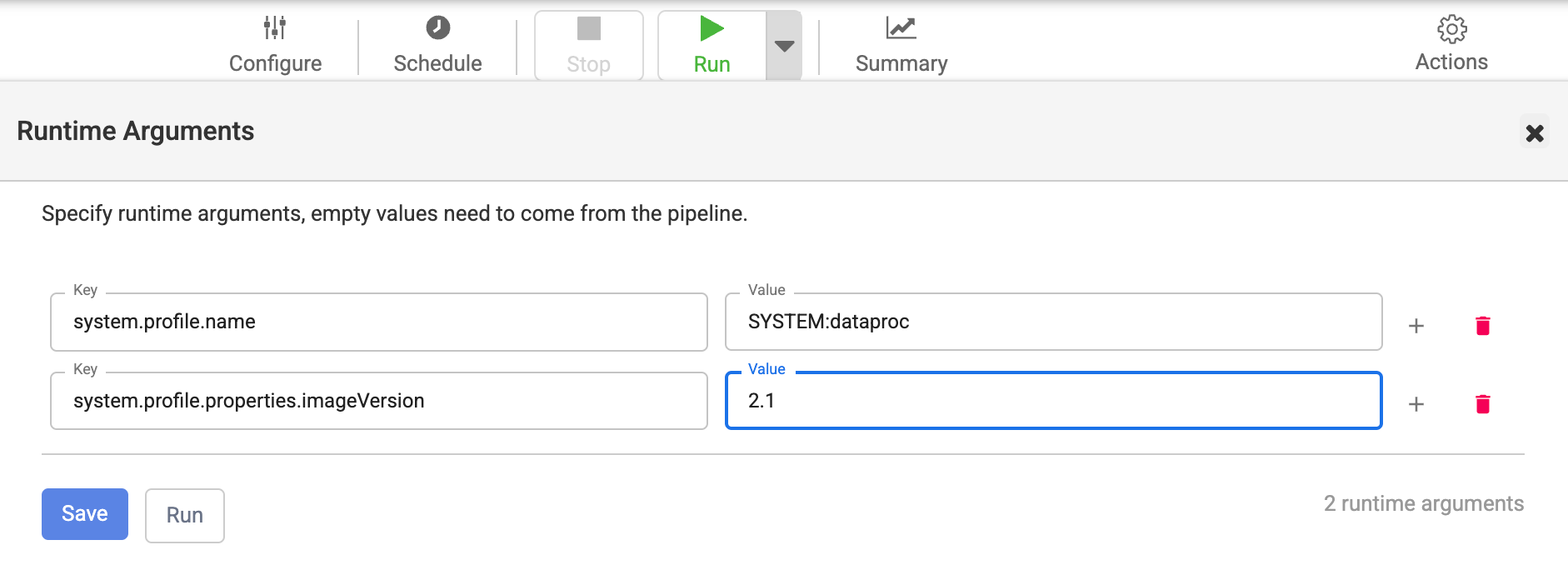

Klicken Sie auf den Erweiterungspfeil, um die Run-Optionen zu maximieren.

Das Fenster Laufzeitargumente wird geöffnet.

Prüfen Sie, ob es eine Überschreibung mit dem Schlüssel

system.profile.properties.imageVersionund einer falschen Bildversion als Wert gibt.Klicken Sie auf Speichern.

Statische Dataproc-Cluster, die von Cloud Data Fusion verwendet werden, mit der ausgewählten Image-Version neu erstellen

Wenn Sie vorhandene Dataproc-Cluster mit Cloud Data Fusion verwenden, folgen Sie der Dataproc-Anleitung, um die Cluster mit der ausgewählten Dataproc-Image-Version für Ihre Cloud Data Fusion-Version neu zu erstellen.

Alternativ können Sie einen neuen Dataproc-Cluster mit der ausgewählten Dataproc-Imageversion erstellen und das Compute-Profil in Cloud Data Fusion mit demselben Compute-Profilnamen und dem aktualisierten Dataproc-Clusternamen löschen und neu erstellen. So können Batch-Pipelines auf dem vorhandenen Cluster ausgeführt werden und nachfolgende Pipelineausführungen auf dem neuen Dataproc-Cluster erfolgen. Sie können den alten Dataproc-Cluster löschen, nachdem Sie bestätigt haben, dass alle Pipelineausführungen abgeschlossen sind.

Prüfen, ob die Dataproc-Image-Version aktualisiert wurde

Konsole

Rufen Sie in der Google Cloud Console die Dataproc-Seite Cluster auf.

Öffnen Sie die Seite Clusterdetails für den neuen Cluster, der von Cloud Data Fusion erstellt wurde, als Sie die neue Version angegeben haben.

Das Feld Image-Version hat den neuen Wert, den Sie in Cloud Data Fusion angegeben haben.

REST API

Rufen Sie die Liste der Cluster mit ihren Metadaten ab:

GET -H "Authorization: Bearer ${AUTH_TOKEN}" \ https://dataproc.googleapis.com/v1/projects/PROJECT_ID/regions/REGION_ID/clustersErsetzen Sie Folgendes:

- Ersetzen Sie

PROJECT_IDdurch den Namen Ihres Namespace. REGION_IDdurch den Namen der Region, in der sich Ihre Cluster befinden.

- Ersetzen Sie

Suchen Sie nach dem Namen Ihrer Pipeline (Clustername).

Unter diesem JSON-Objekt finden Sie das Bild in

config > softwareConfig > imageVersion.

Dataproc-Image auf Version 2.1 oder höher umstellen

Cloud Data Fusion-Versionen 6.9.1 und höher unterstützen das Dataproc-Image 2.1 Compute Engine, das in Java 11 ausgeführt wird. In Version 6.10.0 und höher ist Image 2.1 die Standardeinstellung.

Wenn Sie von einem früheren Image auf Image 2.1 oder höher umstellen, müssen die JDBC-Treiber, die von den Datenbank-Plug-ins in diesen Instanzen verwendet werden, mit Java 11 kompatibel sein, damit Ihre Batchpipelines und Replikationsjobs erfolgreich ausgeführt werden.

Für Dataproc-Image 2.2 und 2.1 gelten in Cloud Data Fusion die folgenden Einschränkungen:

- MapReduce-Jobs werden nicht unterstützt.

- Die JDBC-Treiberversionen, die in den Datenbank-Plug-ins in Ihrer Instanz verwendet werden, müssen aktualisiert werden, damit Java 11 unterstützt wird. In der folgenden Tabelle finden Sie die Treiberversionen, die mit Dataproc 2.2, 2.1 und Java 11 funktionieren:

| JDBC-Treiber | Ältere Versionen, die aus Cloud Data Fusion 6.9.1 entfernt wurden | Java 8- und Java 11-kompatible Versionen, die mit Dataproc 2.2, 2.1 oder 2.0 funktionieren |

|---|---|---|

| Cloud SQL for MySQL-JDBC-Treiber | - | 1.0.16 |

| Cloud SQL for PostgreSQL-JDBC-Treiber | - | 1.0.16 |

| Microsoft SQL Server-JDBC-Treiber | Microsoft JDBC-Treiber 6.0 | Microsoft JDBC-Treiber 9.4 |

| MySQL-JDBC-Treiber | 5.0.8, 5.1.39 | 8.0.25 |

| PostgreSQL-JDBC-Treiber | 9.4.1211.jre7, 9.4.1211.jre8 | 42.6.0.jre8 |

| Oracle JDBC-Treiber | ojdbc7 | ojdbc8 (12c und höher) |

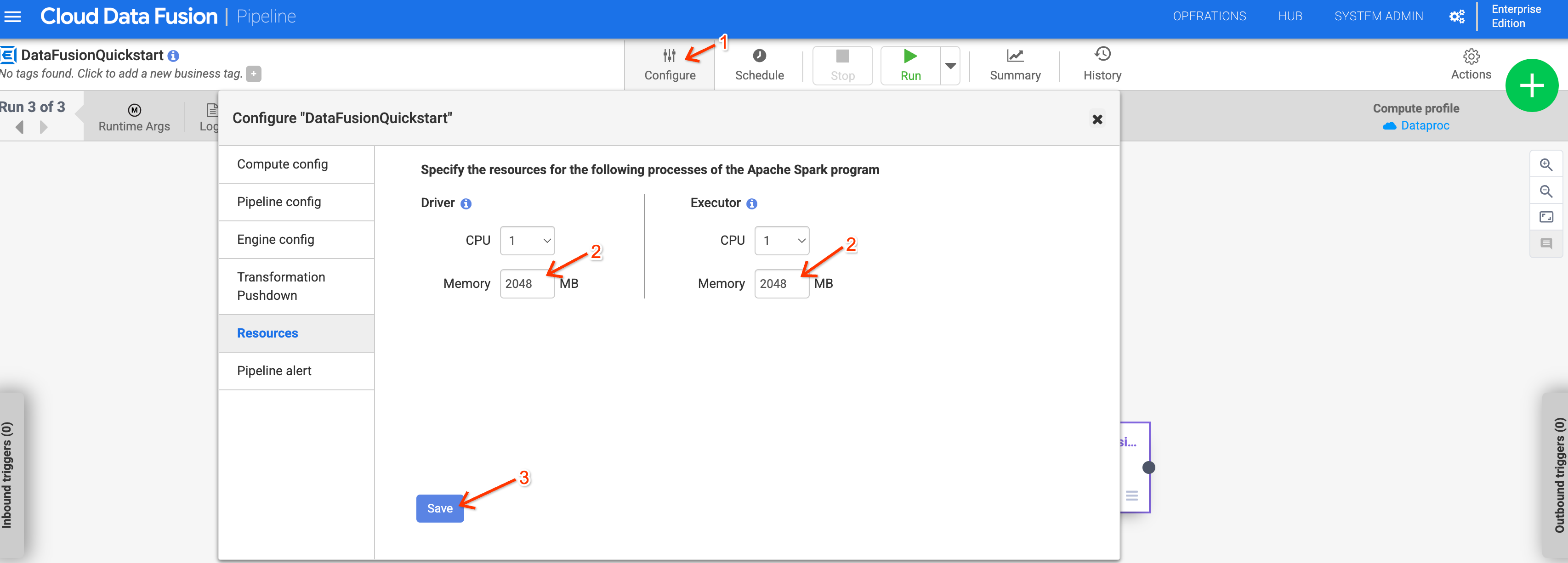

Arbeitsspeichernutzung bei Verwendung von Dataproc 2.1 oder höher

Die Arbeitsspeichernutzung kann bei Pipelines, die Dataproc 2.1 oder höher verwenden, steigen. Wenn Sie Ihre Instanz auf Version 6.10 oder höher aktualisieren und frühere Pipelines aufgrund von Speicherproblemen fehlschlagen, erhöhen Sie den Treiber- und Executor-Arbeitsspeicher in der Resources-Konfiguration für die Pipeline auf 2.048 MB.

Alternativ können Sie die Dataproc-Version überschreiben, indem Sie das Laufzeitargument system.profile.properties.imageVersion auf 2.0-debian10 festlegen.