In diesem Dokument wird eine Konfiguration für die Regel- und Benachrichtigungsbewertung in einer Managed Service for Prometheus-Bereitstellung beschrieben, die die verwaltete Erfassung verwendet.

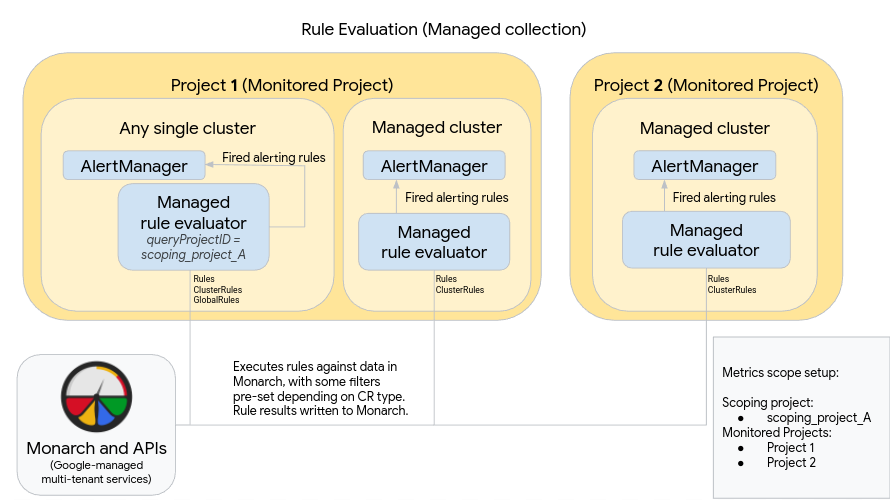

Das folgende Diagramm veranschaulicht eine Bereitstellung, die mehrere Cluster in zwei Google Cloud -Projekten verwendet und sowohl die Regel- als auch die Benachrichtigungsbewertung sowie die optionale GlobalRules-Ressource verwendet:

Beachten Sie Folgendes, um eine Bereitstellung wie im Diagramm einzurichten und zu verwenden:

Die verwaltete Regelbewertung wird automatisch in jedem Cluster bereitgestellt, in dem die verwaltete Erfassung ausgeführt wird. Diese Bewertungen werden so konfiguriert:

Verwenden Sie Rules-Ressourcen, um Regeln für Daten in einem Namespace auszuführen. Rules-Ressourcen müssen in jedem Namespace angewendet werden, in dem Sie die Regel ausführen möchten.

Verwenden Sie ClusterRules-Ressourcen, um Regeln für Daten in einem Cluster auszuführen. ClusterRules-Ressourcen sollten einmal pro Cluster angewendet werden.

Die gesamte Regelbewertung wird für den globalen Datenspeicher Monarch ausgeführt.

- Rules-Ressourcen filtern automatisch Regeln für das Projekt, den Standort, den Cluster und den Namespace, in dem sie installiert sind.

- ClusterRules-Ressourcen filtern automatisch Regeln für das Projekt, den Standort und den Cluster, in dem sie installiert sind.

- Alle Regelergebnisse werden nach der Bewertung in Monarchisch geschrieben.

Eine Prometheus AlertManager-Instanz wird in jedem einzelnen Cluster manuell bereitgestellt. Verwaltete Regelbewertungen werden durch Bearbeiten der OperatorConfig-Ressource konfiguriert, um ausgelöste Benachrichtigungsregeln an ihre lokale AlertManager-Instanz zu senden. Stummschaltungen, Bestätigungen und Workflows für das Vorfallmanagement werden normalerweise in einem Drittanbietertool wie PagerDuty verarbeitet.

Sie können die Benachrichtigungsverwaltung über mehrere Kubernetes-Endpunkte hinweg in einem einzigen AlertManager verwalten, indem Sie eine Endpunktressource von Kubernetes verwenden.

Das obige Diagramm zeigt auch die optionale GlobalRules-Ressource. Verwenden Sie GlobalRules sparsam, z. B. für Aufgaben wie die Berechnung globaler SLOs für Projekte oder die clusterübergreifende Bewertung von Regeln in einem einzelnen Google Cloud Projekt. Wir empfehlen dringend, nach Möglichkeit Rules und ClusterRules zu verwenden. Diese Ressourcen bieten eine herausragende Zuverlässigkeit und eignen sich besser für gängige Kubernetes-Bereitstellungsmechanismen und -Mandantenmodelle.

Wenn Sie die GlobalRules-Ressource verwenden, beachten Sie Folgendes im vorherigen Diagramm:

Ein einzelner Cluster, der in Google Cloud ausgeführt wird, wird als globaler Cluster zur Regelbewertung für einen Messwertbereich festgelegt. Die verwaltete Regelbewertung ist für die Verwendung von Bereichsprojekt_A konfiguriert, das die Projekte 1 und 2 enthält. Regeln, die für Bereichsprojekt_A ausgeführt werden, werden automatisch auf die Projekte 1 und 2 verteilt.

Dem zugrunde liegenden Dienstkonto müssen die Berechtigungen des Monitoring-Betrachters für Bereichsprojekt_A gewährt werden. Weitere Informationen zum Festlegen dieser Felder finden Sie unter Bewertung mehrerer Projekte und globaler Regeln.

Wie in allen anderen Clustern wird die Regelbewertung mit Rules- und ClusterRules-Ressourcen eingerichtet, die Regeln bewerten, die einem Namespace oder Cluster zugeordnet sind. Diese Regeln werden automatisch in das lokale Projekt – in diesem Fall Projekt 1 – gefiltert. Da Bereichsprojekt_A Projekt 1 enthält, werden die konfigurierten Rules- und ClusterRules-Regeln wie erwartet nur für Daten aus dem lokalen Projekt ausgeführt.

Dieser Cluster enthält auch GlobalRules-Ressourcen, die Regeln für Bereichsprojekt_A ausführen. GlobalRules werden nicht automatisch gefiltert und werden daher genau wie geschrieben in allen Projekten, Standorten, Clustern und Namespaces in Bereichsprojekt_A ausgeführt.

Ausgelöste Benachrichtigungsregeln werden wie erwartet an den selbst gehosteten AlertManager gesendet.

Die Verwendung von GlobalRules kann unerwartete Auswirkungen haben, je nachdem, ob Sie die Labels project_id, location, cluster oder namespace in Ihren Regeln beibehalten oder zusammenfassen:

Wenn Ihre GlobalRules-Regel das Label

project_idmithilfe einerby(project_id)-Klausel beibehält, werden die Regelergebnisse mit dem ursprünglichenproject_id-Wert der zugrunde liegenden Zeitachse wieder in Monarch geschrieben.In diesem Szenario müssen Sie dafür sorgen, dass das zugrunde liegende Dienstkonto die Berechtigungen Monitoring-Messwert-Autor für jedes überwachte Projekt in Bereichsprojekt_A hat. Wenn Sie ein neues überwachtes Projekt zu Bereichsprojekt_A hinzufügen, müssen Sie dem Dienstkonto manuell eine neue Berechtigung hinzufügen.

Wenn Ihre GlobalRules-Regel das Label

project_idnicht behält (da keineby(project_id)-Klausel verwendet wird), werden die Regelergebnisse mit demproject_id-Wert des Clusters, in dem die globale Regelbewertung ausgeführt wird, wieder in Monarch geschrieben.In diesem Szenario müssen Sie das zugrunde liegende Dienstkonto nicht weiter ändern.

Wenn Ihre GlobalRules-Regel das Label

locationmithilfe einerby(location)-Klausel beibehält, werden die Regelergebnisse mit jeder ursprünglichen Google Cloud -Region, aus der die zugrunde liegende Zeitachse stammt, wieder in Monarch geschrieben.Wenn Ihre GlobalRules-Regel das Label

locationnicht beibehält, werden die Daten an den Standort des Clusters geschrieben, in dem die globale Regelbewertung ausgeführt wird.

Wir empfehlen dringend, die Labels cluster und namespace in den Ergebnissen der Regelbewertung beizubehalten, sofern der Zweck der Regel nicht darin besteht, diese Labels durch Zusammenfassung zu entfernen. Andernfalls kann die Abfrageleistung sinken und es können Kardinalitätslimits auftreten. Es wird dringend davon abgeraten, beide Labels zu entfernen.