AI スーパーコンピュータで、トレーニング、チューニング、サービングまで一括対応

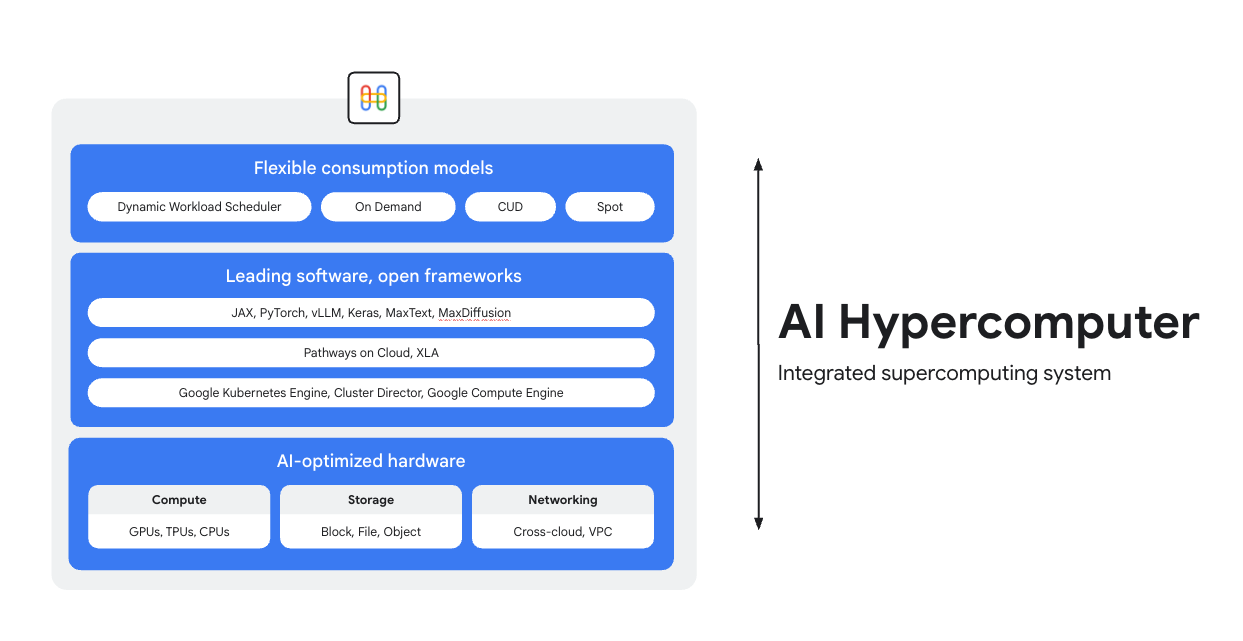

AI Hypercomputer は、Google Cloud 上のあらゆる AI ワークロードを支える統合型スーパーコンピューティング システムです。このシステムは、AI のデプロイを簡素化し、システムレベルの効率を向上させ、費用を最適化するように設計されたハードウェア、ソフトウェア、消費モデルで構成されています。

概要

AI に最適化されたハードウェア

最先端のソフトウェアとオープン フレームワーク

業界最先端のソフトウェアと、オープンなフレームワーク、ライブラリ、コンパイラとの連携により、ハードウェアを最大限に活用し、AI の開発、統合、管理をより効率的に行えます。

- PyTorch、JAX、Keras、vLLM、Megatron-LM、NeMo Megatron、MaxText、MaxDiffusion など、幅広いフレームワークをサポートしています。

- XLA コンパイラとの緊密な統合により、さまざまなアクセラレータ間の相互運用が可能になります。また、Pathways on Cloud を使用すると、Google 社内の大規模なトレーニングと推論のインフラストラクチャを支えているのと同じ分散ランタイムを使用できます。

- これらはすべて、Google Kubernetes Engine、Cluster Director、Google Compute Engine など、選択した環境にデプロイできます。

柔軟な消費モデル

使用量に応じた柔軟なオプションにより、お客様はビジネスニーズに合わせて、確約利用割引による固定費を選択することも、動的なオンデマンド モデルを選択することもできます。Dynamic Workload Scheduler と Spot VM を活用すれば、リソースを過剰に割り当てることなく必要な容量を確保できます。さらに、Google Cloud の費用最適化ツールを使えば、リソースの使用状況を自動的に管理してエンジニアの手作業を減らすことができます。

一般的な使用例

費用対効果の高いモデルのサービングを大規模に実現

推論ワークロードの費用対効果と信頼性を最大化

推論は急速に多様化、複雑化しており、主に以下の 3 つの領域で進化しています。

- 第 1 に、AI との関わり方が変化しています。会話のコンテキストの長さと多様性が増すようになりました。

- 第 2 に、高度な推論と多段階推論により、混合エキスパート(MoE)モデルが一般化していることです。これにより、初期入力から最終出力までのメモリとコンピューティングのスケーリング方法が一変しています。

- 第 3 に、真の価値は、費用あたりのトークン数だけでなく、回答の有用性にあることが明らかになっています。モデルに適切な専門知識が蓄積されているか?ビジネス上の重要な質問に正しく回答できたか?そのため、お客様はプロセッサの価格ではなく、システム運用の総費用に焦点を当てた、より優れた測定基準を必要としていると Google は考えています。

AI 推論のリソース

- AI 推論とは タイプ、比較、ユースケースに関する総合的なガイド

- GKE Inference Quickstart を使用してベスト プラクティスの推論レシピを実行する

- Cloud Run での AI 推論に関するコースを受講する

- 費用効率に優れた AI 推論の秘訣に関する動画を見る

- AI 推論ワークロードを高速化する方法を確認する

AI がスポーツファンをキット デザイナーに変える

PUMA は、統合 AI インフラストラクチャ(AI Hypercomputer)を活用するために Google Cloud と提携しました。これにより、ユーザー プロンプトに Gemini を使用できるほか、Dynamic Workload Scheduler を使用して GPU で推論を動的にスケーリングできるため、費用と生成時間が大幅に削減されました。

対象:

- AI キットの生成時間を 2~5 分からわずか 30 秒に短縮しました。これにより、プラットフォームは高速で真にインタラクティブなエクスペリエンスへと変革され、ユーザーの関心を維持できるようになりました。

- わずか 10 日間で、ファンは 18 万個のキットを作成し、170 万件の評価を投稿しました。

- このプロジェクトは、PUMA がコミュニティとつながる新しい方法を実証しました。ファンをアクティブな共同クリエイターに変えられたことで、単なるブランドから消費者への関係を超えた結びつきが生まれ、最も熱心な消費者のクリエイティブな欲求に関する直接的なリアルタイムの分析情報を得られるようになりました。

入門ガイド

推論ワークロードの費用対効果と信頼性を最大化

推論は急速に多様化、複雑化しており、主に以下の 3 つの領域で進化しています。

- 第 1 に、AI との関わり方が変化しています。会話のコンテキストの長さと多様性が増すようになりました。

- 第 2 に、高度な推論と多段階推論により、混合エキスパート(MoE)モデルが一般化していることです。これにより、初期入力から最終出力までのメモリとコンピューティングのスケーリング方法が一変しています。

- 第 3 に、真の価値は、費用あたりのトークン数だけでなく、回答の有用性にあることが明らかになっています。モデルに適切な専門知識が蓄積されているか?ビジネス上の重要な質問に正しく回答できたか?そのため、お客様はプロセッサの価格ではなく、システム運用の総費用に焦点を当てた、より優れた測定基準を必要としていると Google は考えています。

参考情報

AI 推論のリソース

- AI 推論とは タイプ、比較、ユースケースに関する総合的なガイド

- GKE Inference Quickstart を使用してベスト プラクティスの推論レシピを実行する

- Cloud Run での AI 推論に関するコースを受講する

- 費用効率に優れた AI 推論の秘訣に関する動画を見る

- AI 推論ワークロードを高速化する方法を確認する

お客様の事例

AI がスポーツファンをキット デザイナーに変える

PUMA は、統合 AI インフラストラクチャ(AI Hypercomputer)を活用するために Google Cloud と提携しました。これにより、ユーザー プロンプトに Gemini を使用できるほか、Dynamic Workload Scheduler を使用して GPU で推論を動的にスケーリングできるため、費用と生成時間が大幅に削減されました。

対象:

- AI キットの生成時間を 2~5 分からわずか 30 秒に短縮しました。これにより、プラットフォームは高速で真にインタラクティブなエクスペリエンスへと変革され、ユーザーの関心を維持できるようになりました。

- わずか 10 日間で、ファンは 18 万個のキットを作成し、170 万件の評価を投稿しました。

- このプロジェクトは、PUMA がコミュニティとつながる新しい方法を実証しました。ファンをアクティブな共同クリエイターに変えられたことで、単なるブランドから消費者への関係を超えた結びつきが生まれ、最も熱心な消費者のクリエイティブな欲求に関する直接的なリアルタイムの分析情報を得られるようになりました。

大規模な AI トレーニングと事前トレーニングの実行

強力でスケーラブルかつ効率的な AI トレーニング

トレーニング ワークロードは、緊密に結合されたクラスタ内の数千ノードにわたって、高度に同期されたジョブとして実行する必要があります。1 つのノードがデグレードしただけで、ジョブ全体が中断され、製品化に遅れが生じる可能性があります。次の操作を行う必要があります。

- クラスタを迅速にセットアップし、対象のワークロードに合わせてチューニングする

- 障害を予測して迅速にトラブルシューティングする

- 障害が発生した場合でもワークロードを継続する

Google は、お客様が Google Cloud でトレーニング ワークロードを非常に簡単にデプロイし、スケーリングできるようにすることを目指しています。

強力でスケーラブルかつ効率的な AI トレーニング

AI クラスタの作成を開始するには、以下のチュートリアルのいずれかをご活用ください。

- GPU(A4 VM)と Cluster Toolkit を使用して Slurm クラスタを作成する

- Cluster Director for GKE または Cluster Toolkit を使用して GKE クラスタを作成する

Moloco は、1 日あたり数十億件のリクエストを処理する広告配信プラットフォームを構築

Moloco は、AI Hypercomputer の完全に統合されたスタックを利用して、TPU や GPU などの高度なハードウェアで自動的にスケーリングしました。これにより、Moloco のエンジニアは他の作業に集中できるようになりました。また、Google の業界をリードするデータ プラットフォームとの統合により、AI ワークロードのための包括的なエンドツーエンドのシステムが構築されました。

最初のディープ ラーニング モデルをリリースした後、Moloco はホッケー スティック型の成長と収益化を実現し、2 年半で 5 倍の成長を達成しました。

- GKE 上の Cloud TPU により、モデルのトレーニングを 10 倍高速化し、トレーニング費用を 4 分の 1 に削減

- 1,000 人を超える社内ユーザーにサービスを提供できるようスケーリングし、世界規模の ML システムへのアクセスを提供して、ユーザーが自社のデータから収益性の高い成長を見つけられるよう支援

AssemblyAI

AssemblyAI が Google Cloud を活用してモデルを迅速かつ大規模にトレーニング

LG AI Research は、厳格なデータ セキュリティとデータ所在地に関する要件を遵守しながら、費用を大幅に削減し、開発を加速

Anthropic は、Claude モデルのトレーニングとサービングのために、最大 100 万個の TPU を利用する計画を発表しました。これは、数十億ドルに相当します。では、TPU は Google Cloud 上でどのように実行されているのでしょうか?この動画では、Anthropic が GKE を使用して大規模に AI のコンピューティングの限界を押し広げている様子をご覧いただけます。

入門ガイド

強力でスケーラブルかつ効率的な AI トレーニング

トレーニング ワークロードは、緊密に結合されたクラスタ内の数千ノードにわたって、高度に同期されたジョブとして実行する必要があります。1 つのノードがデグレードしただけで、ジョブ全体が中断され、製品化に遅れが生じる可能性があります。次の操作を行う必要があります。

- クラスタを迅速にセットアップし、対象のワークロードに合わせてチューニングする

- 障害を予測して迅速にトラブルシューティングする

- 障害が発生した場合でもワークロードを継続する

Google は、お客様が Google Cloud でトレーニング ワークロードを非常に簡単にデプロイし、スケーリングできるようにすることを目指しています。

参考情報

強力でスケーラブルかつ効率的な AI トレーニング

AI クラスタの作成を開始するには、以下のチュートリアルのいずれかをご活用ください。

- GPU(A4 VM)と Cluster Toolkit を使用して Slurm クラスタを作成する

- Cluster Director for GKE または Cluster Toolkit を使用して GKE クラスタを作成する

お客様の事例

Moloco は、1 日あたり数十億件のリクエストを処理する広告配信プラットフォームを構築

Moloco は、AI Hypercomputer の完全に統合されたスタックを利用して、TPU や GPU などの高度なハードウェアで自動的にスケーリングしました。これにより、Moloco のエンジニアは他の作業に集中できるようになりました。また、Google の業界をリードするデータ プラットフォームとの統合により、AI ワークロードのための包括的なエンドツーエンドのシステムが構築されました。

最初のディープ ラーニング モデルをリリースした後、Moloco はホッケー スティック型の成長と収益化を実現し、2 年半で 5 倍の成長を達成しました。

- GKE 上の Cloud TPU により、モデルのトレーニングを 10 倍高速化し、トレーニング費用を 4 分の 1 に削減

- 1,000 人を超える社内ユーザーにサービスを提供できるようスケーリングし、世界規模の ML システムへのアクセスを提供して、ユーザーが自社のデータから収益性の高い成長を見つけられるよう支援

AssemblyAI

AssemblyAI が Google Cloud を活用してモデルを迅速かつ大規模にトレーニング

LG AI Research は、厳格なデータ セキュリティとデータ所在地に関する要件を遵守しながら、費用を大幅に削減し、開発を加速

Anthropic は、Claude モデルのトレーニングとサービングのために、最大 100 万個の TPU を利用する計画を発表しました。これは、数十億ドルに相当します。では、TPU は Google Cloud 上でどのように実行されているのでしょうか?この動画では、Anthropic が GKE を使用して大規模に AI のコンピューティングの限界を押し広げている様子をご覧いただけます。

AI アプリケーションのデプロイとオーケストレーション

最先端の AI オーケストレーション ソフトウェアとオープン フレームワークを活用して、AI によるエクスペリエンスを実現

Google Cloud は、一般的なオペレーティング システム、フレームワーク、ライブラリ、ドライバを含むイメージを提供します。AI Hypercomputer は、これらの事前構成されたイメージを最適化して、AI ワークロードをサポートします。

- AI および ML のフレームワークとライブラリ: ディープ ラーニング ソフトウェア レイヤ(DLSL)Docker イメージを使用して、Google Kubernetes Engine(GKE)クラスタで NeMO や MaxText などの ML モデルを実行します。

- クラスタのデプロイと AI オーケストレーション: AI ワークロードを GKE クラスタ、Slurm クラスタ、または Compute Engine インスタンスにデプロイできます。詳細については、VM とクラスタの作成の概要をご覧ください。

ソフトウェア リソースを見る

- Pathways on Cloud: 大規模でマルチタスクのスパース活性化 ML システムを構築できるように設計されたシステム

- Google のグッドプット レシピを活用して ML の生産性を最適化する

- トポロジ対応スケジューリングで GKE ワークロードをスケジュールする

- GPU で DeepSeek、Mixtral、Llama、GPT の各モデルを実行するためのベンチマーク レシピを試す

- 使用オプションを選択して、コンピューティング リソースをより効率的に取得して使用する

Priceline: 旅行者がユニークな体験をキュレートできるよう支援

現在は、Google Cloud を使って生成 AI を組み込むことで、chatbot 内に独自の旅行コンシェルジュを作成できます。お客様に旅行の計画という枠を超えていただけるよう、ユニークな旅行体験のキュレートをサポートしています。」Priceline 社 CTO、Martin Brodbeck 氏

入門ガイド

最先端の AI オーケストレーション ソフトウェアとオープン フレームワークを活用して、AI によるエクスペリエンスを実現

Google Cloud は、一般的なオペレーティング システム、フレームワーク、ライブラリ、ドライバを含むイメージを提供します。AI Hypercomputer は、これらの事前構成されたイメージを最適化して、AI ワークロードをサポートします。

- AI および ML のフレームワークとライブラリ: ディープ ラーニング ソフトウェア レイヤ(DLSL)Docker イメージを使用して、Google Kubernetes Engine(GKE)クラスタで NeMO や MaxText などの ML モデルを実行します。

- クラスタのデプロイと AI オーケストレーション: AI ワークロードを GKE クラスタ、Slurm クラスタ、または Compute Engine インスタンスにデプロイできます。詳細については、VM とクラスタの作成の概要をご覧ください。

参考情報

ソフトウェア リソースを見る

- Pathways on Cloud: 大規模でマルチタスクのスパース活性化 ML システムを構築できるように設計されたシステム

- Google のグッドプット レシピを活用して ML の生産性を最適化する

- トポロジ対応スケジューリングで GKE ワークロードをスケジュールする

- GPU で DeepSeek、Mixtral、Llama、GPT の各モデルを実行するためのベンチマーク レシピを試す

- 使用オプションを選択して、コンピューティング リソースをより効率的に取得して使用する

お客様の事例

Priceline: 旅行者がユニークな体験をキュレートできるよう支援

現在は、Google Cloud を使って生成 AI を組み込むことで、chatbot 内に独自の旅行コンシェルジュを作成できます。お客様に旅行の計画という枠を超えていただけるよう、ユニークな旅行体験のキュレートをサポートしています。」Priceline 社 CTO、Martin Brodbeck 氏

よくある質問

AI Hypercomputer は、個々のクラウド サービスを使用する場合と比べてどうですか?

個々のサービスは特定の機能を提供しますが、AI Hypercomputer は、ハードウェア、ソフトウェア、消費モデルが最適に連携するように設計された統合システムを提供します。この統合により、パフォーマンス、費用、製品化までの時間において、個別のサービスを組み合わせるだけでは実現が難しいシステムレベルの効率性を達成できます。複雑さを軽減し、AI インフラストラクチャに対する包括的なアプローチを提供します。

AI Hypercomputer はハイブリッド環境またはマルチクラウド環境で使用できますか?

はい、AI Hypercomputer は柔軟性を念頭に設計されています。Cross-Cloud Interconnect などのテクノロジーは、オンプレミス データセンターや他のクラウドへの高帯域幅接続を提供し、ハイブリッド AI 戦略やマルチクラウド AI 戦略を促進します。オープン スタンダードで運用し、一般的なサードパーティ ソフトウェアと統合することで、複数の環境にまたがるソリューションの構築や、サービスを自由に変更できる環境を提供しています。

AI Hypercomputer は AI ワークロードのセキュリティにどのように対処していますか?

セキュリティは AI Hypercomputer の中核的な側面です。Google Cloud の多層セキュリティ モデルのメリットを享受できます。具体的な機能としては、Titan セキュリティ マイクロコントローラ(システムが信頼できる状態から起動することを保証)、RDMA ファイアウォール(トレーニング時の TPU / GPU 間のゼロトラスト ネットワーキング用)、AI の安全性を確保する Model Armor などのソリューションとの統合などがあります。これらは、セキュア AI フレームワークなどの堅牢なインフラストラクチャ セキュリティのポリシーと原則によって補完されます。

AI Hypercomputer をインフラストラクチャとして使用する最も簡単な方法は何ですか?

- VM の管理を避けたい場合は、Google Kubernetes Engine(GKE)から始めることをおすすめします。

- 複数のスケジューラを使用する必要がある場合や、GKE を使用できない場合は、Cluster Director を使用することをおすすめします。

- インフラストラクチャを完全に制御したい場合は、VM を直接操作する以外に方法はありません。そのためには、Compute Engine が最適な選択肢です。

大規模 / 高スケールのワークロードにしか使えないのですか?

いいえ。AI Hypercomputer は、あらゆる規模のワークロードに使用できます。小規模なワークロードでも、効率性やデプロイの簡素化など、統合システムのあらゆるメリットを実現できます。AI Hypercomputer は、小規模な概念実証やテストから大規模な本番環境へのデプロイまで、お客様のビジネスの拡大に合わせてサポートします。

AI Hypercomputer は、Google Cloud で AI ワークロードを始める最も簡単な方法ですか?

ほとんどのお客様にとって、Vertex AI のようなマネージド AI プラットフォームは、ツール、テンプレート、モデルがすべて組み込まれているため、AI を使い始めるうえで最も簡単な方法です。さらに、Vertex AI は、ユーザーのために最適化された AI Hypercomputer を基盤としています。Vertex AI は最もシンプルなエクスペリエンスであるため、AI を最も簡単に始められます。インフラストラクチャのすべてのコンポーネントを構成して最適化したい場合は、AI Hypercomputer のコンポーネントにインフラストラクチャとしてアクセスし、ニーズに合わせて組み立てることができます。

AI Hypercomputer はコンポーズ可能なシステムであるため、構成の選択肢が豊富にありますが、ユースケースごとのベスト プラクティスはありますか?

はい、GitHub にレシピ ライブラリを構築しています。また、Cluster Toolkit を使用して、事前構築済みのクラスタ ブループリントを利用することもできます。

AI Hypercomputer を IaaS として使用する場合、どのようなオプションを利用できますか?

AI に最適化されたハードウェア

ストレージ

- トレーニング: Managed Lustre は、高スループットとペタバイト規模の容量を必要とする、要求の厳しい AI トレーニングに最適です。GCS Fuse(オプションで Anywhere Cache を使用)は、レイテンシがそれほど厳しくない、より大容量のニーズに適しています。どちらも GKE と Cluster Director と統合されています。

- 推論: GCS Fuse と Anywhere Cache を併用することで、シンプルなソリューションを実現します。より高いパフォーマンスが必要な場合は、Hyperdisk ML をご検討ください。同じゾーンで Managed Lustre をトレーニングに使用する場合、推論にも使用できます。

ネットワーキング

- トレーニング: VPC での RDMA ネットワーキングや、高速データ転送を実現する高帯域幅の Cloud Interconnect と Cross-Cloud Interconnect などのテクノロジーを活用できます。

- 推論: GKE Inference Gateway や強化された Cloud Load Balancing などのソリューションを利用して、低レイテンシのサービスを提供します。Model Armor を統合することで AI の安全性とセキュリティを確保できます。

コンピューティング: Google Cloud TPU(Trillium)、NVIDIA GPU(Blackwell)、CPU(Axion)にアクセスします。これにより、スループット、レイテンシ、TCO に関する特定のワークロードのニーズに基づいて最適化できます。

最先端のソフトウェアとオープン フレームワーク

- ML フレームワークとライブラリ: PyTorch、JAX、TensorFlow、Keras、vLLM、JetStream、MaxText、LangChain、Hugging Face、NVIDIA(CUDA、NeMo、Triton)など、さまざまなオープンソースとサードパーティのオプションがあります。

- コンパイラ、ランタイム、ツール: XLA(パフォーマンスと相互運用性向け)、Pathways on Cloud、マルチスライス トレーニング、Cluster Toolkit(事前構築済みクラスタ ブループリント向け)など、さまざまなオープンソースとサードパーティ オプションがあります。

- オーケストレーション: Google Kubernetes Engine(GKE)、Cluster Director(Slurm、非マネージド Kubernetes、BYO スケジューラ向け)、Google Compute Engine(GCE)。

消費モデル:

- オンデマンド: 従量課金制。

- 確約利用割引(CUD): 長期契約で大幅な割引(最大 70%)が適用されます。

- Spot VM: フォールト トレラントなバッチジョブに最適で、大幅な割引(最大 91%)が適用されます。

- Dynamic Workload Scheduler(DWS): バッチジョブ / フォールト トレラント ジョブで最大 50% の費用を削減します。