Auf dieser Seite wird der Conversational Commerce-Agent von Vertex AI Search for Commerce beschrieben, der eine geführte Suchfunktion bietet. Die Funktion des Conversational Commerce-Agenten ist Teil des Pakets für die geführte Suche und bietet Nutzern eine interaktivere, fortlaufende Unterhaltung in Echtzeit.

Was ist der Konversations-Agent für den Handel?

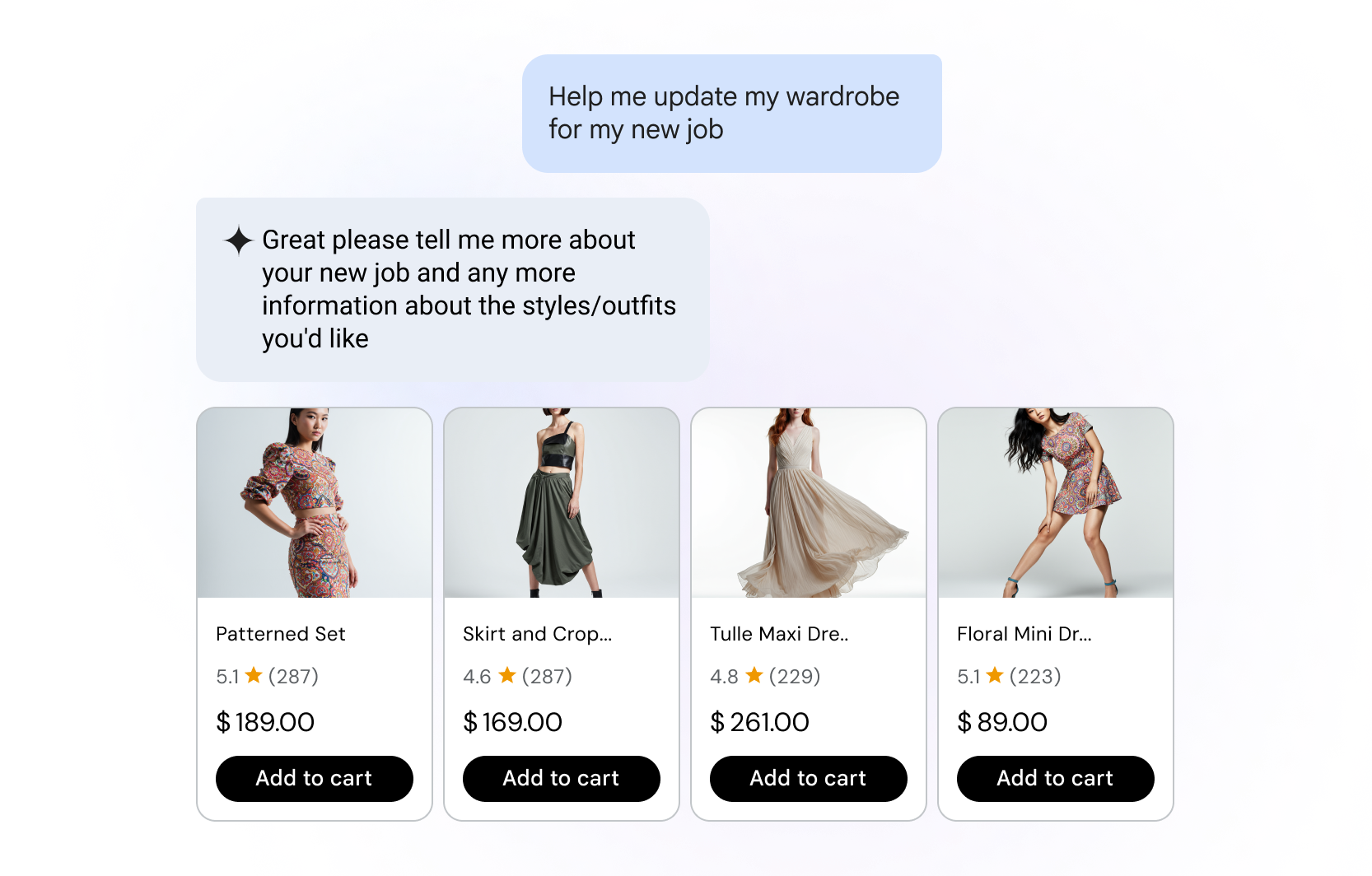

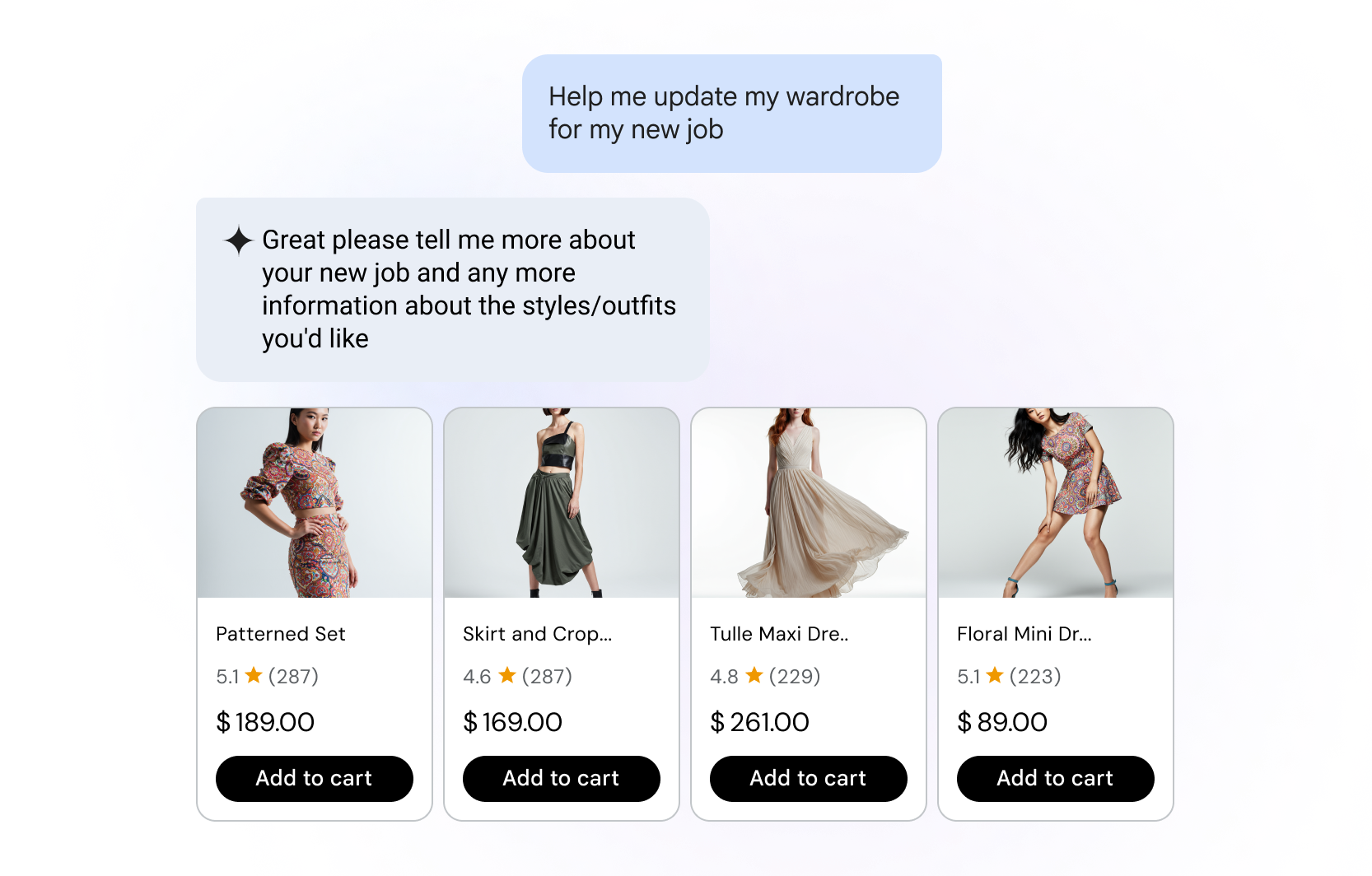

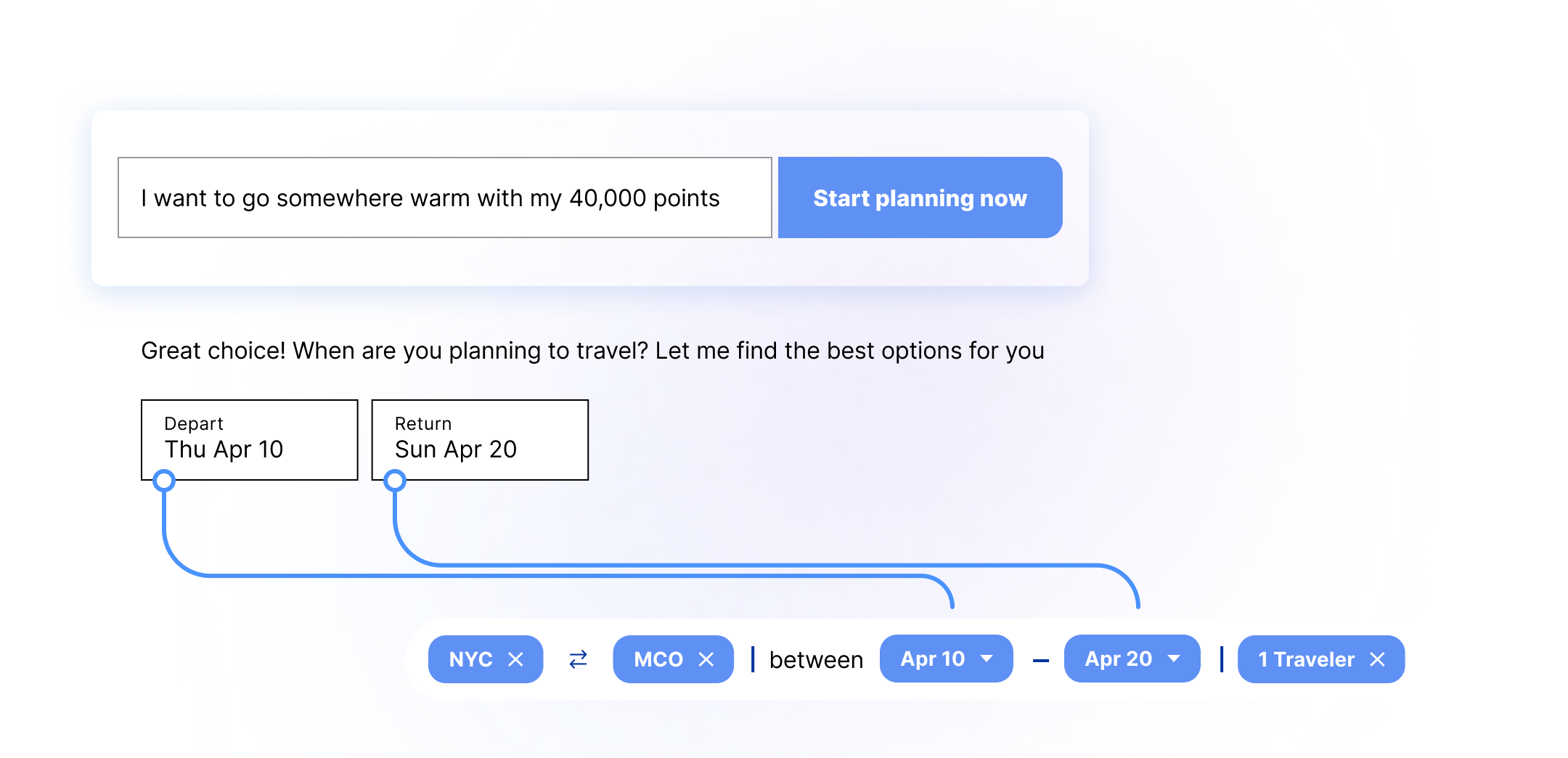

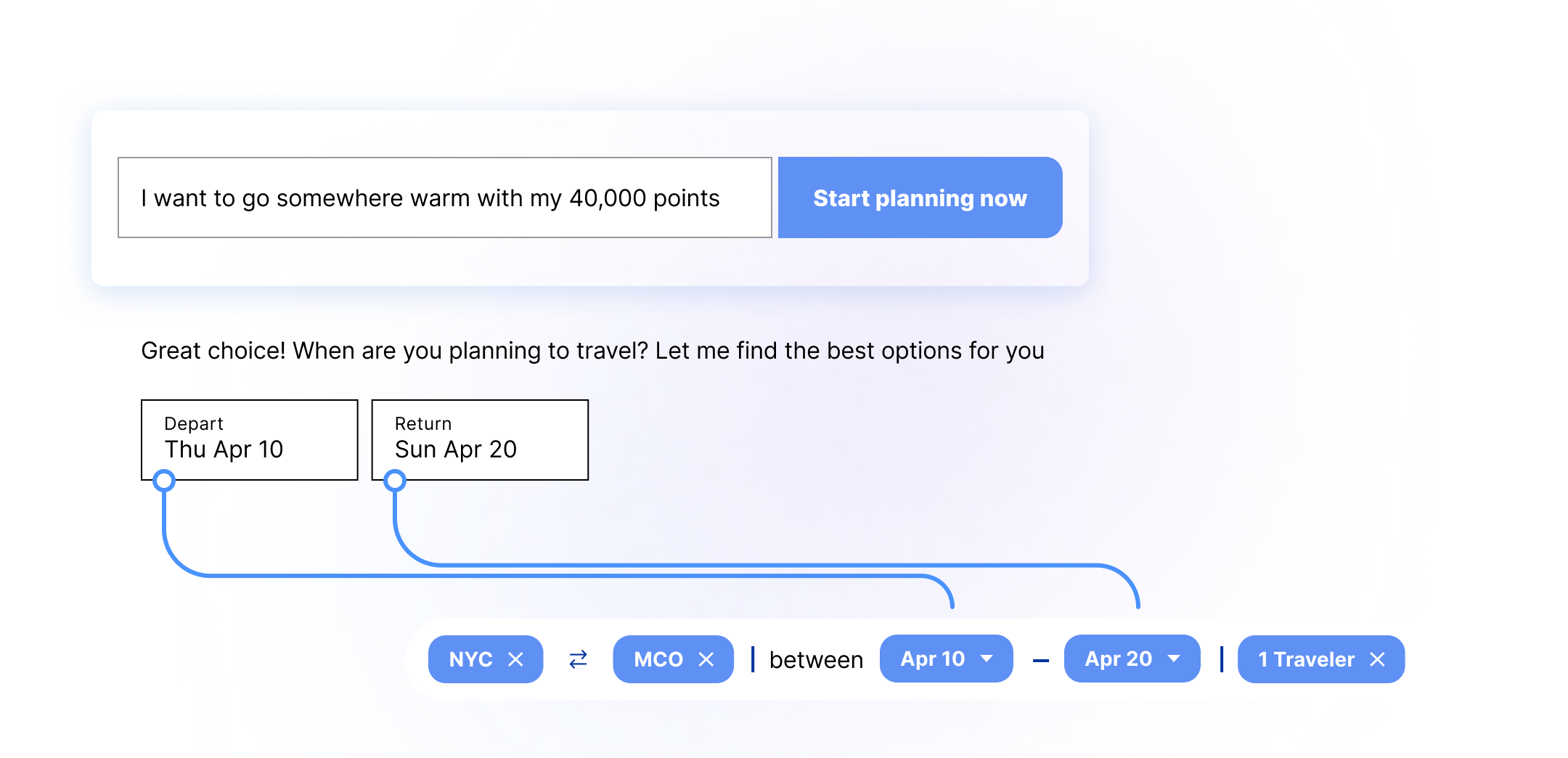

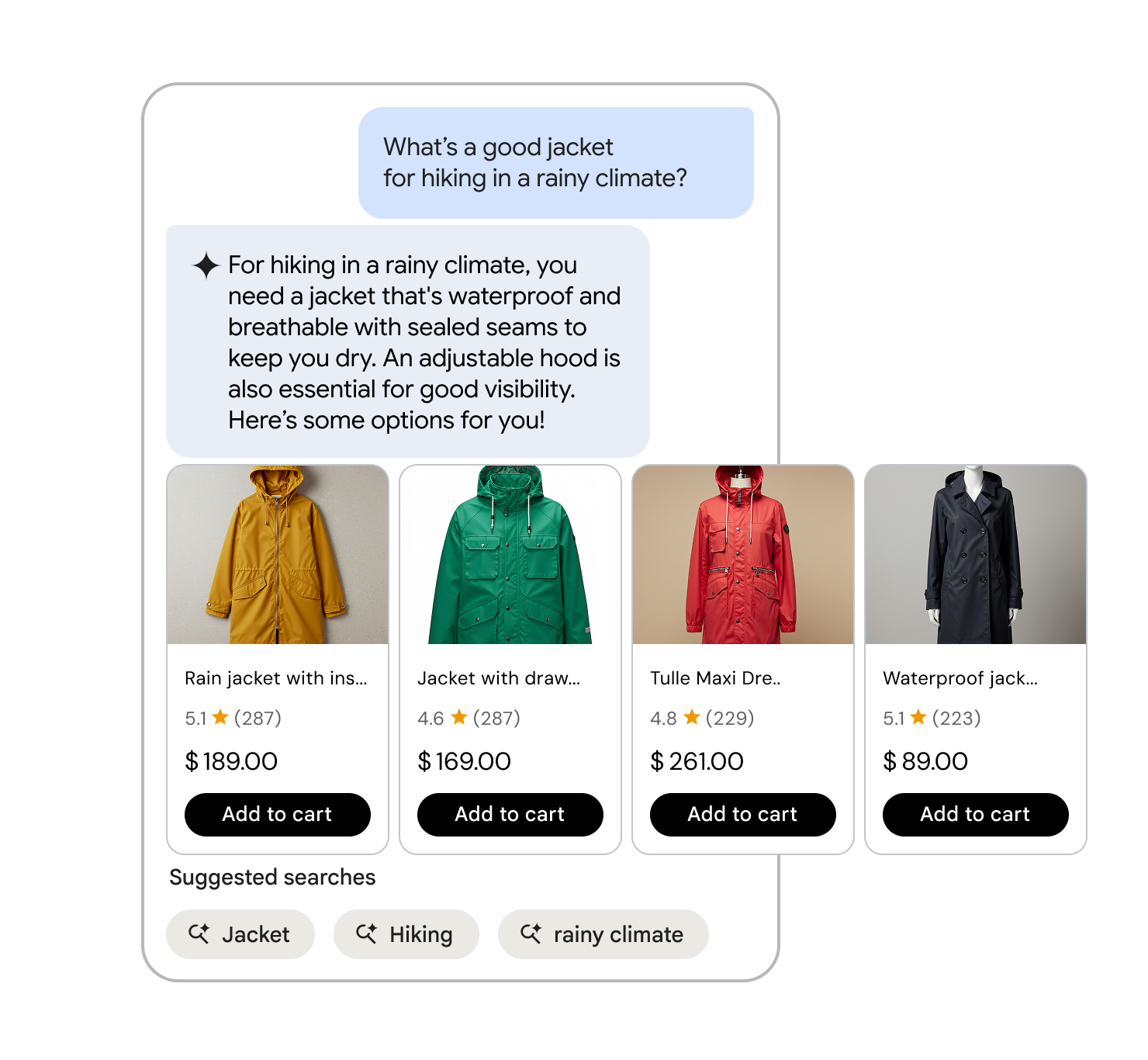

Der Conversational Commerce-Agent ist ein KI-gestütztes Tool für die geführte Suche und Produktfindung. Anstatt mit Keywords zu suchen, verwenden Nutzer natürliche Sprache, um nach dem zu fragen, was sie benötigen. Dazu gehören Folgefragen, multimodale Interaktionen, ein besseres Verständnis der Intention und die Fundierung mit Daten, die über den Produktkatalog hinausgehen. So können Nutzer Ergebnisse intuitiver und effizienter filtern und schneller finden, wonach sie suchen.

Funktionen des Konversations-Agenten für den Handel

Der Conversational Commerce-Agent ergänzt Vertex AI Search for Commerce auf folgende Weise:

- Nutzeranfragen effektiv eingrenzen: Der Conversational Commerce-Agent filtert 10.000 Produkte auf weniger als 100 Produkte herunter,wodurch die Wahrscheinlichkeit steigt, dass der Nutzer einen Kauf tätigt.

- Hyperpersonalisierung: Such-Agents analysieren die Präferenzen, den Kaufverlauf und die Social-Media-Aktivitäten von Käufern, um personalisierte Produktempfehlungen, Werbeaktionen und Einkaufserlebnisse zu ermöglichen.

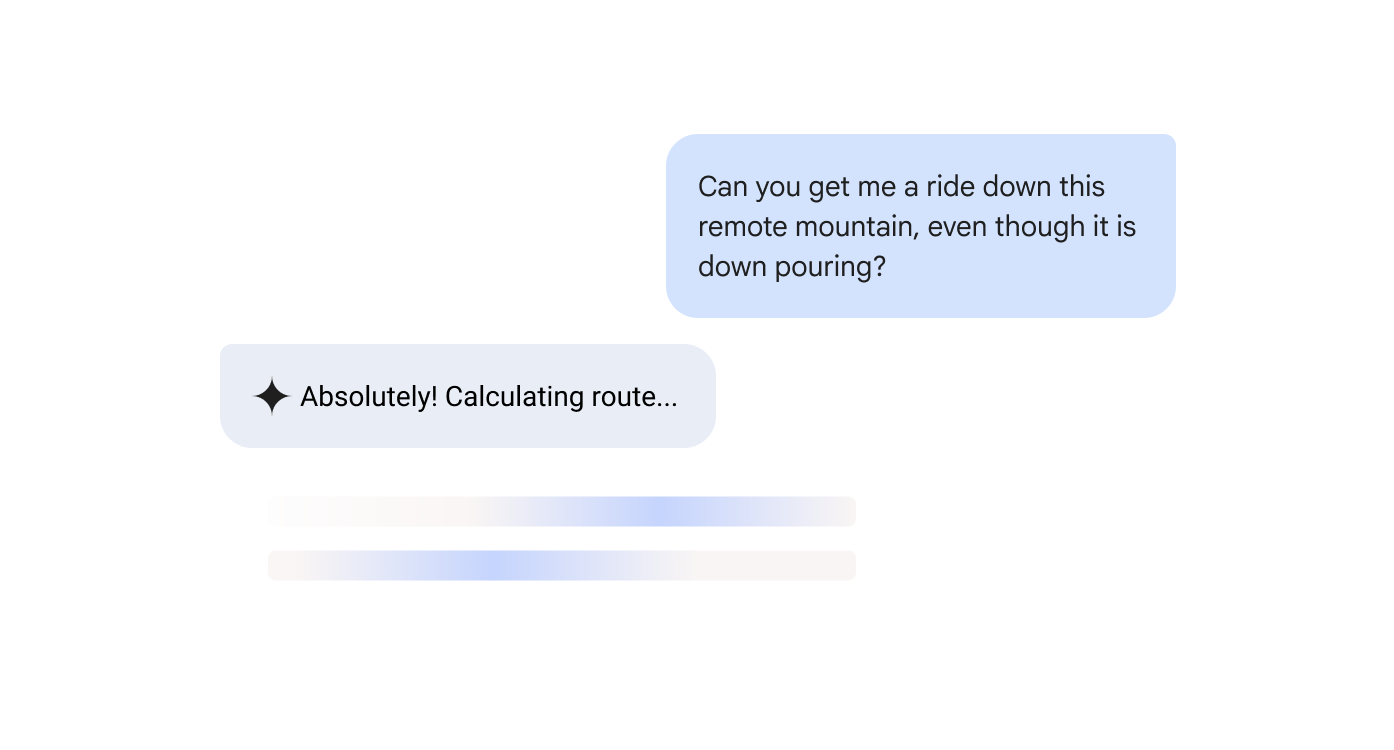

- Integrierte End-to-End-Prozesse: Von der Produktsuche bis zur Kasse begleiten die Such-Agents den Endnutzer während des gesamten Kaufprozesses mit immersiven, dynamischen und kontinuierlichen Gesprächen.

- An den Anwendungsfall für den Handel angepasst: Der Conversational Commerce-Agent deckt E-Commerce, Produktfindung und Support ab.

- Immersive Nutzererlebnisse: Mithilfe von Such-Agents, die Nutzerkonversationen verknüpfen, können Augmented und Virtual Reality zusätzlich auf der Händlerwebsite implementiert werden, um virtuelle Anproben, Store-Touren und räumliche Produktvisualisierungen zu ermöglichen.

Auswirkungen des Konversations-Agenten für den Handel

Als zentraler Bestandteil des Pakets für die geführte Suche verbessert der Konversations-Agent für den Handel die Relevanz der Suchergebnisse und verringert die Reibung für Nutzer.

Die herkömmliche Suche ist die gängigste Methode, um Produkte zu finden. Bei herkömmlichen Ansätzen wird auf einen starren Keyword-Abgleich gesetzt. Nutzer müssen also bestimmte Wörter verwenden und Filter manuell anpassen, um die Ergebnisse einzugrenzen. Allerdings geben nur 10 % der Verbraucher an, dass sie bei der herkömmlichen keywordbasierten Suche genau das finden, wonach sie suchen.

Der Conversational Commerce-Agent löst die frustrierendsten Probleme für Nutzer bei der Suche, z. B. ungenaue Übereinstimmungen, irrelevante Ergebnisse oder Anfragen ohne Ergebnis.

Natural Language Understanding

Die KI-basierte Suche erkennt Anfragen in ganzen Sätzen, interpretiert die Intention und berücksichtigt sprachliche Variationen.

Vorausschauende Unterstützung

Unterstützt Nutzer beim Formulieren von effektiveren Anfragen, indem während der Eingabe Vervollständigungen vorgeschlagen werden.

Multimodale Eingaben

Mit dem Conversational Commerce-Agent können Nutzer nicht nur mit Text, sondern auch mit multimodalen Eingabemethoden wie Sprache und Bildern suchen. Es versteht Nutzerabsichten, Kontext und Variationen in der Formulierung natürlicher Sprache, ohne den Kontext zu verlieren.

- Sprachsuche: Gesprochene Anfragen sind oft anders strukturiert als getippte. Vertex AI Search for Commerce verarbeitet diese Variationen und berücksichtigt dabei Variablen wie Akzente, Hintergrundgeräusche und Füllwörter wie „äh“ oder „hm“. Auf Mobilgeräten ist die Spracheingabe nicht nur einfacher, sondern sie kann auch weniger Bildschirmplatz in Anspruch nehmen, sodass mehr Platz für Produktbilder bleibt.

- Bildersuche: Dank der Bilderkennung können Sie schneller nach einem ähnlichen oder einzigartigen Artikel in einem Social-Media-Beitrag suchen oder ein Foto in der realen Welt aufnehmen. Käufer können dann die Bildersuche verwenden, um schnell nach einem ähnlichen Artikel auf Ihrer Website zu suchen und ihn zu finden.

Mobile-First-Ansatz

2024 erfolgten weltweit fast 80% aller E-Commerce-Besuche über ein Smartphone. Kleinere Bildschirme, kürzere Nutzersitzungen und gruppierte Menüs stellen die herkömmliche Suche vor besondere Herausforderungen. Der Conversational Commerce-Agent wurde entwickelt, damit Nutzer auf ihren Mobilgeräten die volle Leistungsfähigkeit der KI-gestützten Suche nutzen können.

Die Rolle von externer Suche und KI-Assistenten

Wenn ein Nutzer einen bevorzugten Einzelhändler hat, geht er in der Regel direkt dorthin. Wenn Nutzer jedoch neue oder umfassendere Optionen in Betracht ziehen, beginnt der Kaufprozess eher mit einer Marktplatzorientierung, z. B. in der Google Suche oder bei einem KI-Assistenten.

Da sich die KI-gestützte Suche weiterentwickelt, schließt das Paket „Geführte Suche mit Vertex AI Search for Commerce“ die Lücke zwischen externer und interner Produktfindung. Der Konversations-Agent für den Handel behandelt den Übergang zur Handelswebsite als einen einzigen, flüssigen Dialog. So finden Nutzer schnell relevante Ergebnisse.