Auf dieser Seite finden Sie eine Anleitung zur Implementierung der dialogbasierten Produktfilterung für Vertex AI Search for Commerce. Dieses Dokument enthält datengestützte Best Practices für die erfolgreiche Implementierung der konversationellen Produktfilterung für mittelständische und große Einzelhandelsunternehmen.

Die dialogbasierte Produktfilterung von Vertex AI Search for Commerce ist ein KI-basiertes Tool, das die Suche in eine geführte Suche umwandelt, um Käufer bei der Interaktion mit großen Produktkatalogen zu unterstützen. Wenn ein Websitebesucher eine allgemeine Suche durchführt (z. B. Couchtisch oder rotes Kleid), die Tausende von Ergebnissen liefert, werden ihm durch die konversationelle Produktfilterung auf intelligente Weise Folgefragen gestellt, um die Auswahl schnell einzugrenzen.

Geschäftlicher Anwendungsfall

Die dialogbasierte Produktfilterung in der geführten Suche wurde speziell für allgemeine, mehrdeutige oder sehr differenzierte Suchanfragen entwickelt. Wenn Sie Filter anwenden, um die Ergebnisse einzugrenzen, können Sie sowohl den Umsatz als auch die Nutzerinteraktionen deutlich steigern.

Das primäre Ziel der dialogbasierten Produktfilterung besteht darin, Käufern zu helfen, die richtigen Artikel schnell und intuitiv zu finden.

Unternehmen verwenden die dialogbasierte Filterung, um:

- Produkte schneller finden: Helfen Sie Käufern, eine große Auswahl an Produkten schnell einzugrenzen, indem Sie relevante Fragen stellen. So können sie beispielsweise aus 5.000 Teppichen einige Hundert gezielte Ergebnisse filtern.

- Personalisierung optimieren: Die Fragen und Auswahlmöglichkeiten sind für jede Anfrage benutzerdefiniert und basieren auf Verlaufsdaten zur Filternutzung für die jeweilige Anfrage. Bei der Anfrage Couchtisch wird beispielsweise häufiger nach der Farbe als nach der Größe gefiltert. Daher kann die Farbe zuerst abgefragt werden.

- Implementierung vereinfachen: Fragen sind für Produktattribute wie Farbe und Breite vordefiniert. Es gibt jeweils eine Frage pro Attribut.

Einseitige Unterhaltung

Die dialogbasierte Produktfilterung ist ein unidirektionaler Dialog, der den Käufer während der gesamten Suche auf einer E-Commerce-Website begleitet. Das KI-Modell stellt dem Käufer eine Frage und der Käufer antwortet.

Der Käufer gibt eine Suchanfrage ein. Beispiel: Teppiche

Die Einzelhandelswebsite gibt mehr als 80 Seiten mit Produktergebnissen zurück.

Vertex AI Search for Commerce stellt dem Käufer auf der Website eine Frage, um die Suche einzugrenzen. Beispiel: Welche Farbe suchen Sie?

Der Käufer wählt eine Antwort aus einer Liste von Multiple-Choice-Optionen aus. Beispiel: blau

Die Produktergebnisse auf der Seite werden sofort nach der Auswahl des Käufers gefiltert.

Die Suche präsentiert dann die nächstrelevanteste Folgefrage. Beispiel: Welche Form suchst du?

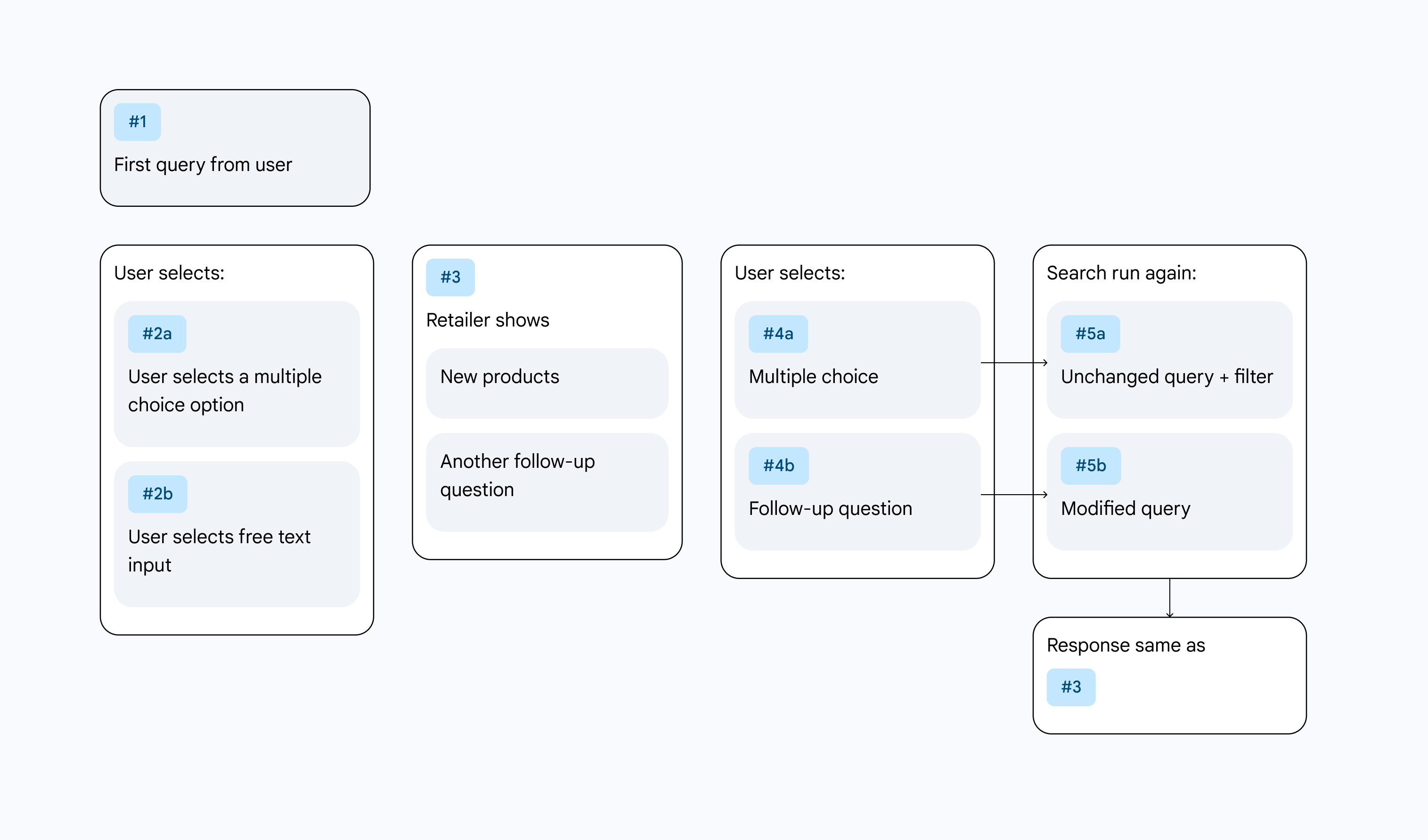

Abbildung 1. User Journey für die dialogbasierte Filterung.

Abbildung 1. User Journey für die dialogbasierte Filterung.

Iterative Verbesserung durch Tests

Die Optimierung der Konversationsfilterung von Produkten erfordert kontinuierliche Anpassungen und datengestützte Entscheidungen. Ziel ist es, die Funktion zum Erfassen von Nutzerinformationen zu maximieren, indem das Käuferverhalten analysiert und das Design entsprechend angepasst wird, um die Nutzerakzeptanz zu fördern.

Das Kaufverhalten wird von verschiedenen Faktoren wie Markttrends, Angeboten von Mitbewerbern und Änderungen der persönlichen Vorlieben beeinflusst. Es ist dynamisch und entwickelt sich im Laufe der Zeit weiter. Es ist wichtig, dass Sie weiterhin mit Ihrem Design experimentieren und es optimieren. Testen Sie neue Ansätze, während Sie mehr Daten erfassen und beobachten, wie Käufer mit den KI-Funktionen interagieren. Dieser fortlaufende Zyklus aus Tests, Datenanalyse und Optimierung trägt dazu bei, dass die KI-Funktionen relevant, effektiv und für Ihre sich entwickelnde Nutzerbasis optimiert bleiben.

Überprüfen Sie regelmäßig Leistungsmesswerte, führen Sie Nutzerumfragen durch und analysieren Sie Feedback, um Verbesserungsmöglichkeiten und neue Innovationschancen zu ermitteln. Diese Verpflichtung zur kontinuierlichen Iteration ist der Schlüssel zum langfristigen Erfolg bei der Bereitstellung von KI-Funktionen.

Erkenntnisse

Nach aufeinanderfolgenden Tests ergeben sich die folgenden Erkenntnisse:

- Kontinuierlich testen: Das optimale Ergebnis ist oft nicht das erste Design, das Sie ausprobieren.

- Iterieren und anpassen: Das Nutzerverhalten ändert sich. Sie sollten Ihre Designs immer wieder überarbeiten und neue Ansätze testen, wenn Sie mehr Daten sammeln und beobachten, wie Nutzer mit der Funktion interagieren.

- Mehr als nur A/B: Beschränken Sie sich nicht nur auf A/B-Tests, bei denen zwei Versionen verglichen werden. Führen Sie stattdessen viele A/B/C/D/E/F-Tests durch, um eine größere Auswahl an UI-Designs und Platzierungsoptionen zu testen.

Wichtige Messwerte für die Optimierung

Um Vertex AI Search für den Handel effektiv zu optimieren, ist es wichtig, relevante Messwerte zu definieren und zu erfassen, die Aufschluss über das Nutzer-Engagement, die Zufriedenheit und die Gesamtwirkung der Funktionen geben. Wichtige Messwerte:

- Conversion-Rate: Der Prozentsatz der Nutzer, die die Zielaktion ausführen, z. B. einen Kauf tätigen.

- Werte für die Nutzerzufriedenheit (z. B. NPS, CSAT): Direktes Feedback von Nutzern zu ihren Erfahrungen mit der KI-Funktion, das qualitative Einblicke in die Nutzerfreundlichkeit und den wahrgenommenen Wert bietet.

- Akzeptanzrate: Der Prozentsatz der Käufer, die die dialogbasierte Produktfilterung aktiv nutzen. Sie gibt Aufschluss über die Sichtbarkeit und den wahrgenommenen Nutzen.

Folgefragen in der Suche

Wenn die konversationelle Produktfilterung aktiviert ist, werden durch Anschlussfragen auf der Website Unterhaltungen ausgelöst, die so lange fortgesetzt werden, bis eines der drei folgenden Szenarien eintritt:

- Eine vorkonfigurierte Mindestanzahl an Produkten wird erreicht (eine Unterhaltung ist nicht sinnvoll, wenn nur zwei Produkte angezeigt werden).

- Der Nutzer klickt auf ein Produkt und legt es in den Einkaufswagen (das Zielvorhaben).

- Die dialogbasierte Produktfilterung wird durch KI-generierte Fragen ermöglicht.

Als Alternative zu dynamischen Attributen verwenden

Dynamische Facetten sind mit allgemeinen Anfragen und einer hohen Anzahl von Suchergebnissen verknüpft, was zu einem niedrigen Umsatz pro Anfrage führt. Endnutzer können überfordert sein, wenn sie Zehntausende von Ergebnissen sehen, und die Suche abbrechen. Die dialogbasierte Suche kann Abfragen optimieren und mit dynamischen Facetten verwendet werden. Die dialogbasierte Produktfilterung bietet einige Vorteile gegenüber dynamischen Facetten. Sie ist persönlicher, interaktiver und nimmt weniger Platz auf der Seite ein.

Weitere Informationen finden Sie auf der Seite Facetten.

Generative Fragen bearbeiten

Die dialogbasierte Produktfilterung fördert die Interaktion zwischen Mensch und generativer KI, da Einzelhändler KI-generierte Fragen anhand des hochgeladenen Katalogs vorab bearbeiten, überschreiben oder abwählen können. Fragen können in der Search for Commerce-Konsole oder über die API einzeln oder in großen Mengen bearbeitet oder deaktiviert werden, um sie an die gewünschten Suchergebnisse anzupassen.

Fazit

Durch die Integration der dialogorientierten Produktfilterung in Ihre E-Commerce-Plattform können Sie die Nutzerfreundlichkeit erheblich verbessern und die Conversion-Raten der Nutzer deutlich steigern. Das gilt insbesondere für Suchanfragen in einer breiten Kategorie, bei denen Nutzer oft eine überwältigende Auswahl haben und Schwierigkeiten haben, ihre Präferenzen schnell einzugrenzen.