É possível usar o recurso de teste integrado para descobrir bugs e evitar regressões. Para testar o agente, use o simulador para interagir com ele e salvar a conversa como um caso de teste.

Quando você salva um caso de teste, as correspondências de intent, as ações do playbook, os fluxos ativados e as páginas ativadas que ocorreram durante a conversa são salvas como expectativas do caso de teste. Quando você executar o caso de teste mais tarde, depois de fazer atualizações no agente, essas expectativas serão verificadas. Você também pode editar essas expectativas ao criar ou editar casos de teste.

Criar um caso de teste

Para criar um caso de teste usando o simulador:

- Abra o simulador.

- Converse com o agente.

- Clique no botão Criar caso de teste acima do simulador.

- O painel do editor de casos de teste é aberto. Informe o nome de exibição do caso de teste e edite qualquer uma das expectativas conforme necessário.

- Clique no botão Salvar caso de teste acima do simulador.

Executar casos de teste

Para executar um único caso de teste:

- Clique em Casos de teste na barra de navegação à esquerda.

- Selecione o caso de teste que você quer executar.

- Clique no botão Executar.

- Os resultados do histórico do caso de teste são mostrados.

Para executar vários casos de teste:

- Clique em Casos de teste na barra de navegação à esquerda.

- Selecione os casos de teste que você quer executar usando as caixas de seleção à esquerda.

- Clique em Executar selecionado.

- Os resultados da execução mais recente do teste são mostrados para cada caso de teste.

Editar um caso de teste

Ao editar um caso de teste, não é possível editar a mensagem do usuário final ou a resposta do agente, mas você pode mudar o seguinte:

- Adicionar expectativas

- Excluir expectativas

- Atualizar expectativas

Para editar um caso de teste:

- Clique em Casos de teste na barra de navegação à esquerda.

- Selecione o caso de teste que você quer editar.

- Clique no botão Editar acima do resumo do caso de teste.

- Você pode abrir a seção Expectativas no nível da conversa para editar as expectativas que se aplicam a toda a conversa.

- Cada turno de conversa mostra a mensagem do usuário final, a resposta do agente e as expectativas para o turno. Não é possível editar as mensagens, mas é possível editar as expectativas de nível de virada.

Excluir casos de teste

Para excluir casos de teste:

- Clique em Casos de teste na barra de navegação à esquerda.

- Selecione os casos de teste que você quer excluir usando as caixas de seleção à esquerda.

- Clique em Excluir casos de teste selecionados.

Expectativas

Ao fornecer expectativas para um caso de teste, você pode fornecer expectativas no nível da conversa ou expectativas no nível da vez.

As expectativas no nível da conversa se aplicam a toda a conversa, e você pode fornecer os seguintes tipos de expectativa:

- Uso da ferramenta

- Invocação de fluxo

- Invocação do playbook

As expectativas no nível da vez se aplicam apenas a uma vez de conversa específica, e você pode fornecer os seguintes tipos de expectativa:

- Resposta do agente

- Fluxo de corrente

- Intenção atual

- Página atual

- Uso da ferramenta

- Invocação de fluxo

- Invocação do playbook

Casos de teste legados

É possível usar o recurso de teste integrado para descobrir bugs e evitar regressões. Para testar o agente, crie casos de teste usando o simulador para definir casos de teste dourados e execute os casos de teste conforme necessário. Uma execução de teste verifica se as respostas do agente não foram alteradas para entradas do usuário final definidas no caso de teste.

As instruções abaixo mostram como usar o console, mas você também pode encontrar a mesma funcionalidade na API.

Configurações do simulador

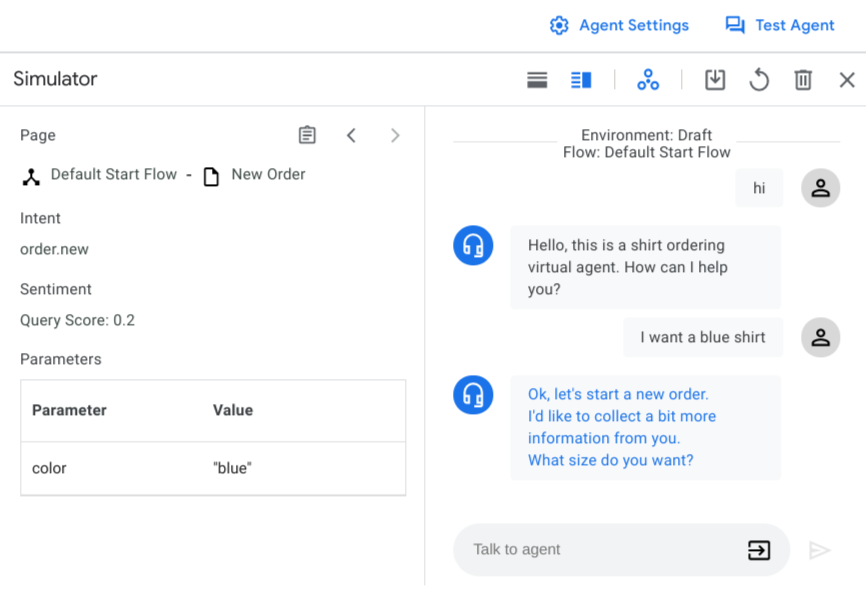

Ao abrir o simulador pela primeira vez, é preciso selecionar um ambiente de agente ou versões de fluxo e um fluxo ativo. Na maioria dos casos, é preciso usar o ambiente de rascunho e o fluxo inicial padrão.

Também é possível ativar ou desativar chamadas de webhook a qualquer momento com o botão de alternância do webhook. A desativação de webhooks é útil ao definir casos de teste.

Entrada do simulador

Ao interagir com o simulador, você fornece a entrada do usuário final como texto e, em seguida, aperte "Enter" ou clique no botão enviar . Além de texto simples, é possível escolher tipos de entrada alternativos com o seletor de entrada :

- Parâmetro: injetar um valor de parâmetro. É possível fornecer parâmetros novos ou fornecer valores predefinidos para os parâmetros existentes.

- Evento: invocar um evento.

- DTMF: enviar a entrada de sinal de frequência dupla (Touch-Tone) para interações de telefonia.

Criar um caso de teste

Para criar uma conversa:

- Abra o console do Dialogflow CX.

- Escolha o projeto.

- Selecione seu agente.

- Clique em Agente de teste para abrir o simulador.

- Converse com o agente para criar uma conversa que abranja a funcionalidade que você quer testar. Para cada fala, verifique os valores corretos da intent acionada, a resposta do agente, a página ativa e os parâmetros da sessão.

Para salvar uma conversa como um caso de teste:

- Clique no botão salvar .

- Insira o nome de exibição do caso de teste. Cada caso de teste precisa ter um nome de exibição exclusivo.

- Opcionalmente, forneça um nome para a tag. As tags ajudam você a organizar os casos de teste. Todas as tags precisam começar com "#".

- Opcionalmente, forneça uma observação que descreva a finalidade do caso de teste.

- É possível selecionar os parâmetros que você quer acompanhar no caso de teste. Uma lista de parâmetros sugeridos é fornecida. Também é possível inserir outros parâmetros para rastrear. Se você selecionar parâmetros de rastreamento, a declaração de parâmetro será verificada ao executar o caso de teste. Veja mais detalhes sobre a declaração de parâmetro na seção Executar casos de teste.

- Clique em Salvar para salvar o caso de teste.

Executar casos de teste

Para visualizar todos os casos de teste de um agente, clique em Casos de teste na guia Gerenciar. A tabela de casos de teste mostra o nome, as tags, o ambiente e o horário de teste mais recentes, assim como o resultado do teste mais recente.

Para executar casos de teste:

- Selecione os casos de testes que você quer executar e clique em Executar. Como alternativa, clique em Executar todos os casos de teste.

- Selecione o ambiente em que você quer executar os casos de teste novamente.

- Os testes começam a ser executados, e você verá o status na fila de tarefas. O resultado do teste será atualizado quando ele for concluído.

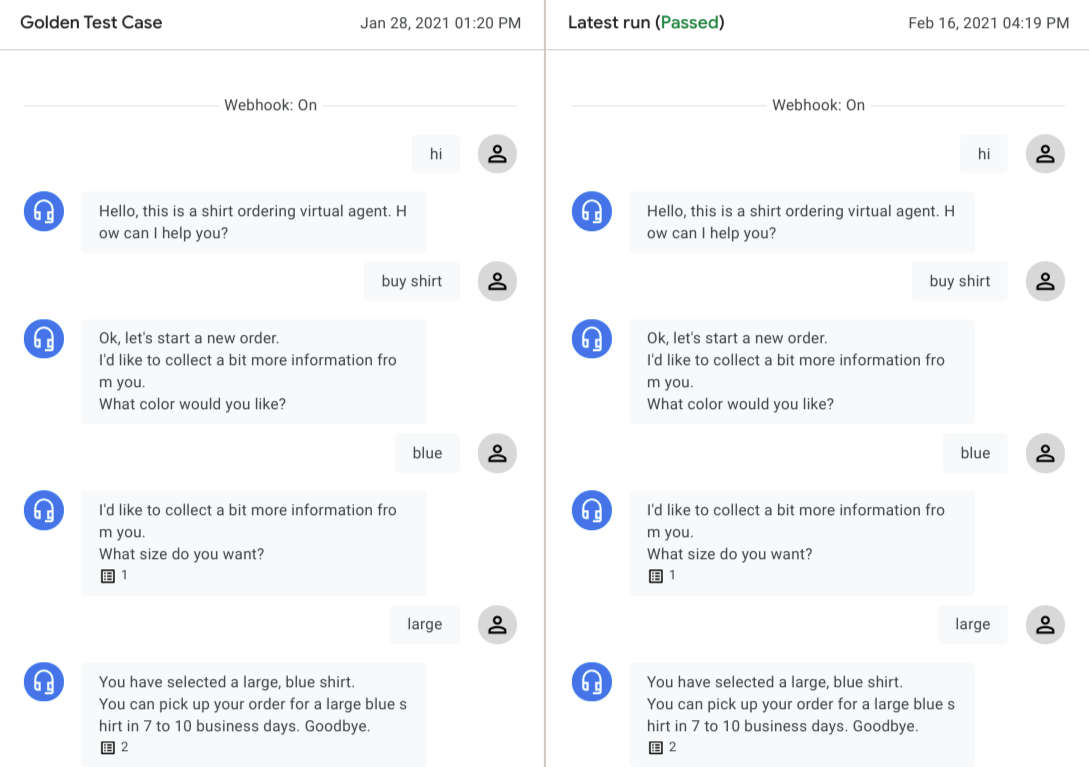

Para ver o resultado detalhado, clique no caso de teste. O caso de teste dourado e as conversas da execução mais recente são mostrados lado a lado.

Clique na fala de qualquer agente para ver os detalhes. O mecanismo de teste verifica os seguintes tipos de dados de cada fala para avaliar o resultado do teste:

Caixa de diálogo do agente:

Para cada turno da conversa, o diálogo do agente é comparado da corrida dourada à mais recente. Se houver alguma diferença, um aviso será exibido. Essas diferenças não impedem que um teste seja aprovado, porque a caixa de diálogo do agente geralmente varia para o mesmo estado do agente.

Intent correspondente:

A intent correspondente precisa ser a mesma para cada fala para um teste ser aprovado.

Página atual

A página ativa precisa ser a mesma para cada fala para um teste ser aprovado.

Parâmetros de sessão

Se você tiver adicionado parâmetros de rastreamento ao criar o caso de teste, o mecanismo de testes verificará os parâmetros da sessão correspondentes e o teste falhará se houver parâmetros ausentes/inesperados ou incompatibilidade de valores de parâmetros.

Em algumas situações, um caso de teste pode ter uma falha esperada devido a um agente atualizado. Se a conversa na última execução refletir as alterações esperadas, clique em Salvar como dourado para substituir o caso de teste dourado.

Editar casos de teste

Para editar um caso de teste, selecione-o na tabela Casos de teste e clique no ícone de edição ao lado do nome do caso de teste. A caixa de diálogo Atualizar casos de teste.

Para editar os metadados e as configurações do caso de teste, clique na guia Configurações.

Você pode editar os campos Nome do caso de teste, Tags e Observação ou adicionar novos parâmetros de acompanhamento.

Clique em Save.

Para editar a entrada do usuário para o caso de teste, clique na guia Entrada do usuário.

Adicione, remova ou edite as entradas do usuário no formato JSON.

Clique em Confirm. Um teste automático é iniciado e a conversa atualizada é exibida após a conclusão do teste.

Clique em Salvar para substituir o caso de teste original dourado ou clique em Salvar como para criar um novo caso de teste com as alterações.

Ver cobertura de teste

Para visualizar um relatório de cobertura de teste para todos os casos de teste, clique em Cobertura.

A página Cobertura inclui as seguintes guias:

A cobertura de transições é determinada para todos os gerenciadores de estado (sem incluir os grupos de rotas) com um destino de transição aplicado pelo caso de teste. O fluxo/página de origem e o fluxo/página de destino da transição estão listados na tabela.

A cobertura de intents é determinada para todas as intents que são correspondidas pelo caso de teste.

A cobertura de grupos de rotas é determinada para todos os grupos de rotas que correspondem ao caso de teste.

Importar e exportar casos de teste

Para exportar casos de teste:

- Selecione os casos de teste e clique em Exportar ou em Exportar todos os casos de teste.

- Clique em Fazer o download para o arquivo local ou forneça um URI de bucket do Cloud Storage e clique em Exportar para o Google Cloud Storage.

Ao importar casos de teste, os agentes de conversação (Dialogflow CX) sempre criam novos casos de teste para o agente de destino e não substituem os casos de teste existentes. Para importar casos de teste:

- Clique em Importar.

- Escolha um arquivo local ou forneça um URI de bucket do Cloud Storage.