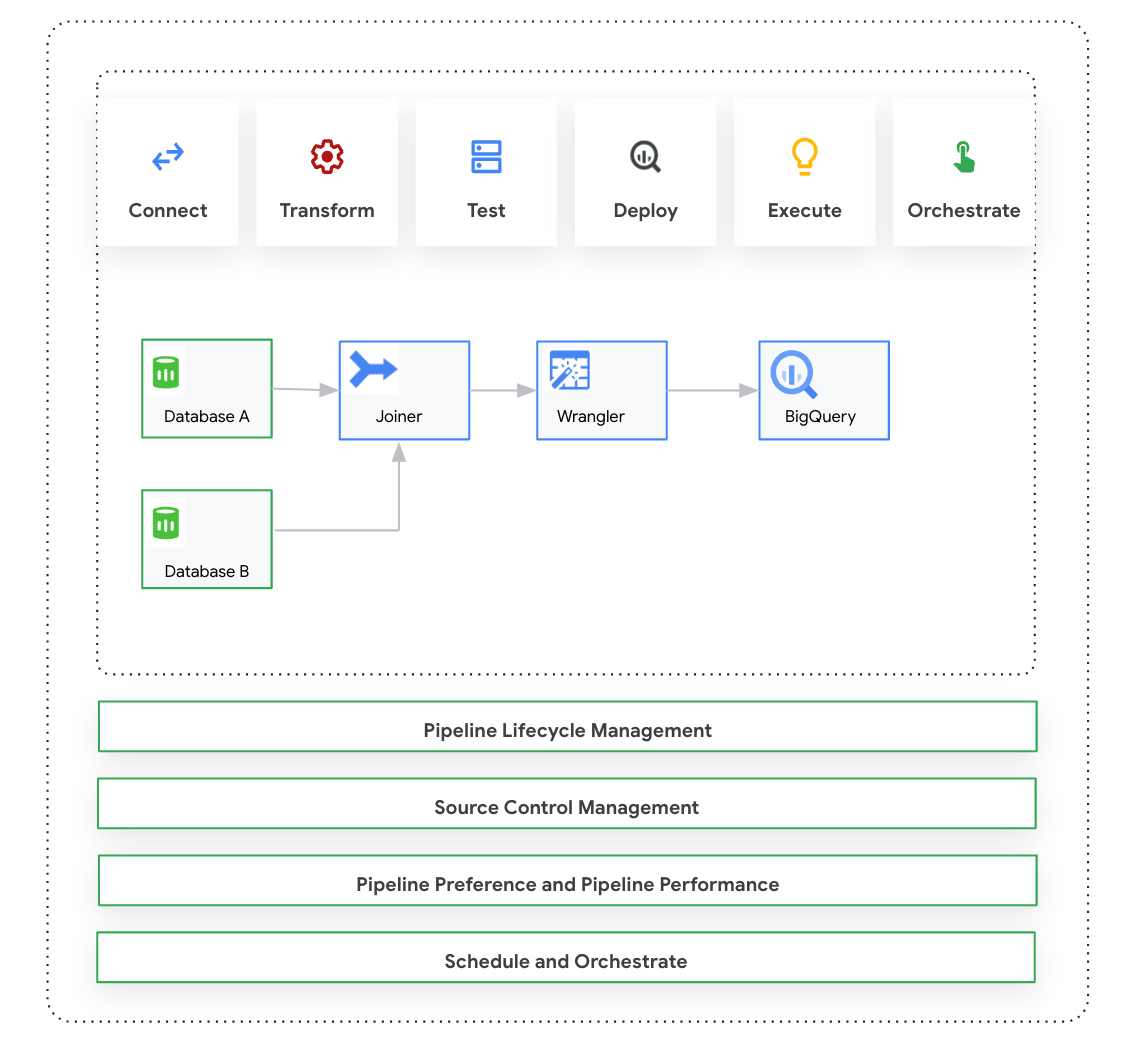

Questa pagina introduce Cloud Data Fusion: Studio, un'interfaccia visiva con trascinamento per la creazione di pipeline di dati da una libreria di plug-in predefiniti e un'interfaccia in cui configurare, eseguire e gestire le pipeline. La creazione di una pipeline in Studio segue in genere questa procedura:

- Connettiti a un'origine dati on-premise o cloud.

- Prepara e trasforma i dati.

- Connettiti alla destinazione.

- Testa la pipeline.

- Esegui la pipeline.

- Pianifica e attiva le pipeline.

Dopo aver progettato ed eseguito la pipeline, puoi gestirla nella pagina Pipeline Studio di Cloud Data Fusion:

- Riutilizza le pipeline parametrizzandone le preferenze e gli argomenti di runtime.

- Gestisci l'esecuzione della pipeline personalizzando i profili di calcolo, gestendo le risorse e ottimizzando il rendimento della pipeline.

- Gestisci il ciclo di vita delle pipeline modificandole.

- Gestisci il controllo del codice sorgente della pipeline utilizzando l'integrazione di Git.

Prima di iniziare

- Attiva l'API Cloud Data Fusion.

- Crea un'istanza Cloud Data Fusion.

- Scopri di più sul controllo dell'accesso in Cloud Data Fusion.

- Comprendi i concetti e i termini chiave di Cloud Data Fusion.

Cloud Data Fusion: panoramica di Studio

Studio include i seguenti componenti.

Amministrazione

Cloud Data Fusion ti consente di avere più spazi dei nomi in ogni istanza. In Studio, gli amministratori possono gestire tutti gli spazi dei nomi in modo centralizzato o ogni spazio dei nomi singolarmente.

Studio fornisce i seguenti controlli amministratore:

- Amministrazione di sistema

- Il modulo Amministrazione di sistema in Studio ti consente di creare nuovi spazi dei nomi e di definire le configurazioni del profilo di calcolo centrali a livello di sistema, applicabili a ogni spazio dei nomi nell'istanza. Per saperne di più, consulta Gestire l'amministrazione di Studio.

- Amministrazione dello spazio dei nomi

- Il modulo Amministrazione spazio dei nomi in Studio ti consente di gestire le configurazioni per lo spazio dei nomi specifico. Per ogni spazio dei nomi, puoi definire profili di calcolo, preferenze di runtime, driver, account di servizio e configurazioni git. Per saperne di più, consulta Gestire l'amministrazione di Studio.

Pipeline Design Studio

Progetta ed esegui le pipeline in Pipeline Design Studio nell'interfaccia web di Cloud Data Fusion. La progettazione ed esecuzione delle pipeline di dati include i seguenti passaggi:

- Connetti a un'origine: Cloud Data Fusion consente di collegarsi a origini dati on-premise e cloud. L'interfaccia di Studio ha plug-in di sistema predefiniti, preinstallati in Studio. Puoi scaricare plug-in aggiuntivi da un repository di plug-in, noto come Hub. Per maggiori informazioni, consulta la Panoramica dei plug-in.

- Preparazione dei dati: Cloud Data Fusion ti consente di preparare i dati utilizzando il potente plug-in di preparazione dei dati Wrangler. Wrangler ti aiuta a visualizzare, esplorare e trasformare un piccolo campione di dati in un unico posto prima di eseguire la logica sull'intero set di dati in Studio. In questo modo puoi applicare rapidamente le trasformazioni per capire in che modo incidono sull'intero set di dati. Puoi creare più trasformazioni e aggiungerle a una ricetta. Per ulteriori informazioni, consulta la panoramica di Wrangler.

- Trasforma: i plug-in di trasformazione modificano i dati dopo che sono stati caricati da una fonte. Ad esempio, puoi clonare un record, modificare il formato del file in JSON o utilizzare il plug-in JavaScript per creare una trasformazione personalizzata. Per maggiori informazioni, consulta la panoramica dei plug-in.

- Connettiti a una destinazione: dopo aver preparato i dati e applicato le trasformazioni, puoi connetterti alla destinazione in cui prevedi di caricarli. Cloud Data Fusion supporta le connessioni a più destinazioni. Per ulteriori informazioni, consulta la panoramica dei plug-in.

- Anteprima: dopo aver progettato la pipeline, per eseguire il debug dei problemi prima di eseguire il deployment e di eseguire una pipeline, esegui un job di anteprima. Se si verificano errori, puoi correggerli in modalità Bozza. Studio utilizza le prime 100 righe del set di dati di origine per generare l'anteprima. Studio mostra lo stato e la durata del job di anteprima. Puoi interrompere il job in qualsiasi momento. Puoi anche monitorare gli eventi di log durante l'esecuzione del job di anteprima. Per ulteriori informazioni, consulta Anteprima dei dati.

Gestire le configurazioni della pipeline: dopo aver visualizzato l'anteprima dei dati, puoi eseguire il deployment della pipeline e gestire le seguenti configurazioni:

- Configurazione di calcolo: puoi modificare il profilo di calcolo che esegue la pipeline, ad esempio se vuoi eseguire la pipeline su un cluster Dataproc personalizzato anziché sul cluster Dataproc predefinito.

- Configurazione della pipeline: per ogni pipeline, puoi attivare o disattivare l'instrumentazione, ad esempio le metriche sui tempi. Per impostazione predefinita, la misurazione è attivata.

- Configurazione del motore: Spark è il motore di esecuzione predefinito. Puoi trasmettere parametri personalizzati per Spark.

- Risorse: puoi specificare la memoria e il numero di CPU per il driver e l'executor Spark. Il driver orchestra il job Spark. L'executor gestisce l'elaborazione dei dati in Spark.

- Avviso sulla pipeline: puoi configurare la pipeline in modo che invii avvisi e inizi le attività di post-elaborazione al termine dell'esecuzione della pipeline. Puoi creare avvisi della pipeline quando la progetti. Dopo aver eseguito il deployment della pipeline, puoi visualizzare gli avvisi. Per modificare le impostazioni di avviso, puoi modificare la pipeline.

- Pushdown della trasformazione: puoi attivare il pushdown della trasformazione se vuoi che una pipeline esegua determinate trasformazioni in BigQuery.

Per ulteriori informazioni, consulta Gestire le configurazioni delle pipeline.

Riutilizza le pipeline utilizzando macro, preferenze e argomenti di runtime: Cloud Data Fusion ti consente di riutilizzare le pipeline di dati. Con le pipeline di dati riutilizzabili, puoi avere una singola pipeline che può applicare un pattern di integrazione dei dati a una serie di casi d'uso e set di dati. Le pipeline riutilizzabili offrono una migliore gestibilità. Ti consentono di impostare la maggior parte della configurazione di una pipeline in fase di esecuzione, anziché codificarla in modo rigido in fase di progettazione. In Pipeline Design Studio, puoi utilizzare le macro per aggiungere variabili alle configurazioni dei plug-in in modo da poter specificare le sostituzioni delle variabili in fase di esecuzione. Per saperne di più, consulta Gestire macro, preferenze e argomenti di runtime.

Esegui: dopo aver esaminato le configurazioni della pipeline, puoi avviarne l'esecuzione. Puoi vedere la modifica dello stato durante le fasi di esecuzione della pipeline, ad esempio provisioning, avvio, esecuzione e esito positivo.

Pianifica e orchestra: le pipeline di dati batch possono essere impostate per essere eseguite con una frequenza e una pianificazione specificate. Dopo aver creato e disegnato una pipeline, puoi creare una pianificazione. In Pipeline Design Studio, puoi orchestrare le pipeline creando un attivatore in una pipeline di dati batch in modo che venga eseguita al termine di una o più esecuzioni della pipeline. Si tratta delle pipeline dirette e a monte. Crea un trigger nella pipeline di destinazione in modo che venga eseguito in base al completamento di una o più pipeline di origine.

Consigliato: puoi anche utilizzare Composer per orchestrare le pipeline in Cloud Data Fusion. Per ulteriori informazioni, consulta Pianificare le pipeline e Orchestrare le pipeline.

Modifica delle pipeline: Cloud Data Fusion ti consente di modificare una pipeline di cui è stato eseguito il deployment. Quando modifichi una pipeline di cui è stato eseguito il deployment, viene creata una nuova versione della pipeline con lo stesso nome e viene contrassegnata come la versione più recente. In questo modo, puoi sviluppare le pipeline in modo iterativo anziché duplicarle, creando una nuova pipeline con un nome diverso. Per ulteriori informazioni, consulta Modificare le pipeline.

Gestione del controllo del codice sorgente: Cloud Data Fusion ti consente di gestire meglio le pipeline tra lo sviluppo e la produzione con la gestione del controllo del codice sorgente delle pipeline utilizzando GitHub.

Logging e monitoraggio: per monitorare le metriche e i log della pipeline, ti consigliamo di attivare il servizio di logging di Stackdriver per utilizzare Cloud Logging con la pipeline Cloud Data Fusion.

Passaggi successivi

- Scopri di più sulla gestione dell'amministrazione di Studio.