Vertex AI 가격 책정

가격은 미국 달러(USD)로 표기됩니다. USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

Vertex AI 가격 책정 및 기존 제품 가격 책정 비교

Vertex AI의 비용은 Vertex AI가 대체하는 기존 AI Platform 및 AutoML 제품의 비용과 동일하게 유지됩니다. 단, 다음은 제외됩니다.

- 기존 AI Platform Prediction과 AutoML Tables 예측은 Vertex AI 추론 및 AutoML 테이블 형식에 지원되지 않는 더 저렴하고 성능이 떨어지는 머신 유형을 지원했습니다.

- 기존 AI Platform Prediction은 Vertex AI 추론에 지원되지 않는 Scale-to-zero를 지원했습니다.

또한 Vertex AI는 다음과 같이 비용을 최적화하는 다양한 방법을 제공합니다.

- 최적화된 TensorFlow 런타임

- 공동 호스팅 모델 지원

- 학습 및 예측에 대한 최소 사용 기간이 없습니다. 대신 30초 단위로 사용 비용이 청구됩니다.

Vertex AI의 생성형 AI 가격 책정

Vertex AI의 생성형 AI 가격 책정 정보는 Vertex AI의 생성형 AI 가격 책정을 참조하세요.

AutoML 모델 가격 책정

Vertex AI AutoML 모델의 경우 다음 세 가지 주요 활동에 대한 비용이 청구됩니다.

- 모델 학습

- 엔드포인트에 모델 배포하기

- 모델을 사용하여 예측

Vertex AI에서는 Vertex AutoML 모델에 사전 정의된 머신 구성을 사용하고 이러한 활동의 시간당 요금에 리소스 사용량이 반영됩니다.

모델 학습에 필요한 시간은 학습 데이터의 규모와 복잡성에 따라 달라집니다. 모델에서 온라인 예측 또는 온라인 설명을 제공하려면 먼저 모델을 배포해야 합니다.

예측이 생성되지 않더라도 엔드포인트에 배포된 각 모델마다 요금을 지불해야 합니다. 추가 요금이 발생하지 않도록 하려면 모델의 배포를 취소해야 합니다. 배포되지 않았거나 배포에 실패한 모델에는 요금이 청구되지 않습니다.

사용한 컴퓨팅 시간에 대해서만 비용을 지불합니다. 따라서 사용자 취소 이외의 다른 이유로 학습에 실패한 경우 해당 시간에 대한 요금은 청구되지 않습니다. 사용자가 작업을 취소하는 경우에는 학습 시간에 해당하는 비용이 청구됩니다.

가격 책정 정보를 보려면 아래에서 모델 유형을 선택하세요.

이미지 데이터

이미지 데이터

작업 | 가격 (분류) (USD) | 가격 (객체 감지) (USD) |

|---|---|---|

학습 | US$3.465 / 1 hour | US$3.465 / 1 hour |

학습(에지 기기 전용 모델) | US$18.00 / 1 hour | US$18.00 / 1 hour |

배포 및 온라인 예측 | US$1.375 / 1 hour | US$2.002 / 1 hour |

일괄 예측 | US$2.222 / 1 hour | US$2.222 / 1 hour |

테이블 형식 데이터

테이블 형식 데이터

작업 | 분류/회귀에 대한 노드 시간당 가격 | 예측 가격 |

|---|---|---|

학습 | US$21.252 / 1 hour | |

추론 | 커스텀 학습 모델 추론과 동일한 가격 Vertex AI는 40개의 n1-highmem-8 머신을 사용하여 일괄 추론을 수행합니다. |

Vertex Explainable AI 추론 요금

Vertex Explainable AI와 연결된 컴퓨팅에는 추론과 동일한 요금이 청구됩니다. 하지만 설명은 일반적인 추론보다 처리 시간이 오래 걸리므로 Vertex Explainable AI를 자동 확장과 함께 과도하게 사용할 경우 많은 노드가 시작되어 추론 요금이 증가할 수 있습니다.

Vertex AI Forecast

AutoML

AutoML

단계 | 가격 책정 |

|---|---|

예측 | 0 count to 1,000,000 count US$0.20 / 1,000 count, per 1 month / account 1,000,000 count to 50,000,000 count US$0.10 / 1,000 count, per 1 month / account 50,000,000 count and above US$0.02 / 1,000 count, per 1 month / account |

학습 | US$21.252 / 1 hour |

Explainable AI | Shapley 값을 사용한 설명 기능. Vertex AI Inference and Explanation 가격 책정 페이지 참조 |

* 예측 데이터 포인트는 예측 범위의 한 시점입니다. 예를 들어 일별 세부사항을 사용하면 7일 범위는 각 시계열당 7개 포인트입니다.

- 추가 비용 없이 최대 5개 예측 분위수를 포함할 수 있습니다.

- 등급당 소비되는 데이터 포인트 수는 매월 새로고침됩니다.

ARIMA+

ARIMA+

단계 | 가격 책정 |

|---|---|

예측 | US$5.00 / 1,000 count |

학습 | TB당$250.00 x 후보 모델 수 x 백테스트 창 수* |

Explainable AI | 시계열 분해를 통한 설명 기능은 추가 비용이 발생하지 않습니다. Shapley 값을 사용한 설명 기능은 지원되지 않습니다. |

자세한 내용은 BigQuery ML 가격 책정 페이지를 참조하세요. Vertex AI 가격 책정에 설명된 것처럼 각 학습 및 예측 작업에는 관리형 파이프라인 실행 1회 비용이 발생합니다.

* 테스트 세트의 기간별로 백테스트 창이 생성됩니다. 사용된 AUTO_ARIMA_MAX_ORDER는 후보 모델의 수를 결정합니다. 여러 시계열이 있는 모델의 경우 범위는 6~42입니다.

커스텀 학습 모델

교육

교육

아래 표에는 다양한 학습 구성의 대략적인 시간당 가격이 나와 있습니다. 선택한 머신 유형의 커스텀 구성을 선택할 수 있습니다. 가격을 계산하려면 사용하는 가상 머신 비용의 합계를 구하세요.

Compute Engine 머신 유형을 사용하고 가속기를 추가하면 가속기 비용이 별도로 부과됩니다. 이 비용을 계산하려면 아래의 가속기 표에 있는 가격에 현재 사용 중인 각 가속기 유형의 실행 시간을 곱하세요.

머신 유형

머신 유형

Vertex AI 커스텀 학습에서 스팟 VM을 사용할 수 있습니다. 스팟 VM 요금은 Compute Engine 스팟 VM 가격 책정에 따라 청구됩니다. 인프라 사용량 외에도 Vertex AI 커스텀 학습 관리 수수료가 있으며, 아래 표에 나와 있습니다.

Vertex AI 커스텀 학습에서 Compute Engine 예약을 사용할 수 있습니다. Compute Engine 예약을 사용하면 해당하는 약정 사용 할인 (CUD)을 포함하여 Compute Engine 가격 책정에 따라 요금이 청구됩니다. 인프라 사용량 외에도 Vertex AI 커스텀 학습 관리 수수료가 있으며, 아래 표에 나와 있습니다.

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Stockholm (europe-north2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Alabama (us-east7)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

머신 유형 | 가격(USD) |

|---|---|

g4-standard-48 | US$5.1749195 / 1 hour |

g4-standard-96 | US$10.349839 / 1 hour |

g4-standard-192 | US$20.699678 / 1 hour |

g4-standard-384 | US$41.399356 / 1 hour |

n1-standard-4 | US$0.21849885 / 1 hour |

n1-standard-8 | US$0.4369977 / 1 hour |

n1-standard-16 | US$0.8739954 / 1 hour |

n1-standard-32 | US$1.7479908 / 1 hour |

n1-standard-64 | US$3.4959816 / 1 hour |

n1-standard-96 | US$5.2439724 / 1 hour |

n1-highmem-2 | US$0.13604845 / 1 hour |

n1-highmem-4 | US$0.2720969 / 1 hour |

n1-highmem-8 | US$0.5441938 / 1 hour |

n1-highmem-16 | US$1.0883876 / 1 hour |

n1-highmem-32 | US$2.1767752 / 1 hour |

n1-highmem-64 | US$4.3535504 / 1 hour |

n1-highmem-96 | US$6.5303256 / 1 hour |

n1-highcpu-16 | US$0.65180712 / 1 hour |

n1-highcpu-32 | US$1.30361424 / 1 hour |

n1-highcpu-64 | US$2.60722848 / 1 hour |

n1-highcpu-96 | US$3.91084272 / 1 hour |

a2-highgpu-1g* | US$4.425248914 / 1 hour |

a2-highgpu-2g* | US$8.850497829 / 1 hour |

a2-highgpu-4g* | US$17.700995658 / 1 hour |

a2-highgpu-8g* | US$35.401991315 / 1 hour |

a2-megagpu-16g* | US$65.707278915 / 1 hour |

a3-highgpu-8g* | US$101.007352832 / 1 hour |

a3-megagpu-8g* | US$106.046424032 / 1 hour |

a3-ultragpu-8g* | US$99.773930496 / 1 hour |

a4-highgpu-8g* | US$148.212 / 1 hour |

e2-standard-4 | US$0.154126276 / 1 hour |

e2-standard-8 | US$0.308252552 / 1 hour |

e2-standard-16 | US$0.616505104 / 1 hour |

e2-standard-32 | US$1.233010208 / 1 hour |

e2-highmem-2 | US$0.103959618 / 1 hour |

e2-highmem-4 | US$0.207919236 / 1 hour |

e2-highmem-8 | US$0.415838472 / 1 hour |

e2-highmem-16 | US$0.831676944 / 1 hour |

e2-highcpu-16 | US$0.455126224 / 1 hour |

e2-highcpu-32 | US$0.910252448 / 1 hour |

n2-standard-4 | US$0.2233714 / 1 hour |

n2-standard-8 | US$0.4467428 / 1 hour |

n2-standard-16 | US$0.8934856 / 1 hour |

n2-standard-32 | US$1.7869712 / 1 hour |

n2-standard-48 | US$2.6804568 / 1 hour |

n2-standard-64 | US$3.5739424 / 1 hour |

n2-standard-80 | US$4.467428 / 1 hour |

n2-highmem-2 | US$0.1506661 / 1 hour |

n2-highmem-4 | US$0.3013322 / 1 hour |

cloud-tpu | 가격은 가속기 유형에 따라 책정됩니다. 자세한 내용은 '가속기'를 참조하세요. |

n2-highmem-8 | US$0.6026644 / 1 hour |

n2-highmem-16 | US$1.2053288 / 1 hour |

n2-highmem-32 | US$2.4106576 / 1 hour |

n2-highmem-48 | US$3.6159864 / 1 hour |

n2-highmem-64 | US$4.8213152 / 1 hour |

n2-highmem-80 | US$6.026644 / 1 hour |

n2-highcpu-16 | US$0.6596032 / 1 hour |

n2-highcpu-32 | US$1.3192064 / 1 hour |

n2-highcpu-48 | US$1.9788096 / 1 hour |

n2-highcpu-64 | US$2.6384128 / 1 hour |

n2-highcpu-80 | US$3.298016 / 1 hour |

c2-standard-4 | US$0.2401292 / 1 hour |

c2-standard-8 | US$0.4802584 / 1 hour |

c2-standard-16 | US$0.9605168 / 1 hour |

c2-standard-30 | US$1.800969 / 1 hour |

c2-standard-60 | US$3.601938 / 1 hour |

m1-ultramem-40 | US$7.237065 / 1 hour |

m1-ultramem-80 | US$14.47413 / 1 hour |

m1-ultramem-160 | US$28.94826 / 1 hour |

m1-megamem-96 | US$12.249984 / 1 hour |

*이 금액에는 GPU 가격이 포함되어 있습니다. 이 인스턴스 유형에는 항상 고정된 수의 GPU 가속기가 필요하기 때문입니다.

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

가속기

가속기

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Berlin (europe-west10)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

머신 유형 | 가격(USD) | Vertex 관리 수수료 |

|---|---|---|

NVIDIA_TESLA_A100 | US$2.933908 / 1 hour | US$0.4400862 / 1 hour |

NVIDIA_TESLA_A100_80GB | US$3.92808 / 1 hour | US$0.589212 / 1 hour |

NVIDIA_H100_80GB | US$9.79655057 / 1 hour | US$1.4694826 / 1 hour |

NVIDIA_H200_141GB | US$10.708501 / 1 hour | 사용할 수 없음 |

NVIDIA_H100_MEGA_80GB | US$11.8959171 / 1 hour | 사용할 수 없음 |

NVIDIA_TESLA_L4 | US$0.644046276 / 1 hour | 사용할 수 없음 |

NVIDIA_TESLA_P4 | US$0.69 / 1 hour | 사용할 수 없음 |

NVIDIA_TESLA_P100 | US$1.679 / 1 hour | 사용할 수 없음 |

NVIDIA_TESLA_T4 | US$0.4025 / 1 hour | 사용할 수 없음 |

NVIDIA_TESLA_V100 | US$2.852 / 1 hour | 사용할 수 없음 |

TPU_V2 Single (8코어) | US$5.175 / 1 hour | 사용할 수 없음 |

TPU_V2 포드 (코어 32개)* | US$27.60 / 1 hour | 사용할 수 없음 |

TPU_V3 Single (코어 8개) | US$9.20 / 1 hour | 사용할 수 없음 |

TPU_V3 포드 (코어 32개)* | US$36.80 / 1 hour | 사용할 수 없음 |

tpu7x-standard-4t (1개 칩) | US$13.80 / 1 hour | 사용할 수 없음 |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

* Cloud TPU 포드를 사용한 학습 가격은 포드의 코어 수에 따라 결정됩니다. 포드의 코어 수는 항상 32의 배수입니다. 코어가 32개가 넘는 포드의 학습 가격을 결정하려면 32코어 포드의 가격에 코어 수를 32로 나눈 값을 곱합니다. 예를 들어 128코어 포드의 경우 가격은 (32코어 포드 가격) * (128/32)입니다. 특정 리전에서 사용할 수 있는 Cloud TPU Pod에 관한 자세한 내용은 Cloud TPU 문서의 시스템 아키텍처를 참조하세요.

디스크

디스크

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

pd-standard | US$0.000063014 / 1 gibibyte hour |

pd-ssd | US$0.000267808 / 1 gibibyte hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

- 모든 사용에는 Vertex AI 할당량 정책이 적용됩니다.

- Vertex AI 수명 주기 동안 데이터 및 프로그램 파일을 Google Cloud Storage 버킷에 저장해야 합니다. Cloud Storage 사용에 대해 자세히 알아보세요.

리소스가 작업에 프로비저닝된 순간부터 작업이 완료될 때까지 모델 학습 비용이 청구됩니다.

경고: 학습 작업에는 Vertex AI 할당량 정책이 적용됩니다. 첫 학습 작업에 매우 강력한 처리 클러스터를 선택할 경우 할당량을 초과할 가능성이 높습니다.

사전 정의된 구성을 위한 확장 등급(AI Platform Training)

모델을 학습시킬 때 사용할 처리 클러스터의 유형을 제어할 수 있습니다. 가장 간단한 방법은 확장 등급이라는 사전 정의된 구성 중 하나를 선택하는 것입니다. 확장 등급에 대해 자세히 알아보세요.

커스텀 구성용 머신 유형

Vertex AI를 사용하거나 AI Platform Training의 확장 등급으로 CUSTOM 선택하면 클러스터의 마스터, 작업자, 파라미터 서버에 사용할 가상 머신의 개수와 유형을 제어할 수 있습니다. Vertex AI의 머신 유형과 AI Platform Training의 머신 유형에 대해 자세히 알아보세요.

커스텀 처리 클러스터를 사용한 학습에는 지정한 모든 머신의 비용을 합친 요금이 청구됩니다. 개별 머신의 활성 처리 시간이 아니라 작업의 총 시간에 대해 요금이 청구됩니다.

Gen AI Evaluation Service

모델 기반 측정항목의 경우 기본 자동 평가 도구 모델과 관련된 예측 비용에 대해서만 요금이 청구됩니다. 평가 데이터 세트와 자동 평가 도구 출력에 제공하는 입력 토큰을 기준으로 요금이 청구됩니다.

Gen AI Evaluation Service가 정식 버전 (GA)으로 제공됩니다. 가격 변경사항은 2025년 4월 14일부터 적용되었습니다.

미터법 | 가격 책정 |

|---|---|

점별 | 기본 자동 채점 모델 Gemini 2.0 Flash |

쌍별 | 기본 자동 채점 모델 Gemini 2.0 Flash |

계산 기반 측정항목은 입력의 경우 1,000자당 $0.00003, 출력의 경우 1,000자당 $0.00009의 요금이 청구됩니다. SKU에서 자동 측정항목이라고 합니다.

측정항목 이름 | 유형 |

|---|---|

완전 일치 | 계산 기반 |

Bleu | 계산 기반 |

Rouge | 계산 기반 |

유효한 도구 호출 | 계산 기반 |

도구 이름 일치 | 계산 기반 |

도구 파라미터 키 일치 | 계산 기반 |

도구 파라미터 KV 일치 | 계산 기반 |

가격은 미국 달러(USD)로 표기됩니다. USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

기존 모델 기반 측정항목은 입력의 경우 문자 1,000개당 $0.005, 출력의 경우 문자 1,000개당 $0.015의 요금이 청구됩니다.

측정항목 이름 | 유형 |

|---|---|

일관성 | 점별 |

유창성 | 점별 |

Fulfillment | 점별 |

안전 | 점별 |

그라운딩 | 점별 |

요약 품질 | 점별 |

요약 유용성 | 점별 |

요약 상세 출력 | 점별 |

질의 응답 품질 | 점별 |

질의 응답 관련성 | 점별 |

질의 응답 유용성 | 점별 |

질의 응답 정확성 | 점별 |

쌍 요약 품질 | 쌍별 |

쌍별 질의 응답 품질 | 쌍별 |

가격은 미국 달러(USD)로 표기됩니다. USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

Vertex AI Agent Engine

Vertex AI Agent Engine은 개발자가 프로덕션에서 에이전트를 확장할 수 있도록 지원하는 서비스 모음입니다. 서비스는 함께 사용하거나 개별적으로 사용할 수 있습니다. 사용한 만큼만 비용을 지불하면 됩니다. 현재는 Agent Engine 런타임에 대한 요금을 지불합니다.

2026년 2월 11일부터 코드 실행, 세션, 메모리 뱅크에 대한 요금이 청구됩니다.

런타임

가격은 Agent Engine 런타임에 배포된 에이전트에서 사용하는 컴퓨팅 (vCPU 시간) 및 메모리 (GiB 시간) 리소스를 기준으로 책정됩니다. 요금은 사용량에 따라 가장 가까운 초 단위로 반올림됩니다. 에이전트의 유휴 시간은 청구되지 않습니다.

무료 등급

런타임을 시작하는 데 도움이 되도록 월별 무료 등급을 제공합니다.

- vCPU - 처음 180,000vCPU-초 (50시간)/월 무료

- RAM - 처음 360,000GiB-초 (100시간)/월 무료

사용량 기반 가격 책정

월간 사용량이 무료 등급을 초과하면 아래 요금에 따라 요금이 청구됩니다.

리소스 | 가격(USD) |

|---|---|

vCPU | 0 hour to 50 hour US$0.00 (Free) / 3,600 second, per 1 month / project 50 hour and above US$0.0864 / 3,600 second, per 1 month / project |

RAM | 0 gibibyte hour to 100 gibibyte hour US$0.00 (Free) / 3,600 gibibyte second, per 1 month / project 100 gibibyte hour and above US$0.009 / 3,600 gibibyte second, per 1 month / project |

코드 실행

런타임과 마찬가지로 샌드박스를 실행하는 데 필요한 컴퓨팅 및 메모리에 대한 비용을 지불합니다. 요금은 사용량에 따라 가장 가까운 초 단위로 반올림됩니다. 유휴 시간은 청구되지 않습니다.

- 컴퓨팅: vCPU 시간당 $0.0864

- 메모리: GiB-시간당$0.0090

세션

세션 서비스에 저장된 이벤트 수에 따라 요금을 지불합니다. Google Cloud는 콘텐츠가 포함된 저장된 세션 이벤트에 대해 요금을 청구합니다. 여기에는 초기 사용자 요청, 모델 응답, 함수 호출, 함수 응답이 포함됩니다. 세션 서비스에 저장된 시스템 제어 이벤트 (예: 체크포인트)에 대해서는 청구하지 않습니다.

- 저장된 이벤트 1,000개당 $0.25

메모리 뱅크

저장되고 반환된 메모리 수에 따라 비용을 지불합니다.

- 저장된 메모리: 저장된 메모리 1,000개당 월$0.25 (+ 메모리 생성을 위한 LLM 비용은 별도 지불)

- 기억 검색: 반환된 기억 1,000개당 $0.50, 매월 반환된 첫 1,000개의 기억은 무료

가격 책정 시나리오

가격 책정 시나리오

Agent Engine 서비스 사용 비용을 이해하는 데 도움이 되도록 경량 에이전트와 표준 에이전트라는 두 가지 가상 에이전트를 제공합니다. 두 시나리오 모두에 대해 다음과 같은 가정을 합니다.

- 무료 등급: 이 계산에서는 런타임 및 메모리 뱅크 무료 등급이 이전 실험을 위해 한 달 내에 이미 사용되었다고 가정합니다.

- 세션당 런타임 요청: '전체 세션' 또는 대화는 10개의 런타임 요청으로 구성됩니다.

- 세션: 각 런타임 요청은 평균 3개의 세션 이벤트를 생성합니다.

- 메모리 뱅크:

- 스토리지: 각 전체 세션이 끝나면 1개의 메모리가 추출되어 저장됩니다.

- 검색: 런타임 요청당 평균 1개의 메모리가 반환된다고 가정합니다.

- Code Execution은 모든 런타임 요청의 30% 에 대해 호출됩니다.

- 청구 월: 모든 월별 계산은 30일을 기준으로 합니다.

기타 참고사항:

- 서비스 모듈성: 아래 시나리오에서는 함께 사용되는 Agent Engine 서비스의 비용을 보여주지만, 서비스를 개별적으로 사용할 수도 있습니다. 예를 들어 Agent Engine 런타임을 사용하지 않고도 Agent Engine 세션 및 메모리 뱅크 서비스를 사용할 수 있습니다.

- 추가 모델 비용: 에이전트에는 추론 및 계획을 위한 LLM이 필요합니다. 에이전트가 소비한 LLM 토큰은 별도로 청구되며 아래 시나리오에 포함되지 않습니다.

- 추가 도구 비용: 에이전트가 작업을 수행하려면 도구가 필요합니다. 에이전트가 사용하는 도구 (예: API 호출, 스토리지)는 별도로 청구되며 아래 시나리오에 포함되지 않습니다.

가상 시나리오

가상 시나리오

시나리오 1: 경량 내부 에이전트

이 시나리오는 낮은 볼륨의 간헐적인 트래픽을 처리하는 에이전트를 나타냅니다.

- 사용 사례 예시: 소규모 회사의 IT 헬프데스크 봇, 이메일을 작성하는 개인 생산성 에이전트, 문서에서 답을 제공하는 Slack 봇

- 런타임 및 코드 실행에 필요한 컴퓨팅 및 메모리: vCPU 1개 / RAM 1GiB

- 트래픽: 초당 0.16개 쿼리 (분당 10개 쿼리), 월간 총 432,000개 요청

- 평균 요청 시간: 3초

서비스 | 계산 | 월간 비용 |

|---|---|---|

런타임 | (요청 432,000개 × 3초/요청 ÷ 3,600초/시간) = 360시간 vCPU: (360시간 × 1 vCPU × $0.0864/시간) = $31.10 RAM: (360시간 × 1GiB × $0.0090/시간) = $3.24 | $34.34 |

코드 실행 | (360시간 런타임 × 30% 사용량) = 108시간 vCPU: (108시간 × 1 vCPU × $0.0864/시간) = $9.33 RAM: (108시간 × 1GiB × $0.0090/시간) = $0.97 | $10.30 |

세션 | 요청 432,000개 x 이벤트 3개 ÷ 1,000 x $0.25 | $324 |

메모리 뱅크 | 저장됨: (요청 432,000개 ÷ 요청 10개/세션 × 메모리 1개/세션 ÷ 1,000) × $0.25 = $10.80 검색: (432,000회 요청 × 1회 반환된 메모리 ÷ 1,000) × $0.50 = $216.00 | $226.80 |

총 예상 월간 비용 | $595.44 |

시나리오 2: 표준 에이전트

이 시나리오는 비즈니스 애플리케이션에 통합되어 일관된 사용자 트래픽을 처리하는 프로덕션 에이전트를 나타냅니다.

- 사용 사례 예시: 전자상거래 사이트의 고객 서비스 에이전트, B2B 웹사이트의 리드 자격 봇, 영업팀의 내부 데이터 분석 에이전트

- 컴퓨팅: vCPU 2개 / RAM 5GiB

- 트래픽: 초당 10개 쿼리 (분당 600개 쿼리), 총 월 25,920,000개 요청

- 평균 요청 시간: 5초

서비스 | 계산 | 월간 비용 |

|---|---|---|

런타임 | (25,920,000회 요청 × 5초/요청 ÷ 3,600초/시간) = 36,000시간 vCPU: (36,000시간 × vCPU 2개 × $0.0864/시간) = $6,220.80 RAM: (36,000시간 × 5GiB × $0.0090/시간) = $1,620.00 | $7,840.80 |

코드 실행 | (36,000 런타임 시간 × 30% 사용량) = 10,800시간 vCPU: (10,800시간 × vCPU 2개 × $0.0864/시간) = $1,866.24 RAM: (10,800시간 × 5GiB × $0.0090/시간) = $486 | $2,352.24 |

세션 | 요청 25,920,000개 * 이벤트 3개 ÷ 1,000 × $0.25 | $19,440 |

메모리 뱅크 | 저장됨: (25,920,000회 요청 ÷ 10회 요청/세션 × 1회 메모리/세션 ÷ 1,000) × $0.25 = $648.00 검색: (25,920,000회 요청 × 1회 반환된 메모리 ÷ 1,000) × $0.50 = $12,960.00 | $13,608 |

총 예상 월간 비용 | $43,241.04 |

Vertex AI 기반 Ray

교육

교육

아래 표에는 다양한 학습 구성의 대략적인 시간당 가격이 나와 있습니다. 선택한 머신 유형의 커스텀 구성을 선택할 수 있습니다. 가격을 계산하려면 사용하는 가상 머신 비용의 합계를 구하세요.

Compute Engine 머신 유형을 사용하고 가속기를 추가하면 가속기 비용이 별도로 부과됩니다. 이 비용을 계산하려면 아래의 가속기 표에 있는 가격에 현재 사용 중인 각 가속기 유형의 실행 시간을 곱하세요.

머신 유형

머신 유형

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

머신 유형 | 가격(USD) |

|---|---|

n1-standard-4 | US$0.2279988 / 1 hour |

n1-standard-8 | US$0.4559976 / 1 hour |

n1-standard-16 | US$0.9119952 / 1 hour |

n1-standard-32 | US$1.8239904 / 1 hour |

n1-standard-64 | US$3.6479808 / 1 hour |

n1-standard-96 | US$5.4719712 / 1 hour |

n1-highmem-2 | US$0.1419636 / 1 hour |

n1-highmem-4 | US$0.2839272 / 1 hour |

n1-highmem-8 | US$0.5678544 / 1 hour |

n1-highmem-16 | US$1.1357088 / 1 hour |

n1-highmem-32 | US$2.2714176 / 1 hour |

n1-highmem-64 | US$4.5428352 / 1 hour |

n1-highmem-96 | US$6.8142528 / 1 hour |

n1-highcpu-16 | US$0.68014656 / 1 hour |

n1-highcpu-32 | US$1.36029312 / 1 hour |

n1-highcpu-64 | US$2.72058624 / 1 hour |

n1-highcpu-96 | US$4.08087936 / 1 hour |

a2-highgpu-1g* | US$4.408062 / 1 hour |

a2-highgpu-2g* | US$8.816124 / 1 hour |

a2-highgpu-4g* | US$17.632248 / 1 hour |

a2-highgpu-8g* | US$35.264496 / 1 hour |

a2-highgpu-16g* | US$70.528992 / 1 hour |

a3-highgpu-8g* | US$105.39898088 / 1 hour |

a3-megagpu-8g* | US$110.65714224 / 1 hour |

a4-highgpu-8g* | US$148.212 / 1 hour |

e2-standard-4 | US$0.16082748 / 1 hour |

e2-standard-4 | US$0.32165496 / 1 hour |

e2-standard-16 | US$0.64330992 / 1 hour |

e2-standard-32 | US$1.28661984 / 1 hour |

e2-highmem-2 | US$0.10847966 / 1 hour |

e2-highmem-4 | US$0.21695932 / 1 hour |

e2-highmem-8 | US$0.43391864 / 1 hour |

e2-highmem-16 | US$0.86783728 / 1 hour |

e2-highcpu-16 | US$0.4749144 / 1 hour |

e2-highcpu-32 | US$0.9498288 / 1 hour |

n2-standard-4 | US$0.2330832 / 1 hour |

n2-standard-8 | US$0.4661664 / 1 hour |

n2-standard-16 | US$0.9323328 / 1 hour |

n2-standard-32 | US$1.8646656 / 1 hour |

n2-standard-48 | US$2.7969984 / 1 hour |

n2-standard-64 | US$3.7293312 / 1 hour |

n2-standard-80 | US$4.661664 / 1 hour |

n2-highmem-2 | US$0.1572168 / 1 hour |

n2-highmem-4 | US$0.3144336 / 1 hour |

n2-highmem-8 | US$0.6288672 / 1 hour |

n2-highmem-16 | US$1.2577344 / 1 hour |

n2-highmem-32 | US$2.5154688 / 1 hour |

n2-highmem-48 | US$3.7732032 / 1 hour |

n2-highmem-64 | US$5.0309376 / 1 hour |

n2-highmem-80 | US$6.288672 / 1 hour |

n2-highcpu-16 | US$0.6882816 / 1 hour |

n2-highcpu-32 | US$1.3765632 / 1 hour |

n2-highcpu-48 | US$2.0648448 / 1 hour |

n2-highcpu-64 | US$2.7531264 / 1 hour |

n2-highcpu-80 | US$3.441408 / 1 hour |

c2-standard-4 | US$0.2505696 / 1 hour |

c2-standard-8 | US$0.5011392 / 1 hour |

c2-standard-16 | US$1.0022784 / 1 hour |

c2-standard-30 | US$1.879272 / 1 hour |

c2-standard-60 | US$3.758544 / 1 hour |

m1-ultramem-40 | US$7.55172 / 1 hour |

m1-ultramem-80 | US$15.10344 / 1 hour |

m1-ultramem-160 | US$30.20688 / 1 hour |

m1-megamem-96 | US$12.782592 / 1 hour |

cloud-tpu | 가격은 가속기 유형에 따라 책정됩니다. 자세한 내용은 '가속기'를 참조하세요. |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

가속기

가속기

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU 유형 | 가격(USD) |

|---|---|

NVIDIA_TESLA_A100 | US$3.5206896 / 1 hour |

NVIDIA_TESLA_A100_80GB | US$4.517292 / 1 hour |

NVIDIA_H100_80GB | US$11.75586073 / 1 hour |

NVIDIA_TESLA_P4 | US$0.72 / 1 hour |

NVIDIA_TESLA_P100 | US$1.752 / 1 hour |

NVIDIA_TESLA_T4 | US$0.42 / 1 hour |

NVIDIA_TESLA_V100 | US$2.976 / 1 hour |

TPU_V2 Single (8코어) | US$5.40 / 1 hour |

TPU_V2 포드 (코어 32개)* | US$28.80 / 1 hour |

TPU_V3 Single (코어 8개) | US$9.60 / 1 hour |

TPU_V3 포드 (코어 32개)* | US$38.40 / 1 hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

* Cloud TPU 포드를 사용한 학습 가격은 포드의 코어 수에 따라 결정됩니다. 포드의 코어 수는 항상 32의 배수입니다. 코어가 32개가 넘는 포드의 학습 가격을 결정하려면 32코어 포드의 가격에 코어 수를 32로 나눈 값을 곱합니다. 예를 들어 128코어 포드의 경우 가격은 (32코어 포드 가격) * (128/32)입니다. 특정 리전에서 사용할 수 있는 Cloud TPU Pod에 관한 자세한 내용은 Cloud TPU 문서의 시스템 아키텍처를 참조하세요.

디스크

디스크

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

디스크 유형 | 가격(USD) |

|---|---|

pd-standard | US$0.000065753 / 1 gibibyte hour |

pd-ssd | US$0.000279452 / 1 gibibyte hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

- 모든 사용에는 Vertex AI 할당량 정책이 적용됩니다.

- Vertex AI 수명 주기 동안 데이터 및 프로그램 파일을 Google Cloud Storage 버킷에 저장해야 합니다. Cloud Storage 사용에 대해 자세히 알아보세요.

리소스가 작업에 프로비저닝된 순간부터 작업이 완료될 때까지 모델 학습 비용이 청구됩니다.

경고: 학습 작업에는 Vertex AI 할당량 정책이 적용됩니다. 첫 학습 작업에 매우 강력한 처리 클러스터를 선택할 경우 할당량을 초과할 가능성이 높습니다.

예측 및 설명

다음 표에는 노드 시간당 일괄 예측, 온라인 예측 및 온라인 설명 가격이 나와 있습니다. 노드 시간은 가상 머신이 예측 작업을 실행하거나 예측 또는 설명 요청을 처리하기 위한 활성 상태 (하나 이상의 모델이 배포된 엔드포인트)에서 대기하는 데 소비하는 시간을 의미합니다.

Vertex AI Inference에 스팟 VM을 사용할 수 있습니다. 스팟 VM 요금은 Compute Engine 스팟 VM 가격 책정에 따라 청구됩니다. 인프라 사용량 외에도 Vertex AI 추론 관리 수수료가 있으며, 아래 표에 나와 있습니다.

Vertex AI 추론에서 Compute Engine 예약을 사용할 수 있습니다. Compute Engine 예약을 사용하면 해당하는 약정 사용 할인 (CUD)을 포함하여 Compute Engine 가격 책정에 따라 요금이 청구됩니다. 인프라 사용량 외에도 Vertex AI 추론 관리 수수료가 있으며, 아래 표에 나와 있습니다.

E2 시리즈

E2 시리즈

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

e2-standard-2 | US$0.0770564 / 1 hour |

e2-standard-4 | US$0.1541128 / 1 hour |

e2-standard-8 | US$0.3082256 / 1 hour |

e2-standard-16 | US$0.6164512 / 1 hour |

e2-standard-32 | US$1.2329024 / 1 hour |

e2-highmem-2 | US$0.1039476 / 1 hour |

e2-highmem-4 | US$0.2078952 / 1 hour |

e2-highmem-8 | US$0.4157904 / 1 hour |

e2-highmem-16 | US$0.8315808 / 1 hour |

e2-highcpu-2 | US$0.056888 / 1 hour |

e2-highcpu-4 | US$0.113776 / 1 hour |

e2-highcpu-8 | US$0.227552 / 1 hour |

e2-highcpu-16 | US$0.455104 / 1 hour |

e2-highcpu-32 | US$0.910208 / 1 hour |

N1 시리즈

N1 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

n1-standard-2 | US$0.1095 / 1 hour |

n1-standard-4 | US$0.219 / 1 hour |

n1-standard-8 | US$0.438 / 1 hour |

n1-standard-16 | US$0.876 / 1 hour |

n1-standard-32 | US$1.752 / 1 hour |

n1-highmem-2 | US$0.137 / 1 hour |

n1-highmem-4 | US$0.274 / 1 hour |

n1-highmem-8 | US$0.548 / 1 hour |

n1-highmem-16 | US$1.096 / 1 hour |

n1-highcpu-2 | US$0.081 / 1 hour |

n1-highcpu-4 | US$0.162 / 1 hour |

n1-highcpu-8 | US$0.324 / 1 hour |

n1-highcpu-16 | US$0.648 / 1 hour |

n1-highcpu-32 | US$1.296 / 1 hour |

N2 시리즈

N2 시리즈

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

n2-standard-2 | US$0.1116854 / 1 hour |

n2-standard-4 | US$0.2233708 / 1 hour |

n2-standard-8 | US$0.4467416 / 1 hour |

n2-standard-16 | US$0.8934832 / 1 hour |

n2-standard-32 | US$1.7869664 / 1 hour |

n2-highmem-2 | US$0.1506654 / 1 hour |

n2-highmem-4 | US$0.3013308 / 1 hour |

n2-highmem-8 | US$0.6026616 / 1 hour |

n2-highmem-16 | US$1.2053232 / 1 hour |

n2-highcpu-2 | US$0.0824504 / 1 hour |

n2-highcpu-4 | US$0.1649008 / 1 hour |

n2-highcpu-8 | US$0.3298016 / 1 hour |

n2-highcpu-16 | US$0.6596032 / 1 hour |

n2-highcpu-32 | US$1.3192064 / 1 hour |

N2D 시리즈

N2D 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

n2d-standard-2 | US$0.0971658 / 1 hour |

n2d-standard-4 | US$0.1943316 / 1 hour |

n2d-standard-8 | US$0.3886632 / 1 hour |

n2d-standard-16 | US$0.7773264 / 1 hour |

n2d-standard-32 | US$1.5546528 / 1 hour |

n2d-highmem-2 | US$0.131077 / 1 hour |

n2d-highmem-4 | US$0.262154 / 1 hour |

n2d-highmem-8 | US$0.524308 / 1 hour |

n2d-highmem-16 | US$1.048616 / 1 hour |

n2d-highcpu-2 | US$0.0717324 / 1 hour |

n2d-highcpu-4 | US$0.1434648 / 1 hour |

n2d-highcpu-8 | US$0.2869296 / 1 hour |

n2d-highcpu-16 | US$0.5738592 / 1 hour |

n2d-highcpu-32 | US$1.1477184 / 1 hour |

C2 시리즈

C2 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

c2-standard-4 | US$0.240028 / 1 hour |

c2-standard-8 | US$0.480056 / 1 hour |

c2-standard-16 | US$0.960112 / 1 hour |

c2-standard-30 | US$1.80021 / 1 hour |

c2-standard-60 | US$3.60042 / 1 hour |

C2D 시리즈

C2D 시리즈

- Taiwan (asia-east1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

c2d-standard-2 | US$0.1044172 / 1 hour |

c2d-standard-4 | US$0.2088344 / 1 hour |

c2d-standard-8 | US$0.4176688 / 1 hour |

c2d-standard-16 | US$0.8353376 / 1 hour |

c2d-standard-32 | US$1.6706752 / 1 hour |

c2d-standard-56 | US$2.9236816 / 1 hour |

c2d-standard-112 | US$5.8473632 / 1 hour |

c2d-highmem-2 | US$0.1408396 / 1 hour |

c2d-highmem-4 | US$0.2816792 / 1 hour |

c2d-highmem-8 | US$0.5633584 / 1 hour |

c2d-highmem-16 | US$1.1267168 / 1 hour |

c2d-highmem-32 | US$2.2534336 / 1 hour |

c2d-highmem-56 | US$3.9435088 / 1 hour |

c2d-highmem-112 | US$7.8870176 / 1 hour |

c2d-highcpu-2 | US$0.086206 / 1 hour |

c2d-highcpu-4 | US$0.172412 / 1 hour |

c2d-highcpu-8 | US$0.344824 / 1 hour |

c2d-highcpu-16 | US$0.689648 / 1 hour |

c2d-highcpu-32 | US$1.379296 / 1 hour |

c2d-highcpu-56 | US$2.413768 / 1 hour |

c2d-highcpu-112 | US$4.827536 / 1 hour |

C3 시리즈

C3 시리즈

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

머신 유형 | 가격(USD) |

|---|---|

c3-highcpu-4 | US$0.19824 / 1 hour |

c3-highcpu-8 | US$0.39648 / 1 hour |

c3-highcpu-22 | US$1.09032 / 1 hour |

c3-highcpu-44 | US$2.18064 / 1 hour |

c3-highcpu-88 | US$4.36128 / 1 hour |

c3-highcpu-176 | US$8.72256 / 1 hour |

A2 시리즈

A2 시리즈

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Salt Lake City (us-west3)

머신 유형 | 가격(USD) |

|---|---|

a2-highgpu-1g | US$4.2244949 / 1 hour |

a2-highgpu-2g | US$8.4489898 / 1 hour |

a2-highgpu-4g | US$16.8979796 / 1 hour |

a2-highgpu-8g | US$33.7959592 / 1 hour |

a2-megagpu-16g | US$64.1020592 / 1 hour |

a2-ultragpu-1g | US$5.7818474 / 1 hour |

a2-ultragpu-2g | US$11.5636948 / 1 hour |

a2-ultragpu-4g | US$23.1273896 / 1 hour |

a2-ultragpu-8g | US$46.2547792 / 1 hour |

예약 또는 스팟 용량에서 사용하면 'vertex-ai-online-prediction' 라벨이 있는 GCE SKU 및 Vertex AI 관리 요금 SKU 등 두 가지 SKU에 청구가 분산됩니다. 이를 통해 Vertex AI에서 약정 사용 할인 (CUD)을 사용할 수 있습니다.

A3 시리즈

A3 시리즈

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

a3-ultragpu-8g | US$96.015616 / 1 hour |

a3-megagpu-8g | US$106.65474 / 1 hour |

예약 또는 스팟 용량에서 사용하면 'vertex-ai-online-prediction' 라벨이 있는 GCE SKU 및 Vertex AI 관리 요금 SKU 등 두 가지 SKU에 청구가 분산됩니다. 이를 통해 Vertex AI에서 약정 사용 할인 (CUD)을 사용할 수 있습니다.

A4 시리즈

A4 시리즈

- Singapore (asia-southeast1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Los Angeles (us-west2)

머신 유형 | 가격(USD) |

|---|---|

a4-highgpu-8g | US$148.212 / 1 hour |

예약 또는 스팟 용량에서 사용하면 'vertex-ai-online-prediction' 라벨이 있는 GCE SKU 및 Vertex AI 관리 요금 SKU 등 두 가지 SKU에 청구가 분산됩니다. 이를 통해 Vertex AI에서 약정 사용 할인 (CUD)을 사용할 수 있습니다.

A4X 시리즈

A4X 시리즈

- Netherlands (europe-west4)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

머신 유형 | 가격(USD) |

|---|---|

a4x-highgpu-4g | US$74.75 / 1 hour |

예약 또는 스팟 용량에서 사용하면 'vertex-ai-online-prediction' 라벨이 있는 GCE SKU 및 Vertex AI 관리 요금 SKU 등 두 가지 SKU에 청구가 분산됩니다. 이를 통해 Vertex AI에서 약정 사용 할인 (CUD)을 사용할 수 있습니다.

a4x-highgpu-4g에는 VM이 최소 18개 필요합니다.

G2 시리즈

G2 시리즈

- Taiwan (asia-east1)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Dammam (me-central2)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

g2-standard-4 | US$0.81293 / 1 hour |

g2-standard-8 | US$0.98181 / 1 hour |

g2-standard-12 | US$1.15069 / 1 hour |

g2-standard-16 | US$1.31957 / 1 hour |

g2-standard-24 | US$2.30138 / 1 hour |

g2-standard-32 | US$1.99509 / 1 hour |

g2-standard-48 | US$4.60276 / 1 hour |

g2-standard-96 | US$9.20552 / 1 hour |

예약 또는 스팟 용량에서 사용하면 'vertex-ai-online-prediction' 라벨이 있는 GCE SKU 및 Vertex AI 관리 요금 SKU 등 두 가지 SKU에 청구가 분산됩니다. 이를 통해 Vertex AI에서 약정 사용 할인 (CUD)을 사용할 수 있습니다.

G4 시리즈

G4 시리즈

- Taiwan (asia-east1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Alabama (us-east7)

- Oregon (us-west1)

- Salt Lake City (us-west3)

머신 유형 | 가격(USD) |

|---|---|

g4-standard-48 | US$5.1749195 / 1 hour |

g4-standard-96 | US$10.349839 / 1 hour |

g4-standard-192 | US$20.699678 / 1 hour |

g4-standard-384 | US$41.399356 / 1 hour |

TPU v5e 가격 책정

TPU v5e 가격 책정

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Oregon (us-west1)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

ct5lp-hightpu-1t | US$1.38 / 1 hour |

ct5lp-hightpu-4t | US$5.52 / 1 hour |

ct5lp-hightpu-8t | US$5.52 / 1 hour |

TPU v6e 가격 책정

TPU v6e 가격 책정

- Tokyo (asia-northeast1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- London (europe-west2)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

머신 유형 | 가격(USD) |

|---|---|

ct6e-standard-1t | US$3.105 / 1 hour |

ct6e-standard-4t | US$12.42 / 1 hour |

ct6e-standard-8t | US$24.84 / 1 hour |

E2 시리즈

E2 시리즈

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0250826 / 1 hour |

RAM | US$0.0033614 / 1 gibibyte hour |

N1 시리즈

N1 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.036 / 1 hour |

RAM | US$0.005 / 1 gibibyte hour |

N2 시리즈

N2 시리즈

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0363527 / 1 hour |

RAM | US$0.0048725 / 1 gibibyte hour |

N2D 시리즈

N2D 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0316273 / 1 hour |

RAM | US$0.0042389 / 1 gibibyte hour |

C2 시리즈

C2 시리즈

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.039077 / 1 hour |

RAM | US$0.0052325 / 1 gibibyte hour |

C2D 시리즈

C2D 시리즈

- Taiwan (asia-east1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0339974 / 1 hour |

RAM | US$0.0045528 / 1 gibibyte hour |

C3 시리즈

C3 시리즈

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.03908 / 1 hour |

RAM | US$0.00524 / 1 gibibyte hour |

A2 시리즈

A2 시리즈

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Tel Aviv (me-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Salt Lake City (us-west3)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0363527 / 1 hour |

RAM | US$0.0048725 / 1 gibibyte hour |

GPU (A100 40 GB) | US$3.3741 / 1 hour |

GPU (A100 80 GB) | US$4.51729 / 1 hour |

A3 시리즈

A3 시리즈

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.0293227 / 1 hour |

RAM | US$0.0025534 / 1 gibibyte hour |

GPU (H100 80 GB) | US$11.2660332 / 1 hour |

GPU (H200) | US$10.708501 / 1 hour |

G2 시리즈

G2 시리즈

- Taiwan (asia-east1)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Dammam (me-central2)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

항목 | 가격(USD) |

|---|---|

vCPU | US$0.02874 / 1 hour |

RAM | US$0.00337 / 1 gibibyte hour |

GPU (L4) | US$0.64405 / 1 hour |

일부 머신 유형에는 선택 사항으로 예측용 GPU 가속기를 추가할 수 있습니다. 선택 사항으로 GPU를 사용하면 이전 표에 나와 있는 요금 외에 별도의 추가 비용이 발생합니다. 각 유형의 선택적 GPU에 대한 가격 책정을 설명하는 각 가격표를 확인하세요.

가속기 - 시간당 가격

가속기 - 시간당 가격

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU 유형 | 가격(USD) |

|---|---|

NVIDIA_TESLA_P4 | US$0.69 / 1 hour |

NVIDIA_TESLA_P100 | US$1.679 / 1 hour |

NVIDIA_TESLA_T4 | US$0.402 / 1 hour |

NVIDIA_TESLA_V100 | US$2.852 / 1 hour |

가격은 GPU당 책정됩니다. 예측 노드당 여러 GPU를 사용하거나 여러 노드를 사용하도록 버전을 확장하는 경우 그에 따라 비용이 인상됩니다.

AI Platform Prediction은 여러 가상 머신 ('노드')을 실행하여 모델의 예측을 제공합니다. 기본적으로 Vertex AI는 언제든지 실행 중인 노드 수를 자동으로 확장합니다. 온라인 예측의 경우 수요에 맞게 노드 수가 확장됩니다. 각 노드는 여러 예측 요청에 응답할 수 있습니다. 일괄 예측의 경우 작업을 실행하는 데 소요되는 총 시간을 줄이기 위해 노드 수가 확장됩니다. 예측 노드 수가 확장되는 방법을 맞춤설정할 수 있습니다.

다음을 포함해 모델에서 각 노드가 실행되는 시간에 대해 요금이 부과됩니다.

- 노드가 일괄 예측 작업을 처리하는 시간

- 노드가 온라인 예측 요청을 처리하는 시간

- 노드가 온라인 예측을 제공하기 위해 준비 상태로 대기하는 시간

1시간 동안 실행되는 노드 1개의 비용을 노드 시간이라고 합니다. 예측 가격 표에 노드 시간의 가격이 나와 있습니다. 가격은 리전 간에도 다르고 온라인 예측과 일괄 예측 간에도 다릅니다.

노드 시간을 백분위수 단위로 사용할 수 있습니다. 예를 들어 30분 동안 실행되는 노드 1개의 비용은 0.5노드 시간입니다.

Compute Engine(N1) 머신 유형의 비용 계산

- 노드의 실행 시간은 30초 단위로 청구됩니다. 즉, 30초마다 해당 시점에 노드에서 사용 중인 30초 상당의 vCPU, RAM, GPU 리소스 요금이 프로젝트에 청구됩니다.

예측 노드의 자동 확장에 대한 추가 정보

온라인 예측 | 일괄 예측 |

|---|---|

확장의 우선순위는 개별 요청의 지연 시간을 줄이는 데 있습니다. 요청을 처리한 후 몇 분간의 유휴 시간 동안 서비스에서 모델을 준비 상태로 유지합니다. | 확장의 우선순위는 작업의 총 경과 시간을 줄이는 데 있습니다. |

확장은 월별 요금 총액에 영향을 줍니다. 요청의 개수 및 빈도가 높을수록 많은 노드가 사용됩니다. | 새 노드를 가동할 때 약간의 오버헤드가 발생하지만 작업 가격이 확장의 영향을 거의 받지 않아야 합니다. |

트래픽에 따라 서비스가 확장되도록 선택하거나 (자동 확장) 지속적으로 실행할 노드의 수를 지정해 지연을 방지할 수 있습니다 (수동 확장).

| 일괄 예측 작업에서 사용할 최대 노드 수를 설정하고 배포 시 모델에서 계속 실행할 노드 수를 설정해 확장에 영향을 줄 수 있습니다. |

일괄 예측 작업은 작업 완료 후 요금이 청구됨

일괄 예측 작업은 작업 도중 증분 방식이 아닌 작업 완료 후 요금이 청구됩니다. 구성한 Cloud Billing 예산 알림은 작업이 실행되는 동안 트리거되지 않습니다. 대규모 작업을 시작하기 전에 먼저 작은 입력 데이터로 비용 벤치마크 작업을 실행하는 것이 좋습니다.

예측 계산의 예

미주 리전의 부동산 회사가 사업하는 리전의 주택 가격에 대한 주간 예측을 실행합니다. 한 달 동안 각각 3920, 4277, 3849, 3961개의 인스턴스로 이루어진 4주간의 일괄 예측을 실행합니다. 작업은 1개 노드로 제한되었고, 각 인스턴스의 평균 처리 시간은 0.72초입니다.

먼저 각 작업이 실행된 시간을 계산합니다.

- 계산

각 작업이 10분 넘게 실행되었으므로 처리 시간에 분 단위로 요금이 청구됩니다.

- 계산

이 달의 총 요금은 $0.26입니다.

이 예시에서는 작업이 단일 노드에서 실행되고 입력 인스턴스마다 일정한 시간이 걸렸다고 가정했습니다. 실제 사용 시에는 여러 노드를 고려하고 각 노드가 계산을 실행하는 데 소요되는 실제 시간을 사용하세요.

Vertex Explainable AI 요금

Vertex Explainable AI 요금

특성 기반 설명

특성 기반 설명은 예측 가격에 추가 비용이 부과되지 않습니다. 하지만 설명은 일반적인 예측보다 처리 시간이 오래 걸리므로 Vertex Explainable AI를 자동 확장과 함께 과도하게 사용할 경우 많은 노드가 시작되어 예측 요금이 증가할 수 있습니다.

예시 기반 설명

예시 기반 설명의 가격 책정은 다음과 같이 구성됩니다.

- 모델을 업로드하거나 모델의 데이터 세트를 업데이트하면 다음에 대한 요금이 청구됩니다.

- 예시의 잠재 공간 표현을 생성하기 위해 사용되는 일괄 예측 작업의 노드 시간당. 이는 예측과 동일한 요율로 청구됩니다.

- 색인 빌드 또는 업데이트에 드는 비용. 이 비용은 벡터 검색의 색인 생성 비용과 같습니다. 즉, 예시 수 * 차원 수 * 부동 소수점 수당 4바이트 * GB당 $3.00입니다. 예를 들어 1백만 개의 예시와 1,000개의 차원 잠재 공간이 있는 경우 비용은 $12 (1,000,000 * 1,000 * 4 * 3.00 / 1,000,000,000)입니다.

- 엔드포인트에 배포하면 엔드포인트의 각 노드에 대해 노드 시간당 요금이 청구됩니다. 엔드포인트와 연결된 모든 컴퓨팅에는 예측과 동일한 요율로 요금이 청구됩니다. 그러나 예시 기반 설명에는 벡터 검색 색인을 제공하기 위해 추가 컴퓨팅 리소스가 필요하므로 이로 인해 더 많은 노드가 시작되고, 예측 비용이 증가합니다.

Vertex AI 신경망 아키텍처 검색

다음 표에는 신경망 아키텍처 검색을 사용할 수 있는 각 리전의 가격 책정이 요약되어 있습니다.

가격

가격

다음 표에는 다양한 구성의 시간당 가격이 나와 있습니다.

사전 정의된 확장 등급을 선택하거나, 선택한 머신 유형으로 이루어진 커스텀 구성을 선택할 수도 있습니다. 커스텀 구성을 선택하는 경우 현재 사용하는 가상 머신 비용의 합계를 구하세요.

가속기를 지원하는 기존 머신 유형의 가격에는 가속기 비용이 포함되어 있습니다. Compute Engine 머신 유형을 사용하고 가속기를 추가하면 가속기 비용이 별도로 부과됩니다. 이 비용을 계산하려면 다음 가속기 표에 있는 가격에 현재 사용 중인 가속기 유형별 개수를 곱하세요.

머신 유형

머신 유형

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

n1-standard-4 | US$0.2849985 / 1 hour |

n1-standard-8 | US$0.569997 / 1 hour |

n1-standard-16 | US$1.139994 / 1 hour |

n1-standard-32 | US$2.279988 / 1 hour |

n1-standard-64 | US$4.559976 / 1 hour |

n1-standard-96 | US$6.839964 / 1 hour |

n1-highmem-2 | US$0.1774545 / 1 hour |

n1-highmem-4 | US$0.1774545 / 1 hour |

n1-highmem-8 | US$0.709818 / 1 hour |

n1-highmem-16 | US$1.419636 / 1 hour |

n1-highmem-32 | US$2.839272 / 1 hour |

n1-highmem-64 | US$5.678544 / 1 hour |

n1-highmem-96 | US$8.517816 / 1 hour |

n1-highcpu-16 | US$0.8501832 / 1 hour |

n1-highcpu-32 | US$1.7003664 / 1 hour |

n1-highcpu-64 | US$3.4007328 / 1 hour |

n1-highcpu-96 | US$5.1010992 / 1 hour |

a2-highgpu-1g | US$5.641070651 / 1 hour |

a2-highgpu-2g | US$11.282141301 / 1 hour |

a2-highgpu-4g | US$22.564282603 / 1 hour |

a2-highgpu-8g | US$45.128565205 / 1 hour |

a2-highgpu-16g | US$90.257130411 / 1 hour |

e2-standard-4 | US$0.20103426 / 1 hour |

e2-standard-8 | US$0.40206852 / 1 hour |

e2-standard-16 | US$0.80413704 / 1 hour |

e2-standard-32 | US$1.60827408 / 1 hour |

e2-highmem-2 | US$0.13559949 / 1 hour |

e2-highmem-4 | US$0.27119898 / 1 hour |

e2-highmem-8 | US$0.54239796 / 1 hour |

e2-highmem-16 | US$1.08479592 / 1 hour |

e2-highcpu-16 | US$0.59364288 / 1 hour |

e2-highcpu-32 | US$1.18728576 / 1 hour |

n2-standard-4 | US$0.291354 / 1 hour |

n2-standard-8 | US$0.582708 / 1 hour |

n2-standard-16 | US$1.165416 / 1 hour |

n2-standard-32 | US$2.330832 / 1 hour |

n2-standard-48 | US$3.496248 / 1 hour |

n2-standard-64 | US$4.661664 / 1 hour |

n2-standard-80 | US$5.82708 / 1 hour |

n2-highmem-2 | US$0.196521 / 1 hour |

n2-highmem-4 | US$0.393042 / 1 hour |

n2-highmem-8 | US$0.786084 / 1 hour |

n2-highmem-16 | US$1.572168 / 1 hour |

n2-highmem-32 | US$3.144336 / 1 hour |

n2-highmem-48 | US$4.716504 / 1 hour |

n2-highmem-64 | US$6.288672 / 1 hour |

n2-highmem-80 | US$7.86084 / 1 hour |

n2-highcpu-16 | US$0.860352 / 1 hour |

n2-highcpu-32 | US$1.720704 / 1 hour |

n2-highcpu-64 | US$3.441408 / 1 hour |

n2-highcpu-80 | US$4.30176 / 1 hour |

c2-standard-4 | US$0.313212 / 1 hour |

c2-standard-8 | US$0.626424 / 1 hour |

c2-standard-16 | US$1.252848 / 1 hour |

c2-standard-30 | US$2.34909 / 1 hour |

c2-standard-60 | US$4.69818 / 1 hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

a2-highgpu 인스턴스 가격에는 연결된 NVIDIA_TESLA_A100 가속기에 대한 요금이 포함됩니다.

가속기

가속기

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU 유형 | 가격(USD) |

|---|---|

NVIDIA_TESLA_A100 | US$4.400862 / 1 hour |

NVIDIA_TESLA_P4 | US$0.90 / 1 hour |

NVIDIA_TESLA_P100 | US$2.19 / 1 hour |

NVIDIA_TESLA_T4 | US$0.525 / 1 hour |

NVIDIA_TESLA_V100 | US$3.72 / 1 hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

디스크

디스크

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

디스크 유형 | 가격(USD) |

|---|---|

pd-standard | US$0.000082192 / 1 gibibyte hour |

pd-ssd | US$0.000349315 / 1 gibibyte hour |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

참고:

- 모든 사용에 신경망 아키텍처 검색 할당량 정책이 적용됩니다.

- 신경망 아키텍처 검색 수명 주기 동안 데이터 및 프로그램 파일을 Cloud Storage 버킷에 저장해야 합니다. Cloud Storage 사용에 대해 자세히 알아보세요.

- 대량 구매에 따른 할인 혜택은 영업팀에 문의하세요.

- 각 VM의 디스크 크기를 100GB가 넘도록 구성한 경우에만 디스크 가격이 청구됩니다. 각 VM의 디스크 100GB (기본 디스크 크기)에는 요금이 부과되지 않습니다. 예를 들어 각 VM에 105GB의 디스크를 사용하도록 구성할 경우 VM마다 5GB의 디스크 요금이 청구됩니다.

Cloud Storage 필수 사용

Cloud Storage 필수 사용

이 문서에 설명된 비용을 지불하는 것 외에도, 신경망 아키텍처 검색 수명 주기 동안 Cloud Storage 버킷에 데이터 및 프로그램 파일을 저장해야 합니다. 이 같은 저장에는 Cloud Storage 가격 책정 정책이 적용됩니다.

Cloud Storage 필수 사용에 포함되는 내용:

- 학습 애플리케이션 패키지 스테이징

- 학습 입력 데이터 저장

참고: 자체적인 가격 책정이 적용되는 Google BigQuery와 같은 다른 Google Cloud 서비스를 사용하여 입력 데이터를 저장할 수도 있습니다.

- 작업의 출력을 저장합니다. 신경망 아키텍처 검색은 이러한 항목을 장기간 저장할 필요가 없습니다. 작업이 완료되는 즉시 파일을 삭제해도 됩니다.

무료 리소스 관리 작업

무료 리소스 관리 작업

신경망 아키텍처 검색에서 제공하는 리소스 관리 작업은 무료로 사용할 수 있습니다. 신경망 아키텍처 검색 할당량 정책은 이러한 작업 중 일부를 제한합니다.

리소스 | 무료 작업 |

|---|---|

jobs | get, list, cancel |

운영 | get, list, cancel, delete |

Vertex AI Pipelines

Vertex AI Pipelines는 파이프라인 실행당 $0.03의 실행 요금을 부과합니다. 미리보기 출시 중에는 실행 요금이 청구되지 않습니다. 또한 파이프라인 구성요소에서 사용하는 Compute Engine 리소스와 같이 Vertex AI Pipelines에서 사용하는 Google Cloud 리소스에 대한 비용도 청구됩니다 (Vertex AI 학습과 동일한 요율로 요금 청구). 마지막으로, 파이프라인이 호출하는 모든 서비스 (예: Dataflow)의 비용을 지불해야 합니다.

Vertex AI Feature Store

Vertex AI Feature Store는 2023년 11월부터 정식 버전(GA)으로 제공됩니다. 이전 버전 제품에 관한 정보는 Vertex AI Feature Store (기존)를 참조하세요.

새로운 Vertex AI Feature Store

새로운 Vertex AI Feature Store

새로운 Vertex AI Feature Store는 두 가지 작업 유형에 걸쳐 기능을 지원합니다.

- 오프라인 작업은 오프라인 스토어 (BigQuery)에서 데이터를 전송, 저장, 검색 및 변환하는 작업입니다.

- 온라인 작업은 온라인 스토어로 데이터를 전송하는 작업이나 온라인 스토어에 데이터가 저장되어 있는 동안 데이터에 수행하는 작업입니다.

오프라인 작업 가격 책정

BigQuery는 오프라인 작업에 사용되므로 오프라인 스토어로의 수집, 오프라인 스토어 쿼리하기 및 오프라인 스토리지 등의 기능에 대해서는 BigQuery 가격 책정을 참조하세요.

온라인 작업 가격 책정

온라인 작업의 경우 Vertex AI Feature Store는 데이터를 온라인 스토어로 전송하거나 데이터를 제공하거나 저장하는 모든 GA 기능에 대해 요금을 청구합니다. 노드-시간은 가상 머신이 작업을 완료하는 데 소요한 시간을 의미하며, 분 단위로 청구됩니다.

- Johannesburg (africa-south1)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Warsaw (europe-central2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Doha (me-central1)

- Dammam (me-central2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

작업 | 가격(USD) |

|---|---|

데이터 처리 노드 데이터 처리 (예: 온라인 데이터 스토어에 수집) 매장, 모니터링 등) | US$0.08 / 1 hour |

최적화된 온라인 서빙 노드 짧은 지연 시간 서빙 및 임베딩 서빙 각 노드에는 200GB의 스토리지가 포함되어 있습니다. | US$0.30 / 1 hour |

Bigtable 온라인 서빙 노드 Cloud Bigtable을 사용한 서빙 | US$0.94 / 1 hour |

Bigtable 온라인 서빙 스토리지 Cloud Bigtable을 사용한 서빙을 위한 스토리지 | US$0.000342466 / 1 gibibyte hour |

최적화된 온라인 서빙 및 Bigtable 온라인 서빙은 서로 다른 아키텍처를 사용하므로 노드를 비교할 수 없습니다.

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

온라인 작업 워크로드 추정치

워크로드를 추정할 때 다음 가이드라인을 고려하세요. 특정 워크로드에 필요한 노드 수는 각 서빙 접근 방식에 따라 다를 수 있습니다.

- 데이터 처리:

- 수집 - 분석 기능을 사용하지 않는 경우 하나의 노드는 시간당 최소 약 100MiB의 데이터를 Bigtable 온라인 스토어 또는 최적화된 온라인 스토어로 수집할 수 있습니다.

- Bigtable 온라인 서빙: 각 노드는 약 15,000QPS와 최대 5TB의 스토리지를 지원할 수 있습니다.

- 최적화된 온라인 서빙: 성능은 머신 유형과 복제본을 기반으로 하며, 이는 워크로드에 따라 비용을 최소화하도록 자동으로 구성됩니다. 각 노드는 고가용성 및 자동 확장을 위해 최소 2개에서 최대 6개의 복제본을 가질 수 있습니다. 복제본 수에 따라 요금이 청구됩니다. 자세한 내용은 월별 시나리오 예시를 참고하세요.

- 임베딩과 관련이 없는 워크로드의 경우 각 노드는 약 500QPS와 최대 200GB의 스토리지를 지원할 수 있습니다.

- 임베딩 관련 워크로드의 경우 각 노드는 약 500QPS와 최대 4GB의 512차원 데이터 스토리지를 지원할 수 있습니다.

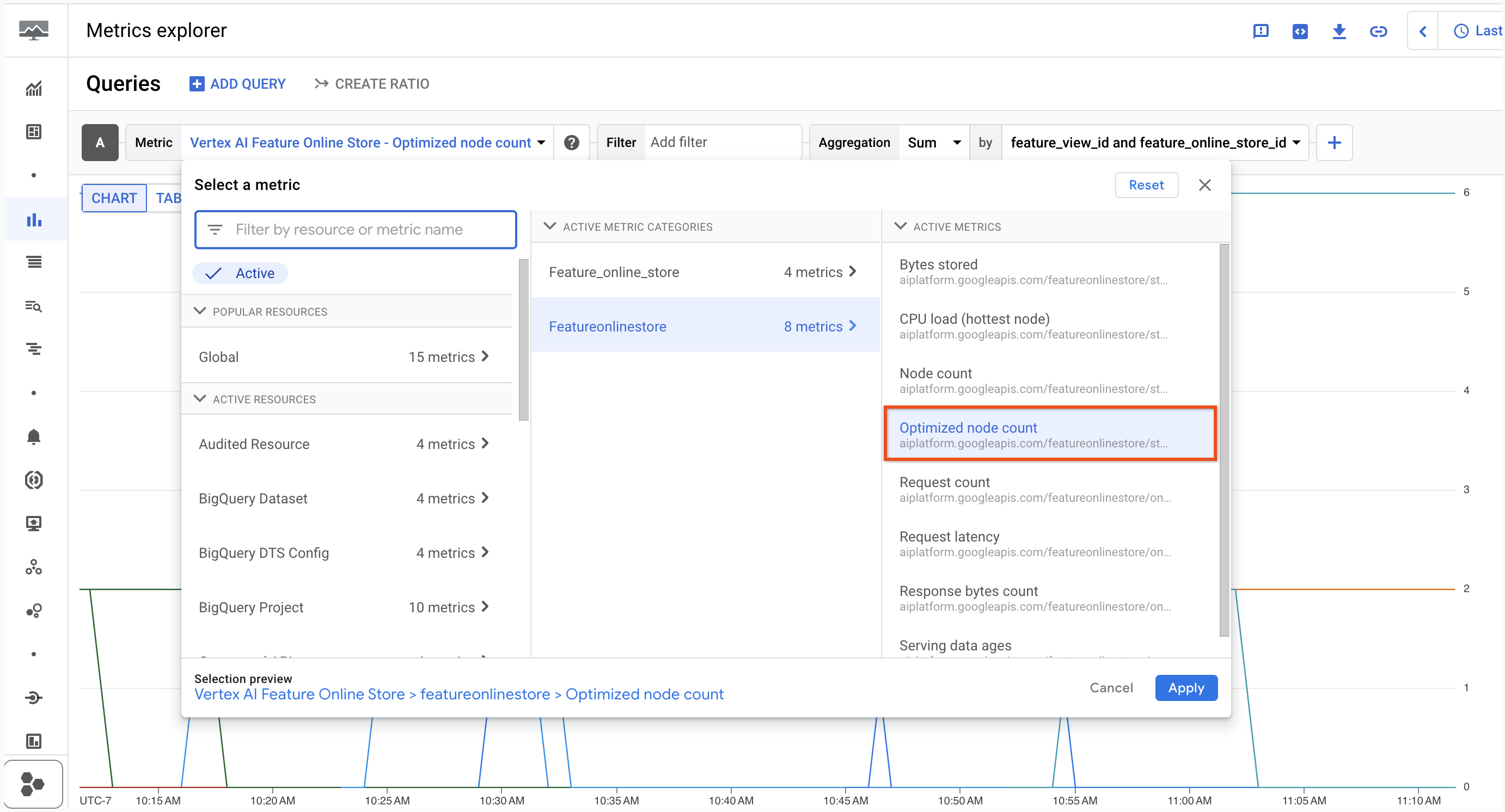

측정항목 탐색기에서 노드 수 (복제본 포함)를 확인할 수 있습니다.

월간 시나리오 예시 (us-central1 가정)

데이터 스트리밍 워크로드 - 2.5TB의 데이터 (매일 1GB가 새로고침됨) 및 1200QPS를 사용하는 Bigtable 온라인 서빙

작업 | 월별 사용량 | 월간 비용 |

|---|---|---|

데이터 처리 노드 | (1GB/일) * (30일/월) * (1,000MB/GB) * (1 노드-시간 / 100MB) = 300 노드-시간 | 300 노드-시간 * (노드-시간당 $0.08) = $24 |

최적화된 온라인 서빙 노드 | 해당사항 없음 | 해당사항 없음 |

Bigtable 온라인 서빙 노드 | (1개 노드) * (24시간/일) * (30일/월) = 720 노드-시간 | 720 노드-시간 * (노드-시간당 $0.94) = $677 |

Bigtable 온라인 서빙 스토리지 | (2.5TB-월) * (1000GB/TB) = 2500GB-월 | 2500GB-월 * (GB-월당 $0.25) = $625 |

합계 | $1,326 |

높은 QPS 워크로드 - 10GB의 비임베딩 데이터 (매일 5GB 새로고침됨) 및 2000QPS로 최적화된 온라인 서빙

작업 | 월별 사용량 | 월간 비용 |

|---|---|---|

데이터 처리 노드 | (5GB/일) * (30일/월) * (1,000MB/GB) * (1 노드-시간 / 100MB) = 1,500 노드-시간 | 1,500노드-시간 * (노드-시간당 $0.08) = $120 |

최적화된 온라인 서빙 노드 | Roundup(10GB * (1 노드 / 200GB)) = 1 * max(2 기본 복제본, 2000 QPS * (1 복제본 / 500 QPS)) = 4 총 노드 * (24시간/일) * (30일/월) =2880 노드-시간 | 2880 노드-시간 * (노드-시간당 0.30) = $864 |

Bigtable 온라인 서빙 노드 | 해당사항 없음 | 해당사항 없음 |

Bigtable 온라인 서빙 스토리지 | 해당사항 없음 | 해당사항 없음 |

합계 | $984 |

임베딩 서빙 워크로드 - 20GB의 임베딩 데이터 (매일 2GB 새로고침) 및 800QPS를 사용하는 최적화된 온라인 서빙

작업 | 월별 사용량 | 월간 비용 |

|---|---|---|

데이터 처리 노드 | (2GB/일) * (30일/월) * (1,000MB/GB) * (1 노드-시간 / 100MB) = 600 노드-시간 | 600 노드-시간 * (노드-시간당 $0.08) = $48 |

최적화된 온라인 서빙 노드 | Roundup(20GB* (1 node / 4GB) = 5 * max(2 default replicas, 800 QPS * (1 replica / 500 QPS)) = 10 total nodes * (24 hr/day) * (30days/month) = 7200 node-hr | 7200 노드-시간 * (노드-시간당 0.30) = $2160 |

Bigtable 온라인 서빙 노드 | 해당사항 없음 | 해당사항 없음 |

Bigtable 온라인 서빙 스토리지 | 해당사항 없음 | 해당사항 없음 |

합계 | $2,208 |

Vertex AI Feature Store(기존)

Vertex AI Feature Store(기존)

Vertex AI Feature Store (기존)의 가격은 온라인 및 오프라인 스토리지의 특성 데이터 양과 온라인 서빙 여부를 기반으로 합니다. 시간당 노드는 가상 머신에서 특성 데이터를 서빙하거나 특성 데이터 요청을 처리하기 위해 준비 상태에서 대기하는 데 사용한 시간을 의미합니다.

작업 | 가격(USD) |

|---|---|

온라인 스토리지 | 월 $0.25/GB |

오프라인 스토리지 | 월 $0.023/GB |

온라인 서빙 | 노드별 시간당 $0.94 |

일괄 내보내기 | 1GB당 $0.005 |

스트리밍 수집 | 수집 1GB당 $0.10 |

USD 외의 통화로 지불하는 경우 Cloud Platform SKU에 해당 통화로 표기된 가격이 적용됩니다.

특성값 모니터링을 활성화하면 청구에는 다음과 같은 요금 외에 위의 요금도 포함됩니다.

- 분석된 모든 데이터에 대해 GB당 $3.50. 스냅샷 분석을 활성화하면 Vertex AI Feature Store(기존)의 데이터에 대해 스냅샷이 생성됩니다. 특성 분석 가져오기를 활성화하면 수집된 데이터 배치가 포함됩니다.

- 특성값 모니터링에 사용되는 다른 Vertex AI Feature Store (기존) 작업에 대한 추가 요금은 다음과 같습니다.

- 스냅샷 분석 기능은 모니터링 간격에 대한 구성을 기반으로 특성값의 스냅샷을 주기적으로 생성합니다.

- 스냅샷 내보내기에 대한 요금은 일반 일괄 내보내기 작업과 동일합니다.

스냅샷 분석 예시

데이터 과학자는 Vertex AI Feature Store(기존)에 대한 특성값 모니터링을 활성화하고 일일 스냅샷 분석에 대한 모니터링을 켭니다. 항목 유형 모니터링을 위해 파이프라인이 매일 실행됩니다. 파이프라인은 Vertex AI Feature Store(기존)에서 2GB의 데이터를 스캔하고 0.1GB의 데이터가 포함된 스냅샷을 내보냅니다. 1일 분석에 대한 총 요금은 다음과 같습니다.

(0.1 GB * $3.50) + (2 GB * $0.005) = $0.36

수집 분석 예시

데이터 과학자는 Vertex AI Feature Store(기존)에 대한 특성값 모니터링을 활성화하고 수집 작업에 대한 모니터링을 켭니다. 수집 작업은 1GB의 데이터를 Vertex AI Feature Store(기존)로 가져옵니다. 특성값 모니터링에 대한 총 요금은 다음과 같습니다.

(1 GB * $3.50) = $3.50

Vertex ML Metadata

메타데이터 스토리지는 바이너리 기가바이트 (GiB) 단위로 측정되며, 1GiB는 1,073,741,824바이트입니다. 이 측정 단위를 기비바이트라고도 부릅니다.

Vertex ML Metadata는 메타데이터 스토리지에 대해 1GiB당 월 $10를 청구합니다. 가격은 메가바이트(MB) 단위로 일할 계산됩니다. 예를 들어 10MB의 메타데이터를 저장하는 경우 해당 10MB의 메타데이터에 대해 매월 $0.10가 청구됩니다.

Vertex ML Metadata가 지원되는 모든 리전에서 가격이 동일합니다.

Vertex AI 텐서보드

Vertex AI TensorBoard를 사용하려면 프로젝트의 IAM 관리자에게 'Vertex AI TensorBoard 웹 앱 사용자' 역할을 할당해 달라고 요청하세요. Vertex AI 관리자 역할에도 액세스 권한이 있습니다.

2023년 8월부터 Vertex AI 텐서보드 가격은 로그 및 측정항목의 데이터 스토리지에 대해 사용자당 월별 라이선스 $300/월에서 $10GiB/월로 변경되었습니다. 즉, 더 이상 구독료가 없으며 사용하는 스토리지에 대해서만 비용을 지불하면 됩니다. 스토리지 관리 방법은 Vertex AI 텐서보드: 오래된 텐서보드 실험 삭제 튜토리얼을 참조하세요.

Vertex AI Vizier

Vertex AI Vizier는 Vertex AI에 포함된 블랙박스 최적화 서비스입니다. Vertex AI Vizier 가격 책정 모델은 다음과 같습니다.

- RANDOM_SEARCH 및 GRID_SEARCH를 사용하는 시도에는 요금이 부과되지 않습니다. 검색 알고리즘에 대해 자세히 알아보세요.

- 월별 첫 Vertex AI Vizier 100회 시도는 무료입니다 (RANDOM_SEARCH 및 GRID_SEARCH를 사용하는 시도는 이 합계에 포함되지 않음).

- Vertex AI Vizier 시도가 100회를 초과하면 같은 달 이후 후속 시도에 $1의 요금이 부과됩니다 (RANDOM_SEARCH 또는 GRID_SEARCH를 사용하는 시도에는 요금이 부과되지 않음).

벡터 검색

벡터 검색 근사 최근접 이웃 서비스의 가격 책정은 다음과 같이 구성됩니다.

- 배포된 색인을 호스팅하는 데 사용되는 각 VM의 노드 시간당 가격

- 새 색인을 빌드하고, 기존 색인을 업데이트하고, 색인 업데이트 스트리밍을 사용하는 데 드는 비용

색인을 빌드하고 업데이트하는 동안 처리된 데이터는 바이너리 GB (기가바이트, 1GiB = 1,073,741,824바이트) 단위로 측정됩니다. 이 측정 단위를 기비바이트라고도 부릅니다.

벡터 검색은 모든 리전에서 처리된 데이터의 기비바이트 (GiB)당 $3.00의 요금을 청구합니다. 벡터 검색은 스트리밍 업데이트 삽입에 대해 수집된 GiB당 $0.45의 요금을 청구합니다.

다음 표에는 벡터 검색을 사용할 수 있는 각 리전의 인덱스 서빙 가격이 요약되어 있습니다. 가격은 머신 유형, 리전에 따라 다르며 노드 시간당 요금이 청구됩니다.

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

e2-standard-2 | US$0.0938084 / 1 hour |

e2-standard-16 | US$0.7504672 / 1 hour |

e2-highmem-16 | US$1.012368 / 1 hour |

n2d-standard-32 | US$1.8926208 / 1 hour |

n1-standard-16 | US$1.0639944 / 1 hour |

n1-standard-32 | US$2.1279888 / 1 hour |

벡터 검색 가격 책정 예시

벡터 검색 가격 책정 예시

벡터 검색 가격은 데이터 크기, 실행하려는 초당 쿼리 수 (QPS)의 수량 및 사용하는 노드 수에 따라 결정됩니다. 예상 서빙 비용을 알아보려면 총 데이터 크기를 계산해야 합니다. 데이터 크기는 임베딩/벡터 수* 차원 수* 차원당 4바이트입니다. 데이터 크기를 계산한 다음에는 서빙 비용과 빌드 비용을 계산할 수 있습니다. 서빙 비용에 빌드 비용을 더하면 월간 총 비용이 됩니다.

- 서빙 비용: 복제본/샤드 개수 * 샤드 개수(~데이터 크기/샤드 크기) * 시간당 비용 * 730시간

- 빌드 비용: 데이터 크기(GiB) * $3/GiB * 월별 업데이트 수

스트리밍 업데이트: 벡터 검색은 휴리스틱 기반 측정항목을 사용하여 압축을 트리거할 시기를 결정합니다. 압축되지 않은 가장 오래된 데이터가 5일 전 데이터인 경우에는 항상 압축이 트리거됩니다. 스트리밍 업데이트 비용 외에도 일괄 업데이트와 동일한 요율로 색인을 재빌드하는 비용이 청구됩니다.

임베딩/벡터 수 | 차원 수 | 초당 쿼리 수(QPS) | 머신 유형 | 노드 | 예상 월별 서빙 비용 (USD) |

|---|---|---|---|---|---|

200만 | 128 | 100 | e2-standard-2 | 1 | $68 |

2,000만 개 | 256 | 1,000 | e2-standard-16 | 1 | $547 |

2,000만 개 | 256 | 3,000 | e2-standard-16 | 3 | $1,642 |

1억 개 | 256 | 500 | e2-highmem-16 | 2 | $1,477 |

10억 | 100 | 500 | e2-highmem-16 | 8 | $5,910 |

모든 예시는 us-central1의 머신 유형을 기반으로 합니다. 발생하는 비용은 재현율 및 지연 시간 요구사항에 따라 달라집니다. 예상 월별 서빙 비용은 콘솔에서 사용되는 노드 수와 직접적인 관련이 있습니다. 비용에 영향을 미치는 구성 파라미터에 대해 자세히 알아보려면 재현율 및 지연 시간에 영향을 미치는 구성 파라미터를 참조하세요.

초당 쿼리 수 (QPS)가 높은 경우 이러한 쿼리를 일괄 처리하면 총비용을 최대 30~40%까지 줄일 수 있습니다.

스토리지 최적화 벡터 검색 등급

스토리지 최적화 벡터 검색 등급

개별 VM과 별도의 압축 작업을 관리하고 비용을 지불하는 대신 다음 두 가지 SKU가 있습니다.

- 용량 단위 (CU): 서빙의 기본 측정기입니다. CU는 컴퓨팅과 활성 SSD 스토리지를 묶은 단위로, 각각 최대 1TiB까지 제공되며 CU당, 시간당, 복제본당 $2.30의 가격이 책정됩니다. 이 단일 요금에는 서빙 비용과 지속적인 색인 관리가 포함됩니다. 인덱스 크기가 커짐에 따라 서비스가 자동 확장되고 추가 CU가 추가됩니다.

- 쓰기 단위: 데이터를 추가하려면 GiB당 $0.45의 요금이 부과됩니다. 요금은 일괄 및 스트리밍 색인 업데이트 모두에 적용됩니다.

단위 | 가격 |

|---|---|

스토리지 최적화 용량 단위 | US$2.30 / 1 hour |

쓰기 단위 | US$0.45 / 1 gibibyte |

Vertex AI Model Registry

Vertex AI Model Registry는 모델과 모델 버전을 추적하고 나열하는 중앙 저장소입니다. 모델을 Vertex AI로 가져올 수 있으며 이러한 모델은 Vertex AI Model Registry에 표시됩니다. Model Registry에 모델을 저장하는 데에는 비용이 들지 않습니다. 비용은 모델을 엔드포인트에 배포하거나 모델에서 일괄 예측을 수행하는 경우에만 발생합니다. 이 비용은 배포하는 모델 유형에 따라 다릅니다.

Vertex AI Model Registry에서 커스텀 모델을 배포하는 가격에 대해 자세히 알아보려면 커스텀 학습 모델을 참조하세요. AutoML 모델 배포 가격 책정에 대해 자세히 알아보려면 AutoML 모델 가격 책정을 참조하세요.

Vertex AI Model Monitoring

Vertex AI를 사용하면 모델을 프로덕션에 배포한 후에도 모델의 지속적인 효과를 모니터링할 수 있습니다. 자세한 내용은 Vertex AI 모델 모니터링 소개를 참조하세요.

Vertex AI 모델 모니터링을 사용하면 다음에 대해 비용이 청구됩니다.

- 제공된 모든 학습 데이터 및 BigQuery 테이블에 로깅된 예측 데이터를 포함하여 분석된 모든 데이터에 대해 GB당 $3.50

- 속성 모니터링이 사용 설정된 경우 BigQuery 스토리지 또는 Batch Explain과 같이 모델 모니터링과 함께 사용하는 다른 Google Cloud 제품에 대한 요금

Vertex AI Model Monitoring은 us-central1, europe-west4, asia-east1, asia-southeast1 리전에서 지원됩니다. 모든 리전의 가격이 동일합니다.

데이터 크기는 TfRecord 형식으로 변환된 후 측정됩니다.

Vertex AI 모델 모니터링 작업을 설정할 때 학습 데이터 세트에는 일회성 요금이 발생합니다.

예측 데이터 세트는 온라인 예측 서비스에서 수집된 로그로 구성됩니다. 예측 요청이 다른 기간에 도달하면 각 기간에 대한 데이터가 수집되고 각 예측 기간에 대해 분석된 데이터의 합계가 요금을 계산하는 데 사용됩니다.

예: 데이터 과학자가 모델에 속하는 예측 트래픽에서 모델 모니터링을 실행합니다.

- 모델은 BigQuery 데이터 세트에서 학습됩니다. TfRecord로 변환한 후의 데이터 크기는 1.5GB입니다.

- 오후 1시~오후 2시에 로깅되는 예측 데이터는 0.1GB이고 오후 3시~오후 4시는 0.2GB입니다.

- 모델 모니터링 작업 설정의 총 가격은 다음과 같습니다.

- (1.5 GB * $3.50) + ((0.1 GB + 0.2 GB) * $3.50) = $6.30

Vertex AI Workbench

가격 책정 정보를 확인하려면 인스턴스, 관리형 노트북 또는 사용자 관리형 노트북을 선택하세요.

인스턴스

인스턴스

아래 표에는 다양한 VM 구성의 대략적인 시간당 가격이 나와 있습니다. 선택한 머신 유형의 커스텀 구성을 선택할 수 있습니다. 가격을 계산하려면 사용하는 가상 머신 비용의 합계를 구하세요.

Compute Engine 머신 유형을 사용하고 가속기를 추가하면 가속기 비용이 별도로 부과됩니다. 이 비용을 계산하려면 아래의 가속기 표에 있는 가격에 현재 사용 중인 각 가속기 유형의 실행 시간을 곱하세요.

CPU

CPU

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

머신 유형 | vCPU당 가격 (USD) |

|---|---|

N1 | US$0.0379332 / 1 hour |

N2 | US$0.0379332 / 1 hour |

E2 | US$0.026173908 / 1 hour |

A2 | US$0.0379332 / 1 hour |

메모리

메모리

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Las Vegas (us-west4)

머신 유형 | 가격(USD) |

|---|---|

N1 | US$0.0050844 / 1 gibibyte hour |

N2 | US$0.0050844 / 1 gibibyte hour |

E2 | US$0.003508236 / 1 gibibyte hour |

A2 | US$0.0050844 / 1 gibibyte hour |

가속기

가속기

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)