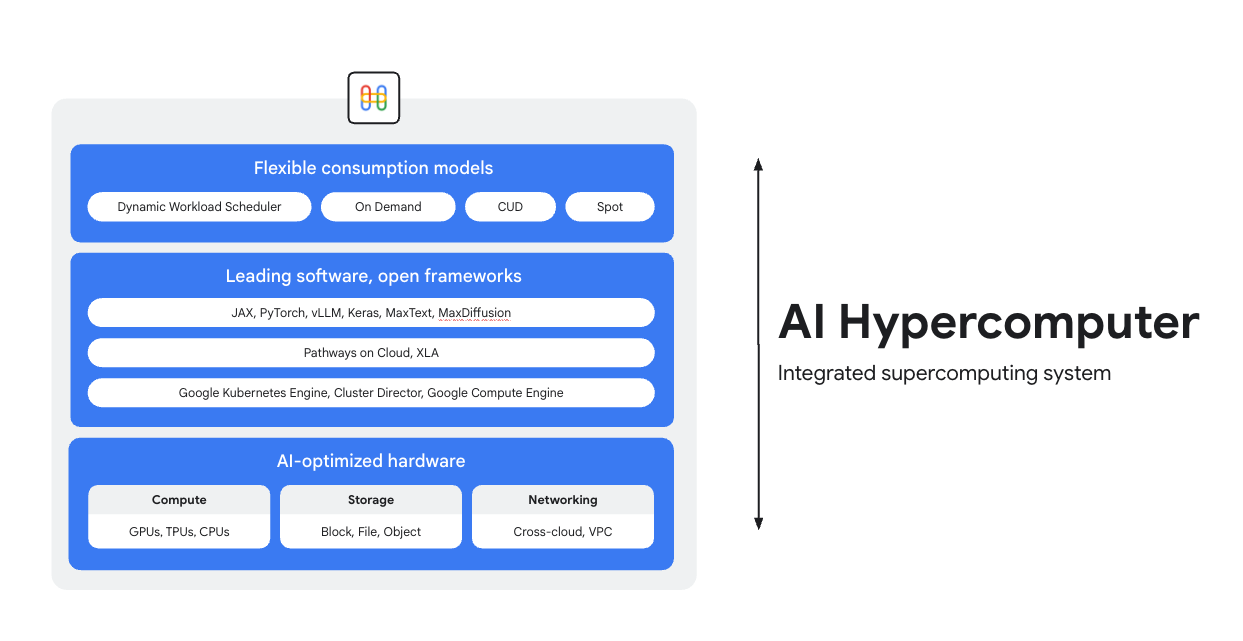

運用 AI Hypercomputer 訓練、調整及提供模型

AI Hypercomputer 是支撐 Google Cloud 上所有 AI 工作負載的整合式超級運算系統,由軟硬體和使用模式組成,可簡化 AI 部署作業、提升系統層級效率,並提高成本效益。

總覽

AI 技術最佳化硬體

先進軟體、開放框架

我們提供領先業界的軟體,並整合開放框架、程式庫和編譯器,讓您的硬體進一步發揮效能,以更高效率開發、整合及管理 AI。

- 支援 PyTorch、JAX、Keras、vLLM、Megatron-LM、NeMo Megatron、MaxText 和 MaxDiffusion 等等。

- 與 XLA 編譯器深度整合,可提高不同加速器之間的互通性;使用 Pathways on Cloud 則只需要單一分散式執行階段,即可支援 Google 內部的大規模訓練和推論基礎架構。

- 無論所選環境是 Google Kubernetes Engine、Cluster Director 或 Google Compute Engine,都可部署這些軟體。

彈性使用模式

我們提供彈性付費方案,客戶可依業務需求,選擇固定費用、承諾使用折扣或動態隨選模式。客戶還可透過 Dynamic Workload Scheduler和 Spot VM 取用所需容量,避免分配過多資源。此外,客戶可使用 Google Cloud 的成本最佳化工具來自動調度資源。這樣不僅能提高資源使用率,也能減少工程師的手動作業。

常見用途

大規模提供模型,同時兼顧成本效益

以最符合成本效益的方式,將推論工作負載可靠性提升到最高

推論技術正快速發展,變得更多元繁複。這項技術主要有三個發展方向:

- 首先,我們與 AI 的互動方式正在改變。對話變得更長,且 AI 能從中瞭解更複雜的脈絡。

- 其次,隨著精細的多步驟推論技術推出,混合專家 (MoE) 模型逐漸普及。這項技術正在重塑記憶體和運算規模,從初始輸入到最終輸出的擴充方式。

- 最後,我們清楚瞭解,模型的真正價值並非每一分錢支援的原始詞元數量,而是回覆的實用性。模型是否具備正確的專業知識?是否正確回答重要業務問題?因此,我們認為客戶需要更妥善的評估,將重點放在總體系統運作成本,而非處理器價格。

瀏覽 AI 推論資源

- 參閱我們的全方位指南「什麼是 AI 推論?」,瞭解 AI 推論的類型、功能比較和用途

- 參加「GKE 推論快速入門導覽課程」,瞭解如何執行推論最佳做法

- 參加「在 Cloud Run 中進行 AI 推論」課程

- 觀看這部影片,瞭解如何以符合成本效益的方式進行 AI 推論

- 瞭解如何加速 AI 推論工作負載

AI 讓體育迷化身球衣設計師

PUMA 與 Google Cloud 合作,採用整合式 AI 基礎架構 (AI Hypercomputer),搭配 Gemini 和 Dynamic Workload Scheduler,根據使用者提示詞,動態調整 GPU 推論規模,大幅降低成本和生成時間。

影響:

- 他們將 AI 球衣生成時間從 2 到 5 分鐘縮短至 30 秒。這讓平台轉變為快速、真正的互動式體驗,吸引使用者持續參與。

- 短短 10 天內,粉絲就創作了 180,000 件球衣,並給出了 170 萬個評分。

- 這項專案為 PUMA 開創與社群互動的新方式,成功將粉絲變成積極的共同創作者,讓公司直接即時掌握最熱情顧客的創作需求,超越單純的品牌與消費者關係。

操作說明

以最符合成本效益的方式,將推論工作負載可靠性提升到最高

推論技術正快速發展,變得更多元繁複。這項技術主要有三個發展方向:

- 首先,我們與 AI 的互動方式正在改變。對話變得更長,且 AI 能從中瞭解更複雜的脈絡。

- 其次,隨著精細的多步驟推論技術推出,混合專家 (MoE) 模型逐漸普及。這項技術正在重塑記憶體和運算規模,從初始輸入到最終輸出的擴充方式。

- 最後,我們清楚瞭解,模型的真正價值並非每一分錢支援的原始詞元數量,而是回覆的實用性。模型是否具備正確的專業知識?是否正確回答重要業務問題?因此,我們認為客戶需要更妥善的評估,將重點放在總體系統運作成本,而非處理器價格。

其他資源

瀏覽 AI 推論資源

- 參閱我們的全方位指南「什麼是 AI 推論?」,瞭解 AI 推論的類型、功能比較和用途

- 參加「GKE 推論快速入門導覽課程」,瞭解如何執行推論最佳做法

- 參加「在 Cloud Run 中進行 AI 推論」課程

- 觀看這部影片,瞭解如何以符合成本效益的方式進行 AI 推論

- 瞭解如何加速 AI 推論工作負載

客戶實例

AI 讓體育迷化身球衣設計師

PUMA 與 Google Cloud 合作,採用整合式 AI 基礎架構 (AI Hypercomputer),搭配 Gemini 和 Dynamic Workload Scheduler,根據使用者提示詞,動態調整 GPU 推論規模,大幅降低成本和生成時間。

影響:

- 他們將 AI 球衣生成時間從 2 到 5 分鐘縮短至 30 秒。這讓平台轉變為快速、真正的互動式體驗,吸引使用者持續參與。

- 短短 10 天內,粉絲就創作了 180,000 件球衣,並給出了 170 萬個評分。

- 這項專案為 PUMA 開創與社群互動的新方式,成功將粉絲變成積極的共同創作者,讓公司直接即時掌握最熱情顧客的創作需求,超越單純的品牌與消費者關係。

執行大規模 AI 訓練和預先訓練

強大、可擴充且高效的 AI 訓練

訓練工作負載必須以高度同步的工作形式,在緊耦合叢集中的數千個節點上執行。只要一個節點的效能降低,就可能中斷整個工作,進而拖慢推出速度。因此必須:

- 確保可快速設定叢集,並根據工作負載進行調整

- 預測故障並立即加以排解

- 即使確實故障,工作負載也能持續運作

我們希望客戶能以相當簡便的方式,在 Google Cloud 部署訓練工作負載並調度相關資源。

強大、可擴充且高效的 AI 訓練

歡迎參閱下列任一教學課程,掌握建立 AI 叢集的入門要領:

- 使用 GPU (A4 VM) 和 Cluster Toolkit 建立 Slurm 叢集

- 使用 GKE Cluster Director 或 Cluster Toolkit 建立 GKE 叢集

Moloco 打造廣告放送平台,每天處理數十億個請求

Moloco 採用 AI Hypercomputer 完全整合的堆疊,在 TPU 和 GPU 等進階硬體上自動擴充,讓 Moloco 工程師能專注於其他工作。此外,並與 Google 業界領先的資料平台整合,為 AI 工作負載打造出端對端的一致系統。

Moloco 推出首批深度學習模型後,業績和獲利呈現曲棍球桿型成長,在 2 年半內成長 5 倍,達到目標。

- 在 GKE 中使用 Cloud TPU,模型訓練速度提升 10 倍,訓練成本降低 4 倍

- 這項服務經過調整可供超過 1,000 名內部使用者存取,讓他們能運用全球規模的機器學習系統,從自家資料中找出獲利成長的機會

操作說明

其他資源

強大、可擴充且高效的 AI 訓練

歡迎參閱下列任一教學課程,掌握建立 AI 叢集的入門要領:

- 使用 GPU (A4 VM) 和 Cluster Toolkit 建立 Slurm 叢集

- 使用 GKE Cluster Director 或 Cluster Toolkit 建立 GKE 叢集

客戶實例

Moloco 打造廣告放送平台,每天處理數十億個請求

Moloco 採用 AI Hypercomputer 完全整合的堆疊,在 TPU 和 GPU 等進階硬體上自動擴充,讓 Moloco 工程師能專注於其他工作。此外,並與 Google 業界領先的資料平台整合,為 AI 工作負載打造出端對端的一致系統。

Moloco 推出首批深度學習模型後,業績和獲利呈現曲棍球桿型成長,在 2 年半內成長 5 倍,達到目標。

- 在 GKE 中使用 Cloud TPU,模型訓練速度提升 10 倍,訓練成本降低 4 倍

- 這項服務經過調整可供超過 1,000 名內部使用者存取,讓他們能運用全球規模的機器學習系統,從自家資料中找出獲利成長的機會

部署及自動調度管理 AI 應用程式

運用頂尖的 AI 自動化調度管理軟體和開放框架,提供 AI 輔助功能

Google Cloud 提供內含常見作業系統、框架、程式庫和驅動程式的映像檔。AI Hypercomputer 會將這些預先設定的映像檔最佳化,來支援 AI 工作負載。

- AI 和機器學習框架、程式庫:使用深度學習軟體層 (DLSL) Docker 映像檔,在 Google Kubernetes Engine (GKE) 叢集執行 NeMO 和 MaxText 等機器學習模型

- 叢集部署和 AI 自動化調度管理:您可以在 GKE 叢集、Slurm 叢集或 Compute Engine 執行個體上,部署 AI 工作負載。詳情請參閱「VM 和叢集建立總覽」

探索軟體資源

- Pathways on Cloud 是一套系統,可用於建立稀疏啟動的大規模多工機器學習系統

- Goodput 做法有助於提升機器學習效率

- Topology Aware Scheduling 可用於安排 GKE 工作負載時程

- 試試我們的基準化做法,在 GPU 上執行 DeepSeek、Mixtral、Llama 和 GPT 模型

- 選擇使用選項,更有效率地取得及使用運算資源

Priceline:協助旅客收集獨特體驗

與 Google Cloud 合作導入生成式 AI 後,我們用聊天機器人就能提供個人化旅遊規劃服務。我們的目標不只是為顧客安排行程,更是協助他們打造獨一無二的旅遊體驗。」Martin Brodbeck,Priceline 技術長

操作說明

運用頂尖的 AI 自動化調度管理軟體和開放框架,提供 AI 輔助功能

Google Cloud 提供內含常見作業系統、框架、程式庫和驅動程式的映像檔。AI Hypercomputer 會將這些預先設定的映像檔最佳化,來支援 AI 工作負載。

- AI 和機器學習框架、程式庫:使用深度學習軟體層 (DLSL) Docker 映像檔,在 Google Kubernetes Engine (GKE) 叢集執行 NeMO 和 MaxText 等機器學習模型

- 叢集部署和 AI 自動化調度管理:您可以在 GKE 叢集、Slurm 叢集或 Compute Engine 執行個體上,部署 AI 工作負載。詳情請參閱「VM 和叢集建立總覽」

其他資源

探索軟體資源

- Pathways on Cloud 是一套系統,可用於建立稀疏啟動的大規模多工機器學習系統

- Goodput 做法有助於提升機器學習效率

- Topology Aware Scheduling 可用於安排 GKE 工作負載時程

- 試試我們的基準化做法,在 GPU 上執行 DeepSeek、Mixtral、Llama 和 GPT 模型

- 選擇使用選項,更有效率地取得及使用運算資源

客戶實例

Priceline:協助旅客收集獨特體驗

與 Google Cloud 合作導入生成式 AI 後,我們用聊天機器人就能提供個人化旅遊規劃服務。我們的目標不只是為顧客安排行程,更是協助他們打造獨一無二的旅遊體驗。」Martin Brodbeck,Priceline 技術長

常見問題

AI Hypercomputer 與使用個別雲端服務有何不同?

每種雲端服務的功能不同,相較之下,AI Hypercomputer 屬於整合式系統,軟硬體和使用模式都經過精心設計,能以最佳方式搭配運作,從系統層級有效提升效能、成本效益和上市速度,這點是無法透過拼湊不同服務來達成。這種整合式系統不僅能簡化作業,還提供全方位的 AI 基礎架構做法。

是否可以在混合雲或多雲端環境中使用 AI Hypercomputer?

是,AI Hypercomputer 將彈性融入設計考量。您可以透過 Cross-Cloud Interconnect 等技術建立高頻寬連線,連至地端部署資料中心和其他雲端,落實混合雲和多雲端 AI 策略。我們採用開放標準,並整合熱門的第三方軟體,讓您能建構支援多個環境的解決方案,以及依需求調整服務。

AI Hypercomputer 如何確保 AI 工作負載的安全性?

安全性是 AI Hypercomputer 的核心面向。這個架構採用 Google Cloud 的多層式安全防護模型。具體功能包括 Titan 安全微控制器 (確保系統以可信任的狀態啟動)、RDMA 防火牆 (訓練時可於 TPU/GPU 之間建立零信任網路),且與 Model Armor 等 AI 安全性解決方案整合。此外,我們還制定完善的基礎架構安全防護政策和原則做為輔助,例如安全 AI 架構。

如果想使用 AI Hypercomputer 做為基礎架構,最簡單的方式為何?

- 如果您不想管理 VM,我們建議從 Google Kubernetes Engine (GKE) 開始

- 如果您需要多個排程器,或無法使用 GKE,我們建議使用 Cluster Director

- 如果您想全面控管基礎架構,唯一的方法是直接使用 VM;要採取這個方法,最合適的平台就是 Compute Engine

AI Hypercomputer 是否只適用於大型/高可擴充性工作負載?

否。AI Hypercomputer 可用於任何規模的工作負載。即使是小型工作負載,也能充分利用這個整合式系統的所有優勢,例如提升效率及簡化部署作業。此外,AI Hypercomputer 還能支援客戶擴展業務,無論是小型概念驗證和實驗,或大規模正式環境部署作業,都不成問題。

如果想開始在 Google Cloud 執行 AI 工作負載,使用 AI Hypercomputer 是最簡單的方式嗎?

對大多數客戶來說,使用代管 AI 平台是最簡單的 AI 入門方式。以 Vertex AI 為例,這個平台不僅內建所有工具、範本和模型,還採用 AI Hypercomputer,可代為進行最佳化調整。Vertex AI 容易上手,讓您輕鬆開始使用 AI。如果您想自行設定及調整每個基礎架構元件,可以使用 AI Hypercomputer 元件做為基礎架構,並根據需求組合。

由於 AI Hypercomputer 是可組合的系統,用途相當廣泛,是否有適合各用途的最佳做法可供參考?

是,我們正在 GitHub 規劃一系列做法。您也可以使用 Cluster Toolkit,取得預先建構的叢集藍圖。

如果要使用 AI Hypercomputer 做為 IaaS,有哪些可用選項?

AI 技術最佳化硬體

儲存空間

- 訓練:Managed Lustre 具備高處理量和 PB 規模容量,非常適合執行要求嚴苛的 AI 訓練。GCS Fuse (可選擇搭配 Anywhere Cache) 適合容量需求大,且延遲時間目標寬鬆的環境。兩者皆可與 GKE 和 Cluster Director 整合。

- 推論:如果想要簡易的解決方案,可使用 GCS Fuse 搭配 Anywhere Cache。如果想要更高效能,則建議使用 Hyperdisk ML。此外,您還可在單一可用區將 Managed Lustre 同時用於訓練和推論。

網路

- 訓練:虛擬私有雲的 RDMA 網路等技術,以及高頻寬的 Cloud Interconnect 和 Cross-Cloud Interconnect,都有助於迅速移轉資料。

- 推論:GKE Inference Gateway 和進階版 Cloud Load Balancing 等解決方案,能以低延遲提供服務。Model Armor 則可整合至 AI 系統,以確保安全。

運算:Google Cloud TPU (Trillium)、NVIDIA GPU (Blackwell),以及 Google 開發的 CPU (Axion),可根據特定工作的處理量、延遲時間或總持有成本要求,進行最佳化。

先進軟體和開放框架

- 機器學習框架和程式庫:PyTorch、JAX、TensorFlow、Keras、vLLM、JetStream、MaxText、LangChain、Hugging Face、NVIDIA (CUDA、NeMo、Triton),以及其他開放原始碼和第三方選項。

- 編譯器、執行階段和工具:XLA (可提升效能和互通性)、Pathways on Cloud、Multislice Training、Cluster Toolkit (適用於預先建構的叢集藍圖),以及其他開放原始碼和第三方選項。

- 自動化調度管理:Google Kubernetes Engine (GKE)、Cluster Director (適用於 Slurm、非代管 Kubernetes、自備排程器) 和 Google Compute Engine (GCE)。

使用模式:

- 依需求:即付即用。

- 承諾使用折扣 (CUD):簽訂長期承諾使用合約可大幅節省費用 (最多 70%)。

- Spot VM:適合容錯批次工作,提供大幅折扣 (最多 91%)。

- Dynamic Workload Scheduler (DWS):最多可省下 50% 的批次/容錯工作費用。