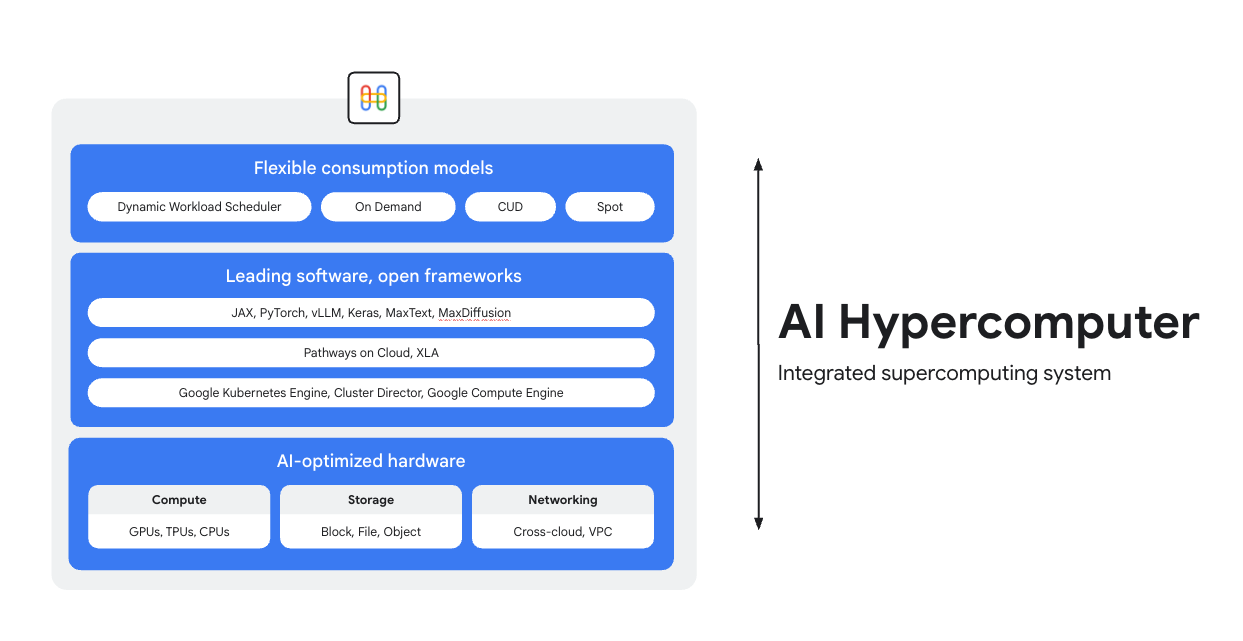

Entraînez, réglez et mettez en service des modèles sur un superordinateur d'IA

AI Hypercomputer est le système de calcul intensif intégré qui sous-tend chaque charge de travail d'IA sur Google Cloud. Il se compose de modèles de matériel, de logiciels et de consommation conçus pour simplifier le déploiement de l'IA, améliorer l'efficacité au niveau du système et optimiser les coûts.

Présentation

Matériel optimisé par l'IA

Faites votre choix parmi des options de calcul (y compris des accélérateurs d'IA), de stockage et de gestion de réseaux optimisées pour remplir des objectifs précis au niveau des charges de travail, qu'il s'agisse d'augmenter le débit, de réduire la latence, d'accélérer le délai d'obtention des résultats ou de diminuer le coût total de possession. En savoir plus sur les Cloud TPU, les Cloud GPU, ainsi que sur les dernières nouveautés en matière de stockage et de gestion de réseaux

Logiciels de pointe, frameworks ouverts

Exploitez tout le potentiel de votre matériel grâce à des logiciels de pointe intégrés à des frameworks, des bibliothèques et des compilateurs ouverts pour rendre le développement, l'intégration et la gestion de l'IA plus efficaces.

- Compatible avec PyTorch, JAX, Keras, vLLM, Megatron-LM, NeMo Megatron, MaxText, MaxDiffusion et bien d'autres.

- L'intégration étroite avec le compilateur XLA permet l'interopérabilité entre différents accélérateurs, tandis que Pathways on Cloud vous permet d'utiliser le même environnement d'exécution distribué que celui qui alimente l'infrastructure interne d'entraînement et d'inférence à grande échelle de Google.

- Vous pouvez déployer tout cela dans l'environnement de votre choix, qu'il s'agisse de Google Kubernetes Engine, de Cluster Director ou de Google Compute Engine.

Modèles de consommation flexibles

Les options de consommation flexibles permettent aux clients de choisir des coûts fixes avec des remises sur engagement d'utilisation ou des modèles dynamiques à la demande pour répondre aux besoins de leur entreprise.Le programmeur de charge de travail dynamique et les VM Spot peuvent vous aider à obtenir la capacité dont vous avez besoin, sans surallouer les ressources.De plus, les outils d'optimisation des coûts de Google Cloud permettent d'automatiser l'utilisation des ressources afin de réduire les tâches manuelles des ingénieurs.

Fonctionnement

Dans cette présentation issue de l'AI Infra Summit 2025, un responsable de Google Cloud explique les prochaines étapes pour les fondations de l'IA et explique comment utiliser AI Hypercomputer pour l'inférence. Il décrit également les dernières bonnes pratiques technologiques que vous pouvez appliquer dès aujourd'hui.

Dans cette présentation issue de l'AI Infra Summit 2025, un responsable de Google Cloud explique les prochaines étapes pour les fondations de l'IA et explique comment utiliser AI Hypercomputer pour l'inférence. Il décrit également les dernières bonnes pratiques technologiques que vous pouvez appliquer dès aujourd'hui.

Utilisations courantes

Mettre en service des modèles à grande échelle de façon économique

Maximisez le rapport prix/performances et la fiabilité pour les charges de travail d'inférence

L'inférence devient rapidement plus diversifiée et complexe, et évolue dans trois domaines principaux :

- Tout d'abord, notre façon d'interagir avec l'IA change. Les conversations intègrent désormais un contexte beaucoup plus long et diversifié.

- Deuxièmement, les modèles MoE (Mixture-of-Experts) sont de plus en plus courants en raison de leur capacité à effectuer des inférences sophistiquées en plusieurs étapes. Cela redéfinit la façon dont la mémoire et le calcul évoluent, de l'entrée initiale jusqu'à la sortie finale.

- Enfin, il est clair que la valeur réelle ne se limite pas au nombre brut de jetons par dollar, mais qu'elle dépend aussi de la pertinence de la réponse. Le modèle possède-t-il l'expertise requise ? A-t-il répondu correctement à une question commerciale cruciale ? C'est pourquoi nous pensons que les clients ont besoin de meilleures mesures, axées sur le coût total des opérations système, et non sur le prix de leurs processeurs.

Explorer les ressources sur l'inférence dans l'IA

- Qu'est-ce que l'inférence de l'IA ? Notre guide complet sur les types, les comparaisons et les cas d'utilisation.

- Exécutez des recettes d'inférence selon les bonnes pratiques avec le guide de démarrage rapide de l'inférence GKE.

- Suivez un cours sur l'inférence de l'IA sur Cloud Run.

- Regardez cette vidéo sur le secret d'une inférence de l'IA économique

- Découvrez comment accélérer les charges de travail des inférences de l'IA

L'IA permet aux fans de sport de créer des maillots

La marque PUMA s'est associée à Google Cloud pour son infrastructure d'IA intégrée (AI Hypercomputer), ce qui lui a permis d'utiliser Gemini pour les requêtes des utilisateurs, ainsi que le programmeur de charge de travail dynamique pour mettre à l'échelle l'inférence sur les GPU de manière dynamique, réduisant ainsi considérablement les coûts et le temps de génération.

Impact :

- Ils ont réduit le temps de génération des maillots en IA, passant de 2 à 5 minutes à seulement 30 secondes. La plate-forme s'est ainsi transformée en une expérience rapide et véritablement interactive qui a su maintenir l'engagement des utilisateurs.

- En seulement 10 jours, les fans ont créé 180 000 maillots et attribué 1,7 million de notes.

- Ce projet a permis à PUMA de créer du lien avec sa communauté d'une manière inédite. Cela a dépassé la simple relation entre une marque et ses consommateurs en transformant ses fans en cocréateurs actifs. L'entreprise a ainsi pu obtenir des informations directes et en temps réel sur les désirs créatifs de ses clients les plus passionnés.

Guides pratiques

Maximisez le rapport prix/performances et la fiabilité pour les charges de travail d'inférence

L'inférence devient rapidement plus diversifiée et complexe, et évolue dans trois domaines principaux :

- Tout d'abord, notre façon d'interagir avec l'IA change. Les conversations intègrent désormais un contexte beaucoup plus long et diversifié.

- Deuxièmement, les modèles MoE (Mixture-of-Experts) sont de plus en plus courants en raison de leur capacité à effectuer des inférences sophistiquées en plusieurs étapes. Cela redéfinit la façon dont la mémoire et le calcul évoluent, de l'entrée initiale jusqu'à la sortie finale.

- Enfin, il est clair que la valeur réelle ne se limite pas au nombre brut de jetons par dollar, mais qu'elle dépend aussi de la pertinence de la réponse. Le modèle possède-t-il l'expertise requise ? A-t-il répondu correctement à une question commerciale cruciale ? C'est pourquoi nous pensons que les clients ont besoin de meilleures mesures, axées sur le coût total des opérations système, et non sur le prix de leurs processeurs.

Autres ressources

Explorer les ressources sur l'inférence dans l'IA

- Qu'est-ce que l'inférence de l'IA ? Notre guide complet sur les types, les comparaisons et les cas d'utilisation.

- Exécutez des recettes d'inférence selon les bonnes pratiques avec le guide de démarrage rapide de l'inférence GKE.

- Suivez un cours sur l'inférence de l'IA sur Cloud Run.

- Regardez cette vidéo sur le secret d'une inférence de l'IA économique

- Découvrez comment accélérer les charges de travail des inférences de l'IA

Témoignages de clients

L'IA permet aux fans de sport de créer des maillots

La marque PUMA s'est associée à Google Cloud pour son infrastructure d'IA intégrée (AI Hypercomputer), ce qui lui a permis d'utiliser Gemini pour les requêtes des utilisateurs, ainsi que le programmeur de charge de travail dynamique pour mettre à l'échelle l'inférence sur les GPU de manière dynamique, réduisant ainsi considérablement les coûts et le temps de génération.

Impact :

- Ils ont réduit le temps de génération des maillots en IA, passant de 2 à 5 minutes à seulement 30 secondes. La plate-forme s'est ainsi transformée en une expérience rapide et véritablement interactive qui a su maintenir l'engagement des utilisateurs.

- En seulement 10 jours, les fans ont créé 180 000 maillots et attribué 1,7 million de notes.

- Ce projet a permis à PUMA de créer du lien avec sa communauté d'une manière inédite. Cela a dépassé la simple relation entre une marque et ses consommateurs en transformant ses fans en cocréateurs actifs. L'entreprise a ainsi pu obtenir des informations directes et en temps réel sur les désirs créatifs de ses clients les plus passionnés.

Exécutez des entraînements et des pré-entraînements d'IA à grande échelle

Entraînement d'IA performant, évolutif et efficace

Les charges de travail d'entraînement doivent s'exécuter en tant que jobs hautement synchronisés sur des milliers de nœuds dans des clusters fortement couplés. Un seul nœud dégradé peut perturber l'ensemble d'un job, ce qui retarde le délai de mise sur le marché. Vos tâches sont les suivantes :

- S'assurer que le cluster est configuré rapidement et adapté à la charge de travail en question

- Prédire les défaillances et les résoudre rapidement

- Poursuivre l'exécution d'une charge de travail, même en cas de défaillance

Nous voulons que les clients puissent déployer et effectuer le scaling des charges de travail d'entraînement sur Google Cloud de façon extrêmement simple.

Entraînement d'IA performant, évolutif et efficace

Pour créer un cluster d'IA, commencez par consulter l'un de nos tutoriels :

- Créer un cluster Slurm avec des GPU (VM A4) et Cluster Toolkit

- Créer un cluster GKE avec Cluster Director pour GKE ou Cluster Toolkit

Moloco a créé une plate-forme de diffusion publicitaire pour traiter des milliards de demandes par jour

Moloco s'est appuyé sur la pile entièrement intégrée d'AI Hypercomputer pour effectuer un scaling automatique sur du matériel avancé comme les TPU et les GPU. Les ingénieurs de Moloco ont ainsi pu se consacrer à d'autres tâches. L'intégration à la plate-forme de données de pointe de Google a permis de créer un système cohérent de bout en bout pour les charges de travail d'IA.

Après avoir lancé ses premiers modèles de deep learning, Moloco a connu une croissance et une rentabilité exponentielles, multipliant par cinq son chiffre d'affaires en deux ans et demi.

- Entraînement de modèles 10 fois plus rapide avec les Cloud TPU sur GKE, et coûts d'entraînement divisés par quatre

- Mise à l'échelle effectuée pour atteindre plus de 1 000 utilisateurs internes, en leur donnant accès à un système de machine learning à l'échelle de la planète qui les aide à identifier des sources de croissance rentables à partir de leurs propres données

AssemblyAI

AssemblyAI utilise Google Cloud pour entraîner des modèles rapidement et à grande échelle

LG AI Research a considérablement réduit ses coûts et accéléré son développement, tout en respectant des exigences strictes en termes de sécurité et de résidence des données

Anthropic a annoncé son intention d'accéder à un million de TPU pour entraîner et mettre en service les modèles Claude, ce qui représente des dizaines de milliards de dollars. Mais comment l'entreprise exploite-t-elle Google Cloud ? Regardez cette vidéo pour découvrir comment Anthropic repousse les limites de calcul de l'IA à grande échelle avec GKE.

Guides pratiques

Entraînement d'IA performant, évolutif et efficace

Les charges de travail d'entraînement doivent s'exécuter en tant que jobs hautement synchronisés sur des milliers de nœuds dans des clusters fortement couplés. Un seul nœud dégradé peut perturber l'ensemble d'un job, ce qui retarde le délai de mise sur le marché. Vos tâches sont les suivantes :

- S'assurer que le cluster est configuré rapidement et adapté à la charge de travail en question

- Prédire les défaillances et les résoudre rapidement

- Poursuivre l'exécution d'une charge de travail, même en cas de défaillance

Nous voulons que les clients puissent déployer et effectuer le scaling des charges de travail d'entraînement sur Google Cloud de façon extrêmement simple.

Autres ressources

Entraînement d'IA performant, évolutif et efficace

Pour créer un cluster d'IA, commencez par consulter l'un de nos tutoriels :

- Créer un cluster Slurm avec des GPU (VM A4) et Cluster Toolkit

- Créer un cluster GKE avec Cluster Director pour GKE ou Cluster Toolkit

Témoignages de clients

Moloco a créé une plate-forme de diffusion publicitaire pour traiter des milliards de demandes par jour

Moloco s'est appuyé sur la pile entièrement intégrée d'AI Hypercomputer pour effectuer un scaling automatique sur du matériel avancé comme les TPU et les GPU. Les ingénieurs de Moloco ont ainsi pu se consacrer à d'autres tâches. L'intégration à la plate-forme de données de pointe de Google a permis de créer un système cohérent de bout en bout pour les charges de travail d'IA.

Après avoir lancé ses premiers modèles de deep learning, Moloco a connu une croissance et une rentabilité exponentielles, multipliant par cinq son chiffre d'affaires en deux ans et demi.

- Entraînement de modèles 10 fois plus rapide avec les Cloud TPU sur GKE, et coûts d'entraînement divisés par quatre

- Mise à l'échelle effectuée pour atteindre plus de 1 000 utilisateurs internes, en leur donnant accès à un système de machine learning à l'échelle de la planète qui les aide à identifier des sources de croissance rentables à partir de leurs propres données

AssemblyAI

AssemblyAI utilise Google Cloud pour entraîner des modèles rapidement et à grande échelle

LG AI Research a considérablement réduit ses coûts et accéléré son développement, tout en respectant des exigences strictes en termes de sécurité et de résidence des données

Anthropic a annoncé son intention d'accéder à un million de TPU pour entraîner et mettre en service les modèles Claude, ce qui représente des dizaines de milliards de dollars. Mais comment l'entreprise exploite-t-elle Google Cloud ? Regardez cette vidéo pour découvrir comment Anthropic repousse les limites de calcul de l'IA à grande échelle avec GKE.

Déployer et orchestrer des applications d'IA

Exploitez des logiciels d'orchestration d'IA de pointe et des frameworks ouverts pour proposer des expériences basées sur l'IA

Google Cloud fournit des images contenant des systèmes d'exploitation, des frameworks, des bibliothèques et des pilotes courants. AI Hypercomputer optimise ces images préconfigurées pour prendre en charge vos charges de travail d'IA.

- Frameworks et bibliothèques d'IA et de ML : utilisez les images Docker Deep Learning Software Layer (DLSL) pour exécuter des modèles de ML comme NeMO et MaxText sur un cluster Google Kubernetes Engine (GKE).

- Déploiement de clusters et orchestration d'IA : vous pouvez déployer vos charges de travail d'IA sur des clusters GKE, des clusters Slurm ou des instances Compute Engine. Pour en savoir plus, consultez la présentation de la création de VM et de clusters.

Explorer les ressources logicielles

- Pathways on Cloud est un système conçu pour permettre la création de systèmes de machine learning à grande échelle, multitâches et à activation partielle.

- Optimisez votre productivité en ML avec nos recettes Goodput.

- Planifiez des charges de travail GKE avec la planification sensible à la topologie.

- Essayez l'une de nos recettes de benchmarking pour exécuter les modèles DeepSeek, Mixtral, Llama et GPT sur des GPU.

- Choisissez une option de consommation pour obtenir et utiliser les ressources de calcul plus efficacement.

Priceline : aider les voyageurs à choisir des expériences uniques

"En intégrant l'IA générative à notre chatbot en collaboration avec Google Cloud, nous avons pu créer un assistant de voyage sur mesure. Nous voulons révolutionner l'organisation de voyages afin de faire vivre des vacances uniques à nos clients." Martin Brodbeck, directeur de la technologie, Priceline

Guides pratiques

Exploitez des logiciels d'orchestration d'IA de pointe et des frameworks ouverts pour proposer des expériences basées sur l'IA

Google Cloud fournit des images contenant des systèmes d'exploitation, des frameworks, des bibliothèques et des pilotes courants. AI Hypercomputer optimise ces images préconfigurées pour prendre en charge vos charges de travail d'IA.

- Frameworks et bibliothèques d'IA et de ML : utilisez les images Docker Deep Learning Software Layer (DLSL) pour exécuter des modèles de ML comme NeMO et MaxText sur un cluster Google Kubernetes Engine (GKE).

- Déploiement de clusters et orchestration d'IA : vous pouvez déployer vos charges de travail d'IA sur des clusters GKE, des clusters Slurm ou des instances Compute Engine. Pour en savoir plus, consultez la présentation de la création de VM et de clusters.

Autres ressources

Explorer les ressources logicielles

- Pathways on Cloud est un système conçu pour permettre la création de systèmes de machine learning à grande échelle, multitâches et à activation partielle.

- Optimisez votre productivité en ML avec nos recettes Goodput.

- Planifiez des charges de travail GKE avec la planification sensible à la topologie.

- Essayez l'une de nos recettes de benchmarking pour exécuter les modèles DeepSeek, Mixtral, Llama et GPT sur des GPU.

- Choisissez une option de consommation pour obtenir et utiliser les ressources de calcul plus efficacement.

Témoignages de clients

Priceline : aider les voyageurs à choisir des expériences uniques

"En intégrant l'IA générative à notre chatbot en collaboration avec Google Cloud, nous avons pu créer un assistant de voyage sur mesure. Nous voulons révolutionner l'organisation de voyages afin de faire vivre des vacances uniques à nos clients." Martin Brodbeck, directeur de la technologie, Priceline

Modèles Open Source sur Google Cloud

Questions fréquentes

En quoi l'architecture AI Hypercomputer se distingue-t-elle de l'utilisation de services cloud individuels ?

Alors que chaque service offre des capacités spécifiques, AI Hypercomputer fournit un système intégré où le matériel, les logiciels et les modèles de consommation sont conçus pour fonctionner de manière optimale ensemble. Cette intégration offre des gains d'efficacité au niveau du système en termes de performances, de coût et de délai de mise sur le marché, qui sont plus difficiles à atteindre en associant des services disparates. Il réduit la complexité et offre une approche globale de l'infrastructure d'IA.

Peut-on utiliser AI Hypercomputer dans un environnement hybride ou multicloud ?

Oui, AI Hypercomputer est conçu pour être flexible. Des technologies comme Cross-Cloud Interconnect offrent une connectivité à bande passante élevée aux centres de données sur site et à d'autres environnements cloud, ce qui facilite les stratégies d'IA hybrides et multicloud. Nous nous appuyons sur des normes ouvertes et intégrons des logiciels tiers populaires pour vous permettre de créer des solutions qui couvrent plusieurs environnements et de modifier les services selon vos besoins.

Comment l'architecture AI Hypercomputer gère-t-elle la sécurité des charges de travail d'IA ?

La sécurité est un aspect essentiel d'AI Hypercomputer. Il bénéficie du modèle de sécurité multicouche de Google Cloud. Les fonctionnalités spécifiques incluent les microcontrôleurs de sécurité Titan (qui garantissent que les systèmes démarrent à partir d'un état de confiance), le pare-feu RDMA (pour la mise en réseau zéro confiance entre les TPU/GPU pendant l'entraînement) et l'intégration à des solutions comme Model Armor pour la sécurité de l'IA. Ces mesures sont complétées par des règles et des principes de sécurité robustes pour l'infrastructure, comme le framework d'IA sécurisé.

Quelle est la façon la plus simple d'utiliser AI Hypercomputer en tant qu'infrastructure ?

- Si vous ne souhaitez pas gérer de VM, nous vous recommandons de commencer par Google Kubernetes Engine (GKE).

- Si vous devez utiliser plusieurs planificateurs ou si vous ne pouvez pas utiliser GKE, nous vous recommandons d'utiliser Cluster Director.

- Si vous souhaitez avoir un contrôle complet sur votre infrastructure, la seule façon d'y parvenir est de travailler directement avec des VM. Dans ce cas, Compute Engine est la meilleure option.

Est-ce que ce service est utile uniquement pour les charges de travail à grande échelle ?

Non. AI Hypercomputer peut être utilisé pour des charges de travail de toutes tailles. Les charges de travail plus petites bénéficient également de tous les avantages d'un système intégré, comme l'efficacité et la simplification du déploiement. AI Hypercomputer accompagne également les clients à mesure que leur entreprise se développe, depuis des petites démonstrations de faisabilité et expérimentations jusqu'aux déploiements en production à grande échelle.

AI Hypercomputer est-il le moyen le plus simple de commencer à utiliser les charges de travail d'IA sur Google Cloud ?

Pour la plupart des clients, une plate-forme d'IA gérée comme Vertex AI est le moyen le plus simple de se lancer dans l'IA, car elle intègre tous les outils, modèles et modèles prédéfinis nécessaires. De plus, Vertex AI s'appuie sur AI Hypercomputer en arrière-plan de manière optimisée pour vous. Vertex AI est le moyen le plus simple de vous lancer grâce à son expérience simplifiée. Si vous préférez configurer et optimiser chaque composant de votre infrastructure, vous pouvez accéder aux composants d'AI Hypercomputer en tant qu'infrastructure et les assembler selon vos besoins.

Comme AI Hypercomputer est un système composable, il existe de nombreuses options. Avez-vous des bonnes pratiques pour chaque cas d'utilisation ?

Oui, nous créons une bibliothèque de recettes dans GitHub. Vous pouvez également utiliser Cluster Toolkit pour accéder à des plans de cluster prédéfinis.

Quelles sont les options disponibles lorsque j'utilise AI Hypercomputer en tant qu'IaaS ?

Matériel optimisé par l'IA

Stockage

- Entraînement : Managed Lustre est idéal pour les entraînements exigeants de l'IA, offrant un haut débit et une capacité à l'échelle du pétaoctet. GCS Fuse (associé facultativement à Anywhere Cache) convient aux besoins de plus grande capacité avec une latence moins stricte. Les deux s'intègrent à GKE et à Cluster Director.

- Inférence : GCS Fuse associé à Anywhere Cache offre une solution simple. Pour de meilleures performances, envisagez d'utiliser Hyperdisk ML. Si vous utilisez Managed Lustre pour l'entraînement dans la même zone, vous pouvez également l'utiliser pour l'inférence.

Mise en réseau

- Entraînement : bénéficiez de technologies comme la mise en réseau RDMA dans les VPC, et de Cloud et Cross-Cloud Interconnect à bande passante élevée pour un transfert de données rapide.

- Inférence : utilisez des solutions comme la passerelle d'inférence GKE et Cloud Load Balancing amélioré pour un traitement à faible latence. Model Armor peut être intégré pour renforcer la sécurité de l'IA.

Calcul : accédez aux TPU Google Cloud (Trillium), aux GPU NVIDIA (Blackwell) et aux CPU (Axion). Cela permet d'optimiser le débit, la latence ou le coût total de possession en fonction des besoins spécifiques des charges de travail.

Principaux logiciels et frameworks Open Source

- Frameworks et bibliothèques de ML : PyTorch, JAX, TensorFlow, Keras, vLLM, JetStream, MaxText, LangChain, Hugging Face, NVIDIA (CUDA, NeMo, Triton) et de nombreuses autres options Open Source et tierces.

- Compilateurs, environnements d'exécution et outils : XLA (pour les performances et l'interopérabilité), Pathways on Cloud, l'entraînement à plusieurs tranches, Cluster Toolkit (pour les plans de clusters prédéfinis) et de nombreuses autres options Open Source et tierces.

- Orchestration : Google Kubernetes Engine (GKE), Cluster Director (pour Slurm, Kubernetes non géré, planificateurs BYO) et Google Compute Engine (GCE).

Modèles de consommation :

- À la demande : paiement à l'usage.

- Remises sur engagement d'utilisation : économisez jusqu'à 70 % en vous engageant sur le long terme.

- VM Spot : idéales pour les jobs par lot tolérants aux pannes, elles offrent des remises importantes (jusqu'à 91 %).

- Programmeur de charge de travail dynamique : économisez jusqu'à 50 % pour les jobs par lot/tolérants aux pannes.