Cloud GPUs

Leistungsfähige GPUs in Google Cloud für maschinelles Lernen, wissenschaftliches Rechnen und generative KI

Beschleunigung von Computing-Arbeitslasten wie generativer KI, 3D-Visualisierung und Hochleistungs-Computing mit modernster KI-Hardware und ‑Software

Eine breite Auswahl von GPUs für unterschiedliche Leistungs- und Preisanforderungen

Flexible Preise und Maschinenanpassungen zur Optimierung je nach Arbeitslast

Wichtige Features

Wichtige Features

Verschiedene GPU-Typen

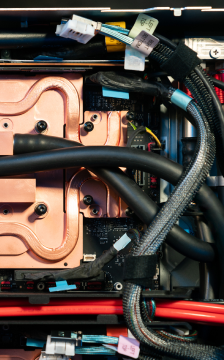

Als Teil der Compute Engine bieten die NVIDIA-GPUs RTX PRO 6000, GB300, GB200, B200, H200, H100, L4, P100, P4, T4, V100 und A100 eine Reihe von Rechenoptionen, um Ihre Arbeitslasten je nach Leistungsanforderungen kostenoptimiert abzudecken.

Flexible Leistung

Stimmen Sie den Prozessor, den Arbeitsspeicher, das Hochleistungslaufwerk und bis zu acht GPUs pro Instanz optimal auf die jeweilige Arbeitslast ab. Dank sekundengenauer Abrechnung zahlen Sie nur für das, was Sie tatsächlich nutzen.

Alle Vorteile von Google Cloud

Nutzen Sie für Ihre GPU-Arbeitslasten Google Cloud und profitieren Sie von branchenführenden Technologien für Speicher, Netzwerk und Datenanalyse.

Das ist neu

Das ist neu

Melden Sie sich für die Google Cloud-Newsletter an – so erhalten Sie regelmäßig Produktupdates, Veranstaltungsinformationen, Sonderangebote und mehr.

Dokumentation

Dokumentation

Preise

Preise

Informationen zu den Preisen für die verschiedenen GPU-Typen und Regionen in der Compute Engine finden Sie in der Preisübersicht für GPUs.

Gleich loslegen

Profitieren Sie von einem Guthaben über 300 $, um Google Cloud und mehr als 20 „Immer kostenlos“ Produkte kennenzulernen.

Benötigen Sie Hilfe beim Einstieg?

Vertrieb kontaktierenMit einem zertifizierten Partner arbeiten

Partner findenMehr ansehen

Alle Produkte ansehen