Pipeline mit dem Job-Builder ausführen

In dieser Kurzanleitung erfahren Sie, wie Sie einen Dataflow-Job mit dem Dataflow-Job-Builder ausführen. Der Job-Builder ist eine visuelle Benutzeroberfläche zum Erstellen und Ausführen von Dataflow-Pipelines in der Google Cloud Console, ohne Code schreiben zu müssen.

In dieser Kurzanleitung laden Sie eine Beispielpipeline in den Job-Builder, führen einen Job aus und prüfen, ob der Job eine Ausgabe erstellt hat.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataflow, Compute Engine, Cloud Logging, Cloud Storage, Google Cloud Storage JSON, and Resource Manager APIs.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataflow, Compute Engine, Cloud Logging, Cloud Storage, Google Cloud Storage JSON, and Resource Manager APIs.

- Erstellen Sie einen Cloud Storage-Bucket:

- In the Google Cloud console, go to the Cloud Storage Buckets page.

- Click Create bucket.

- On the Create a bucket page, enter your bucket information. To go to the next

step, click Continue.

- For Name your bucket, enter a unique bucket name. Don't include sensitive information in the bucket name, because the bucket namespace is global and publicly visible.

-

For Choose where to store your data, do the following:

- Select a Location type option.

- Select a Location option.

- For Choose a default storage class for your data, select the following: Standard.

- For Choose how to control access to objects, select an Access control option.

- For Advanced settings (optional), specify an encryption method, a retention policy, or bucket labels.

- Click Create.

Damit Sie die Schritte in dieser Kurzanleitung ausführen können, muss Ihr Nutzerkonto die Rollen Dataflow-Administrator und Dienstkontonutzer haben. Das Compute Engine-Standarddienstkonto muss die Rolle "Dataflow-Worker" haben. So fügen Sie die erforderlichen Rollen in der Google Cloud Console hinzu:

- Rufen Sie die IAM-Seite auf.

Zu IAM - Wählen Sie Ihr Projekt aus.

- Klicken Sie in der Zeile mit Ihrem Nutzerkonto auf Hauptkonto bearbeiten.

- Klicken Sie auf Weitere Rolle hinzufügen und wählen Sie in der Drop-down-Liste Dataflow-Administrator aus.

- Klicken Sie auf Weitere Rolle hinzufügen und wählen Sie in der Drop-down-Liste Dienstkontonutzer aus.

- Klicken Sie auf Speichern.

- Klicken Sie in der Zeile mit dem Compute Engine-Standarddienstkonto auf Hauptkonto bearbeiten.

- Klicken Sie auf Weitere Rolle hinzufügen und wählen Sie in der Drop-down-Liste Dataflow-Worker aus.

- Klicken Sie auf Weitere Rolle hinzufügen und wählen Sie in der Drop-down-Liste die Option Storage-Objekt-Administrator aus.

Klicken Sie auf Speichern.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter IAM-Rolle über die Konsole zuweisen.

- Rufen Sie die IAM-Seite auf.

- Jedes neue Projekt beginnt standardmäßig mit einem Standardnetzwerk.

Wenn das Standardnetzwerk für Ihr Projekt deaktiviert oder gelöscht wurde, benötigen Sie in Ihrem Projekt ein Netzwerk, für das Ihr Nutzerkonto die Rolle Compute-Netzwerknutzer hat (

roles/compute.networkUser).

Beispielpipeline laden

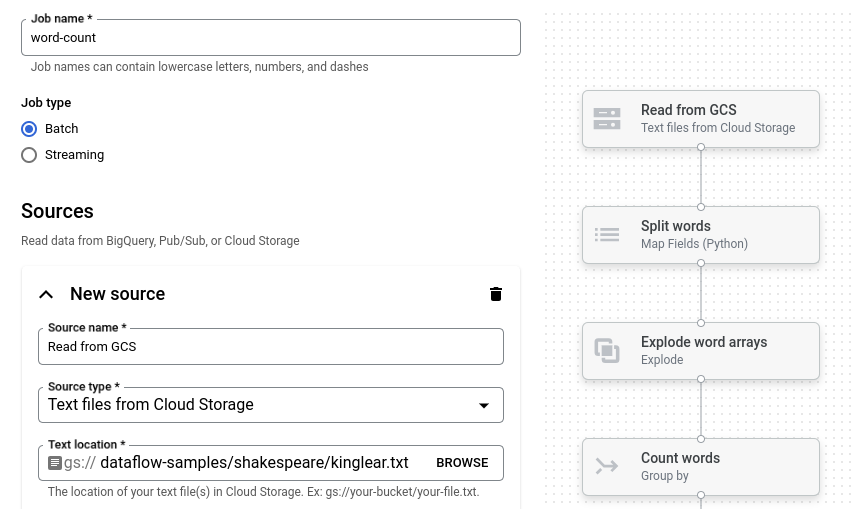

In diesem Schritt laden Sie eine Beispielpipeline, die die Wörter in King Lear von Shakespeare zählt.

Rufen Sie die Seite Jobs in der Google Cloud Console auf.

Klicken Sie auf Job aus Vorlage erstellen.

Klicken Sie auf Job-Builder.

Klicken Sie auf Laden.

Klicken Sie auf Wortzählung. Der Job-Builder wird mit einer grafischen Darstellung der Pipeline ausgefüllt.

Für jeden Pipelineschritt wird im Job-Builder eine Karte mit den Konfigurationsparametern für diesen Schritt angezeigt. Im ersten Schritt werden beispielsweise Textdateien aus Cloud Storage gelesen. Der Speicherort der Quelldaten ist im Feld Textspeicherort bereits ausgefüllt.

Ausgabeort festlegen

In diesem Schritt geben Sie einen Cloud Storage-Bucket an, in den die Pipeline die Ausgabe schreibt.

Suchen Sie die Karte Neue Senke. Möglicherweise müssen Sie scrollen.

Klicken Sie im Feld Textspeicherort auf Durchsuchen.

Wählen Sie den Namen des Cloud Storage-Buckets aus, den Sie unter Hinweise erstellt haben.

Klicken Sie auf Untergeordnete Ressourcen ansehen.

Geben Sie im Feld „Dateiname“

wordsein.Klicken Sie auf Auswählen.

Job ausführen

Klicken Sie auf Job ausführen. Der Job-Builder erstellt einen Dataflow-Job und wechselt dann zum Job-Diagramm. Wenn der Job gestartet wird, zeigt die Jobgrafik eine grafische Darstellung der Pipeline an, die der im Job-Builder angezeigten ähnelt. Bei jedem Schritt der Pipeline wird der Status in der Jobgrafik aktualisiert.

Im Bereich Jobinfo wird der Gesamtstatus des Jobs angezeigt. Wenn der Job erfolgreich abgeschlossen wurde, wird das Feld Jobstatus auf Succeeded aktualisiert.

Jobausgabe überprüfen

Führen Sie nach Abschluss des Jobs die folgenden Schritte aus, um die Ausgabe der Pipeline aufzurufen:

Wechseln Sie in der Google Cloud Console zur Cloud Storage-Seite Buckets.

Klicken Sie in der Bucket-Liste auf den Namen des Buckets, den Sie unter Vorbereitung erstellt haben.

Klicken Sie auf die Datei mit dem Namen

words-00000-of-00001.Klicken Sie auf der Seite Objektdetails auf die authentifizierte URL, um die Pipelineausgabe aufzurufen.

Die Ausgabe sollte in etwa so aussehen:

brother: 20

deeper: 1

wrinkles: 1

'alack: 1

territory: 1

dismiss'd: 1

[....]

Bereinigen

Mit den folgenden Schritten vermeiden Sie, dass Ihrem Google Cloud-Konto die in dieser Anleitung verwendeten Ressourcen in Rechnung gestellt werden:

Projekt löschen

Am einfachsten können Sie weitere Kosten vermeiden, wenn Sie das Google Cloud-Projekt löschen, das Sie für den Schnellstart erstellt haben.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Einzelne Ressourcen löschen

Wenn Sie das in dieser Kurzanleitung verwendete Google Cloud-Projekt beibehalten möchten, löschen Sie den Cloud Storage-Bucket:

- In the Google Cloud console, go to the Cloud Storage Buckets page.

- Click the checkbox for the bucket that you want to delete.

- To delete the bucket, click Delete, and then follow the instructions.