Cloud Composer 1 | Cloud Composer 2

Tutorial ini menunjukkan cara menggunakan Cloud Composer untuk membuat DAG (Directed Acyclic Graph) Apache Airflow yang menjalankan tugas jumlah kata Apache Hadoop di cluster Dataproc.

Tujuan

- Akses lingkungan Cloud Composer Anda dan gunakan Airflow UI.

- Membuat dan melihat variabel lingkungan Airflow.

- Buat dan jalankan DAG yang mencakup tugas-tugas berikut:

- Membuat cluster Dataproc.

- Menjalankan tugas penghitungan kata Apache Hadoop di cluster.

- Menghasilkan hasil jumlah kata ke bucket Cloud Storage.

- Menghapus cluster.

Biaya

Dalam dokumen ini, Anda menggunakan komponen Google Cloud yang dapat ditagih berikut:

- Cloud Composer

- Dataproc

- Cloud Storage

Untuk membuat perkiraan biaya berdasarkan proyeksi penggunaan Anda,

gunakan kalkulator harga.

Sebelum memulai

Pastikan API berikut diaktifkan di project Anda:

Konsol

Enable the Dataproc, Cloud Storage APIs.

gcloud

Enable the Dataproc, Cloud Storage APIs:

gcloud services enable dataproc.googleapis.com

storage-component.googleapis.com Di project Anda, buat bucket Cloud Storage dari kelas dan region penyimpanan apa pun untuk menyimpan hasil tugas jumlah kata Hadoop.

Catat jalur bucket yang Anda buat, misalnya

gs://example-bucket. Anda akan menentukan variabel Airflow untuk jalur ini dan menggunakan variabel tersebut dalam contoh DAG nanti dalam tutorial ini.Buat lingkungan Cloud Composer dengan parameter default. Tunggu hingga pembuatan lingkungan selesai. Setelah selesai, tanda centang hijau akan ditampilkan di sebelah kiri nama lingkungan.

Catat region tempat Anda membuat lingkungan, misalnya

us-central. Anda akan menentukan variabel Airflow untuk region ini dan menggunakannya dalam contoh DAG untuk menjalankan cluster Dataproc di region yang sama.

Menetapkan variabel Airflow

Tetapkan variabel Airflow untuk digunakan nanti dalam contoh DAG. Misalnya, Anda dapat menetapkan variabel Airflow di UI Airflow.

| Variabel Airflow | Nilai |

|---|---|

gcp_project

|

Project ID dari project yang Anda gunakan untuk tutorial ini, seperti example-project. |

gcs_bucket

|

Bucket Cloud Storage URI yang Anda buat untuk tutorial ini, seperti gs://example-bucket |

gce_region

|

Region tempat Anda membuat lingkungan, seperti us-central1.

Ini adalah region tempat cluster Dataproc Anda akan dibuat. |

Lihat contoh alur kerja

DAG Airflow adalah kumpulan tugas terorganisir yang ingin Anda jadwalkan

dan jalankan. DAG ditentukan dalam file Python standar. Kode yang ditampilkan di

hadoop_tutorial.py adalah kode alur kerja.

Aliran udara 2

Aliran udara 1

Operator

Untuk mengorkestrasi tiga tugas dalam contoh alur kerja, DAG mengimpor tiga operator Airflow berikut:

DataprocClusterCreateOperator: Membuat cluster Dataproc.DataProcHadoopOperator: Mengirim tugas jumlah kata Hadoop dan menulis hasilnya ke bucket Cloud Storage.DataprocClusterDeleteOperator: Menghapus cluster untuk menghindari timbulnya biaya Compute Engine yang berkelanjutan.

Dependensi

Anda mengatur tugas yang ingin dijalankan dengan cara yang mencerminkan hubungan dan dependensinya. Tugas dalam DAG ini berjalan secara berurutan.

Aliran udara 2

Aliran udara 1

Penjadwalan

Nama DAG adalah composer_hadoop_tutorial, dan DAG berjalan sekali setiap

hari. Karena start_date yang diteruskan ke default_dag_args ditetapkan ke yesterday, Cloud Composer menjadwalkan alur kerja untuk dimulai segera setelah DAG diupload ke bucket lingkungan.

Aliran udara 2

Aliran udara 1

Mengupload DAG ke bucket lingkungan

Cloud Composer menyimpan DAG di folder /dags di bucket lingkungan Anda.

Untuk mengupload DAG:

Di komputer lokal Anda, simpan

hadoop_tutorial.py.Di konsol Google Cloud, buka halaman Environments.

Dalam daftar lingkungan, pada kolom folder DAGs untuk lingkungan Anda, klik link DAGs.

Klik Upload file.

Pilih

hadoop_tutorial.pydi komputer lokal Anda dan klik Open.

Cloud Composer menambahkan DAG ke Airflow dan menjadwalkan DAG secara otomatis. Perubahan DAG terjadi dalam 3-5 menit.

Pelajari operasi DAG

Lihat status tugas

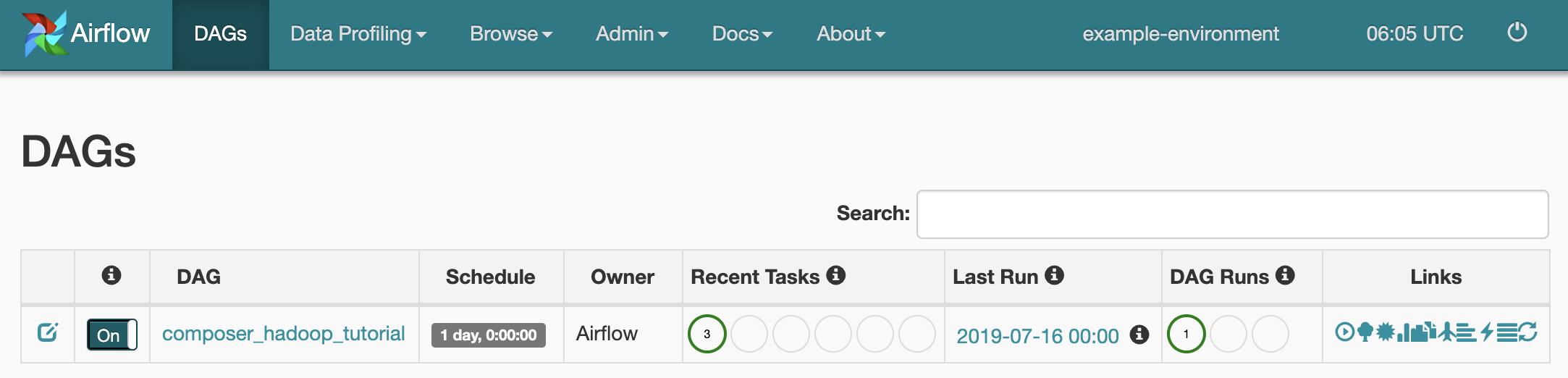

Saat Anda mengupload file DAG ke folder dags/ di Cloud Storage, Cloud Composer akan mengurai file tersebut. Jika berhasil diselesaikan, nama

alur kerja akan muncul di listingan DAG, dan alur kerja akan dimasukkan ke dalam antrean untuk

segera dijalankan.

Untuk melihat status tugas, buka antarmuka web Airflow, lalu klik DAG di toolbar.

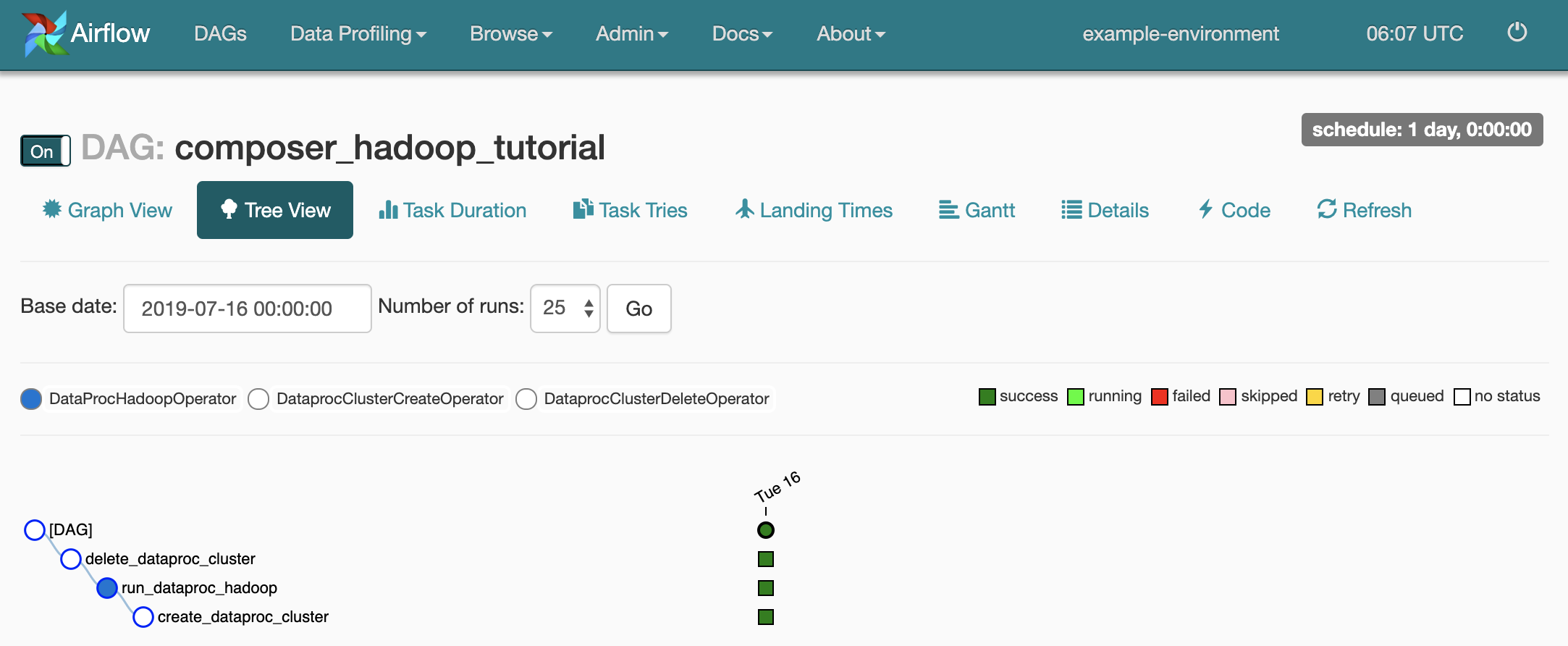

Untuk membuka halaman detail DAG, klik

composer_hadoop_tutorial. Halaman ini menyertakan representasi grafis dari tugas dan dependensi alur kerja.

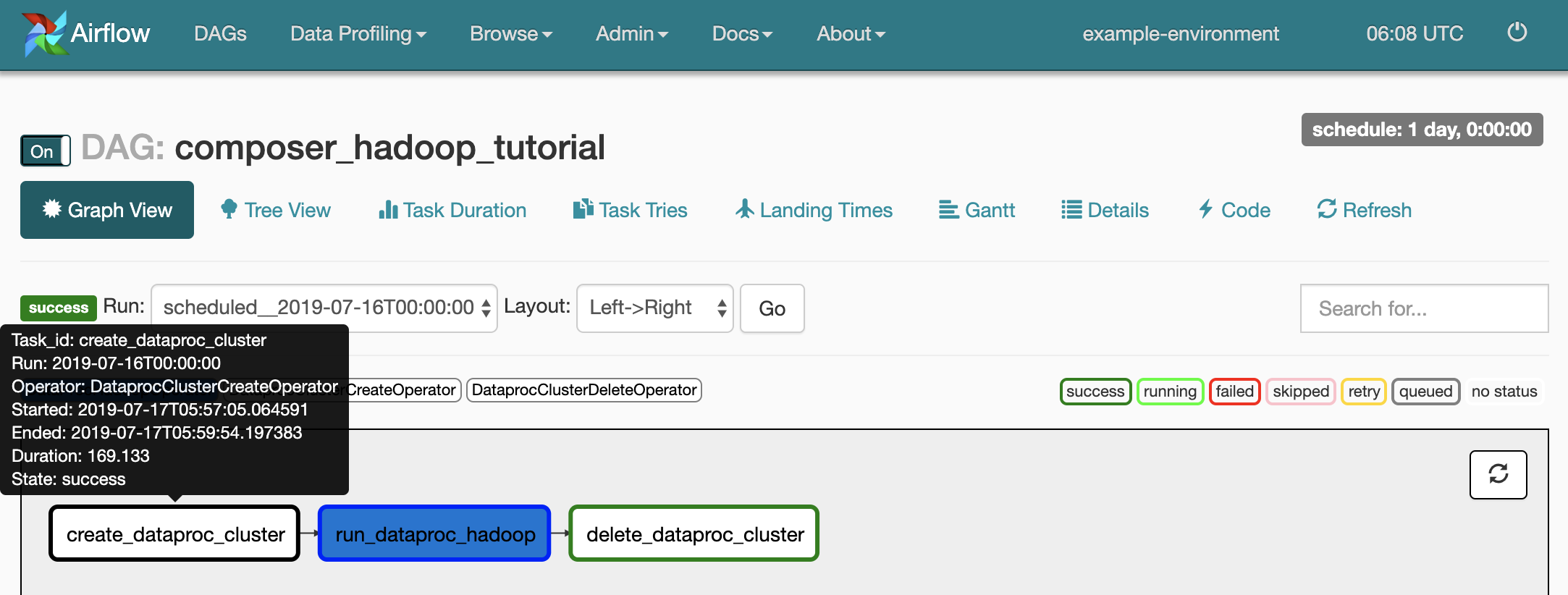

Untuk melihat status setiap tugas, klik Graph View, lalu arahkan kursor ke grafik untuk setiap tugas.

Mengantrekan alur kerja lagi

Untuk menjalankan alur kerja lagi dari Graph View:

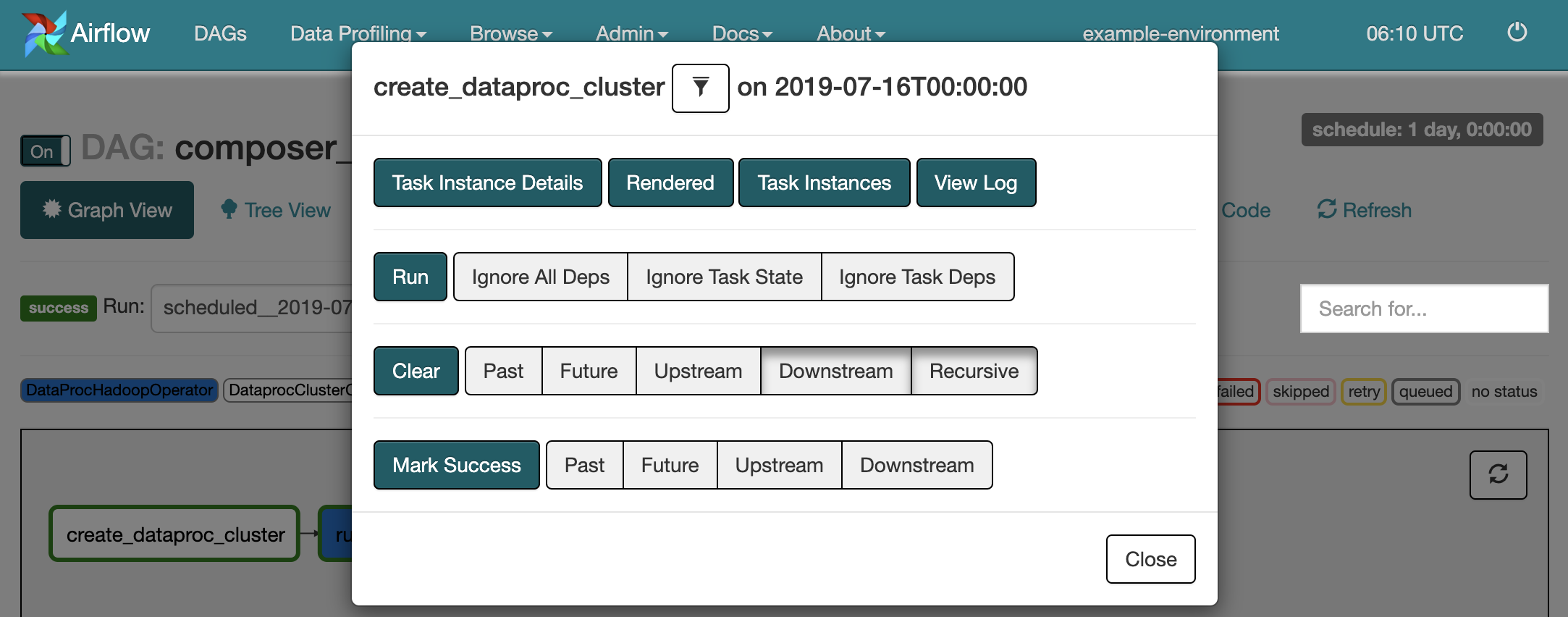

- Di Tampilan Grafik UI Airflow, klik grafis

create_dataproc_cluster. - Untuk mereset ketiga tugas tersebut, klik Hapus, lalu klik Oke untuk mengonfirmasi.

- Klik

create_dataproc_clusterlagi di Graph View. - Untuk mengantrekan alur kerja lagi, klik Jalankan.

Melihat hasil tugas

Anda juga dapat memeriksa status dan hasil alur kerja composer_hadoop_tutorial dengan membuka halaman Konsol Google Cloud berikut:

Cluster Dataproc: untuk memantau pembuatan dan penghapusan cluster. Perhatikan bahwa cluster yang dibuat oleh alur kerja bersifat sementara: cluster hanya ada selama durasi alur kerja dan dihapus sebagai bagian dari tugas alur kerja terakhir.

Tugas Dataproc: untuk melihat atau memantau tugas jumlah kata Apache Hadoop. Klik ID Tugas untuk melihat output log tugas.

Browser Cloud Storage: untuk melihat hasil jumlah kata di folder

wordcountdi bucket Cloud Storage yang Anda buat untuk tutorial ini.

Pembersihan

Hapus resource yang digunakan dalam tutorial ini:

Menghapus lingkungan Cloud Composer, termasuk menghapus bucket lingkungan secara manual.

Hapus bucket Cloud Storage yang menyimpan hasil tugas jumlah kata Hadoop.