Modelos de linguagem grandes (LLMs)

Modelos de linguagem grandes com a tecnologia de ponta da IA do Google

O Google Cloud traz inovações desenvolvidas e testadas pelo Google DeepMind para nossa plataforma de IA pronta para empresas. Assim, os clientes podem começar a usá-las para criar e oferecer recursos de IA generativa hoje mesmo — não amanhã.

Novos clientes ganham US$ 300 em créditos para gastar naVertex AI.

Visão geral

O que é um modelo de linguagem grande (LLM)?

Um modelo de linguagem grande (LLM) é um modelo de linguagem estatística, treinado com uma quantidade enorme de dados, que pode ser usado para gerar e traduzir texto e outros conteúdos, além de executar outras tarefas de processamento de linguagem natural (PLN).

Normalmente, os LLMs são baseados em arquiteturas de aprendizado profundo, como o Transformer desenvolvido pelo Google em 2017, e podem ser treinados com bilhões de texto e outros conteúdos.

Quais são alguns exemplos de modelos de fundação conhecidos?

A Vertex AI oferece acesso ao Gemini, um modelo multimodal do Google DeepMind. O Gemini é capaz de entender praticamente qualquer entrada, combinando diferentes tipos de informações e gerando quase qualquer saída. Crie e teste na Vertex AI com o Gemini, usando texto, imagens, vídeo ou código Usando o raciocínio avançado e os recursos de geração de última geração do Gemini, os desenvolvedores podem testar exemplos de comandos para extrair texto de imagens, converter o texto da imagem para JSON e até gerar respostas sobre imagens enviadas para criar aplicativos de IA de última geração.

Quais são os casos de uso para modelos de linguagem grandes?

Os LLMs orientados por texto são usados em diversas tarefas de processamento de linguagem natural, como geração de texto, tradução automática, resumo de texto, respostas a perguntas e criação de chatbots que podem conversar com humanos.

Os LLMs também podem ser treinados com outros tipos de dados, como código, imagens, áudio, vídeo e mais. Os modelos Veo, Imagen e Chirp da IA do Google são alguns exemplos desse tipo que geram novos aplicativos e ajudam a criar soluções para os problemas mais complexos do mundo.

Quais são os benefícios dos modelos de linguagem grandes?

Quais serviços de modelos de linguagem grandes o Google Cloud oferece?

IA generativa na Vertex AI: oferece acesso aos grandes modelos de IA generativa do Google para que seja possível testar, ajustar e implantá-los para uso nos seus aplicativos com tecnologia de IA.

Vertex AI Agent Builder: permite que os desenvolvedores criem agentes com uma abordagem aberta e os implantem com controles de nível empresarial.

Customer Engagement Suite com a IA do Google: solução para central de atendimento inteligente que inclui o Dialogflow, nossa plataforma de IA de conversação com recursos de LLM e baseados em intent.

Como funciona

Os LLMs usam uma quantidade enorme de dados de texto para treinar uma rede neural. Essa rede neural é então usada para gerar e traduzir textos ou realizar outras tarefas. Quanto mais dados forem usados para treinar a rede neural, melhor e mais precisa ela será na execução da tarefa.

O Google Cloud desenvolveu produtos com base nas próprias tecnologias de LLM, atendendo a diversos casos de uso que são apresentados a seguir na seção "Usos comuns".

Os LLMs usam uma quantidade enorme de dados de texto para treinar uma rede neural. Essa rede neural é então usada para gerar e traduzir textos ou realizar outras tarefas. Quanto mais dados forem usados para treinar a rede neural, melhor e mais precisa ela será na execução da tarefa.

O Google Cloud desenvolveu produtos com base nas próprias tecnologias de LLM, atendendo a diversos casos de uso que são apresentados a seguir na seção "Usos comuns".

Usos comuns

Crie um chatbot

Crie um chatbot com tecnologia de LLM

A Vertex AI para Agentes facilita a criação de chatbots com fala natural, semelhantes a humanos. O agente de IA generativa é um recurso da Vertex AI para Agentes criado com base na funcionalidade do Dialogflow CX.

Com esse recurso, é possível informar um URL do site e/ou qualquer número de documentos para que o agente de IA generativa analise o conteúdo e crie um agente virtual com tecnologia de repositório de dados e LLMs.

Tutoriais

Crie um chatbot com tecnologia de LLM

A Vertex AI para Agentes facilita a criação de chatbots com fala natural, semelhantes a humanos. O agente de IA generativa é um recurso da Vertex AI para Agentes criado com base na funcionalidade do Dialogflow CX.

Com esse recurso, é possível informar um URL do site e/ou qualquer número de documentos para que o agente de IA generativa analise o conteúdo e crie um agente virtual com tecnologia de repositório de dados e LLMs.

Pesquisa e descoberta de informações

Encontre e resuma informações complexas em momentos

Extraia e resuma informações importantes de documentos complexos, como formulários 10K, artigos de pesquisa, serviços de notícias de terceiros e relatórios financeiros. Basta clicar em um botão. Saiba como a Vertex AI para Pesquisa usa linguagem natural para entender consultas semânticas, oferecer respostas resumidas e incluir perguntas de acompanhamento na demonstração à direita.

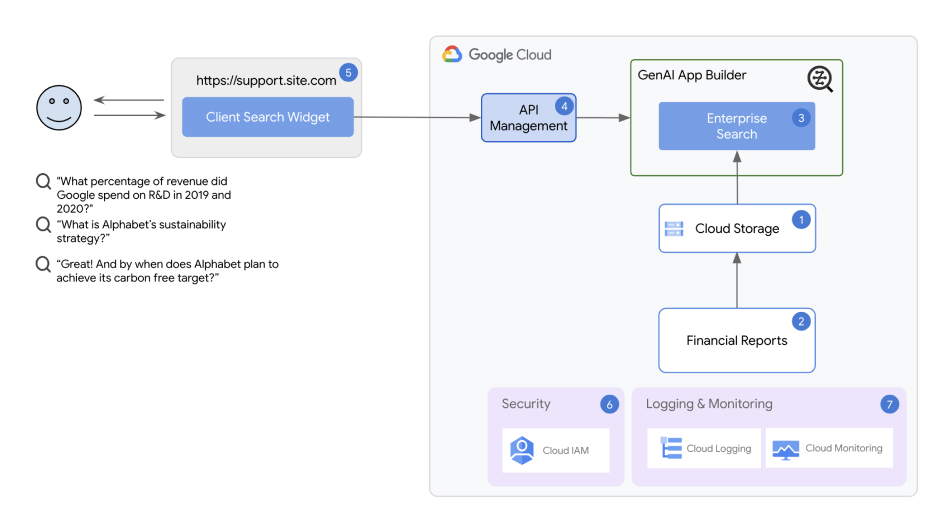

Arquitetura da solução de pesquisa e descoberta de informações

A solução usa o Vertex AI Agent Builder como componente principal. Com o Vertex AI Agent Builder, até mesmo desenvolvedores em início de carreira podem criar e implantar chatbots e apps de pesquisa em minutos.

Tutoriais

Encontre e resuma informações complexas em momentos

Extraia e resuma informações importantes de documentos complexos, como formulários 10K, artigos de pesquisa, serviços de notícias de terceiros e relatórios financeiros. Basta clicar em um botão. Saiba como a Vertex AI para Pesquisa usa linguagem natural para entender consultas semânticas, oferecer respostas resumidas e incluir perguntas de acompanhamento na demonstração à direita.

Outros recursos

Arquitetura da solução de pesquisa e descoberta de informações

A solução usa o Vertex AI Agent Builder como componente principal. Com o Vertex AI Agent Builder, até mesmo desenvolvedores em início de carreira podem criar e implantar chatbots e apps de pesquisa em minutos.

Resumo de documentos

Processe e faça um resumo de documentos grandes usando os LLMs da Vertex AI

Com o Resumo de documentos da IA generativa, implante uma solução de um clique para ajudar a detectar texto em arquivos brutos e automatizar resumos de documentos. A solução estabelece um pipeline que usa o reconhecimento óptico de caracteres (OCR) do Cloud Vision para extrair texto de documentos PDF enviados por upload no Cloud Storage, cria um resumo do texto extraído com o Vertex AI Generative AI Studio e armazena o resumo pesquisável em um banco de dados do BigQuery.

Tutoriais

Processe e faça um resumo de documentos grandes usando os LLMs da Vertex AI

Com o Resumo de documentos da IA generativa, implante uma solução de um clique para ajudar a detectar texto em arquivos brutos e automatizar resumos de documentos. A solução estabelece um pipeline que usa o reconhecimento óptico de caracteres (OCR) do Cloud Vision para extrair texto de documentos PDF enviados por upload no Cloud Storage, cria um resumo do texto extraído com o Vertex AI Generative AI Studio e armazena o resumo pesquisável em um banco de dados do BigQuery.

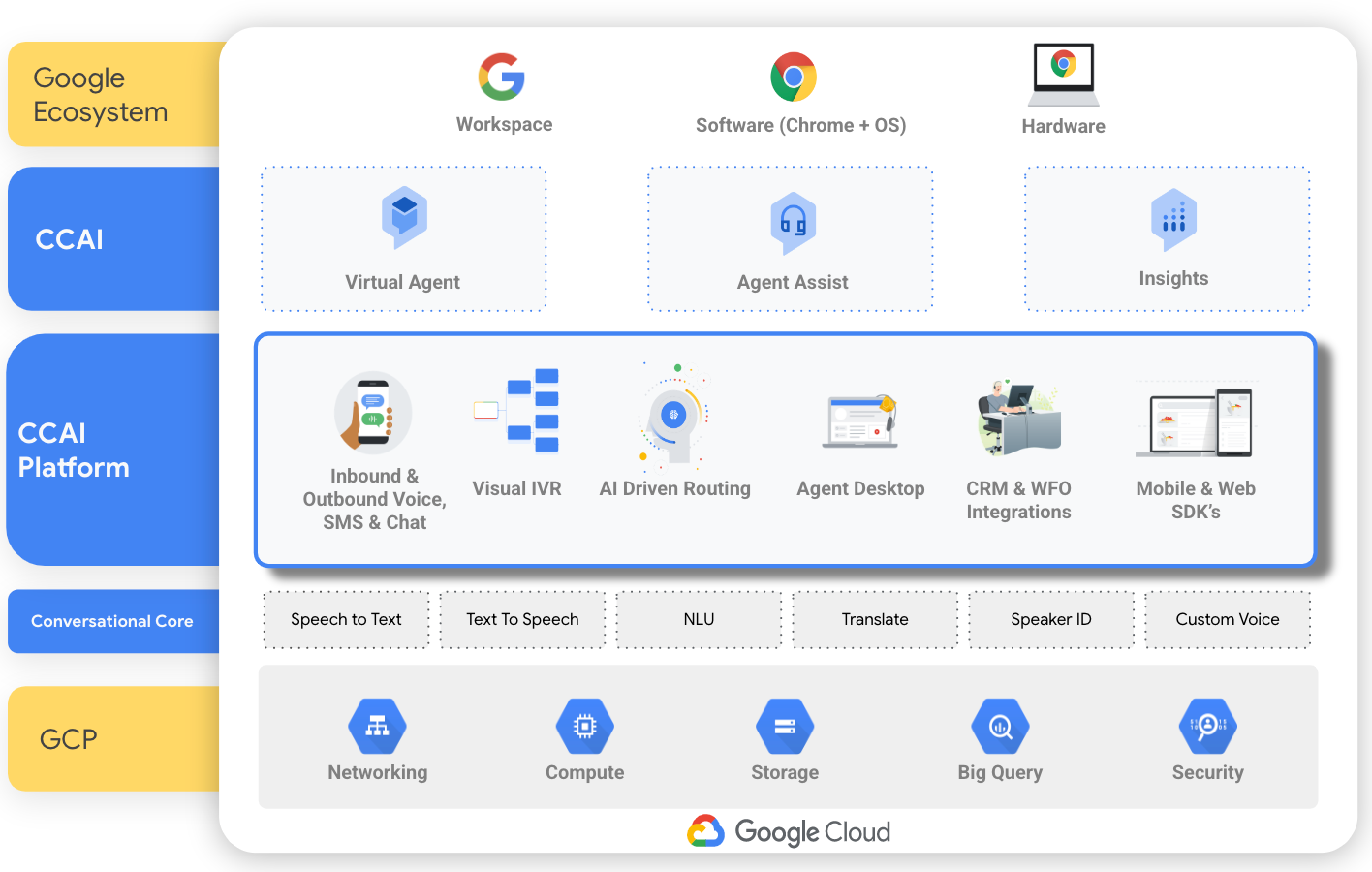

Crie uma central de atendimento com tecnologia de IA

Crie uma central de atendimento com tecnologia de IA usando a CCAI

Com tecnologias de IA, como processamento de linguagem natural, machine learning e reconhecimento de texto e voz, o Customer Engagement Suite com a IA do Google oferece uma solução de central de atendimento como serviço (CCaaS) que ajuda a criar uma central de atendimento do zero. Ela também tem ferramentas individuais voltadas a aspectos específicos de uma central de atendimento, por exemplo, Dialogflow para criar um chatbot, Agent Assist para assistência em tempo real a agentes humanos e Insights de conversa para identificar o sentimento e os motivadores das ligações.

Tutoriais

Crie uma central de atendimento com tecnologia de IA usando a CCAI

Com tecnologias de IA, como processamento de linguagem natural, machine learning e reconhecimento de texto e voz, o Customer Engagement Suite com a IA do Google oferece uma solução de central de atendimento como serviço (CCaaS) que ajuda a criar uma central de atendimento do zero. Ela também tem ferramentas individuais voltadas a aspectos específicos de uma central de atendimento, por exemplo, Dialogflow para criar um chatbot, Agent Assist para assistência em tempo real a agentes humanos e Insights de conversa para identificar o sentimento e os motivadores das ligações.