modelli linguistici di grandi dimensioni (LLM)

Modelli linguistici di grandi dimensioni (LLM) basati sull'IA di Google di altissimo livello

Google Cloud introduce innovazioni sviluppate e testate da Google Deepmind nella nostra piattaforma di IA di livello enterprise, in modo che i clienti possano iniziare a utilizzarle per creare e fornire funzionalità di IA generativa oggi stesso, non domani.

I nuovi clienti ricevono 300 $ di crediti gratuiti da spendere su Vertex AI.

Panoramica

Che cos'è un modello linguistico di grandi dimensioni (LLM)?

Un modello linguistico di grandi dimensioni (LLM) è un modello linguistico statistico, addestrato su un'enorme quantità di dati, che può essere utilizzato per generare e tradurre testo e altri contenuti ed eseguire altre attività di elaborazione del linguaggio naturale (NLP).

Gli LLM si basano solitamente su architetture di deep learning, come il Transformer sviluppato da Google nel 2017, e possono essere addestrati su miliardi di testi e altri contenuti.

Quali sono alcuni esempi di modelli di base popolari?

Vertex AI offre l'accesso a Gemini, un modello multimodale di Google DeepMind. Gemini è in grado di comprendere praticamente qualsiasi input, combinare diversi tipi di informazioni e generare quasi tutti gli output. Esegui prompt e test in Vertex AI con Gemini utilizzando testo, immagini, video o codice. Utilizzando il ragionamento avanzato e le funzionalità di generazione all'avanguardia di Gemini, gli sviluppatori possono provare prompt di esempio per estrarre il testo dalle immagini, convertire il testo delle immagini in formato JSON e persino generare risposte sulle immagini caricate per creare applicazioni IA di nuova generazione.

Quali sono i casi d'uso dei modelli linguistici di grandi dimensioni (LLM)?

Gli LLM basati sul testo vengono utilizzati per una varietà di attività di elaborazione del linguaggio naturale, tra cui la generazione del testo, la traduzione automatica, il riassunto del testo, la risposta a domande e la creazione di chatbot in grado di intrattenere conversazioni con gli esseri umani.

Gli LLM possono anche essere addestrati su altri tipi di dati, tra cui codice, immagini, audio, video e altro ancora. Veo, Imagen e Chirp di Google AI sono esempi di questi modelli che daranno vita a nuove applicazioni e aiuteranno a creare soluzioni ai problemi più difficili al mondo.

Quali sono i vantaggi dei modelli LLM?

Quali servizi di modelli linguistici di grandi dimensioni (LLM) offre Google Cloud?

AI generativa su Vertex AI: ti consente di accedere ai grandi modelli di AI generativa di Google in modo da poterli testare, ottimizzare ed eseguire il deployment per utilizzarli nelle tue applicazioni basate sull'AI.

Vertex AI Agent Builder: consente agli sviluppatori di creare agenti con un approccio aperto ed eseguirne il deployment con controlli di livello enterprise.

Customer Engagement Suite con Google AI: soluzione intelligente per contact center che include Dialogflow, la nostra piattaforma di AI conversazionale con funzionalità sia basate su intent che LLM.

Come funziona

Gli LLM utilizzano un'enorme quantità di dati di testo per addestrare una rete neurale. Questa rete neurale viene quindi utilizzata per generare e tradurre testi o per svolgere altre attività. Più dati vengono utilizzati per addestrare la rete neurale, migliore e più precisa sarà nello svolgimento del suo compito.

Google Cloud ha sviluppato prodotti basati sulle sue tecnologie LLM, per un'ampia varietà di casi d'uso che puoi esplorare nella sezione Utilizzi comuni di seguito.

Gli LLM utilizzano un'enorme quantità di dati di testo per addestrare una rete neurale. Questa rete neurale viene quindi utilizzata per generare e tradurre testi o per svolgere altre attività. Più dati vengono utilizzati per addestrare la rete neurale, migliore e più precisa sarà nello svolgimento del suo compito.

Google Cloud ha sviluppato prodotti basati sulle sue tecnologie LLM, per un'ampia varietà di casi d'uso che puoi esplorare nella sezione Utilizzi comuni di seguito.

Utilizzi comuni

Crea un chatbot

Crea un chatbot basato su LLM

Vertex AI Agents consente la creazione di chatbot dal suono naturale, simile a quello umano. Generative AI Agent è una funzionalità di Vertex AI Agents basata su Dialogflow CX.

Grazie a questa funzionalità, Generative AI Agent è in grado di analizzare un sito web e/o un numero qualsiasi di documenti e creare un agente virtuale basato su datastore e LLM.

Procedure

Crea un chatbot basato su LLM

Vertex AI Agents consente la creazione di chatbot dal suono naturale, simile a quello umano. Generative AI Agent è una funzionalità di Vertex AI Agents basata su Dialogflow CX.

Grazie a questa funzionalità, Generative AI Agent è in grado di analizzare un sito web e/o un numero qualsiasi di documenti e creare un agente virtuale basato su datastore e LLM.

Ricerca e scoperta delle informazioni

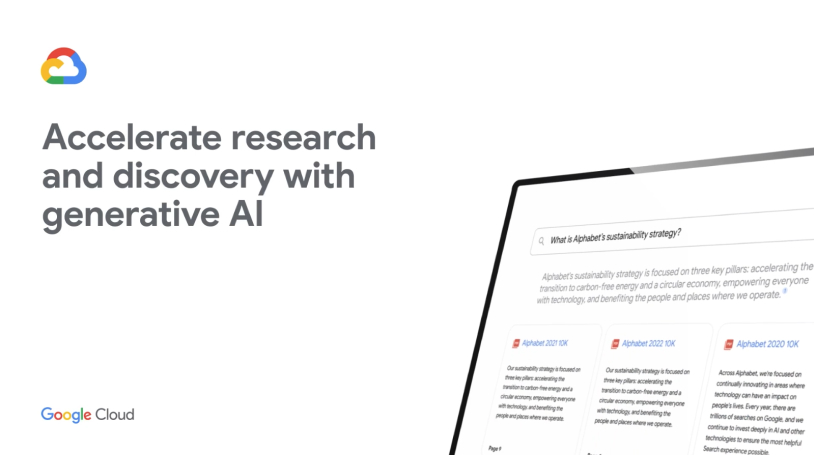

Trova e riepiloga le informazioni complesse in pochi istanti

Estrai e riepiloga informazioni importanti da documenti complessi, come moduli 10-K, articoli di ricerca, servizi di informazione di terze parti e report finanziari, con un semplice clic. Guarda come Vertex AI Search utilizza il linguaggio naturale per comprendere le query semantiche, offrire risposte riepilogative e domande di follow-up nella demo a destra.

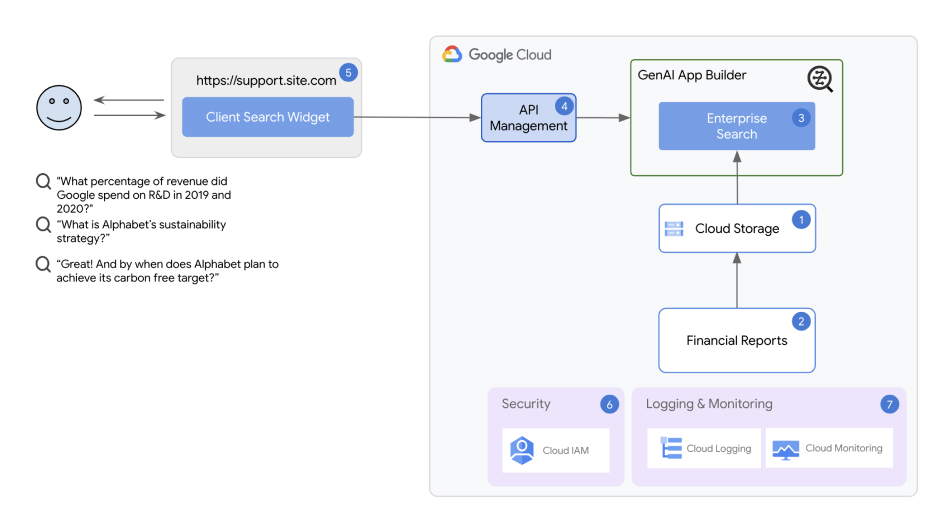

Architettura della soluzione di ricerca e scoperta delle informazioni

La soluzione utilizza Vertex AI Agent Builder come componente principale. Con Vertex AI Agent Builder, anche gli sviluppatori all'inizio della carriera possono creare ed eseguire il deployment di chatbot e applicazioni di ricerca in pochi minuti.

Procedure

Trova e riepiloga le informazioni complesse in pochi istanti

Estrai e riepiloga informazioni importanti da documenti complessi, come moduli 10-K, articoli di ricerca, servizi di informazione di terze parti e report finanziari, con un semplice clic. Guarda come Vertex AI Search utilizza il linguaggio naturale per comprendere le query semantiche, offrire risposte riepilogative e domande di follow-up nella demo a destra.

Risorse aggiuntive

Architettura della soluzione di ricerca e scoperta delle informazioni

La soluzione utilizza Vertex AI Agent Builder come componente principale. Con Vertex AI Agent Builder, anche gli sviluppatori all'inizio della carriera possono creare ed eseguire il deployment di chatbot e applicazioni di ricerca in pochi minuti.

Riassunto di un documento

Elaborazione e riepilogo di documenti di grandi dimensioni utilizzando gli LLM di Vertex AI

Con Generative AI Document Summarization, esegui il deployment di una soluzione con un solo clic che aiuta a rilevare il testo nei file non elaborati e ad automatizzare i riepiloghi dei documenti. La soluzione stabilisce una pipeline che utilizza il riconoscimento ottico dei caratteri (OCR) di Cloud Vision per estrarre il testo dai documenti PDF caricati in Cloud Storage, crea un riepilogo dal testo estratto con Vertex AI Generative AI Studio e lo archivia in un database BigQuery.

Procedure

Elaborazione e riepilogo di documenti di grandi dimensioni utilizzando gli LLM di Vertex AI

Con Generative AI Document Summarization, esegui il deployment di una soluzione con un solo clic che aiuta a rilevare il testo nei file non elaborati e ad automatizzare i riepiloghi dei documenti. La soluzione stabilisce una pipeline che utilizza il riconoscimento ottico dei caratteri (OCR) di Cloud Vision per estrarre il testo dai documenti PDF caricati in Cloud Storage, crea un riepilogo dal testo estratto con Vertex AI Generative AI Studio e lo archivia in un database BigQuery.

Creare un contact center basato sull'IA

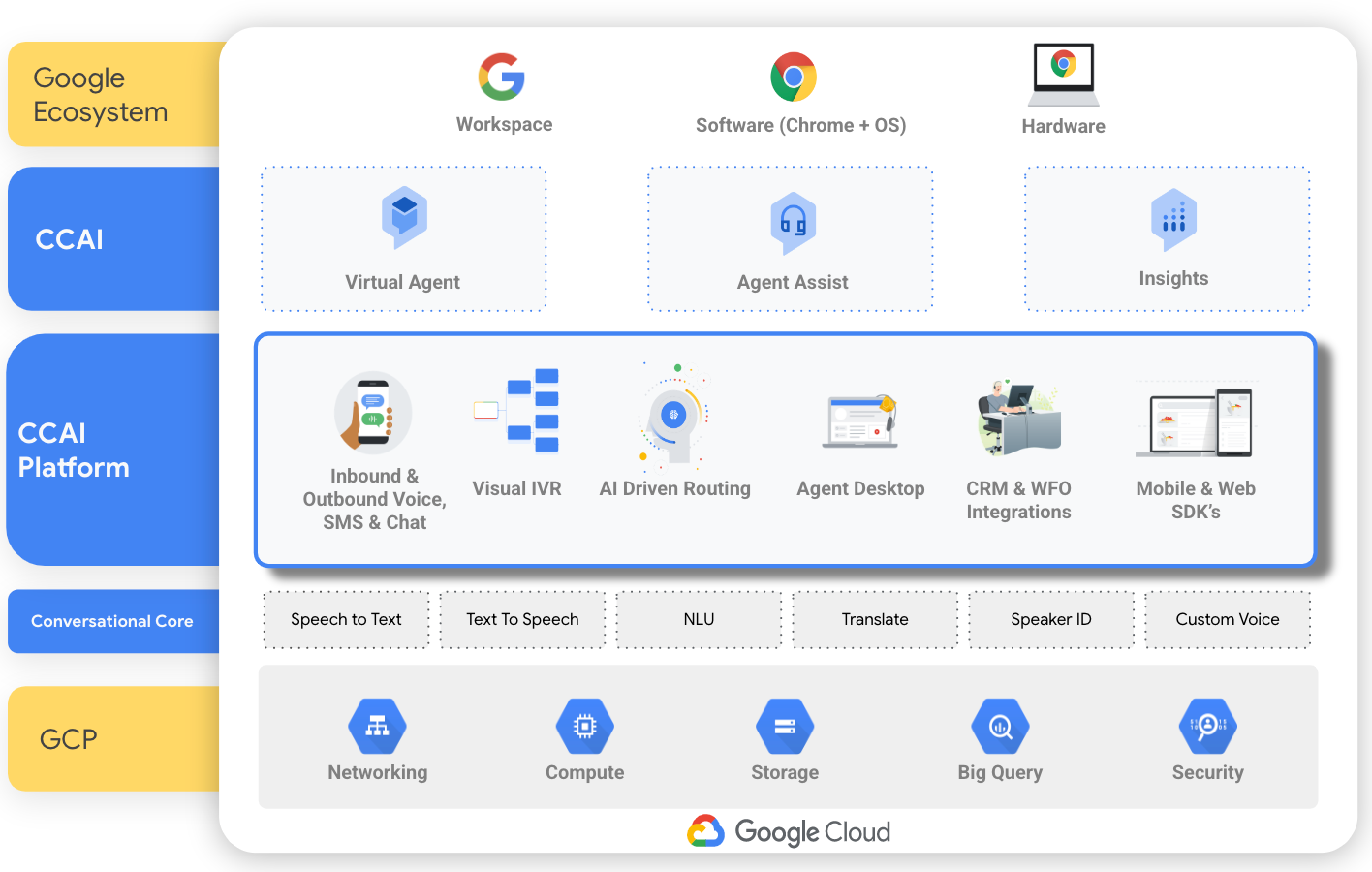

Crea un contact center basato sull'IA con CCAI

Basata su tecnologie di AI come l'elaborazione del linguaggio naturale, il machine learning e il riconoscimento vocale e testuale, la suite Customer Engagement con Google AI offre una soluzione Contact Center as a Service (CCaaS) che aiuta a creare un contact center da zero. Dispone inoltre di strumenti individuali che gestiscono aspetti specifici di un contact center, ad esempio Conversational Agents (Dialogflow) per creare un chatbot, Agent Assist per l'assistenza in tempo reale agli agenti umani e Conversational Insights per identificare i fattori chiave e il sentiment delle chiamate.

Procedure

Crea un contact center basato sull'IA con CCAI

Basata su tecnologie di AI come l'elaborazione del linguaggio naturale, il machine learning e il riconoscimento vocale e testuale, la suite Customer Engagement con Google AI offre una soluzione Contact Center as a Service (CCaaS) che aiuta a creare un contact center da zero. Dispone inoltre di strumenti individuali che gestiscono aspetti specifici di un contact center, ad esempio Conversational Agents (Dialogflow) per creare un chatbot, Agent Assist per l'assistenza in tempo reale agli agenti umani e Conversational Insights per identificare i fattori chiave e il sentiment delle chiamate.