Modelos de lenguaje extensos (LLMs)

Modelos de lenguaje extensos con la excepcional IA de Google

Google Cloud lleva las innovaciones desarrolladas y probadas por Google DeepMind a nuestra plataforma de IA preparada para el ámbito empresarial. De esta manera, los clientes pueden empezar a usarlas para desarrollar y ofrecer funciones de IA generativa hoy mismo, no en el futuro.

Los nuevos clientes reciben 300 USD gratis para invertirlo en Vertex AI.

Información general

¿Qué es un modelo de lenguaje extenso (LLM)?

Un modelo de lenguaje extenso (LLM) es un modelo estadístico de lenguaje entrenado con una gran cantidad de datos que puede utilizarse para generar y traducir texto y otros tipos de contenido, así como para llevar a cabo otras tareas de procesamiento del lenguaje natural (PLN).

Los LLMs suelen basarse en arquitecturas de aprendizaje profundo, como el Transformer que desarrolló Google en el 2017, y se pueden entrenar con miles de millones de textos y otros contenidos.

¿Cuáles son algunos ejemplos de los modelos básicos más populares?

Vertex AI ofrece acceso a Gemini, un modelo multimodal de Google DeepMind. Gemini es capaz de comprender prácticamente cualquier entrada gracias a la combinación de diferentes tipos de información, y de generar casi cualquier salida. Realiza peticiones y pruebas en Vertex AI con Gemini, usando texto, imágenes, vídeo o código. Gracias al razonamiento avanzado y las funciones innovadoras de generación de Gemini, los desarrolladores pueden probar peticiones de ejemplo para extraer texto de imágenes, convertir texto de imagen a JSON e incluso generar respuestas sobre imágenes subidas para crear aplicaciones de IA de nueva generación.

¿En qué casos se pueden usar los modelos de lenguaje extensos?

Los LLMs basados en texto se utilizan para llevar a cabo diversas tareas de procesamiento del lenguaje natural, como la generación de texto, la traducción automática, el resumen de textos, la respuesta a preguntas y la creación de bots de chat que pueden mantener conversaciones con personas.

Los LLMs también se pueden entrenar con otros tipos de datos, como código, imágenes, audio, vídeo y más. Veo, Imagen y Chirp de Google AI son ejemplos de modelos que generarán nuevas aplicaciones y ayudarán a crear soluciones para los problemas más complicados del mundo.

¿Cuáles son las ventajas de los modelos de lenguaje extensos?

¿Qué servicios de modelo de lenguaje extenso ofrece Google Cloud?

IA generativa en Vertex AI: te da acceso a grandes modelos de IA generativa de Google para que puedas probarlos, ajustarlos y desplegarlos antes de usarlos en tus aplicaciones basadas en IA.

Vertex AI Agent Builder: permite a los desarrolladores crear agentes con un enfoque abierto y desplegarlos con controles de nivel empresarial.

Customer Engagement Suite with Google AI: solución de centro de contacto inteligente que incluye Dialogflow, nuestra plataforma de IA conversacional con funciones basadas en la intención y en LLMs.

Cómo funciona

Los LLMs entrenan una red neuronal a partir de gran cantidad de datos de texto. Esta red neuronal se usa para generar o traducir texto o llevar a cabo otras tareas. Cuantos más datos se usen para entrenar la red neuronal, mejor y más precisa será la ejecución de la tarea.

Google Cloud ha desarrollado productos basados en sus tecnologías de LLMs para dar respuesta a una amplia variedad de casos prácticos. Puedes consultarlos en la sección "Usos habituales" de este artículo.

Los LLMs entrenan una red neuronal a partir de gran cantidad de datos de texto. Esta red neuronal se usa para generar o traducir texto o llevar a cabo otras tareas. Cuantos más datos se usen para entrenar la red neuronal, mejor y más precisa será la ejecución de la tarea.

Google Cloud ha desarrollado productos basados en sus tecnologías de LLMs para dar respuesta a una amplia variedad de casos prácticos. Puedes consultarlos en la sección "Usos habituales" de este artículo.

Usos habituales

Crea un bot de chat

Desarrolla un bot de chat con LLM

Vertex AI Conversation facilita la creación de bots de chat que suenan naturales y parecen humanos. Generative AI Agent es una función de Vertex AI Conversation que se basa en la funcionalidad de Dialogflow CX.

Con esta función, puedes proporcionar la URL de un sitio web o cualquier número de documentos para que el agente de IA generativa analice tu contenido y cree un agente virtual basado en almacenes de datos y LLMs.

Instrucciones

Desarrolla un bot de chat con LLM

Vertex AI Conversation facilita la creación de bots de chat que suenan naturales y parecen humanos. Generative AI Agent es una función de Vertex AI Conversation que se basa en la funcionalidad de Dialogflow CX.

Con esta función, puedes proporcionar la URL de un sitio web o cualquier número de documentos para que el agente de IA generativa analice tu contenido y cree un agente virtual basado en almacenes de datos y LLMs.

Investigación y descubrimiento de información

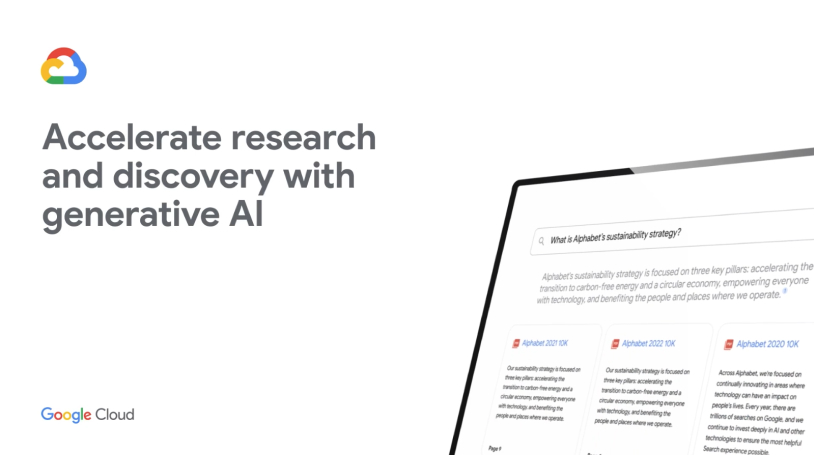

Buscar y resumir información compleja en momentos

Extrae y resume información valiosa de documentos complejos, como formularios 10-K, artículos de investigación, servicios de noticias de terceros e informes financieros, con solo hacer clic en un botón. Descubre cómo utiliza Vertex AI Search el lenguaje natural para comprender consultas semánticas, ofrecer respuestas resumidas y hacer preguntas de seguimiento en la demo de la derecha.

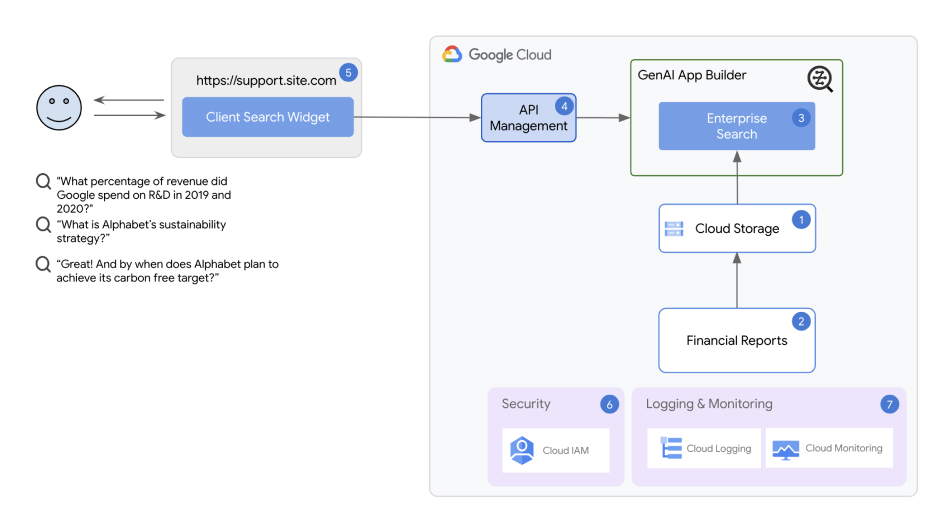

Arquitectura de soluciones de investigación y descubrimiento de información

La solución usa Vertex AI Agent Builder como componente principal. Gracias a Vertex AI Agent Builder, incluso los desarrolladores que están empezando su carrera profesional pueden crear y desplegar rápidamente bots de chat y aplicaciones de búsqueda en cuestión de minutos.

Instrucciones

Buscar y resumir información compleja en momentos

Extrae y resume información valiosa de documentos complejos, como formularios 10-K, artículos de investigación, servicios de noticias de terceros e informes financieros, con solo hacer clic en un botón. Descubre cómo utiliza Vertex AI Search el lenguaje natural para comprender consultas semánticas, ofrecer respuestas resumidas y hacer preguntas de seguimiento en la demo de la derecha.

Otros recursos

Arquitectura de soluciones de investigación y descubrimiento de información

La solución usa Vertex AI Agent Builder como componente principal. Gracias a Vertex AI Agent Builder, incluso los desarrolladores que están empezando su carrera profesional pueden crear y desplegar rápidamente bots de chat y aplicaciones de búsqueda en cuestión de minutos.

Resumen de documentos

Procesa y resume documentos de gran tamaño con LLMs de Vertex AI

Con la solución de resumen de documentos de IA generativa, podrás desplegar una solución con un solo clic que ayude a detectar texto en archivos sin procesar y a automatizar los resúmenes de documentos. La solución establece un flujo de procesamiento que utiliza la tecnología de reconocimiento óptico de caracteres (OCR) de Cloud Vision para extraer texto de documentos PDF subidos en Cloud Storage, crear un resumen del texto extraído con Generative AI Studio de Vertex AI y almacenar el resumen, que se puede buscar, en una base de datos de BigQuery.

Instrucciones

Procesa y resume documentos de gran tamaño con LLMs de Vertex AI

Con la solución de resumen de documentos de IA generativa, podrás desplegar una solución con un solo clic que ayude a detectar texto en archivos sin procesar y a automatizar los resúmenes de documentos. La solución establece un flujo de procesamiento que utiliza la tecnología de reconocimiento óptico de caracteres (OCR) de Cloud Vision para extraer texto de documentos PDF subidos en Cloud Storage, crear un resumen del texto extraído con Generative AI Studio de Vertex AI y almacenar el resumen, que se puede buscar, en una base de datos de BigQuery.

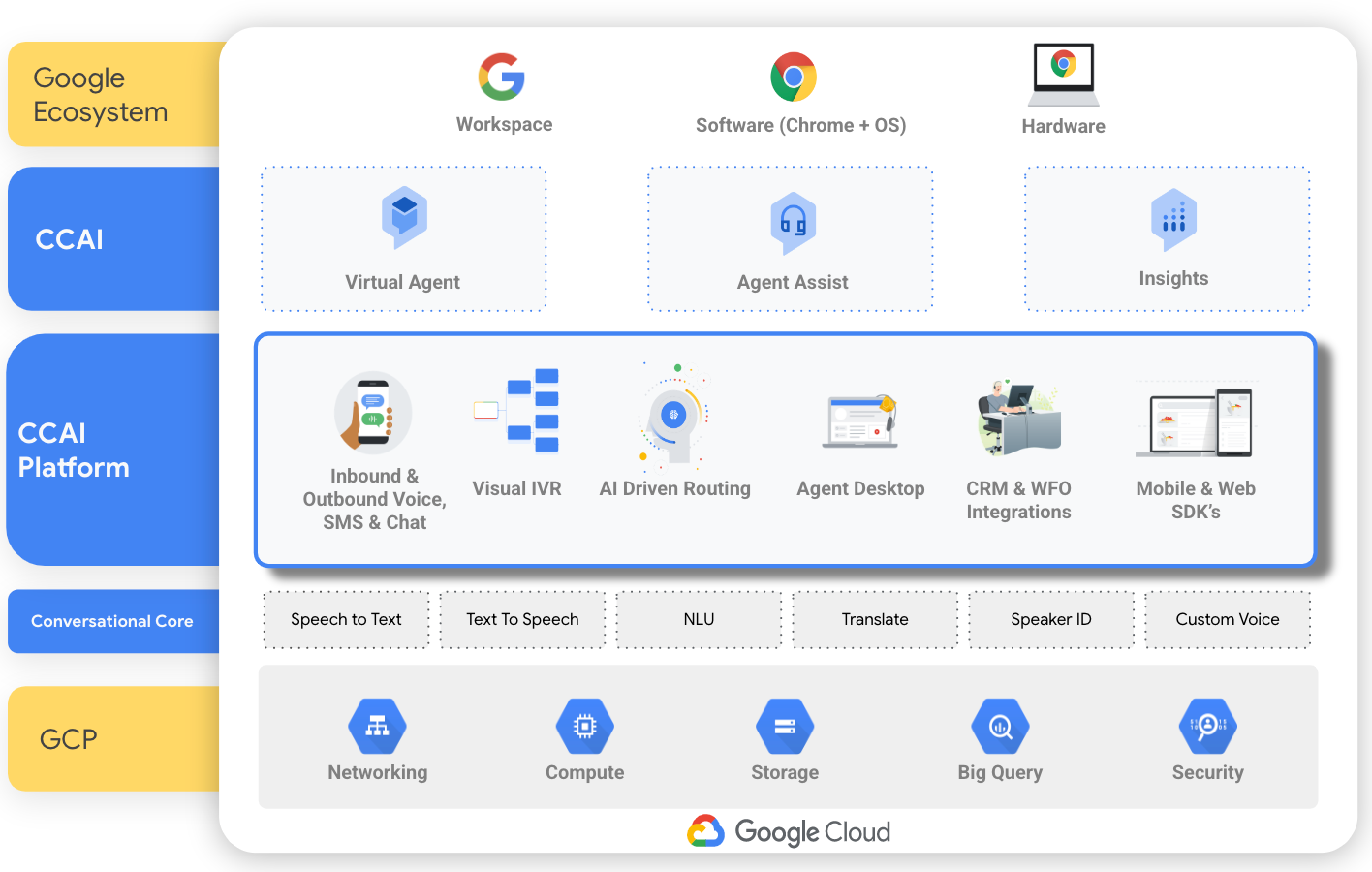

Crea un centro de contacto basado en IA

Crea un centro de contacto basado en IA con CCAI

El paquete de interacción con el cliente con la IA de Google usa la tecnología de IA del procesamiento del lenguaje natural, el aprendizaje automático y el reconocimiento de voz y texto, y cuenta con un centro de contacto como servicio (CCaaS) que permite crear un centro de contacto desde cero. También incluye herramientas concretas que se centran en aspectos específicos de un centro de contacto; por ejemplo, agentes conversacionales (Dialogflow) para crear un bot de chat, Agent Assist para ofrecer asistencia en tiempo real a los agentes humanos y Conversational Insights para identificar los motivos de las llamadas y las opiniones.

Instrucciones

Crea un centro de contacto basado en IA con CCAI

El paquete de interacción con el cliente con la IA de Google usa la tecnología de IA del procesamiento del lenguaje natural, el aprendizaje automático y el reconocimiento de voz y texto, y cuenta con un centro de contacto como servicio (CCaaS) que permite crear un centro de contacto desde cero. También incluye herramientas concretas que se centran en aspectos específicos de un centro de contacto; por ejemplo, agentes conversacionales (Dialogflow) para crear un bot de chat, Agent Assist para ofrecer asistencia en tiempo real a los agentes humanos y Conversational Insights para identificar los motivos de las llamadas y las opiniones.