Large Language Models (LLMs)

Large Language Models, die auf erstklassiger Google-KI basieren

Google Cloud bringt Innovationen, die von Google DeepMind entwickelt und getestet wurden, in unsere unternehmensgerechte KI-Plattform ein. Kunden können damit schon heute – und nicht erst morgen – Generative AI-Funktionen entwickeln und bereitstellen.

Neukunden erhalten ein Startguthaben von 300 $ für Vertex AI.

Überblick

Was ist ein Large Language Model (LLM)?

Ein Large Language Model (LLM) ist ein statistisches Sprachmodell, das auf einer riesigen Datenmenge trainiert wird. Es kann verwendet werden, um Text und andere Inhalte zu generieren und zu übersetzen sowie andere Aufgaben zur Natural Language Processing (NLP) auszuführen.

LLMs basieren in der Regel auf Deep-Learning-Architekturen wie dem 2017 von Google entwickelten Transformer und können mit Milliarden von Text und anderen Inhalten trainiert werden.

Was sind Beispiele für beliebte Foundation Models?

Vertex AI bietet Zugriff auf Gemini, ein multimodales Modell von Google DeepMind. Gemini ist in der Lage, praktisch jede Eingabe zu verstehen, verschiedene Arten von Informationen zu kombinieren und fast jede Ausgabe zu generieren. Testen Sie Prompts in Vertex AI mit Gemini mit Text, Bildern, Video oder Code. Mit der fortschrittlichen Logik und den hochmodernen Funktionen von Gemini können Entwickler Beispiel-Prompts ausprobieren, um Text aus Bildern zu extrahieren, Bildtext in JSON zu konvertieren und sogar Antworten zu hochgeladenen Bildern zu generieren, um KI-Anwendungen der nächsten Generation zu entwickeln.

Was sind die Anwendungsfälle für Large Language Models?

Textgesteuerte LLMs werden für eine Vielzahl von Natural Language Processing-Aufgaben verwendet, einschließlich Textgenerierung, maschinelle Übersetzung, Textzusammenfassung, Beantwortung von Fragen und Erstellung von Chatbots, die Unterhaltungen mit Menschen führen können.

LLMs können auch mit anderen Datentypen trainiert werden, darunter Code, Bilder, Audio, Video und mehr. Veo, Imagen und Chirp von Google AI sind Beispiele für solche Modelle, die neue Anwendungen und Lösungen für die größten Herausforderungen der Welt hervorbringen.

Was sind die Vorteile von Large Language Models?

Welche Large-Language-Modelldienste bietet Google Cloud?

Generative AI in Vertex AI: Sie erhalten Zugriff auf die großen generativen KI-Modelle von Google, sodass Sie sie testen, optimieren und für die Verwendung in Ihren KI-gestützten Anwendungen bereitstellen können.

Vertex AI Agent Builder: Entwickler können Agents mit einem offenen Ansatz erstellen und sie mit Steuerelementen für Unternehmen bereitstellen.

Customer Engagement Suite mit Google AI: Intelligente Contact Center-Lösung mit Dialogflow, unserer dialogorientierten KI-Plattform mit Intent- und LLM-Funktionen.

Funktionsweise

LLMs verwenden eine große Menge an Textdaten, um ein neuronales Netzwerk zu trainieren. Dieses neuronale Netzwerk wird dann verwendet, um Text zu generieren, zu übersetzen oder andere Aufgaben auszuführen. Je mehr Daten zum Trainieren des neuronalen Netzwerks verwendet werden, desto besser und genauer kann es seine Aufgabe ausführen.

Google Cloud hat Produkte auf Basis seiner LLM-Technologien entwickelt, die auf eine Vielzahl von Anwendungsfällen ausgelegt sind, die Sie im Abschnitt „Häufige Anwendungsfälle“ unten untersuchen können.

LLMs verwenden eine große Menge an Textdaten, um ein neuronales Netzwerk zu trainieren. Dieses neuronale Netzwerk wird dann verwendet, um Text zu generieren, zu übersetzen oder andere Aufgaben auszuführen. Je mehr Daten zum Trainieren des neuronalen Netzwerks verwendet werden, desto besser und genauer kann es seine Aufgabe ausführen.

Google Cloud hat Produkte auf Basis seiner LLM-Technologien entwickelt, die auf eine Vielzahl von Anwendungsfällen ausgelegt sind, die Sie im Abschnitt „Häufige Anwendungsfälle“ unten untersuchen können.

Gängige Einsatzmöglichkeiten

Chatbot erstellen

LLM-gestützten Chatbot erstellen

Vertex AI Agents ermöglicht die Erstellung natürlich klingender, menschenähnlicher Chatbots. Der Generative AI-Agent ist eine Funktion in Vertex AI Agents, die auf den Funktionen von Dialogflow CX basiert.

Mit dieser Funktion können Sie eine Website-URL und/oder eine beliebige Anzahl von Dokumenten angeben. Der Generative AI-Agent parst dann die Inhalte und erstellt einen virtuellen Agenten, der auf Datenspeichern und LLMs basiert.

Anleitungen

LLM-gestützten Chatbot erstellen

Vertex AI Agents ermöglicht die Erstellung natürlich klingender, menschenähnlicher Chatbots. Der Generative AI-Agent ist eine Funktion in Vertex AI Agents, die auf den Funktionen von Dialogflow CX basiert.

Mit dieser Funktion können Sie eine Website-URL und/oder eine beliebige Anzahl von Dokumenten angeben. Der Generative AI-Agent parst dann die Inhalte und erstellt einen virtuellen Agenten, der auf Datenspeichern und LLMs basiert.

Recherche und Informationssuche

Komplexe Informationen in wenigen Augenblicken finden und zusammenfassen

Extrahieren Sie wertvolle Informationen aus komplexen Dokumenten und lassen Sie diese mit nur einem Klick zusammenfassen. Mögliche Quellelemente sind 10-K-Formularen, Forschungsarbeiten, Nachrichtendienste Dritter und Finanzberichten. Sehen Sie sich in der Demo auf der rechten Seite an, wie Vertex AI Search mit natürlicher Sprache semantische Suchanfragen versteht, zusammengefasste Antworten bietet und Anschlussfragen stellt.

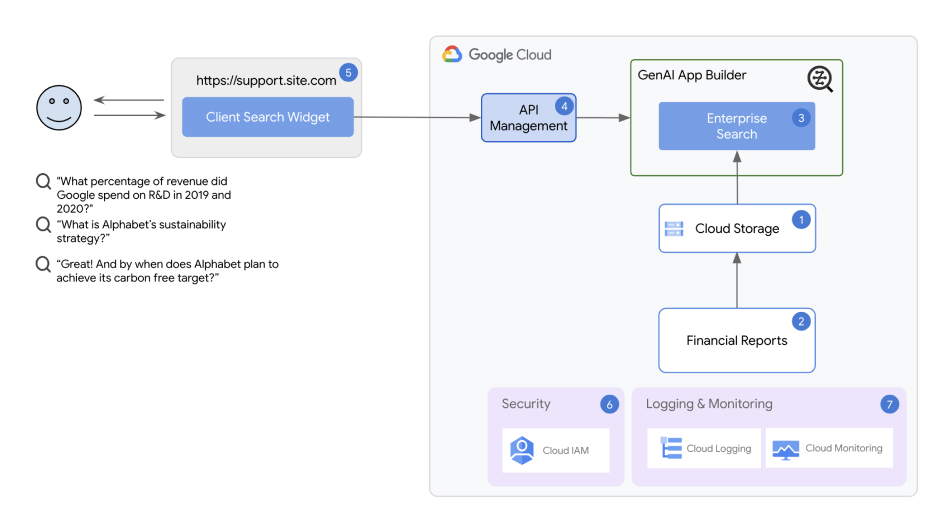

Architektur der Lösung zur Forschung und Informationssuche

Die Lösung verwendet Vertex AI Agent Builder als Kernkomponente. Mit Vertex AI Agent Builder können selbst Entwicklungsteams in der Anfangsphase in wenigen Minuten Chatbots und Suchanwendungen erstellen und bereitstellen.

Anleitungen

Komplexe Informationen in wenigen Augenblicken finden und zusammenfassen

Extrahieren Sie wertvolle Informationen aus komplexen Dokumenten und lassen Sie diese mit nur einem Klick zusammenfassen. Mögliche Quellelemente sind 10-K-Formularen, Forschungsarbeiten, Nachrichtendienste Dritter und Finanzberichten. Sehen Sie sich in der Demo auf der rechten Seite an, wie Vertex AI Search mit natürlicher Sprache semantische Suchanfragen versteht, zusammengefasste Antworten bietet und Anschlussfragen stellt.

Weitere Ressourcen

Architektur der Lösung zur Forschung und Informationssuche

Die Lösung verwendet Vertex AI Agent Builder als Kernkomponente. Mit Vertex AI Agent Builder können selbst Entwicklungsteams in der Anfangsphase in wenigen Minuten Chatbots und Suchanwendungen erstellen und bereitstellen.

Dokumentzusammenfassung

Große Dokumente mit Vertex AI LLMs verarbeiten und zusammenfassen

Stellen Sie mit Generative AI Document Summarization eine Ein-Klick-Lösung bereit, die Text in RAW-Dateien erkennt und Dokumentzusammenfassungen automatisiert. Die Lösung erstellt eine Pipeline, die die optische Zeichenerkennung (OCR) von Cloud Vision verwendet, um Text aus hochgeladenen PDF-Dokumenten in Cloud Storage zu extrahieren, mit Vertex AI Generative AI Studio eine Zusammenfassung aus dem extrahierten Text zu erstellen und die durchsuchbare Zusammenfassung in einer BigQuery-Datenbank zu speichern.

Anleitungen

Große Dokumente mit Vertex AI LLMs verarbeiten und zusammenfassen

Stellen Sie mit Generative AI Document Summarization eine Ein-Klick-Lösung bereit, die Text in RAW-Dateien erkennt und Dokumentzusammenfassungen automatisiert. Die Lösung erstellt eine Pipeline, die die optische Zeichenerkennung (OCR) von Cloud Vision verwendet, um Text aus hochgeladenen PDF-Dokumenten in Cloud Storage zu extrahieren, mit Vertex AI Generative AI Studio eine Zusammenfassung aus dem extrahierten Text zu erstellen und die durchsuchbare Zusammenfassung in einer BigQuery-Datenbank zu speichern.

AI-gestütztes Contact Center aufbauen

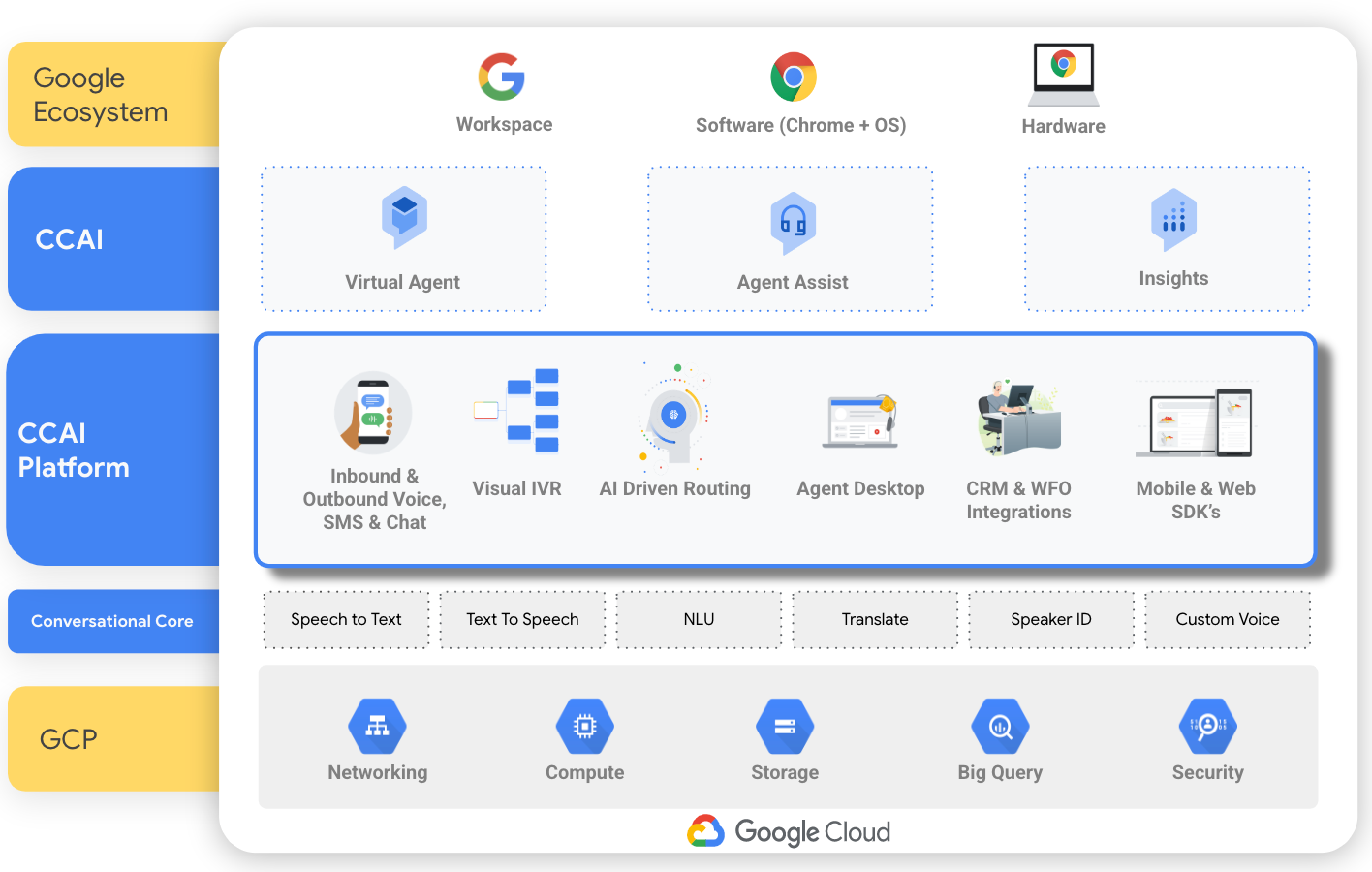

Mit CCAI ein KI-gestütztes Contact Center erstellen

Customer Engagement Suite mit Google AI basiert auf KI-Technologien wie Natural Language Processing, Machine Learning sowie Text- und Spracherkennung und bietet eine CCaaS-Lösung (Contact Center as a Service), mit der ein neues Contact Center von Grund auf aufgebaut werden kann. Es verfügt auch über individuelle Tools, die auf bestimmte Aspekte eines Contact Centers ausgerichtet sind, z. B. Konversations-Agents (Dialogflow) zum Erstellen eines Chatbots, Agent Assist für Kontakt zu Kundenservicepersonal in Echtzeit und Dialogorientierte Insights zur Ermittlung von Gesprächsmotiven und Stimmung.

Anleitungen

Mit CCAI ein KI-gestütztes Contact Center erstellen

Customer Engagement Suite mit Google AI basiert auf KI-Technologien wie Natural Language Processing, Machine Learning sowie Text- und Spracherkennung und bietet eine CCaaS-Lösung (Contact Center as a Service), mit der ein neues Contact Center von Grund auf aufgebaut werden kann. Es verfügt auch über individuelle Tools, die auf bestimmte Aspekte eines Contact Centers ausgerichtet sind, z. B. Konversations-Agents (Dialogflow) zum Erstellen eines Chatbots, Agent Assist für Kontakt zu Kundenservicepersonal in Echtzeit und Dialogorientierte Insights zur Ermittlung von Gesprächsmotiven und Stimmung.