Google Kubernetes Engine (GKE)

Kubernetes weiterentwickelt: Die Grundlage für Plattformentwickler

Stellen Sie Ihre Container auf Autopilot und führen Sie Ihre Unternehmensarbeitslasten sicher und ohne operative Kubernetes-Kenntnisse aus.

Sie erhalten einen zonalen oder Autopilot-Cluster pro Monat kostenlos. Neukunden erhalten außerdem ein Guthaben von 300 $, um GKE auszuprobieren.

Features

Vereinfachte Clusterverwaltung und verbesserte Ressourceneffizienz

Im Betriebsmodus GKE Autopilot verwaltet Google Ihre Knoteninfrastruktur, Skalierung, Sicherheit und vorkonfigurierten Funktionen. Dank der automatischen Anpassung der Kapazität und der Abrechnung pro Pod können Sie Überbereitstellung, überhöhte Kosten und Unterauslastung vermeiden. Mit der containeroptimierten Computing-Plattform von Autopilot erhalten Sie eine nahezu in Echtzeit vertikal und horizontal skalierbare Computing-Lösung, die die benötigte Kapazität zum besten Preis-Leistungs-Verhältnis bereitstellt.

Produktionsreife Plattform für agentenbasierte KI-Arbeitslasten und generative KI-Modelle

Mit Unterstützung für bis zu 65.000-Knoten-Cluster, Integration mit AI Hypercomputer und GPU- und TPU-Unterstützung erleichtert GKE die Ausführung von ML-, HPC- und anderen Arbeitslasten, die von speziellen Hardwarebeschleunigern profitieren.

Die GKE-Inferenzfunktionen mit Skalierung und Load Balancing-Techniken, die generative KI berücksichtigen, tragen dazu bei, die Bereitstellungskosten um über 30 % und die Tail-Latenz um 60 % zu senken und den Durchsatz im Vergleich zu anderen verwalteten und Open-Source-Kubernetes-Angeboten um bis zu 40 % zu steigern.

Von Grund auf sicher

GKE bietet Sicherheit in großem Maßstab mit integrierten Best Practice, konformer Infrastruktur und Echtzeit-Benachrichtigungen. So können Sie Sicherheitsbedrohungen und Compliance-Probleme schnell und effizient in einer einheitlichen Ansicht beheben.

GKE wird von einem Google-Sicherheitsteam aus mehr als 750 Fachleuten betreut. Die integrierten Sicherheitsfunktionen umfassen Patching und Härtung, Isolation und Segmentierung, Confidential GKE Nodes, Identitäts- und Zugriffsverwaltung sowie Integrationen mit Cloud Logging und Cloud Monitoring.

Und mit GKE Sandbox können Sie eine zweite Schutzschicht zwischen containerisierten Arbeitslasten in GKE für eine optimierte Arbeitslastsicherheit hinzufügen.

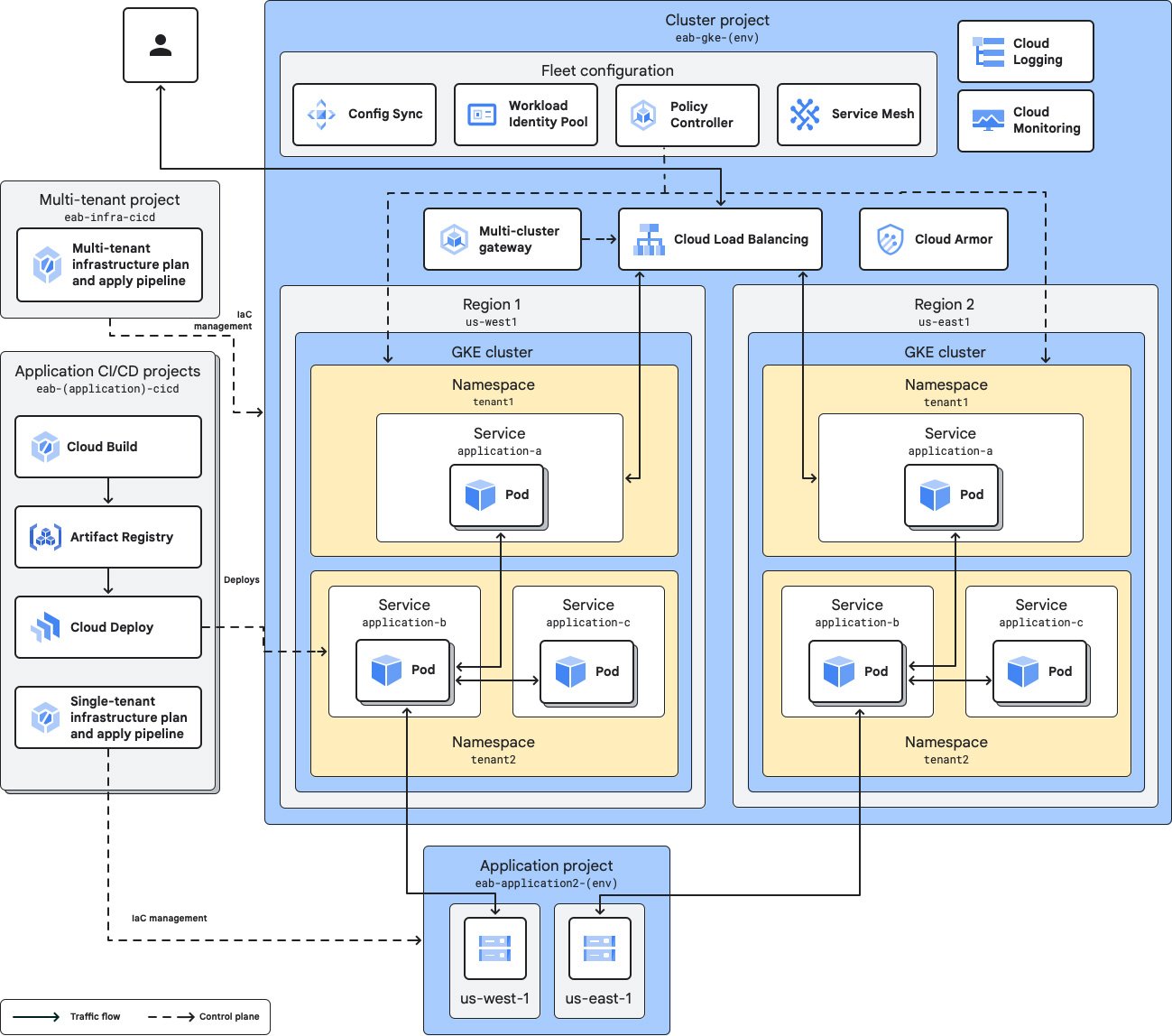

Verwaltung mehrerer Teams und Cluster

Mit Flotten und Teams können Sie Cluster und Arbeitslasten organisieren und Ressourcen mühelos mehreren Teams zuweisen, um die Geschwindigkeit zu verbessern und die Inhaberschaft zu delegieren. Mit Teambereichen können Sie Teilmengen von Flottenressourcen auf Teambasis definieren, wobei jeder Bereich einem oder mehreren Clustern der Flottenmitglieder zugeordnet ist.

Sie können mehrere Cluster auswählen, um Dienste nach Umgebungen, Stufen, Sprachen, Teams oder Infrastrukturanbietern zu trennen. Flotten sollen die Verwaltung mehrerer Cluster so einfach wie möglich machen.

Arbeitslastenübertragung mit Multi-Cloud-Unterstützung

GKE führt Certified Kubernetes aus und unterstützt offene Standards, sodass Kunden ihre Anwendungen unverändert auf vorhandener lokaler Hardware oder in der öffentlichen Cloud ausführen können.

Mit GKE-angehängten Clustern können Sie jeden konformen Kubernetes-Cluster, den Sie selbst erstellt haben, in der GKE-Verwaltungsumgebung registrieren oder anhängen. Durch das Anhängen eines Clusters erhalten Sie GKE-Verwaltung und ‑Steuerung sowie Zugriff auf zusätzliche Funktionen wie Config Sync, Cloud Service Mesh und Flotten.

Funktionsweise

In jedem GKE-Cluster verwaltet GKE den Lebenszyklus der Kubernetes-Steuerungsebene von der Clustererstellung bis zum Löschen. Wenn Autopilot aktiviert ist, kann GKE auch Ihre Knoten verwalten, einschließlich automatisierter Bereitstellung, Skalierung und Planung. Sie können aber auch die Knoten selbst verwalten und so mehr Kontrolle haben.

In jedem GKE-Cluster verwaltet GKE den Lebenszyklus der Kubernetes-Steuerungsebene von der Clustererstellung bis zum Löschen. Wenn Autopilot aktiviert ist, kann GKE auch Ihre Knoten verwalten, einschließlich automatisierter Bereitstellung, Skalierung und Planung. Sie können aber auch die Knoten selbst verwalten und so mehr Kontrolle haben.

Gängige Einsatzmöglichkeiten

Plattformen für alle Ihre Arbeitslasten erstellen

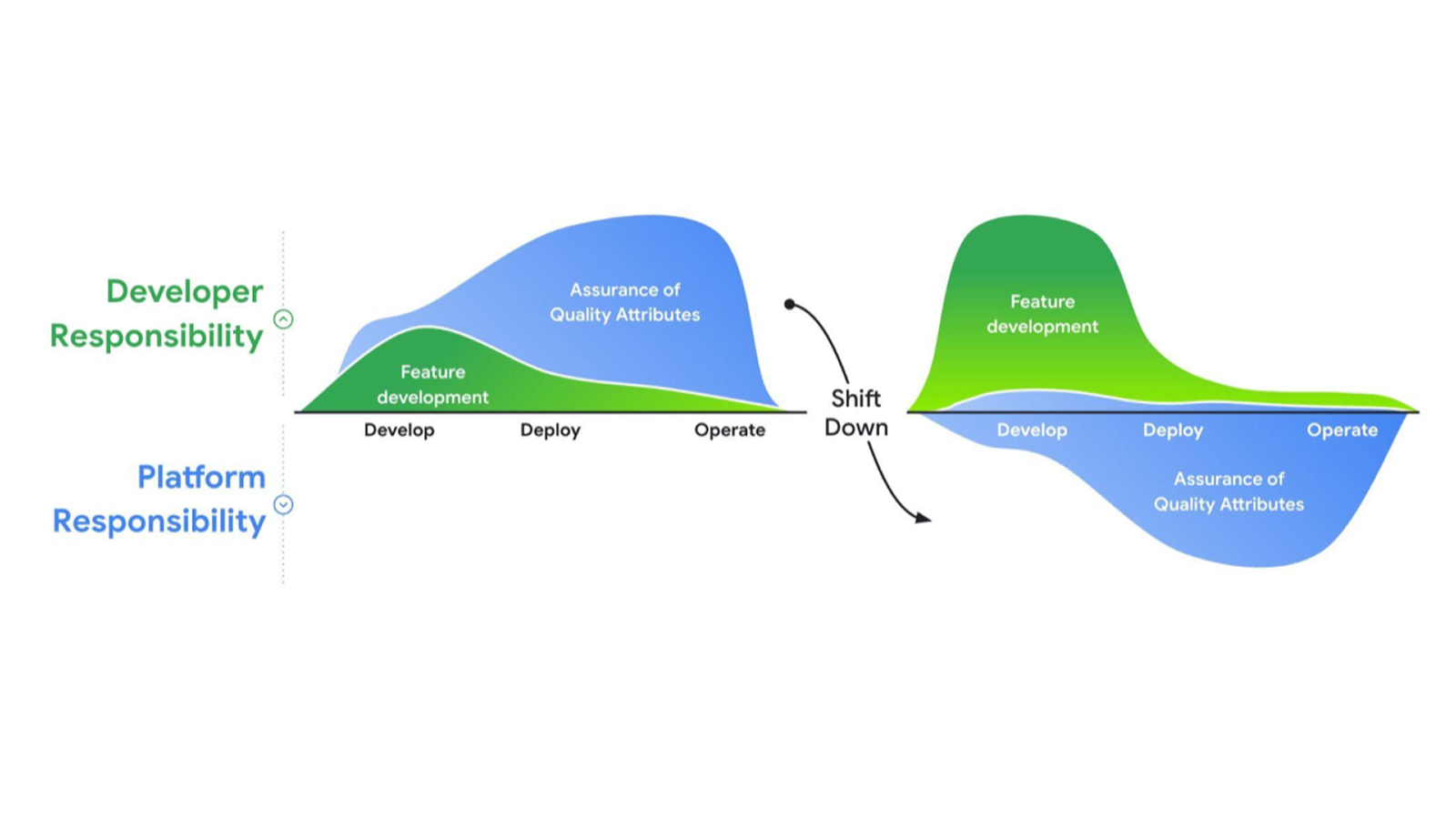

Entwicklerplattform für Unternehmen erstellen, um Apps schnell und zuverlässig bereitzustellen

Entwicklerplattform für Unternehmen erstellen, um Apps schnell und zuverlässig bereitzustellen

Google Cloud bietet eine umfassende Suite verwalteter Dienste und Laufzeiten, die als Bausteine für Ihre Plattform dienen. So finden Sie die richtige Kombination von Diensten für Ihre Anwendungsfälle. Die enge Einbindung von GKE in die Google Cloud-Umgebung, die unübertroffene Skalierbarkeit und die integrierten Sicherheitsfunktionen machen es zu einer idealen Grundlage für Ihre Plattform.

Was ist Platform Engineering?

Tutorials, Kurzanleitungen und Labs

Entwicklerplattform für Unternehmen erstellen, um Apps schnell und zuverlässig bereitzustellen

Entwicklerplattform für Unternehmen erstellen, um Apps schnell und zuverlässig bereitzustellen

Google Cloud bietet eine umfassende Suite verwalteter Dienste und Laufzeiten, die als Bausteine für Ihre Plattform dienen. So finden Sie die richtige Kombination von Diensten für Ihre Anwendungsfälle. Die enge Einbindung von GKE in die Google Cloud-Umgebung, die unübertroffene Skalierbarkeit und die integrierten Sicherheitsfunktionen machen es zu einer idealen Grundlage für Ihre Plattform.

Lernressourcen

Was ist Platform Engineering?

Generative KI-Modelle trainieren, bereitstellen und skalieren

Inferenz mit generativer KI mit GKE bereitstellen

Inferenz mit generativer KI mit GKE bereitstellen

GKE bietet nicht nur eine Plattform für KI, sondern vereinfacht und automatisiert auch Kubernetes-Vorgänge mit KI. Dank Unterstützung für bis zu 65.000 Knoten und der Integration in AI Hypercomputer können Sie Ihre größten Modelle für generative KI in der GKE trainieren und skalieren.

Außerdem bieten die auf generativer KI basierenden Inferenzfunktionen von GKE bis zu 30 % niedrigere Bereitstellungskosten, 60 % niedrigere Tail-Latenz und 40 % höheren Durchsatz als OSS K8s.

Tutorials, Kurzanleitungen und Labs

Inferenz mit generativer KI mit GKE bereitstellen

Inferenz mit generativer KI mit GKE bereitstellen

GKE bietet nicht nur eine Plattform für KI, sondern vereinfacht und automatisiert auch Kubernetes-Vorgänge mit KI. Dank Unterstützung für bis zu 65.000 Knoten und der Integration in AI Hypercomputer können Sie Ihre größten Modelle für generative KI in der GKE trainieren und skalieren.

Außerdem bieten die auf generativer KI basierenden Inferenzfunktionen von GKE bis zu 30 % niedrigere Bereitstellungskosten, 60 % niedrigere Tail-Latenz und 40 % höheren Durchsatz als OSS K8s.

Orchestrierung mehrerer Agenten

Multi-Agent-Anwendungen bereitstellen und orchestrieren

Multi-Agent-Anwendungen bereitstellen und orchestrieren

Bei der agentischen KI geht es um die Orchestrierung und Ausführung von Agenten, die LLMs als „Gehirn“ verwenden, um Aktionen über Tools auszuführen.

GKE ist die ultimative offene Plattform zur Unterstützung von Agenten und zur Orchestrierung Ihrer Rechenleistung, damit Sie die nächste Generation von agentischen KI-Arbeitslasten nutzen können.

Tutorials, Kurzanleitungen und Labs

Multi-Agent-Anwendungen bereitstellen und orchestrieren

Multi-Agent-Anwendungen bereitstellen und orchestrieren

Bei der agentischen KI geht es um die Orchestrierung und Ausführung von Agenten, die LLMs als „Gehirn“ verwenden, um Aktionen über Tools auszuführen.

GKE ist die ultimative offene Plattform zur Unterstützung von Agenten und zur Orchestrierung Ihrer Rechenleistung, damit Sie die nächste Generation von agentischen KI-Arbeitslasten nutzen können.

Preise

| GKE-Preisgestaltung | Nachdem das Guthaben aufgebraucht wurde, richten sich die Gesamtkosten nach dem Clusterbetriebsmodus, den Clusterverwaltungsgebühren und den anfallenden Gebühren für die eingehende Datenübertragung. | |

|---|---|---|

| Dienst | Beschreibung | Preis ($) |

Kostenlose Stufe | Die kostenlose GKE-Stufe umfasst ein monatliches Guthaben von 74,40 $ pro Rechnungskonto, das auf zonale und Autopilot-Cluster angewendet wird. | Kostenlos |

Clusterverwaltungsgebühr | Bietet eine vollständig automatisierte Verwaltung des Clusterlebenszyklus, Pod- und Cluster-Autoscaling, Kostentransparenz, automatisierte Optimierung der Infrastrukturkosten und Funktionen für die Verwaltung mehrerer Cluster – ohne Aufpreis. | 0,10 $ pro Cluster und Stunde |

Compute | Im Autopilot-Modus zahlen Sie nur für die CPU-, Arbeitsspeicher- und Rechenressourcen, die für Ihre Pods bereitgestellt werden. Bei Knotenpools und Compute-Klassen, die nicht Autopilot verwenden, werden Ihnen die zugrunde liegenden Compute Engine-Instanzen der Knoten in Rechnung gestellt, bis die Knoten gelöscht werden. | Siehe Compute Engine-Preise |

Mehr zu den Preisen von GKE: Vollständige Preisinformationen

GKE-Preisgestaltung

Nachdem das Guthaben aufgebraucht wurde, richten sich die Gesamtkosten nach dem Clusterbetriebsmodus, den Clusterverwaltungsgebühren und den anfallenden Gebühren für die eingehende Datenübertragung.

Die kostenlose GKE-Stufe umfasst ein monatliches Guthaben von 74,40 $ pro Rechnungskonto, das auf zonale und Autopilot-Cluster angewendet wird.

Kostenlos

Clusterverwaltungsgebühr

Bietet eine vollständig automatisierte Verwaltung des Clusterlebenszyklus, Pod- und Cluster-Autoscaling, Kostentransparenz, automatisierte Optimierung der Infrastrukturkosten und Funktionen für die Verwaltung mehrerer Cluster – ohne Aufpreis.

0,10 $

pro Cluster und Stunde

Im Autopilot-Modus zahlen Sie nur für die CPU-, Arbeitsspeicher- und Rechenressourcen, die für Ihre Pods bereitgestellt werden.

Bei Knotenpools und Compute-Klassen, die nicht Autopilot verwenden, werden Ihnen die zugrunde liegenden Compute Engine-Instanzen der Knoten in Rechnung gestellt, bis die Knoten gelöscht werden.

Siehe Compute Engine-Preise

Mehr zu den Preisen von GKE: Vollständige Preisinformationen

Anwendungsszenario

Von GKE-Kunden lernen

Seit 10 Jahren erfolgreich: Warum Signify auf GKE setzt

Mit GKE als Grundlage konnte die Philips Hue-Plattform ihre Infrastruktur so skalieren, dass sie in den letzten zehn Jahren einen Anstieg der Transaktionen und Befehle um 1.150 % bewältigen konnte.

KI-Innovationen mit der GKE nutzen

Der KI-basierte Werbeanbieter Moloco erzielt mit TPUs in GKE 10-mal schnellere Modelltrainingszeiten.

Mit TPUs in GKE reduziert HubX die Latenz um bis zu 66 %, was zu einer besseren Nutzererfahrung und höheren Conversion-Raten führt.

LiveX AI erzielt mit GKE Autopilot über 50 % niedrigere Gesamtkosten, 25 % schnellere Markteinführungszeit und 66 % niedrigere Betriebskosten.