このドキュメントでは、課金対象である次の Google Cloudコンポーネントを使用します。

- Dataproc

- Compute Engine

- Cloud Scheduler

料金計算ツールを使うと、予想使用量に基づいて費用の見積もりを生成できます。

始める前に

プロジェクトを設定する

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Scheduler APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

-

gcloud CLI を初期化するには、次のコマンドを実行します。

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Scheduler APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

-

gcloud CLI を初期化するには、次のコマンドを実行します。

gcloud init - Google Cloud コンソールで [IAM と管理] → [ロール] ページを開きます。

- [ロールを作成] をクリックして [ロールの作成] ページを開きます。

- [タイトル]、[説明]、[ID]、[ロールのリリース段階] の各項目を入力します。提案: ロールのタイトルとして「Dataproc ワークフロー テンプレートの作成」を使用します。

- [権限の追加] をクリックします。

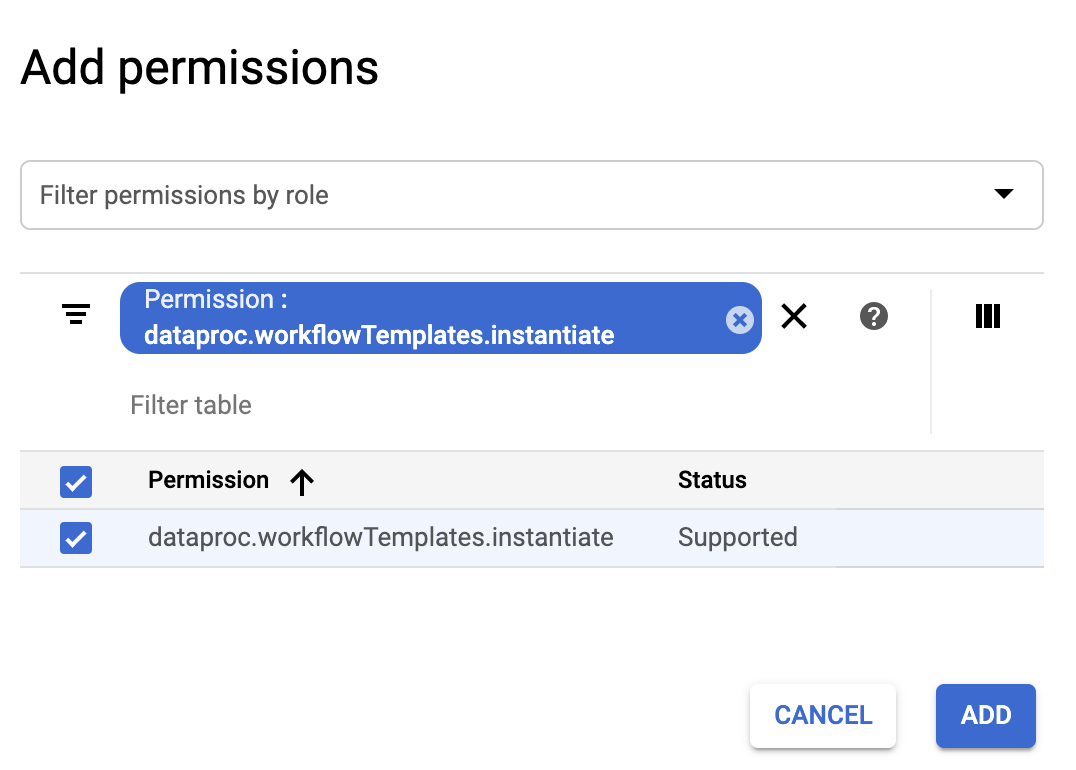

- [権限の追加] フォームで [フィルタ] をクリックし、[権限] を選択します。フィルタを入力して [権限: dataproc.workflowTemplates.instantiate] を読み取ります。

- 一覧表示されている権限の左側にあるチェックボックスをオンにして、[追加] をクリックします。

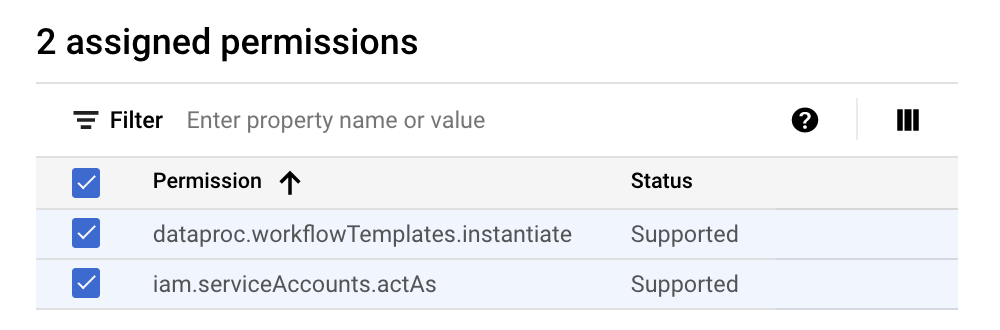

- [ロールの作成] ページで、再度 [権限の追加] をクリックし、前の追加手順を繰り返して iam.serviceAccounts.actAs 権限をカスタムロールに追加します。[ロールの作成] ページに 2 つの権限が表示されるようになりました。

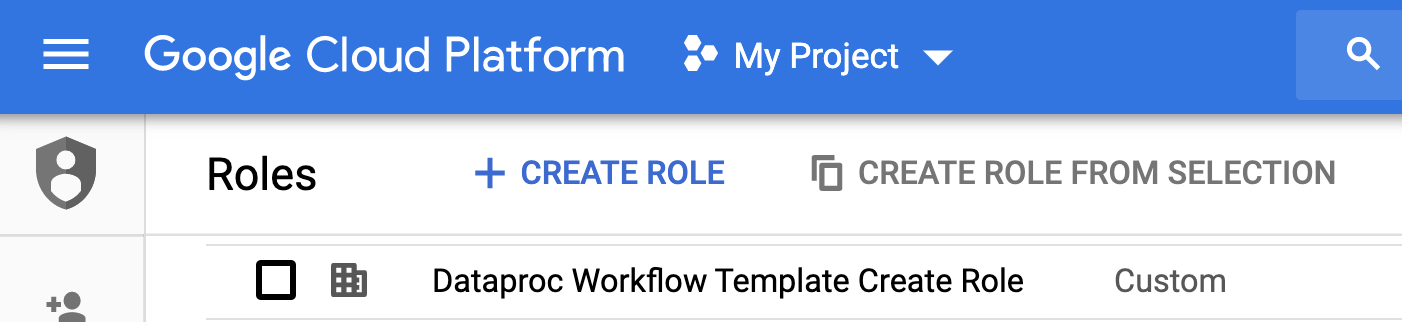

- [ロールの作成] ページで [作成] をクリックします。カスタムロールが [ロール] ページに表示されます。

Google Cloud コンソールで、[サービス アカウント] ページに移動します。

プロジェクトを選択します。

[ サービス アカウントを作成] をクリックします。

[サービス アカウント名] フィールドに

workflow-schedulerという名前を入力します。 Google Cloud コンソールでは、この名前に基づいて [サービス アカウント ID] フィールドの値が設定されます。省略可: [サービス アカウントの説明] フィールドに、サービス アカウントの説明を入力します。

[作成して続行] をクリックします。

[ロールを選択] フィールドをクリックし、前の手順で作成した Dataproc ワークフロー テンプレートの作成カスタムロールを選択します。

[続行] をクリックします。

[サービス アカウント管理者ロール] フィールドに、Google アカウントのメールアドレスを入力します。

[完了] をクリックして、サービス アカウントの作成を完了します。

- このコマンドでは、「us-central1」リージョンを指定しています。以前に

gcloud config set compute/regionを実行してリージョン プロパティを設定した場合は、別のリージョンを指定するか、--regionフラグを削除できます。 add-jobコマンドの「-- 」(ダッシュ ダッシュ スペース)の並びにより、1000引数が SparkPi ジョブに渡されます。この引数は、円周率の値を推定するために使用するサンプルの数を指定するものです。- ワークフロー テンプレートを作成します。

gcloud dataproc workflow-templates create sparkpi \ --region=us-central1

- Spark ジョブを Sparkpi ワークフロー テンプレートに追加します。step-id の「compute」は必須で、追加された SparkPi ジョブを識別します。

gcloud dataproc workflow-templates add-job spark \ --workflow-template=sparkpi \ --step-id=compute \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ --region=us-central1 \ -- 1000

- ワークフローを実行するには、マネージドの単一ノードクラスタを使用します。Dataproc によってクラスタが作成され、ワークフローがクラスタ上で実行され、ワークフローの完了時にクラスタが削除されます。

gcloud dataproc workflow-templates set-managed-cluster sparkpi \ --cluster-name=sparkpi \ --single-node \ --region=us-central1

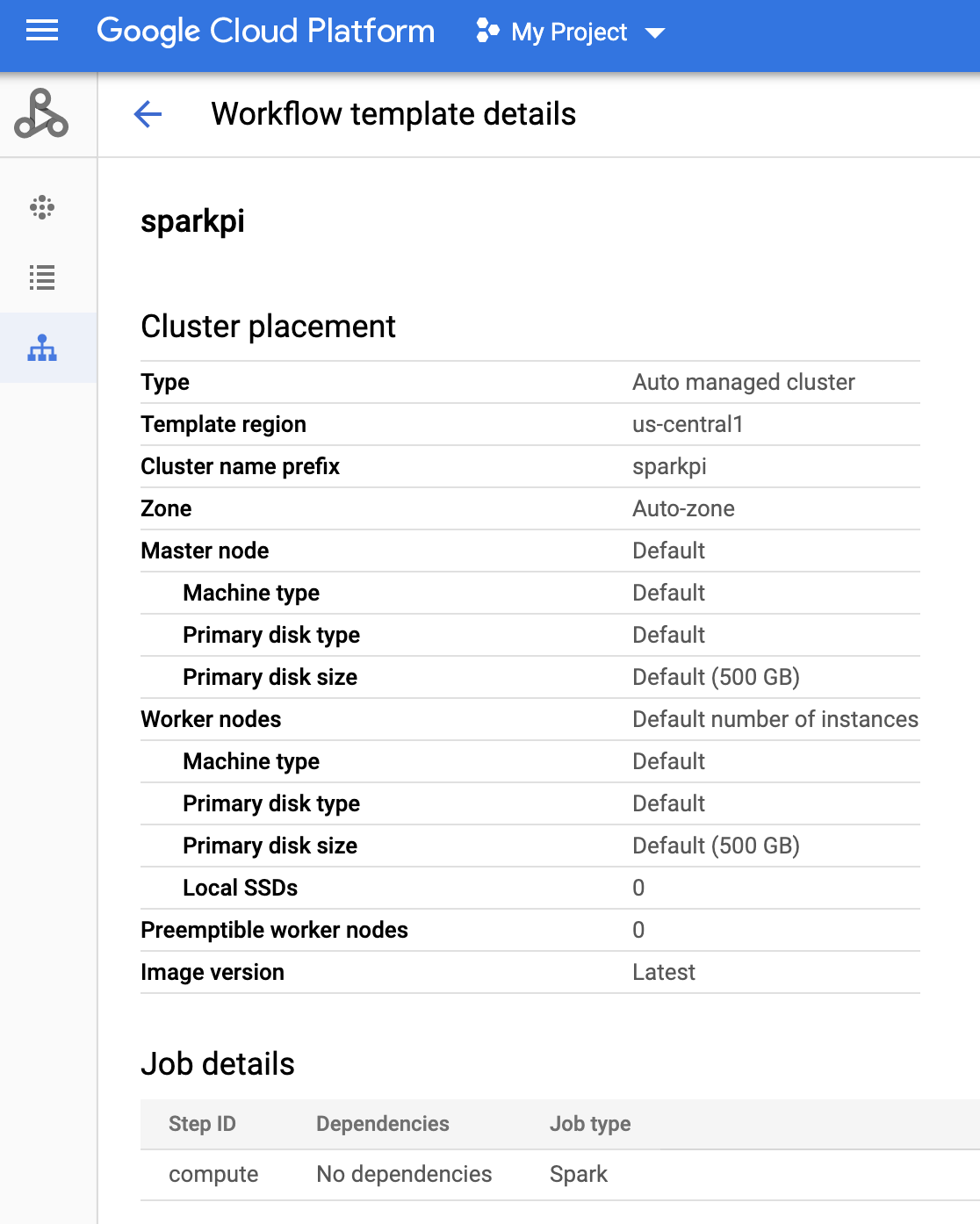

- Google Cloud コンソールの Dataproc の [ワークフロー] ページで名前

sparkpiをクリックし、[ワークフロー テンプレートの詳細] ページを開きます。sparkpi テンプレートの各属性を確認します。

Google Cloud コンソールで Cloud Scheduler ページを開きます(ページを開くには、プロジェクトの選択が必要な場合があります)。[ジョブを作成] をクリックします。

次のジョブ情報を入力または選択します。

- リージョンを選択: 「us-central」など、ワークフロー テンプレートを作成したリージョン。

- 名前: 「sparkpi」

- 頻度: 「* * * * *」は毎分、「0 9 * * 1」は毎週月曜日の午前 9 時を意味します。Unix の他の cron 値については、ジョブ スケジュールの定義をご覧ください。注: Google Cloud コンソールで、Cloud Scheduler の [ジョブ] にある [今すぐ実行] ボタンをクリックすると、設定したジョブを実行する頻度に関係なく、ジョブを実行してテストできます。

- タイムゾーン: timezone を選択します。「アメリカ合衆国」と入力すると、米国のタイムゾーンが表示されます。

- ターゲット: 「HTTP」

- URL: your-project-id を挿入してから、以下の URL を挿入します。ワークフロー テンプレートを別のリージョンに作成した場合は、「us-central1」を置き換えます。この URL は、Dataproc の

workflowTemplates.instantiateAPI を呼び出して、sparkpi ワークフロー テンプレートを実行します。https://dataproc.googleapis.com/v1/projects/your-project-id/regions/us-central1/workflowTemplates/sparkpi:instantiate?alt=json

- HTTP メソッド:

- 「POST」

- 本文: 「{}」

- Auth ヘッダー:

- 「Add OAuth token」

- サービス アカウント: このチュートリアルで作成したサービス アカウントの service account address を挿入します。your-project-id を変えて次のアカウント アドレスを使用できます。

workflow-scheduler@your-project-id.iam.gserviceaccount.com

- 範囲: この項目は無視できます。

- [作成] をクリックします。

Cloud Scheduler の [ジョブ] ページの

sparkpiジョブの行で、[今すぐ実行] をクリックします。数分待った後、Dataproc の [ワークフロー] ページを開いて、sparkpi ワークフローが完了したことを確認します。

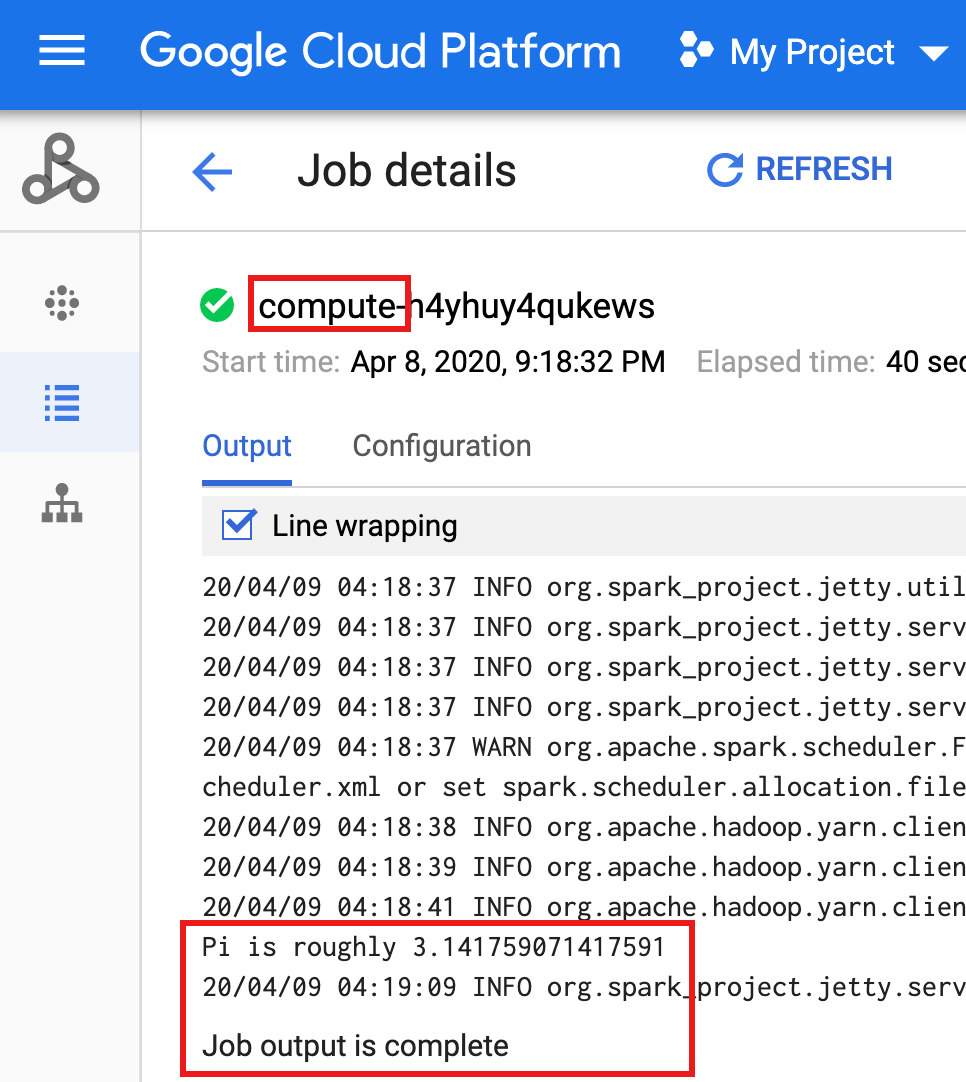

ワークフローがマネージド クラスタを削除すると、 Google Cloud コンソールにジョブの詳細が表示されます。Dataproc の [ジョブ] ページに表示されている

compute...ジョブをクリックして、ワークフロー ジョブの詳細を表示します。

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

カスタムロールを作成する

サービス アカウントを作成する

ワークフロー テンプレートを作成する

ローカル ターミナル ウィンドウまたは Cloud Shell で以下に表示されているコマンドをコピーして実行し、ワークフロー テンプレートを作成して定義します。

注:

Cloud Scheduler ジョブを作成する

スケジュールされたワークフロー ジョブをテストする

クリーンアップ

このチュートリアルのワークフローでは、ワークフローが完了するとマネージド クラスタが削除されます。ワークフローを維持すると、ワークフローを再実行できます。料金は発生しません。このチュートリアルで作成した他のリソースを削除して、繰り返しコストが発生しないようにすることが可能です。

プロジェクトを削除する

ワークフロー テンプレートを削除する

gcloud dataproc workflow-templates delete sparkpi \ --region=us-central1

Cloud Scheduler ジョブを削除する

Google Cloud コンソールで Cloud Scheduler の [ジョブ] ページを開き、sparkpi 関数の左側にあるボックスをオンにして、[削除] をクリックします。

サービス アカウントを削除する

Google Cloud コンソールで [IAM と管理] → [サービス アカウント] ページを開き、workflow-scheduler... サービス アカウントの左側にあるボックスを選択して、[削除] をクリックします。