En este documento, usarás los siguientes componentes facturables de Google Cloud:

- Dataproc

- Compute Engine

- Cloud Composer

Para generar una estimación de costos en función del uso previsto, usa la calculadora de precios.

Antes de comenzar

Configura tu proyecto

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

-

Para inicializar gcloud CLI, ejecuta el siguiente comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

-

Para inicializar gcloud CLI, ejecuta el siguiente comando:

gcloud init - Crea la plantilla de flujo de trabajo

sparkpi.gcloud dataproc workflow-templates create sparkpi \ --region=us-central1 - Agrega el trabajo de Spark a la plantilla de flujo de trabajo.

sparkpiLa marcastep-idde “compute” identifica el trabajo de SparkPi.gcloud dataproc workflow-templates add-job spark \ --workflow-template=sparkpi \ --step-id=compute \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ --region=us-central1 \ -- 1000 - Usa un clúster administrado y de un solo nodo para ejecutar el flujo de trabajo. Dataproc creará el clúster, ejecutará el flujo de trabajo en él y, luego, borrará el clúster cuando este se complete.

gcloud dataproc workflow-templates set-managed-cluster sparkpi \ --cluster-name=sparkpi \ --single-node \ --region=us-central1 - Confirma la creación de la plantilla de flujo de trabajo.

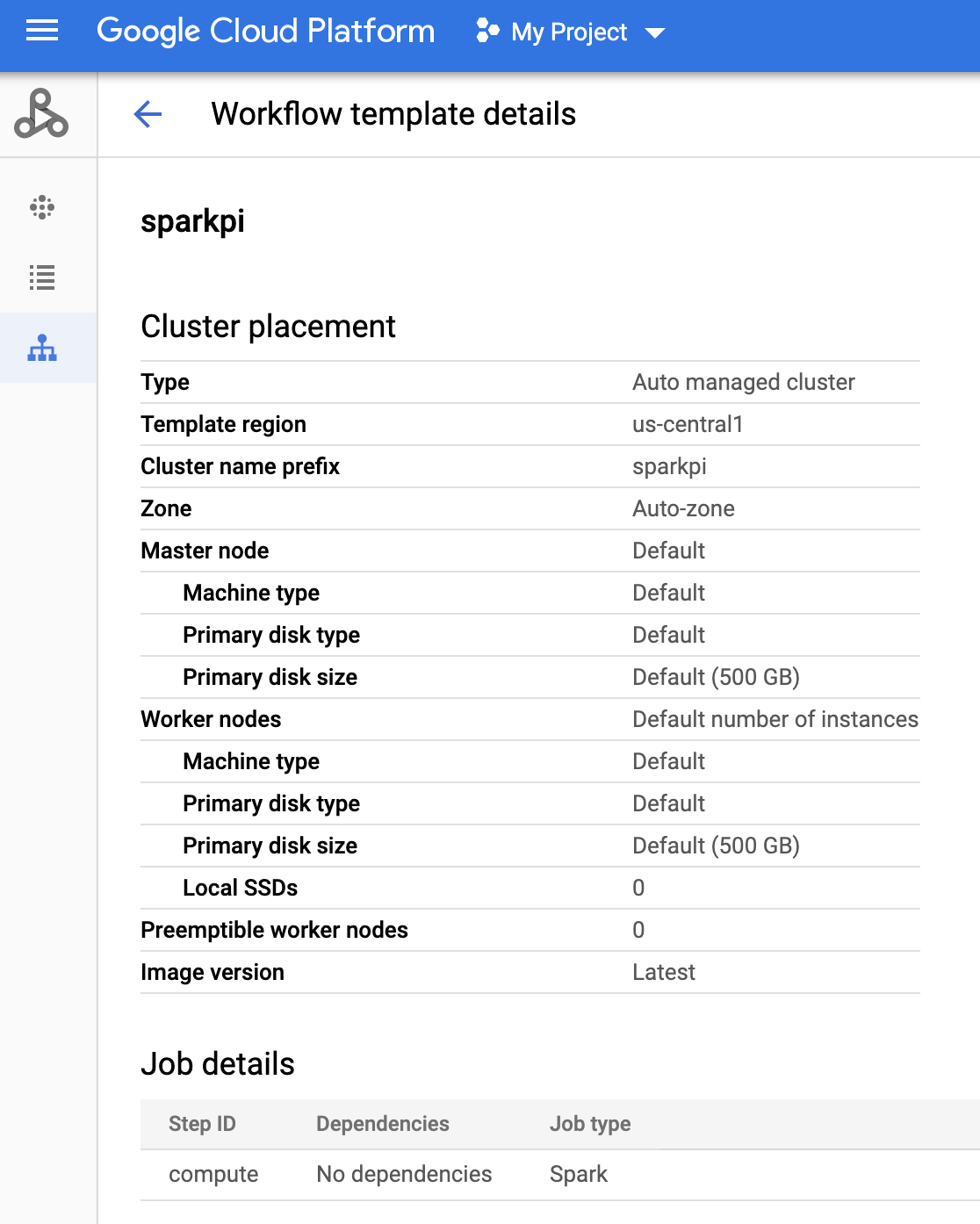

Console

Haz clic en el nombre de

sparkpien la página Flujos de trabajo de Dataproc en la consola de Google Cloud para abrir la página Detalles de la plantilla de flujo de trabajo. Haz clic en el nombre de tu plantilla de flujo de trabajo para confirmar los atributos de la plantillasparkpi.

Comando de gcloud

Ejecuta el siguiente comando:

gcloud dataproc workflow-templates describe sparkpi --region=us-central1 - Crea o usa un entorno existente de Cloud Composer.

- Configurar variables de entorno

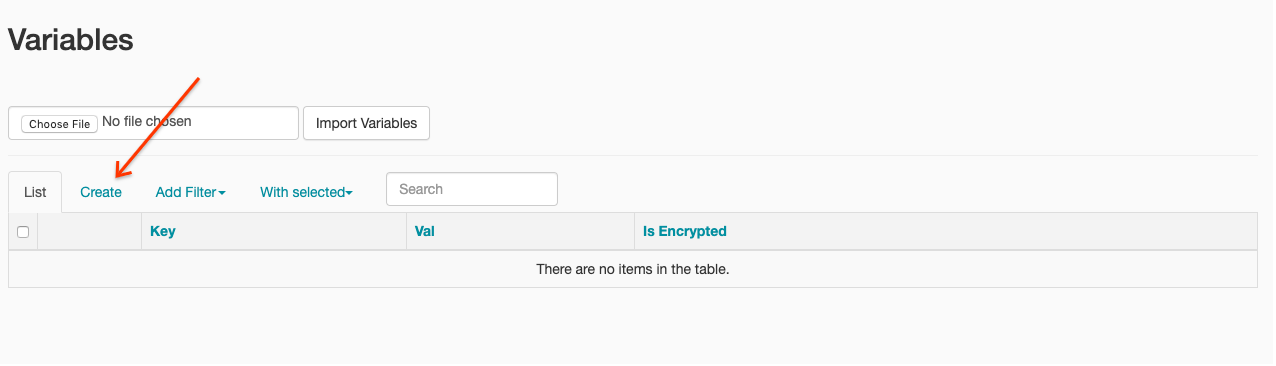

IU de Airflow

- En la barra de herramientas, haz clic en Administrador > Variables.

- Haz clic en Crear.

- Ingresa la siguiente información:

- Key:

project_id - Val: PROJECT_ID, el ID de tu proyecto de Google Cloud

- Key:

- Haz clic en Guardar.

Comando de gcloud

Ingresa los siguientes comandos:

ENVIRONMENTes el nombre del entorno de Cloud Composer.LOCATIONes la región en la que se encuentra el entorno de Cloud Composer.PROJECT_IDes el ID del proyecto que contiene el entorno de Cloud Composer.

gcloud composer environments run ENVIRONMENT --location LOCATION variables set -- project_id PROJECT_ID - En la barra de herramientas, haz clic en Administrador > Variables.

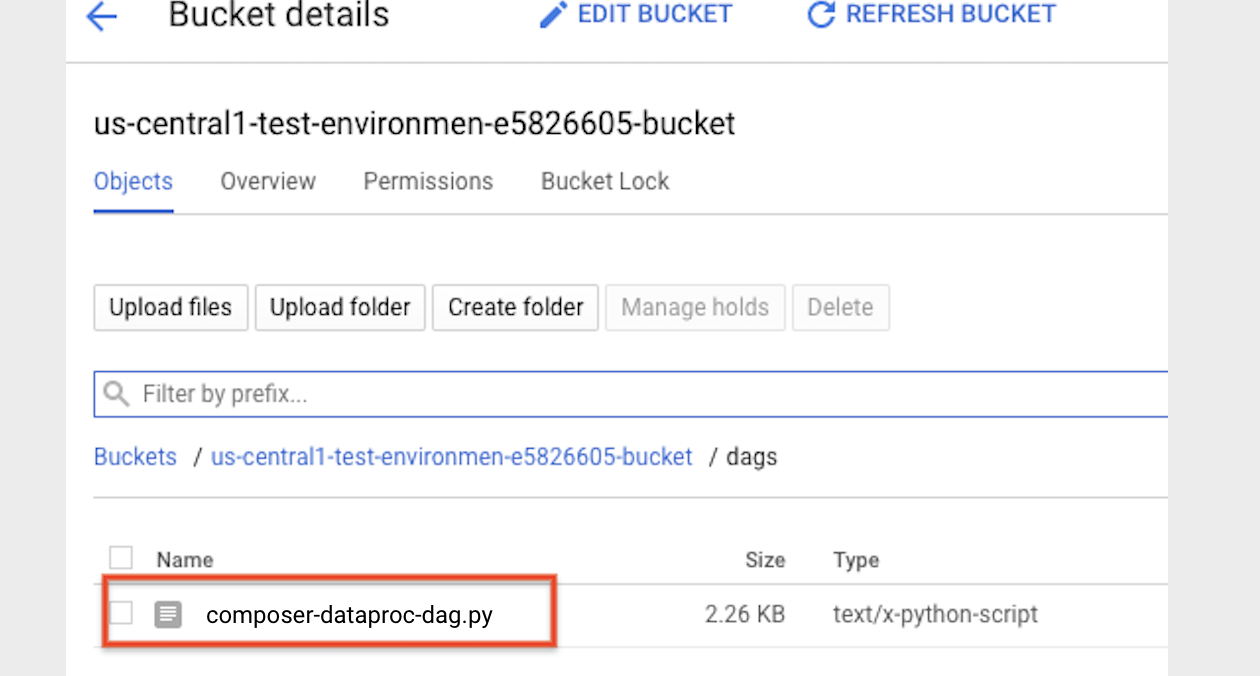

- Copia el siguiente código de DAG de forma local en un archivo llamado “composer-dataproc-dag.py”, que usa DataprocInstantiateWorkflowTemplateOperator.

Airflow 2

Airflow 1

- Sube el DAG a tu carpeta de entorno en Cloud Storage. Una vez que la carga se haya completado de forma correcta, haz clic en el vínculo Carpeta de DAG en la página del entorno de Cloud Composer.

- Abre la interfaz web de Airflow.

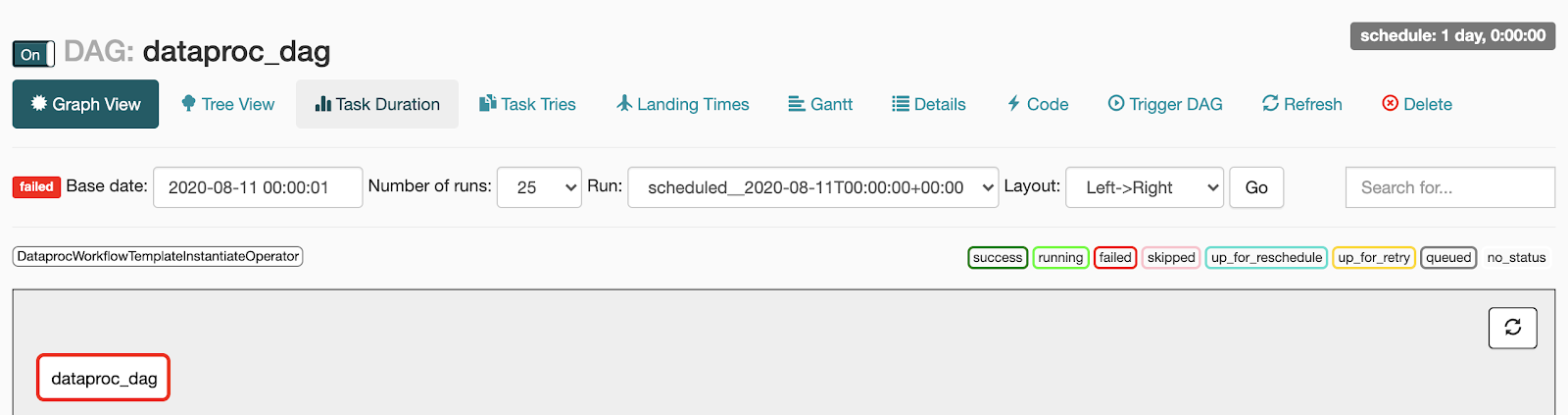

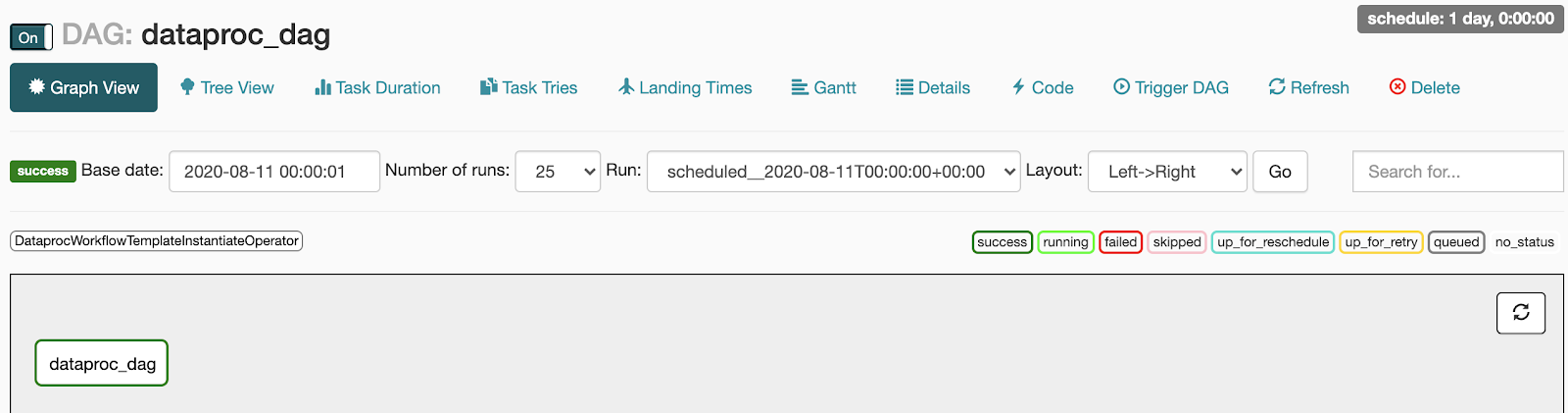

- En la página de los DAG, haz clic en el nombre del DAG (por ejemplo,

dataproc_workflow_dag). - En la página de detalles de los DAG, haz clic en Graph View.

- Verifica el estado:

- Tarea con errores: la tarea estará encerrada en un cuadro rojo. También puedes mantener el puntero sobre la tarea y ver si aparece el mensaje Estado: con errores.

- Éxito: La tarea tiene un cuadro verde a su alrededor.

También puedes mantener el puntero sobre la tarea y ver si aparece el mensaje Estado: correcto.

- Tarea con errores: la tarea estará encerrada en un cuadro rojo. También puedes mantener el puntero sobre la tarea y ver si aparece el mensaje Estado: con errores.

- Consulta la Descripción general de las plantillas de flujos de trabajo de Dataproc.

- Consulta Soluciones de programación del flujo de trabajo.

Crea una plantilla de flujo de trabajo de Dataproc

Copia y ejecuta los siguientes comandos en una ventana de la terminal local o en Cloud Shell para crear y definir una plantilla de flujo de trabajo.

Crea y sube un DAG a Cloud Storage

Cómo ver el estado de una tarea

IU de Airflow

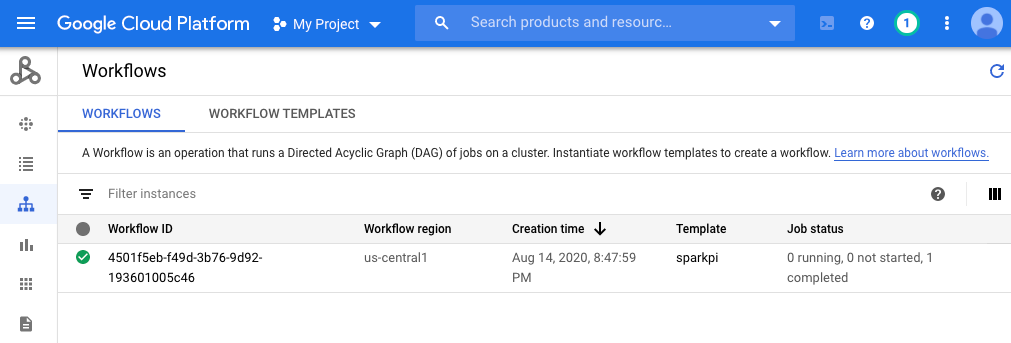

Console

Haz clic en la pestaña Flujos de trabajo para ver el estado del flujo de trabajo.

Comando de gcloud

gcloud dataproc operations list \

--region=us-central1 \

--filter="labels.goog-dataproc-workflow-template-id=sparkpi"

Limpia

Para evitar que se apliquen cargos a tu Google Cloud cuenta, puedes borrar los recursos que usaste en este instructivo: