Questo documento mostra come attivare e utilizzare la derivazione dei dati per i job Dataproc Hive.

Puoi abilitare la derivazione dei dati per i job Hive Dataproc utilizzando un'azione di inizializzazione quando crei un cluster.

Quando attivi la derivazione dei dati Hive su un cluster, i job Hive che invii al cluster acquisiscono gli eventi di derivazione dei dati e li pubblicano in Dataplex Universal Catalog.

Visualizzare le informazioni sulla derivazione

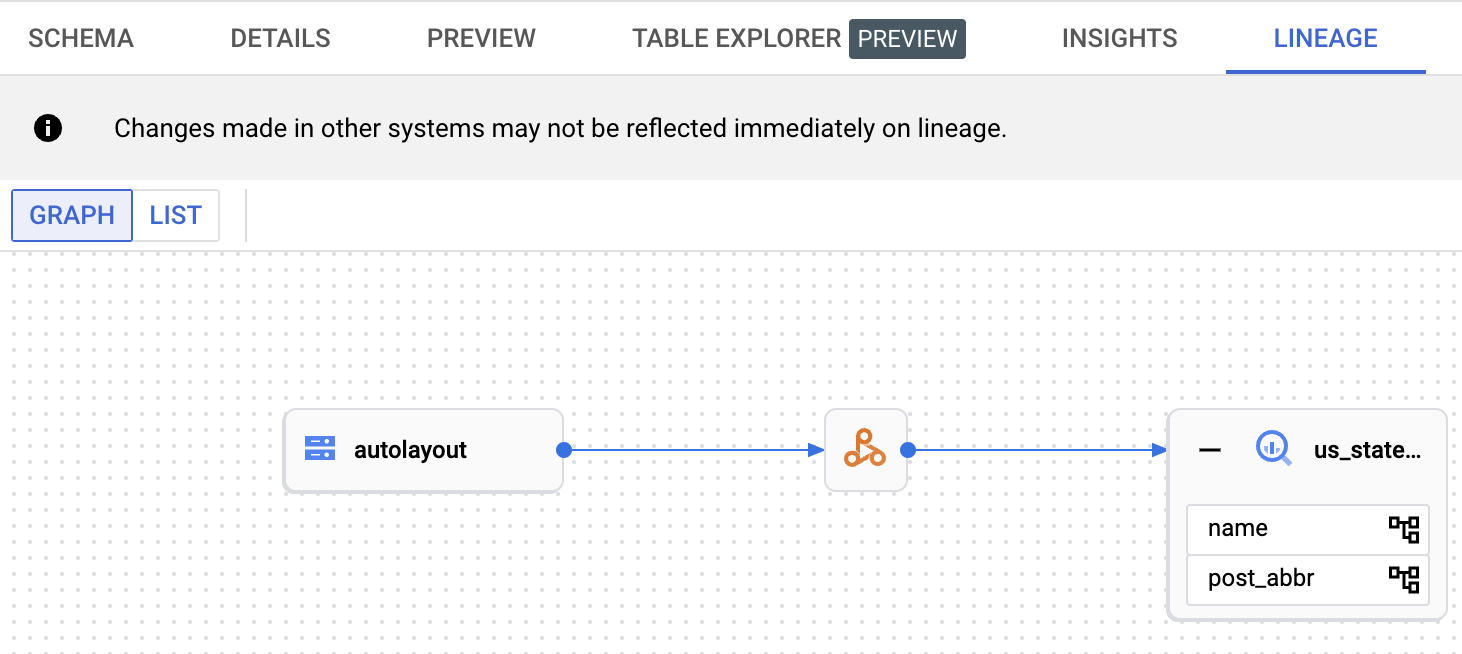

Un grafico della derivazione dei dati mostra le relazioni tra le risorse del progetto e i processi che le hanno create. Puoi accedere ai grafici di derivazione utilizzando il Catalogo universale Dataplex, BigQuery Studio e Vertex AI nella console Google Cloud .

Prezzi

La derivazione dei dati Hive di Dataproc viene offerta durante l'anteprima senza costi aggiuntivi. Vengono applicati i prezzi standard di Dataproc.

Prima di iniziare

Nella console Google Cloud , nella pagina di selezione del progetto, seleziona il progetto che contiene il cluster Dataproc per cui vuoi monitorare la derivazione.

Abilita l'API Data Lineage e l'API Dataplex.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per utilizzare la derivazione dei dati in Dataproc, chiedi all'amministratore di concederti i seguenti ruoli IAM sul service account VM del cluster Dataproc:

-

Visualizza la derivazione dei dati nel Catalogo universale Dataplex o utilizza l'API Data Lineage:

Visualizzatore della derivazione dei dati (

roles/datalineage.viewer) -

Produci la derivazione dei dati manualmente utilizzando l'API:

Data Lineage Events Producer (

roles/datalineage.producer) -

Modifica la derivazione dei dati utilizzando l'API:

Data Lineage Editor (

roles/datalineage.editor) -

Eseguire tutte le operazioni sulla derivazione dei dati:

Amministratore di Data Lineage (

roles/datalineage.admin)

Per ulteriori informazioni sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Abilita la derivazione dei dati Hive

Per abilitare la derivazione dei dati Hive su un cluster, specifica l'hive-lineage.sh

azione di inizializzazione quando

crei un cluster Dataproc.

Questa azione di inizializzazione è archiviata in bucket regionali in Cloud Storage.

Esempio di creazione di cluster gcloud CLI:

gcloud dataproc clusters create CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--image-version IMAGE_VERSION \

--initialization-actions gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.shSostituisci quanto segue:

- CLUSTER_NAME: il nome del cluster.

- PROJECT_ID: il tuo ID progetto Google Cloud . Gli ID progetto sono elencati nella sezione Informazioni sul progetto della Google Cloud console Dashboard.

- REGION: la regione di Compute Engine in cui si trova il cluster.

- IMAGE_VERSION La versione dell'immagine prevista per il cluster.

--initialization-actions: specifica un'azione di installazione che si trova in una località regionale Cloud Storage e che attiva la provenienza dei dati Hive.- (Facoltativo) Aggiungi l'azione di inizializzazione del connettore Hive-BigQuery. Se vuoi integrare le tabelle BigQuery con i carichi di lavoro Hive, devi installare il connettore Hive-BigQuery sul cluster. Consulta l'esempio di lineage dei dati Hive con BigQuery, che esegue un'azione di inizializzazione del connettore per installare il connettore Hive-BigQuery sul cluster.

Invia un job Hive

Quando invii un job Hive a un cluster Dataproc creato con la derivazione dei dati Hive abilitata, Dataproc acquisisce e segnala le informazioni sulla derivazione dei dati a Dataplex Universal Catalog.

Esempio di invio di job Hive della gcloud CLI:

gcloud dataproc jobs submit hive \

--cluster=CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--properties=hive.openlineage.namespace=CUSTOM_NAMESPACE \

--execute HIVE_QUERYSostituisci quanto segue:

- CLUSTER_NAME: il nome del cluster.

- PROJECT_ID: il tuo ID progetto Google Cloud . Gli ID progetto sono elencati nella sezione Informazioni sul progetto della Google Cloud console Dashboard.

- REGION: la regione Compute Engine in cui si trova il cluster.

- CUSTOM_NAMESPACE: uno spazio dei nomi Hive personalizzato facoltativo che puoi specificare per identificare il job Hive.

- HIVE_QUERY: la query Hive da inviare al cluster.

Anziché specificare una query, puoi sostituire il flag

--execute HIVE_QUERYcon un flag--file SQL_FILEper specificare la posizione di un file che contiene la query.

Visualizza la derivazione nel Catalogo universale Dataplex

Un grafico di derivazione mostra le relazioni tra le risorse del progetto e i processi che le hanno create. Puoi visualizzare le informazioni sulla derivazione dei dati nella console Google Cloud o recuperarle dall'API Data Lineage sotto forma di dati JSON.

Lignaggio dei dati Hive con esempio BigQuery

L'esempio in questa sezione è costituito dai seguenti passaggi:

- Crea un cluster Dataproc con la derivazione dei dati Hive attivata e il connettore Hive-BigQuery installato sul cluster.

- Esegui una query Hive sul cluster per copiare i dati tra le tabelle Hive.

- Visualizza il grafico della derivazione dei dati generato in BigQuery Studio.

Crea un cluster Dataproc

Esegui questo comando in una finestra del terminale locale o in Cloud Shell per creare un cluster Dataproc.

gcloud dataproc clusters create CLUSTER_NAME \ --project PROJECT_ID \ --region REGION \ --image-version IMAGE_VERSION \ --initialization-actions gs://goog-dataproc-initialization-actions-REGION/connectors/connectors.sh, gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.sh \ --metadata hive-bigquery-connector-version=HIVE_BQ_VERSION

Note:

- CLUSTER_NAME: il nome del cluster.

- PROJECT_ID: il tuo ID progetto Google Cloud . Gli ID progetto sono elencati nella sezione Informazioni sul progetto della Google Cloud console Dashboard.

- REGION: la regione di Compute Engine in cui si trova il cluster.

- IMAGE_VERSION La versione dell'immagine prevista per il cluster.

--initialization-actions: queste azioni di installazione, che si trovano in Cloud Storage, installano il connettore Hive-BigQuery e attivano la provenienza dei dati Hive.- HIVE_BQ_VERSION: specifica la

versione del connettore Hive-BigQuery.

Il flag

--metadatapassa la versione all'azione di inizializzazioneconnectors.shper installare il connettore Hive-BigQuery sul cluster.

Eseguire una query Hive

Esegui una query Hive per eseguire le seguenti azioni:

- Crea una tabella esterna

us_statescon input di dati di esempio dags://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout. - Crea una tabella gestita

us_states_copynel set di dati BigQuery specificato. - Copia tutti i dati da

us_statesaus_states_copy.

Per eseguire la query:

- In una finestra del terminale locale o in Cloud Shell,

utilizza un editor di testo, ad esempio

vionano, per copiare l'istruzione della query Hive riportata di seguito in un filehive-example.sql, quindi salva il file nella directory corrente. - Invia il file

hive-example.sqlal cluster Dataproc creato in precedenza sostituendo il flag--execute HIVE_QUERYcon un flag--file SQL_FILEper specificare la posizione del filehive-example.sqlsalvato. Tieni presente che le variabili PROJECT e BQ_DATASET devono essere compilate.

Hive BigQueryStorageHandler

CREATE EXTERNAL TABLE us_states ( name STRING, post_abbr STRING ) STORED AS PARQUET LOCATION 'gs://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout'; CREATE TABLE us_states_copy ( name STRING, post_abbr STRING ) STORED BY 'com.google.cloud.hive.bigquery.connector.BigQueryStorageHandler' TBLPROPERTIES ( 'bq.table'='PROJECT.BQ_DATASET.us_states_copy' ); INSERT INTO us_states_copy SELECT * FROM us_states;

Visualizzare il grafico della derivazione dei dati

Al termine del job Hive, visualizza la derivazione dei dati in BigQuery Studio nella console Google Cloud :

Per informazioni sulla visualizzazione dei grafici in BigQuery Studio, vedi Visualizzare la derivazione in BigQuery. Per informazioni sulla comprensione dei grafici, consulta Modello informativo della derivazione dei dati.

Passaggi successivi

- Scopri di più sulla derivazione dei dati.