Dataproc

Apache Spark et Hadoop géré avec Google Dataproc

Exécutez vos charges de travail Spark et Open Source les plus exigeantes plus facilement avec un service géré, plus intelligemment avec Gemini et plus rapidement avec Lightning Engine.

Apache Spark est une marque de l'Apache Software Foundation.

Points forts du produit

Lightning Engine pour des performances Spark plus de 4,3 fois supérieures afin de créer des lakehouses ouverts

Prêt pour l'IA/le ML en entreprise avec la prise en charge des GPU et l'intégration de Vertex AI

Sécurité et gouvernance professionnelles pour les charges de travail critiques

Fonctionnalités

Des performances de pointe

Accélérez vos jobs Spark les plus exigeants avec Lightning Engine. Notre moteur nouvelle génération offre des performances plus de 4,3 fois supérieures grâce à l'optimisation gérée, ce qui réduit le coût total de possession et le réglage manuel. Disponible dès maintenant en preview pour Dataproc.

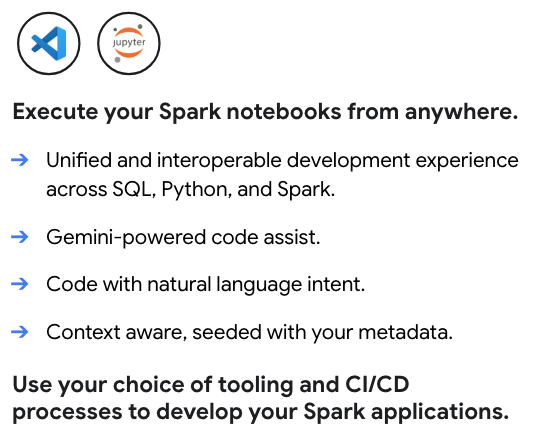

Développement et opérations optimisés par l'IA

Accélérez l'ensemble de votre workflow avec Gemini. Bénéficiez d'une assistance optimisée par l'IA pour écrire et déboguer le code PySpark, et utilisez Gemini Cloud Assist pour obtenir une analyse automatisée des causes fondamentales pour les jobs qui échouent ou s'exécutent lentement, afin de réduire considérablement le temps de dépannage.

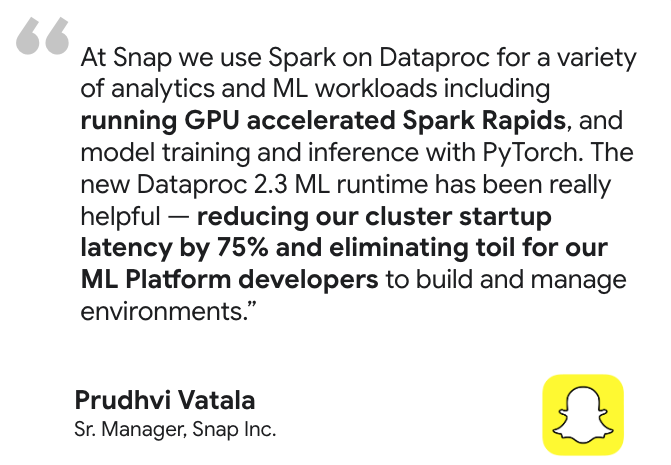

Prêt pour l'IA/le ML en entreprise

Créez et opérationnalisez l'ensemble de votre cycle de vie de machine learning. Accélérez l'entraînement et l'inférence de modèles grâce à la prise en charge des GPU optimisée par NVIDIA RAPIDS™ et les environnements d'exécution de ML préconfigurés. Vous l'intégrez ensuite à l'écosystème d'IA de Google Cloud pour orchestrer des opérations de ML de bout en bout avec Vertex AI Pipelines.

Intégrations de lakehouse puissantes

Connectez-vous de façon native à une architecture de lakehouse ouverte. Traitez les données directement depuis BigQuery, orchestrez les opérations de ML avec Vertex AI Pipelines et unifiez la gouvernance de vos données ouvertes avec BigLake et Dataplex Universal Catalog.

Contrôle et personnalisation inégalés

Adaptez chaque cluster Dataproc à vos besoins spécifiques. Développez en Python, Scala ou Java, choisissez parmi une large gamme de types de machines, utilisez des actions d'initialisation pour installer des logiciels personnalisés et exploitez vos propres images de conteneurs pour une portabilité maximale.

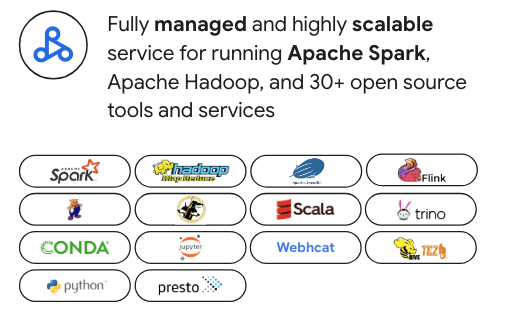

Conçu pour la pile de données Open Source moderne

Évitez la dépendance vis-à-vis d'un fournisseur. Bien que Dataproc soit optimisé pour Apache Spark, il prend en charge plus de 30 outils Open Source tels qu'Apache Hadoop, Flink, Trino et Presto. Il s'intègre parfaitement aux outils d'orchestration populaires comme Airflow et peut être étendu avec Kubernetes et Docker pour une flexibilité maximale.

Une sécurité de niveau professionnel

S'intègre parfaitement à votre stratégie de sécurité. Exploitez IAM pour définir des autorisations précises, VPC Service Controls pour la sécurité réseau et Kerberos pour une authentification forte sur votre cluster Spark.

Utilisations courantes

Migration vers le cloud

Migrez facilement vos charges de travail Apache Hadoop et Spark sur site. C'est aussi la solution idéale pour passer d'une version autogérée de Spark à un service entièrement géré. La prise en charge par Dataproc d'un large éventail de versions de Spark, y compris l'ancienne version 2.x, simplifie la migration en réduisant la nécessité de refactoriser immédiatement le code. Vous pouvez ainsi exploiter les compétences Open Source existantes de votre équipe pour migrer plus rapidement vers le cloud.

Ressources de formation

Migration vers le cloud

Migrez facilement vos charges de travail Apache Hadoop et Spark sur site. C'est aussi la solution idéale pour passer d'une version autogérée de Spark à un service entièrement géré. La prise en charge par Dataproc d'un large éventail de versions de Spark, y compris l'ancienne version 2.x, simplifie la migration en réduisant la nécessité de refactoriser immédiatement le code. Vous pouvez ainsi exploiter les compétences Open Source existantes de votre équipe pour migrer plus rapidement vers le cloud.

Modernisation du lakehouse

Utilisez Dataproc comme moteur de traitement Open Source puissant pour votre data lakehouse moderne. Traitez les données dans des formats ouverts comme Apache Iceberg directement depuis votre lac de données afin d'éliminer les silos de données et les transferts de données coûteux. Intégrez-le de manière fluide à BigQuery et à Dataplex Universal Catalog pour bénéficier d'une plate-forme d'analyse et de gouvernance véritablement unifiée et multimoteur.

Ressources de formation

Modernisation du lakehouse

Utilisez Dataproc comme moteur de traitement Open Source puissant pour votre data lakehouse moderne. Traitez les données dans des formats ouverts comme Apache Iceberg directement depuis votre lac de données afin d'éliminer les silos de données et les transferts de données coûteux. Intégrez-le de manière fluide à BigQuery et à Dataplex Universal Catalog pour bénéficier d'une plate-forme d'analyse et de gouvernance véritablement unifiée et multimoteur.

Ingénierie des données

Créez et orchestrez des pipelines ETL Spark complexes et de longue durée avec une fiabilité et une évolutivité de niveau professionnel. Exploitez des fonctionnalités puissantes comme l'autoscaling pour optimiser les coûts et les performances, et utilisez des modèles de workflow pour automatiser et gérer de bout en bout vos jobs en production les plus critiques.

Ressources de formation

Ingénierie des données

Créez et orchestrez des pipelines ETL Spark complexes et de longue durée avec une fiabilité et une évolutivité de niveau professionnel. Exploitez des fonctionnalités puissantes comme l'autoscaling pour optimiser les coûts et les performances, et utilisez des modèles de workflow pour automatiser et gérer de bout en bout vos jobs en production les plus critiques.

Data science à grande échelle

Fournissez aux équipes de data science des environnements de cluster Spark puissants et personnalisables pour l'entraînement de modèles à grande échelle et l'inférence par lot. Grâce aux environnements d'exécution de ML préconfigurés et à la prise en charge des GPU, vous pouvez accélérer l'ensemble du cycle de vie du ML et intégrer Vertex AI pour créer et opérationnaliser des pipelines MLOps de bout en bout.

Ressources de formation

Data science à grande échelle

Fournissez aux équipes de data science des environnements de cluster Spark puissants et personnalisables pour l'entraînement de modèles à grande échelle et l'inférence par lot. Grâce aux environnements d'exécution de ML préconfigurés et à la prise en charge des GPU, vous pouvez accélérer l'ensemble du cycle de vie du ML et intégrer Vertex AI pour créer et opérationnaliser des pipelines MLOps de bout en bout.

Moteurs d'analyse OSS flexibles

Allez au-delà de Spark et Hadoop sans ajouter de frais généraux opérationnels. Déployez des clusters dédiés avec Trino pour le SQL interactif, Flink pour le traitement par flux avancé ou d'autres moteurs Open Source spécialisés. Dataproc fournit un plan de contrôle unifié pour gérer cet écosystème diversifié avec la simplicité d'un service géré.

Ressources de formation

Moteurs d'analyse OSS flexibles

Allez au-delà de Spark et Hadoop sans ajouter de frais généraux opérationnels. Déployez des clusters dédiés avec Trino pour le SQL interactif, Flink pour le traitement par flux avancé ou d'autres moteurs Open Source spécialisés. Dataproc fournit un plan de contrôle unifié pour gérer cet écosystème diversifié avec la simplicité d'un service géré.

Tarification

| Clusters Dataproc gérés | Dataproc propose un modèle de tarification basé sur le paiement à l'usage. Optimisez les coûts grâce à l'autoscaling et aux VM préemptives. |

|---|---|

Composants clés |

|

Exemple | Un cluster comportant 6 nœuds (1 nœud principal + 5 nœuds de calcul) avec 4 processeurs chacun fonctionnant pendant 2 heures coûterait 0,48 $. Frais Dataproc = nombre de vCPU x heures x tarif Dataproc = 24 x 2 x 0,01 = 0,48 $ |

Clusters Dataproc gérés

Dataproc propose un modèle de tarification basé sur le paiement à l'usage. Optimisez les coûts grâce à l'autoscaling et aux VM préemptives.

Composants clés

- Instances Compute Engine (vCPU, mémoire)

- Frais de service Dataproc (par vCPU/heure)

- Disques persistants

Exemple

Un cluster comportant 6 nœuds (1 nœud principal + 5 nœuds de calcul) avec 4 processeurs chacun fonctionnant pendant 2 heures coûterait 0,48 $. Frais Dataproc = nombre de vCPU x heures x tarif Dataproc = 24 x 2 x 0,01 = 0,48 $

Cas d'utilisation métier

Élaborez votre cas d'utilisation métier pour Google Dataproc

Avantages économiques de Google Cloud Dataproc et Spark sans serveur par rapport aux autres solutions

Découvrez comment Dataproc permet de réaliser des économies considérables sur le coût total de possession et de générer de la valeur commerciale par rapport aux solutions sur site et aux autres solutions cloud.

Dans le rapport :

Découvrez comment Dataproc et Serverless pour Apache Spark peuvent permettre de réaliser des économies de 18 % à 60 % par rapport aux autres solutions cloud Spark.

Découvrez comment Google Cloud Serverless pour Apache Spark peut offrir une amélioration du rapport prix/performances de 21 à 55 % par rapport à d'autres offres Spark sans serveur.

Découvrez comment Dataproc et Google Cloud Serverless pour Apache Spark simplifient les déploiements Spark et contribuent à réduire la complexité opérationnelle.

Questions fréquentes

Quand dois-je choisir Dataproc plutôt que Google Cloud Serverless pour Apache Spark ?

Choisissez Dataproc si vous avez besoin d'un contrôle précis sur votre environnement de cluster, si vous migrez des charges de travail Hadoop/Spark existantes ou si vous avez besoin d'un cluster persistant avec un ensemble varié d'outils Open Source. Pour découvrir une analyse détaillée des différences entre les modèles de gestion, les charges de travail idéales et les structures de coûts.

Puis-je utiliser d'autres outils que Spark et Hadoop ?

Oui. Dataproc est une plate-forme unifiée pour la pile de données Open Source moderne. Il prend en charge plus de 30 composants, ce qui vous permet d'exécuter des clusters dédiés pour des outils tels que Flink pour le traitement par flux ou Trino pour le SQL interactif, le tout dans un service géré unique.

Quel niveau de contrôle ai-je sur l'environnement de cluster ?

Vous disposez d'un haut degré de contrôle. Dataproc vous permet de personnaliser les types de machines, la taille des disques et les configurations réseau. Vous pouvez également utiliser des actions d'initialisation pour installer des logiciels personnalisés, vos propres images de conteneurs et les VM Spot pour optimiser les coûts.