Hochparallele HPC-Arbeitslasten in Dataflow

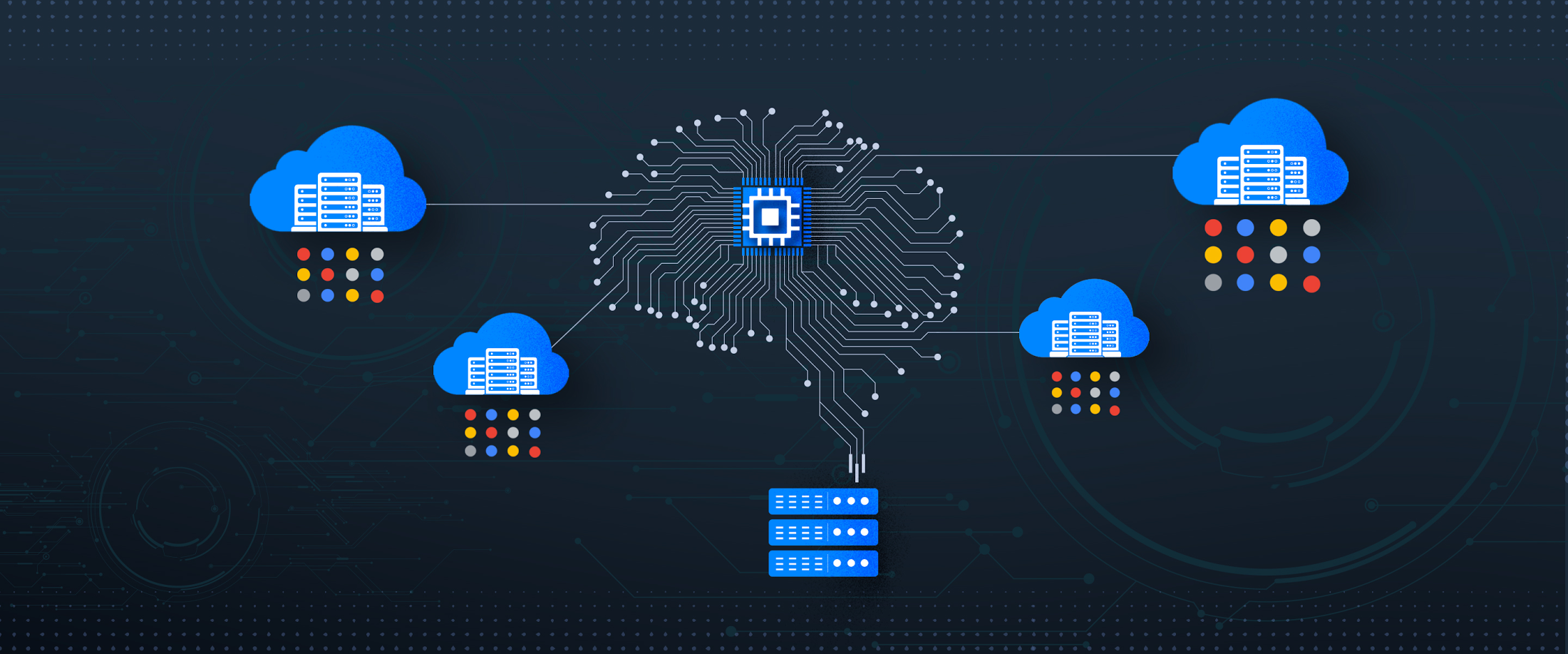

Wenn Sie mit Grid-Computing mit hohem Volumen arbeiten, können Sie mit Dataflow hochparallele HPC-Arbeitslasten in einem vollständig verwalteten System ausführen. Mit Dataflow können Sie Ihre hochgradig parallelen Arbeitslasten in einer einzigen Pipeline ausführen, wodurch sich die Effizienz verbessert und Ihr Workflow einfacher zu verwalten wird. Die Daten verbleiben sowohl für die Vor- und Nachbearbeitung als auch für die Aufgabenverarbeitung in einem System. Dataflow verwaltet automatisch Leistung, Skalierbarkeit, Verfügbarkeit und Sicherheitsanforderungen.

Anleitung für benutzerdefinierte Container

In dieser Anleitung finden Sie ein End-to-End-Beispiel für eine hochparallele HPC-Pipeline, die benutzerdefinierte Container mit C++-Bibliotheken verwendet.

Best Practices für hochgradig parallele HPC-Anwendungen

Informationen zu Best Practices beim Entwerfen einer hochgradig parallelen HPC-Pipeline.

Ressourcen

GPUs verwenden

Die Verwendung von GPUs in Dataflow-Jobs kann die Aufgaben zur Verarbeitung von Bildern und zur Verarbeitung von maschinellem Lernen beschleunigen.

Fallstudie

HSBC nutzte einen hochparallelen Dataflow-HPC-Workflow, um die Rechenkapazität und -geschwindigkeit zu erhöhen und gleichzeitig die Kosten zu senken.

Beispiele auf GitHub ansehen

Das Beispiel für eine hochparallele Dataflow-HPC-Pipeline und der entsprechende Quellcode sind auf GitHub verfügbar.