Usar el complemento fuente por lotes de Salesforce para analizar los datos de clientes potenciales en BigQuery

Aprende a usar el complemento de origen por lotes de Salesforce en Cloud Data Fusion para analizar los datos de clientes potenciales en BigQuery.

Para seguir la guía paso a paso sobre esta tarea directamente en la consola Google Cloud , haz clic en Guiarme:

Situación

Considera un gerente de marketing que planifica una campaña de marketing por correo electrónico altamente segmentada para promocionar un producto nuevo. Tienes una lista de clientes potenciales en Sales Cloud de Salesforce. Antes de crear una campaña segmentada, para comprender mejor a tu público objetivo, debes usar el complemento de origen por lotes de Salesforce en Cloud Data Fusion para extraer datos de clientes potenciales específicos.

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Crea una instancia de Cloud Data Fusion.

- Configura una conexión a la API de Salesforce creando una app conectada de Salesforce para Cloud Data Fusion.

En la consola de Google Cloud , ve a la página Roles.

Haz clic en Crear rol.

En el campo Title, ingresa

Custom Role-Tutorial.Haz clic en Agregar permisos.

En la ventana Agregar permisos, selecciona los siguientes permisos y haz clic en Agregar:

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Haz clic en Crear.

Ve a la página de Instancias de Cloud Data Fusion.

Haz clic en el nombre de la instancia.

Toma nota de la cuenta de servicio predeterminada de Compute Engine. La página de detalles de la instancia contiene esta información.

El formato del nombre de la cuenta de servicio predeterminada de Compute Engine de Cloud Data Fusion es

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Ve a la página IAM:

En la barra de Filtro, ingresa el nombre de tu cuenta de servicio predeterminada de Compute Engine.

Para la cuenta de servicio predeterminada de Compute Engine, haz clic en Editar.

Haz clic en Agregar otro rol.

En el campo Selecciona un rol, selecciona Rol personalizado - instructivo.

Haz clic en Guardar.

Administrar permisos

Crea y asigna los roles y permisos personalizados necesarios.

Crea un rol personalizado y agrega permisos

Asigna un rol personalizado a la cuenta de servicio predeterminada de Compute Engine

Configura el complemento de origen por lotes de Salesforce para Cloud Data Fusion

Ve a la página de Instancias de Cloud Data Fusion.

Para tu instancia, haz clic en Ver instancia. Se abrirá la interfaz web de Cloud Data Fusion.

Ve a la página de Studio.

Haz clic en Hub.

En la barra de búsqueda, ingresa

Salesforce.Haz clic en Salesforce plugins y, luego, en Deploy.

En la ventana Salesforce plugins deploy haz clic en Finish.

Cuando se completa la implementación, se muestra un diálogo con un mensaje de éxito.

En ese diálogo, haz clic en Create a pipeline.

Se mostrará la página Cloud Data Fusion Studio.

Selecciona Data Pipelines - batch como el tipo de canalización de datos.

En el menú Source, haz clic en Salesforce.

Ve al nodo de Salesforce y haz clic en Properties. Se abrirá la página de propiedades del complemento de Salesforce.

En el campo Reference name, ingresa un nombre para tu fuente. Por ejemplo,

Leads_generated.En la sección Connection, haz clic en el botón de activación Use connection.

Haz clic en Browse connections. Se abrirá la ventana Browse connections.

Haz clic en Add connection y selecciona Salesforce.

En la ventana Create a Salesforce connection, haz clic en la pestaña Configuration y haz lo siguiente:

En el campo Name, ingresa un nombre para identificar la conexión, por ejemplo,

Salesforce_connection.En la sección Credentials, ingresa los siguientes detalles de tu cuenta de Salesforce:

- Nombre de usuario

- Contraseña

- Clave de consumidor

- Secreto de consumidor

- Token de seguridad

Haz clic en Test Connection. Si los detalles ingresados son correctos, la prueba se realizará de manera correcta con el mensaje "Successfully connected".

Haz clic en Crear.

Selecciona Salesforce_connection y regresa a la página de propiedades del complemento de Salesforce.

Extrae datos del complemento de origen por lotes de Salesforce

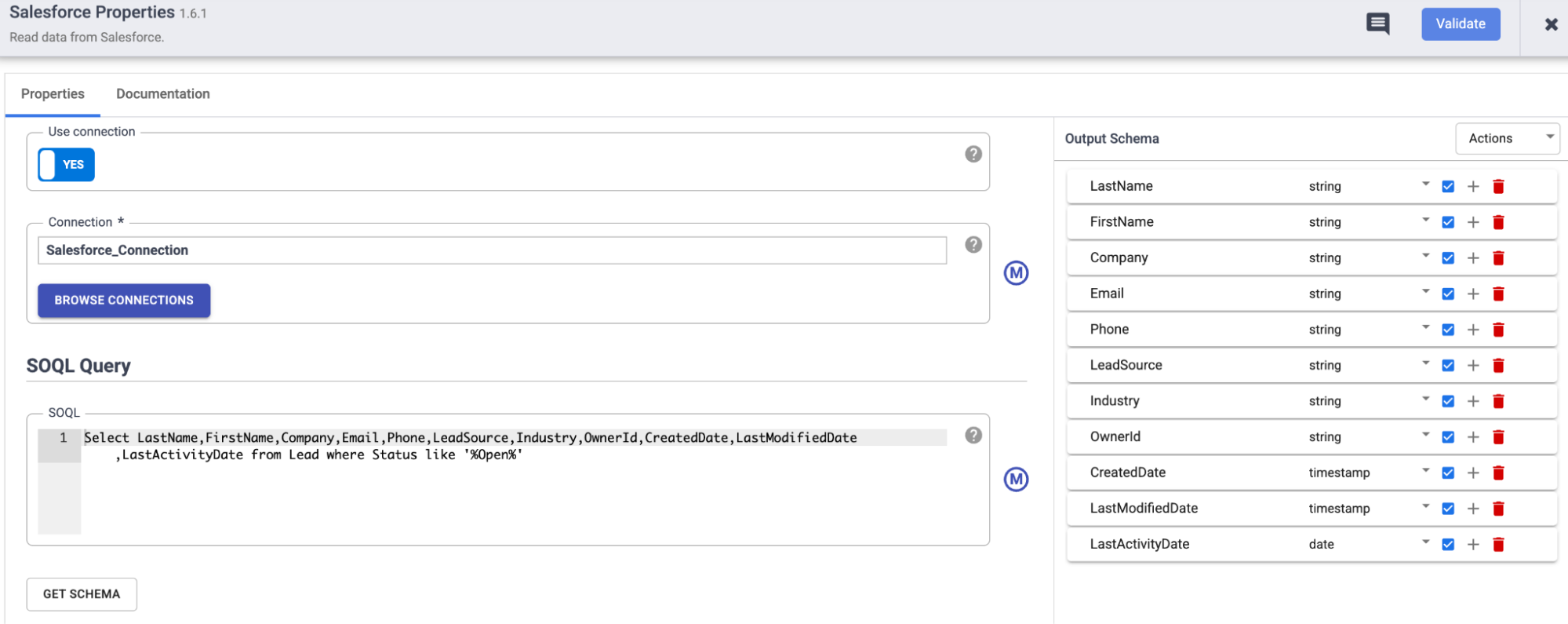

En la página de propiedades del complemento de Salesforce, en la sección SOQL query, ingresa la siguiente consulta:

Select LastName,FirstName,Company,Email,Phone,LeadSource,Industry,OwnerId,CreatedDate,LastModifiedDate,LastActivityDate from Lead where Status like '%Open%'Esta consulta recupera los detalles de un cliente potencial potencial que se necesita para publicar una campaña a partir del sObject

Lead.Para determinar la validez del esquema de objetos, haz clic en Get shcema.

Si deseas filtrar los registros por una fecha o una hora específica para publicar la campaña, usa los siguientes campos:

- Última modificación después del

- Última modificación antes del

- Duración

- Desplazamiento

Transforma datos con el complemento Wrangler

Usa el complemento Wrangler en Cloud Data Fusion para limpiar y enriquecer tus datos:

Regresa a la página de Studio.

En el menú Transform, haz clic en Wrangler.

Conecta Wrangler al complemento de origen por lotes de Salesforce.

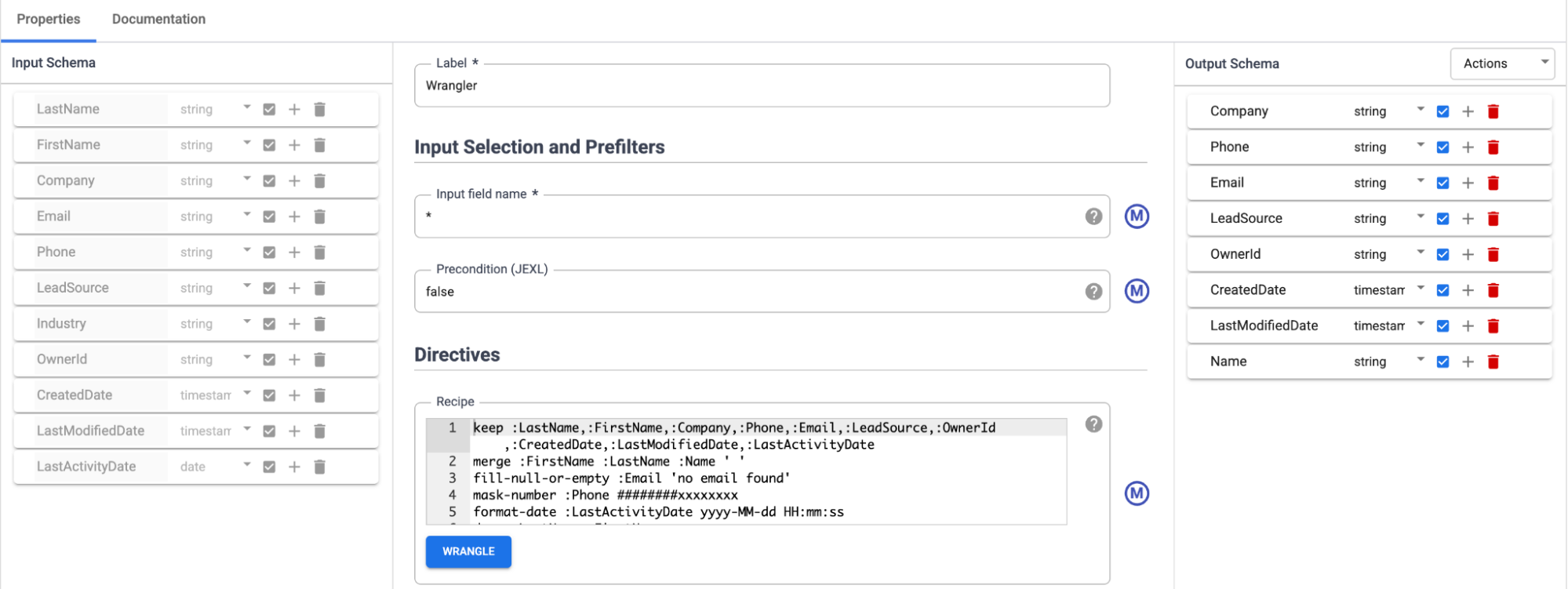

Ve al complemento Wrangler y haz clic en Properties. Se abrirá la página de propiedades del complemento Wrangler.

Asegúrate de que se propague el Esquema de entrada.

Haz clic en Wrangle.

En el panel Connections, selecciona una conexión válida.

Selecciona el sObject que deseas transformar, por ejemplo,

Lead.Transforma los datos con las directivas requeridas:

keep :LastName,:FirstName,:Company,:Phone,:Email,:LeadSource,:OwnerId, :CreatedDate,:LastModifiedDate,:LastActivityDatemerge :FirstName :LastName :Name ' ' fill-null-or-empty :Email 'no email found' mask-number :Phone ########xxxxxxxx format-date :LastActivityDate yyyy-MM-dd HH:mm:ss drop :LastName,:FirstName

Cargar datos en BigQuery

Regresa a la página de Studio.

En el menú Sink, haz clic en BigQuery.

Ve al nodo de BigQuery y haz clic en Properties. Se abrirá la página de propiedades del complemento de BigQuery.

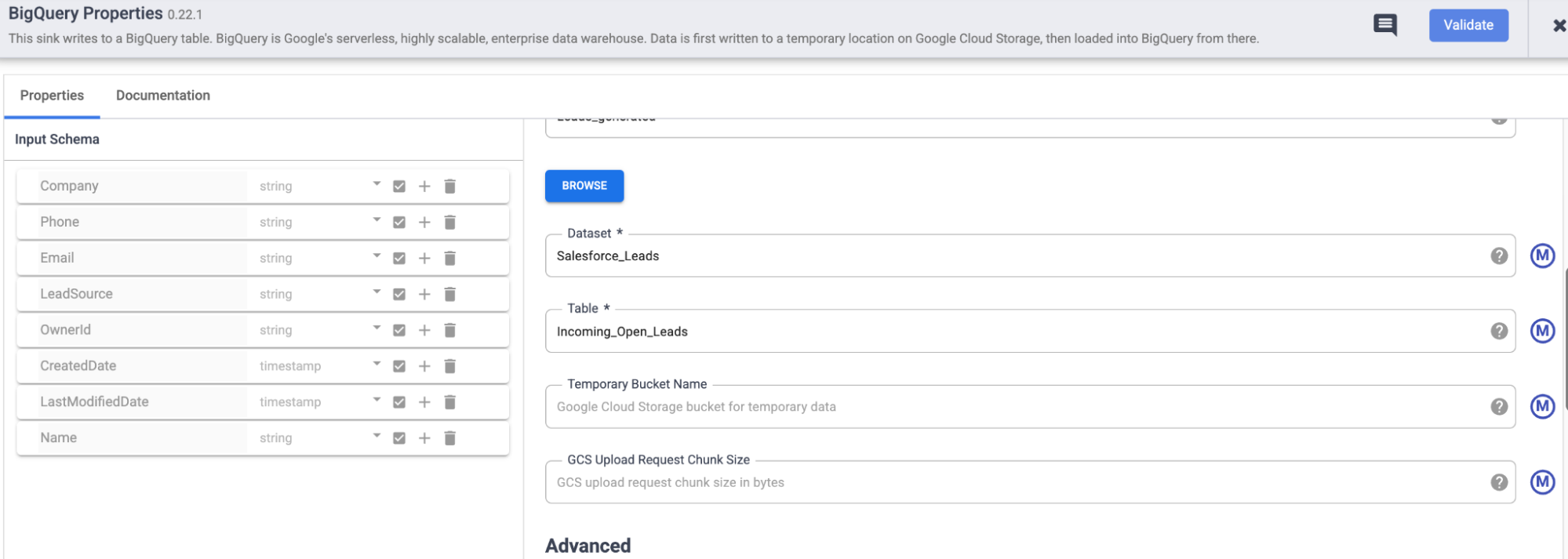

En la sección Basic, en el campo Reference name, ingresa un nombre para identificar este receptor. Un ejemplo es

Leads_generated.En el campo Dataset, ingresa el conjunto de datos al que pertenece la tabla. Por ejemplo,

Salesforce_Leads.En el campo Table, ingresa la tabla en la que se deben almacenar los registros extraídos. Un ejemplo es

Incoming_Open_Leads.Para validar el complemento, haz clic en Validate.

Implementa, programa y ejecuta la canalización

Para implementar la canalización, haz clic en Deploy.

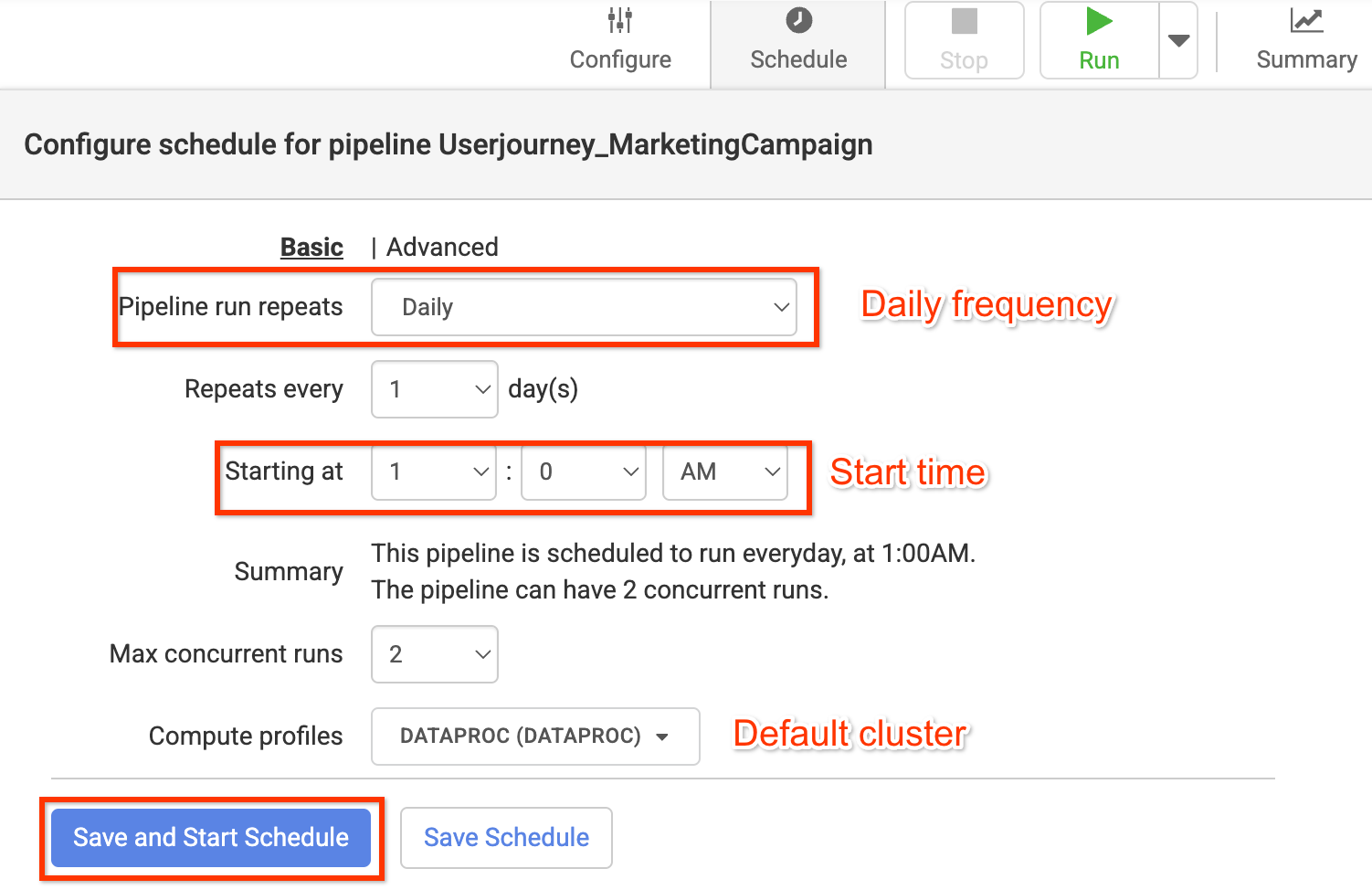

Para establecer un programa de actualización adecuado mediante programadores, sigue estos pasos:

- Haz clic en Programar.

Ingresa los siguientes detalles:

- Pipeline run repeats

- Se repite cada

- A partir de

- Max concurrent runs

- Compute profiles

Haz clic en Save and start schedule.

Para ejecutar la canalización, haz clic en Run.

Verifica la extracción y transferencia de datos

En la consola de Google Cloud , ve a la página BigQuery.

Busca el conjunto de datos

Salesforce_Leadsy el nombre de la tablaIncoming_Open_Leadspara ver los registros extraídos.Para ejecutar la consulta, haz clic en Consulta.

Analiza los datos de clientes potenciales para comprender mejor a tu público y publicar campañas personalizadas a gran escala.

Limpia

Sigue estos pasos para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos que usaste en esta página.

Borra la instancia de Cloud Data Fusion

Sigue estas instrucciones para borrar tu instancia de Cloud Data Fusion.

Borra el proyecto

La manera más fácil de eliminar la facturación es borrar el proyecto que creaste para el instructivo.

Para borrar el proyecto, sigue estos pasos:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.