Cloud Data Fusion でデータ パイプラインを作成する場合は、ノードと呼ばれる一連のステージを使用して、ソースからシンクへのデータフローの際にデータを移動して管理します。各ノードは、プラグイン(Cloud Data Fusion の機能を拡張するカスタマイズ可能なモジュール)で構成されています。

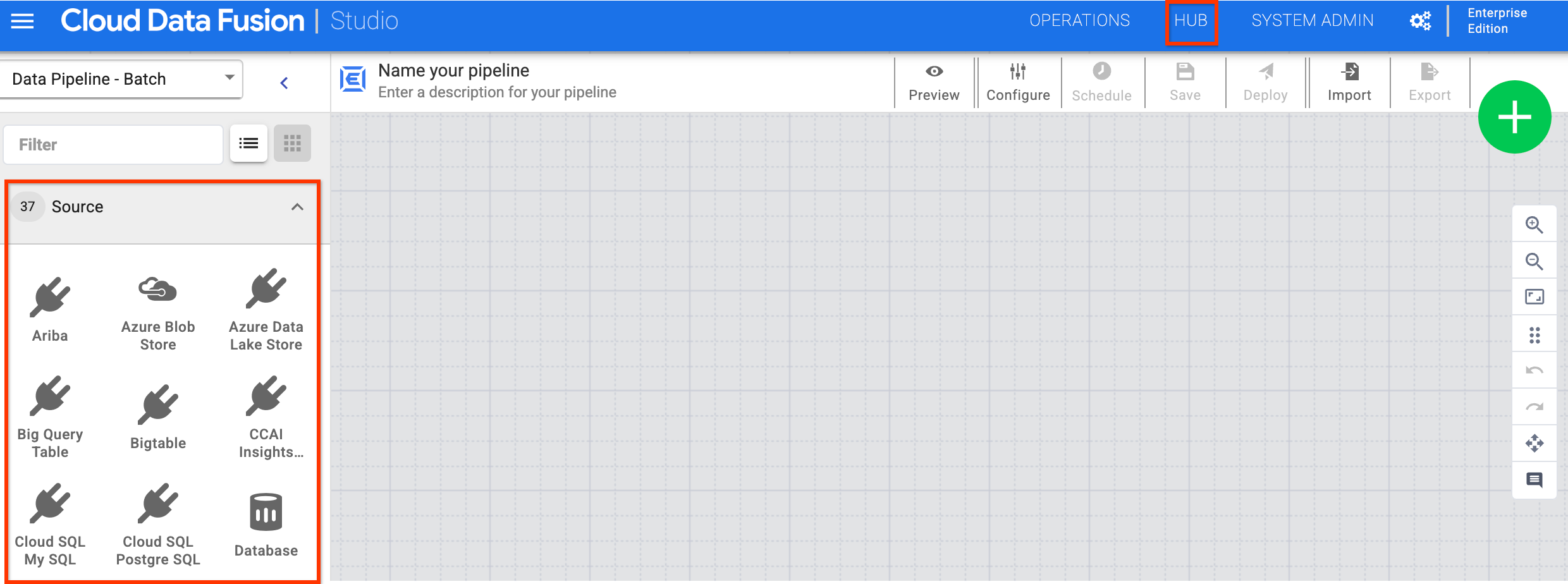

Cloud Data Fusion ウェブ インターフェースの [Studio] ページでプラグインを確認できます。その他のプラグインについては、[ハブ] をクリックします。

プラグインの種類

プラグインは次のカテゴリに分類されます。

- ソース

- 変換

- 分析

- シンク

- Conditions and Actions

- Error handlers and alerts

ソース

ソース プラグインは、パイプラインがデータを読み取るデータベース、ファイル、リアルタイム ストリームに接続します。ウェブ インターフェースを使用してデータ パイプラインのソースを設定するため、低レベルの接続のコーディングについて心配する必要はありません。

変換

変換プラグインは、データがソースから取り込まれた後にデータを変更します。たとえば、レコードのクローンを作成したり、ファイル形式を JSON に変更したり、JavaScript プラグインを使用してカスタム変換を作成したりできます。

分析

分析プラグインは、さまざまなソースからのデータの結合、分析と ML オペレーションの実行などの集約を行います。

シンク

シンク プラグインは、Cloud Storage、BigQuery、Spanner、リレーショナル データベース、ファイル システム、メインフレームなどのリソースにデータを書き込みます。シンクに書き込まれるデータをクエリするには、Cloud Data Fusion ウェブ インターフェースまたは REST API を使用します。

Conditions and Actions

条件プラグインとアクション プラグインを使用して、ワークフロー中に実行されるアクションをスケジュールします。このアクションは、ワークフロー内のデータを直接操作しません。次に例を示します。

- Database プラグインを使用して、パイプラインの最後に実行されるデータベース コマンドをスケジュールします。

- File Move プラグインを使用して、Cloud Storage 内でファイルを移動するアクションをトリガーします。

Error handlers and alerts

ステージに null 値、論理エラー、その他のエラーの原因が存在する場合、エラーハンドラ プラグインを使用してエラーを検出できます。変換または分析プラグインの後に、これらのプラグインを使用して出力のエラーを見つけます。エラーをデータベースに書き込んで分析できます。

次のステップ

- プラグインを調べる。

- プラグインを使用してデータ パイプラインを作成する。