Grands modèles de langage (LLM)

Grands modèles de langage optimisés par l'IA de pointe de Google

Google Cloud intègre des innovations développées et testées par Google DeepMind à notre plate-forme d'IA adaptée aux entreprises. Les clients peuvent ainsi les utiliser pour créer et fournir des fonctionnalités d'IA générative dès aujourd'hui, et non demain.

Les nouveaux clients bénéficient de 300 $ de crédits gratuits à dépenser sur Vertex AI.

Présentation

Qu'est-ce qu'un grand modèle de langage (LLM) ?

Un grand modèle de langage (LLM) est un modèle de langage statistique, entraîné sur une grande quantité de données. Il peut être utilisé pour générer et traduire du texte et d'autres contenus, et pour effectuer d'autres tâches de traitement du langage naturel (TLN).

Les LLM sont généralement basés sur des architectures de deep learning, comme le modèle Transformer développé par Google en 2017, et peuvent être entraînés sur des milliards de texte et d'autres contenus.

Quels sont les exemples de modèles de fondation populaires ?

Vertex AI permet d'accéder à Gemini, un modèle multimodal de Google DeepMind. Gemini est capable de comprendre pratiquement n'importe quelle entrée, de combiner différents types d'informations et de générer presque n'importe quel résultat. Lancez des requêtes et effectuez des tests dans Vertex AI avec Gemini à l'aide de texte, d'images, de vidéos ou de code. Grâce aux raisonnements avancés et aux fonctionnalités de génération de pointe de Gemini, les développeurs peuvent essayer des exemples de requêtes pour extraire du texte à partir d'images, convertir le texte des images au format JSON, et même générer des réponses sur les images importées pour créer des applications d'IA de nouvelle génération.

Quels sont les cas d'utilisation des grands modèles de langage ?

Les LLM basés sur du texte sont utilisés pour diverses tâches de traitement du langage naturel, comme la génération de texte, la traduction automatique, la synthèse de texte, les systèmes de questions-réponses et la création de chatbots capables de tenir des conversations avec des humains.

Les LLM peuvent également être entraînés sur d'autres types de données, y compris du code, des images, de l'audio, des vidéos, etc. Veo, Imagen et Chirp de Google AI sont des exemples de modèles qui permettront de lancer de nouvelles applications et de concevoir des solutions pour les problèmes les plus difficiles du monde.

Quels sont les avantages des grands modèles de langage ?

Quels sont les services liés aux grands modèles de langage proposés par Google Cloud ?

Generative IA sur Vertex AI : vous permet d'accéder aux grands modèles d'IA génératifs de Google afin que vous puissiez les tester, les régler et les déployer pour les utiliser dans vos applications basées sur l'IA.

Vertex AI Agent Builder : permet aux développeurs de créer des agents avec une approche ouverte et de les déployer avec des commandes de niveau entreprise.

Customer Engagement Suite avec l'IA de Google : solution de centre de contact intelligent qui inclut Dialogflow, notre plate-forme d'IA conversationnelle dotée à la fois de fonctionnalités basées sur l'intent et LLM.

Fonctionnement

Les LLM utilisent une grande quantité de données textuelles pour entraîner un réseau de neurones. Ce réseau de neurones est ensuite utilisé pour générer du texte, le traduire ou effectuer d'autres tâches. Plus il y a de données utilisées pour entraîner le réseau de neurones, plus il sera efficace et précis.

Google Cloud a développé des produits basés sur ses technologies LLM et répondant à une grande variété de cas d'utilisation. Vous pouvez les explorer dans la section "Utilisations courantes" ci-dessous.

Les LLM utilisent une grande quantité de données textuelles pour entraîner un réseau de neurones. Ce réseau de neurones est ensuite utilisé pour générer du texte, le traduire ou effectuer d'autres tâches. Plus il y a de données utilisées pour entraîner le réseau de neurones, plus il sera efficace et précis.

Google Cloud a développé des produits basés sur ses technologies LLM et répondant à une grande variété de cas d'utilisation. Vous pouvez les explorer dans la section "Utilisations courantes" ci-dessous.

Utilisations courantes

Créer un chatbot

Créer un chatbot basé sur LLM

Vertex AI Agents facilite la création de chatbots au ton naturel et aux apparences humaines. L'agent d'IA générative est une fonctionnalité de Vertex AI Agents qui s'appuie sur les fonctionnalités de Dialogflow CX.

Grâce à cette fonctionnalité, vous pouvez fournir une URL de site Web et/ou un nombre illimité de documents. Ensuite, l'agent d'IA générative analyse votre contenu et crée un agent virtuel alimenté par des data stores et des LLM.

Guides pratiques

Créer un chatbot basé sur LLM

Vertex AI Agents facilite la création de chatbots au ton naturel et aux apparences humaines. L'agent d'IA générative est une fonctionnalité de Vertex AI Agents qui s'appuie sur les fonctionnalités de Dialogflow CX.

Grâce à cette fonctionnalité, vous pouvez fournir une URL de site Web et/ou un nombre illimité de documents. Ensuite, l'agent d'IA générative analyse votre contenu et crée un agent virtuel alimenté par des data stores et des LLM.

Recherche et découverte d'informations

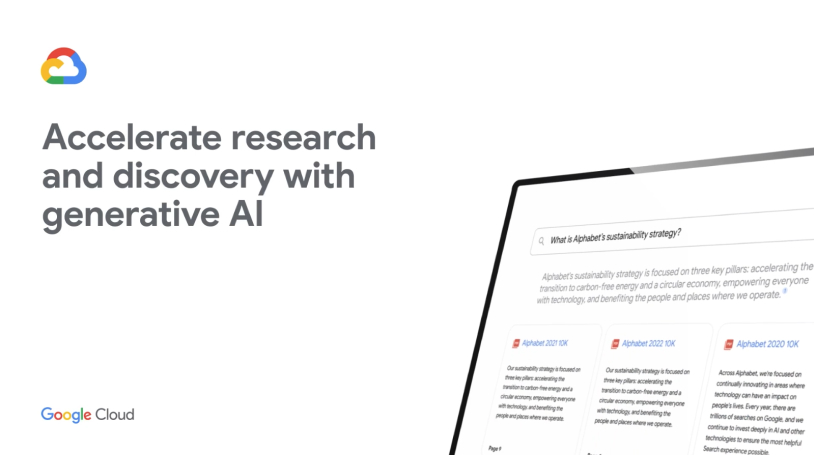

Recherchez et résumez des informations complexes en quelques instants

Extrayez et résumez des informations précieuses d'un simple clic à partir de documents complexes, tels que des formulaires 10-K, des articles de recherche, des services d'actualités tiers et des rapports financiers. Regardez comment Vertex AI Search utilise le langage naturel pour comprendre les requêtes sémantiques, résumer des réponses et poser des questions complémentaires dans la démo à droite.

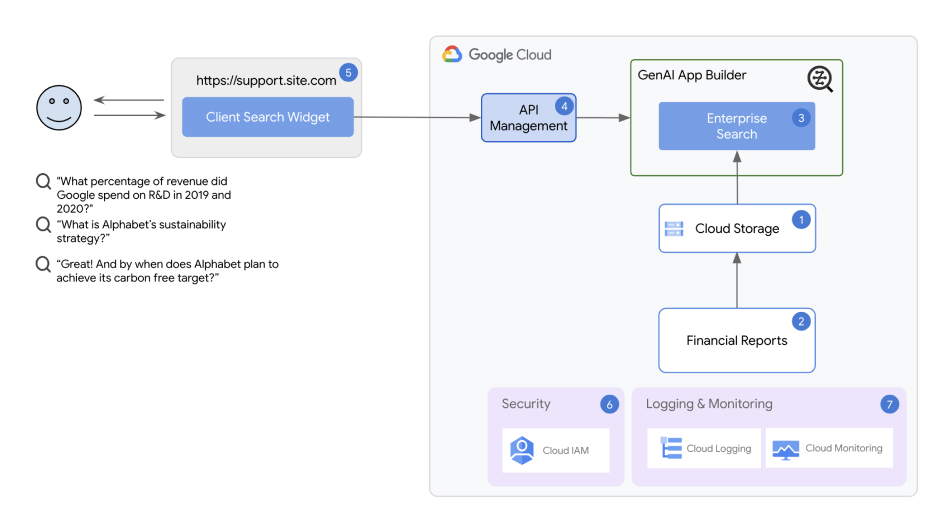

Architecture de la solution de recherche et de découverte d'informations

La solution utilise Vertex AI Agent Builder comme composant principal. Avec Vertex AI Agent Builder, même les développeurs en début de carrière peuvent créer et déployer rapidement des chatbots, ainsi que des applications de recherche, en quelques minutes.

Guides pratiques

Recherchez et résumez des informations complexes en quelques instants

Extrayez et résumez des informations précieuses d'un simple clic à partir de documents complexes, tels que des formulaires 10-K, des articles de recherche, des services d'actualités tiers et des rapports financiers. Regardez comment Vertex AI Search utilise le langage naturel pour comprendre les requêtes sémantiques, résumer des réponses et poser des questions complémentaires dans la démo à droite.

Autres ressources

Architecture de la solution de recherche et de découverte d'informations

La solution utilise Vertex AI Agent Builder comme composant principal. Avec Vertex AI Agent Builder, même les développeurs en début de carrière peuvent créer et déployer rapidement des chatbots, ainsi que des applications de recherche, en quelques minutes.

Synthèse de documents

Traitez et synthétisez des documents volumineux à l'aide des LLM de Vertex AI

Avec la synthèse de documents d'IA générative, déployez une solution en un clic qui aide à détecter le texte dans les fichiers bruts et à automatiser les résumés de documents. La solution établit un pipeline qui utilise la reconnaissance optique des caractères (OCR) dans Cloud Vision pour extraire le texte des documents PDF importés dans Cloud Storage, crée un résumé à partir du texte extrait avec Vertex AI et stocke le résumé consultable dans une base de données BigQuery.

Guides pratiques

Traitez et synthétisez des documents volumineux à l'aide des LLM de Vertex AI

Avec la synthèse de documents d'IA générative, déployez une solution en un clic qui aide à détecter le texte dans les fichiers bruts et à automatiser les résumés de documents. La solution établit un pipeline qui utilise la reconnaissance optique des caractères (OCR) dans Cloud Vision pour extraire le texte des documents PDF importés dans Cloud Storage, crée un résumé à partir du texte extrait avec Vertex AI et stocke le résumé consultable dans une base de données BigQuery.

Créer un centre de contact basé sur l'IA

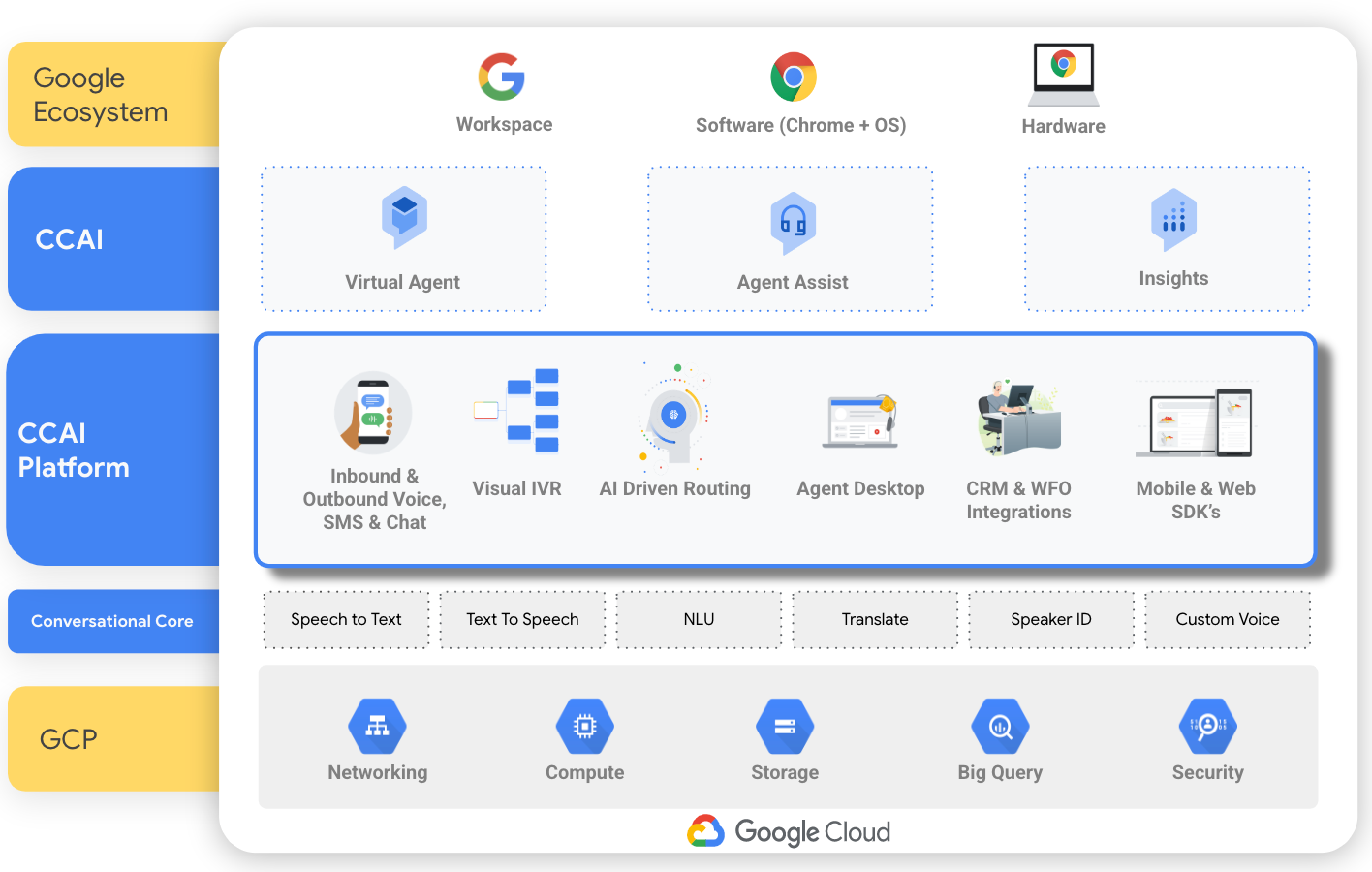

Créer un centre de contact basé sur l'IA avec CCAI

Reposant sur des technologies d'IA telles que le traitement du langage naturel, le machine learning et la reconnaissance vocale et textuelle, Customer Engagement Suite avec l'IA de Google propose un service CCaaS (Contact Center as a Service), qui permet de créer un centre de contact en partant de zéro. Il dispose également d'outils individuels qui ciblent des aspects spécifiques d'un centre de contact. Par exemple, les agents de conversation (Dialogflow) permettent de créer un chatbot, Agent Assist d'obtenir une assistance en temps réel auprès d'agents humains, et Conversational Insights d'identifier les facteurs à l'origine des appels et leur sentiment général.

Guides pratiques

Créer un centre de contact basé sur l'IA avec CCAI

Reposant sur des technologies d'IA telles que le traitement du langage naturel, le machine learning et la reconnaissance vocale et textuelle, Customer Engagement Suite avec l'IA de Google propose un service CCaaS (Contact Center as a Service), qui permet de créer un centre de contact en partant de zéro. Il dispose également d'outils individuels qui ciblent des aspects spécifiques d'un centre de contact. Par exemple, les agents de conversation (Dialogflow) permettent de créer un chatbot, Agent Assist d'obtenir une assistance en temps réel auprès d'agents humains, et Conversational Insights d'identifier les facteurs à l'origine des appels et leur sentiment général.