Video-on-Demand

Video-on-Demand (VOD) in Google Cloud

Überblick

Was ist VOD?

Video-on-Demand (VOD) ist ein Medienvertriebssystem, mit dem Nutzer Videoinhalte gemäß ihren Präferenzen ansehen können, ohne dass dabei statische Zeitpläne oder bestimmte Videowiedergabegeräte vorgegeben sind.

Was ist der Unterschied zwischen VOD und Livestreaming?

VOD-Streaming ist nicht dasselbe wie Livestreaming. VOD-Inhalte beruhen auf vorab aufgezeichneten und bearbeiteten Videoinhalten, bevor der Nutzer sie sich ansieht. Beim Livestreaming werden Live-Videoinhalte in Echtzeit bereitgestellt.

Welche Arten von VOD gibt es?

Wie funktioniert VOD?

Was sind die Vorteile von VOD?

Wie funktioniert VOD mit Google Cloud?

Gängige Einsatzmöglichkeiten

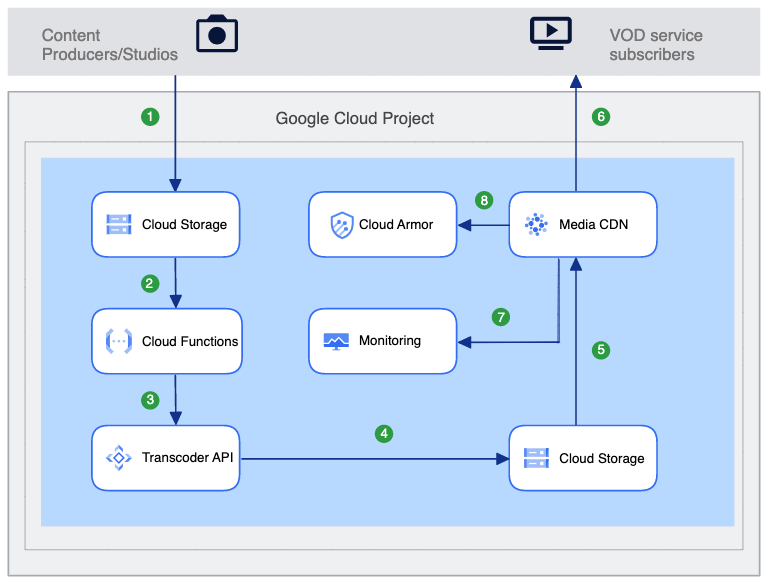

Video-on-Demand-Plattform

Videoinhalte mit Media CDN bereitstellen

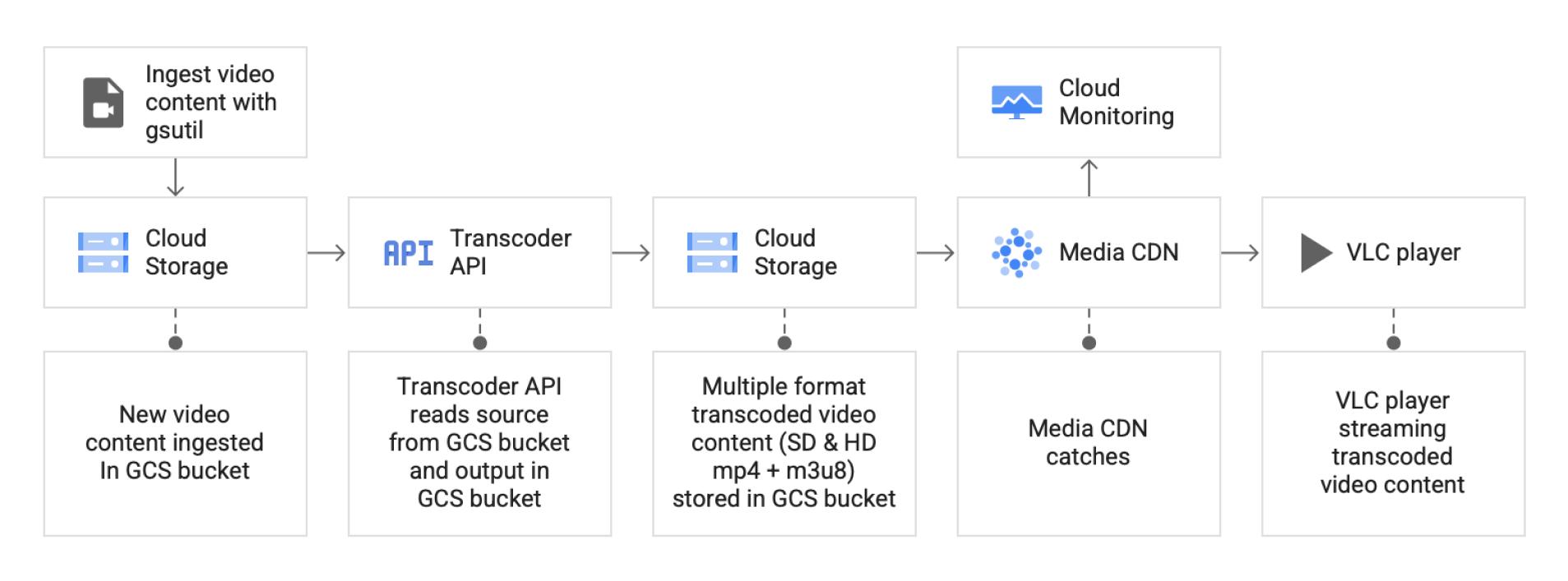

Hier erfahren Sie, wie Sie mit Google Cloud-Produkten und -Infrastruktur einen End-to-End-Streaming-Workflow für VOD-Streaming erstellen. Neuer Videocontent wird in Cloud Storage aufgenommen, mit der Transcoder API transcodiert und global mit Media CDN von einem HLS/MPEG-DASH-kompatiblen Videoplayer wiedergegeben.

Anleitungen

Videoinhalte mit Media CDN bereitstellen

Hier erfahren Sie, wie Sie mit Google Cloud-Produkten und -Infrastruktur einen End-to-End-Streaming-Workflow für VOD-Streaming erstellen. Neuer Videocontent wird in Cloud Storage aufgenommen, mit der Transcoder API transcodiert und global mit Media CDN von einem HLS/MPEG-DASH-kompatiblen Videoplayer wiedergegeben.

VOD-Inhalte transcodieren

Videos mit der Transcoder API transcodieren

Die Transcoder API transcodiert aufgenommene Video-Mezzanine-Dateien in die gewünschten Ausgabeformate, einschließlich MP4, HLS und MPEG-DASH. Für jedes Eingabevideo liefert die Transcoder API Ausgabewiedergaben basierend auf Ihrer Konfiguration: SD (weniger als 1280 x 720 Pixel) bis HD (1280 x 720 Pixel) bis UHD (mehr als 1920 x 1080 bis 4096 x 216 Pixel) , Die transcodierten Videos werden in einem separaten Cloud Storage-Bucket abgelegt, der als Ursprungsspeicher für Media CDN dient.

Anleitungen

Videos mit der Transcoder API transcodieren

Die Transcoder API transcodiert aufgenommene Video-Mezzanine-Dateien in die gewünschten Ausgabeformate, einschließlich MP4, HLS und MPEG-DASH. Für jedes Eingabevideo liefert die Transcoder API Ausgabewiedergaben basierend auf Ihrer Konfiguration: SD (weniger als 1280 x 720 Pixel) bis HD (1280 x 720 Pixel) bis UHD (mehr als 1920 x 1080 bis 4096 x 216 Pixel) , Die transcodierten Videos werden in einem separaten Cloud Storage-Bucket abgelegt, der als Ursprungsspeicher für Media CDN dient.

Videotranscodierung automatisieren

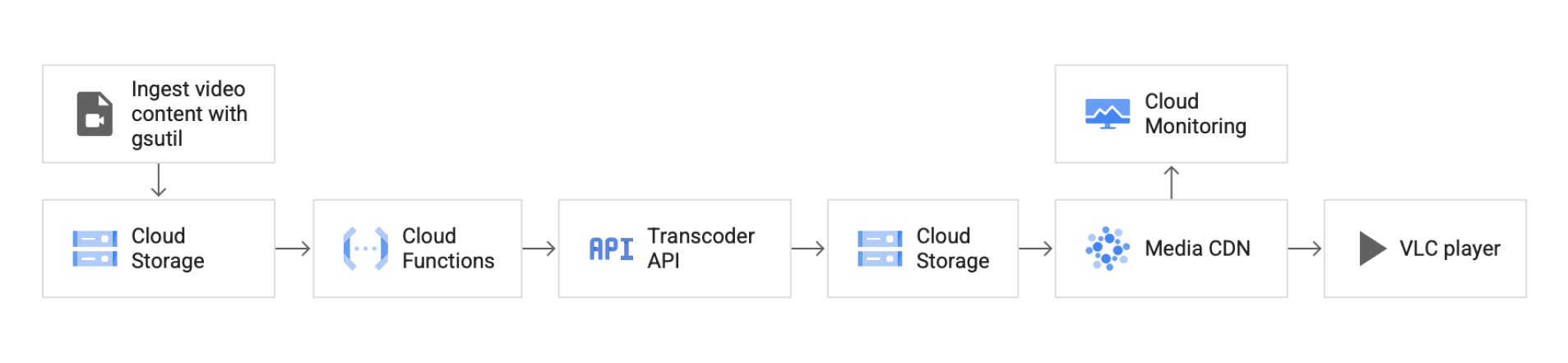

Transcodierungsvorgänge mit Cloud Functions automatisieren

Sobald Videodateien in Cloud Storage aufgenommen wurden, erkennt Cloud Functions automatisch ein neues Video im Bucket und erstellt den Transcodierungsjob. Die Transcoder API wandelt aufgenommene Mezzanine-Videodateien in die gewünschten Ausgabeformate um, einschließlich H.264-Codierung sowie MP4-, HLS- und MPEG-DASH-Paketerstellung. Die resultierenden transcodierten Dateien werden in einem separaten Cloud Storage-Bucket abgelegt, der als Ursprungsspeicher für Media CDN dient.

Anleitungen

Transcodierungsvorgänge mit Cloud Functions automatisieren

Sobald Videodateien in Cloud Storage aufgenommen wurden, erkennt Cloud Functions automatisch ein neues Video im Bucket und erstellt den Transcodierungsjob. Die Transcoder API wandelt aufgenommene Mezzanine-Videodateien in die gewünschten Ausgabeformate um, einschließlich H.264-Codierung sowie MP4-, HLS- und MPEG-DASH-Paketerstellung. Die resultierenden transcodierten Dateien werden in einem separaten Cloud Storage-Bucket abgelegt, der als Ursprungsspeicher für Media CDN dient.

Livestreams transcodieren

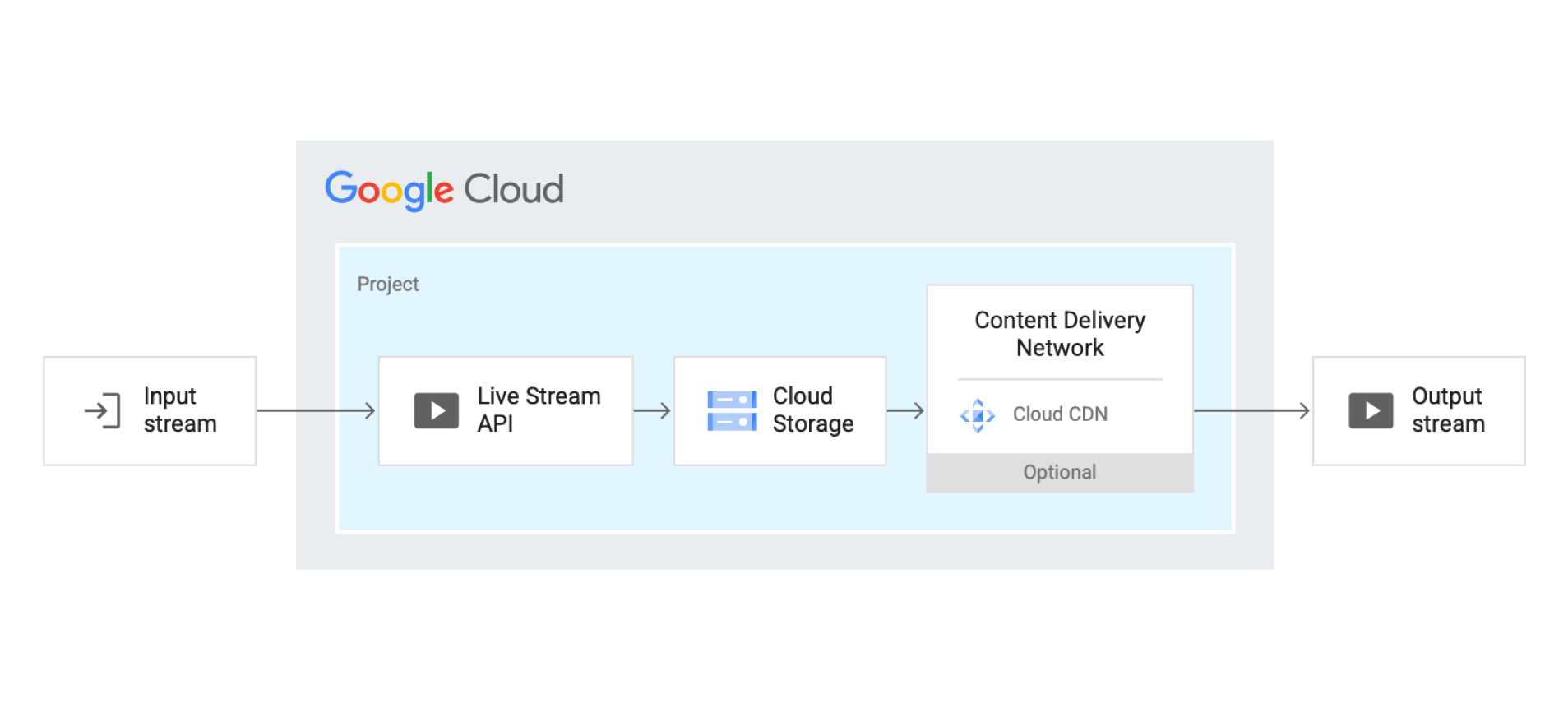

Livestream mit der Live Stream API transcodieren

Die Live Stream API transcodiert Mezzanine-Live-Signale automatisch in Direct-to-Consumer-Streamingformate, einschließlich HLS und MPEG-DASH. Richten Sie zuerst einen Eingabeendpunkt ein und erstellen Sie dann eine Kanalressource, die den SRT- oder RTMP-Livebeitragsstream in einen HLS- oder DASH-Ausgabestream transcodiert. Von der Live Stream API erstellte Ausgabestreams werden in Cloud Storage-Buckets gespeichert, die als Back-End für Cloud CDN konfiguriert werden können.

Anleitungen

Livestream mit der Live Stream API transcodieren

Die Live Stream API transcodiert Mezzanine-Live-Signale automatisch in Direct-to-Consumer-Streamingformate, einschließlich HLS und MPEG-DASH. Richten Sie zuerst einen Eingabeendpunkt ein und erstellen Sie dann eine Kanalressource, die den SRT- oder RTMP-Livebeitragsstream in einen HLS- oder DASH-Ausgabestream transcodiert. Von der Live Stream API erstellte Ausgabestreams werden in Cloud Storage-Buckets gespeichert, die als Back-End für Cloud CDN konfiguriert werden können.

Videoanzeigen für VOD

Anzeigen mit der Video Stitcher API in VOD-Inhalte einfügen

Fügen Sie Anzeigen, die auf Ad-Servern gespeichert und durch Metadaten beschrieben werden, in VOD-Inhalte ein. Dadurch werden Monetarisierungsstrategien für VOD-Inhalte nahtlos unterstützt. Die Video Stitcher API unterstützt die folgenden Formate, die mit dem Common Media Application Format (CMAF) konform sind (HTTP Live Streaming (HLS)) und Dynamic Adaptive Streaming over HTTP (DASH) als Standard-Streaming mit adaptiver Bitrate. Nach dem Aufruf erstellt die API eine neue VOD-Sitzung, in der die Wiedergabe-URL und Informationen zu den in das Video eingefügten Anzeigen angegeben werden.

Anleitungen

Anzeigen mit der Video Stitcher API in VOD-Inhalte einfügen

Fügen Sie Anzeigen, die auf Ad-Servern gespeichert und durch Metadaten beschrieben werden, in VOD-Inhalte ein. Dadurch werden Monetarisierungsstrategien für VOD-Inhalte nahtlos unterstützt. Die Video Stitcher API unterstützt die folgenden Formate, die mit dem Common Media Application Format (CMAF) konform sind (HTTP Live Streaming (HLS)) und Dynamic Adaptive Streaming over HTTP (DASH) als Standard-Streaming mit adaptiver Bitrate. Nach dem Aufruf erstellt die API eine neue VOD-Sitzung, in der die Wiedergabe-URL und Informationen zu den in das Video eingefügten Anzeigen angegeben werden.

Videoanzeigen für Livestreams

Anzeigen in einen Livestream einfügen

Ähnlich wie bei VOD werden Anzeigen über die Video Stitcher API dynamisch in den Livestreamcontent eingefügt. Dies wird anhand von auf Ad-Servern gespeicherten Metadaten beschrieben. Die Video Stitcher API unterstützt die folgenden Formate, die mit dem Common Media Application Format (CMAF) konform sind (HTTP Live Streaming (HLS)) und Dynamic Adaptive Streaming over HTTP (DASH) als Standard-Streaming mit adaptiver Bitrate. Nach dem Aufruf wird über die API eine neue Livesitzung erstellt, in der die Wiedergabe-URL und Informationen zu den in das Video eingefügten Anzeigen angegeben werden.

Anleitungen

Anzeigen in einen Livestream einfügen

Ähnlich wie bei VOD werden Anzeigen über die Video Stitcher API dynamisch in den Livestreamcontent eingefügt. Dies wird anhand von auf Ad-Servern gespeicherten Metadaten beschrieben. Die Video Stitcher API unterstützt die folgenden Formate, die mit dem Common Media Application Format (CMAF) konform sind (HTTP Live Streaming (HLS)) und Dynamic Adaptive Streaming over HTTP (DASH) als Standard-Streaming mit adaptiver Bitrate. Nach dem Aufruf wird über die API eine neue Livesitzung erstellt, in der die Wiedergabe-URL und Informationen zu den in das Video eingefügten Anzeigen angegeben werden.

Video Intelligence für VOD

VOD-Inhalte mit der Video Intelligence API annotieren

Mit der Video Intelligence API können Entwickler die Videoanalysetechnologie von Google in ihre Anwendungen einbinden. Vortrainierte Modelle für maschinelles Lernen erkennen in gespeicherten und gestreamten Videos automatisch eine Vielzahl von Objekten, Orten und Aktionen. Mit der REST API können Nutzer Videos, die lokal oder in Cloud Storage gespeichert sind, mit Kontextinformationen zu dem gesamten Video, pro Segment, pro Aufnahme und pro Frame versehen.

Anleitungen

VOD-Inhalte mit der Video Intelligence API annotieren

Mit der Video Intelligence API können Entwickler die Videoanalysetechnologie von Google in ihre Anwendungen einbinden. Vortrainierte Modelle für maschinelles Lernen erkennen in gespeicherten und gestreamten Videos automatisch eine Vielzahl von Objekten, Orten und Aktionen. Mit der REST API können Nutzer Videos, die lokal oder in Cloud Storage gespeichert sind, mit Kontextinformationen zu dem gesamten Video, pro Segment, pro Aufnahme und pro Frame versehen.

Video Intelligence für Livestreams

Liveinhalte mit der Video Intelligence API annotieren

Die Video Intelligence API ermöglicht die Streaminganalyse von Live-Medien in Echtzeit. Vortrainierte Modelle für maschinelles Lernen erkennen in gespeicherten und live gestreamten Videos automatisch eine Vielzahl von Objekten, Orten und Aktionen. Mit der REST API können Nutzer Videos kommentieren, die in Cloud Storage gespeichert sind oder live gestreamt werden. Außerdem unterstützt sie standardmäßige Livestreaming-Protokolle wie RTSP, RTMP und HLS. Kontextinformationen werden für das gesamte Video, pro Segment, pro Aufnahme und pro Frame zur Verfügung gestellt.

Anleitungen

Liveinhalte mit der Video Intelligence API annotieren

Die Video Intelligence API ermöglicht die Streaminganalyse von Live-Medien in Echtzeit. Vortrainierte Modelle für maschinelles Lernen erkennen in gespeicherten und live gestreamten Videos automatisch eine Vielzahl von Objekten, Orten und Aktionen. Mit der REST API können Nutzer Videos kommentieren, die in Cloud Storage gespeichert sind oder live gestreamt werden. Außerdem unterstützt sie standardmäßige Livestreaming-Protokolle wie RTSP, RTMP und HLS. Kontextinformationen werden für das gesamte Video, pro Segment, pro Aufnahme und pro Frame zur Verfügung gestellt.