CAE ソリューション - 概要

Google Cloud の HPC プラットフォームは、要求の厳しい CAE ワークフロー向けのパワフルでスケーラブルなプラットフォームを提供します。従来の HPC システムのパフォーマンスと、グローバル スケール、弾力性、柔軟性に優れたクラウドのメリットを兼ね備えています。

- スケーラビリティ: Google Cloud の弾力性のあるインフラストラクチャにより、ユーザーは CAE ワークロードをオンデマンドでスケールアップまたはスケールダウンでき、変動するコンピューティング ニーズに柔軟に対応できます。

- パフォーマンス: Google Cloud の最新世代の CPU と GPU と高性能ネットワーキングを組み合わせることで、CAE シミュレーションを効率的に実行し、ターンアラウンド タイムを最小限に抑え、設計のイテレーションを加速できます。

- 柔軟性: Google Cloud は、さまざまな CAE アプリケーションやワークロードに最適化された幅広い VM インスタンスを提供しており、ユーザーは特定のニーズに最適なコンピューティング リソースを選択できます。

- Ease-of-use: Google の CAE ソリューションを使用すると、シミュレーションや分析を高速化することで、簡単に使い始めることができ、変革の力を体験できます。

CAE ワークロードのリファレンス アーキテクチャ

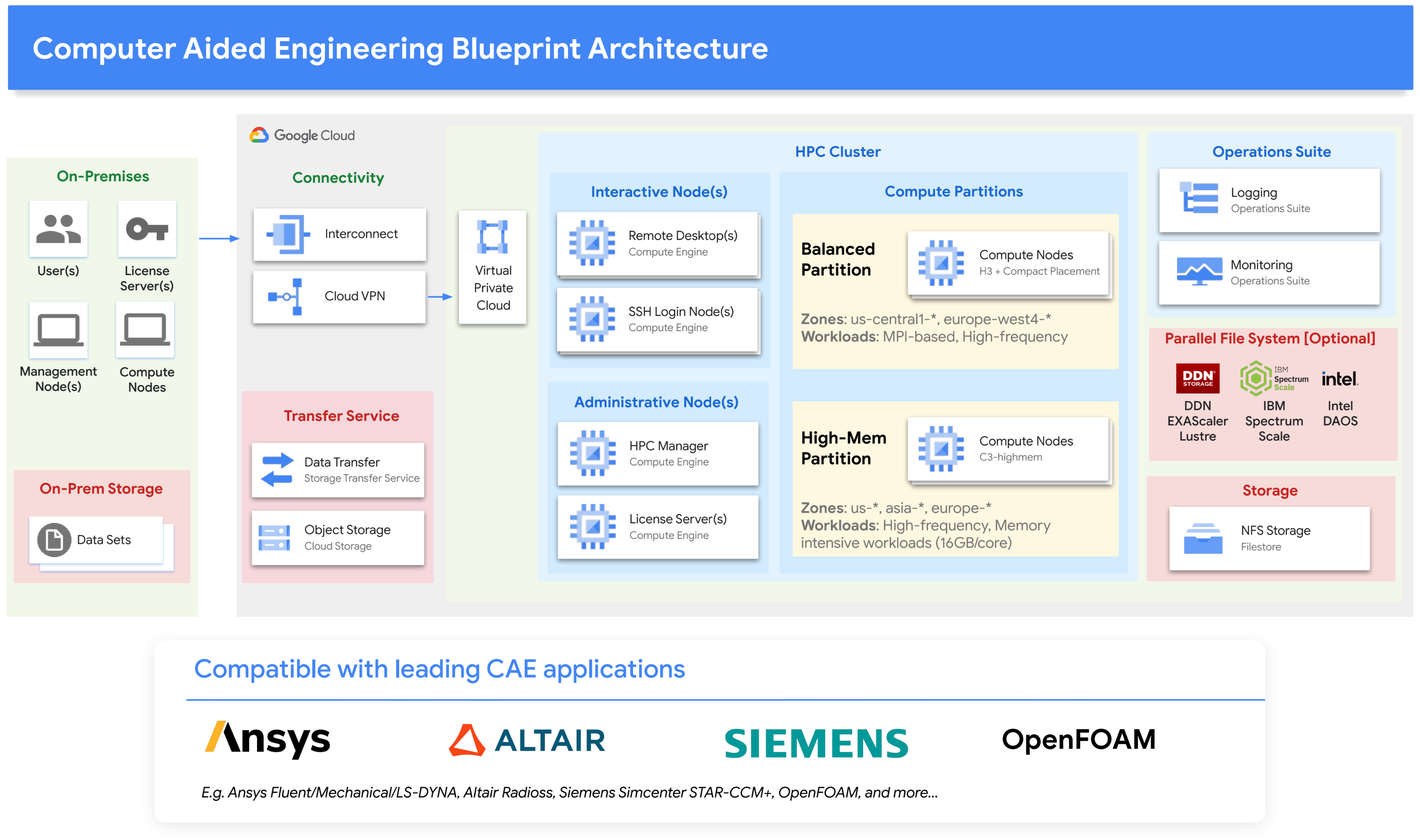

CAE ワークフローでの Google Cloud の使用を簡素化するために、計算負荷の高い CAE ワークロードの要件を満たす適切なクラウド コンポーネントを構築しました。具体的には、CAE ソリューションは、最新の Intel Xeon プラットフォームに基づく Google Cloud の H3 VM ファミリーと C3 VM ファミリーを中心に構築されています。これらの VM ファミリーは、メモリとフロップのバランスが取れた高いメモリ帯域幅を提供します。これは CAE に最適です。このソリューションは、密結合の MPI アプリケーションや、最大 16 GB/コアのメモリを必要とするワークロードにも対応します。幅広い IO 要件に対応するさまざまなストレージ オプションが含まれています。リソース管理については、SchedMD の Slurm や Altair の PBS Professional などのスケジューラをサポートしています。

次のアーキテクチャ図は、このソリューションを示しています。

ソリューション コンポーネント

CAE ソリューションのアーキテクチャは、コンピューティング、ネットワーキング、ストレージ、Google のオープンソース Cloud HPC Toolkit など、いくつかの主要コンポーネントで構成されています。

コンピューティング

CAE ソリューションは Google Compute Engine 上に構築されています。Compute Engine には、GPU 搭載のマシンタイプを含め、さまざまなマシンタイプが用意されています。Compute Engine は、特殊な VM タイプと高性能なネットワーキングのために、高いパフォーマンスと柔軟性を必要とする CAE ワークロードに適しています。

H3 VM: CAE ワークロードに適したバランス パーティションが、コアあたり 4 GB、最大数千のコア数(MPI 経由))の Intel の最新の Sapphire Rapids を使用して Google の HPC VM から構築されます。

C3 VM: メモリ使用量の多い CAE ワークロードに適したハイメモリ パーティションは、Intel の最新の Sapphire Rapids 世代(16 GB/コア)を使用して Google の C3 VM から構築されています。

プレースメント ポリシー: プレースメント ポリシーを使用すると、VM が互いに近接して作成されるため、VM 間の通信レイテンシが短縮され、全体的なパフォーマンスが向上します。

HPC VM イメージ: 最適なパフォーマンスを実現するために、Google Cloud でのパフォーマンスを最適化するために標準の Linux オペレーティング システムのディストリビューションを構成する HPC VM イメージが用意されています。

汎用 VM: ログインノード、ライセンス サーバー、その他のタスク用。

リモート デスクトップ VM - リモート デスクトップ セッションとリモート可視化用。

ネットワーキング

Google Virtual Private Cloud: Google VPC は、プロジェクト用の物理ネットワークを仮想化したサービスです。

Google Cloud の接続: Google Cloud の接続を使用すると、オンプレミス ネットワークを高可用性かつ低レイテンシで Google Cloud に接続して拡張できます。

Google Cloud VPN: Google Cloud VPN は、ピア ネットワークを Virtual Private Cloud(VPC)ネットワークに安全に接続します。

gVNIC: Google Virtual NIC は、コンピューティング VM 間で高パフォーマンスと低レイテンシを提供する仮想ネットワーク インターフェース カード(NIC)です。gVNIC は、高いネットワーク パフォーマンスを必要とする CAE ワークロードに適しています。

ストレージ

Google Filestore: Filestore は、高パフォーマンスと低レイテンシを提供するフルマネージド NFS サービスです。Filestore は、アプリケーションやホーム ディレクトリなど、ネットワーク全体で共有されるデータや表示する必要のあるデータに適しています。

並列ファイル システム: Google Cloud は多くのストレージ ベンダーと提携して、HPC ワークロード用にさまざまな並列ファイル システムを提供しています。これらのパートナーには、NetApp、DDN EXAScaler、Sycomp Spectrum Scale、Weka などがあります。

Google Storage Transfer Service: マネージドの Storage Transfer Service を使用すると、Google Cloud、Amazon、Azure、オンプレミスなどにまたがるファイル ストレージとオブジェクトとの間で、迅速かつ安全にデータを転送できます。

Google Cloud Storage: Cloud Storage は、スケーラブルで耐久性のあるオブジェクト ストレージ サービスです。Cloud Storage は、大量のデータの保存に適しています。また、データ転送にも適しています。

ツール

Google Cloud HPC Toolkit - Google のオープンソースの Cloud HPC Toolkit を使用すると、お客様やパートナーは Google Cloud の HPC ベスト プラクティスに従って再現可能なターンキー HPC 環境を簡単にデプロイできます。Google の CAE ソリューションには、Google Cloud で HPC 環境を簡単にインスタンス化して CAE ワークロードを実行できるようにする HPC Toolkit ブループリントが付属しています。

Google Cloud で CAE を使ってみる

クラウドで CAE ワークロードを実行する際の考慮事項

CAE ワークロードをクラウドで実行する場合、次のような多くの要素を考慮する必要があります。

- 互換性: CAE アプリケーションがクラウドベースの HPC 環境との互換性についてテストされていることを確認します。

- VM の選択: ISV ソフトウェアを最適に実行する適切な VM タイプを選択します。多くの CAE ワークロードは、大量のメモリ帯域幅と全体的な FLOP とメモリ帯域幅のバランスの取れたコンピューティング アーキテクチャに適しています。

- スケーラビリティ: 大規模な CAE ワークロードは複数の VM で実行する必要があり、MPI と VM の高密度デプロイのサポートが必要であることを考慮してください。

- スループット: 同時に実行する必要があるワークロードの数を評価し、需要に応じてクラウド リソースを増減できる自動スケーリングのスケジューリング モデルを検討します。

- 費用: CAE 用の商用 ISV ソフトウェア パッケージは、多くの場合、「コア単位」でライセンスされます。これは総費用の重要な要素であり、VM タイプの選択に影響を与えます。

- 使用/消費: クラウドは、オンプレミスのインストールでは実現できない弾力性を提供します。オンデマンドと確約利用の適切なバランスを検討したり、Spot VM を特定したりすることもできます。

- 使いやすさ: 使用するクラウド HPC ソリューションが使いやすく、管理しやすいことを確認してください。

汎用 CAE リファレンス ブループリント

Google Cloud CAE ソリューションの一部として、汎用 CAE リファレンス アーキテクチャおよびブループリントを開発しました。これは、Google Cloud に CAE アーキテクチャをプロビジョニングするために Google の Cloud HPC Toolkit と簡単に使用できるものです。Google は、次のような主要な ISV アプリケーションの互換性とパフォーマンスを検証済みです。

- Ansys Fluent

- Ansys メカニカル

- Ansys LS-DYNA

- Siemens Simcenter STAR-CCM+

- Altair RadiOSs

- OpenFOAM

これらのソフトウェア パッケージのパフォーマンスについては、以下のベンチマーク セクションをご覧ください。

汎用 CAE リファレンス アーキテクチャ ブループリントを使用すると、幅広い CAE アプリケーションやワークフローと互換性のあるクラウド環境を即座に構築できます。CAE ソフトウェアを柔軟に選択し、独自の HPC 環境を管理したいユーザーに適しています。また、Google Cloud で CAE シミュレーションを実行するための Google のベスト プラクティスを活用した、システム インテグレータの出発点にもなります。

アプリケーション固有のブループリント

Google Cloud には、一般的な CAE ソフトウェア用のアプリケーション固有のブループリントも数多く用意されています。これらのブループリントは、特定の CAE ソフトウェアに最適なパフォーマンスを提供するように事前構成されています。特定のブループリントを持つソフトウェアには、次のものがあります。

アプリケーション固有のブループリントは、CAE を迅速かつ簡単に使い始めたいと考えているユーザーにとっては優れたオプションです。ブループリントは、特定の CAE ソフトウェア向けに最適化された事前構成済みの環境を提供するため、ユーザー自身で環境を構成する必要はありません。

パートナーのサービス

Google Cloud は、TotalCAE、Rescale、Parallel Works、Eviden Nimbix、Penguin Computing、NAG などの数多くの HPC-as-a-Service プロバイダと提携しており、Altair などの CAE ISV ベンダーとも提携しています。これらのプロバイダは、事前構成された CAE ソフトウェア環境、特定の CAE アプリケーションのサポート、専門家によるコンサルティング サービスなど、CAE 向けのさまざまなマネージド HPC ソリューションを提供しています。これらのサービスは、CAE 向けのマネージド HPC ソリューションを必要とするユーザーに適しています。プロバイダは、事前構成済みの CAE ソフトウェア環境、特定の CAE アプリケーションのサポート、専門家によるコンサルティング サービスなど、さまざまなサービスを提供しています。

アーキテクチャの代替とベスト プラクティス

Google Compute Engine、Google Kubernetes Engine、Google Batch。

CAE ソリューションは Google Compute Engine 上に構築されていますが、Google Kubernetes Engine や Google Batch などの他のコンピューティング フレームワーク上に構築することもできます。Kubernetes Engine は、コンテナ化された環境で CAE ワークロードを実行するために使用できるマネージド Kubernetes サービスです。Kubernetes Engine は、スケーラビリティとポータビリティを必要とする CAE ワークロードに適しています。Google Batch は、バッチジョブを実行するためのマネージド サービスです。Batch はコンテナ化されておらず、大幅なカスタマイズやチューニングが不要な CAE ワークロードに適しています。

HPC 環境の設計について詳しくは、Cluster Toolkitのテクニカル ガイドをご確認ください。この技術ガイドには、インフラストラクチャ(コンピューティング、ネットワーク、ストレージ)、システム ソフトウェア(スケジューラ、ストレージ)、アーキテクチャに関する考慮事項の幅広いオプションが説明されています。

ベスト プラクティス

Google Cloud 上の CAE ワークロードのパフォーマンスを最適化するために従うべきベスト プラクティスは多数あります。たとえば、プレースメント ポリシーを使用して、ワークロードが互いに近いコンピューティング リソースに配置されるようにすることができます。これにより、レイテンシが短縮され、パフォーマンスが向上します。また、Cloud HPC Toolkit を使用してワークロードを最適化することもできます。

MPI のパフォーマンスを改善する方法については、HPC ワークロードを実行するためのベスト プラクティスをご覧ください。Open MPI と Intel MPI はどちらも、Google Cloud の HPC ネットワーキング エンジニアの協力を得て、Google Cloud のパフォーマンスに合わせて調整および最適化されています。

ベンチマーク

一般的な CAE 環境ブループリントとその H3 VM は、主要な CAE ISV アプリケーションについて、標準ベンチマーク モデルでベンチマークされています。

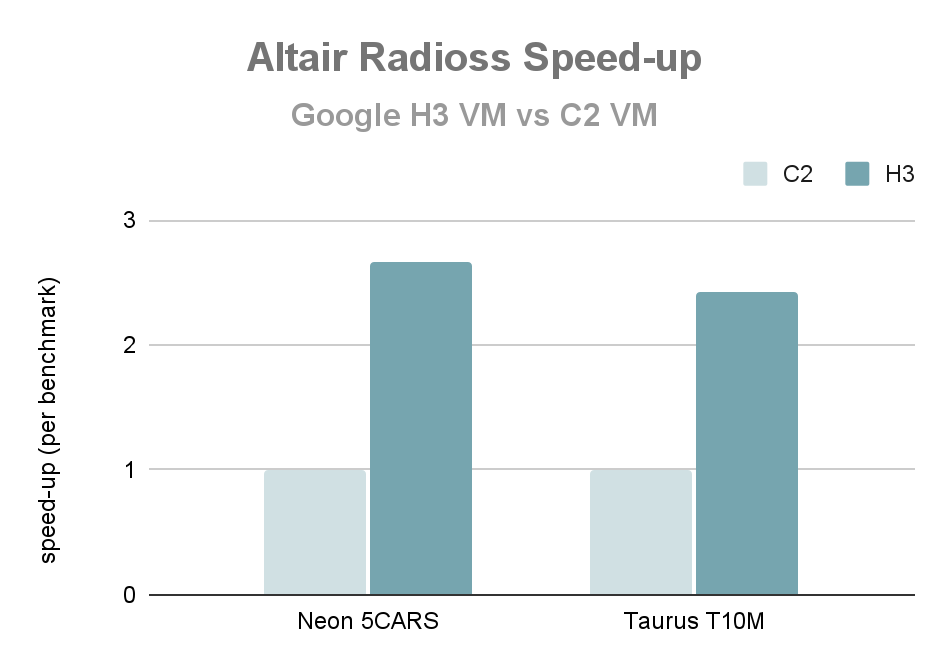

単一ノードのパフォーマンス: Altair Radioss

以下のグラフは、H3 VM 上で Altair Radioss 2022.3 を実行した場合の単一ノードのパフォーマンスを、C2 VM(いずれの場合も VM 全体)と比較したものです。Altair Radioss で一般的に使用されている 2 つのベンチマーク(Neon 5CARS と T10M)と比べて速度は 2.6 倍です。

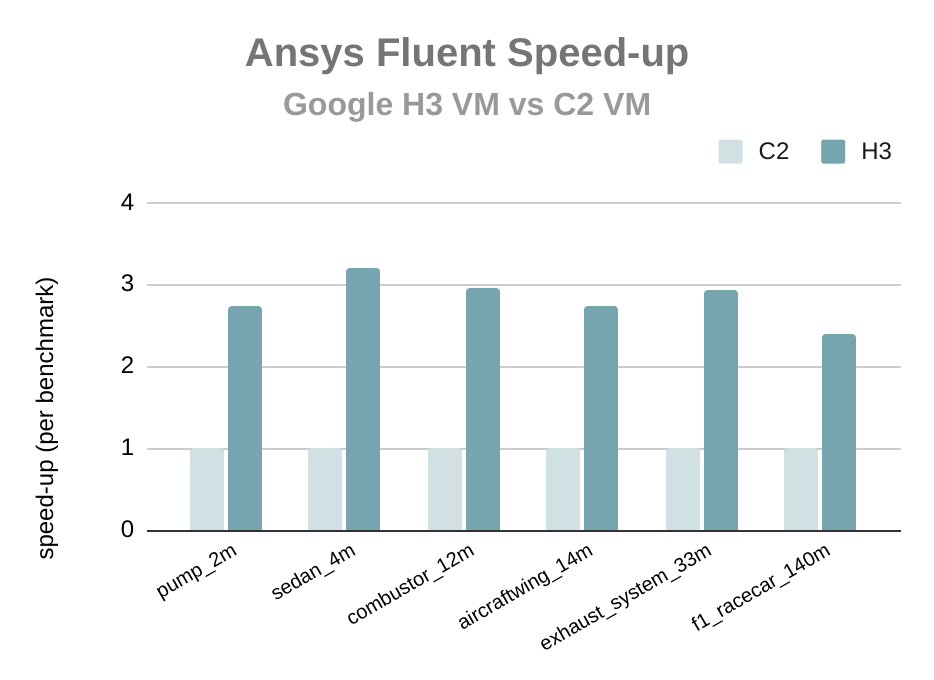

単一ノードのパフォーマンス: Ansys Fluent

次のグラフは、H3 VM 上で Ansys Fluent 2022 R2 を実行した場合のパフォーマンスを、CAE ソリューション ブループリントを使用した C2 VM と比較した場合のパフォーマンスを示しています(いずれの場合も VM 全体)。Ansys Fluent の一般的なベンチマークよりも処理速度が 2.8 倍向上し、Google H3 プラットフォームが計算流体力学のワークロードに非常に適していることを示しています。

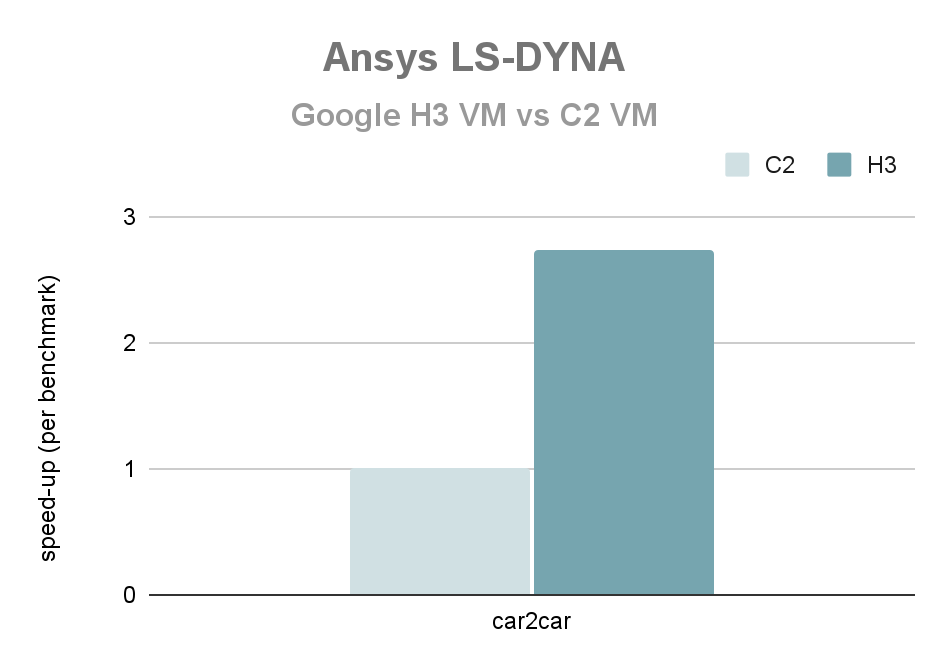

単一ノードのパフォーマンス: Ansys LS-DYNA

次のグラフは、H3 VM 上で Ansys LS-DYNA R9.3.1 を実行した場合の単一ノードのパフォーマンスを、C2 VM(いずれの場合も VM 全体)と比較して示しています。Ansys LS-DYNA の car2car クラッシュ ベンチマークの高速化は 2.7 倍

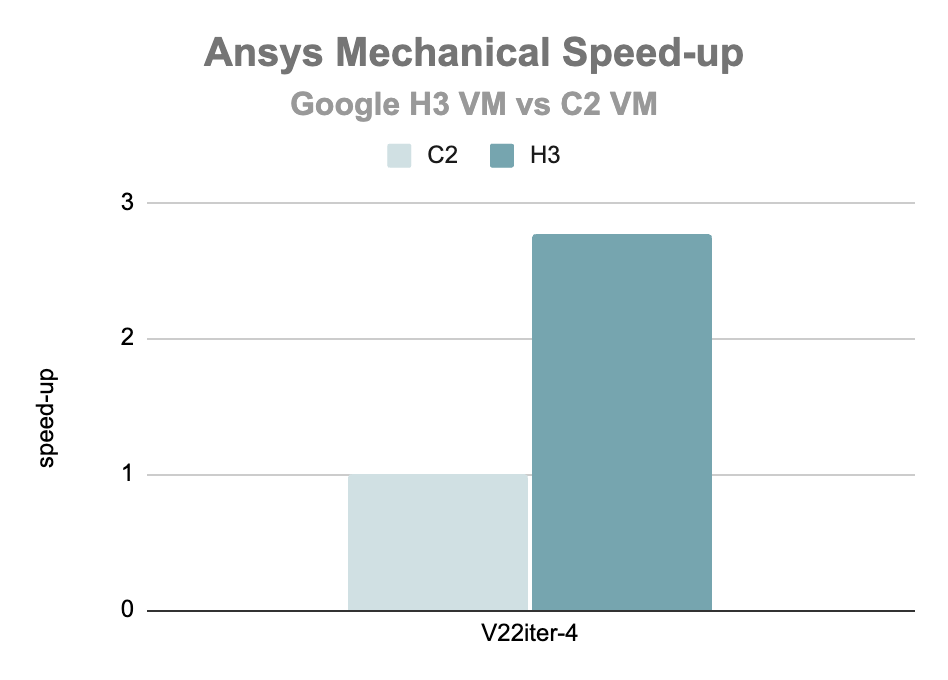

単一ノードのパフォーマンス: Ansys Mechanical

次のグラフは、H3 VM 上で Ansys Mechanical 2022 R1 を実行した場合の単一ノードのパフォーマンスを、C2 VM(いずれの場合も VM 全体)と比較して示しています。Ansys Mechanical の V2iter-4 ベンチマークの高速化は 2.8 倍です。

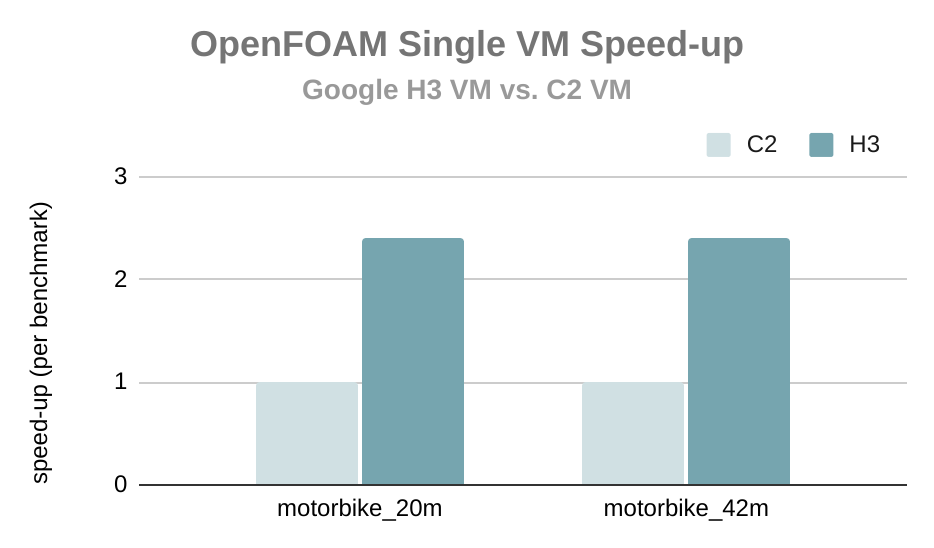

単一ノードのパフォーマンス: OpenFOAM

次のグラフは、H3 VM 上で OpenFOAM Foundation の OpenFOAM v7 を実行した場合の単一ノードのパフォーマンスを、C2 VM(いずれの場合も VM 全体)と比較して示しています。OpenFOAM の一般的に使用されているベンチマークと比較した高速化は 2.4 倍です。

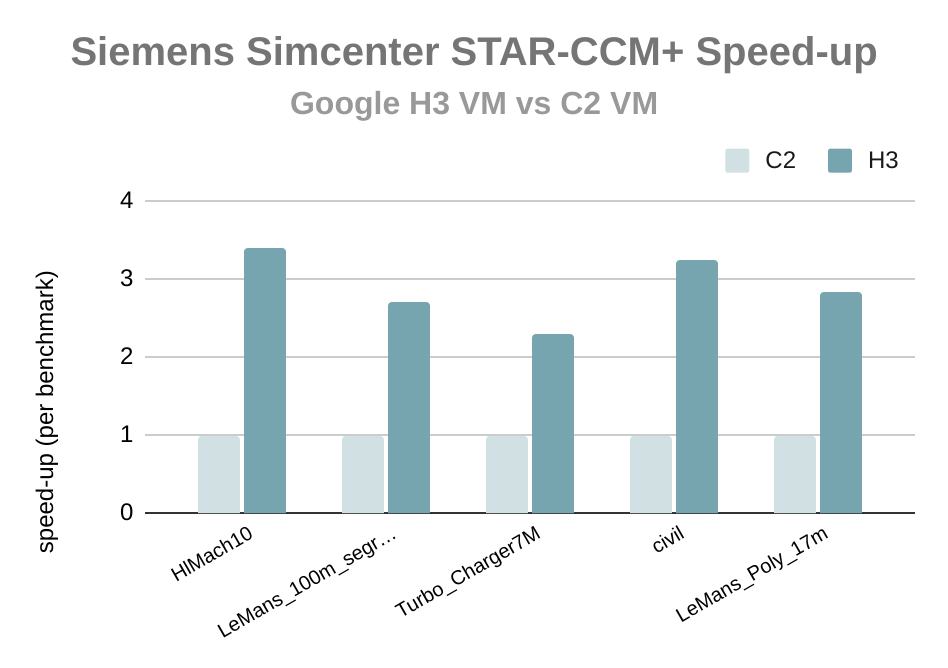

単一ノードのパフォーマンス: Siemens Simcenter STAR-CCM+

次のグラフは、H3 VM 上で Siemens Simcenter STAR-CCM+ 18.02.008 を実行した場合の単一ノードのパフォーマンスを、C2 VM(いずれの場合も VM 全体)と比較して示しています。Siemens Simcenter STAR-CCM+ の一般的に使用されているベンチマークと比較した高速化は 2.9 倍です。

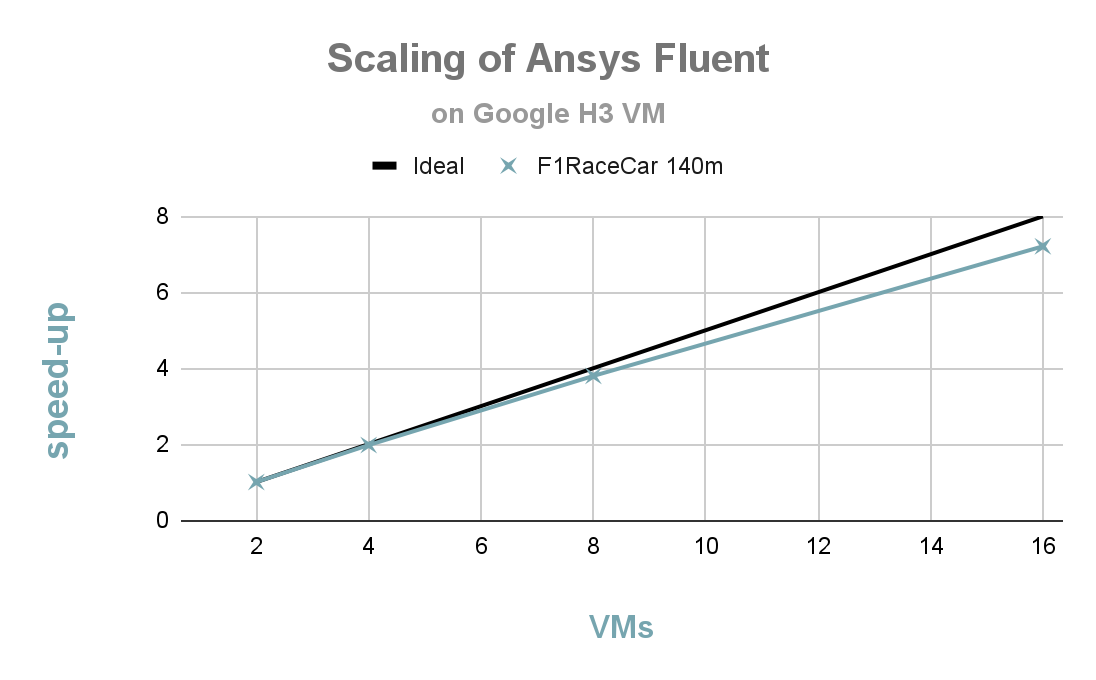

強力なスケーリング: Ansys Fluent

次のグラフは、H3 VM を使用した F1 RaceCar(140m)ベンチマークでの Ansys Fluent 2022 R2 の強力なスケーリング動作を示しています。2 ノードから 16 ノードへの優れたスケーリングが確認できます。16 ノード(1, 408 コア)での並列効率は 90% を超えています。

CAE ワークロードに対する Google Cloud のメリット

CAE ワークロードの実行に関して Google Cloud には、次のような多くのメリットがあります。

パフォーマンス

Google Cloud の HPC インフラストラクチャは、CAE ワークロードに高いパフォーマンスを提供するように設計されています。最新の CPU と GPU を利用できます。また、ネットワーク インフラストラクチャは低レイテンシを実現するように設計されています。

スケーラビリティ

スケーラビリティ

Google Cloud の HPC インフラストラクチャは、スケーラビリティを考慮して設計されています。CAE ワークロードは必要に応じてスケールアップまたはスケールダウンでき、リソースを迅速かつ簡単に追加または削除できます。

柔軟性

柔軟性

Google Cloud の HPC インフラストラクチャは、柔軟性を考慮して設計されています。CAE ワークロードは、さまざまなコンピューティング オプションで実行でき、さまざまなストレージ オプションが利用できます。

使いやすさ

使いやすさ

Google Cloud の HPC インフラストラクチャは、使いやすいように設計されています。Cloud HPC Toolkit は、Google Cloud 上での CAE ワークロードの最適化に使用できるツールとライブラリのセットを提供します。

費用対効果

費用対効果

Google Cloud の HPC インフラストラクチャは費用対効果を重視して設計されています。さまざまな料金オプションが用意されており、Spot VM を使用して費用を削減できます。

パフォーマンスとコストのさらなる最適化

適切なマシンタイプの選択

Google Cloud にはさまざまなマシンタイプがあり、それぞれ CPU、GPU、メモリの構成が異なります。ワークロードに適したマシンタイプを選択することにより、パフォーマンスと費用に大きな影響を与える場合があります。たとえば、H3 VM は、メモリ帯域幅とコアの比率が高いため、コアごとにライセンスされた CAE アプリケーションに適しています。また、コアあたり 4 GB の H3 VM は、多様なワークロードに十分なメモリを提供します。構造力学など、特にメモリ要求の厳しいワークロードの場合、ハイメモリ構成の C3 VM はコアあたり 16 GB を提供します。

適切なストレージの選択

Google Cloud にはさまざまなストレージ オプションがあり、それぞれパフォーマンスとコスト特性が異なります。ワークロードに適したストレージ オプションを選択することは、パフォーマンスと費用に大きな影響を与える可能性があります。HPC 環境では、考慮すべきストレージのタイプもいくつかあります。

一般的な HPC 環境は、ホーム ストレージとスクラッチ ストレージという要件の異なる少なくとも 2 種類のストレージをホストします。それぞれのストレージ タイプの選択は、HPC ワークロードに固有のニーズによって異なります。たとえば、大量のスクラッチ データを生成するワークロードには高パフォーマンスのスクラッチ ストレージ ソリューションが必要で、複数のコンピューティング ノードにまたがって共通のデータに同時にアクセスするワークロードには並列ファイル システムが必要になる場合があります。特定の HPC ワークロードに適したストレージ タイプは、ワークロード固有のニーズによって異なります。

HPC 環境では、ホーム ストレージやスクラッチ ストレージに加えて、頻繁にアクセスされないデータの保存に使用されるアーカイブ ストレージなど、他のタイプのストレージが使用されることがあります。Archive Storage は、Cloud Storage によって最も費用対効果の高い方法で提供されます。

ホーム ストレージ

ホーム ストレージは通常、構成、スクリプト、後処理データなど、共有ユーザー ファイル(主に「/home」ディレクトリ)を保存するために使用されます。このストレージはクラスタ全体の同じ場所にマウントされ、この名前空間への共通アクセスを許可されます。通常、ホーム ストレージは永続的です。通常、ホーム ストレージは NFS プロトコルに基づいて構築されます。

Google Cloud HPC 環境では、Filestore などの Google サービスや、NetApp などのパートナー サービスによってホーム ストレージを提供できます。

- Google Cloud Filestore は、高パフォーマンスかつ低レイテンシでデータにアクセスできるフルマネージド ファイル ストレージ サービスです。Filestore は、頻繁にアクセスされるホーム ストレージ データの保存に適しています。

- NetApp Cloud Volumes Service は、データへの高パフォーマンスかつ低レイテンシのアクセスを提供するフルマネージド ファイル ストレージ サービスです。NetApp Cloud Volumes Service は、頻繁にアクセスされるホーム ストレージ データを保存する場合に適しています。

スクラッチ ストレージ

通常、スクラッチ ストレージは、中間結果やシミュレーション出力データなどの一時ファイルを保存するために使用されます。これらは、HPC 環境の異なるノード間で共有することも、共有しないこともできます。通常、スクラッチ ストレージは永続的ではありません。通常、スクラッチ ストレージは、ローカル フラッシュ ストレージや並列ファイル システムなど、ホーム ストレージよりも高性能のストレージ システム上に構築されます。

Google Cloud HPC 環境では、Persistent Disk、ローカル SSD、Cloud Filestore、Parallelstore などの Google サービス、または NetApp、DDN EXAScaler、Sycomp、Weka などのパートナー サービスによってスクラッチ ストレージを提供できます。

- Google Cloud Persistent Disk は、データへの高パフォーマンスかつ低レイテンシのアクセスを実現するブロック ストレージ サービスです。Persistent Disk を使用すると、HPC クラスタのユーザーごとにスクラッチ ディレクトリを作成できます。

- Google Cloud のローカル SSD は、一部の Compute Engine マシンタイプで利用可能なローカル SSD ストレージ オプションです。ローカル SSD を使用すると、HPC クラスタのユーザーごとにスクラッチ ディレクトリを作成できます。

- Google Cloud Filestore は、データへの高パフォーマンスかつ低レイテンシのアクセスを提供するフルマネージド NFS ファイル ストレージ サービスです。Filestore を使用すると、HPC クラスタ上のユーザーごとにスクラッチ ディレクトリを作成できます。

- Google Cloud Parallelstore は、HPC ワークロード用に最適化された高性能並列ファイル システムです。Parallelstore を使用すると、HPC クラスタ上のユーザーごとにスクラッチ ディレクトリを作成できます。

- NetApp Cloud Volumes Service は、データへの高パフォーマンスかつ低レイテンシのアクセスを提供するフルマネージド ファイル ストレージ サービスです。NetApp Cloud Volumes Service を使用すると、HPC クラスタ上のユーザーごとにスクラッチ ディレクトリを作成できます。

- DDN EXAScaler Cloud は、HPC ワークロード用に最適化された高性能並列ファイル システムです。DDN EXAScaler Cloud を使用すると、HPC クラスタに単一または複数のスクラッチ ディレクトリを作成できます。

- WekaIO Matrix は、HPC ワークロード用に最適化された高性能並列ファイル システムです。WekaIO Matrix を使用すると、HPC クラスタ上のユーザーごとにスクラッチ ディレクトリを作成できます。

Spot VM

Spot VM は、CAE ワークロードを実行するための費用対効果の高い方法になり得ます。Spot VM は割引価格で利用できますが、短期間でいつでも終了できます。Spot VM は、標準インスタンスのコストを最大 91% 割引でき、GPU やローカル SSD など、HPC ユーザーが期待する機能をサポートします。

ワークフローが中断の可能性(プリエンプション)を許容できる場合、アプリケーションを比較的短い時間(4 時間未満)で実行できる場合は、Spot モデルをテストすることをおすすめします。お客様は、オンデマンドと比べて最大 90% の費用削減を実現でき、軽微な中断を許容できる程度に節約できることを実感しています。

H3 などの特定の VM タイプは Spot をサポートしていません。

事例紹介

AirShaper

AirShaper は、空気力学のオンライン プラットフォームです。これを使用すると、設計者やエンジニアは完全に自動化された方法で空気の流れのシミュレーションを実行できます。空気力学の専門知識のないユーザーでも、信頼性の高い結果を得て設計を改善できます。

AirShaper は、HPC 計算流体力学(CFD)ワークロードを古い VM プラットフォームから新しい C2D VM ファミリーに移行しました。これにより、以前のクラウド環境と比較して、シミュレーション時間とワークロード実行あたりの費用が削減され、オンプレミス環境と比較して、結果を得るまでの時間が大幅に短縮されました。

「AirShaper では、CFD シミュレーションを定額料金で提供しています。通常は、コアの数が多いほど、そしてコアが高速なほど、総費用は高くなり、その原因の一つにはスケーリングの問題があります。しかし H3 では、シミュレーション時間を 2 分の 1 に短縮することができ、そのうえ総費用も低下するのには驚きました。」

- Airshaper、CEO、Wouter Remmerie 氏

費用を約 50% 削減 | オンプレミスのインスタンスと比較して、シミュレーション時間を 3 分の 1 以上短縮 | 前世代のハイ パフォーマンス コンピューティング インスタンスと比較してシミュレーション時間を 30% 短縮します |

費用を約 50% 削減

オンプレミスのインスタンスと比較して、シミュレーション時間を 3 分の 1 以上短縮

前世代のハイ パフォーマンス コンピューティング インスタンスと比較してシミュレーション時間を 30% 短縮します

Altair

Altair は、製品開発、ハイ パフォーマンス コンピューティング(HPC)、データ分析の分野でソフトウェアおよびクラウド ソリューションを提供するグローバル テクノロジー企業です。Altair のソフトウェアは、エンジニア、科学者、データ アナリストによって使用され、自動車、航空宇宙、製造、エネルギーなど、さまざまな業界の複雑な問題を解決しています。

Altair は Google Cloud パートナーであり、そのソフトウェアは Google Cloud で利用できます。Altair のソフトウェアは Google Cloud 用に最適化されており、Google Cloud のパフォーマンス、スケーラビリティ、柔軟性を活用できます。Altair は、お客様が HPC 目標を達成できるよう支援することに尽力しており、HPC 向けの幅広いソフトウェア ソリューションを提供しています。その一つが有限要素分析ツールの RadiOSs です。Altair は、新しい H3 VM により、RadiOSs のクラウドベースのランタイムにおいて大幅な改善を実証しました。

「Altair で行った H3 の初期テストでは、Radioss ワークロードのシミュレーション実行時間が C2 と比較して最大 3 分の 1 に短縮されました。Google Cloud Platform での実行時間がこれほど大幅に短縮されると、両社に共通のお客様はエンジニアリングの生産性を高めることができるでしょう。」

- RadiOSs 開発および Altair Solver 担当シニア バイス プレジデント、Eric Lequiniou 氏

TotalCAE

TotalCAE は、エンジニアリングと科学アプリケーション向けのマネージド HPC ソリューションの大手プロバイダです。TotalCAE のソリューションは使いやすいように設計されており、お客様が成果を得るまでの時間を短縮し、費用を削減し、生産性を向上させることができるよう支援します。TotalCAE のソリューションは、複雑なエンジニアリングや科学の問題を解決するために、世界中のお客様が使用しています。たとえば、TotalCAE のソリューションは、航空機や自動車などの乗り物の設計とシミュレーション、建物や橋の性能の分析、新たな薬と治療法の開発に使用されています。

TotalCAE は Google Cloud パートナーであり、そのソリューションは Google Cloud での運用をサポートしています。TotalCAE のソリューションは Google Cloud 向けに最適化されており、Google Cloud のパフォーマンス、スケーラビリティ、柔軟性を活用できます。Google Cloud の HPC インフラストラクチャを使用することで、TotalCAE は顧客により良いパフォーマンスを低コストで提供できるようになりました。

「Google Cloud の H3 インスタンスのおかげで、CAE ワークロードのコアあたりのパフォーマンスが C2 より最大 25% 向上し、ジョブ費用も 50% 低下しました。これにより、GCP で CAE ワークロードを実行するお客様に最大 2.5 倍高いコスト パフォーマンスとスケーラビリティを提供できます。」

- TotalCAE CEO、Rodney Mach 氏

Google Cloud での CAE ワークロードの詳細

Google Cloud での HPC ワークロードと CAE ワークロードについては、他にも多くのメリットがあります。Google HPC チームメンバーへの相談にご興味をお持ちの場合、または Google Cloud の使用開始をご希望の場合は、お問い合わせください。それまでは Google Cloud のすべてのリソースで学習を継続してください。

開始にあたりサポートが必要な場合

お問い合わせ信頼できるパートナーと連携する

パートナーを探すもっと見る

すべてのプロダクトを見る