Exécuter des charges de travail d'ingénierie assistée par ordinateur sur Google Cloud

L'ingénierie assistée par ordinateur (IAO) englobe un large éventail d'applications, dont l'analyse structurelle, la dynamique des fluides, la sécurité en cas de plantage et l'analyse thermique, pour n'en citer que quelques-unes. Tous ces cas d'utilisation nécessitent d'importantes ressources de calcul pour gérer les simulations complexes de la physique impliquée, ainsi que des données d'entrée et de sortie potentiellement volumineuses. Dans ce guide de référence technique, nous expliquons comment exploiter Google Cloud pour accélérer les workflows IAO en fournissant des ressources de calcul hautes performances (HPC).

Solution CAE – En bref

La plate-forme HPC de Google Cloud offre une plate-forme puissante et évolutive pour les workflows IAO exigeants. Elle combine les performances des systèmes HPC traditionnels avec les avantages d'un cloud élastique et flexible à l'échelle mondiale :

- Évolutivité : l'infrastructure élastique de Google Cloud permet aux utilisateurs d'adapter (à la hausse ou à la baisse) leurs charges de travail CAE à la demande, en leur offrant la flexibilité nécessaire pour répondre à l'évolution des besoins en calcul.

- Performances : les processeurs et GPU de dernière génération de Google Cloud, associés à une mise en réseau hautes performances, garantissent l'efficacité des simulations IAO tout en réduisant les délais d'exécution et en accélérant les itérations de conception.

- Flexibilité : Google Cloud propose une large gamme d'instances de VM optimisées pour différentes applications et charges de travail IAO, ce qui permet aux utilisateurs de sélectionner les ressources de calcul les plus adaptées à leurs besoins spécifiques.

- Ease-of-use: : la solution CAE de Google vous permet de démarrer facilement et de profiter de la puissance de transformation des simulations et analyses accélérées.

Architecture de référence pour les charges de travail CAE

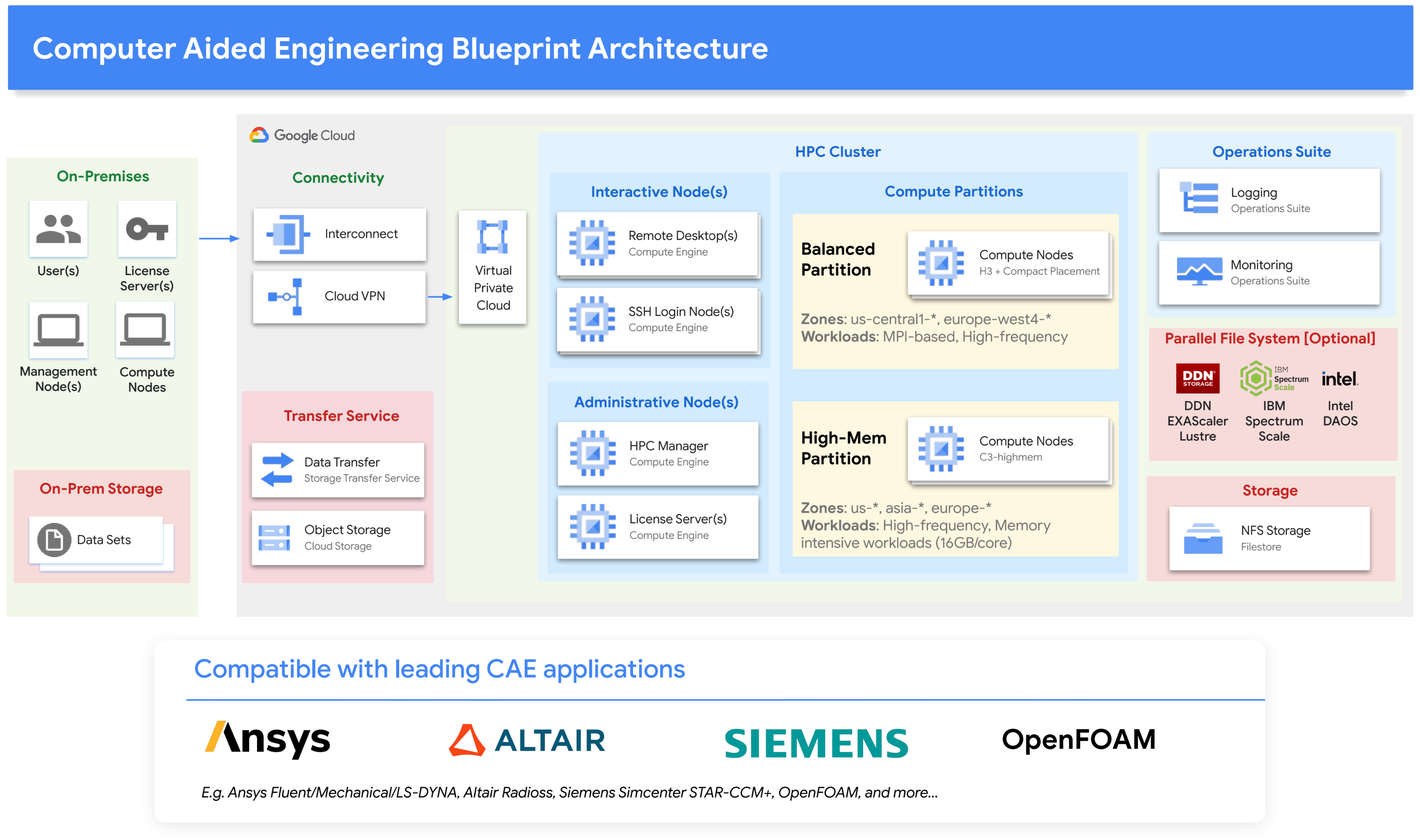

Afin de simplifier l'utilisation de Google Cloud pour les workflows IAO, nous avons rassemblé les composants cloud adaptés aux exigences des charges de travail IAO utilisant beaucoup de ressources de calcul. Plus précisément, notre solution IAO s'articule autour des familles de VM H3 et C3 de Google Cloud, et s'appuie sur la dernière plate-forme Intel Xeon. Ces familles de VM fournissent une bande passante mémoire élevée pour un ratio mémoire/flop équilibré, idéalement adapté à l'IAO. Cette solution est conçue pour les applications MPI à couplage fort, ainsi que pour les charges de travail exigeant jusqu'à 16 Go/cœur en mémoire. Elle inclut diverses options de stockage répondant à un large éventail d'exigences d'E/S. Pour la gestion des ressources, elle prend en charge les planificateurs tels que Slurm de SchedMD et PBS Professional d'Altair.

Le schéma d'architecture suivant illustre la solution :

Composants de la solution

L'architecture de la solution IAO est composée de plusieurs composants clés, y compris le calcul, la mise en réseau, le stockage, ainsi que le kit Open Source Cloud HPC Toolkit de Google.

Calcul

La solution IAO est basée sur Google Compute Engine. Compute Engine propose différents types de machines, y compris des types de machines avec GPU. Compute Engine est un bon choix pour les charges de travail CAE qui nécessitent des performances et une flexibilité élevées, en raison de ses types de VM spécialisés et de sa mise en réseau hautes performances :

VM H3 : une partition équilibrée adaptée aux charges de travail CAE est conçue à partir de la VM HPC de Google utilisant les derniers Sapphire Rapids d'Intel, avec 4 Go/cœur et jusqu'à des milliers de cœurs (via MPI).

VM C3 : une partition à haute capacité de mémoire, adaptée aux charges de travail IAO exigeantes en mémoire, est créée à partir de la VM C3 de Google utilisant la dernière génération Sapphire Rapids d'Intel avec 16 Go par cœur.

Règles d'emplacement : les stratégies d'emplacement garantissent que les VM sont créées à proximité les unes des autres, ce qui réduit la latence de communication entre les VM et améliore les performances globales.

Image de VM HPC : pour des performances optimales, nous fournissons des images de VM HPC qui configurent les distributions de systèmes d'exploitation Linux standards afin d'optimiser les performances sur Google Cloud.

VM à usage général : pour les nœuds de connexion, les serveurs de licences et les tâches diverses.

VM de bureau à distance : pour les sessions de bureau à distance et la visualisation à distance.

Mise en réseau

Cloud privé virtuel Google : le VPC Google est une version virtuelle d'un réseau physique pour votre projet.

Connectivité Google Cloud : la connectivité Google Cloud vous permet de connecter des réseaux sur site à Google Cloud et de les étendre avec une haute disponibilité et une faible latence.

Google Cloud VPN : Google Cloud VPN connecte en toute sécurité votre réseau de pairs à un réseau cloud privé virtuel (VPC).

gVNIC : la carte d'interface réseau virtuelle Google est une carte d'interface réseau qui offre des performances élevées et une faible latence entre les VM de calcul. gVNIC est un bon choix pour les charges de travail CAE qui nécessitent des performances réseau élevées.

Stockage

Google Filestore : Filestore est un service NFS entièrement géré qui offre de hautes performances et une faible latence. Filestore est idéal pour les données partagées ou qui doivent être visibles sur le réseau, telles que les applications ou les répertoires d'accueil.

Systèmes de fichiers parallèles : Google Cloud s'associe à un certain nombre de fournisseurs de stockage pour proposer divers systèmes de fichiers parallèles pour les charges de travail HPC. Parmi ces partenaires figurent NetApp, DDN EXAScaler, Sycomp Spectrum Scale et Weka.

Service de transfert de stockage de Google : le service de transfert de stockage géré permet de transférer des données de manière rapide et sécurisée entre les systèmes de stockage d'objets et de fichiers dans Google Cloud, Amazon, Azure, un environnement sur site, etc.

Google Cloud Storage : Cloud Storage est un service de stockage d'objets évolutif et durable. Cloud Storage est idéal pour stocker de grandes quantités de données ou en transférer.

Outils

Google Cloud HPC Toolkit : le Cloud HPC Toolkit Open Source de Google permet aux clients et aux partenaires de déployer facilement des environnements HPC clés en main reproductibles en suivant les bonnes pratiques HPC de Google Cloud. La solution CAE de Google est fournie avec un plan HPC Toolkit qui permet d'instancier facilement un environnement HPC dans Google Cloud, prêt à exécuter des charges de travail CAE.

Premiers pas avec CAE sur Google Cloud

Points à prendre en compte pour exécuter des charges de travail CAE dans le cloud

Lorsque vous exécutez des charges de travail CAE dans le cloud, vous devez prendre en compte un certain nombre de facteurs, y compris :

- Compatibilité : assurez-vous que la compatibilité des applications CAE avec l'environnement HPC dans le cloud a été testée.

- Sélection de VM : choisissez le type de VM qui exécute les logiciels d'éditeurs indépendants de manière optimale. De nombreuses charges de travail CAE se prêtent aux architectures de calcul avec une grande quantité de bande passante mémoire et un ratio global de bande passante flops:memory équilibré.

- Évolutivité : n'oubliez pas que les charges de travail CAE plus importantes peuvent nécessiter de s'exécuter sur plusieurs VM, ce qui nécessite la prise en charge de MPI et des déploiements denses des VM.

- Débit : évaluez le nombre de charges de travail à exécuter simultanément et envisagez des modèles de planification avec autoscaling pouvant augmenter ou réduire les ressources cloud en fonction de la demande.

- Coût : les packages logiciels d'éditeurs indépendants pour les applications CAE sont souvent sous licence "par cœur". Il s'agit d'un facteur important dans le coût total qui peut influencer le choix du type de VM.

- Utilisation/Consommation : le cloud offre une élasticité que l'installation sur site ne peut pas offrir, étudiez le bon équilibre entre l'utilisation à la demande et l'engagement d'utilisation, ou même les VM Spot.

- Facilité d'utilisation : assurez-vous que la solution cloud HPC que vous choisissez est facile à utiliser et à gérer.

Plan de référence de CAE à usage général

Dans le cadre de la solution IAO de Google Cloud, nous avons développé une architecture et un plan de référence d'outils IAO à usage général, que vous pouvez facilement utiliser avec Google Cloud HPC Toolkit pour provisionner l'architecture IAO dans Google Cloud. Nous avons vérifié la compatibilité et les performances de plusieurs applications d'éditeurs indépendants de premier plan, y compris les suivantes :

- Ansys Fluent

- Ansys Mechanical

- Ansys LS-DYNA

- Siemens Simcenter STAR-CCM+

- Altair Radioss

- OpenFOAM

Consultez la section ci-dessous sur les analyses comparatives pour connaître les performances de ces packages logiciels.

Le plan d'architecture de référence IAO à usage général permet aux utilisateurs de créer instantanément un environnement cloud compatible avec un large éventail d'applications et de workflows IAO. Il s'agit d'une bonne option pour les utilisateurs qui souhaitent être libres de choisir leur logiciel IAO et gérer leur propre environnement HPC. Il sert également de point de départ aux intégrateurs système et s'appuie sur les bonnes pratiques de Google pour exécuter des simulations IAO sur Google Cloud.

Plans spécifiques à l'application

Google Cloud propose également un certain nombre de plans spécifiques aux applications pour les logiciels CAE populaires. Ces plans sont préconfigurés pour fournir des performances optimales pour le logiciel IAO spécifique. Les logiciels avec des plans spécifiques incluent :

Les plans spécifiques aux applications constituent une bonne option pour les utilisateurs qui souhaitent commencer à utiliser l'outil IAO rapidement et facilement. Les plans fournissent un environnement préconfiguré qui est optimisé pour le logiciel CAE spécifique, de sorte que les utilisateurs n'ont pas à se soucier eux-mêmes de la configuration de l'environnement.

Offres des partenaires

Google Cloud s'associe à plusieurs fournisseurs HPC-as-a-Service, tels que TotalCAE, Rescale, Parallel Works, Eviden Nimbix, Penguin Computing et NAG, ainsi qu'à des fournisseurs d'éditeurs de solutions indépendants de CAE tels qu'Altair. Ces fournisseurs proposent diverses solutions HPC gérées pour CAE, y compris des environnements logiciels CAE préconfigurés, une assistance pour des applications CAE spécifiques et des services de conseil spécialisés. Ces offres constituent une bonne option pour les utilisateurs qui souhaitent bénéficier d'une solution HPC gérée pour la CAE. Les fournisseurs proposent une variété de services, y compris des environnements logiciels CAE préconfigurés, une assistance pour des applications CAE spécifiques et des services de conseil spécialisés.

Alternatives architecturales et bonnes pratiques

Google Compute Engine, Google Kubernetes Engine, Google Batch.

Bien que la solution IAO soit basée sur Google Compute Engine, il est également possible de la développer sur d'autres frameworks de calcul, tels que Google Kubernetes Engine ou Google Batch. Kubernetes Engine est un service Kubernetes géré qui permet d'exécuter des charges de travail IAO dans un environnement conteneurisé. Kubernetes Engine est un choix judicieux pour les charges de travail IAO reposant sur l'évolutivité et la portabilité. Google Batch est un service géré permettant d'exécuter des tâches par lot. Batch est idéal pour les charges de travail CAE qui ne sont pas conteneurisées et qui ne nécessitent pas de personnalisation ni de réglages importants.

Pour en savoir plus sur la conception d'environnements HPC, consultez notre guide technique sur le kit de clusters, qui couvre un large éventail d'options en matière d'infrastructure (calcul, réseau, stockage), de logiciels système (programmeurs, stockage) et de considérations architecturales.

Bonnes pratiques

Il existe un certain nombre de bonnes pratiques que vous pouvez suivre pour optimiser les performances de vos charges de travail CAE sur Google Cloud. Par exemple, vous pouvez utiliser des stratégies de placement pour garantir que vos charges de travail sont placées sur des ressources de calcul proches les unes des autres, ce qui peut réduire la latence et améliorer les performances. Vous pouvez également utiliser le kit Cloud HPC pour optimiser vos charges de travail.

Notre guide "Bonnes pratiques pour exécuter des charges de travail HPC" explique comment améliorer les performances MPI. Open MPI et Intel MPI ont été réglés et optimisés pour les performances de Google Cloud, en partenariat avec les ingénieurs réseau HPC de Google Cloud.

Benchmarks

Le plan d'environnement générique de CAE ainsi que sa VM H3 ont fait l'objet d'une analyse comparative pour les principales applications d'éditeurs indépendants de CAE sur leurs modèles de benchmark standards.

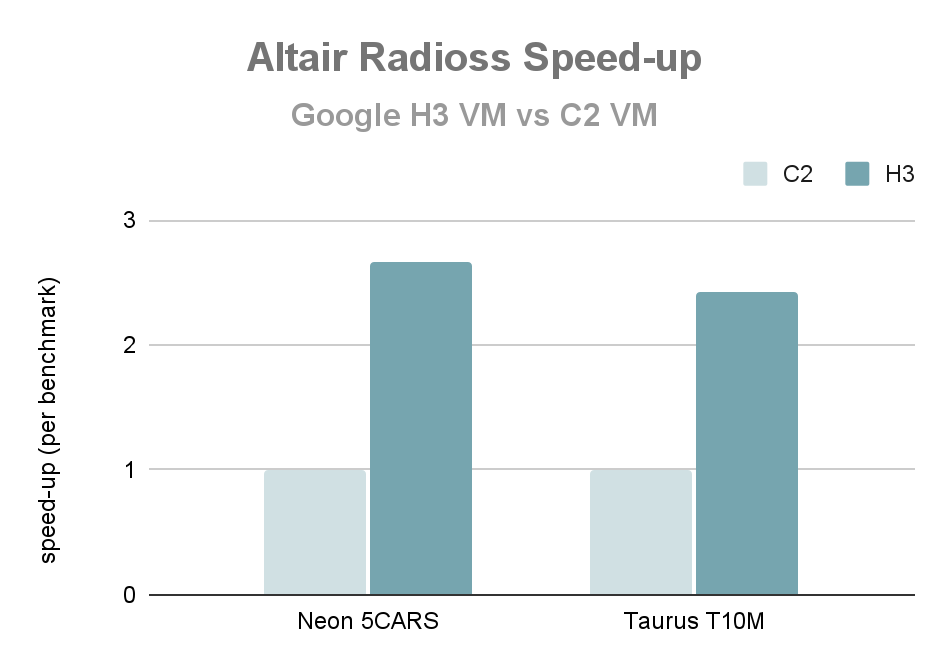

Performances sur nœud unique : Altair Radioss

Le graphique suivant montre les performances d'un nœud unique lors de l'exécution d'Altair Radioss 2022.3 sur la VM H3 par rapport à la VM C2 (VM entière dans chaque cas). La vitesse est multipliée par 2,6 par rapport à deux benchmarks communément utilisés (Neon 5CARS et T10M) pour les appareils Altair Radioss.

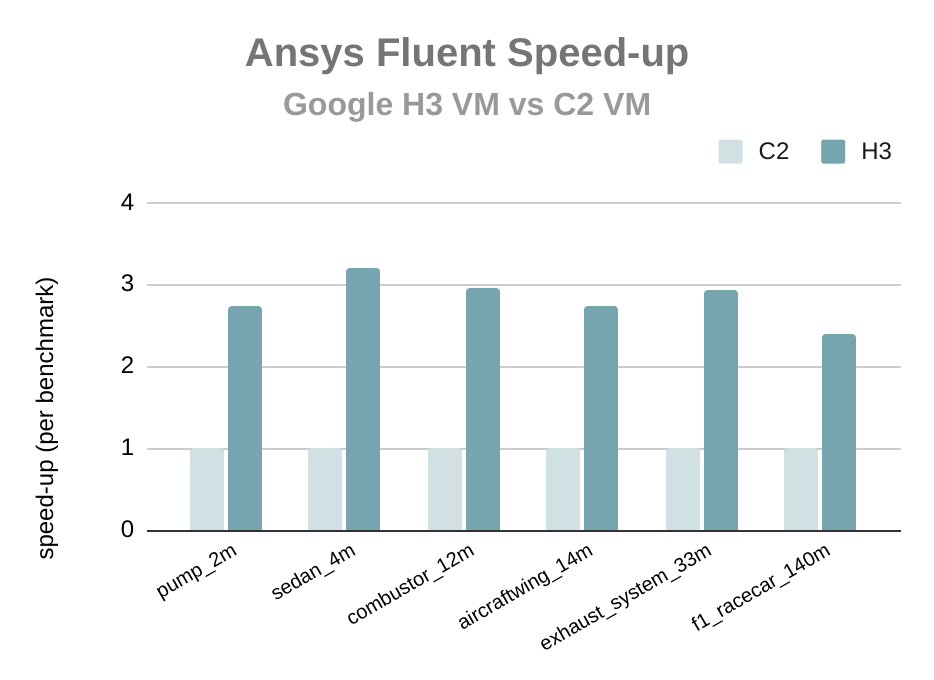

Performances sur nœud unique : Ansys Fluent

Le graphique suivant montre les performances lors de l'exécution d'Ansys Fluent 2022 R2 sur la VM H3 par rapport à la VM C2 à l'aide du plan de solution CAE (VM entière dans chaque cas). La vitesse par rapport aux analyses comparatives couramment utilisées pour Ansys Fluent est multipliée par 2,8. Cela prouve que la plate-forme Google H3 est particulièrement adaptée aux charges de travail de dynamique des fluides de calcul.

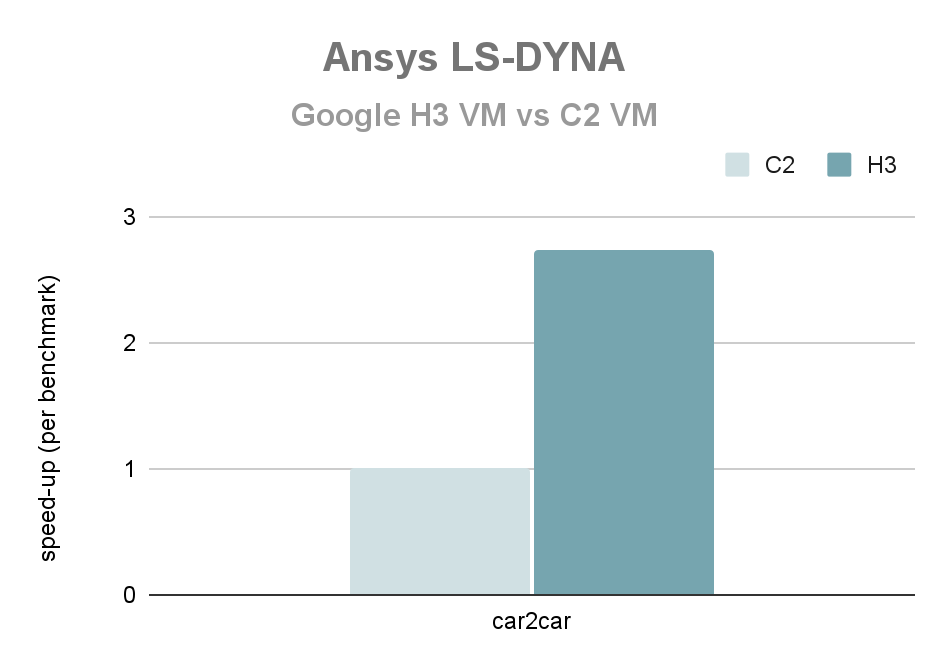

Performances sur nœud unique : Ansys LS-DYNA

Le graphique suivant montre les performances d'un nœud unique lors de l'exécution d'Ansys LS-DYNA R9.3.1 sur la VM H3 par rapport à la VM C2 (VM entière dans chaque cas). La vitesse de référence pour le benchmark des accidents car2car avec Ansys LS-DYNA est multipliée par 2,7

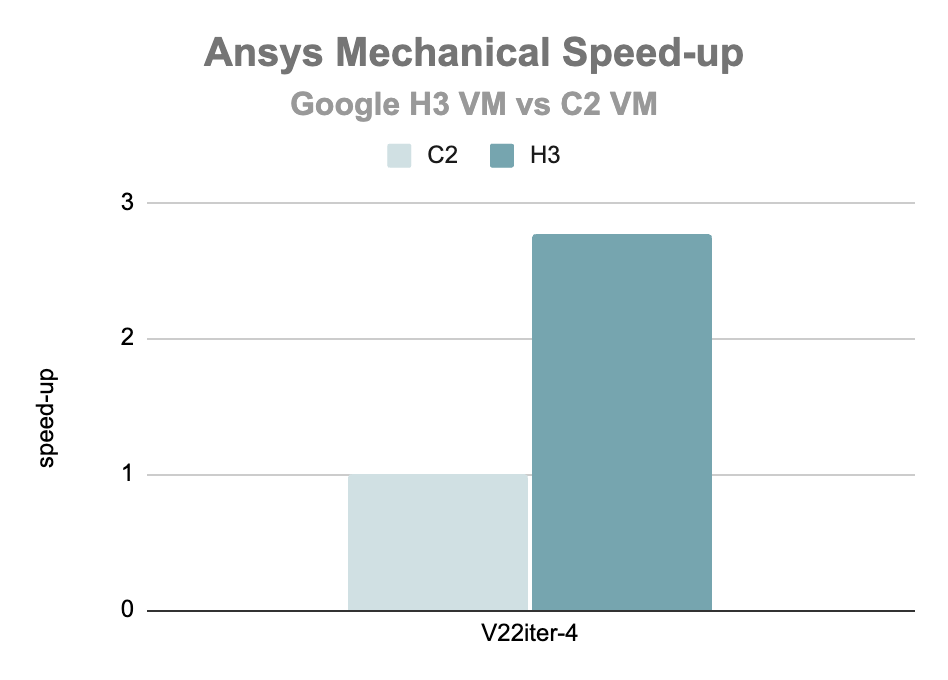

Performances sur nœud unique : Ansys Mechanical

Le graphique suivant montre les performances d'un nœud unique lors de l'exécution d'Ansys Mechanical 2022 R1 sur la VM H3 par rapport à la VM C2 (VM entière dans chaque cas). L'accélération pour le benchmark V2iter-4 pour Ansys Mechanical est 2,8 fois supérieure

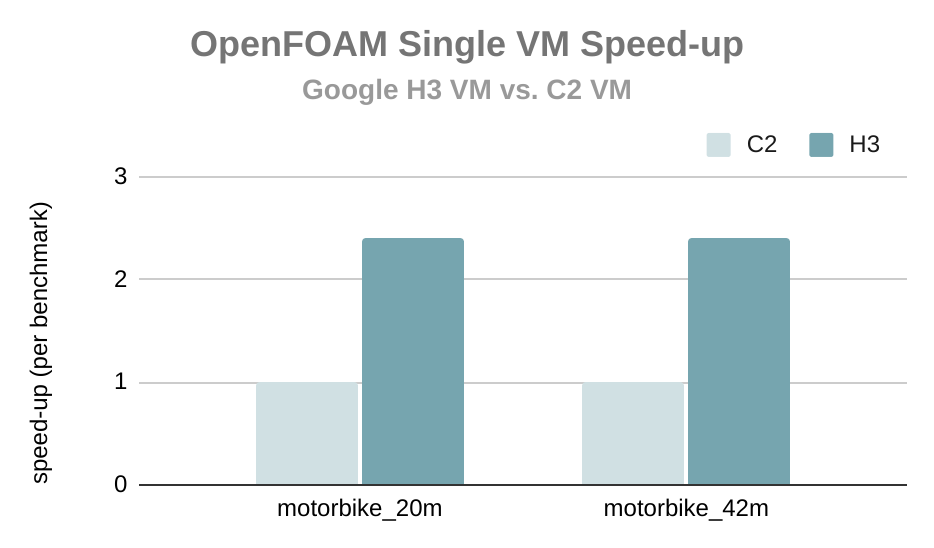

Performances sur nœud unique : OpenFOAM

Le graphique suivant montre les performances d'un nœud unique lors de l'exécution de la version v7 d'OpenFOAM Foundation sur la VM H3 par rapport à la VM C2 (VM entière dans chaque cas). La vitesse d'OpenFOAM par rapport aux analyses comparatives couramment utilisées est 2,4 fois supérieure.

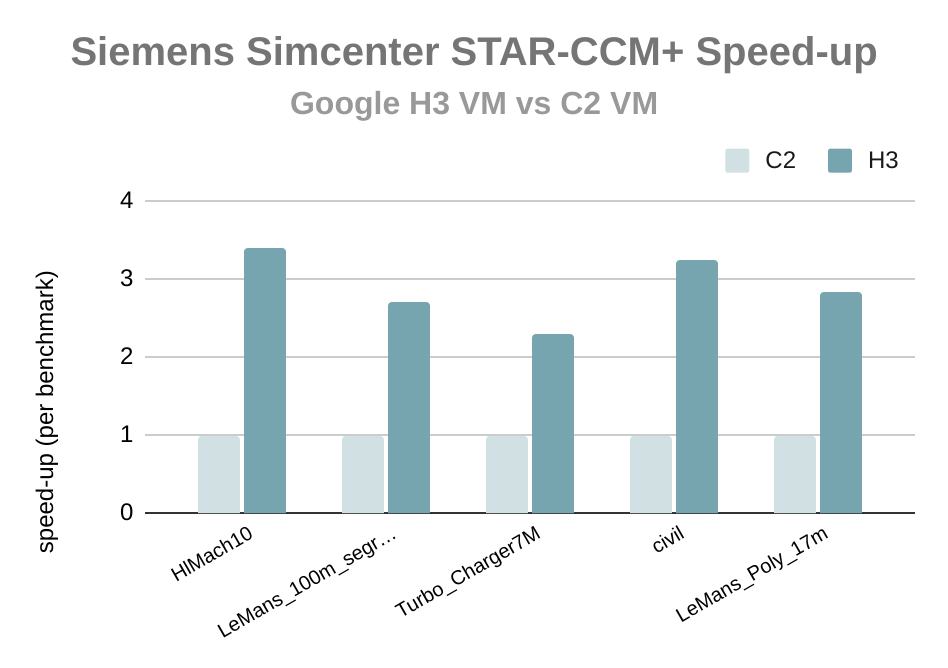

Performances sur nœud unique : Siemens Simcenter STAR-CCM+

Le graphique suivant montre les performances d'un nœud unique lors de l'exécution de Siemens Simcenter STAR-CCM+ 18.02.008 sur la VM H3 par rapport à la VM C2 (VM entière dans chaque cas). La vitesse par rapport aux benchmarks couramment utilisées pour Siemens Simcenter STAR-CCM+ est 2,9 fois supérieure.

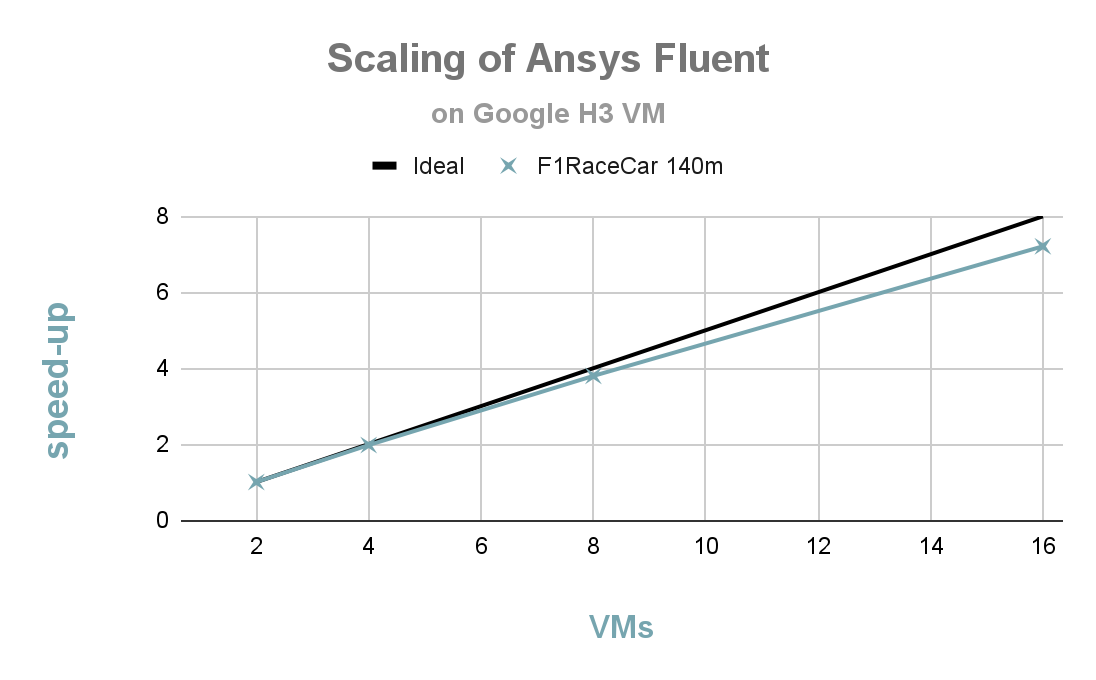

Scaling fort : Ansys Fluent

Le graphique suivant illustre le comportement de scaling élevé d'Ansys Fluent 2022 R2 sur le benchmark F1 RaceCar (140 m) utilisant des VM H3. Vous pouvez constater un bon scaling de 2 à 16 nœuds, avec une efficacité parallèle de plus de 90% à 16 nœuds (1 408 cœurs).

Avantages de Google Cloud pour les charges de travail CAE

Google Cloud offre de nombreux avantages pour l'exécution de charges de travail CAE, y compris :

Performances

L'infrastructure HPC de Google Cloud est conçue pour offrir des performances élevées pour les charges de travail CAE. Les derniers processeurs et GPU sont disponibles, et l'infrastructure réseau est conçue pour offrir une faible latence.

Évolutivité

Évolutivité

L'infrastructure HPC de Google Cloud est conçue pour être évolutive. Les charges de travail CAE peuvent être augmentées ou réduites selon les besoins, et des ressources peuvent être ajoutées ou supprimées rapidement et facilement.

Flexibilité

Flexibilité

L'infrastructure HPC de Google Cloud est conçue pour être flexible. Les charges de travail CAE peuvent être exécutées sur diverses options de calcul et différentes options de stockage sont disponibles.

Simplicité d'utilisation

Simplicité d'utilisation

L'infrastructure HPC de Google Cloud est conçue pour être facile à utiliser. Cloud HPC Toolkit fournit un ensemble d'outils et de bibliothèques permettant d'optimiser les charges de travail CAE sur Google Cloud.

Rentabilité

Rentabilité

L'infrastructure HPC de Google Cloud est conçue pour être rentable. Différentes options de tarification sont disponibles, et vous pouvez utiliser des VM Spot pour réduire les coûts.

Autres optimisations des performances et des coûts

Choisir le bon type de machine

Google Cloud propose une large gamme de types de machines, chacun avec des configurations de processeur, de GPU et de mémoire différentes. Choisir le type de machine adapté à votre charge de travail peut avoir un impact significatif sur les performances et les coûts. Par exemple, la VM H3 est idéale pour les applications CAE sous licence par cœur, en raison du ratio bande passante mémoire/cœur élevé. Avec un débit de 4 Go par cœur, la VM H3 offre suffisamment de mémoire pour diverses charges de travail. Pour les charges de travail particulièrement exigeantes en mémoire, telles que la mécanique structurelle, la VM C3, avec sa configuration haute capacité de mémoire, fournit 16 Go/cœur.

Choisir le bon espace de stockage

Google Cloud propose plusieurs options de stockage, chacune présentant des caractéristiques de performances et de coûts différentes. Choisir la bonne option de stockage pour votre charge de travail peut avoir un impact significatif sur les performances et les coûts. Il existe également plusieurs types de stockage dans un environnement HPC à envisager.

Les environnements HPC standards hébergent au moins deux types de stockage ayant des besoins différents : un stockage personnel et un espace de stockage temporaire. Le choix du type de stockage pour chacun d'eux dépend des besoins spécifiques de la charge de travail HPC. Par exemple, une charge de travail qui génère une grande quantité de données entièrement nouvelles peut nécessiter une solution de stockage temporaire hautes performances. De même, une charge de travail qui accède simultanément à des données communes sur plusieurs nœuds de calcul peut nécessiter un système de fichiers parallèle. Le choix du type de stockage pour une charge de travail HPC donnée dépend de ses besoins spécifiques.

En plus du stockage personnel et du stockage temporaire, les environnements HPC peuvent utiliser d'autres types de stockage, comme le stockage Archive, qui permet de stocker des données rarement consultées. Cloud Storage offre la solution la plus économique pour le stockage Archive.

Stockage personnel

Le stockage personnel est généralement utilisé pour stocker des fichiers utilisateur partagés, principalement dans le répertoire "/home", comme les configurations, les scripts et les données de post-traitement. Cet espace de stockage sera installé au même endroit dans le cluster pour permettre un accès commun à cet espace de noms. Le stockage personnel est généralement persistant et basé sur le protocole NFS.

Dans un environnement HPC Google Cloud, le stockage personnel peut être fourni par des services Google tels que Filestore ou par des offres partenaires comme NetApp.

- Google Cloud Filestore est un service de stockage de fichiers entièrement géré qui fournit un accès aux données hautes performances et à faible latence. Filestore est un bon choix pour stocker des données de stockage personnel fréquemment consultées.

- NetApp Cloud Volumes Service est un service de stockage de fichiers entièrement géré qui fournit un accès aux données hautes performances et à faible latence. NetApp Cloud Volumes Service est un excellent choix pour stocker des données de stockage personnel fréquemment consultées.

Stockage temporaire

Le stockage temporaire est généralement utilisé pour stocker des fichiers temporaires, tels que des résultats intermédiaires et des données de sortie de simulation. Ceux-ci peuvent être partagés ou non entre différents nœuds de l'environnement HPC. Le stockage temporaire n'est généralement pas persistant. Le stockage temporaire repose généralement sur des systèmes de stockage plus performants que le stockage personnel, tels qu'un stockage Flash local ou des systèmes de fichiers parallèles.

Dans un environnement HPC Google Cloud, le stockage temporaire peut être fourni par des services Google tels que Persistent Disk, un disque SSD local, Cloud Filestore ou Parallelstore, ou par des offres partenaires comme NetApp, DDN EXAScaler, Sycomp et Weka.

- Google Cloud Persistent Disk est un service de stockage de blocs qui fournit un accès aux données hautes performances et à faible latence. Persistent Disk permet de créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

- Le disque SSD local Google Cloud est une option de stockage SSD local disponible sur certains types de machines Compute Engine. Le disque SSD local peut être utilisé pour créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

- Google Cloud Filestore est un service de stockage de fichiers NFS entièrement géré qui fournit un accès aux données hautes performances et à faible latence. Filestore permet de créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

- Google Cloud Parallelstore est un système de fichiers parallèle hautes performances optimisé pour les charges de travail HPC. Parallelstore permet de créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

- NetApp Cloud Volumes Service est un service de stockage de fichiers entièrement géré qui fournit un accès aux données hautes performances et à faible latence. NetApp Cloud Volumes Service permet de créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

- DDN EXAScaler Cloud est un système de fichiers parallèle hautes performances optimisé pour les charges de travail HPC. DDN EXAScaler Cloud permet de créer un ou plusieurs répertoires temporaires sur un cluster HPC.

- WekaIO Matrix est un système de fichiers parallèle hautes performances optimisé pour les charges de travail HPC. La matrice WekaIO peut être utilisée pour créer un répertoire temporaire pour chaque utilisateur d'un cluster HPC.

Spot VM

Les VM Spot permettent d'exécuter des charges de travail IAO de manière économique. Elles sont disponibles à prix réduit, mais peuvent être arrêtées à tout moment avec un court préavis. Les VM Spot offrent jusqu'à 91 % de réduction sur le coût d'une instance standard et offrent le type de fonctionnalités attendues par les utilisateurs HPC, y compris les GPU et les SSD locaux.

Si votre workflow peut tolérer le risque d'interruption (préemption), il est recommandé de tester le modèle Spot si l'application peut s'exécuter dans un délai relativement court (moins de quatre heures). Les clients ont constaté que les économies pouvant atteindre 90 % par rapport à la tarification à la demande leur permettent de tolérer des interruptions mineures.

Notez que certains types de VM, tels que H3, ne sont pas compatibles avec Spot.

Études de cas

AirShaper

AirShaper est une plate-forme en ligne d'aérodynamique qui permet aux concepteurs et aux ingénieurs d'exécuter des simulations de flux d'air de manière entièrement automatisée. Les utilisateurs sans expertise en aérodynamique peuvent ainsi obtenir des résultats fiables et améliorer leur conception.

AirShaper a migré ses charges de travail HPC Computational Fluid Dynamics (CFD) vers la nouvelle famille de VM C2D à partir d'une ancienne plate-forme de VM, ce qui lui a permis de gagner du temps de simulation et le coût par exécution de la charge de travail par rapport à son environnement cloud précédent, et d'améliorer considérablement ses délais de résultats par rapport à la version de l'environnement sur site.

"Chez AirShaper, nous proposons des simulations CFD à un coût fixe. Des cœurs plus nombreux et plus rapides impliquent généralement un coût global plus élevé, en partie dû aux problèmes de scaling. Mais avec les VM H3, nous pouvons réduire de moitié les temps de simulation tout en réduisant également le coût global."

- Wouter Remmerie, PDG, Airshaper

Réduire les coûts de près de 50 % | L'entreprise a pu atteindre des temps de simulation plus de trois fois inférieurs par rapport aux instances sur site. | Réduction des temps de simulation de 30 % par rapport aux instances de calcul hautes performances des générations précédentes |

Réduire les coûts de près de 50 %

L'entreprise a pu atteindre des temps de simulation plus de trois fois inférieurs par rapport aux instances sur site.

Réduction des temps de simulation de 30 % par rapport aux instances de calcul hautes performances des générations précédentes

Altair

Altair est une entreprise technologique internationale qui fournit des solutions logicielles et cloud dans les domaines du développement de produits, du calcul hautes performances (HPC) et de l'analyse de données. Les ingénieurs, les scientifiques et les analystes de données utilisent le logiciel Altair pour résoudre des problèmes complexes dans de nombreux secteurs, y compris l'automobile, l'aérospatiale, l'industrie et l'énergie.

Altair est un partenaire Google Cloud, et ses logiciels sont disponibles sur Google Cloud. Le logiciel d'Altair est optimisé pour Google Cloud et permet de bénéficier des performances, de l'évolutivité et de la flexibilité de Google Cloud. Altair s'engage à aider ses clients à atteindre leurs objectifs HPC et propose une large gamme de solutions logicielles pour le HPC. L'une d'elles est Radioss, un outil d'analyse des éléments finis. Grâce à la nouvelle VM H3, Altair a pu démontrer des améliorations significatives dans l'environnement d'exécution basé sur le cloud de Radioss.

"Chez Altair, nous sommes ravis que les premiers tests indiquent une réduction de l'exécution de simulation jusqu'à trois fois supérieure pour les charges de travail Radioss exécutées sur les H3 par rapport aux C2. Ces environnements d'exécution beaucoup plus rapides sur Google Cloud vont nous aider à accroître la productivité des ingénieurs chez nos clients communs."

- Eric Lequiniou, vice-président senior, Radioss Development and Altair Solver

TotalCAE

TotalCAE est l'un des principaux fournisseurs de solutions HPC gérées pour les applications scientifiques et d'ingénierie. Les solutions de TotalCAE sont conçues pour être faciles à utiliser. Elles aident les clients à accélérer le délai d'obtention de résultats, à réduire les coûts et à améliorer la productivité. Les solutions de TotalCAE permettent aux clients du monde entier de résoudre des problèmes scientifiques et d'ingénierie complexes. Par exemple, les solutions de TotalCAE sont utilisées pour concevoir et simuler des avions, des voitures et d'autres véhicules, pour analyser les performances des bâtiments et des ponts et pour développer de nouveaux médicaments et thérapies.

TotalCAE est un partenaire de Google Cloud, et ses solutions sont compatibles avec Google Cloud. Les solutions de TotalCAE sont optimisées pour Google Cloud et peuvent être utilisées pour bénéficier des performances, de l'évolutivité et de la flexibilité de Google Cloud. Grâce à l'infrastructure HPC de Google Cloud, TotalCAE a pu offrir à ses clients de meilleures performances à moindre coût.

"Avec les instances Google Cloud H3, nous avons enregistré une amélioration des performances par cœur allant jusqu'à 25% pour les charges de travail CAE, pour un coût de travail 50% inférieur à celui du C2. TotalCAE a ainsi pu offrir à ses clients un rapport prix/performances 2,5 fois supérieur et une évolutivité pour les charges de travail CAE sur Google Cloud".

- Rodney Mach, PDG, TotalCAE

En savoir plus sur les charges de travail CAE sur Google Cloud

De nombreuses informations sur les charges de travail HPC et CAE sont disponibles sur Google Cloud. Contactez-nous si vous souhaitez discuter avec un membre de l'équipe HPC de Google ou commencer à utiliser Google Cloud. En attendant, consultez toutes nos ressources pour continuer à vous former.

Passez à l'étape suivante

Profitez de 300 $ de crédits gratuits et de plus de 20 produits Always Free pour commencer à créer des applications sur Google Cloud.

Vous avez besoin d'aide pour démarrer ?

Contacter le service commercialFaites appel à un partenaire de confiance

Trouvez un partenairePoursuivez vos recherches

Voir tous les produits