Computergestützte Entwicklungsarbeitslasten in Google Cloud ausführen

Computer-Aided Engineering (CAE) umfasst eine breite Palette von Anwendungen, einschließlich Strukturanalyse, Strömungsdynamik, Absturzsicherheit und Wärmeanalyse, um nur einige zu nennen. All diese Anwendungsfälle erfordern erhebliche Rechenressourcen, um die komplexen Simulationen der erforderlichen Physik und potenziell große Eingabe- und Ausgabedaten zu verarbeiten. In diesem technischen Referenzleitfaden wird beschrieben, wie Sie Google Cloud nutzen können, um CAE-Workflows durch Bereitstellung von Hochleistungs-Computing-Ressourcen (HPC) zu beschleunigen.

CAE-Lösung – Kurzfassung

Die HPC-Plattform von Google Cloud ist eine leistungsstarke und skalierbare Plattform für anspruchsvolle CAE-Workflows. Sie kombiniert die Leistung herkömmlicher HPC-Systeme mit den Vorteilen einer globalen, elastischen und flexiblen Cloud:

- Skalierbarkeit : Dank der flexiblen Infrastruktur von Google Cloud können Nutzer ihre CAE-Arbeitslasten on demand hoch- oder herunterskalieren und so flexibel auf schwankende Computing-Anforderungen reagieren.

- Leistung : Die CPUs und GPUs der neuesten Generation von Google Cloud sorgen in Kombination mit Hochleistungsnetzwerken dafür, dass CAE-Simulationen effizient ausgeführt werden, wodurch Bearbeitungszeiten minimiert und Designiterationen beschleunigt werden.

- Flexibilität : Google Cloud bietet eine breite Palette von VM-Instanzen, die für verschiedene CAE-Anwendungen und -Arbeitslasten optimiert sind. So können Nutzer die optimalen Rechenressourcen für ihre spezifischen Anforderungen auswählen.

- Ease-of-use: Die CAE-Lösung von Google erleichtert Ihnen den Einstieg und bietet Ihnen die transformative Kraft beschleunigter Simulationen und Analysen.

Eine Referenzarchitektur für CAE-Arbeitslasten

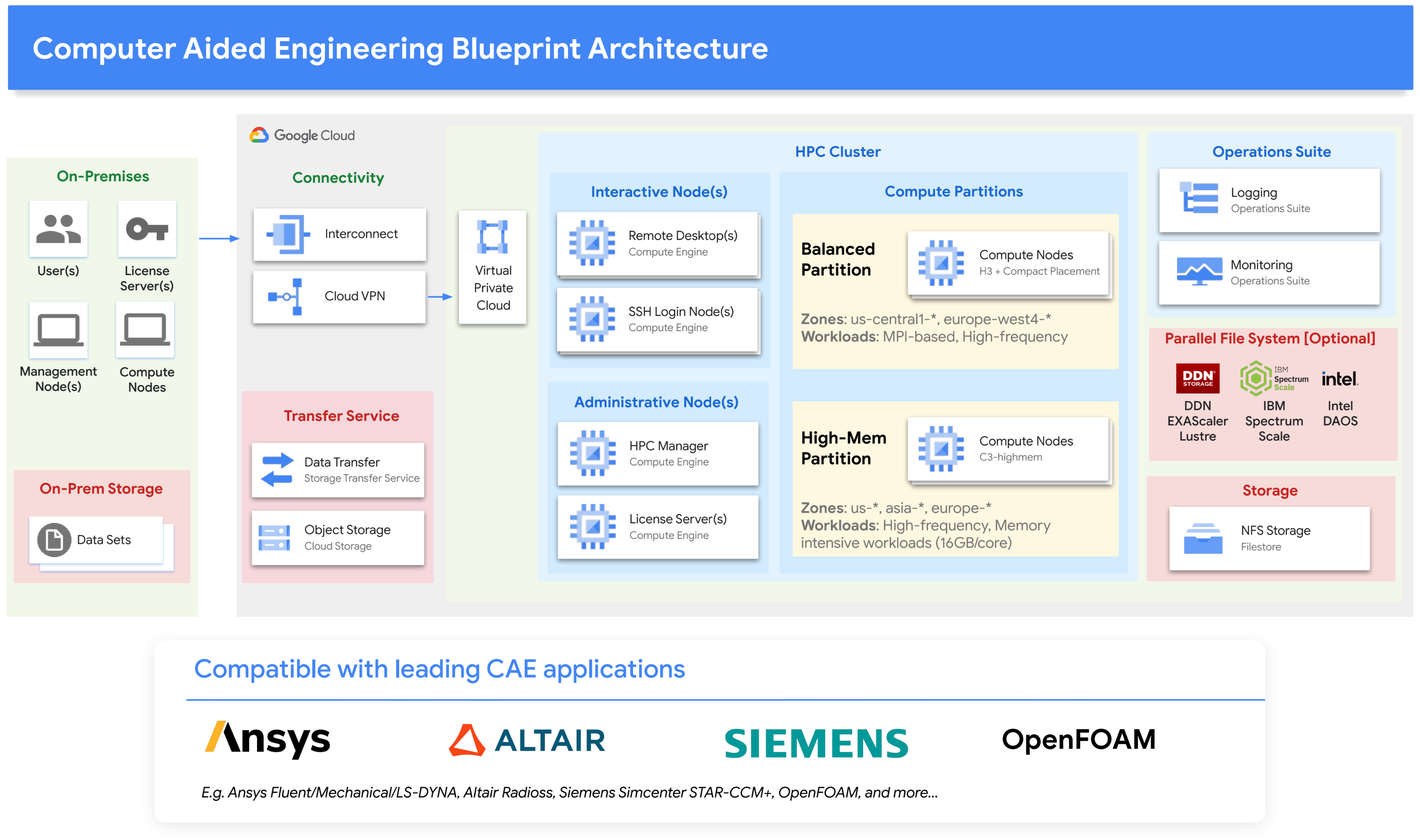

Um die Verwendung von Google Cloud für CAE-Workflows zu vereinfachen, haben wir die richtigen Cloud-Komponenten zusammengestellt, die den Anforderungen rechenintensiver CAE-Arbeitslasten gerecht werden. Unsere CAE-Lösung basiert insbesondere auf den H3- und C3-VM-Familien von Google Cloud und basiert auf der neuesten Intel Xeon-Plattform. Diese VM-Familien bieten eine hohe Arbeitsspeicherbandbreite für ein ausgewogenes Arbeitsspeicher-Flop-Verhältnis, das ideal für CAE geeignet ist. Die Lösung eignet sich sowohl für eng gekoppelte MPI-Anwendungen als auch für arbeitsspeicherintensive Arbeitslasten mit bis zu 16 GB pro Kern. Es umfasst verschiedene Speicheroptionen, die eine Vielzahl von E/A-Anforderungen erfüllen. Für die Ressourcenverwaltung werden Planer wie Slurm von SchedMD und PBS Professional von Altair unterstützt.

Das folgende Architekturdiagramm veranschaulicht die Lösung:

Lösungskomponenten

Die Architektur der CAE-Lösung besteht aus mehreren Schlüsselkomponenten, darunter Computing, Netzwerk, Speicher und das Open-Source-Cloud HPC-Toolkit von Google.

Compute

Die CAE-Lösung basiert auf Google Compute Engine. Compute Engine bietet eine Vielzahl von Maschinentypen, einschließlich Maschinentypen mit GPUs. Compute Engine ist aufgrund der speziellen VM-Typen und des leistungsstarken Netzwerks eine gute Wahl für CAE-Arbeitslasten, die eine hohe Leistung und Flexibilität erfordern:

H3-VMs: Eine ausgewogene Partition, die sich gut für CAE-Arbeitslasten eignet, wird aus der HPC-VM von Google mit dem neuesten Sapphire Rapids-Dienst von Intel mit 4 GB/Kern und bis zu Tausenden von Kernen (über MPI) erstellt.

C3-VMs: Eine Partition mit großem Speicher, die sich gut für speicherintensive CAE-Arbeitslasten eignet, wird aus der C3-VM von Google mit der neuesten Sapphire Rapids-Generation von Intel mit 16 GB/Kern erstellt.

Platzierungsrichtlinien: Mit Platzierungsrichtlinien wird sichergestellt, dass VMs nahe beieinander erstellt werden. Dadurch wird die Latenz der Kommunikation zwischen VMs verringert und die Gesamtleistung verbessert.

HPC-VM-Image: Für eine optimale Leistung stellen wir HPC-VM-Images zur Verfügung, die standardmäßige Linux-Betriebssystemverteilungen für eine optimale Leistung in Google Cloud konfigurieren.

VMs für allgemeine Zwecke: für Anmeldeknoten, Lizenzserver und sonstige Aufgaben.

Remote Desktop-VMs – für Remote Desktop-Sitzungen und Remote-Visualisierung.

Netzwerk

Google Virtual Private Cloud: Google VPC ist eine virtuelle Version eines physischen Netzwerks für Ihr Projekt.

Google Cloud-Konnektivität: Mit Google Cloud-Konnektivität können Sie lokale Netzwerke mit hoher Verfügbarkeit und niedriger Latenz zu Google Cloud verbinden und erweitern.

Google Cloud VPN: Mit Google Cloud VPN wird Ihr Peer-Netzwerk sicher mit einem VPC-Netzwerk (Virtual Private Cloud) verbunden.

gVNIC Google Virtual NIC ist eine virtuelle Netzwerkkarte (Network Interface Card, NIC), die hohe Leistung und niedrige Latenz zwischen Compute-VMs bietet. gVNIC ist eine gute Wahl für CAE-Arbeitslasten, die eine hohe Netzwerkleistung erfordern.

Speicher

Google Filestore: Filestore ist ein vollständig verwalteter NFS-Dienst, der hohe Leistung und niedrige Latenz bietet. Filestore ist eine gute Wahl für Daten, die freigegeben werden oder im gesamten Netzwerk sichtbar sein müssen, z. B. Anwendungen oder Basisverzeichnisse.

Parallele Dateisysteme: Google Cloud arbeitet mit einer Reihe von Speicheranbietern zusammen, um eine Vielzahl von parallelen Dateisystemen für HPC-Arbeitslasten anzubieten. Zu diesen Partnern gehören NetApp, DDN EXAScaler, Sycomp Spectrum Scale und Weka.

Google Storage Transfer Service: Mit dem verwalteten Storage Transfer Service können Daten schnell und sicher zwischen Objekt- und Dateispeichern in Google Cloud, Amazon, Azure, lokalen Systemen und anderen Diensten übertragen werden.

Google Cloud Storage: Cloud Storage ist ein skalierbarer und langlebiger Objektspeicherdienst. Cloud Storage eignet sich gut für die Speicherung großer Datenmengen oder kann für die Datenübertragung verwendet werden.

Tools

Google Cloud HPC-Toolkit – Mit dem Open-Source-Cloud HPC-Toolkit von Google können Kunden und Partner ganz einfach wiederholbare, sofort einsatzfähige HPC-Umgebungen gemäß den HPC-Best Practices von Google Cloud bereitstellen. Die CAE-Lösung von Google enthält einen HPC-Toolkit-Blueprint, mit dem Sie ganz einfach eine HPC-Umgebung in Google Cloud instanziieren können, auf der CAE-Arbeitslasten ausgeführt werden können.

Erste Schritte mit CAE-Arbeitslasten in Google Cloud

Überlegungen zum Ausführen von CAE-Arbeitslasten in der Cloud

Beim Ausführen von CAE-Arbeitslasten in der Cloud sind eine Reihe von Faktoren zu berücksichtigen:

- Kompatibilität: Achten Sie darauf, dass CAE-Anwendungen auf Kompatibilität mit der cloudbasierten HPC-Umgebung getestet wurden.

- VM-Auswahl: Wählen Sie den richtigen VM-Typ aus, mit dem ISV-Software optimal ausgeführt wird. Viele CAE-Arbeitslasten eignen sich für Computing-Architekturen mit hoher Arbeitsspeicherbandbreite und einem insgesamt ausgeglichenen Verhältnis zwischen Flops:Speicher und Bandbreite.

- Skalierbarkeit: Beachten Sie, dass größere CAE-Arbeitslasten möglicherweise auf mehreren VMs ausgeführt werden müssen, sodass MPI und dichte Bereitstellungen der VMs unterstützt werden müssen.

- Durchsatz: Bewerten Sie, wie viele Arbeitslasten gleichzeitig ausgeführt werden müssen, und ziehen Sie das Autoscaling von Planungsmodellen in Betracht, mit denen die Cloud-Ressourcen je nach Bedarf vergrößert und verkleinert werden können.

- Kosten: Kommerzielle ISV-Softwarepakete für CAE werden oft „nach Kern“ lizenziert. Das ist ein wichtiger Faktor für die Gesamtkosten und kann die Auswahl eines VM-Typs beeinflussen.

- Nutzung/Verbrauch: Die Cloud bietet Flexibilität, die eine lokale Installation nicht bieten kann. Finden Sie die richtige Balance zwischen On-Demand- und zugesicherter Nutzung oder sogar Spot-VMs.

- Nutzerfreundlichkeit: Achten Sie darauf, dass die von Ihnen gewählte Cloud-HPC-Lösung einfach zu nutzen und zu verwalten ist.

CAE-Referenz-Blueprint für allgemeine Zwecke

Im Rahmen der CAE-Lösung von Google Cloud haben wir eine CAE-Referenzarchitektur und einen Blueprint für allgemeine Zwecke entwickelt, die problemlos mit dem Cloud HPC-Toolkit von Google zur Bereitstellung der CAE-Architektur in Google Cloud verwendet werden können. Wir haben die Kompatibilität und Leistung mehrerer führender ISV-Anwendungen überprüft, darunter:

- Ansys Fluent

- Ansys Mechanical

- Ansys LS-DYNA

- Siemens Simcenter STAR-CCM+

- Altair Radioss

- OpenFOAM

Im Abschnitt zu Benchmarks unten finden Sie Informationen zur Leistung dieser Softwarepakete.

Mit dem Blueprint für die allgemeine CAE-Referenzarchitektur können Nutzer sofort eine Cloud-Umgebung einrichten, die mit einer Vielzahl von CAE-Anwendungen und -Workflows kompatibel ist. Dies ist eine gute Option für Nutzer, die bei der Auswahl ihrer CAE-Software flexibel sein und ihre eigene HPC-Umgebung verwalten möchten. Er dient auch als Ausgangspunkt für Systemintegratoren und nutzt die Best Practices von Google zum Ausführen von CAE-Simulationen in Google Cloud.

Anwendungsspezifische Blueprints

Google Cloud bietet außerdem eine Reihe von anwendungsspezifischen Blueprints für gängige CAE-Software an. Diese Blueprints sind vorkonfiguriert, um eine optimale Leistung für die jeweilige CAE-Software zu erzielen. Software mit spezifischen Blueprints:

Die anwendungsspezifischen Blueprints sind eine gute Option für Nutzer, die schnell und einfach mit CAE loslegen möchten. Die Blueprints bieten eine vorkonfigurierte Umgebung, die für die spezifische CAE-Software optimiert ist, sodass sich Nutzer nicht um die Konfiguration der Umgebung selbst kümmern müssen.

Partnerangebote

Google Cloud arbeitet mit einer Reihe von HPC-as-a-Service-Anbietern wie TotalCAE, Rescale, Parallel Works, Eviden Nimbix, Penguin Computing und NAG sowie mit CAE ISV-Anbietern wie Altair zusammen. Diese Anbieter bieten eine Vielzahl verwalteter HPC-Lösungen für CAE an, einschließlich vorkonfigurierter CAE-Softwareumgebungen, Support für bestimmte CAE-Anwendungen und fachkundige Beratungsdienste. Diese Angebote sind eine gute Option für Nutzende, die eine verwaltete HPC-Lösung für CAE wünschen. Die Anbieter bieten eine Vielzahl von Diensten an, darunter vorkonfigurierte CAE-Softwareumgebungen, Support für bestimmte CAE-Anwendungen und fachkundige Beratungsdienste.

Alternativen zur Architektur und Best Practices

Google Compute Engine, Google Kubernetes Engine, Google Batch

Die CAE-Lösung basiert zwar auf Google Compute Engine, kann aber auch auf anderen Compute-Frameworks wie Google Kubernetes Engine oder Google Batch erstellt werden. Kubernetes Engine ist ein verwalteter Kubernetes-Dienst, mit dem CAE-Arbeitslasten in einer Containerumgebung ausgeführt werden können. Kubernetes Engine ist eine gute Wahl für CAE-Arbeitslasten, die Skalierbarkeit und Übertragbarkeit erfordern. Google Batch ist ein verwalteter Dienst zum Ausführen von Batchjobs. Batch ist eine gute Wahl für CAE-Arbeitslasten, die nicht containerisiert sind und keine umfassende Anpassung oder Feinabstimmung erfordern.

Weitere Informationen zum Erstellen von HPC-Umgebungen finden Sie in unserem technischen Leitfaden für Cluster Toolkit. Darin werden die vielfältigen Optionen für Infrastruktur (Computing, Netzwerk, Speicher), Systemsoftware (Planer, Speicher) und architektonische Aspekte behandelt.

Best Practices

Es gibt eine Reihe von Best Practices, mit denen Sie die Leistung Ihrer CAE-Arbeitslasten in Google Cloud optimieren können. Mit Platzierungsrichtlinien können Sie beispielsweise dafür sorgen, dass Ihre Arbeitslasten auf Rechenressourcen platziert werden, die nah beieinander liegen. Dadurch können die Latenz verringert und die Leistung verbessert werden. Sie können auch das Cloud HPC-Toolkit verwenden, um Ihre Arbeitslasten zu optimieren.

In unserem Leitfaden Best Practices zum Ausführen von HPC-Workloads ist dokumentiert, wie Sie die MPI-Leistung verbessern können. Sowohl Open MPI als auch Intel MPI wurden in Zusammenarbeit mit den HPC-Netzwerkentwicklern von Google Cloud sofort für die Leistung von Google Cloud angepasst und optimiert.

Benchmarks

Der generische CAE-Umgebungs-Blueprint und die zugehörige H3-VM wurden für die wichtigsten CAE ISV-Anwendungen auf ihren Standard-Benchmark-Modellen getestet.

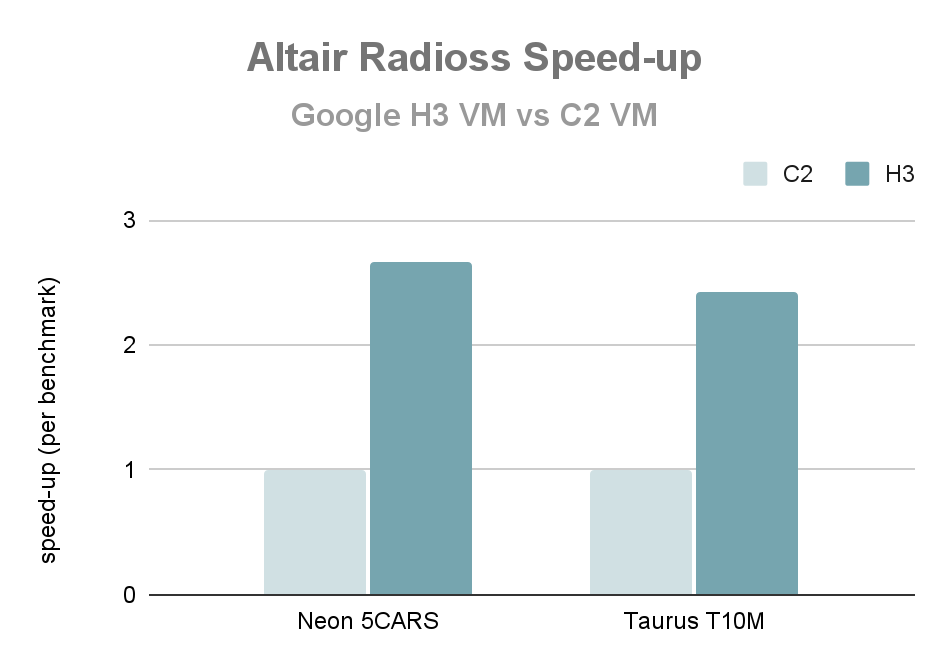

Leistung einzelner Knoten: Altair-Funkschnittstellen

Das folgende Diagramm zeigt die Leistung der Ausführung von Altair Radioss 2022.3 auf der einzelnen Knoten auf der H3-VM im Verhältnis zur C2-VM (in jedem Fall ganze VM). Die Beschleunigung gegenüber zwei häufig verwendeten Benchmarks (Neon 5CARS und T10M) für Altair Radios ist 2,6-fach.

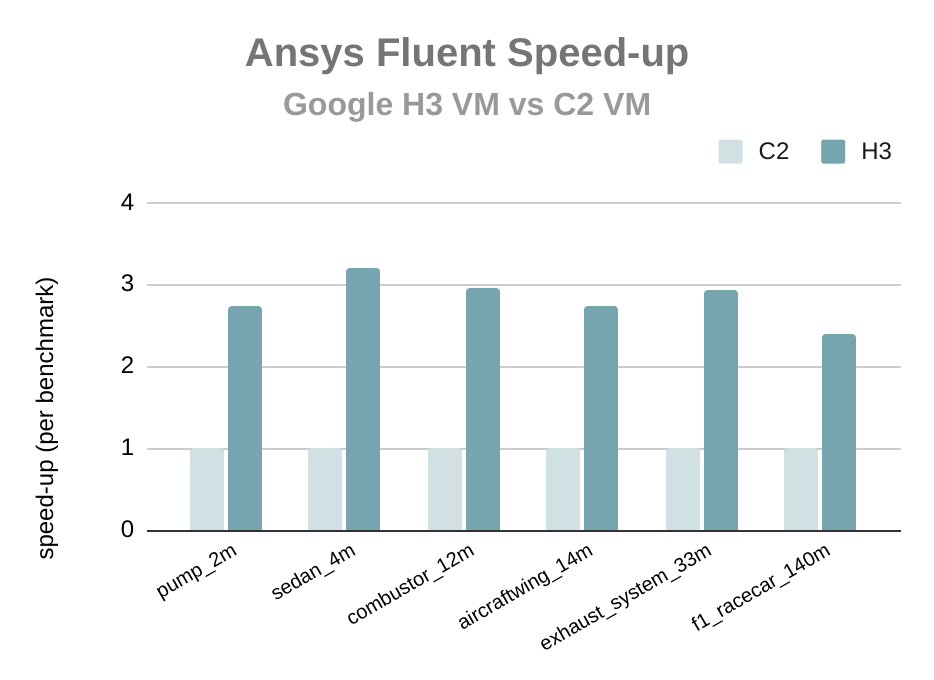

Leistung einzelner Knoten: Ansys Fluent

Das folgende Diagramm zeigt die Leistung beim Ausführen von Ansys Fluent 2022 R2 auf der H3-VM relativ zur C2-VM unter Verwendung des CAE-Lösungs-Blueprints (in jedem Fall ganze VM). Die Beschleunigung gegenüber den allgemein verwendeten Benchmarks für Ansys Fluent ist 2,8-mal und zeigt, dass sich die Google H3-Plattform sehr gut für Arbeitslasten der computergestützten Strömungsdynamik eignet.

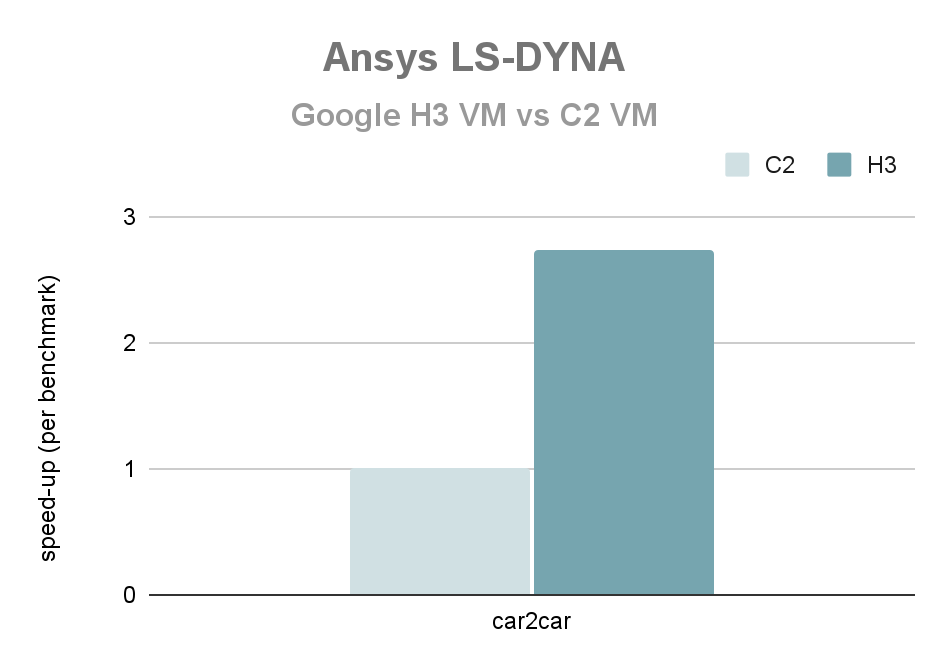

Leistung einzelner Knoten: Ansys LS-DYNA

Das folgende Diagramm zeigt die Leistung eines einzelnen Knotens beim Ausführen von Ansys LS-DYNA R9.3.1 auf der H3-VM im Verhältnis zur C2-VM (in jedem Fall ganze VM). Der Geschwindigkeitszuwachs für den Car2Car-Crash-Benchmark für Ansys LS-DYNA beträgt das 2,7-fache.

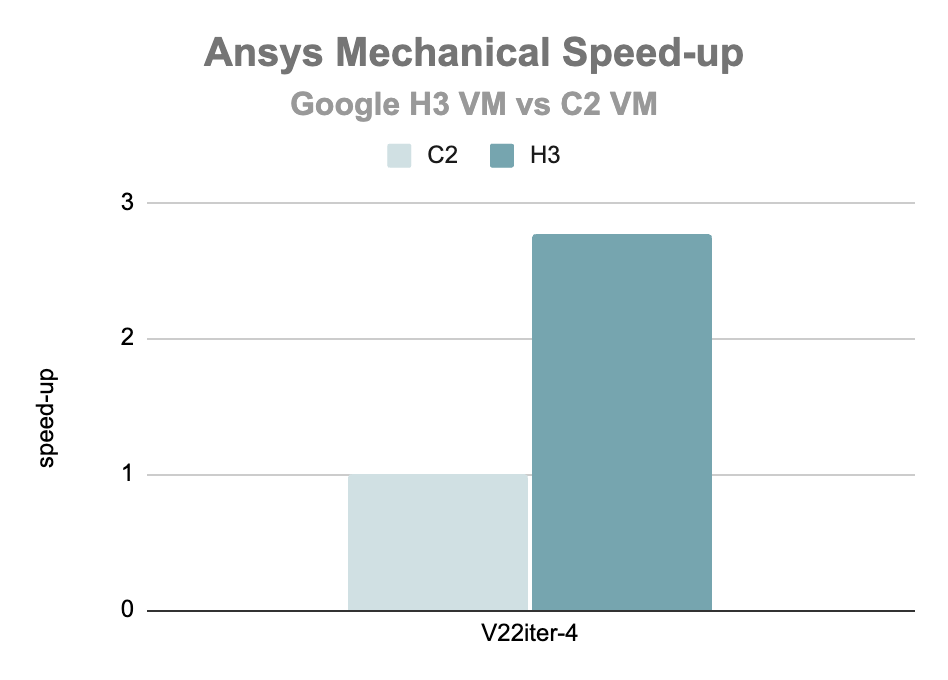

Leistung einzelner Knoten: Ansys Mechanical

Das folgende Diagramm zeigt die Leistung eines einzelnen Knotens bei der Ausführung von Ansys Mechanical 2022 R1 auf der H3-VM im Verhältnis zur C2-VM (in jedem Fall ganze VM). Die Beschleunigung der V2iter-4-Benchmark für Ansys Mechanical ist 2,8-fach.

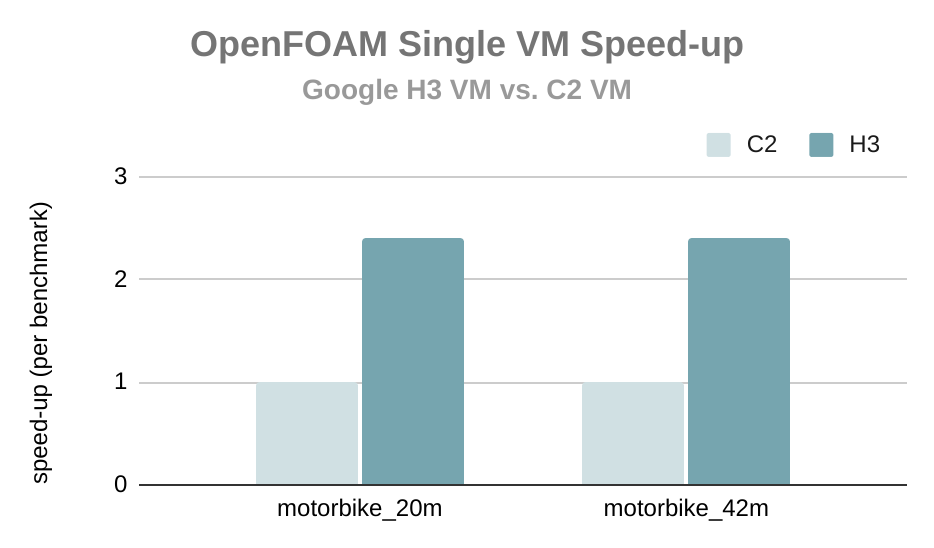

Leistung einzelner Knoten: OpenFOAM

Das folgende Diagramm zeigt die Leistung eines einzelnen Knotens beim Ausführen von OpenFOAM v7 der OpenFOAM Foundation auf der H3-VM im Verhältnis zur C2-VM (in jedem Fall ganze VM). Der Geschwindigkeitszuwachs gegenüber gängigen Benchmarks für OpenFOAM ist Faktor 2,4.

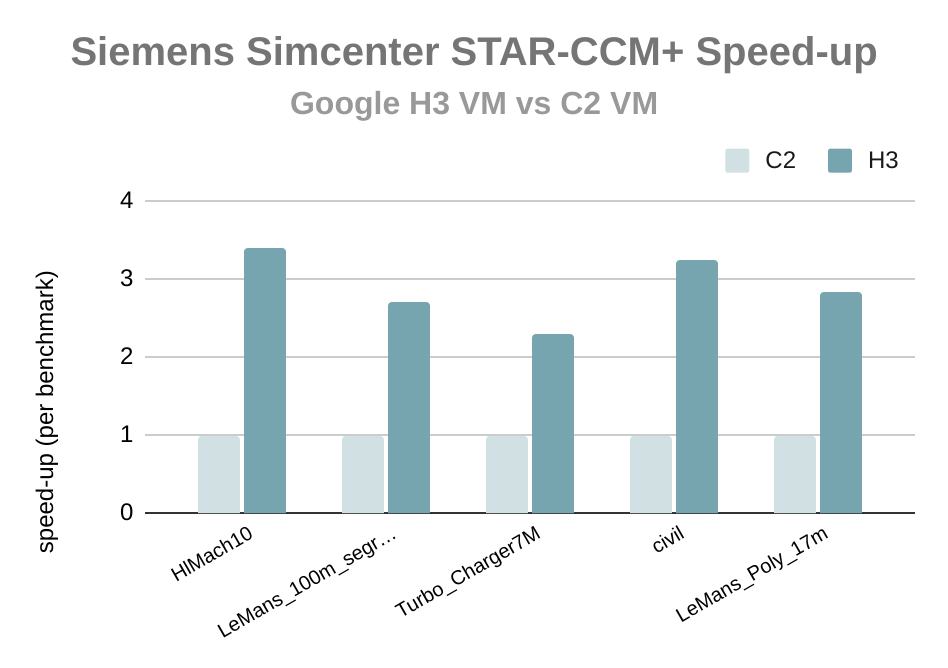

Leistung einzelner Knoten: Siemens Simcenter STAR-CCM+

Das folgende Diagramm zeigt die Leistung eines einzelnen Knotens beim Ausführen von Siemens Simcenter STAR-CCM+ 18.02.008 auf der H3-VM im Verhältnis zur C2-VM (in jedem Fall ganze VM). Der Geschwindigkeitszuwachs gegenüber gängigen Benchmarks für Siemens Simcenter STAR-CCM+ beträgt das 2,9-fache.

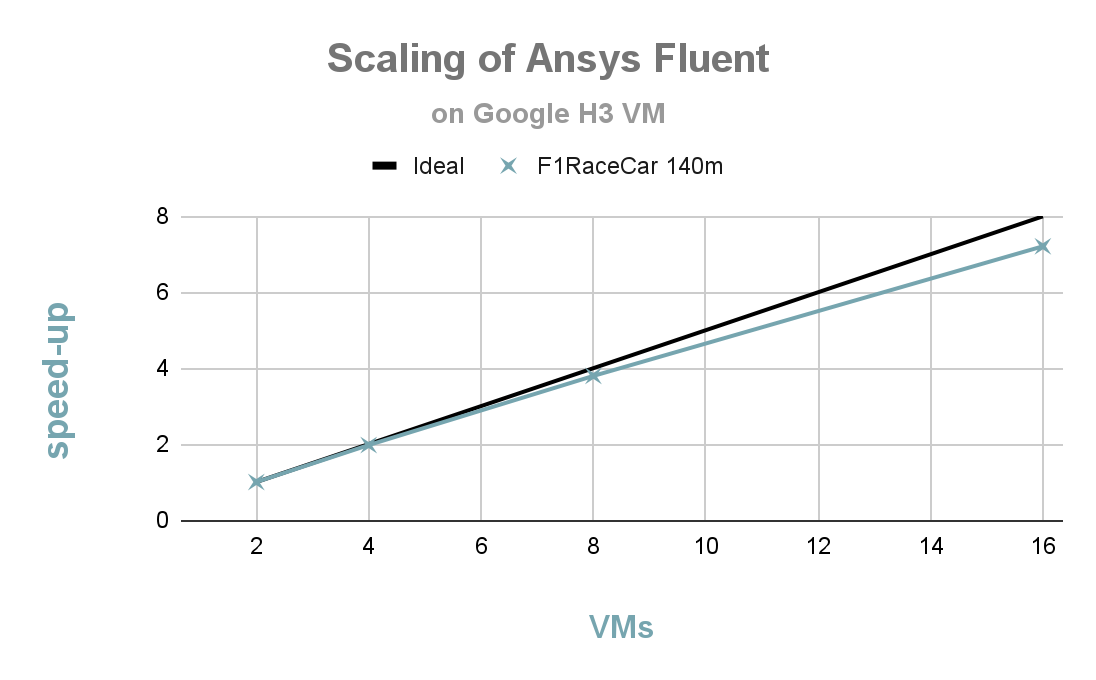

Starke Skalierung: Ansys Fluent

Das folgende Diagramm zeigt das starke Skalierungsverhalten von Ansys Fluent 2022 R2 in der F1 RaceCar-Benchmark (140 m) mit H3-VMs. Sie können eine gute Skalierung von 2 bis 16 Knoten mit einer parallelen Effizienz von über 90% bei 16 Knoten (1.408 Kernen) feststellen.

Vorteile von Google Cloud für CAE-Arbeitslasten

Google Cloud bietet beim Ausführen von CAE-Arbeitslasten eine Reihe von Vorteilen, darunter:

Leistung

Die HPC-Infrastruktur von Google Cloud ist auf eine hohe Leistung für CAE-Arbeitslasten ausgelegt. Es sind die neuesten CPUs und GPUs verfügbar und die Netzwerkinfrastruktur ist auf eine niedrige Latenz ausgelegt.

Skalierbarkeit

Skalierbarkeit

Die HPC-Infrastruktur von Google Cloud ist skalierbar. CAE-Arbeitslasten können nach Bedarf hoch- oder herunterskaliert und Ressourcen können schnell und einfach hinzugefügt oder entfernt werden.

Flexibel

Flexibel

Die HPC-Infrastruktur von Google Cloud ist auf Flexibilität ausgelegt. CAE-Arbeitslasten können auf einer Vielzahl von Compute-Optionen ausgeführt werden, und es steht eine Vielzahl von Speicheroptionen zur Verfügung.

Nutzerfreundlichkeit

Nutzerfreundlichkeit

Die HPC-Infrastruktur von Google Cloud ist auf Nutzerfreundlichkeit ausgelegt. Das Cloud HPC-Toolkit bietet eine Reihe von Tools und Bibliotheken, mit denen CAE-Arbeitslasten in Google Cloud optimiert werden können.

Kosteneffektivität

Kosteneffektivität

Die HPC-Infrastruktur von Google Cloud ist kostengünstig. Es stehen verschiedene Preisoptionen zur Verfügung und mit Spot-VMs können die Kosten gesenkt werden.

Weitere Optimierungen von Leistung und Kosten

Auswahl des richtigen Maschinentyps

Google Cloud bietet eine breite Palette von Maschinentypen mit unterschiedlichen CPU-, GPU- und Arbeitsspeicherkonfigurationen. Die Auswahl des richtigen Maschinentyps für Ihre Arbeitslast kann erhebliche Auswirkungen auf Leistung und Kosten haben. Die H3-VM ist beispielsweise aufgrund des hohen Verhältnisses von Arbeitsspeicherbandbreite zu Kernen eine gute Wahl für pro Kern lizenzierte CAE-Anwendungen und mit 4 GB/Kern bietet die H3-VM ausreichend Arbeitsspeicher für verschiedene Arbeitslasten. Für besonders speicherintensive Arbeitslasten, wie z.B. Strukturmechanik, bietet die C3-VM in ihrer hohen Speicherkonfiguration 16 GB/Kern.

Den richtigen Speicher auswählen

Google Cloud bietet eine Vielzahl von Speicheroptionen mit jeweils unterschiedlichen Leistungs- und Kostenmerkmalen. Die Auswahl der richtigen Speicheroption für Ihre Arbeitslast kann erhebliche Auswirkungen auf Leistung und Kosten haben. In einer HPC-Umgebung müssen auch verschiedene Speichertypen in Betracht gezogen werden.

In typischen HPC-Umgebungen werden mindestens zwei Speichertypen mit unterschiedlichen Anforderungen gehostet: Home Storage und Scratch-Storage. Die Wahl des jeweiligen Speichertyps hängt von den spezifischen Anforderungen der HPC-Arbeitslast ab. So kann beispielsweise eine Arbeitslast, die eine große Menge an Scratch-Daten erzeugt, eine hochleistungsfähige Scratch-Speicherlösung erfordern, oder eine Arbeitslast, die über mehrere Rechenknoten gleichzeitig auf gemeinsame Daten zugreift, kann ein paralleles Dateisystem erfordern. Die Wahl des Speichertyps für eine bestimmte HPC-Arbeitslast hängt von den spezifischen Anforderungen der Arbeitslast ab.

Neben dem Home Storage und dem Scratch-Speicher können HPC-Umgebungen auch andere Speichertypen verwenden, wie den Archivspeicher, der zum Speichern von Daten verwendet wird, auf die nicht häufig zugegriffen wird. Archivspeicher kann am kostengünstigsten von Cloud Storage bereitgestellt werden.

Home Storage

Home Storage wird in der Regel zum Speichern freigegebener Nutzerdateien verwendet, hauptsächlich im Verzeichnis „/home“, z. B. für Konfigurationen, Skripts und Nachbearbeitungsdaten. Dieser Speicher wird an derselben Stelle im Cluster bereitgestellt, um gemeinsamen Zugriff auf diesen Namespace zu ermöglichen. Der Home Storage ist in der Regel dauerhaft. Der Home Storage basiert in der Regel auf dem NFS-Protokoll.

In einer Google Cloud HPC-Umgebung kann der Heimspeicher von Google-Diensten wie Filestore oder Partnerangeboten wie NetApp bereitgestellt werden.

- Google Cloud Filestore ist ein vollständig verwalteter Dateispeicherdienst, der Hochleistungszugriff mit niedriger Latenz auf Daten bietet. Filestore ist eine gute Wahl für die Speicherung von Daten, auf die häufig zugegriffen wird, auf dem Home Storage.

- Der NetApp Cloud Volumes-Dienst ist ein vollständig verwalteter Dateispeicherdienst, der Hochleistungszugriff mit geringer Latenz auf Daten bietet. Der NetApp Cloud Volumes Service ist eine gute Wahl für die Speicherung von Daten im Home Storage, auf die häufig zugegriffen wird.

Scratch-Speicher

Der Scratch-Speicher wird in der Regel zum Speichern temporärer Dateien wie Zwischenergebnisse und Simulationsausgabedaten verwendet. Diese können von verschiedenen Knoten in der HPC-Umgebung gemeinsam genutzt werden. Der Scratch-Speicher ist in der Regel nicht dauerhaft. Scratch-Storage basiert in der Regel auf leistungsfähigeren Speichersystemen als Home Storage, wie z.B. lokalen Flash-Speichern oder parallelen Dateisystemen.

In einer Google Cloud HPC-Umgebung kann der Scratch-Speicher von Google-Diensten wie Persistent Disk, Local SSD, Cloud Filestore oder Parallelstore oder von Partnerangeboten wie NetApp, DDN EXAScaler, Sycomp und Weka bereitgestellt werden.

- Google Cloud Persistent Disk ist ein Blockspeicherdienst, der Hochleistungszugriff mit geringer Latenz auf Daten bietet. Persistent Disk kann verwendet werden, um für jeden Nutzer in einem HPC-Cluster ein Scratch-Verzeichnis zu erstellen.

- Google Cloud Local SSD ist eine lokale SSD-Speicheroption, die auf einigen Compute Engine-Maschinentypen verfügbar ist. Lokale SSDs können verwendet werden, um für jeden Nutzer in einem HPC-Cluster ein Scratch-Verzeichnis zu erstellen.

- Google Cloud Filestore ist ein vollständig verwalteter NFS-Dateispeicherdienst, der Hochleistungszugriff mit niedriger Latenz auf Daten bietet. Filestore kann zum Erstellen eines Scratch-Verzeichnisses für jeden Nutzer in einem HPC-Cluster verwendet werden.

- Google Cloud Parallelstore ist ein leistungsstarkes paralleles Dateisystem, das für HPC-Arbeitslasten optimiert ist. Mit Parallelstore kann für jeden Nutzer in einem HPC-Cluster ein Scratch-Verzeichnis erstellt werden.

- Der NetApp Cloud Volumes-Dienst ist ein vollständig verwalteter Dateispeicherdienst, der Hochleistungszugriff mit geringer Latenz auf Daten bietet. Mit dem NetApp Cloud Volumes-Dienst kann für jeden Nutzer in einem HPC-Cluster ein Scratch-Verzeichnis erstellt werden.

- DDN EXAScaler Cloud ist ein leistungsstarkes paralleles Dateisystem, das für HPC-Arbeitslasten optimiert ist. DDN EXAScaler Cloud kann zum Erstellen eines oder mehrerer Scratch-Verzeichnisse in einem HPC-Cluster verwendet werden.

- WekaIO Matrix ist ein paralleles Hochleistungs-Dateisystem, das für HPC-Arbeitslasten optimiert ist. Mit WekaIO Matrix kann für jeden Nutzer in einem HPC-Cluster ein Scratch-Verzeichnis erstellt werden.

Spot-VMs

Spot-VMs können eine kostengünstige Möglichkeit zum Ausführen von CAE-Arbeitslasten sein. Spot-VMs sind zu einem reduzierten Preis erhältlich, können aber jederzeit mit einer kurzen Frist beendet werden. Spot-VMs bieten bis zu 91% Rabatt auf die Kosten einer Standardinstanz und unterstützen die Funktionen, die HPC-Nutzer erwarten, einschließlich GPUs und lokaler SSDs.

Wenn Ihr Workflow die Gefahr einer Unterbrechung tolerieren kann, ist das Testen des Spot-Modells eine gute Idee, wenn die Anwendung in einem relativ kurzen Zeitraum (< 4 Stunden) ausgeführt werden kann. Kunden stellten fest, dass sie durch die Kosteneinsparungen von bis zu 90% im Vergleich zur On-Demand-Nutzung genug spart, um kleinere Unterbrechungen zu ertragen.

Beachten Sie, dass bestimmte VM-Typen, wie z.B. H3, Spot nicht unterstützen.

Fallstudien

AirShaper

AirShaper ist eine Onlineplattform für die Aerodynamik, mit der Designschaffende und Ingenieure Luftströmungssimulationen auf vollständig automatisierte Weise durchführen können. Nutzer ohne Fachwissen im Bereich Aerodynamik erhalten so zuverlässige Ergebnisse und können ihr Design verbessern.

AirShaper migrierte seine HPC Computational Fluid Dynamics (CFD)-Arbeitslasten von einer älteren VM-Plattform auf die neue C2D VM-Familie. Dadurch sparte das Unternehmen im Vergleich zu seiner vorherigen Cloud-Umgebung Simulationszeit und Kosten pro Arbeitslast-Ausführung und konnte die Zeit bis zum Erreichen der Ergebnisse im Vergleich zu seiner lokalen Umgebung drastisch verkürzen.

„Wir bei AirShaper bieten CFD-Simulationen zu einem festen Preis an. Mehr und schnellere Kerne bedeuten in der Regel höhere Gesamtkosten, zum Teil aufgrund von Skalierungsproblemen. Aber mit H3 können wir die Simulationszeiten halbieren und gleichzeitig die Gesamtkosten senken.“

– Wouter Remmerie, CEO, Airshaper

Senkung der Kosten um fast 50 % | Im Vergleich zu lokalen Instanzen konnten sie die Simulationszeiten um mehr als den Faktor 3 reduzieren | 30% kürzere Simulationszeiten als bei Hochleistungs-Computing-Instanzen der vorherigen Generation |

Senkung der Kosten um fast 50 %

Im Vergleich zu lokalen Instanzen konnten sie die Simulationszeiten um mehr als den Faktor 3 reduzieren

30% kürzere Simulationszeiten als bei Hochleistungs-Computing-Instanzen der vorherigen Generation

Logo: Altair

Altair ist ein globales Technologieunternehmen, das Software- und Cloud-Lösungen in den Bereichen Produktentwicklung, Hochleistungs-Computing (HPC) und Datenanalyse anbietet. Die Software von Altair wird von Ingenieuren, Wissenschaftlern und Datenanalysten verwendet, um komplexe Probleme in einer Vielzahl von Branchen zu lösen, darunter Automobil, Luft- und Raumfahrt, Fertigung und Energieerzeugung.

Altair ist ein Google Cloud-Partner und seine Software ist in Google Cloud verfügbar. Die Software von Altair ist für Google Cloud optimiert und kann genutzt werden, um die Leistung, Skalierbarkeit und Flexibilität von Google Cloud zu nutzen. Altair möchte seinen Kunden helfen, ihre HPC-Ziele zu erreichen, und bietet eine breite Palette von Softwarelösungen für HPC an. Dazu gehört beispielsweise Radioss, ein Tool zur Analyse endlicher Elemente. Altair konnte mit der neuen H3-VM erhebliche Verbesserungen bei der cloudbasierten Laufzeit von Radioss verzeichnen.

„Wir bei Altair sind begeistert, dass erste Tests eine bis zu dreifache Reduzierung der Simulationslaufzeit für Radioss-Arbeitslasten auf H3 gegenüber C2 zeigen. Diese deutlich schnelleren Laufzeiten in Google Cloud werden die Entwicklungsproduktivität unserer gemeinsamen Kunden steigern.“

– Eric Lequiniou, Senior Vice President, Radioss Development und Altair Solver

TotalCAE

TotalCAE ist ein führender Anbieter verwalteter HPC-Lösungen für technische und wissenschaftliche Anwendungen. Die Lösungen von TotalCAE sind so konzipiert, dass sie nutzerfreundlich sind und den Kunden helfen, schneller Ergebnisse zu liefern, Kosten zu senken und die Produktivität zu steigern. Die Lösungen von TotalCAE werden von Kunden auf der ganzen Welt genutzt, um komplexe technische und wissenschaftliche Probleme zu lösen. Die Lösungen von TotalCAE werden beispielsweise für die Konstruktion und Simulation von Flugzeugen, Autos und anderen Fahrzeugen, für die Analyse der Leistungsfähigkeit von Gebäuden und Brücken sowie für die Entwicklung neuer Medikamente und Therapien eingesetzt.

TotalCAE ist ein Google Cloud-Partner und seine Lösungen unterstützen Google Cloud. Die Lösungen von TotalCAE sind für Google Cloud optimiert und können verwendet werden, um die Leistung, Skalierbarkeit und Flexibilität von Google Cloud zu nutzen. Dank der HPC-Infrastruktur von Google Cloud konnte TotalCAE seinen Kunden eine bessere Leistung zu geringeren Kosten bieten.

„Mit H3-Instanzen von Google Cloud haben wir eine Leistungssteigerung von bis zu 25 % pro Kern für CAE-Arbeitslasten bei 50 % niedrigeren Job-Kosten als bei C2 festgestellt. Damit kann TotalCAE seinen Kunden eine bis zu 2,5-fach höhere Preisleistung und Skalierbarkeit für CAE-Arbeitslasten auf Google Cloud bieten.“

– Rodney Mach, CEO, TotalCAE

Weitere Informationen zu CAE-Arbeitslasten in Google Cloud

Es gibt viel mehr über HPC- und CAE-Arbeitslasten in Google Cloud zu erfahren. Kontaktieren Sie uns, wenn Sie mit einem Mitglied des Google HPC-Teams sprechen möchten oder Google Cloud verwenden möchten. Bis dahin können Sie alle Ressourcen nutzen, um weiter zu lernen!

Gleich loslegen

Profitieren Sie von einem Guthaben über 300 $, um Google Cloud und mehr als 20 „Immer kostenlos“ Produkte kennenzulernen.

Benötigen Sie Hilfe beim Einstieg?

Vertrieb kontaktierenMit einem zertifizierten Partner arbeiten

Partner findenMehr ansehen

Alle Produkte ansehen