Cette page décrit l'agent de commerce conversationnel Vertex AI Search pour le commerce, qui est une fonctionnalité de recherche guidée. La fonctionnalité d'agent de commerce conversationnel fait partie du package de recherche guidée. Elle offre aux utilisateurs une expérience conversationnelle continue et plus interactive en temps réel.

Qu'est-ce qu'un agent de commerce conversationnel ?

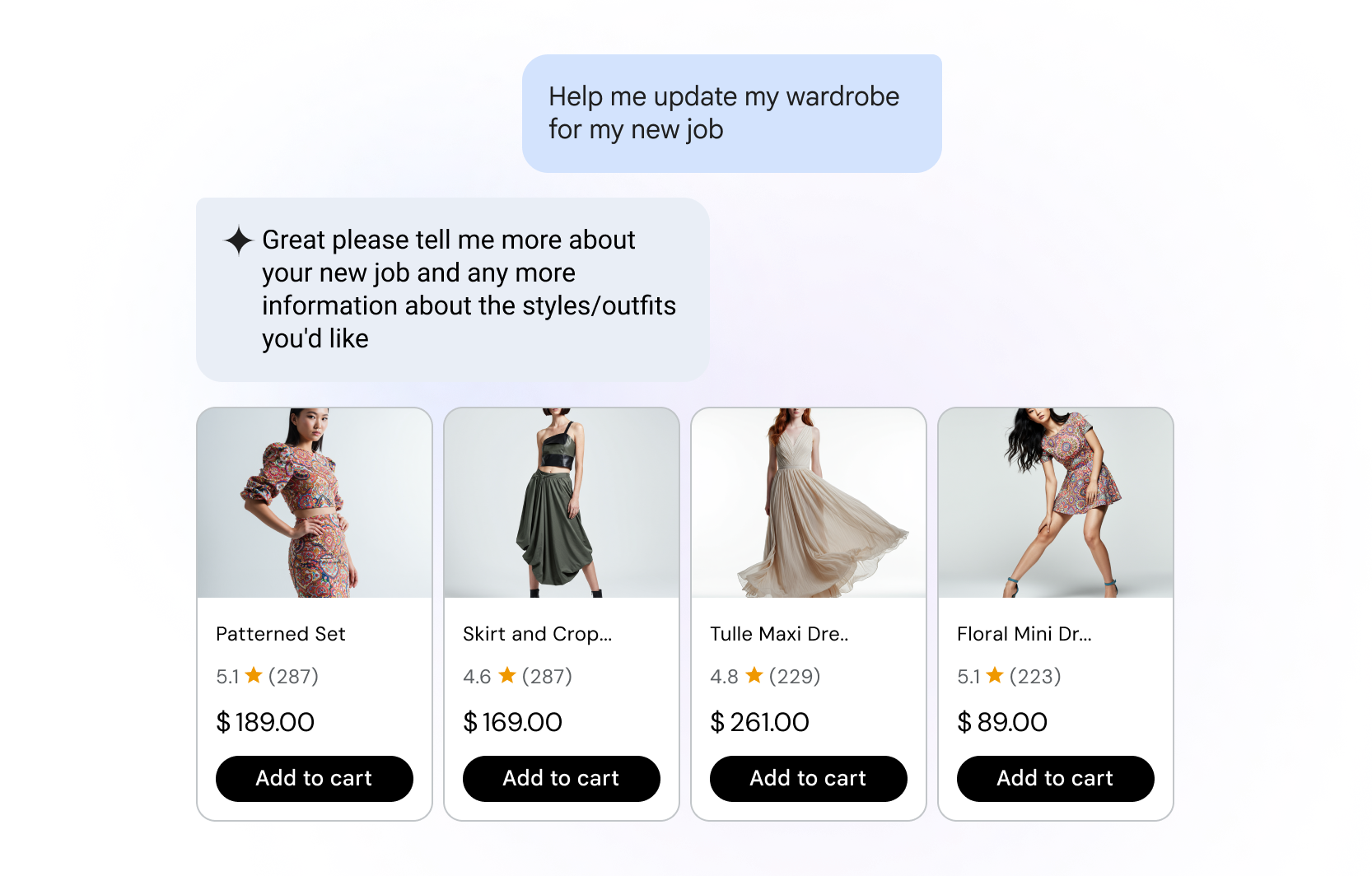

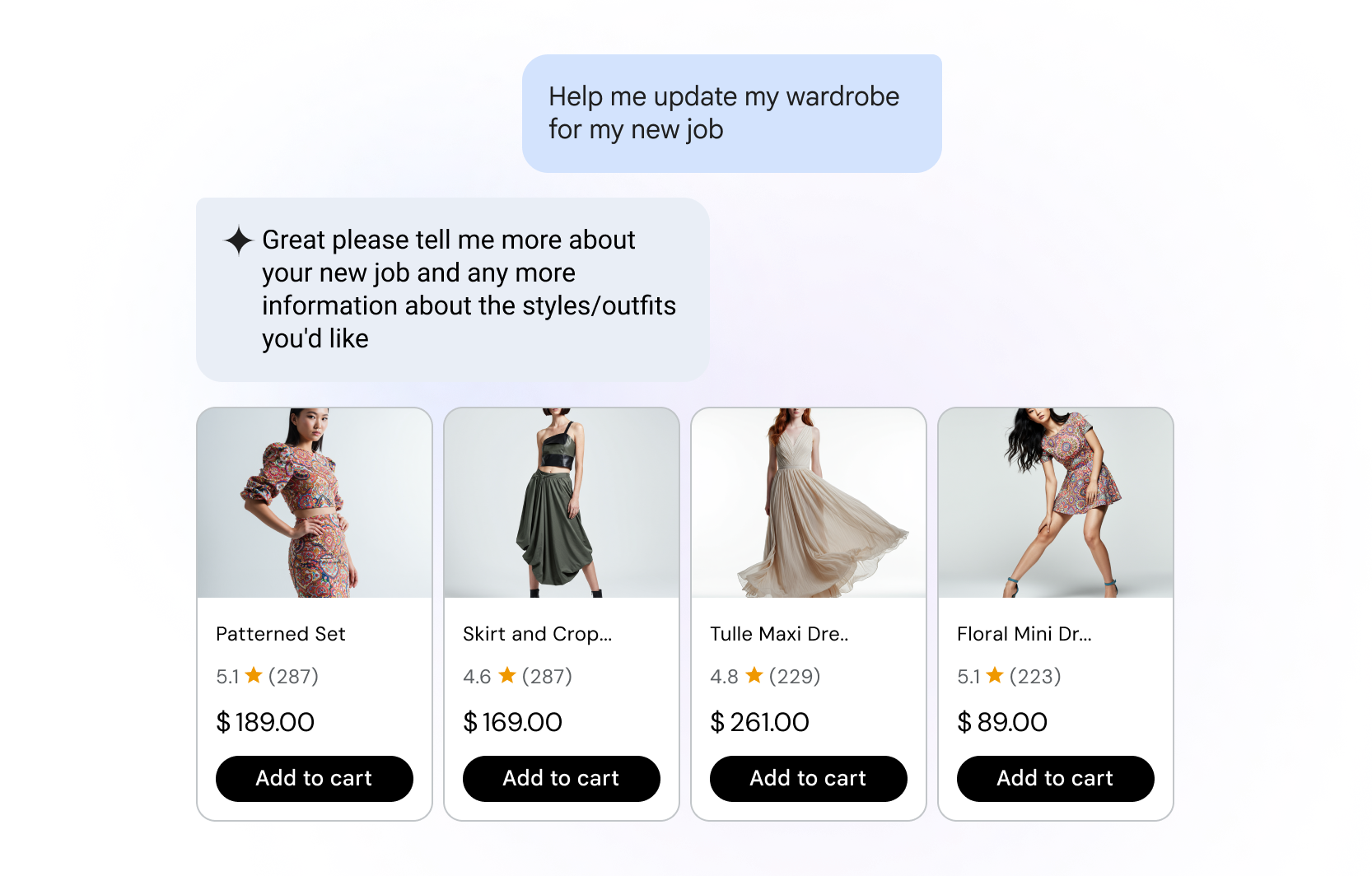

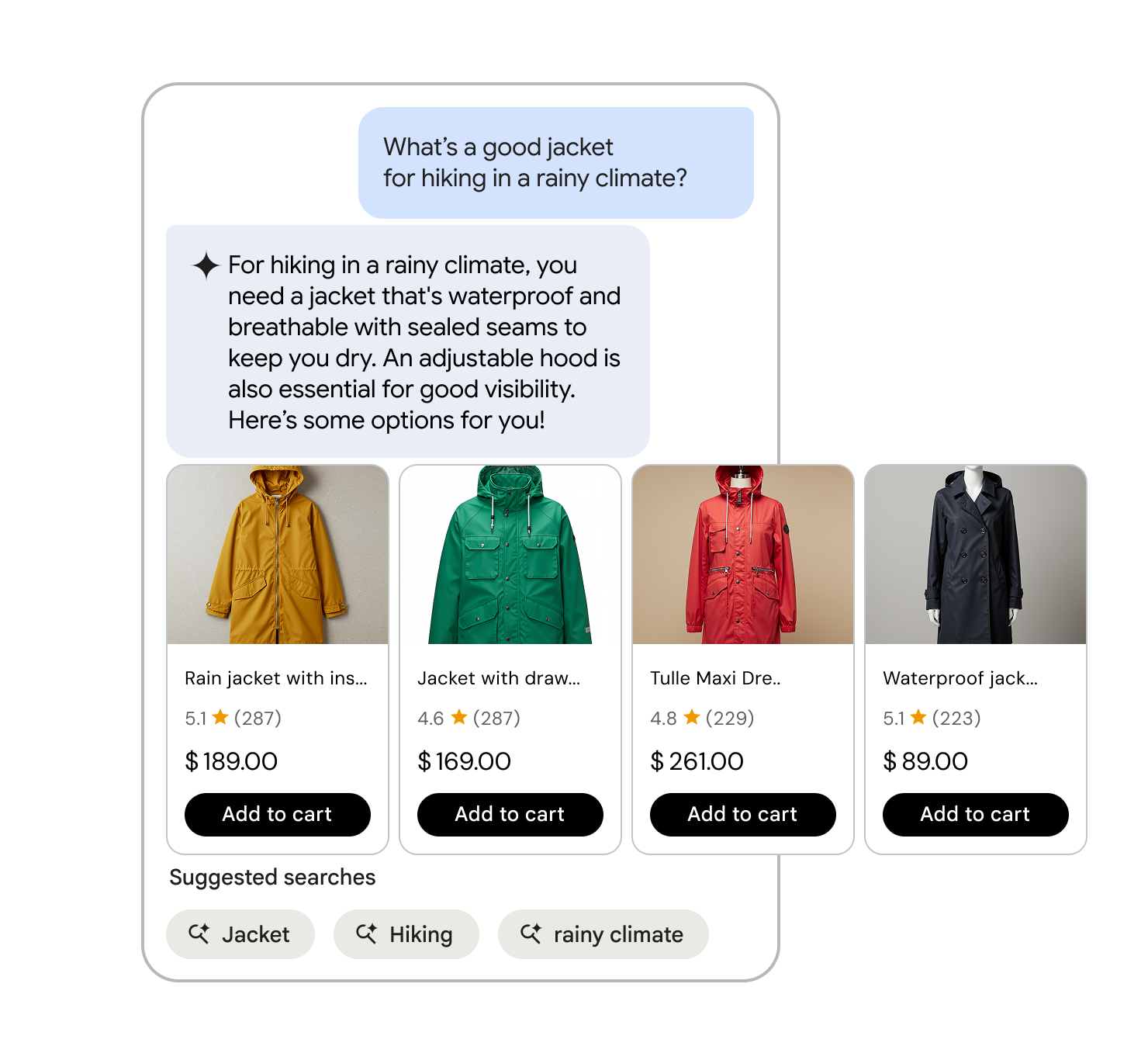

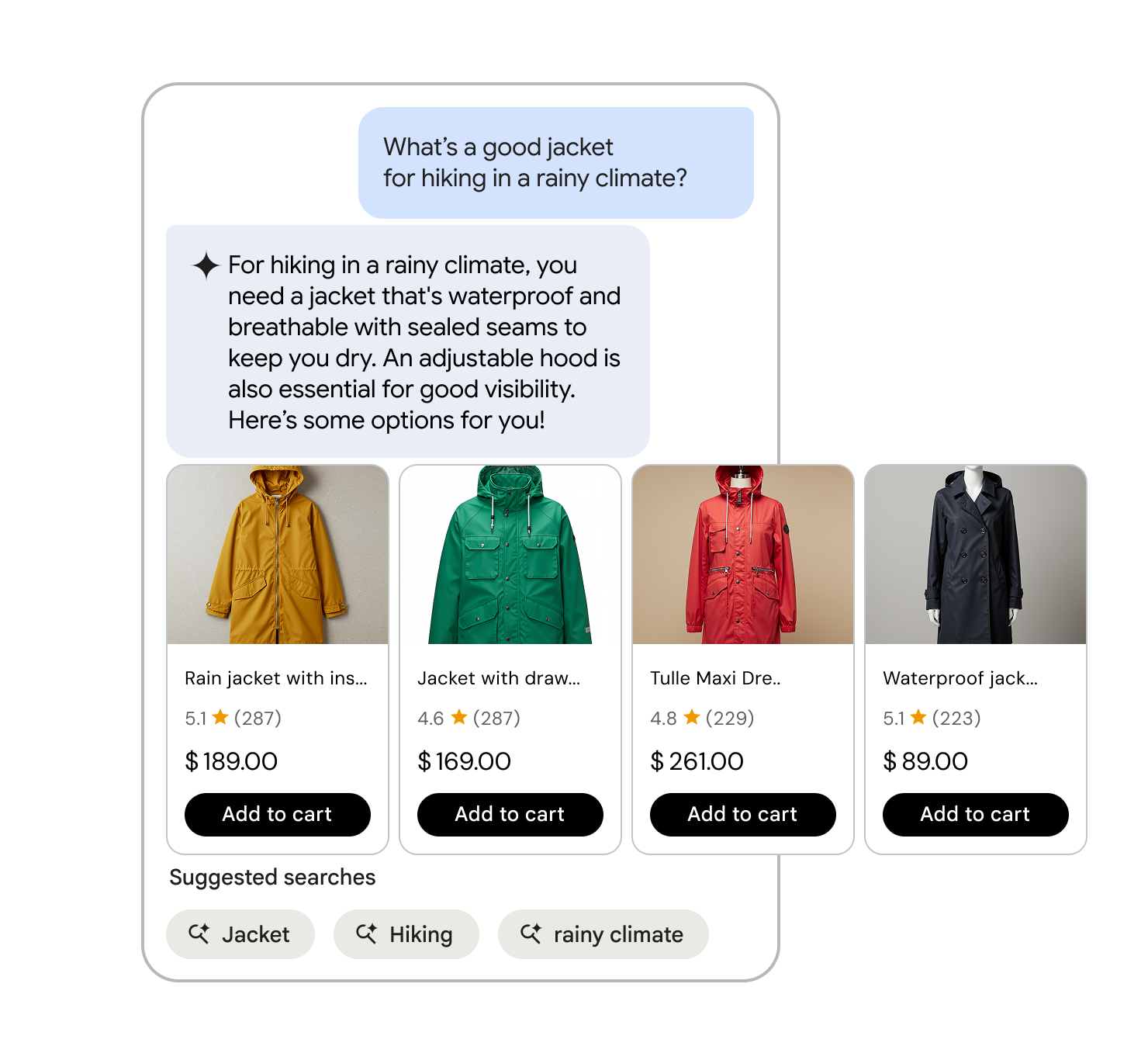

L'agent de commerce conversationnel est un outil de recherche guidée et de découverte de produits basé sur l'IA. Au lieu de rechercher avec des mots clés, les utilisateurs utilisent le langage naturel pour demander ce dont ils ont besoin, y compris des questions de suivi, des interactions multimodales, une meilleure compréhension de l'intention et un ancrage avec des données au-delà du catalogue de produits. Cette approche permet de filtrer les résultats de manière plus intuitive et efficace, ce qui aide les utilisateurs à trouver plus précisément et plus rapidement ce qu'ils recherchent.

Capacités de l'agent de commerce conversationnel

L'agent Conversational Commerce améliore l'expérience Vertex AI Search pour le commerce de la manière suivante :

- Affiner efficacement les requêtes des utilisateurs : l'agent de commerce conversationnel filtre 10 000 produits pour n'en retenir qu'une centaine, ce qui augmente la probabilité que l'utilisateur décide d'effectuer un achat.

- Hyperpersonnalisation : les agents de recherche analysent les préférences, l'historique des achats et l'activité sur les réseaux sociaux des acheteurs pour leur proposer des recommandations de produits, des promotions et des expériences d'achat plus personnalisées.

- Parcours complets intégrés : de la découverte des produits au paiement, les agents de recherche accompagnent l'utilisateur final tout au long de son parcours d'achat grâce à une conversation immersive, dynamique et continue.

- Adapté au cas d'utilisation du commerce : l'agent de commerce conversationnel couvre l'e-commerce, la découverte de produits et l'assistance.

- Expériences utilisateur immersives : grâce aux agents de recherche qui organisent les conversations des utilisateurs, la réalité augmentée et la réalité virtuelle peuvent également être implémentées sur le site du marchand pour créer des essayages virtuels, des visites de magasin et des visualisations spatiales de produits.

Impact de l'agent de commerce conversationnel

Élément central du package de recherche guidée, l'agent de commerce conversationnel améliore la pertinence des résultats de recherche et réduit les frictions pour les utilisateurs.

La recherche commerciale habituelle est la méthode la plus courante pour trouver des produits. Les approches habituelles s'appuient sur une correspondance stricte des mots clés, ce qui oblige vos utilisateurs à utiliser des mots spécifiques et à ajuster manuellement les filtres pour affiner les résultats. Toutefois, seuls 1 consommateur sur 10 affirme trouver exactement ce qu'il recherche lorsqu'il utilise l'ancienne recherche par mots clés.

L'agent de commerce conversationnel résout les problèmes les plus frustrants pour les utilisateurs lors de la recherche, tels que les correspondances inexactes, les résultats non pertinents ou les requêtes sans résultat.

Compréhension du langage naturel

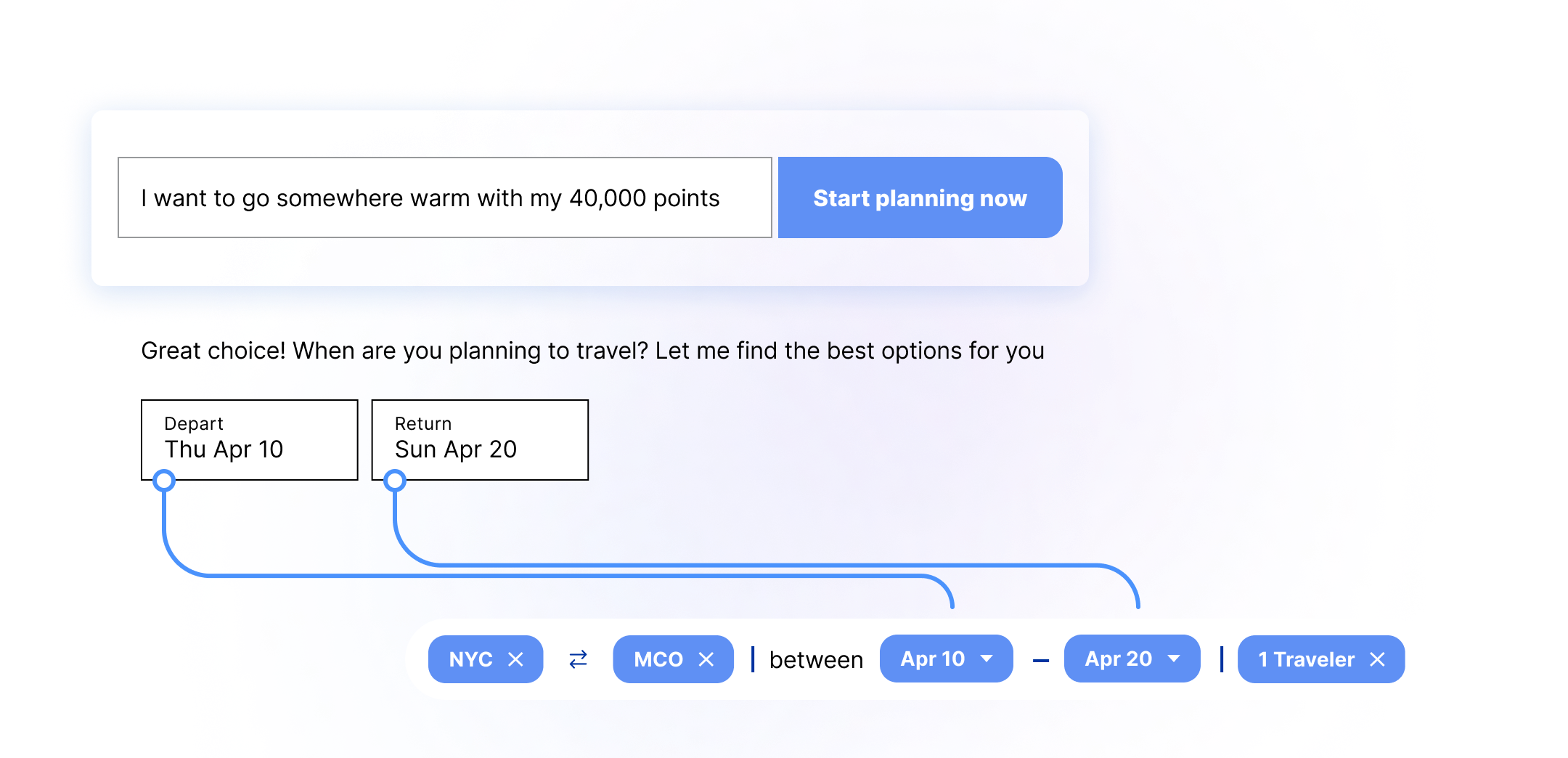

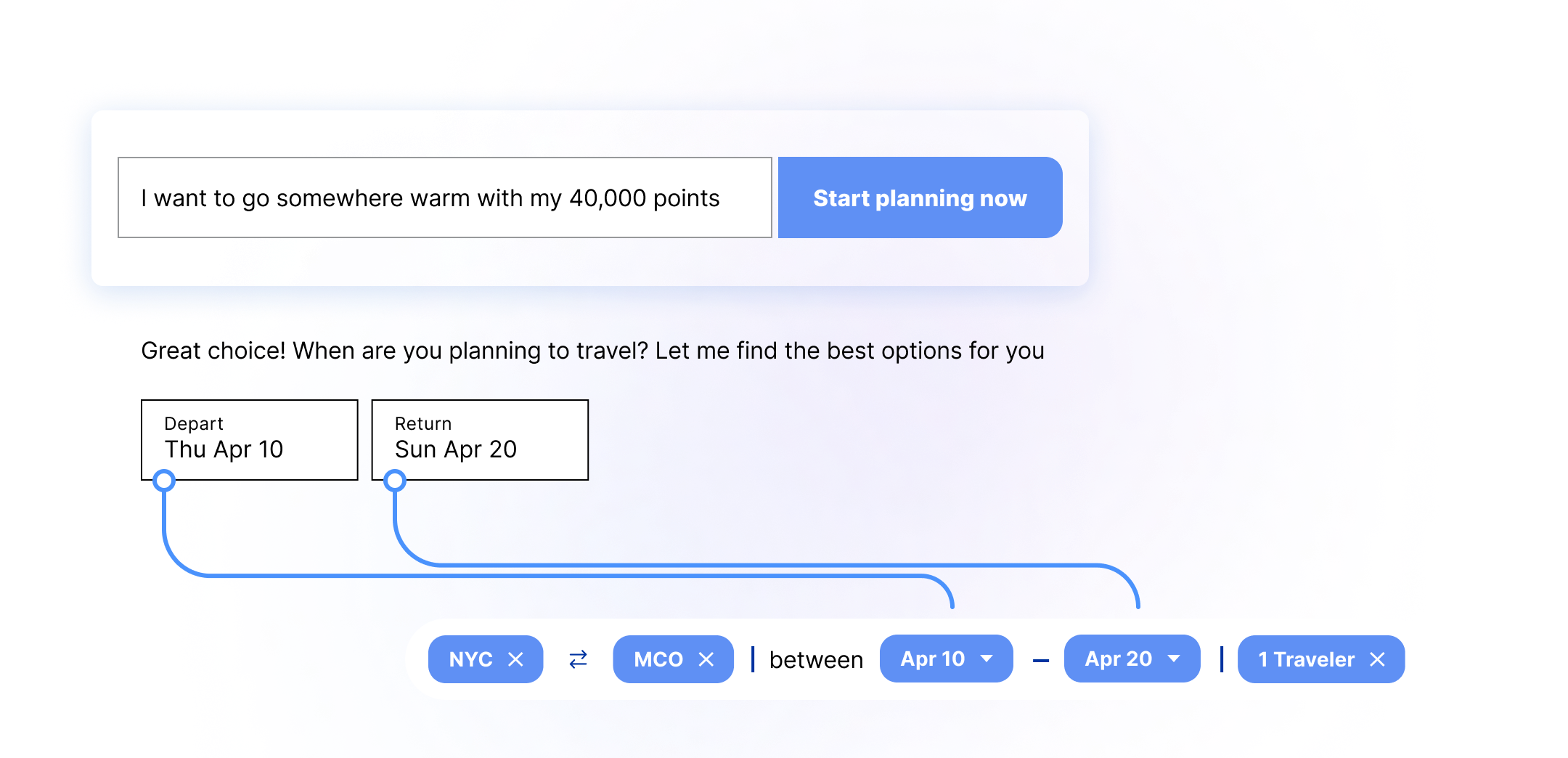

La recherche optimisée par l'IA reconnaît les requêtes en langage naturel, interprète l'intention et tient compte des variations linguistiques.

Assistance prédictive

Aide les utilisateurs à formuler des requêtes plus efficacement en suggérant des complétions à mesure qu'ils saisissent du texte.

Entrées multimodales

L'agent de commerce conversationnel permet aux utilisateurs d'effectuer des recherches à l'aide de méthodes d'entrée multimodales telles que la voix et les images, en plus du texte. Elle comprend l'intention de l'utilisateur, le contexte et les variations de langage naturel dans la formulation sans perdre le contexte.

- Recherche vocale : les requêtes vocales sont souvent structurées différemment de celles saisies au clavier. Vertex AI Search for Commerce traite ces variations en tenant compte de variables telles que les accents, le bruit de fond, les hésitations et les mots de remplissage. Sur mobile, la recherche vocale est non seulement plus facile à saisir, mais elle peut également prendre moins de place à l'écran, ce qui permet d'afficher plus de visuels de produits immobiliers.

- Recherche d'images : la reconnaissance d'images permet de trouver plus rapidement un article similaire ou unique dans un post sur les réseaux sociaux ou en prenant une photo dans la vie réelle. Les acheteurs peuvent ensuite utiliser la recherche d'images pour trouver rapidement un article similaire sur votre site.

Expérience axée sur le mobile

En 2024, près de 80 % des visites d'e-commerce dans le monde ont eu lieu sur un téléphone mobile. Les écrans plus petits, les sessions utilisateur plus courtes et les menus regroupés posent des défis uniques aux anciennes expériences de recherche. L'agent de commerce conversationnel est conçu pour permettre aux utilisateurs d'accéder à toute la puissance de la recherche optimisée par l'IA depuis leurs appareils mobiles.

Rôle de la recherche externe et des assistants IA

Lorsqu'un utilisateur a un marchand préféré, il a tendance à s'y rendre directement. Toutefois, lorsqu'ils explorent de nouvelles options ou des options plus larges, le parcours utilisateur commence plus souvent par une orientation vers une place de marché, comme la recherche Google ou un assistant IA.

À mesure que la recherche basée sur l'IA évolue, le package de recherche guidée Vertex AI Search pour le commerce comble le fossé entre la découverte de produits en externe et sur site. En traitant la transition vers le site e-commerce comme une conversation unique et fluide, l'agent de commerce conversationnel permet aux utilisateurs de trouver rapidement des résultats pertinents.