Vertex AI Platform

Schnellere Innovationen mit KI für Unternehmen, unterstützt durch Gemini-Modelle

Vertex AI ist eine vollständig verwaltete, einheitliche KI-Entwicklungsplattform zum Erstellen und Verwenden von Anwendungen basierend auf generativer KI. Greifen Sie über Vertex AI Studio auf Agent Builder und über 200 Foundation Models zu.

Neukunden erhalten ein Guthaben von bis zu 300 $, um Vertex AI und andere Google Cloud-Produkte auszuprobieren.

Features

Gemini, das leistungsstärkste multimodale Modell von Google

Vertex AI bietet Zugriff auf die neuesten Gemini-Modelle von Google. Gemini ist in der Lage, praktisch jede Eingabe zu verstehen, verschiedene Arten von Informationen zu kombinieren und fast jede Ausgabe zu generieren. Testen Sie Gemini in Vertex AI Studio mit Text, Bildern, Video oder Code. Mit der fortschrittlichen Logik und den hochmodernen Funktionen von Gemini können Entwickler Beispiel-Prompts ausprobieren, um Text aus Bildern zu extrahieren, Bildtext in JSON zu konvertieren und sogar Antworten zu hochgeladenen Bildern zu generieren, um KI-Anwendungen der nächsten Generation zu entwickeln.

Mehr als 200 generative KI-Modelle und -Tools

In Model Garden haben Sie die Wahl zwischen einer Vielzahl von Modellen mit Erstanbieter- (Gemini, Imagen, Chirp, Veo), Drittanbieter- (Claude Model Family von Anthropic) und offenen Modellen (Gemma, Llama 3.2). Über Erweiterungen können Modelle Echtzeitinformationen abrufen und Aktionen auslösen. Mit einer Vielzahl von Feinabstimmungsoptionen für die Text-, Bild- und Code-Modelle von Google können Sie Modelle an Ihren Anwendungsfall anpassen.

Generative KI-Modelle und vollständig verwaltete Tools erleichtern das Erstellen, Anpassen, Einbinden und Bereitstellen von Prototypen in Anwendungen.

Offene und integrierte KI-Plattform

Data Scientists können mit den Vertex AI Platform-Tools zum Trainieren, Abstimmen und Bereitstellen von ML-Modellen schneller arbeiten.

Vertex AI-Notebooks, einschließlich Colab Enterprise oder Workbench nach Ihrer Wahl, sind nativ in BigQuery eingebunden und bieten eine zentrale Oberfläche für alle Daten- und KI-Arbeitslasten.

Mit Vertex AI Training und Vorhersage können Sie die Trainingszeit reduzieren und Modelle mithilfe von Open-Source-Frameworks Ihrer Wahl und einer optimierten KI-Infrastruktur ganz einfach in der Produktion bereitstellen.

MLOps für prädiktive und generative KI

Die Vertex AI Platform bietet maßgeschneiderte MLOps-Tools für Data Scientists und ML-Entwickler, um ML-Projekte zu automatisieren, zu standardisieren und zu verwalten.

Modulare Tools helfen Ihnen dabei, teamübergreifend zusammenzuarbeiten und Modelle während des gesamten Entwicklungszyklus zu verbessern. Mit Vertex AI Evaluation können Sie das beste Modell für einen Anwendungsfall ermitteln und Workflows mit Vertex AI Pipelines orchestrieren, alle Modelle mit Model Registry verwalten, ML-Funktionen mit Feature Store bereitstellen, freigeben und wiederverwenden sowie Modelle auf Eingabeabweichungen und ‑Drift überwachen.

Agent-Builder

Mit Vertex AI Agent Builder können Entwickler ganz einfach für Unternehmen geeignete generative KI-Erlebnisse erstellen und bereitstellen. Bietet den Komfort einer No-Code-Agent-Builder-Konsole sowie leistungsstarke Fundament-, Orchestrierungs- und Anpassungsfunktionen. Mit Vertex AI Agent Builder können Entwickler schnell eine Reihe von Agents und Anwendungen für generative KI erstellen, die auf den Daten ihrer Organisation basieren.

Funktionsweise

Vertex AI bietet mehrere Optionen für das Modelltraining und die Bereitstellung:

- Generative KI bietet Zugriff auf große generative KI-Modelle, einschließlich Gemini 2.0, damit Sie sie für die Verwendung in KI-Anwendungen bewerten, optimieren und bereitstellen können.

- Mit Model Garden können Sie Vertex AI ermitteln, testen, anpassen und bereitstellen sowie Open-Source-Modelle und Assets auswählen.

- Benutzerdefiniertes Training gibt Ihnen vollständige Kontrolle über den Trainingsprozess. Dazu gehört die Verwendung Ihres bevorzugten ML-Frameworks, das Schreiben eines eigenen Trainingscodes und das Auswählen von Optionen für die Hyperparameter-Abstimmung.

Vertex AI bietet mehrere Optionen für das Modelltraining und die Bereitstellung:

- Generative KI bietet Zugriff auf große generative KI-Modelle, einschließlich Gemini 2.0, damit Sie sie für die Verwendung in KI-Anwendungen bewerten, optimieren und bereitstellen können.

- Mit Model Garden können Sie Vertex AI ermitteln, testen, anpassen und bereitstellen sowie Open-Source-Modelle und Assets auswählen.

- Benutzerdefiniertes Training gibt Ihnen vollständige Kontrolle über den Trainingsprozess. Dazu gehört die Verwendung Ihres bevorzugten ML-Frameworks, das Schreiben eines eigenen Trainingscodes und das Auswählen von Optionen für die Hyperparameter-Abstimmung.

Gängige Einsatzmöglichkeiten

Mit Gemini erstellen

Zugriff auf Gemini-Modelle über die Gemini API in Google Cloud Vertex AI

- Python

- JavaScript

- Java

- Einfach loslegen (Go)

- Curl

Codebeispiel

Zugriff auf Gemini-Modelle über die Gemini API in Google Cloud Vertex AI

- Python

- JavaScript

- Java

- Einfach loslegen (Go)

- Curl

Generative KI in Anwendungen

Einführung in generative KI in Vertex AI

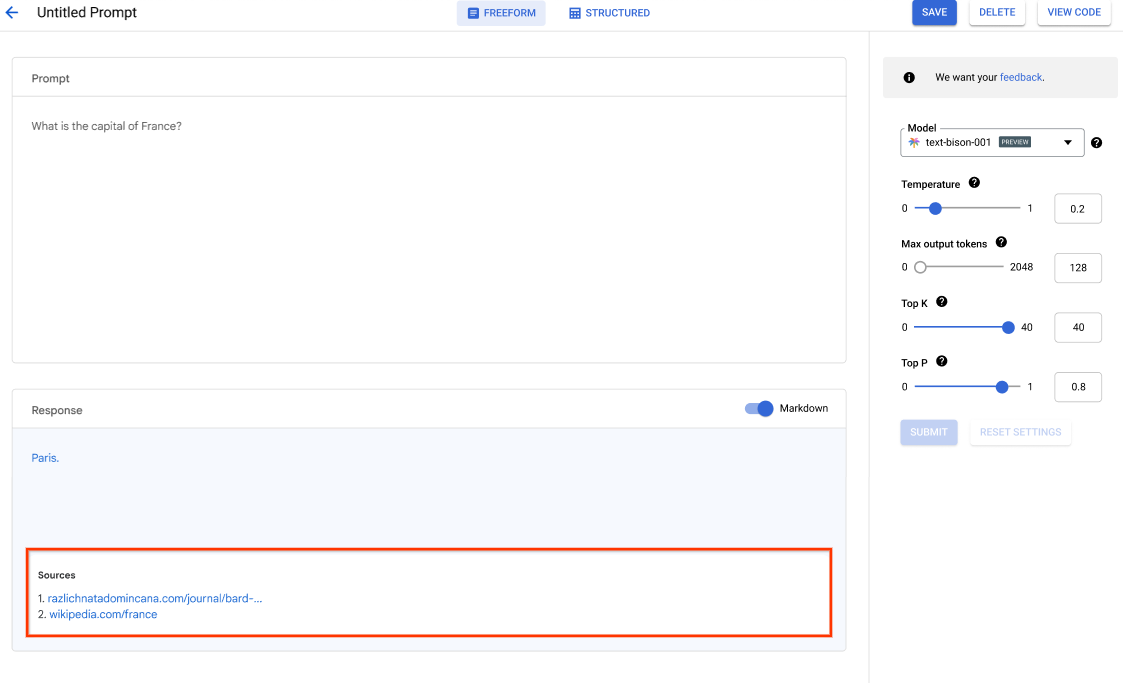

Vertex AI Studio bietet eine Google Cloud Console zum schnellen Prototyping und Testen von generativen KI-Modellen. Hier erfahren Sie, wie Sie Generative AI Studio dazu verwenden können, Modelle anhand von Prompt-Beispielen zu testen, Prompts zu entwerfen und zu speichern, ein Foundation Model zu optimieren und zwischen Sprache und Text umzuwandeln.

In Generative AI Studio LLMs optimieren

Tutorials, Kurzanleitungen und Labs

Einführung in generative KI in Vertex AI

Vertex AI Studio bietet eine Google Cloud Console zum schnellen Prototyping und Testen von generativen KI-Modellen. Hier erfahren Sie, wie Sie Generative AI Studio dazu verwenden können, Modelle anhand von Prompt-Beispielen zu testen, Prompts zu entwerfen und zu speichern, ein Foundation Model zu optimieren und zwischen Sprache und Text umzuwandeln.

In Generative AI Studio LLMs optimieren

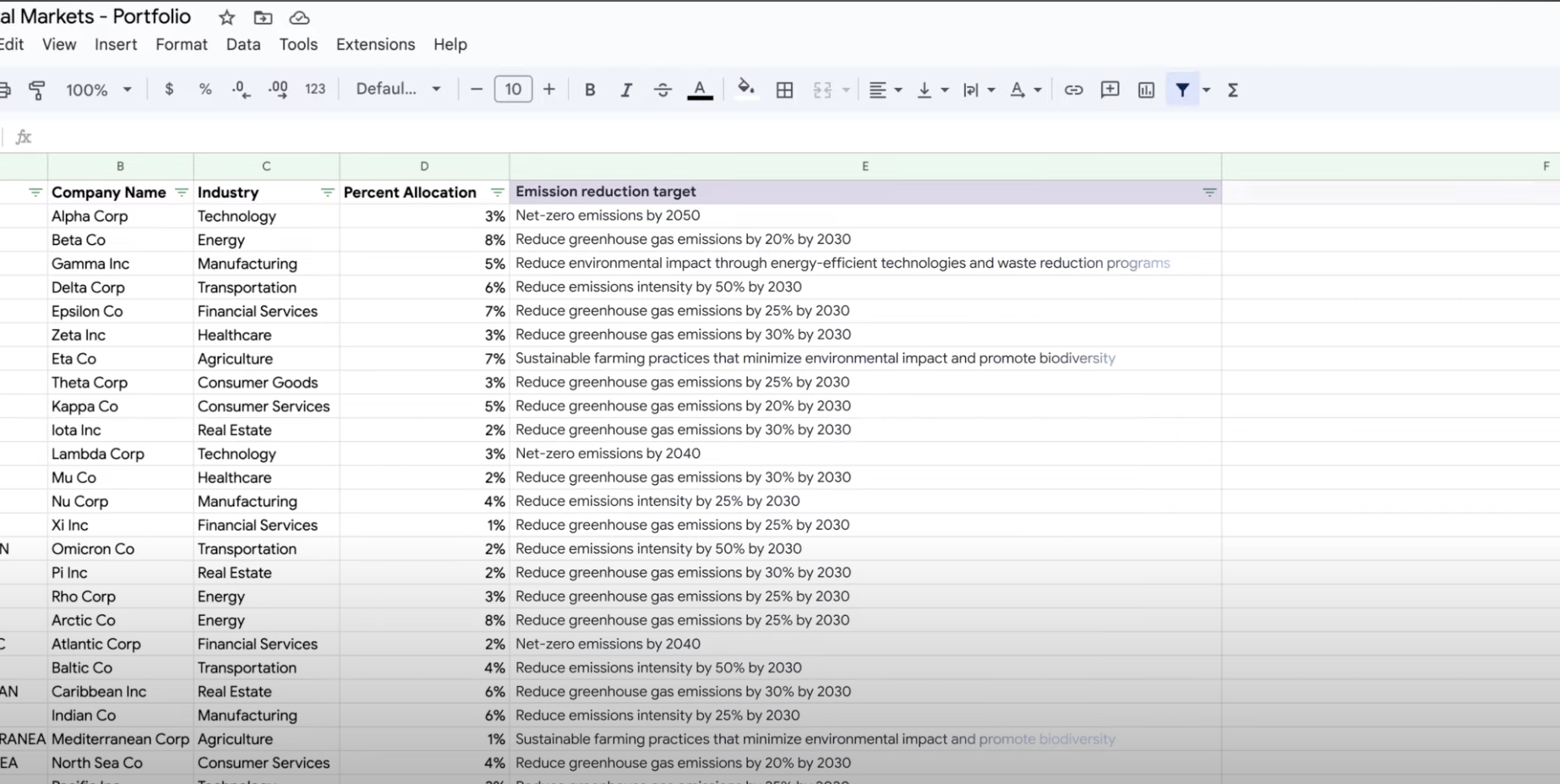

Daten extrahieren, zusammenfassen und klassifizieren

Generative KI zur Zusammenfassung, Klassifizierung und Extraktion verwenden

Hier erfahren Sie, wie Sie mit der Unterstützung von generativer KI von Vertex AI Text-Prompts für die Verarbeitung einer beliebigen Anzahl von Aufgaben erstellen. Zu den gängigsten Aufgaben zählen Klassifizierung, Zusammenfassung und Extraktion. Mit Gemini in Vertex AI können Sie Prompts in Bezug auf Struktur und Format flexibel entwerfen.

Tutorials, Kurzanleitungen und Labs

Generative KI zur Zusammenfassung, Klassifizierung und Extraktion verwenden

Hier erfahren Sie, wie Sie mit der Unterstützung von generativer KI von Vertex AI Text-Prompts für die Verarbeitung einer beliebigen Anzahl von Aufgaben erstellen. Zu den gängigsten Aufgaben zählen Klassifizierung, Zusammenfassung und Extraktion. Mit Gemini in Vertex AI können Sie Prompts in Bezug auf Struktur und Format flexibel entwerfen.

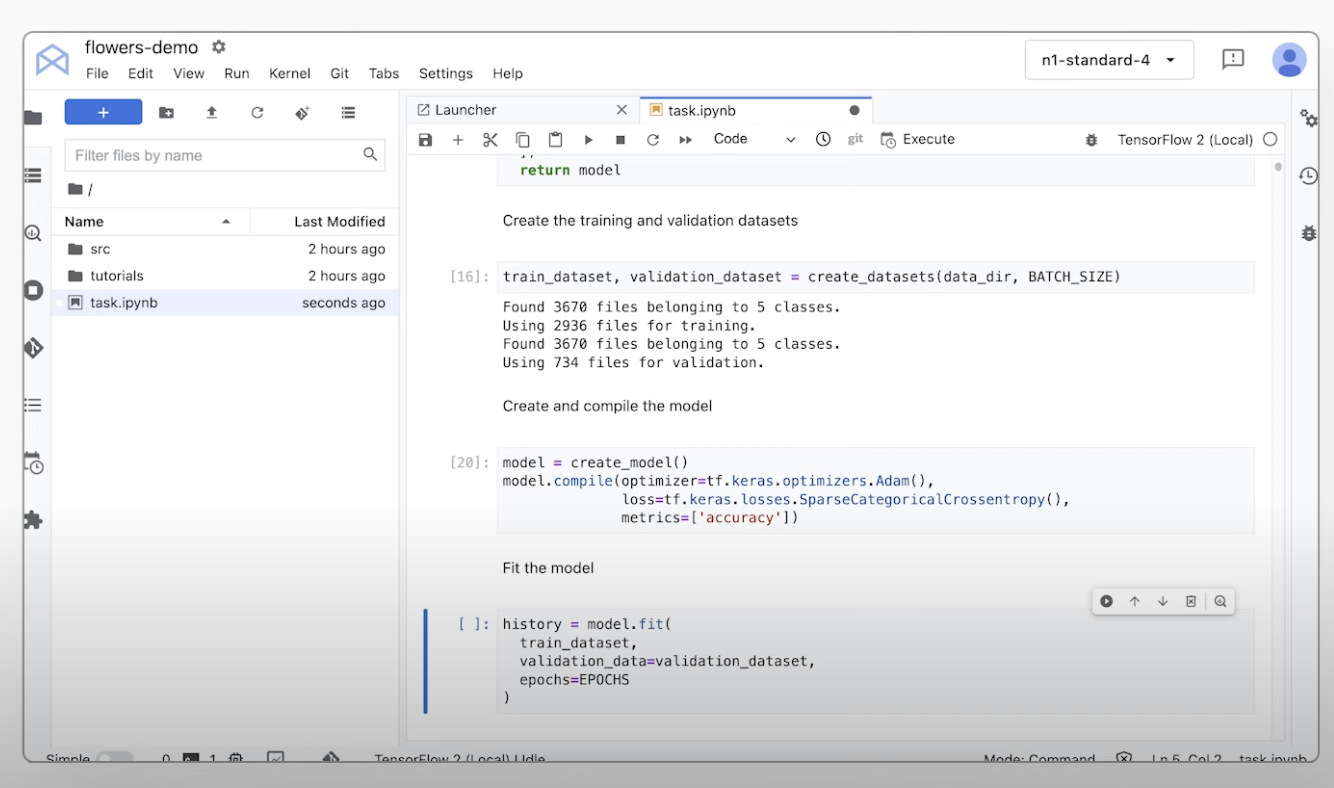

Benutzerdefinierte ML-Modelle trainieren

Benutzerdefiniertes ML-Training – Übersicht und Dokumentation

In dieser Schritt-für-Schritt-Videoanleitung werden die Schritte beschrieben, die zum Trainieren benutzerdefinierter Modelle in Vertex AI erforderlich sind.

Tutorials, Kurzanleitungen und Labs

Benutzerdefiniertes ML-Training – Übersicht und Dokumentation

In dieser Schritt-für-Schritt-Videoanleitung werden die Schritte beschrieben, die zum Trainieren benutzerdefinierter Modelle in Vertex AI erforderlich sind.

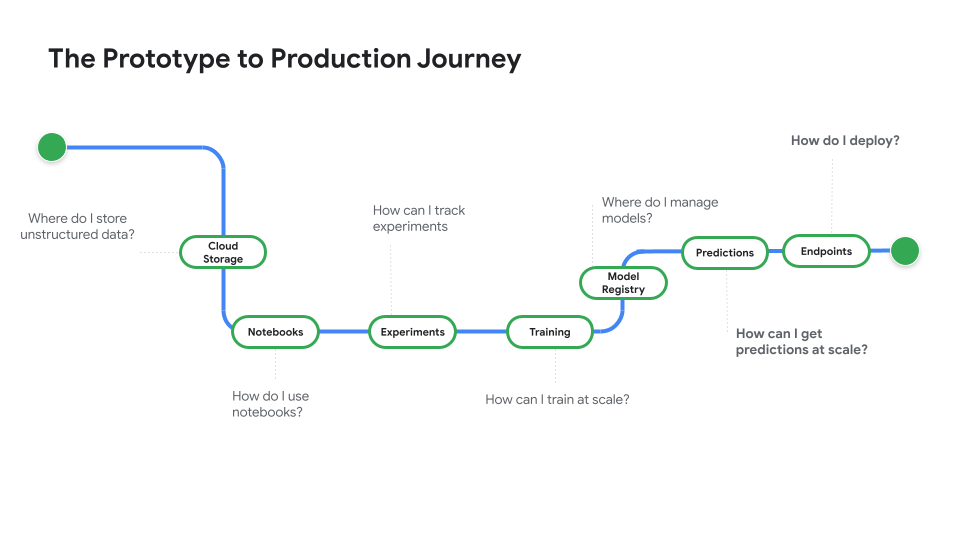

Modell für die Produktion bereitstellen

Für Batch- oder Onlinevorhersagen bereitstellen

Sehen Sie sich die Videoreihe Von Prototyp zur Produktion an, die Sie vom Notebook-Code bis zu einem bereitgestellten Modell führt.

Tutorials, Kurzanleitungen und Labs

Für Batch- oder Onlinevorhersagen bereitstellen

Sehen Sie sich die Videoreihe Von Prototyp zur Produktion an, die Sie vom Notebook-Code bis zu einem bereitgestellten Modell führt.

Preise

| Details zu den Vertex AI-Preisen | Bezahlen Sie nur für die verwendeten Vertex AI-Tools, Speicher-, Computing- und Cloud-Ressourcen. Neukunden erhalten ein Guthaben von 300 $, um Vertex AI und Google Cloud-Produkte auszuprobieren. | |

|---|---|---|

| Tools und Verwendung | Beschreibung | Preis |

Generative KI | Imagen-Modell für die Bildgenerierung Basierend auf den Preisen für Bild- und Zeicheneingabe oder für das benutzerdefinierte Training. | Ab 0,0001 $ |

Text-, Chat- und Codegenerierung Basierend auf jeweils 1.000 Zeichen Eingabe (Prompt) und je 1.000 Zeichen Ausgabe (Antwort). | Ab 0,0001 $ pro 1.000 Zeichen | |

AutoML-Modelle | Training, Bereitstellung und Vorhersage von Bilddaten Basierend auf der Trainingszeit pro Knotenstunde, die die Ressourcennutzung widerspiegelt, und ob der Zweck die Klassifizierung oder die Objekterkennung ist. | Ab 1,375 $ pro Knotenstunde |

Training und Vorhersage von Videodaten Basierend auf dem Preis pro Knotenstunde und ob der Zweck Klassifizierung, Objekt-Tracking oder Aktionserkennung ist. | Ab 0,462 $ pro Knotenstunde | |

Tabellarisches Datentraining und -vorhersage Basierend auf dem Preis pro Knotenstunde und ob der Zweck Klassifizierung/Regression oder Prognose ist. Wenden Sie sich an den Vertrieb, um Informationen zu möglichen Rabatten und Preisen zu erhalten. | Vertrieb kontaktieren | |

Upload, Training, Bereitstellung und Vorhersage von Textdaten Basierend auf Stundensätzen für Training und Vorhersage, Seiten für den Upload von Legacy-Daten (nur PDF) sowie Textdatensätzen und Seiten für die Vorhersage. | Ab 0,05 $ pro Stunde | |

Benutzerdefinierte Modelle | Training von benutzerdefiniertem Modell Basierend auf dem pro Stunde verwendeten Maschinentyp, der Region und den verwendeten Beschleunigern. Fordern Sie einen Kostenvoranschlag über den Vertrieb oder unseren Preisrechner an. | Vertrieb kontaktieren |

Vertex AI Notebooks | Computing- und Speicherressourcen Basiert auf den Preisen, die auch für Compute Engine und Cloud Storage gelten. | Auf Produkte verweisen |

Verwaltungsgebühren Zusätzlich zur oben genannten Ressourcennutzung fallen Verwaltungsgebühren je nach verwendeter Region, Instanzen, Notebooks und verwalteten Notebooks an. Details ansehen. | Weitere Informationen | |

Vertex AI Pipelines | Ausführungs- und zusätzliche Gebühren Basierend auf der Ausführungsgebühr, den verwendeten Ressourcen und möglichen zusätzlichen Servicegebühren. | Ab 0,03 $ Pro Pipelineausführung |

Vertex AI Vektorsuche | Kosten für Bereitstellung und Erstellung Abhängig von der Größe Ihrer Daten, der Anzahl der Abfragen pro Sekunde, die Sie ausführen möchten, und der Anzahl der verwendeten Knoten. View example. | Siehe Beispiel |

Preisdetails für alle Features und Dienste von Vertex AI.

Details zu den Vertex AI-Preisen

Bezahlen Sie nur für die verwendeten Vertex AI-Tools, Speicher-, Computing- und Cloud-Ressourcen. Neukunden erhalten ein Guthaben von 300 $, um Vertex AI und Google Cloud-Produkte auszuprobieren.

Imagen-Modell für die Bildgenerierung

Basierend auf den Preisen für Bild- und Zeicheneingabe oder für das benutzerdefinierte Training.

Starting at

0,0001 $

Text-, Chat- und Codegenerierung

Basierend auf jeweils 1.000 Zeichen Eingabe (Prompt) und je 1.000 Zeichen Ausgabe (Antwort).

Starting at

0,0001 $

pro 1.000 Zeichen

Training, Bereitstellung und Vorhersage von Bilddaten

Basierend auf der Trainingszeit pro Knotenstunde, die die Ressourcennutzung widerspiegelt, und ob der Zweck die Klassifizierung oder die Objekterkennung ist.

Starting at

1,375 $

pro Knotenstunde

Training und Vorhersage von Videodaten

Basierend auf dem Preis pro Knotenstunde und ob der Zweck Klassifizierung, Objekt-Tracking oder Aktionserkennung ist.

Starting at

0,462 $

pro Knotenstunde

Tabellarisches Datentraining und -vorhersage

Basierend auf dem Preis pro Knotenstunde und ob der Zweck Klassifizierung/Regression oder Prognose ist. Wenden Sie sich an den Vertrieb, um Informationen zu möglichen Rabatten und Preisen zu erhalten.

Vertrieb kontaktieren

Upload, Training, Bereitstellung und Vorhersage von Textdaten

Basierend auf Stundensätzen für Training und Vorhersage, Seiten für den Upload von Legacy-Daten (nur PDF) sowie Textdatensätzen und Seiten für die Vorhersage.

Starting at

0,05 $

pro Stunde

Training von benutzerdefiniertem Modell

Basierend auf dem pro Stunde verwendeten Maschinentyp, der Region und den verwendeten Beschleunigern. Fordern Sie einen Kostenvoranschlag über den Vertrieb oder unseren Preisrechner an.

Vertrieb kontaktieren

Computing- und Speicherressourcen

Basiert auf den Preisen, die auch für Compute Engine und Cloud Storage gelten.

Auf Produkte verweisen

Verwaltungsgebühren

Zusätzlich zur oben genannten Ressourcennutzung fallen Verwaltungsgebühren je nach verwendeter Region, Instanzen, Notebooks und verwalteten Notebooks an. Details ansehen.

Weitere Informationen

Ausführungs- und zusätzliche Gebühren

Basierend auf der Ausführungsgebühr, den verwendeten Ressourcen und möglichen zusätzlichen Servicegebühren.

Starting at

0,03 $

Pro Pipelineausführung

Vertex AI Vektorsuche

Kosten für Bereitstellung und Erstellung

Abhängig von der Größe Ihrer Daten, der Anzahl der Abfragen pro Sekunde, die Sie ausführen möchten, und der Anzahl der verwendeten Knoten. View example.

Siehe Beispiel

Preisdetails für alle Features und Dienste von Vertex AI.

Proof of Concept starten

Anwendungsszenario

Das volle Potenzial von generativer KI ausschöpfen

„Die Präzision der Lösung für generative KI von Google Cloud und die praktische Funktion der Vertex AI Platform gibt uns die Zuversicht, dass wir mit der Implementierung dieser hochmodernen Technologie in das Herzstück unseres Unternehmens unser langfristiges Ziel einer Reaktionszeit von null Minuten erreichen werden.“

Abdol Moabery, CEO von GA Telesis

Analystenberichte

TKTKT

Google wurde im Bericht The Forrester Wave™: AI Infrastructure Solutions, Q1 2024 als einer der führenden Anbieter eingestuft und erhielt die höchste Punktzahl aller Anbieter, die sowohl im Bereich „Aktuelles Angebot“ als auch „Strategie“ bewertet wurden.

Google im Bericht „The Forrester Wave™: AI Foundation Models For Language, Q2 2024“ als einer der führenden Anbieter eingestuft Bericht lesen

Google im Bericht „The Forrester Wave: AI/ML Platforms, Q3 2024“ als führender Anbieter eingestuft. Weitere Informationen.