Questo tutorial mostra come esporre più servizi gRPC di cui è stato eseguito il deployment su Google Kubernetes Engine (GKE) su un singolo indirizzo IP esterno utilizzando un bilanciatore del carico di rete passthrough esterno e proxy Envoy. Il tutorial mette in evidenza alcune delle funzionalità avanzate fornite da Envoy per gRPC.

Introduzione

gRPC è un framework RPC open source, indipendente dal linguaggio, basato su HTTP/2 che utilizza buffer di protocollo per una rappresentazione efficiente on-the-wire e una serializzazione rapida. Ispirato a Stubby, il framework RPC interno di Google, gRPC consente la comunicazione a bassa latenza tra microservizi e tra client mobile e API.

gRPC viene eseguito su HTTP/2 e offre diversi vantaggi rispetto a HTTP/1.1, ad esempio la codifica binaria efficiente, il multiplexing di richieste e risposte su una singola connessione e il controllo del flusso automatico. gRPC offre anche diverse opzioni per il bilanciamento del carico. Questo tutorial si concentra sulle situazioni in cui i client non sono attendibili, come i client mobile e i client in esecuzione al di fuori del perimetro di trust del service provider. Tra le opzioni di bilanciamento del carico fornite da gRPC, in questo tutorial utilizzi il bilanciamento del carico basato su proxy.

Nel tutorial, esegui il deployment di un servizio Kubernetes di TYPE=LoadBalancer, che

viene esposto come bilanciatore del carico di rete passthrough esterno del livello di trasporto (livello 4) su

Google Cloud. Questo servizio fornisce un singolo indirizzo IP pubblico e passa

le connessioni TCP direttamente ai backend configurati. Nel tutorial, il

backend è un deployment Kubernetes di istanze Envoy.

Envoy è un proxy open source del livello applicazione (livello 7) che offre molte funzionalità avanzate. In questo tutorial, lo utilizzi per terminare le connessioni TLS e instradare il traffico gRPC al servizio Kubernetes appropriato. Rispetto ad altre soluzioni del livello applicazione come Kubernetes Ingress, l'utilizzo diretto di Envoy offre diverse opzioni di personalizzazione, ad esempio le seguenti:

- Service Discovery

- Algoritmi di bilanciamento del carico

- Trasformazione di richieste e risposte, ad esempio in JSON o gRPC-Web

- Autenticare le richieste con la convalida dei token JWT

- Controlli di integrità gRPC

Combinando un bilanciatore del carico di rete passthrough esterno con Envoy, puoi configurare un endpoint (indirizzo IP esterno) che inoltra il traffico a un insieme di istanze Envoy in esecuzione in un cluster Google Kubernetes Engine. Queste istanze utilizzano quindi le informazioni del livello applicazione per eseguire il proxy delle richieste a diversi servizi gRPC in esecuzione nel cluster. Le istanze Envoy utilizzano il DNS del cluster per identificare e bilanciare il carico delle richieste gRPC in entrata ai pod integri e in esecuzione per ogni servizio. Ciò significa che il traffico viene bilanciato del carico sui pod per richiesta RPC anziché per connessione TCP dal client.

Architettura

In questo tutorial, esegui il deployment di due servizi gRPC, echo-grpc e reverse-grpc,

in un cluster Google Kubernetes Engine (GKE) e li esponi a internet

su un indirizzo IP pubblico. Il seguente diagramma mostra l'architettura

per esporre questi due servizi tramite un unico endpoint:

Un bilanciatore del carico di rete passthrough esterno accetta le richieste in entrata da internet (ad esempio, da client mobile o consumer di servizi esterni alla tua azienda). Il bilanciatore del carico di rete passthrough esterno esegue le seguenti attività:

- Bilancia il carico delle connessioni in entrata ai nodi del pool. Il traffico

viene inoltrato al servizio Kubernetes

envoy, che è esposto su tutti i nodi del cluster. Il proxy di rete Kubernetes inoltra queste connessioni ai pod che eseguono Envoy. - Esegue controlli di integrità HTTP sui nodi del cluster.

Envoy esegue le seguenti attività:

- Termina le connessioni TLS.

- Rileva i pod che eseguono i servizi gRPC eseguendo query sul servizio DNS del cluster interno.

- Instrada e bilancia il carico del traffico ai pod del servizio gRPC.

- Esegue controlli di integrità dei servizi gRPC in base al protocollo di controllo di integrità gRPC.

- Espone un endpoint per il controllo di integrità delle istanze Envoy da parte del bilanciatore del carico di rete passthrough esterno.

I servizi gRPC (echo-grpc e reverse-grpc) sono esposti come

servizi headless Kubernetes.

Ciò significa che non viene assegnato alcun indirizzo clusterIP e il proxy di rete Kubernetes non bilancia il carico del traffico verso i pod. Viene invece creato un record A DNS che

contiene gli indirizzi IP dei pod nel servizio DNS del cluster. Envoy

rileva gli indirizzi IP dei pod da questa voce DNS e bilancia il carico

tra questi in base alla policy configurata in Envoy.

Il seguente diagramma mostra gli oggetti Kubernetes coinvolti in questo tutorial:

Prepara l'ambiente

In Cloud Shell, imposta il progetto Google Cloud che vuoi utilizzare per questo tutorial:

gcloud config set project PROJECT_ID

Sostituisci

PROJECT_IDcon l'Google Cloud ID progetto.Abilita le API Artifact Registry e GKE:

gcloud services enable artifactregistry.googleapis.com \ container.googleapis.com

Crea il cluster GKE

In Cloud Shell, crea un cluster GKE per l'esecuzione dei servizi gRPC:

gcloud container clusters create envoy-grpc-tutorial \ --enable-ip-alias \ --release-channel rapid \ --scopes cloud-platform \ --workload-pool PROJECT_ID.svc.id.goog \ --location us-central1-fQuesto tutorial utilizza la zona

us-central1-f. Puoi utilizzare una zona o regione diversa.Verifica che il contesto

kubectlsia stato configurato elencando i nodi nel cluster:kubectl get nodes --output nameL'output è simile al seguente:

node/gke-envoy-grpc-tutorial-default-pool-c9a3c791-1kpt node/gke-envoy-grpc-tutorial-default-pool-c9a3c791-qn92 node/gke-envoy-grpc-tutorial-default-pool-c9a3c791-wf2h

Crea il repository Artifact Registry

In Cloud Shell, crea un nuovo repository per archiviare le immagini container:

gcloud artifacts repositories create envoy-grpc-tutorial-images \ --repository-format docker \ --location us-central1Crea il repository nella stessa regione del cluster GKE per ottimizzare la latenza e la larghezza di banda di rete quando i nodi eseguono il pull delle immagini container.

Concedi il ruolo Artifact Registry Reader nel repository al account di servizio Google utilizzato dalle VM dei nodi del cluster GKE:

PROJECT_NUMBER=$(gcloud projects describe PROJECT_ID --format 'value(projectNumber)') gcloud artifacts repositories add-iam-policy-binding envoy-grpc-tutorial-images \ --location us-central1 \ --member serviceAccount:$PROJECT_NUMBER-compute@developer.gserviceaccount.com \ --role roles/artifactregistry.readerAggiungi una voce di assistenza per le credenziali per il nome host del repository al file di configurazione Docker nella home directory di Cloud Shell:

gcloud auth configure-docker us-central1-docker.pkg.devLa voce dell'helper delle credenziali consente agli strumenti per le immagini container in esecuzione in Cloud Shell di autenticarsi nella posizione del repository Artifact Registry per il pull e il push delle immagini.

Esegui il deployment dei servizi gRPC

Per instradare il traffico a più servizi gRPC dietro un bilanciatore del carico, esegui il deployment di

due servizi gRPC di esempio: echo-grpc e reverse-grpc. Entrambi i servizi espongono un

metodo unario che accetta una stringa nel campo della richiesta content. echo-grpc

risponde con i contenuti inalterati, mentre reverse-grpc risponde con la

stringa di contenuti invertita.

In Cloud Shell, clona il repository contenente i servizi gRPC e passa alla directory del repository:

git clone https://github.com/GoogleCloudPlatform/kubernetes-engine-samples cd kubernetes-engine-samples/networking/grpc-gke-nlb-tutorial/Crea un certificato TLS autofirmato e una chiave privata:

openssl req -x509 -newkey rsa:4096 -nodes -sha256 -days 365 \ -keyout privkey.pem -out cert.pem -extensions san \ -config \ <(echo "[req]"; echo distinguished_name=req; echo "[san]"; echo subjectAltName=DNS:grpc.example.com ) \ -subj '/CN=grpc.example.com'Crea un secret Kubernetes denominato

envoy-certsche contenga il certificato TLS autofirmato e la chiave privata:kubectl create secret tls envoy-certs \ --key privkey.pem --cert cert.pem \ --dry-run=client --output yaml | kubectl apply --filename -Envoy utilizza questo certificato TLS e la chiave privata quando termina le connessioni TLS.

Crea le immagini container per le app di esempio

echo-grpcereverse-grpc, esegui il push delle immagini su Artifact Registry e il deployment delle app nel cluster GKE utilizzando Skaffold:skaffold run \ --default-repo=us-central1-docker.pkg.dev/PROJECT_ID/envoy-grpc-tutorial-images \ --module=echo-grpc,reverse-grpc \ --skip-testsSkaffold è uno strumento open source di Google che automatizza i flussi di lavoro per lo sviluppo, la creazione, il push e il deployment di applicazioni come container.

Esegui il deployment di Envoy nel cluster GKE utilizzando Skaffold:

skaffold run \ --digest-source=none \ --module=envoy \ --skip-testsVerifica che due pod siano pronti per ogni deployment:

kubectl get deploymentsL'output è simile al seguente. I valori di

READYdevono essere2/2per tutti i deployment.NAME READY UP-TO-DATE AVAILABLE AGE echo-grpc 2/2 2 2 1m envoy 2/2 2 2 1m reverse-grpc 2/2 2 2 1m

Verifica che

echo-grpc,envoyereverse-grpcesistano come servizi Kubernetes:kubectl get services --selector skaffold.dev/run-idL'output è simile al seguente. Sia

echo-grpcchereverse-grpcdevono avereTYPE=ClusterIPeCLUSTER-IP=None.NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE echo-grpc ClusterIP None <none> 8081/TCP 2m envoy LoadBalancer 10.40.2.203 203.0.113.1 443:31516/TCP 2m reverse-grpc ClusterIP None <none> 8082/TCP 2m

Testa i servizi gRPC

Per testare i servizi, utilizza lo strumento a riga di comando

grpcurl.

In Cloud Shell, installa

grpcurl:go install github.com/fullstorydev/grpcurl/cmd/grpcurl@latestRecupera l'indirizzo IP esterno del servizio Kubernetes

envoye archivialo in una variabile di ambiente:EXTERNAL_IP=$(kubectl get service envoy \ --output=jsonpath='{.status.loadBalancer.ingress[0].ip}')Invia una richiesta all'app di esempio

echo-grpc:grpcurl -v -d '{"content": "echo"}' \ -proto echo-grpc/api/echo.proto \ -authority grpc.example.com -cacert cert.pem \ $EXTERNAL_IP:443 api.Echo/EchoL'output è simile al seguente:

Resolved method descriptor: rpc Echo ( .api.EchoRequest ) returns ( .api.EchoResponse ); Request metadata to send: (empty) Response headers received: content-type: application/grpc date: Wed, 02 Jun 2021 07:18:22 GMT hostname: echo-grpc-75947768c9-jkdcw server: envoy x-envoy-upstream-service-time: 3 Response contents: { "content": "echo" } Response trailers received: (empty) Sent 1 request and received 1 responseL'intestazione della risposta

hostnamemostra il nome del podecho-grpcche ha gestito la richiesta. Se ripeti il comando alcune volte, dovresti visualizzare due valori diversi per l'intestazione della rispostahostname, corrispondenti ai nomi dei podecho-grpc.Verifica lo stesso comportamento con il servizio gRPC inverso:

grpcurl -v -d '{"content": "reverse"}' \ -proto reverse-grpc/api/reverse.proto \ -authority grpc.example.com -cacert cert.pem \ $EXTERNAL_IP:443 api.Reverse/ReverseL'output è simile al seguente:

Resolved method descriptor: rpc Reverse ( .api.ReverseRequest ) returns ( .api.ReverseResponse ); Request metadata to send: (empty) Response headers received: content-type: application/grpc date: Wed, 02 Jun 2021 07:20:15 GMT hostname: reverse-grpc-5c9b974f54-wlfwt server: envoy x-envoy-upstream-service-time: 1 Response contents: { "content": "esrever" } Response trailers received: (empty) Sent 1 request and received 1 response

Configurazione di Envoy

Per comprendere meglio la configurazione di Envoy, puoi esaminare il file di configurazione

envoy/k8s/envoy.yaml nel repository Git.

La sezione route_config specifica in che modo le richieste in entrata vengono instradate alle app di esempio

echo-grpc e reverse-grpc.

Le app di esempio sono definite come cluster Envoy.

I campi type: STRICT_DNS e lb_policy: ROUND_ROBIN nella definizione del cluster specificano che Envoy esegue ricerche DNS del nome host specificato nel campo address e bilancia il carico tra gli indirizzi IP nella risposta alla ricerca DNS. La risposta contiene più indirizzi IP perché gli oggetti servizio Kubernetes che definiscono le app di esempio specificano servizi headless.

Il campo http2_protocol_options specifica che Envoy utilizza il protocollo HTTP/2

per le app di esempio.

Il campo grpc_health_check nella sezione health_checks specifica che

Envoy utilizza il protocollo di controllo di integrità gRPC per determinare l'integrità delle

app di esempio.

Risoluzione dei problemi

Se riscontri problemi con questo tutorial, ti consigliamo di consultare questi documenti:

- Risoluzione dei problemi dei cluster Kubernetes

- Risoluzione dei problemi delle applicazioni di cui è stato eseguito il deployment su Kubernetes

Puoi anche esplorare l'interfaccia di amministrazione di Envoy per diagnosticare i problemi con la configurazione di Envoy.

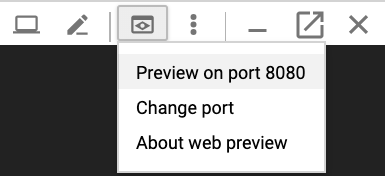

Per aprire l'interfaccia di amministrazione, configura il port forwarding da Cloud Shell alla porta

admindi uno dei pod Envoy:kubectl port-forward \ $(kubectl get pods -o name | grep envoy | head -n1) 8080:8090Attendi finché non visualizzi questo output nella console:

Forwarding from 127.0.0.1:8080 -> 8090

Fai clic sul pulsante Anteprima web in Cloud Shell e seleziona Anteprima sulla porta 8080. Si apre una nuova finestra del browser che mostra l'interfaccia di amministrazione.

Al termine, torna a Cloud Shell e premi

Control+Cper terminare l'inoltro delle porte.

Modi alternativi per instradare il traffico gRPC

Puoi modificare questa soluzione in diversi modi per adattarla al tuo ambiente.

Bilanciatori del carico alternativi a livello di applicazione

Alcune delle funzionalità del livello applicazione fornite da Envoy possono essere fornite anche da altre soluzioni di bilanciamento del carico:

Puoi utilizzare un bilanciatore del carico delle applicazioni esterno globale o un bilanciatore del carico delle applicazioni esterno regionale anziché un bilanciatore del carico di rete passthrough esterno e Envoy autogestito. L'utilizzo di un bilanciatore del carico delle applicazioni esterno offre diversi vantaggi rispetto a un bilanciatore del carico di rete pass-through esterno, come funzionalità avanzate di gestione del traffico, certificati TLS gestiti e integrazione con altri prodotti Google Cloud come Cloud CDN, Google Cloud Armor e IAP.

Ti consigliamo di utilizzare un bilanciatore del carico delle applicazioni esterno globale o regionale se le funzionalità di gestione del traffico che offrono soddisfano i tuoi casi d'uso e se non hai bisogno del supporto per l'autenticazione basata su certificati client, nota anche come autenticazione TLS reciproca (mTLS). Per saperne di più, consulta i seguenti documenti:

Se utilizzi Cloud Service Mesh o Istio, puoi utilizzare le relative funzionalità per instradare e bilanciare il carico del traffico gRPC. Sia Cloud Service Mesh che Istio forniscono un gateway in entrata di cui viene eseguito il deployment come bilanciatore del carico di rete passthrough esterno con un backend Envoy, simile all'architettura di questo tutorial. La principale differenza è che Envoy viene configurato tramite gli oggetti di routing del traffico di Istio.

Per rendere instradabili i servizi di esempio in questo tutorial nella rete mesh di servizi Cloud Service Mesh o Istio, devi rimuovere la riga

clusterIP: Nonedai manifest del servizio Kubernetes (echo-service.yamlereverse-service.yaml). Ciò significa utilizzare la funzionalità di Service Discovery e bilanciamento del carico di Cloud Service Mesh o Istio anziché la funzionalità simile in Envoy.Se utilizzi già Cloud Service Mesh o Istio, ti consigliamo di utilizzare il gateway di ingresso per il routing ai tuoi servizi gRPC.

Puoi utilizzare NGINX al posto di Envoy, come deployment o utilizzando il controller Ingress NGINX per Kubernetes. In questo tutorial viene utilizzato Envoy perché fornisce funzionalità gRPC più avanzate, come il supporto per il protocollo di controllo di integrità gRPC.

Connettività di rete VPC interna

Se vuoi esporre i servizi all'esterno del cluster GKE, ma solo all'interno della tua rete VPC, puoi utilizzare un bilanciatore del carico di rete pass-through interno o un bilanciatore del carico delle applicazioni interno.

Per utilizzare un bilanciatore del carico di rete passthrough interno al posto di un bilanciatore del carico di rete passthrough esterno, aggiungi l'annotazione cloud.google.com/load-balancer-type: "Internal" al manifest envoy-service.yaml.

Per utilizzare un bilanciatore del carico delle applicazioni interno, consulta la documentazione sulla configurazione di Ingress per i bilanciatori del carico delle applicazioni interni.