Neste documento, você usará os seguintes componentes faturáveis do Google Cloud:

- Dataproc

- Compute Engine

- Cloud Composer

Para gerar uma estimativa de custo baseada na projeção de uso deste tutorial, use a calculadora de preços.

Antes de começar

Criar o projeto

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

- Install the Google Cloud CLI.

-

To initialize the gcloud CLI, run the following command:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

- Install the Google Cloud CLI.

-

To initialize the gcloud CLI, run the following command:

gcloud init

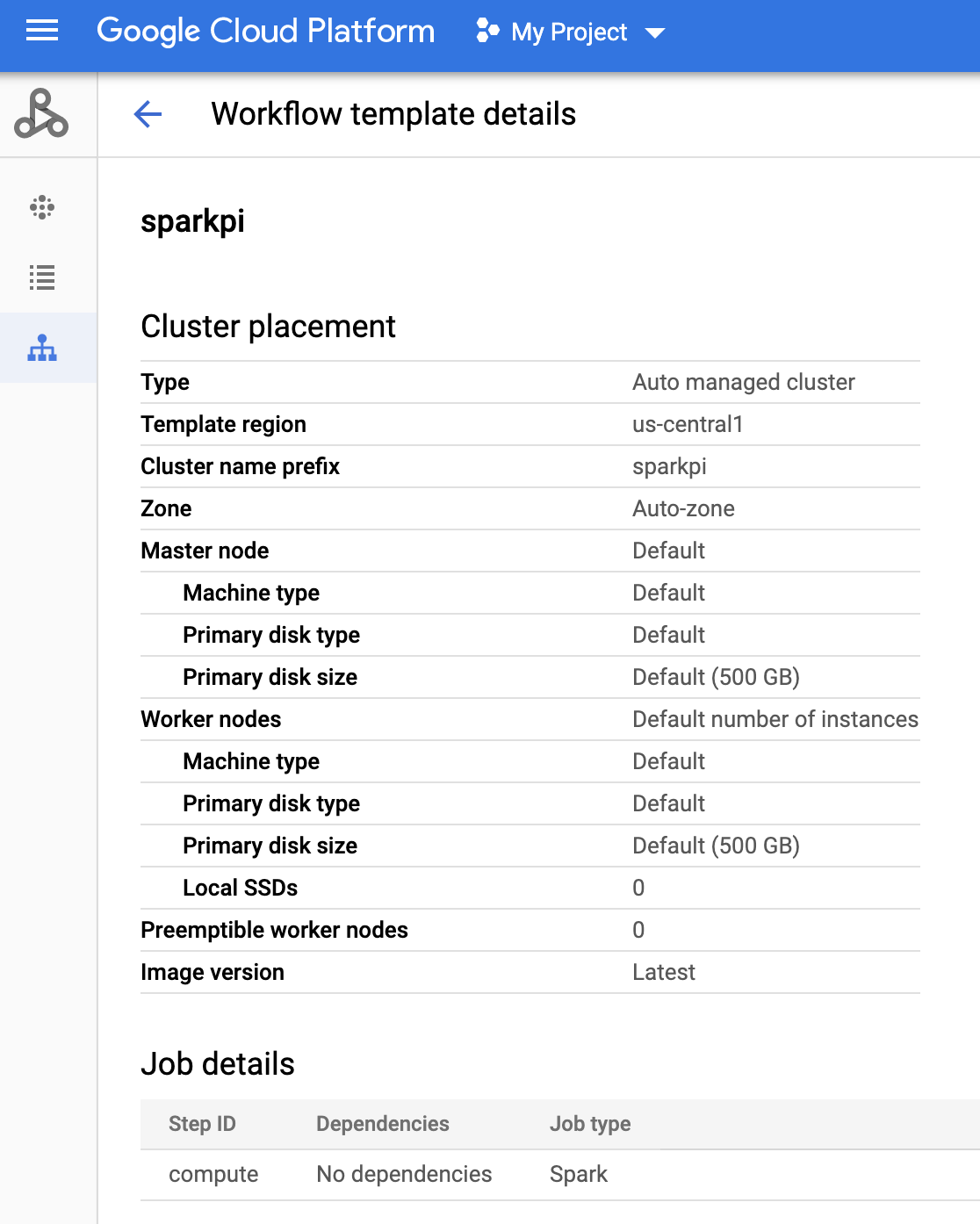

Criar um modelo de fluxo de trabalho do Dataproc

Copie e execute os comandos listados abaixo em uma janela de terminal local ou no Cloud Shell para criar e definir um modelo de fluxo de trabalho.

- Crie o modelo de fluxo de trabalho

sparkpi.gcloud dataproc workflow-templates create sparkpi \ --region=us-central1 - Adicione o job do Spark ao modelo de fluxo de trabalho

sparkpi. A sinalizaçãostep-id"compute" identifica o job do SparkPi.gcloud dataproc workflow-templates add-job spark \ --workflow-template=sparkpi \ --step-id=compute \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ --region=us-central1 \ -- 1000 - Use um cluster gerenciado

de nó único

para executar o fluxo de trabalho. O Dataproc criará o cluster,

executará o fluxo de trabalho nele e excluirá o cluster quando o fluxo de trabalho for concluído.

gcloud dataproc workflow-templates set-managed-cluster sparkpi \ --cluster-name=sparkpi \ --single-node \ --region=us-central1 - Confirme a criação do modelo de fluxo de trabalho.

Console

Clique no nome do

sparkpina página Fluxos de trabalho Dataproc no console do Google Cloud para abrir a página Detalhes do modelo de fluxo de trabalho. Clique no nome do seu modelo de fluxo de trabalho para confirmar os atributos do modelosparkpi.

Comando gcloud

Execute este comando:

gcloud dataproc workflow-templates describe sparkpi --region=us-central1

Criar e fazer upload de um DAG para o Cloud Storage

- Crie ou use um ambiente atual do Cloud Composer.

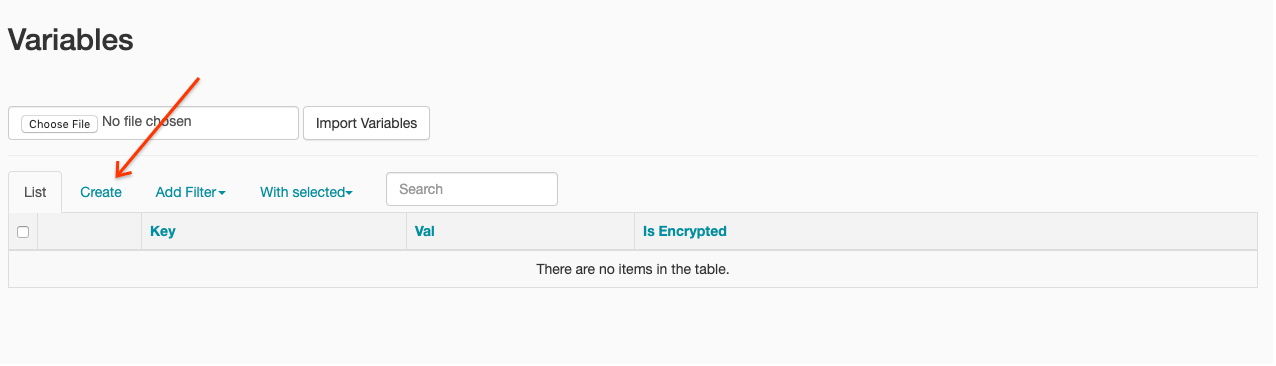

- Defina variáveis de ambiente.

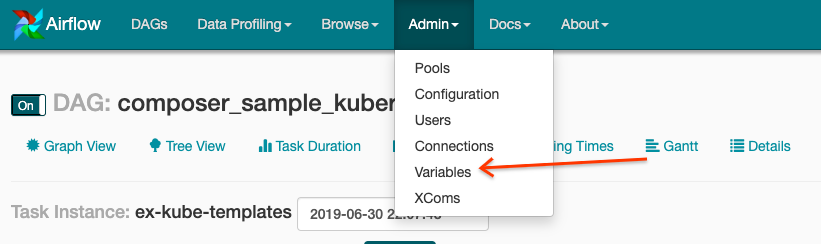

IU do Airflow

- Na barra de ferramentas, clique em Administrador > Variáveis.

- Clique em Criar.

- Digite as seguintes informações:

- Chave:

project_id - Val: PROJECT_ID: ID do projeto do Google Cloud

- Chave:

- Clique em Save.

Comando gcloud

Digite os seguintes comandos:

ENVIRONMENTé o nome do ambiente do Cloud ComposerLOCATIONé a região em que o ambiente do Cloud Composer está localizadoPROJECT_IDé o ID do projeto que contém o ambiente do Cloud Composer

gcloud composer environments run ENVIRONMENT --location LOCATION variables set -- project_id PROJECT_ID - Na barra de ferramentas, clique em Administrador > Variáveis.

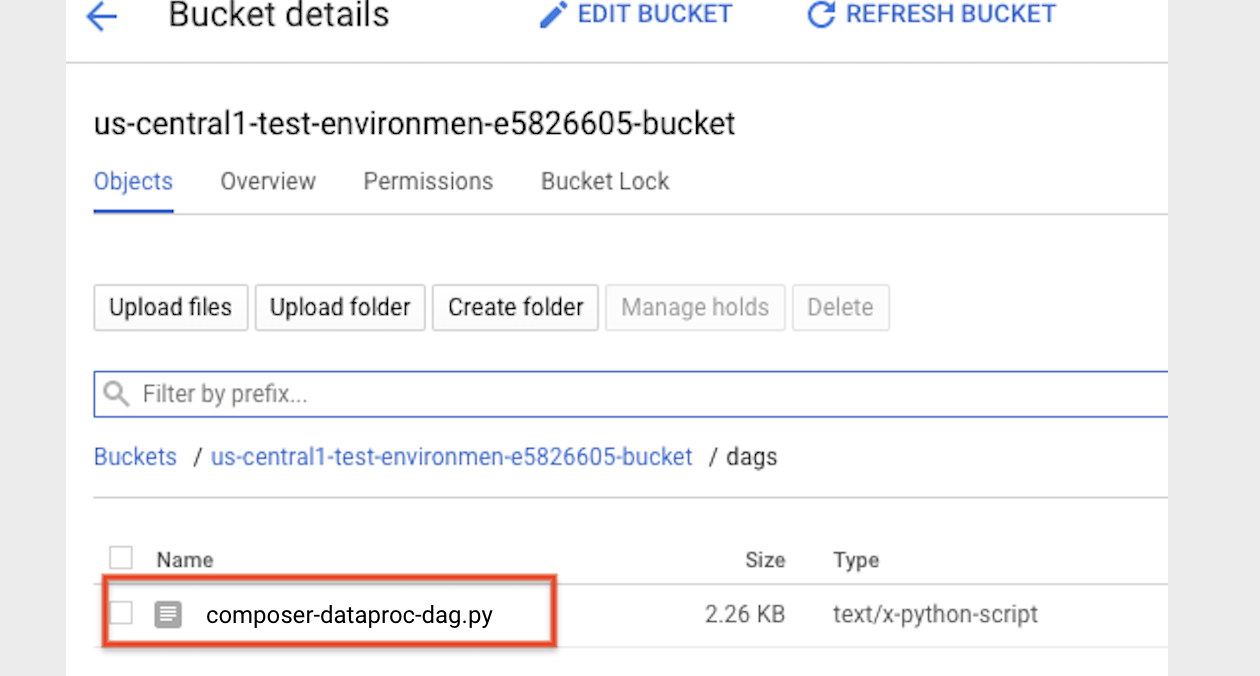

- Copie o código do DAG a seguir localmente em um arquivo chamado "composer-dataproc-dag.py",

que usa o

DataprocInstantiateWorkflowTemplateOperator.

Airflow 2

Airflow 1

- Faça o upload do

DAG para a pasta do ambiente no Cloud Storage. Depois que o upload for

concluído, clique no link Pasta de DAGs

na página do ambiente do Cloud Composer.

Como visualizar o status de uma tarefa

IU do Airflow

- Abra a interface da Web do Airflow.

- Na página DAGs, clique no nome do DAG, por exemplo,

dataproc_workflow_dag. - Na página "Detalhes dos DAGs", clique em Visualizar gráfico.

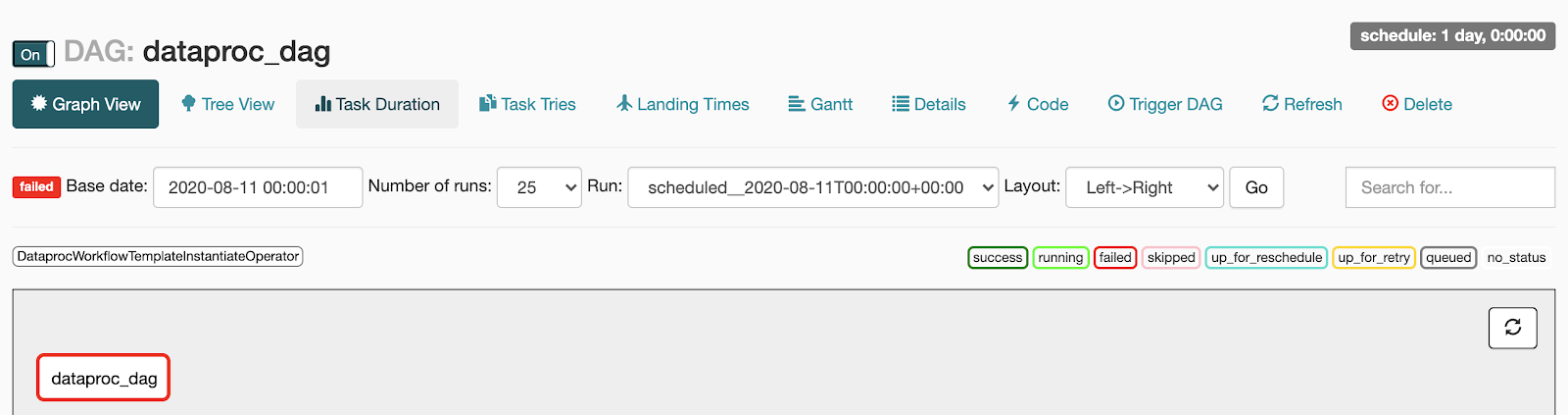

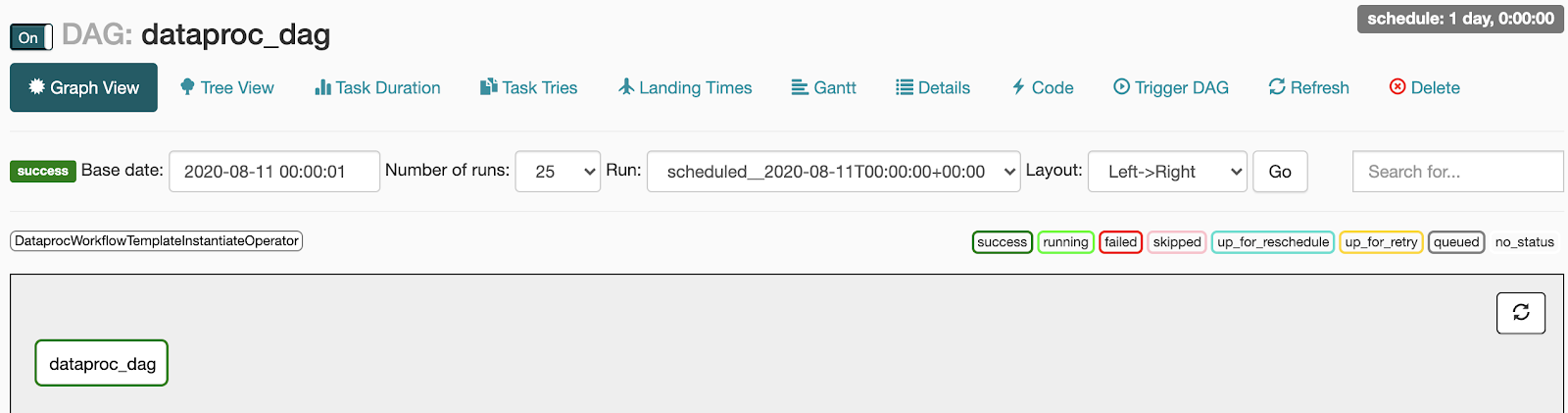

- Verificar status:

- Falha: a tarefa tem uma caixa vermelha ao redor.

Você também pode manter o ponteiro do mouse sobre a tarefa e verificar se há a mensagem Estado: Falha.

- Bem-sucedida: a tarefa tem uma caixa verde ao redor.

Você também pode manter o ponteiro do mouse sobre a tarefa e verificar se há a mensagem Estado: sucesso.

- Falha: a tarefa tem uma caixa vermelha ao redor.

Você também pode manter o ponteiro do mouse sobre a tarefa e verificar se há a mensagem Estado: Falha.

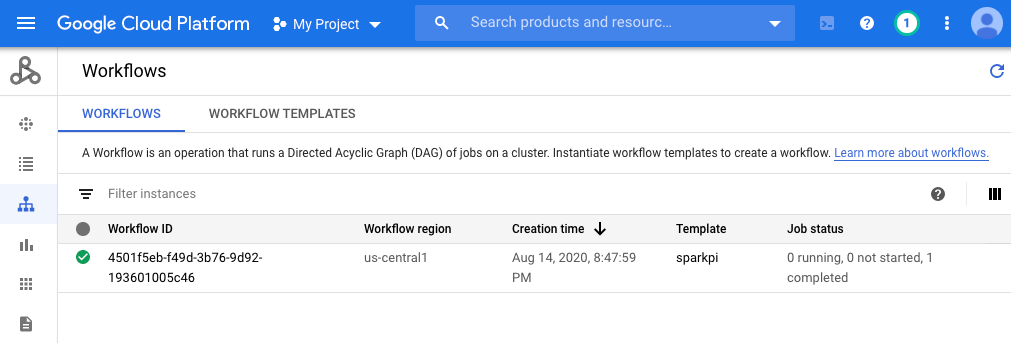

Console

Clique na guia "Fluxos de trabalho" para ver o status do fluxo de trabalho.

Comando gcloud

gcloud dataproc operations list \

--region=us-central1 \

--filter="labels.goog-dataproc-workflow-template-id=sparkpi"

Limpar

Para evitar cobranças na sua conta do Google Cloud , exclua os recursos usados neste tutorial:

A seguir

- Consulte Visão geral dos modelos de fluxo de trabalho do Dataproc

- Consulte Soluções de programação de fluxo de trabalho