Crie um pipeline de campanhas segmentadas

Saiba como usar o Cloud Data Fusion para limpar, transformar e processar dados de clientes para selecionar candidatos para uma campanha de destino.

Para seguir orientações passo a passo para esta tarefa diretamente na Google Cloud consola, clique em Orientar-me:

Cenário

Quer criar materiais de marketing personalizados para uma promoção de campanha contínua e distribuí-los diretamente nas caixas de correio das casas dos seus clientes.

A sua campanha tem duas restrições:

- Localização: só faz entregas a clientes na Califórnia, Washington e Oregon.

- Custo: para poupar combustível, faz entregas em casas de clientes de acesso rápido. Entrega apenas a clientes que vivem em avenidas.

Este tutorial mostra como gerar a lista de moradas de clientes para a campanha. Neste tutorial, vai fazer o seguinte:

- Limpe os dados de clientes: filtre os clientes que vivem numa avenida na Califórnia, em Washington ou no Oregon.

Crie um pipeline que faça o seguinte:

- Junta os dados de clientes filtrados a um conjunto de dados público que contém abreviaturas de estados.

- Armazena os dados limpos e unidos numa tabela do BigQuery que pode consultar (através da interface Web do BigQuery) ou analisar (através do Looker Studio).

Objetivos

- Associe o Cloud Data Fusion a duas origens de dados

- Aplique transformações básicas

- Junte as duas origens de dados

- Escreva os dados de saída num destino

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Crie uma instância do Cloud Data Fusion.

Este tutorial pressupõe que usa a conta de serviço do Compute Engine predefinida. Na Google Cloud consola, aceda à página Funções:

Clique em Criar função.

No campo Título, introduza

Custom Role-Tutorial.Clique em Adicionar autorizações.

Na janela Adicionar autorizações, selecione as seguintes autorizações e clique em Adicionar:

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Clique em Criar.

Aceda à página Instâncias do Cloud Data Fusion:

Clique no nome da instância.

Tome nota da conta de serviço do Dataproc predefinida. A página de detalhes da instância contém estas informações.

Segue-se o formato do nome da conta de serviço do Dataproc:

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Saiba mais sobre as contas de serviço do Dataproc.

Aceda à página IAM:

Na barra Filtro, introduza o nome da sua conta de serviço do Dataproc predefinida.

Para a sua conta de serviço predefinida do Compute Engine, clique em Editar.

Clique em Adicionar outra função.

No campo Selecionar uma função, selecione Função personalizada – Tutorial.

Clique em Guardar.

Certifique-se de que a conta de serviço já tem atribuída a função de executor do Cloud Data Fusion.

Gerir autorizações

Crie e atribua as funções e as autorizações personalizadas necessárias.

Crie uma função personalizada e adicione autorizações

Atribua uma função personalizada à conta de serviço predefinida do Compute Engine

Prepare os dados de clientes

Este tutorial requer os dois conjuntos de dados de entrada seguintes, que são fornecidos com a sua instância do Cloud Data Fusion:

- Dados de clientes de exemplo: um ficheiro CSV denominado

customers.csv. - Abreviações dos estados: uma tabela do BigQuery denominada

state_abbreviations.

Carregue os dados de clientes

Aceda à página Instâncias do Cloud Data Fusion:

Para a instância do Cloud Data Fusion que está a usar, clique em Ver instância. A interface Web do Cloud Data Fusion é aberta num novo separador.

Clique em Wrangler. É apresentada a página Wrangler.

No painel Ligações, aceda a GCS > Exemplos de contentores.

Clique em campaign-tutorial.

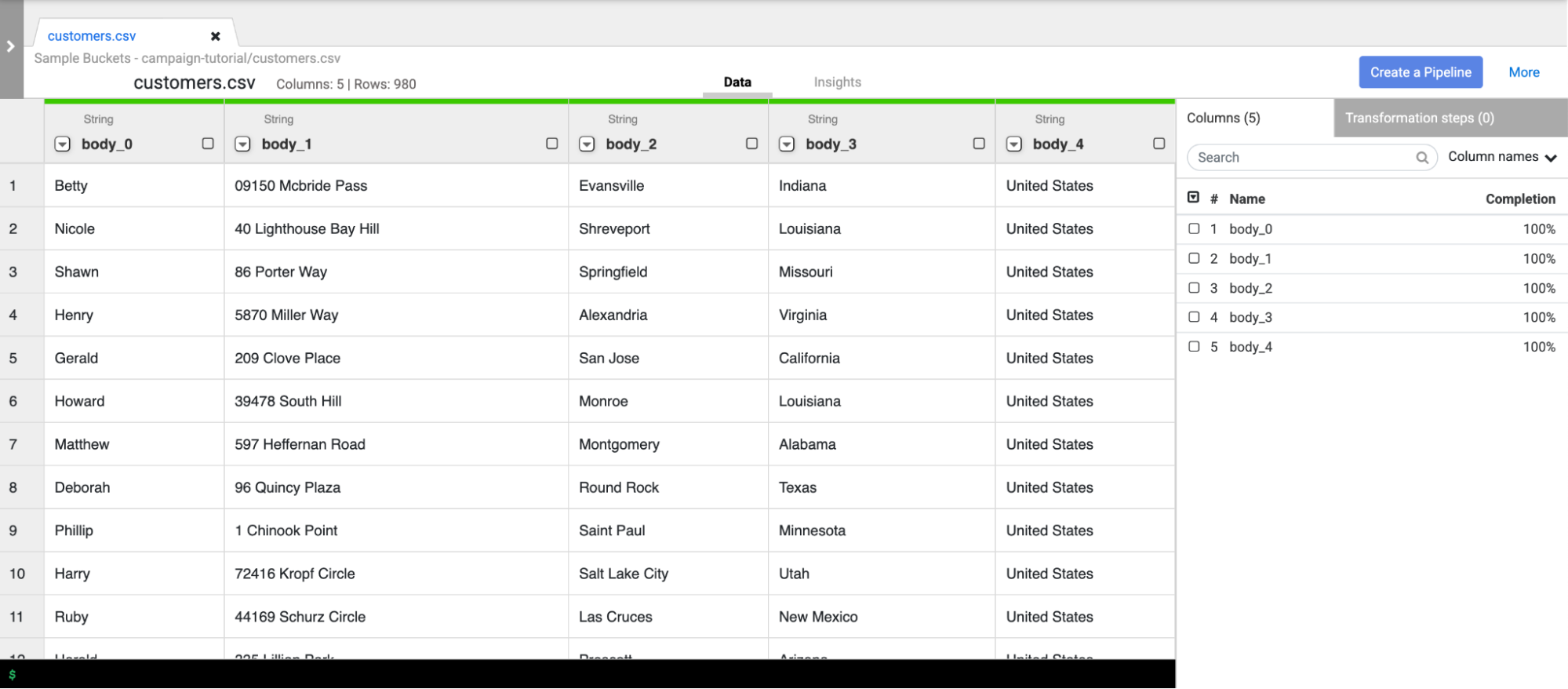

Clique em customers.csv.

Na janela Opções de análise, especifique o seguinte:

- Formato:

csv - Ativar valor cotado:

False - Usar a primeira linha como cabeçalho:

False - Codificação de ficheiros:

UTF-8

- Formato:

Clique em Confirm. Os dados dos clientes são carregados num novo separador no Wrangler.

Limpe os dados de clientes

Esta contém duas subtarefas:

- Definir o esquema

- Filtrar os dados dos clientes para apresentar apenas o público-alvo de que precisa

Defina o esquema

Defina o esquema dos dados atribuindo nomes adequados às colunas da tabela. Para atribuir nomes mais informativos às colunas, como body_1 e body_2, siga estes passos:

- No painel do lado direito, clique no separador Colunas.

- Clique no menu pendente Nomes das colunas e selecione Definir tudo.

Na caixa de diálogo Nomes das colunas do conjunto em massa, introduza os seguintes nomes das colunas separados por vírgulas:

Name,StreetAddress,City,State,CountryClique em Aplicar.

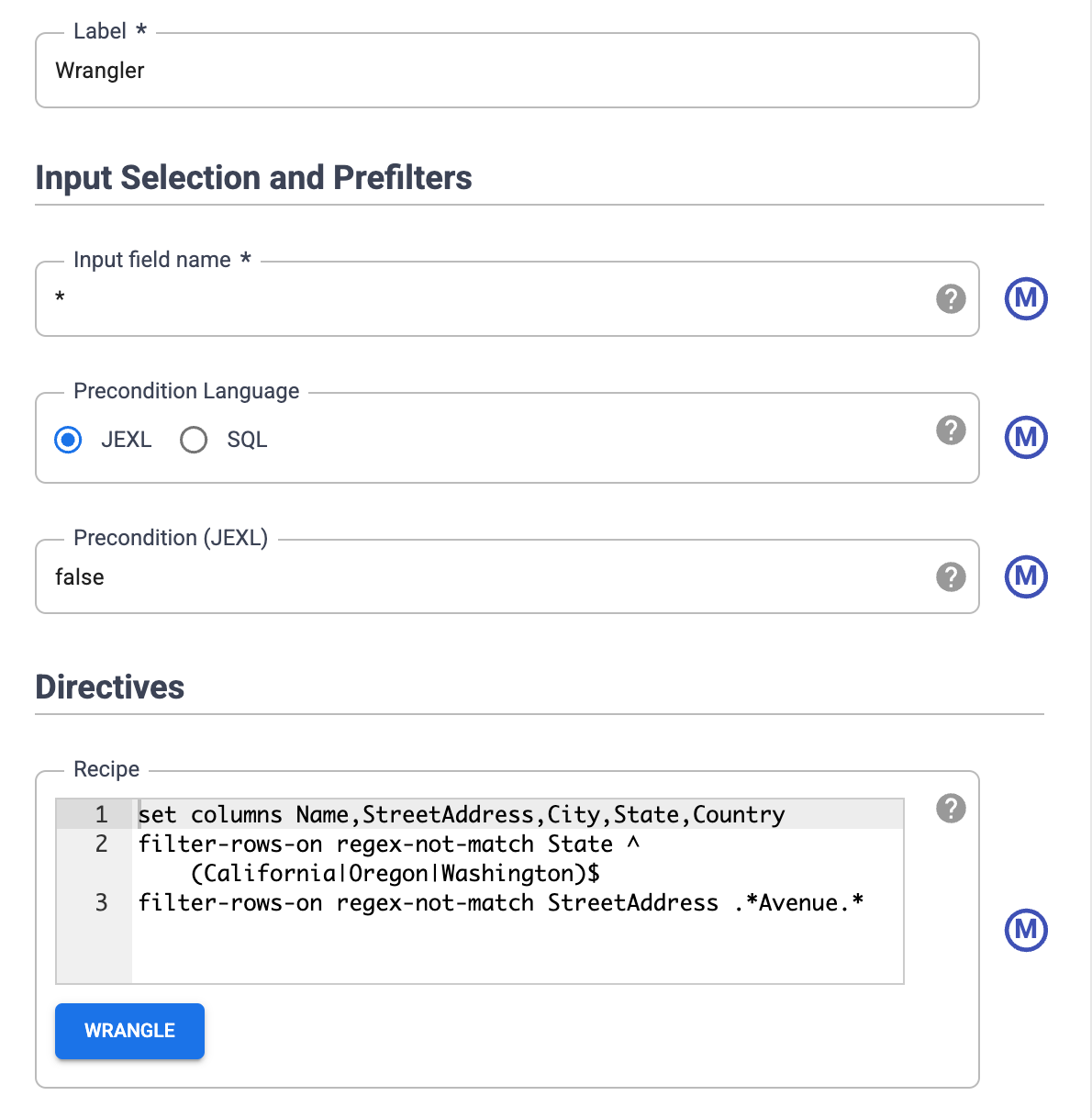

Filtre os dados

Filtre os dados para apresentar apenas os clientes que vivem na Califórnia, no Oregon ou em Washington.

Remova todas as linhas que contenham valores diferentes dos seguintes estados:

- Clique no menu pendente da coluna Estado e selecione Filtrar.

Na janela de filtro, faça o seguinte:

- Clique em Manter linhas.

- Clique no menu pendente Se e selecione o valor corresponde à regex.

Introduza a seguinte expressão regular:

^(California|Oregon|Washington)$Clique em Aplicar.

Os valores na coluna Estado são Califórnia, Oregão ou Washington.

Filtre os dados para apresentar apenas clientes que vivem em avenidas. Mantenha apenas os endereços que contêm a string Avenue:

- Clique no menu pendente da coluna StreetAddress e selecione Filtrar.

- Na janela de filtro, faça o seguinte:

- Clique em Manter linhas.

- Clique no menu pendente Se, selecione o valor contém e introduza

Avenue. - Selecione Ignorar maiúsculas/minúsculas.

- Clique em Aplicar.

Antes de executar tarefas de processamento paralelo no conjunto de dados completo, o Wrangler apenas apresenta os primeiros 1000 valores do conjunto de dados. Uma vez que filtrou alguns dados, restam apenas alguns clientes na apresentação do Wrangler.

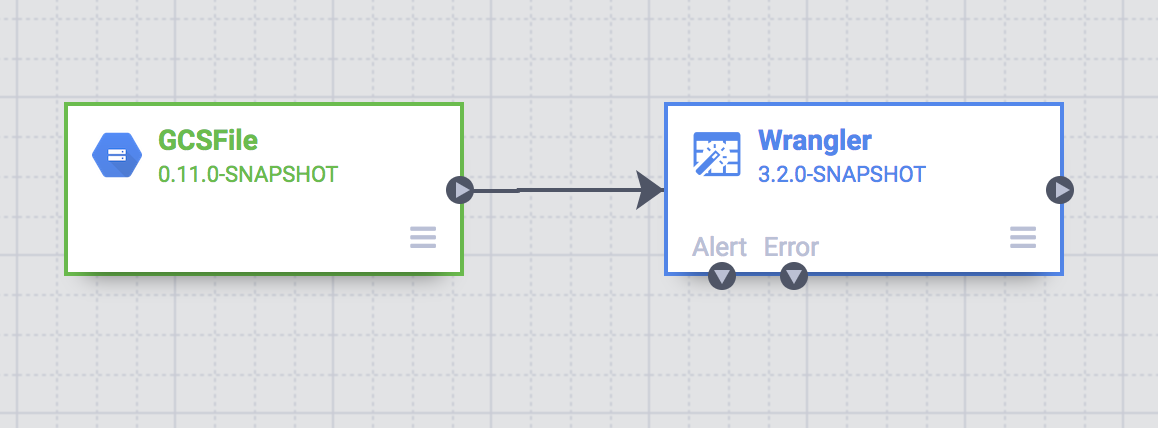

Crie um pipeline em lote

Limparam os dados e executaram transformações num subconjunto dos dados. Agora, pode criar um pipeline em lote para executar transformações em todo o conjunto de dados.

O Cloud Data Fusion traduz o pipeline que cria no Studio num programa Apache Spark que executa transformações em paralelo num cluster Dataproc efémero. Este processo permite-lhe executar transformações complexas em grandes quantidades de dados de forma escalável e fiável, sem ter de gerir a infraestrutura.

- Na página do Wrangler, clique em Criar um pipeline.

- Selecione Pipeline em lote. É apresentada a página do Studio.

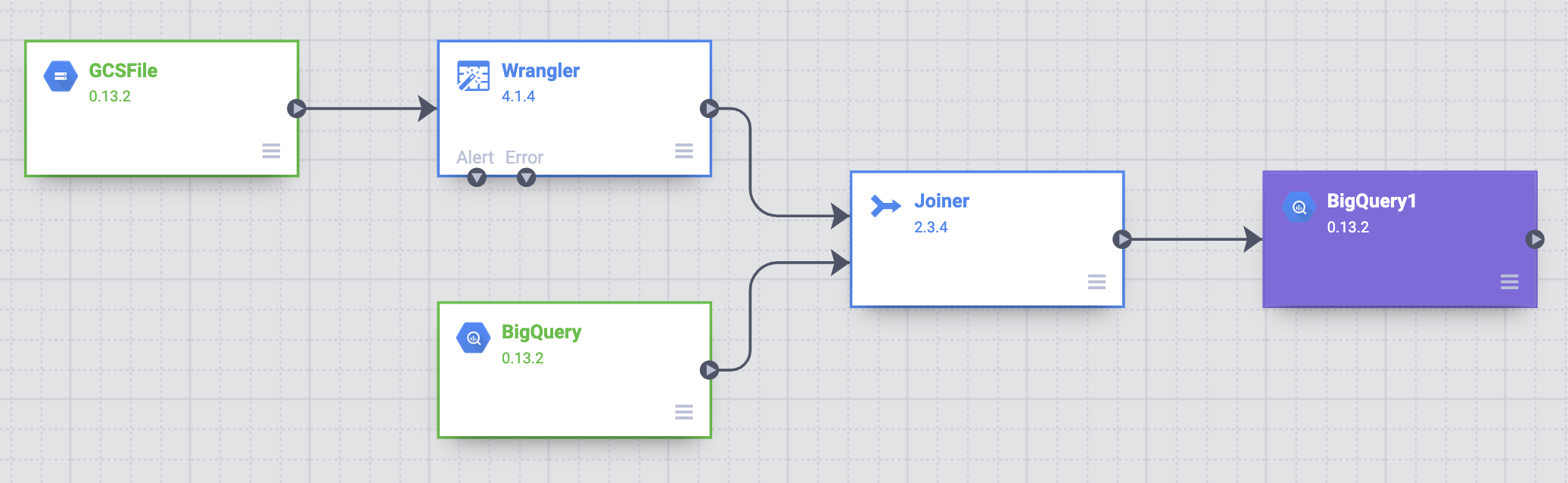

Na página do Studio, um nó de origem GCSFile está ligado a um nó Wrangler.

As transformações que aplicou na página do Wrangler aparecem no nó Wrangler na página do Studio.

Para ver as transformações que aplicou, coloque o cursor do rato sobre o nó Wrangler e clique em Propriedades.

As transformações que aplicou aparecem nas Diretivas.

Clique em Validar.

Clique em Fechar.

Por exemplo, percebe que a coluna País não é necessária porque o valor é sempre USA. Siga estes passos para eliminar a coluna:

- Clique em Wrangle.

- Clique na seta para baixo junto a País e selecione Eliminar coluna.

- Clique em Aplicar. A página do Wrangler é fechada e a janela de propriedades do Wrangler é aberta na página do Studio. Em Diretivas, é apresentado

drop Country. - Clique em Fechar.

Abreviar os nomes dos estados

O sistema de navegação no seu veículo de entrega só reconhece moradas que contêm nomes de distritos abreviados (CA, e não Califórnia), e os seus dados de clientes contêm nomes de distritos completos.

A tabela pública do BigQuery state_abbreviations contém duas colunas: uma com os nomes completos dos estados e outra com os nomes abreviados dos estados.

Pode usar esta tabela para atualizar os nomes dos estados nos dados dos clientes.

Veja os dados dos nomes dos estados no BigQuery

Num separador separado, aceda à página do BigQuery Studio:

Clique em Criar consulta SQL e introduza a seguinte consulta no editor de consultas:

SELECT * FROM `dis-user-guide.campaign_tutorial.state_abbreviations`Clique em Executar.

O BigQuery apresenta uma lista de nomes de estados e as respetivas abreviaturas.

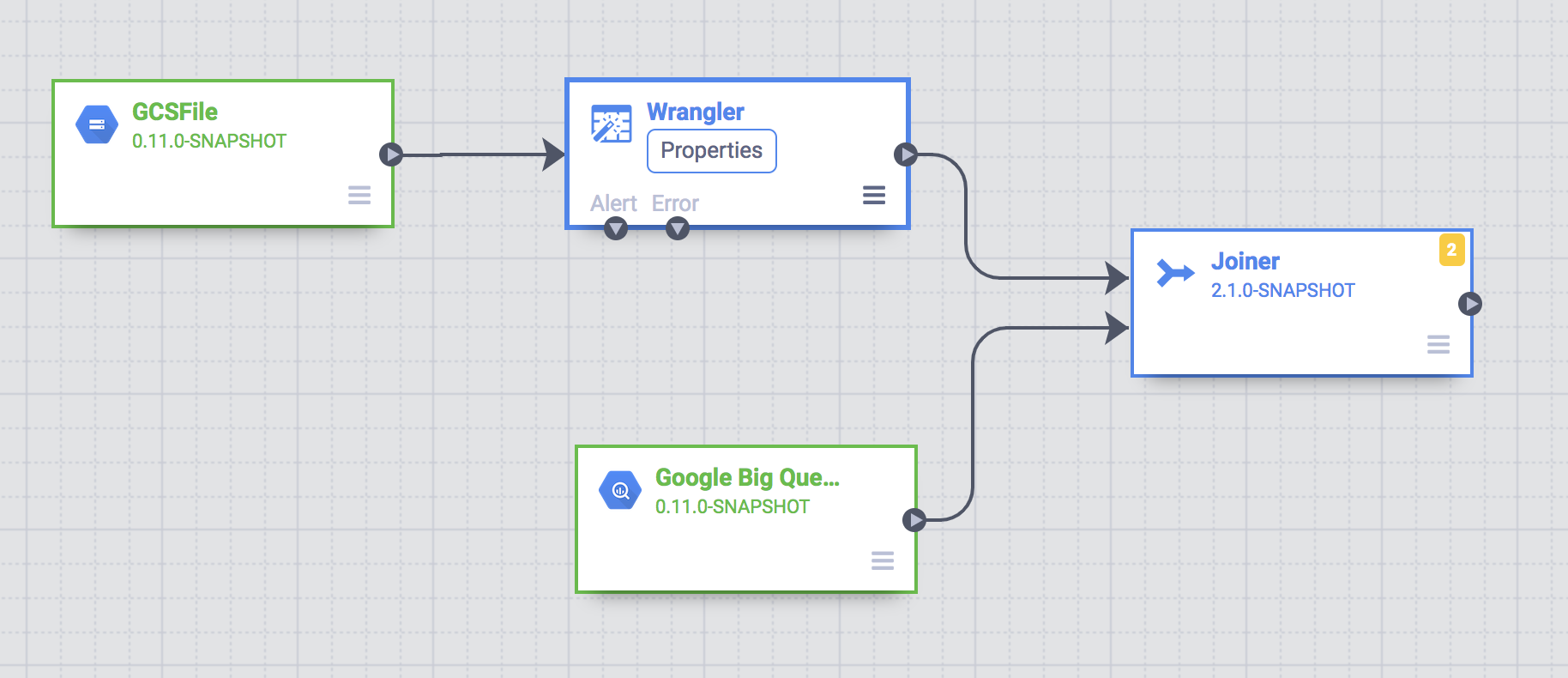

Aceda à tabela do BigQuery

Adicione uma origem no pipeline que aceda à tabela do BigQuery

state_abbreviations.

- Aceda à página do Cloud Data Fusion Studio e expanda o menu Origem.

Clique em BigQuery.

É apresentado um nó de origem do BigQuery na tela, juntamente com os outros dois nós.

Passe o ponteiro do rato sobre o nó de origem do BigQuery e clique em Propriedades.

- No campo ID do projeto do conjunto de dados, introduza

dis-user-guide. - No campo Nome de referência, introduza

state_abbreviations. - No campo Conjunto de dados, introduza

campaign_tutorial. - No campo Tabela, introduza

state_abbreviations.

- No campo ID do projeto do conjunto de dados, introduza

Preencha o esquema da tabela do BigQuery clicando em Obter esquema.

Clique em Fechar.

Junte as duas origens de dados

Para gerar resultados que contenham dados de clientes com nomes de estados abreviados, associe as duas origens de dados, os dados de clientes e as abreviaturas dos estados.

- Aceda à página do Cloud Data Fusion Studio e expanda o menu Analytics.

Clique em Aderente.

É apresentado um nó Joiner, que representa uma ação semelhante a uma junção SQL, na tela.

Associe o nó Wrangler e o nó BigQuery ao nó Joiner: arraste uma seta de associação na extremidade direita do nó de origem e solte-a no nó de destino.

Passe o cursor do rato sobre o nó Joiner e clique em Propriedades.

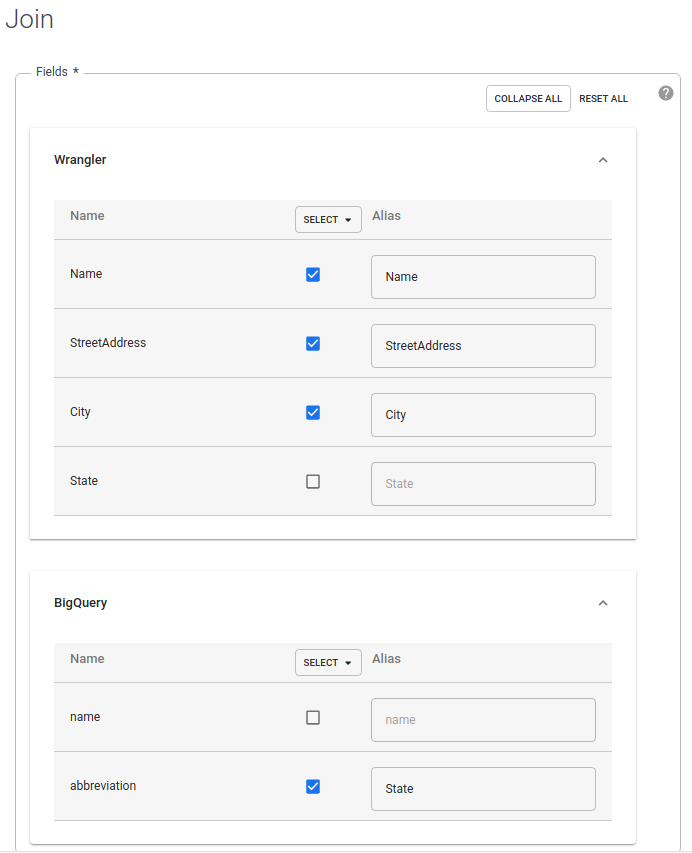

Na secção Campos, expanda Wrangler e BigQuery.

- Desmarque a caixa de verificação state do Wrangler.

- Desmarque a caixa de verificação do nome do BigQuery porque quer apenas o nome abreviado do estado e não o nome completo do estado.

Mantenha a caixa de verificação abreviatura do BigQuery selecionada e altere o alias para

State.

No campo Tipo de junção, mantenha o valor como Exterior. Para Entradas obrigatórias, selecione a caixa de verificação Wrangler.

Na secção Condição de junção, para o Wrangler, selecione Estado. Para o BigQuery, selecione nome.

Gere o esquema da junção resultante. Clique em Obter esquema.

Clique em Validar.

Clique em Fechar.

Armazene a saída no BigQuery

Armazenar o resultado do pipeline numa tabela do BigQuery. O local onde armazena os seus dados é denominado destino.

- Aceda à página do Cloud Data Fusion Studio e expanda Destino.

- Clique em BigQuery.

Associe o nó Joiner ao nó BigQuery.

Passe o ponteiro do rato sobre o nó BigQuery e clique em Propriedades.

- No campo Conjunto de dados, introduza

dis_user_guide. - No campo Tabela, selecione

customer_data_abbreviated_states. - Clique em Fechar.

- No campo Conjunto de dados, introduza

Implemente e execute a tubagem

- Na página do Studio, clique em Dê um nome ao seu pipeline e introduza

CampaignPipeline. - Clique em Guardar.

- No canto superior direito, clique em Implementar.

- Após a conclusão da implementação, clique em Executar.

A execução do pipeline pode demorar alguns minutos. Enquanto aguarda, pode observar o Estado da transição do pipeline de Aprovisionamento > A iniciar > Em execução > Desaprovisionamento > Concluído.

Veja os resultados

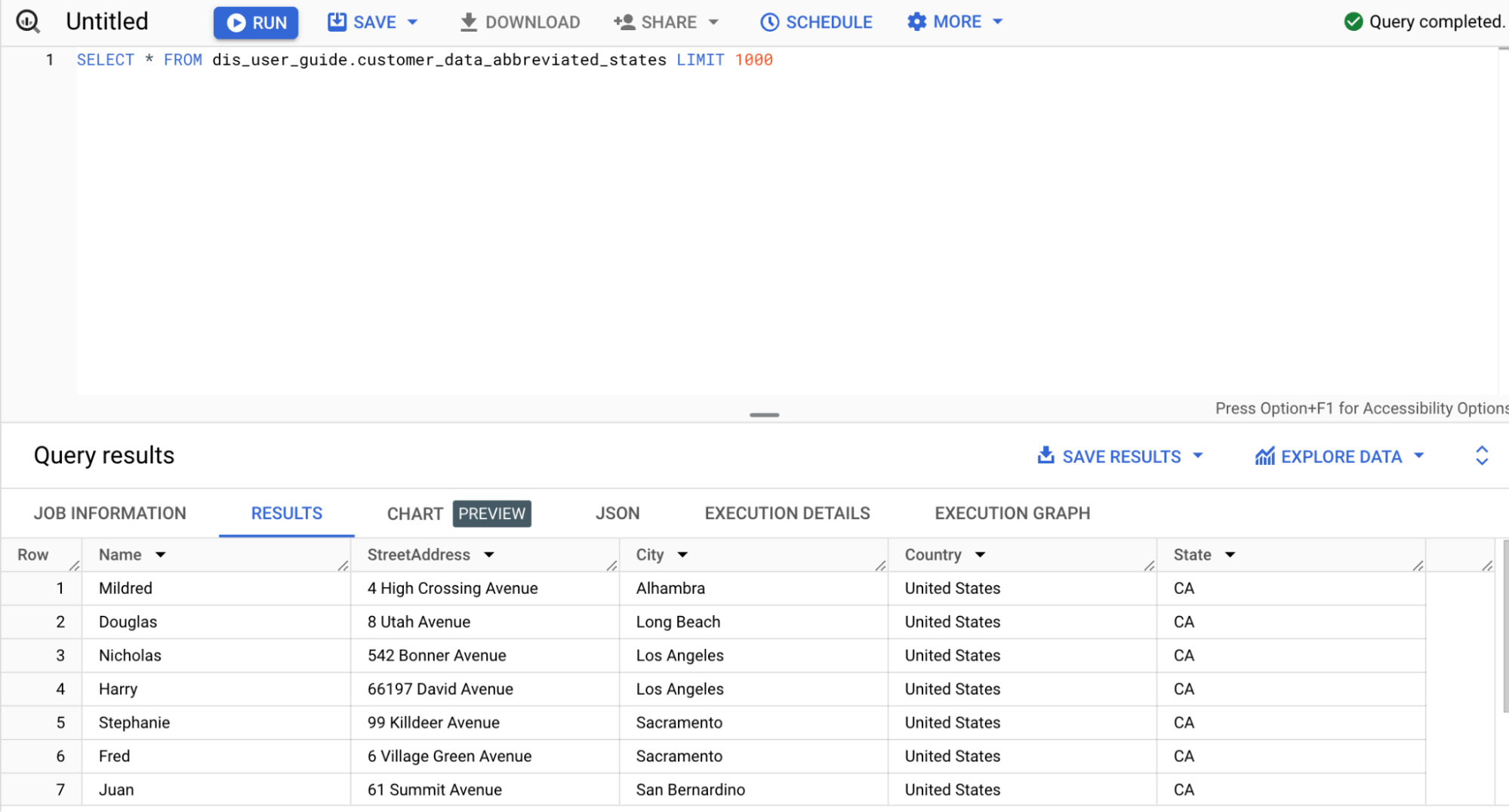

Na Google Cloud consola, aceda à página do BigQuery:

Clique em Criar consulta SQL.

Consulte a tabela

customer_data_abbreviated_states:SELECT * FROM dis_user_guide.customer_data_abbreviated_states LIMIT 1000

Criou com êxito um pipeline de dados.

Limpar

Para evitar incorrer em cobranças na sua Google Cloud conta pelos recursos usados nesta página, siga estes passos.

Elimine o conjunto de dados do BigQuery

Para eliminar o conjunto de dados do BigQuery que criou neste tutorial, faça o seguinte:

- Na Google Cloud consola, aceda à página do BigQuery.

- Selecione o conjunto de dados

dis_user_guide. - Clique em delete Eliminar conjunto de dados.

Elimine a instância do Cloud Data Fusion

Siga estas instruções para eliminar a sua instância do Cloud Data Fusion.

Elimine o projeto

A forma mais fácil de eliminar a faturação é eliminar o projeto que criou para o tutorial.

Para eliminar o projeto:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

O que se segue?

- Saiba mais sobre o Cloud Data Fusion.