Utiliser le plug-in de source par lot Salesforce pour analyser des données sur les prospects dans BigQuery

Découvrez comment utiliser le plug-in de source par lot Salesforce dans Cloud Data Fusion pour analyser les données sur les prospects dans BigQuery.

Pour obtenir des instructions détaillées sur cette tâche directement dans la console Google Cloud , cliquez sur Visite guidée :

Scénario

Prenons l'exemple d'un responsable marketing qui planifie une campagne d'e-mailing très ciblée pour promouvoir un nouveau produit. Vous disposez d'une liste de prospects dans Salesforce Sales Cloud. Avant de créer une campagne ciblée, vous souhaitez mieux comprendre votre audience cible. Pour ce faire, vous voulez utiliser le plug-in de source par lot Salesforce dans Cloud Data Fusion afin d'extraire des données spécifiques sur les prospects.

Avant de commencer

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Créez une instance Cloud Data Fusion.

- Configurez une connexion à l'API Salesforce en créant une application connectée Salesforce pour Cloud Data Fusion.

Dans la console Google Cloud , accédez à la page Rôles.

Cliquez sur Créer un rôle.

Dans le champ Titre, saisissez

Custom Role-Tutorial.Cliquez sur Ajouter des autorisations.

Dans la fenêtre Ajouter des autorisations, sélectionnez les autorisations suivantes et cliquez sur Ajouter :

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Cliquez sur Créer.

Accédez à la page Instances de Cloud Data Fusion :

Cliquez sur le nom de votre instance.

Notez le compte de service Compute Engine par défaut. La page de détails de l'instance contient ces informations.

Le format du nom du compte de service Compute Engine par défaut de Cloud Data Fusion est

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Accédez à la page IAM :

Dans la barre Filer, saisissez le nom de votre compte de service Compute Engine par défaut.

Pour votre compte de service Compute Engine par défaut, cliquez sur Modifier.

Cliquez sur Ajouter un autre rôle.

Dans le champ Sélectionnez un rôle, choisissez Tutoriel des rôles personnalisés.

Cliquez sur Enregistrer.

Gérer les autorisations

Créez et attribuez les rôles et autorisations personnalisés nécessaires.

Créer un rôle personnalisé et ajouter des autorisations

Attribuer un rôle personnalisé au compte de service Compute Engine par défaut

Configurer le plug-in de source par lot Salesforce Cloud Data Fusion

Accédez à la page Instances de Cloud Data Fusion :

Pour votre instance, cliquez sur Afficher l'instance. L'interface Web de Cloud Data Fusion s'ouvre.

Accédez à la page Studio.

Cliquez sur Hub.

Dans la barre de recherche, saisissez

Salesforce.Cliquez sur Plug-ins Salesforce, puis sur Déployer.

Dans la fenêtre Déploiement des plug-ins Salesforce, cliquez sur Terminer.

Une fois le déploiement terminé, une boîte de dialogue s'affiche avec un message de réussite.

Dans cette boîte de dialogue, cliquez sur Créer un pipeline.

La page Cloud Data Fusion Studio s'affiche.

Sélectionnez Pipeline de données - lot comme type de pipeline de données.

Dans le menu Source, cliquez sur Salesforce.

Accédez au nœud Salesforce et cliquez sur Propriétés. La page des propriétés du plug-in Salesforce s'ouvre.

Dans le champ Nom de la référence, saisissez le nom de la source. Exemple :

Leads_generated.Dans la section Connexion, cliquez sur le bouton Utiliser la connexion.

Cliquez sur Parcourir les connexions. La fenêtre Parcourir les connexions s'ouvre.

Cliquez sur Ajouter une connexion, puis sélectionnez Salesforce.

Dans la fenêtre Créer une connexion Salesforce, cliquez sur l'onglet Configuration et procédez comme suit :

Dans le champ Nom, saisissez un nom pour identifier votre connexion (par exemple,

Salesforce_connection).Dans la section Identifiants, saisissez les informations suivantes concernant votre compte Salesforce :

- Nom d'utilisateur

- Mot de passe

- Clé du site consommateur

- Clé secrète du site consommateur

- Jeton de sécurité

Cliquez sur Test connection (Tester la connexion). Si les informations saisies sont correctes, le test réussit et le message "Connexion réussie" s'affiche.

Cliquez sur Créer.

Sélectionnez Salesforce_connection et revenez à la page des propriétés du plug-in Salesforce.

Extraire les données du plug-in de source par lot Salesforce

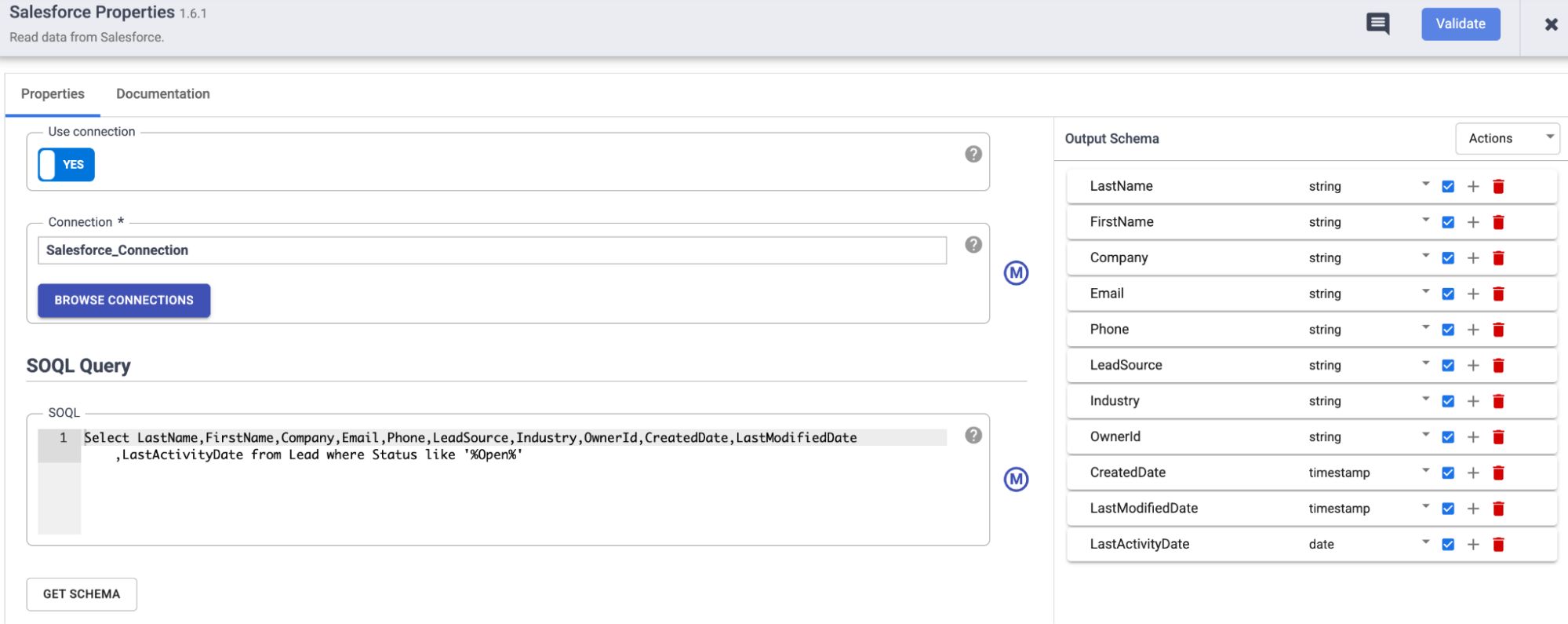

Sur la page des propriétés du plug-in Salesforce, dans la section Requête SOQL, saisissez la requête suivante :

Select LastName,FirstName,Company,Email,Phone,LeadSource,Industry,OwnerId,CreatedDate,LastModifiedDate,LastActivityDate from Lead where Status like '%Open%'Cette requête extrait les informations d'un prospect potentiel requis pour exécuter une campagne à partir du sObject

Lead.Pour déterminer la validité du schéma d'objet, cliquez sur Obtenir un schéma.

Pour filtrer les enregistrements en fonction d'une date ou d'une heure spécifique pour diffuser la campagne, utilisez les champs suivants :

- Dernière modification après le

- Dernière modification avant le

- Durée

- Décalage (offset)

Transformer des données à l'aide du plug-in Wrangler

Utilisez le plug-in Wrangler dans Cloud Data Fusion pour nettoyer et enrichir vos données :

Revenez à la page Studio.

Dans le menu Transformer, cliquez sur Wrangler.

Connectez Wrangler au plug-in de source par lot Salesforce.

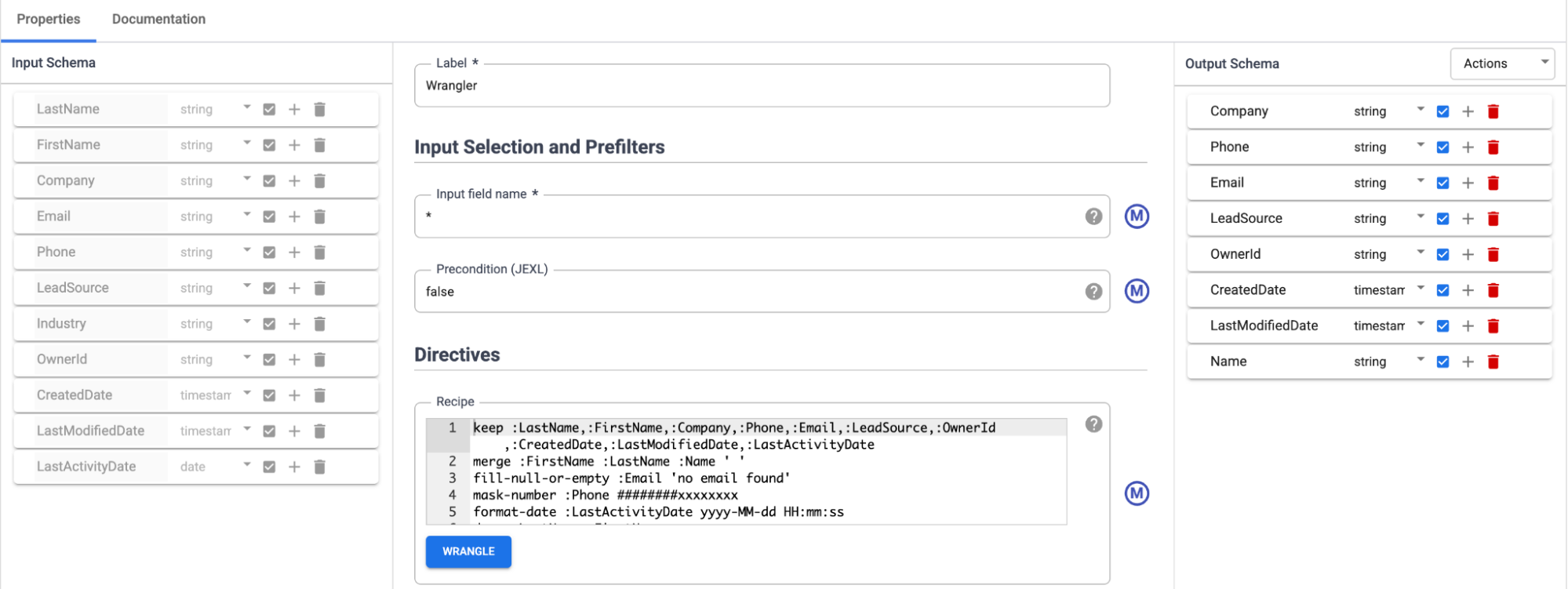

Accédez au plug-in Wrangler, puis cliquez sur Propriétés. La page des propriétés du plug-in Wrangler s'ouvre.

Assurez-vous que le schéma d'entrée est renseigné.

Cliquez sur Wrangle.

Dans le volet Connexions, sélectionnez une connexion valide.

Sélectionnez le sObject que vous souhaitez transformer (par exemple,

Lead).Transformez les données avec les directives requises :

keep :LastName,:FirstName,:Company,:Phone,:Email,:LeadSource,:OwnerId, :CreatedDate,:LastModifiedDate,:LastActivityDatemerge :FirstName :LastName :Name ' ' fill-null-or-empty :Email 'no email found' mask-number :Phone ########xxxxxxxx format-date :LastActivityDate yyyy-MM-dd HH:mm:ss drop :LastName,:FirstName

Charger des données dans BigQuery

Revenez à la page Studio.

Dans le menu Récepteur, cliquez sur BigQuery.

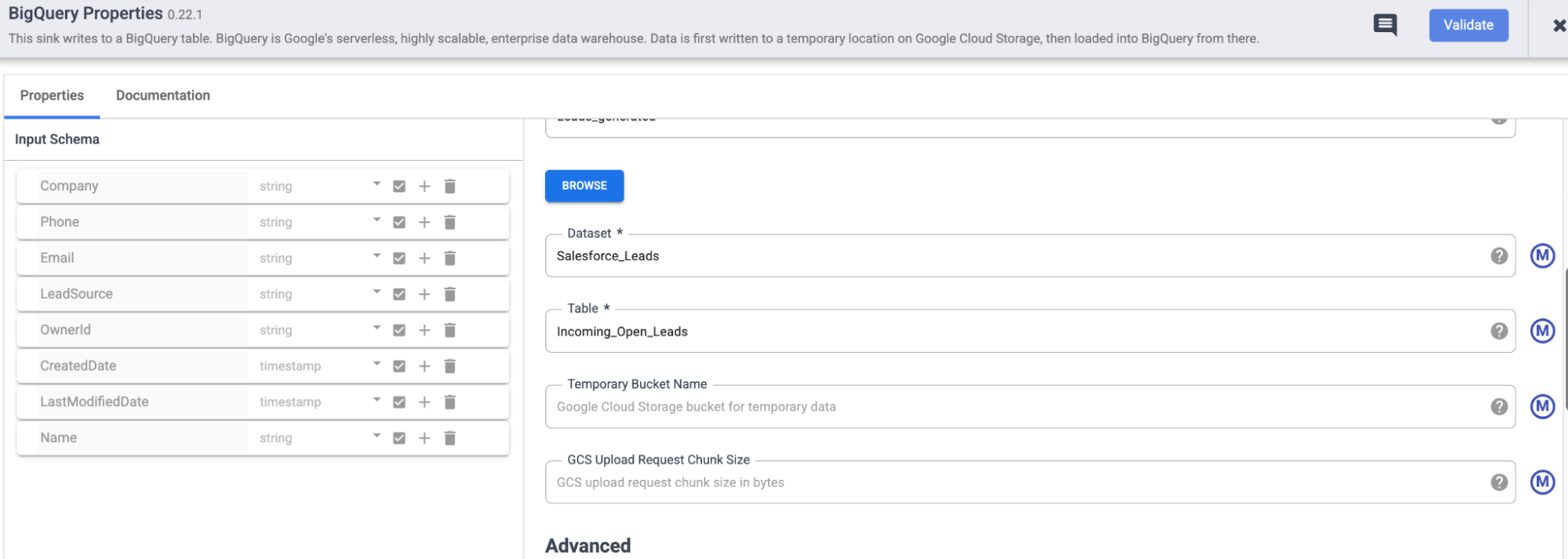

Accédez au nœud BigQuery, puis cliquez sur Propriétés. La page des propriétés du plug-in BigQuery s'ouvre.

Dans le champ Nom de la référence de la section Basique, saisissez un nom permettant d'identifier ce récepteur. Par exemple,

Leads_generated.Dans le champ Ensemble de données, saisissez l'ensemble de données auquel appartient la table. Exemple :

Salesforce_Leads.Dans le champ Table, saisissez la table dans laquelle les enregistrements extraits doivent être stockés. Par exemple,

Incoming_Open_Leads.Pour valider le plug-in, cliquez sur Valider.

Déployer, planifier et exécuter le pipeline

Pour déployer le pipeline, cliquez sur Déployer.

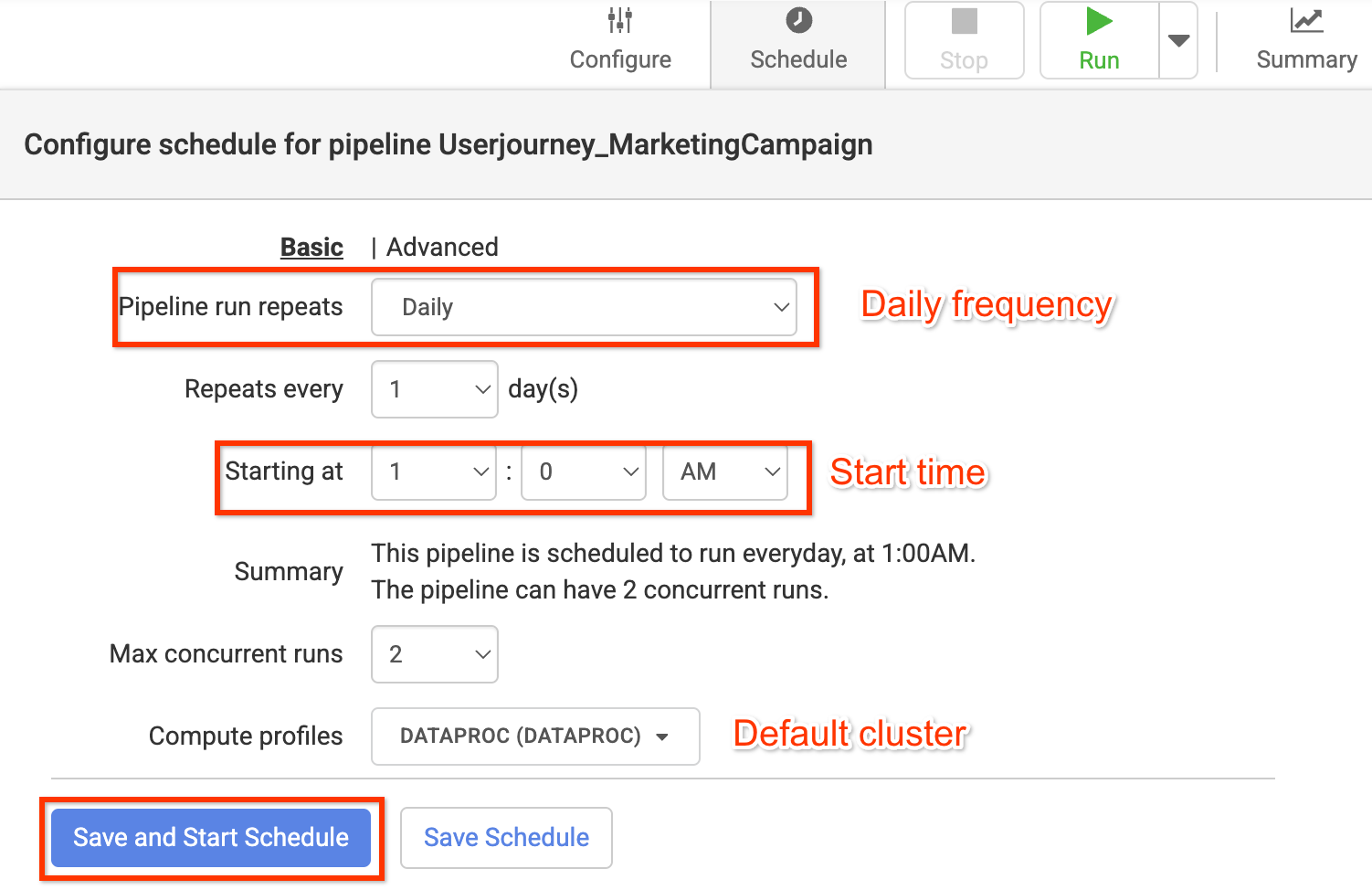

Pour configurer un planning d'actualisation approprié à l'aide des planificateurs, procédez comme suit :

- Cliquez sur Programmer.

Saisissez les informations suivantes :

- Pipeline run repeats

- Repeats every

- À partir de

- Max concurrent runs

- Compute profiles

Cliquez sur Enregistrer et démarrer la planification.

Pour exécuter le pipeline, cliquez sur Exécuter.

Vérifier l'extraction et l'ingestion des données

Dans la console Google Cloud , accédez à la page BigQuery.

Recherchez l'ensemble de données

Salesforce_Leadset le nom de la tableIncoming_Open_Leadspour afficher les enregistrements extraits.Pour exécuter la requête, cliquez sur Requête.

Analysez les données sur les prospects pour mieux comprendre votre audience et diffuser des campagnes sur mesure à grande échelle.

Effectuer un nettoyage

Pour éviter que les ressources utilisées dans cette démonstration soient facturées sur votre compte Google Cloud , procédez comme suit :

Supprimer l'instance Cloud Data Fusion

Suivez ces instructions pour supprimer votre instance Cloud Data Fusion.

Supprimer le projet

Le moyen le plus simple d'empêcher la facturation est de supprimer le projet que vous avez créé pour ce tutoriel.

Pour supprimer le projet :

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.