Ejecuta un DAG de Apache Airflow en Cloud Composer 1

Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

En esta guía de inicio rápido, se muestra cómo crear un entorno de Cloud Composer y cómo ejecutar un DAG de Apache Airflow en Cloud Composer 1.

Si eres nuevo en Airflow, consulta el instructivo de conceptos de Airflow en la documentación de Apache Airflow para obtener más información sobre los conceptos, los objetos y su uso.

Si deseas usar Google Cloud CLI en su lugar, consulta Ejecuta un DAG de Apache Airflow en Cloud Composer (Google Cloud CLI).

Si deseas crear un entorno con Terraform, consulta Crea entornos (Terraform).

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Cloud Composer API.

-

Si quieres obtener los permisos que necesitas para completar esta guía de inicio rápido, pídele a tu administrador que te otorgue los siguientes roles de IAM en tu proyecto:

-

Para ver, crear y administrar el entorno de Cloud Composer, haz lo siguiente:

-

Administrador de objetos de almacenamiento y entorno (

roles/composer.environmentAndStorageObjectAdmin) -

Usuario de cuenta de servicio (

roles/iam.serviceAccountUser)

-

Administrador de objetos de almacenamiento y entorno (

-

Para ver los registros, usa el Visualizador de registros (

roles/logging.viewer).

Para obtener más información sobre cómo otorgar roles, consulta Administra el acceso a proyectos, carpetas y organizaciones.

También puedes obtener los permisos necesarios mediante roles personalizados o cualquier otro rol predefinido.

-

Para ver, crear y administrar el entorno de Cloud Composer, haz lo siguiente:

Crea la cuenta de servicio de un entorno

Cuando creas un entorno, especificas una cuenta de servicio. Esta cuenta de servicio se denomina cuenta de servicio del entorno. Tu entorno usa esta cuenta de servicio para realizar la mayoría de las operaciones.

La cuenta de servicio de tu entorno no es una cuenta de usuario. Una cuenta de servicio es un tipo especial de cuenta que usa una aplicación o una instancia de máquina virtual (VM), no una persona.

Para crear una cuenta de servicio para tu entorno, sigue estos pasos:

Crea una cuenta de servicio nueva, como se describe en la documentación de Identity and Access Management.

Otórgale un rol, como se describe en la documentación de Identity and Access Management. El rol requerido es Trabajador de Composer (

composer.worker).

Crear un entorno

En la consola de Google Cloud, ve a la página Crear entorno.

En el campo Nombre, ingresa

example-environment.En la lista desplegable Ubicación, selecciona una región para el entorno de Cloud Composer. En esta guía, se usa la región

us-central1.Para otras opciones de configuración del entorno, usa los valores predeterminados proporcionados.

Haz clic en Crear y espera a que se cree el entorno.

Cuando termines, aparecerá una marca de verificación verde junto al nombre del entorno.

Crea un archivo DAG

Un DAG de Airflow es una colección de tareas organizadas que deseas programar y ejecutar. Los DAG se definen en archivos estándares de Python.

En esta guía, se usa un ejemplo de DAG de Airflow definido en el archivo quickstart.py.

El código de Python de este archivo hace lo siguiente:

- Crea un DAG

composer_sample_dag. Este DAG se ejecuta todos los días. - Ejecuta una tarea

print_dag_run_conf. La tarea imprime la configuración de ejecución del DAG con el operador bash.

Guarda una copia del archivo quickstart.py en tu máquina local:

Sube el archivo de DAG al bucket de tu entorno

Cada entorno de Cloud Composer tiene un bucket de Cloud Storage asociado. Airflow en Cloud Composer programa solo los DAG que se encuentran en la carpeta /dags de este bucket.

Para programar tu DAG, sube quickstart.py desde tu máquina local a la carpeta /dags de tu entorno:

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno,

example-environment. Se abrirá la página Detalles del entorno.Haz clic en Abrir carpeta de DAG. Se abrirá la página Detalles del bucket.

Haz clic en Subir archivos y, luego, selecciona tu copia de

quickstart.py.Para subir el archivo, haz clic en Abrir.

Cómo ver el DAG

Después de subir el archivo DAG, Airflow hace lo siguiente:

- Analiza el archivo DAG que subiste. Es posible que el DAG tarde unos minutos en estar disponible para Airflow.

- Agrega el DAG a la lista de DAGs disponibles.

- Ejecuta el DAG según el programa que proporcionaste en el archivo DAG.

Para verificar que tu DAG se procese sin errores y esté disponible en Airflow, obsérvalo en la IU de DAG. La IU de DAG es la interfaz de Cloud Composer para ver información de DAG en la consola de Google Cloud. Cloud Composer también proporciona acceso a la IU de Airflow, que es una interfaz web nativa de Airflow.

Espera unos cinco minutos para darle tiempo a Airflow de procesar el archivo DAG que subiste anteriormente y completar la primera ejecución del DAG (se explica más adelante).

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno,

example-environment. Se abrirá la página Detalles del entorno.Ve a la pestaña DAG.

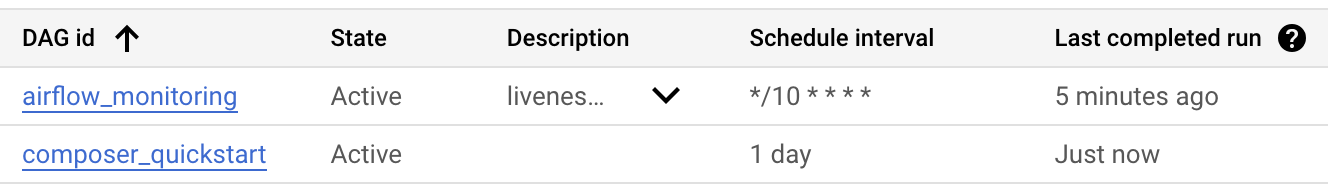

Verifica que el DAG

composer_quickstartesté presente en la lista de DAG.

Figura 1: La lista de DAG muestra el DAG composer_quickstart (haz clic para ampliar).

Cómo ver los detalles de la ejecución del DAG

Una sola ejecución de un DAG se denomina ejecución de DAG. Airflow ejecuta de inmediato una ejecución de DAG para el DAG de ejemplo porque la fecha de inicio en el archivo DAG está establecida en ayer. De esta manera, Airflow se pone al día con la programación del DAG especificado.

El DAG de ejemplo contiene una tarea, print_dag_run_conf, que ejecuta el comando echo en la consola. Este comando genera metainformación sobre el DAG (el identificador numérico de la ejecución del DAG).

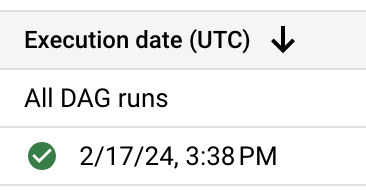

En la pestaña DAGs, haz clic en

composer_quickstart. Se abrirá la pestaña Runs del DAG.En la lista de ejecuciones de DAG, haz clic en la primera entrada.

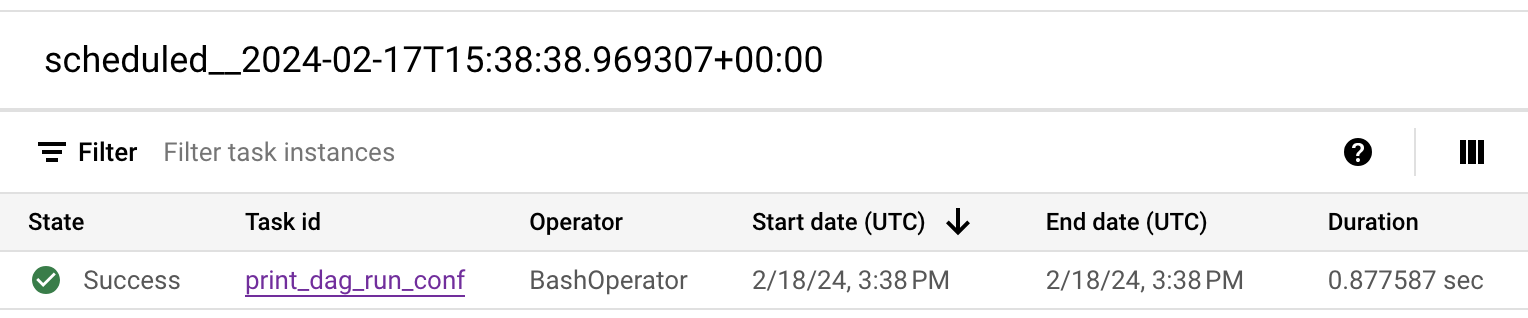

Figura 2: La lista de ejecuciones de DAG para el DAG composer_quickstart (haz clic para ampliar) Se muestran los detalles de la ejecución del DAG, que detallan la información sobre las tareas individuales del DAG de ejemplo.

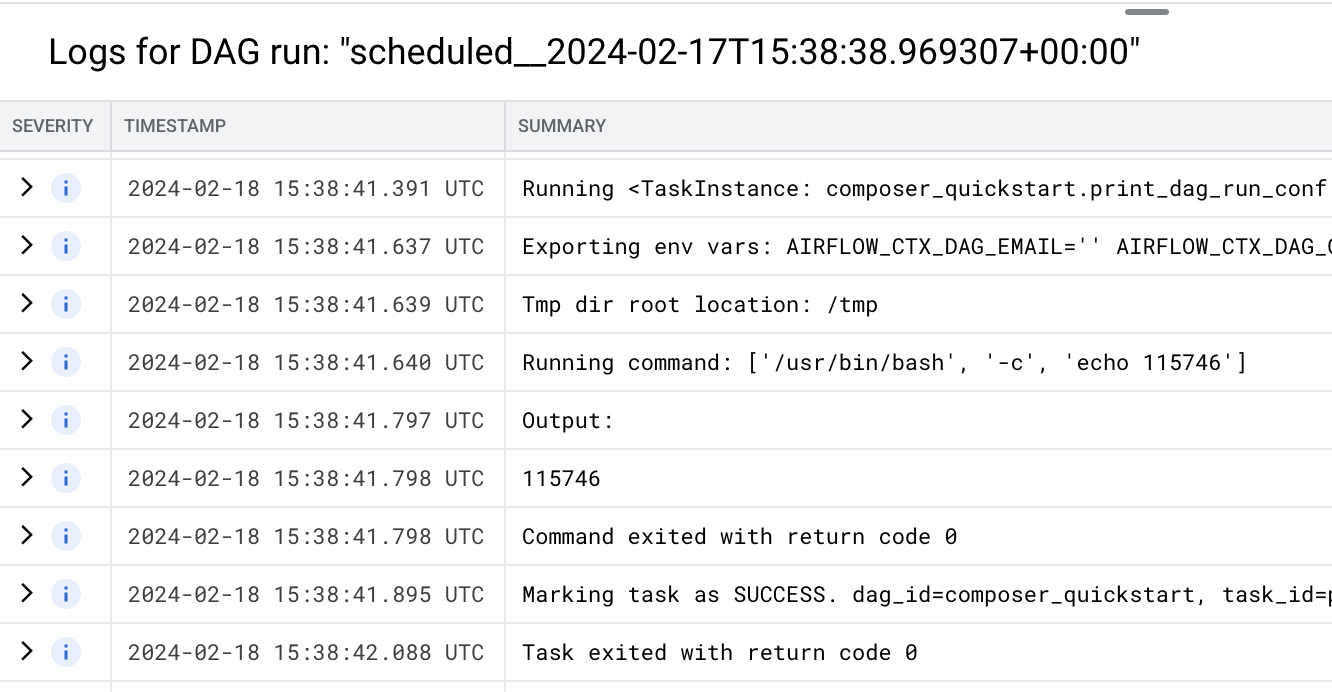

Figura 3: La lista de tareas que se ejecutaron en la ejecución de DAG (haz clic para ampliar) En la sección Registros de la ejecución del DAG, se enumeran los registros de todas las tareas de la ejecución del DAG. Puedes ver el resultado del comando

echoen los registros.

Figura 4: Registros de la tarea print_dag_run_conf (haz clic para ampliar)

Limpia

Sigue estos pasos para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos que usaste en esta página.

Borra los recursos que se usaron en este instructivo:

Borra el entorno de Cloud Composer:

En la consola de Google Cloud, ve a la página Entornos.

Selecciona

example-environmenty haz clic en Borrar.Espera hasta que se borre el entorno.

Borra el bucket de tu entorno. Aunque borres el entorno de Cloud Composer, no se borra el bucket.

En la consola de Google Cloud, ve a la página Almacenamiento > Navegador.

Selecciona el bucket del entorno y haz clic en Borrar. Por ejemplo, este bucket puede llamarse

us-central1-example-environ-c1616fe8-bucket.

¿Qué sigue?