Cloud Composer 1 | Cloud Composer 2 | Cloud Composer 3

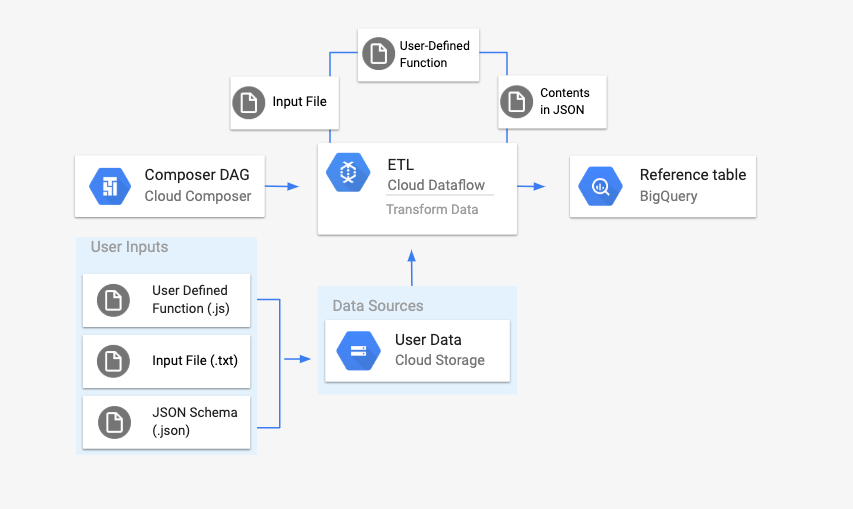

In questa pagina viene descritto come utilizzare DataflowTemplateOperator per l'avvio

Pipeline Dataflow da

con Cloud Composer.

Pipeline da testo a BigQuery di Cloud Storage

è una pipeline batch che consente di caricare file di testo

Cloud Storage, trasformali utilizzando una funzione JavaScript definita dall'utente (UDF) che fornisci e invia i risultati a

in BigQuery.

Panoramica

Prima di avviare il flusso di lavoro, creerai le seguenti entità:

Una tabella BigQuery vuota da un set di dati vuoto che conterrà le seguenti colonne di informazioni:

location,average_temperature,monthe, facoltativamente,inches_of_rain,is_currentelatest_measurement.Un file JSON che normalizzerà i dati di

.txtnel formato corretto per il parametro . L'oggetto JSON avrà un array diBigQuery Schema, in cui ciascun oggetto conterrà un nome di colonna, un tipo di input e se non è un campo obbligatorio.Un file

.txtdi input che conterrà i dati che verranno caricati collettivamente alla tabella BigQuery.Una funzione definita dall'utente scritta in JavaScript che trasformerà ciascuna riga del file

.txtnelle variabili pertinenti per la tabella.Un file DAG Airflow che punterà alla posizione di questi .

Successivamente, caricherai il file

.txt, il file delle funzioni definite dall'utente.jse lo schema.jsonin un bucket Cloud Storage. Caricherai anche il DAG del tuo ambiente Cloud Composer.Dopo aver caricato il DAG, Airflow eseguirà un'attività da quest'ultimo. Questa attività avviare una pipeline Dataflow che applicherà funzione definita dall'utente al file

.txte formattarla in base alla Schema JSON.Infine, i dati vengono caricati nella tabella BigQuery che hai creato in precedenza.

Prima di iniziare

- Questa guida richiede familiarità con JavaScript per scrivere la funzione definita dall'utente.

- Questa guida presuppone che tu abbia già un Cloud Composer completamente gestito di Google Cloud. Consulta Creare un ambiente per crearne uno. Puoi utilizzare qualsiasi versione di Cloud Composer con questa guida.

-

Abilita le API Cloud Composer, Dataflow, Cloud Storage, BigQuery.

Crea una tabella BigQuery vuota con una definizione di schema

Creare una tabella BigQuery con una definizione di schema. Tu utilizzerà questa definizione di schema più avanti in questa guida. Questo La tabella BigQuery conterrà i risultati del caricamento in batch.

Per creare una tabella vuota con una definizione di schema:

Console

Nella console Google Cloud, vai a BigQuery pagina:

Nel pannello di navigazione, nella sezione Risorse, espandi le progetto.

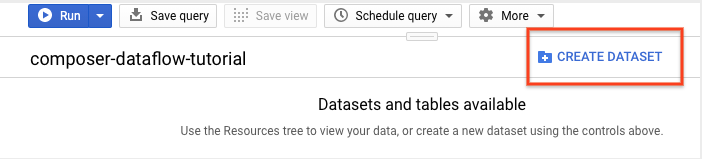

Nel riquadro dei dettagli, fai clic su Crea set di dati.

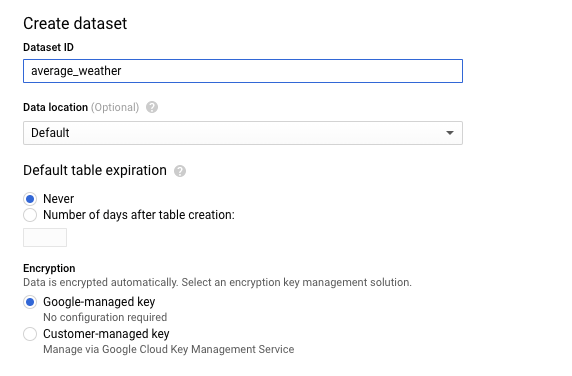

Nella pagina Crea set di dati, nella sezione ID set di dati, assegna un nome Set di dati

average_weather. Lascia invariati i valori predefiniti di tutti gli altri campi. stato.

Fai clic su Crea set di dati.

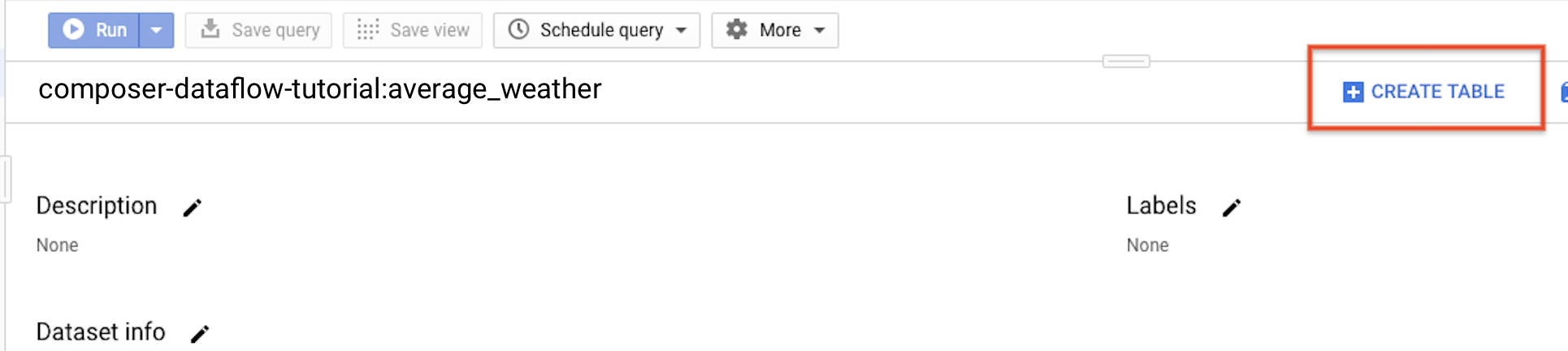

Torna al pannello di navigazione, nella sezione Risorse ed espandi del progetto. Quindi, fai clic sul set di dati

average_weather.Nel riquadro dei dettagli, fai clic su Crea tabella.

Nella pagina Crea tabella, nella sezione Origine, seleziona Tabella vuota.

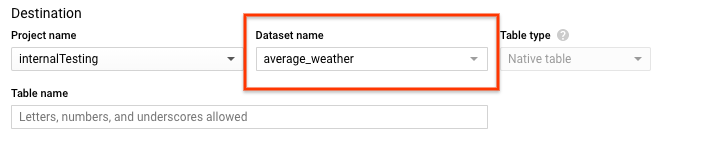

Nella sezione Destinazione della pagina Crea tabella:

In Nome set di dati, scegli il set di dati

average_weather.

Nel campo Nome tabella, inserisci il nome

average_weather.Verifica che l'opzione Tipo di tabella sia impostata su Tabella nativa.

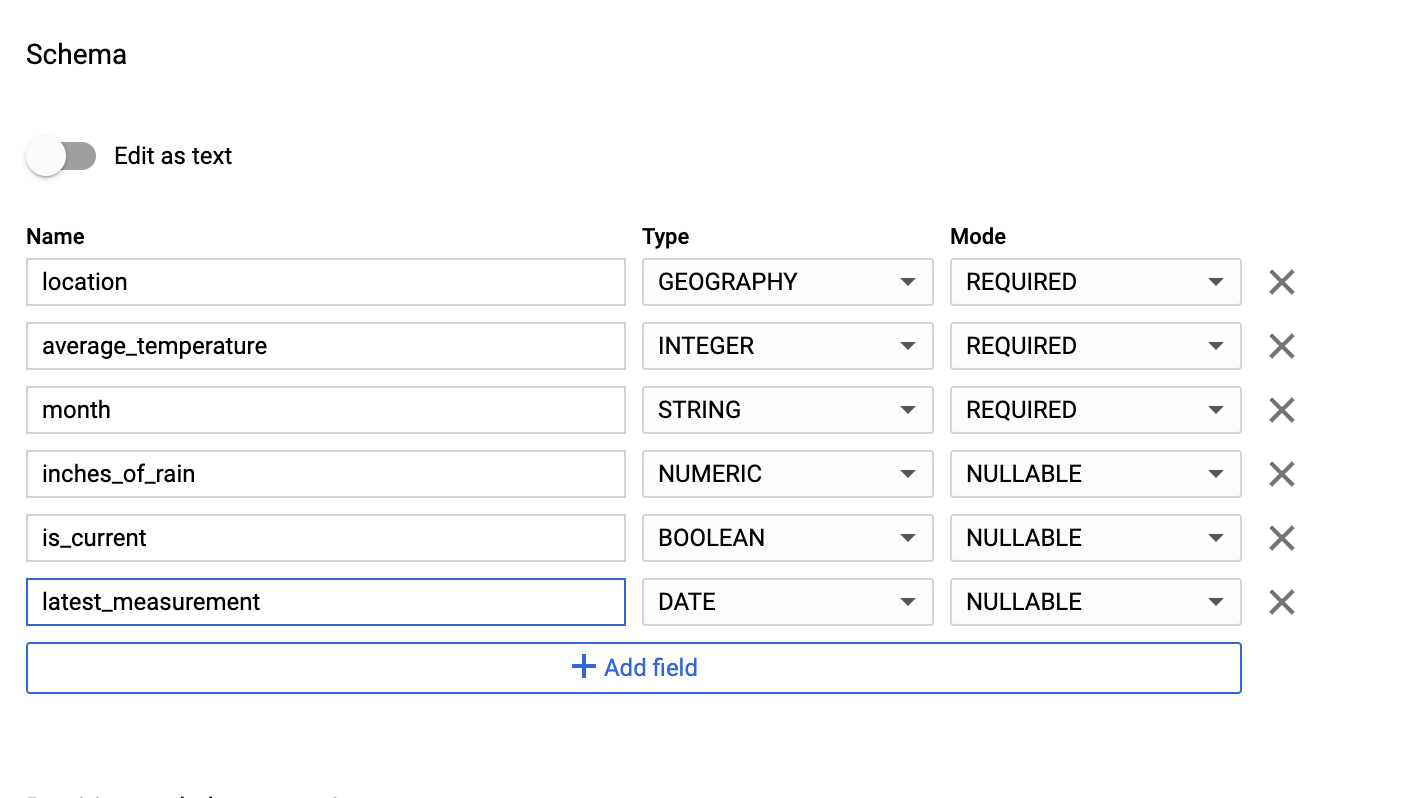

Nella sezione Schema, inserisci lo schema. definizione di Kubernetes. Puoi utilizzare uno dei seguenti approcci:

Inserisci manualmente le informazioni sullo schema attivando Modifica come testo e inserendo lo schema della tabella come array JSON. Digita quanto segue campi:

[ { "name": "location", "type": "GEOGRAPHY", "mode": "REQUIRED" }, { "name": "average_temperature", "type": "INTEGER", "mode": "REQUIRED" }, { "name": "month", "type": "STRING", "mode": "REQUIRED" }, { "name": "inches_of_rain", "type": "NUMERIC" }, { "name": "is_current", "type": "BOOLEAN" }, { "name": "latest_measurement", "type": "DATE" } ]Utilizza Aggiungi campo per inserire manualmente lo schema:

In Impostazioni di partizionamento e clustering, lascia il valore predefinito valore,

No partitioning.Nella sezione Opzioni avanzate, per Crittografia lascia il valore predefinito,

Google-managed key.Fai clic su Crea tabella.

bq

Utilizza il comando bq mk per creare un set di dati vuoto e una tabella in

del set di dati.

Esegui questo comando per creare un set di dati delle condizioni meteorologiche globali medie:

bq --location=LOCATION mk \

--dataset PROJECT_ID:average_weather

Sostituisci quanto segue:

LOCATION: la regione in cui si trova l'ambiente.PROJECT_ID: l'ID del progetto.

Esegui questo comando per creare una tabella vuota in questo set di dati con la definizione dello schema:

bq mk --table \

PROJECT_ID:average_weather.average_weather \

location:GEOGRAPHY,average_temperature:INTEGER,month:STRING,inches_of_rain:NUMERIC,is_current:BOOLEAN,latest_measurement:DATE

Dopo aver creato la tabella, puoi aggiorna la scadenza, la descrizione e le etichette della tabella. Puoi anche modificare la definizione dello schema.

Python

Salva questo codice come

dataflowtemplateoperator_create_dataset_and_table_helper.py

e aggiornare le variabili in modo che riflettano il progetto e la località,

eseguilo con questo comando:

python dataflowtemplateoperator_create_dataset_and_table_helper.py

Python

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Crea un bucket Cloud Storage

Crea un bucket per contenere tutti i file necessari per il flusso di lavoro. Il DAG che più avanti nella guida farà riferimento ai file che caricherai in questa Cloud Storage. Per creare un nuovo bucket di archiviazione:

Console

Apri Cloud Storage nella console Google Cloud.

Fai clic su Crea bucket per aprire il modulo di creazione del bucket.

Inserisci le informazioni sul bucket e fai clic su Continua per completare ogni passaggio:

Specifica un nome globalmente univoco per il tuo bucket. Questa guida utilizza

bucketName, ad esempio.Seleziona Regione come tipo di località. Quindi, seleziona un'opzione Località in cui verranno archiviati i dati del bucket.

Seleziona Standard come classe di archiviazione predefinita per i tuoi dati.

Seleziona il controllo dell'accesso Uniforme per accedere agli oggetti.

Fai clic su Fine.

gsutil

Usa il comando gsutil mb:

gsutil mb gs://bucketName/

Sostituisci quanto segue:

bucketName: il nome del bucket che hai creato in precedenza in questo guida.

Esempi di codice

C#

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Go

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Java

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Ruby

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Crea uno schema BigQuery in formato JSON per la tabella di output

Crea un file di schema BigQuery in formato JSON corrispondente alla

che hai creato in precedenza. Tieni presente che i nomi, i tipi e le modalità dei campi

devono corrispondere a quelli definiti in precedenza nella tabella BigQuery

. Questo file normalizzerà i dati del file .txt in un formato

compatibili con lo schema BigQuery. Assegna un nome a questo file

jsonSchema.json.

{

"BigQuery Schema": [

{

"name": "location",

"type": "GEOGRAPHY",

"mode": "REQUIRED"

},

{

"name": "average_temperature",

"type": "INTEGER",

"mode": "REQUIRED"

},

{

"name": "month",

"type": "STRING",

"mode": "REQUIRED"

},

{

"name": "inches_of_rain",

"type": "NUMERIC"

},

{

"name": "is_current",

"type": "BOOLEAN"

},

{

"name": "latest_measurement",

"type": "DATE"

}]

}

Crea un file JavaScript per formattare i dati

In questo file, definirai la funzione definita dall'utente (UDF) che fornisce

la logica per trasformare le righe di testo nel file di input. Tieni presente che

prende ciascuna riga di testo nel file di input come argomento separato,

la funzione verrà eseguita una volta per ogni riga del file di input. Assegna un nome a questo file

transformCSVtoJSON.js.

Crea il file di input

Questo file conterrà le informazioni che vuoi caricare sul tuo

Tabella BigQuery. Copia questo file localmente e assegnagli un nome

inputFile.txt.

POINT(40.7128 74.006),45,'July',null,true,2020-02-16

POINT(41.8781 87.6298),23,'October',13,false,2015-02-13

POINT(48.8566 2.3522),80,'December',null,true,null

POINT(6.5244 3.3792),15,'March',14,true,null

Carica i file nel bucket

Carica i file seguenti nel bucket Cloud Storage che hai creato precedenti:

- Schema BigQuery in formato JSON (

.json) - Funzione JavaScript definita dall'utente (

transformCSVtoJSON.js) Il file di input del testo da elaborare (

.txt)

Console

- Nella console Google Cloud, vai alla pagina Bucket di Cloud Storage.

Nell'elenco dei bucket, fai clic sul tuo bucket.

Nella scheda Oggetti del bucket, esegui una delle seguenti operazioni:

Trascina i file desiderati dal desktop o da Gestione file. al riquadro principale della console Google Cloud.

Fai clic sul pulsante Carica file e seleziona i file che vuoi carica nella finestra di dialogo visualizzata e fai clic su Apri.

gsutil

Esegui il comando gsutil cp:

gsutil cp OBJECT_LOCATION gs://bucketName

Sostituisci quanto segue:

bucketName: il nome del bucket che hai creato in precedenza in questa guida.OBJECT_LOCATION: il percorso locale dell'oggetto. Ad esempio:Desktop/transformCSVtoJSON.js.

Esempi di codice

Python

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Ruby

Per eseguire l'autenticazione su Cloud Composer, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Configura DataflowTemplateOperator

Prima di eseguire il DAG, imposta le seguenti variabili Airflow.

| Variabile Airflow | Valore |

|---|---|

project_id

|

L'ID del progetto |

gce_zone

|

Zona Compute Engine in cui si trova il cluster Dataflow devono essere creati |

bucket_path

|

La località del bucket Cloud Storage che hai creato precedenti |

Ora farai riferimento ai file creati in precedenza per creare un DAG che avvia

dal flusso di lavoro Dataflow. Copia questo DAG e salvalo localmente

come composer-dataflow-dag.py.

Flusso d'aria 2

Flusso d'aria 1

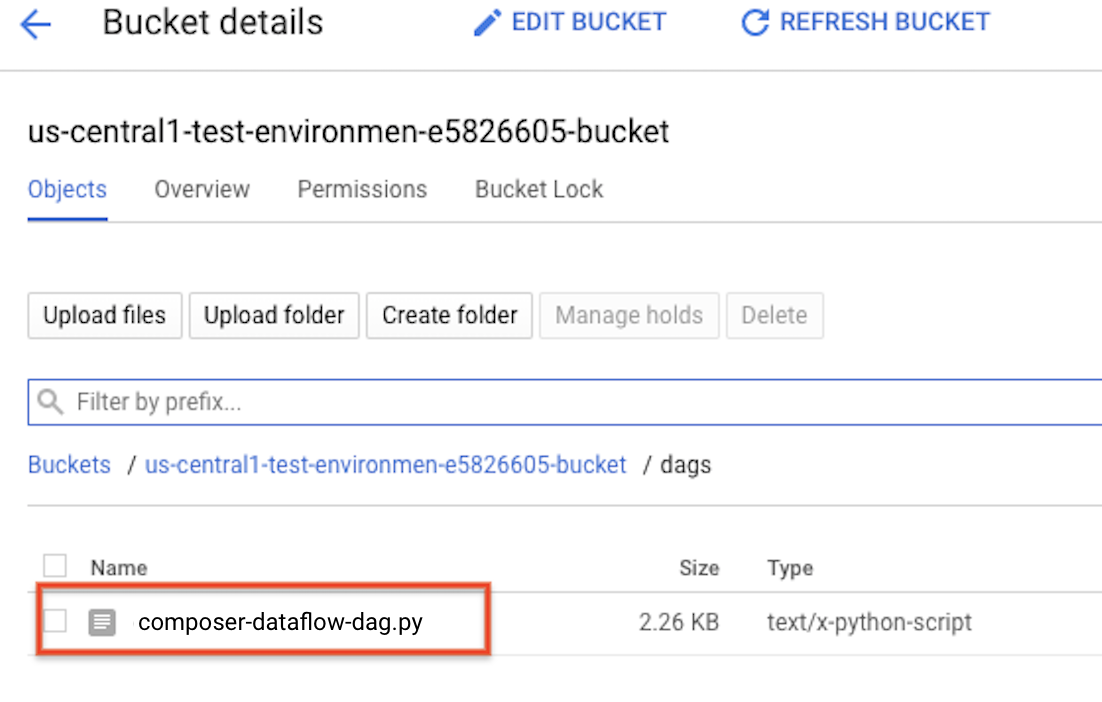

Carica il DAG in Cloud Storage

Carica il DAG nella cartella /dags della cartella

di sincronizzare la directory di una VM

con un bucket. Una volta completato il caricamento, puoi visualizzarlo

facendo clic sul link Cartella dei DAG in Cloud Composer

Pagina Ambienti.

Visualizzare lo stato dell'attività

- Vai all'interfaccia web di Airflow.

- Nella pagina dei DAG, fai clic sul nome del DAG (ad esempio

composerDataflowDAG). - Nella pagina dei dettagli dei DAG, fai clic su Vista grafico.

Verifica lo stato:

Failed: intorno all'attività è presente una casella rossa. Puoi anche tenere il puntatore sopra l'attività e cercare State: Non riuscita.Success: intorno all'attività è presente un riquadro verde. Puoi anche tenere il puntatore sopra l'attività per verificare Stato: operazione completata.

Dopo alcuni minuti, puoi controllare i risultati in Dataflow in BigQuery.

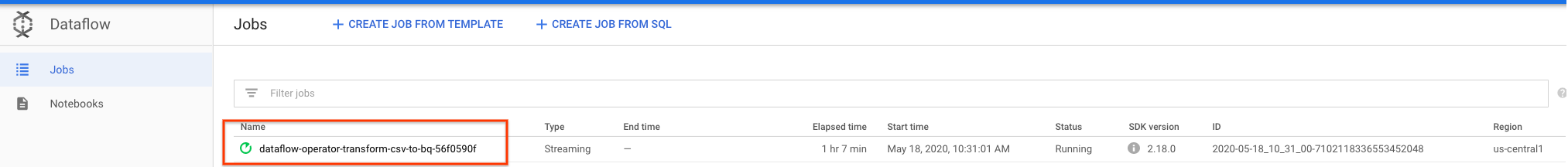

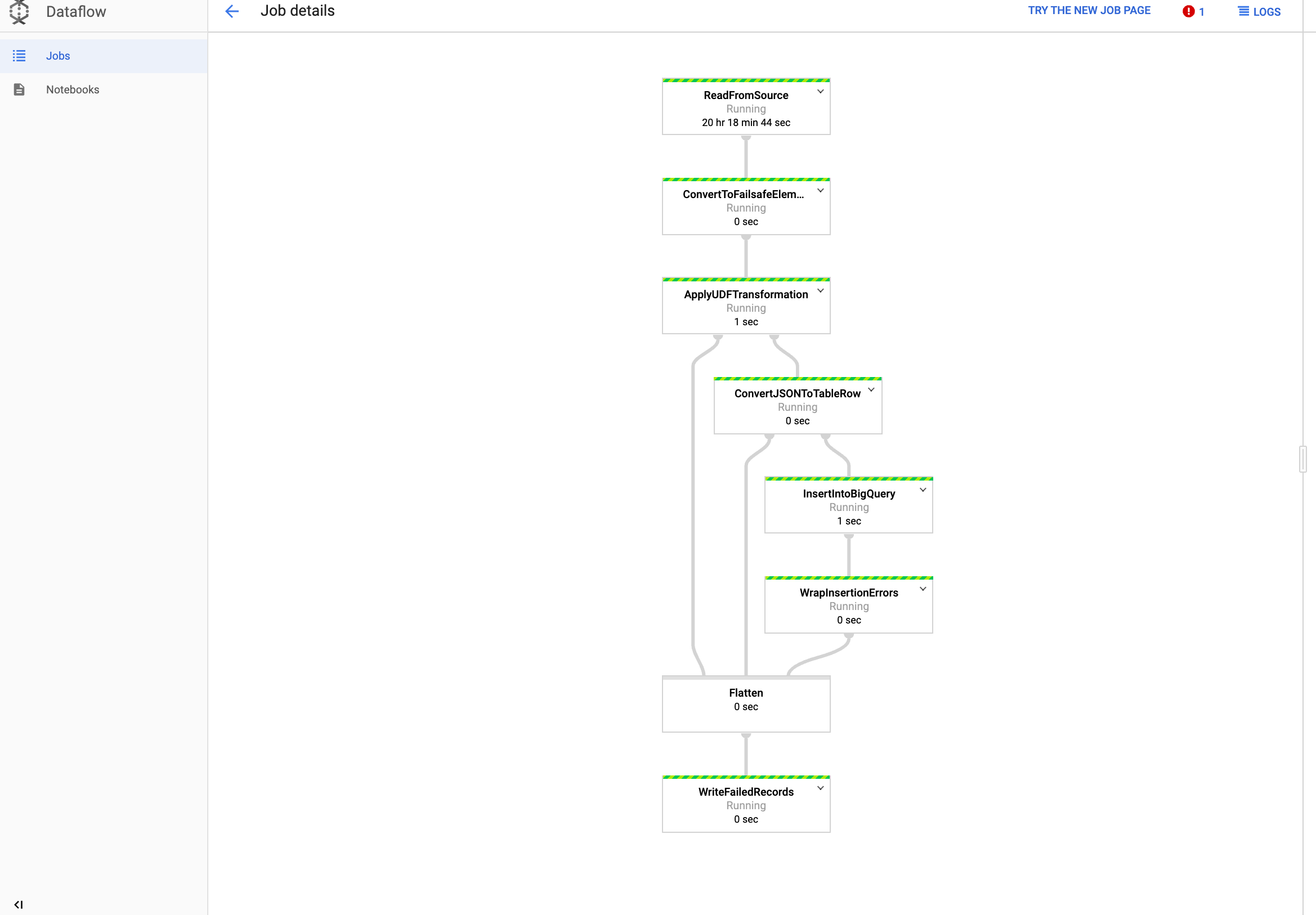

Visualizza il job in Dataflow

Nella console Google Cloud, vai alla pagina Dataflow.

Il tuo job è denominato

dataflow_operator_transform_csv_to_bqcon un ID univoco alla fine del nome con un trattino, in questo modo:

Fai clic sul nome per visualizzare dettagli offerta di lavoro.

Visualizzare i risultati in BigQuery

Nella console Google Cloud, vai alla pagina BigQuery.

Puoi inviare query utilizzando SQL standard. Usa la seguente query per visualizza le righe aggiunte alla tabella:

SELECT * FROM projectId.average_weather.average_weather