Questo tutorial mostra come creare un servizio di chat in tempo reale multistanza utilizzando WebSocket con una connessione persistente per la comunicazione bidirezionale. Con WebSocket, sia il client che il server possono inviarsi messaggi a vicenda senza eseguire il polling del server per gli aggiornamenti.

Anche se puoi configurare Cloud Run per utilizzare l'affinità di sessione, questa fornisce un'affinità ottimale, il che significa che qualsiasi nuova richiesta può comunque essere potenzialmente indirizzata a un'istanza diversa. Di conseguenza, i messaggi degli utenti nel servizio di chat devono essere sincronizzati in tutte le istanze, non solo tra i client connessi a un'istanza.

Panoramica del design

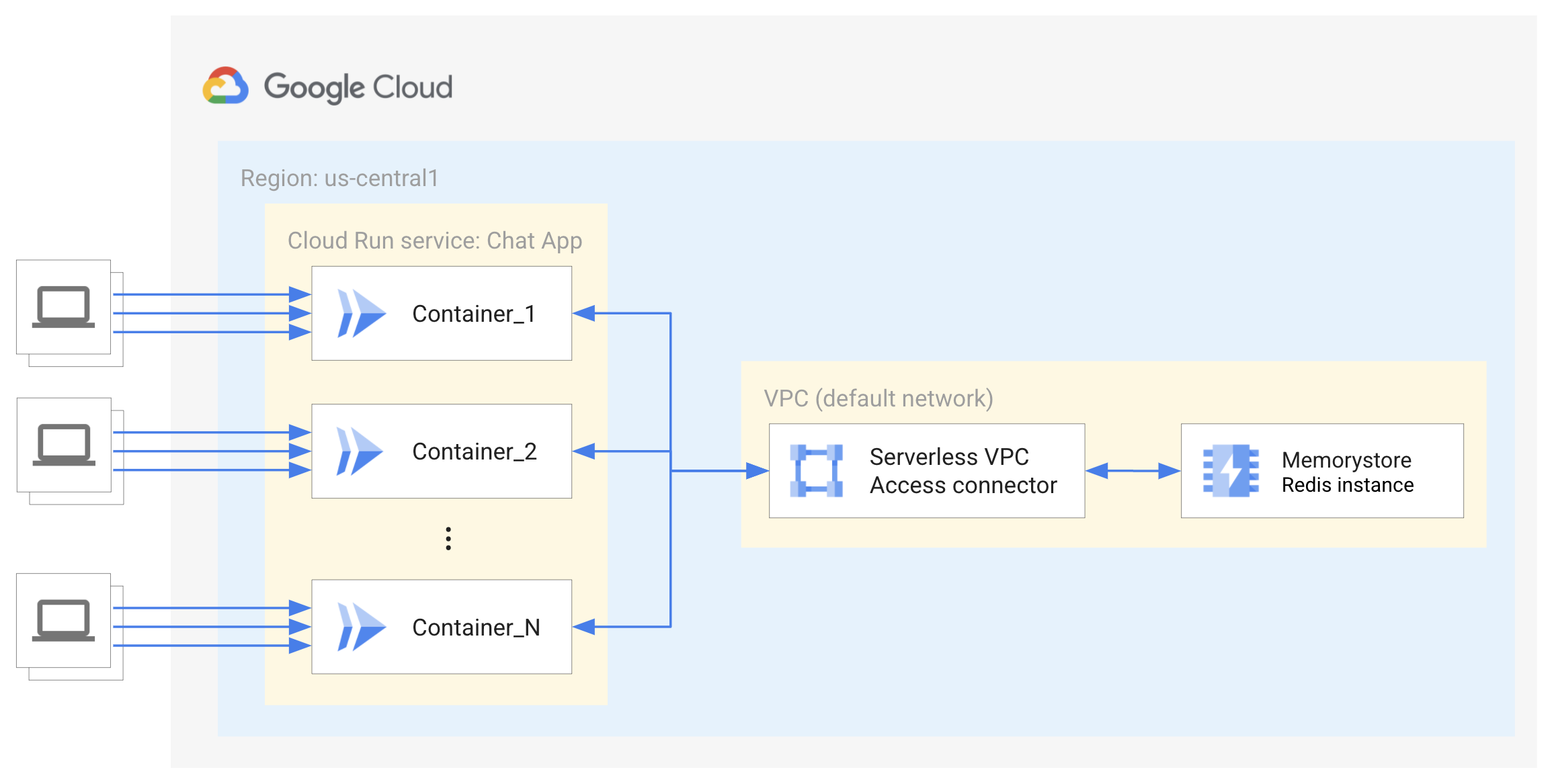

Questo servizio di chat di esempio utilizza un'istanza Memorystore for Redis per archiviare e sincronizzare i messaggi degli utenti in tutte le istanze. Redis utilizza un meccanismo Pub/Sub, da non confondere con il prodotto Cloud Pub/Sub, per eseguire il push dei dati ai client abbonati connessi a qualsiasi istanza, in modo da eliminare il polling HTTP per gli aggiornamenti.

Tuttavia, anche con gli aggiornamenti push, qualsiasi istanza creata riceverà solo i nuovi messaggi inviati al container. Per caricare i messaggi precedenti, la cronologia dei messaggi deve essere archiviata e recuperata da una soluzione di archiviazione persistente. Questo esempio utilizza la funzionalità convenzionale di Redis di un archivio di oggetti per memorizzare nella cache e recuperare la cronologia dei messaggi.

L'istanza Redis è protetta da internet tramite IP privati con accesso controllato e limitato ai servizi in esecuzione sulla stessa rete privata virtuale dell'istanza Redis. Pertanto, è necessario un connettore di accesso VPC serverless per consentire al servizio Cloud Run di connettersi a Redis. Scopri di più sull'accesso VPC serverless.

Limitazioni

Questo tutorial non mostra l'autenticazione degli utenti finali o la memorizzazione nella cache delle sessioni. Per saperne di più sull'autenticazione degli utenti finali, consulta il tutorial di Cloud Run sull'autenticazione degli utenti finali.

Questo tutorial non implementa un database come Firestore per l'archiviazione e il recupero indefiniti della cronologia dei messaggi di chat.

Per rendere pronto per la produzione questo servizio di esempio sono necessari elementi aggiuntivi. Per fornire alta disponibilità tramite la replica e il failover automatico, è consigliata un'istanza Redis di livello standard.

Configurazione dei valori predefiniti di gcloud

Per configurare gcloud con i valori predefiniti per il tuo servizio Cloud Run:

Imposta il progetto predefinito:

gcloud config set project PROJECT_ID

Sostituisci PROJECT_ID con il nome del progetto che hai creato per questo tutorial.

Configura gcloud per la regione scelta:

gcloud config set run/region REGION

Sostituisci REGION con la regione Cloud Run supportata che preferisci.

Località Cloud Run

Cloud Run è regionale, il che significa che l'infrastruttura che esegue i tuoi servizi Cloud Run si trova in una regione specifica ed è gestita da Google per essere disponibile in modo ridondante in tutte le zone all'interno di quella regione.

Il rispetto dei requisiti di latenza, disponibilità o durabilità sono fattori

primari per la selezione della regione in cui vengono eseguiti i servizi Cloud Run.

In genere puoi selezionare la regione più vicina ai tuoi utenti, ma devi considerare

la posizione degli altri Google Cloud

prodotti utilizzati dal tuo servizio Cloud Run.

L'utilizzo combinato dei prodotti Google Cloud in più località può influire

sulla latenza e sui costi del servizio.

Cloud Run è disponibile nelle seguenti regioni:

Soggetto ai prezzi di Livello 1

asia-east1(Taiwan)asia-northeast1(Tokyo)asia-northeast2(Osaka)asia-south1(Mumbai, India)europe-north1(Finlandia)Bassi livelli di CO2

europe-north2(Stoccolma)Bassi livelli di CO2

europe-southwest1(Madrid)Bassi livelli di CO2

europe-west1(Belgio)Bassi livelli di CO2

europe-west4(Paesi Bassi)Bassi livelli di CO2

europe-west8(Milano)europe-west9(Parigi)Bassi livelli di CO2

me-west1(Tel Aviv)northamerica-south1(Messico)us-central1(Iowa)Bassi livelli di CO2

us-east1(Carolina del Sud)us-east4(Virginia del Nord)us-east5(Columbus)us-south1(Dallas)Bassi livelli di CO2

us-west1(Oregon)Bassi livelli di CO2

Soggetto ai prezzi di Livello 2

africa-south1(Johannesburg)asia-east2(Hong Kong)asia-northeast3(Seul, Corea del Sud)asia-southeast1(Singapore)asia-southeast2(Giacarta)asia-south2(Delhi, India)australia-southeast1(Sydney)australia-southeast2(Melbourne)europe-central2(Varsavia, Polonia)europe-west10(Berlino)europe-west12(Torino)europe-west2(Londra, Regno Unito)Bassi livelli di CO2

europe-west3(Francoforte, Germania)europe-west6(Zurigo, Svizzera)A basse emissioni di CO2

me-central1(Doha)me-central2(Dammam)northamerica-northeast1(Montreal)Bassi livelli di CO2

northamerica-northeast2(Toronto)Bassi livelli di CO2

southamerica-east1(San Paolo, Brasile)Bassi livelli di CO2

southamerica-west1(Santiago, Cile)Bassi livelli di CO2

us-west2(Los Angeles)us-west3(Salt Lake City)us-west4(Las Vegas)

Se hai già creato un servizio Cloud Run, puoi visualizzare la regione nella dashboard Cloud Run nella consoleGoogle Cloud .

Recupero dell'esempio di codice

Per recuperare l'esempio di codice da utilizzare:

Clona il repository di esempio sulla tua macchina locale:

Node.js

git clone https://github.com/GoogleCloudPlatform/nodejs-docs-samples.git

In alternativa, puoi scaricare il campione come file ZIP ed estrarlo.

Passa alla directory che contiene il codice campione di Cloud Run:

Node.js

cd nodejs-docs-samples/run/websockets/

Nozioni di base sul codice

Socket.io è una libreria che consente la comunicazione bidirezionale in tempo reale tra il browser e il server. Sebbene Socket.io non sia un'implementazione di WebSocket, esegue il wrapping della funzionalità per fornire un'API più semplice per più protocolli di comunicazione con funzionalità aggiuntive, come una maggiore affidabilità, la riconnessione automatica e la trasmissione a tutti i client o a un sottoinsieme di client.

Integrazione lato client

Il client crea una nuova istanza socket per ogni connessione. Poiché questo esempio viene sottoposto a rendering lato server, non è necessario definire l'URL del server. L'istanza del socket può emettere ed ascoltare eventi.

Integrazione lato server

Sul lato server, il server Socket.io viene inizializzato e collegato al server HTTP. Analogamente al lato client, una volta che il server Socket.io si connette al client, viene creata un'istanza socket per ogni connessione, che può essere utilizzata per inviare e ascoltare i messaggi. Socket.io fornisce anche un'interfaccia semplice per creare "stanze" o un canale arbitrario a cui i socket possono partecipare e da cui possono uscire.

Socket.io fornisce anche un adattatore Redis per trasmettere eventi a tutti i client, indipendentemente dal server che gestisce il socket. Socket.io utilizza solo il meccanismo Pub/Sub di Redis e non archivia alcun dato.

L'adattatore Redis di Socket.io può riutilizzare il client Redis utilizzato per archiviare la cronologia dei messaggi della stanza virtuale. Ogni container creerà una connessione all'istanza Redis e Cloud Run può creare un numero elevato di istanze. Questo valore è molto inferiore alle 65.000 connessioni supportate da Redis. Se devi supportare questa quantità di traffico, devi anche valutare il throughput del connettore di accesso VPC serverless.

Riconnessione

Cloud Run ha un timeout massimo di 60 minuti. Devi quindi aggiungere una logica di riconnessione per i possibili timeout. In alcuni casi, Socket.io tenta automaticamente di riconnettersi dopo eventi di disconnessione o errore di connessione. Non è garantito che il client si riconnetta alla stessa istanza.

Le istanze verranno mantenute se è presente una connessione attiva finché tutte le richieste non vengono chiuse o non vanno in timeout. Anche se utilizzi l'affinità sessione di Cloud Run, è possibile che il bilanciamento del carico delle nuove richieste venga eseguito sui container attivi, il che consente di fare lo scale in i container. Se ti preoccupa la persistenza di un numero elevato di container dopo un picco di traffico, puoi ridurre il valore massimo del timeout, in modo che i socket inutilizzati vengano puliti più spesso.

Spedizione del servizio

Crea un'istanza Memorystore for Redis:

gcloud redis instances create INSTANCE_ID --size=1 --region=REGION

Sostituisci INSTANCE_ID con il nome dell'istanza, ad esempio

my-redis-instance, e REGION_ID con la regione per tutte le risorse e i servizi, ad esempioeurope-west1.All'istanza verrà allocato automaticamente un intervallo IP dall'intervallo di rete di servizio predefinito. Questo tutorial utilizza 1 GB di memoria per la cache locale dei messaggi nell'istanza Redis. Scopri di più su come determinare le dimensioni iniziali di un'istanza Memorystore per il tuo caso d'uso.

Configura un connettore di accesso VPC serverless:

Per connettersi all'istanza Redis, il servizio Cloud Run deve accedere alla rete VPC autorizzata dell'istanza Redis.

Ogni connettore VPC richiede una propria subnet

/28per posizionare le istanze del connettore. Questo intervallo IP non deve sovrapporsi ad alcuna prenotazione di indirizzi IP esistente nella tua rete VPC. Ad esempio,10.8.0.0(/28) funzionerà nella maggior parte dei nuovi progetti oppure puoi specificare un altro intervallo IP personalizzato non utilizzato, ad esempio10.9.0.0(/28). Puoi vedere quali intervalli IP sono attualmente riservati nella Google Cloud console.gcloud compute networks vpc-access connectors create CONNECTOR_NAME \ --region REGION \ --range "10.8.0.0/28"

Sostituisci CONNECTOR_NAME con il nome del connettore.

Questo comando crea un connettore nella rete VPC predefinita, la stessa dell'istanza Redis, con dimensioni della macchina

e2-micro. L'aumento delle dimensioni della macchina del connettore può migliorare la velocità effettiva del connettore, ma aumenterà anche i costi. Il connettore deve trovarsi nella stessa regione dell'istanza Redis. Scopri di più sulla configurazione dell'accesso VPC serverless.Definisci una variabile di ambiente con l'indirizzo IP della rete autorizzata dell'istanza Redis:

export REDISHOST=$(gcloud redis instances describe INSTANCE_ID --region REGION --format "value(host)")

Crea un account di servizio che funga da identità del servizio. Per impostazione predefinita, non dispone di privilegi diversi dall'appartenenza al progetto.

gcloud iam service-accounts create chat-identity gcloud projects add-iam-policy-binding PROJECT_ID \ --member=serviceAccount:chat-identity@PROJECT_ID.iam.gserviceaccount.com \ --role=roles/serviceusage.serviceUsageConsumer

Crea ed esegui il deployment dell'immagine container su Cloud Run:

gcloud run deploy chat-app --source . \ --vpc-connector CONNECTOR_NAME \ --allow-unauthenticated \ --timeout 3600 \ --service-account chat-identity \ --update-env-vars REDISHOST=$REDISHOST

Rispondi a eventuali richieste di installazione delle API necessarie rispondendo

yquando richiesto. Devi farlo solo una volta per progetto. Rispondi agli altri prompt fornendo la piattaforma e la regione, se non hai impostato i valori predefiniti per questi elementi come descritto nella pagina di configurazione. Scopri di più sul deployment dal codice sorgente.

Prova

Per provare il servizio completo:

Nel browser, vai all'URL fornito nel passaggio di deployment precedente.

Aggiungi il tuo nome e una chat room per accedere.

Invia un messaggio alla stanza virtuale.

Se scegli di continuare a sviluppare questi servizi, ricorda che hanno accesso Identity and Access Management (IAM) limitato al resto di Google Cloud e dovranno essere assegnati ruoli IAM aggiuntivi per accedere a molti altri servizi.