Che cos'è l'orchestrazione dei container?

La gestione di una singola applicazione containerizzata è relativamente semplice, ma la scalabilità a centinaia o migliaia in un sistema distribuito introduce sfide significative per garantire disponibilità, interconnettività e scalabilità. L'orchestrazione dei container risolve queste complessità. Sebbene Kubernetes sia la piattaforma open source leader per questa attività, gli strumenti di orchestrazione dei container completamente gestiti, come Google Kubernetes Engine (GKE), semplificano il deployment e la gestione continua, astraendo gran parte del carico operativo associato a Kubernetes.

Definizione di orchestrazione dei container

L'orchestrazione dei container è il sistema che esegue automaticamente il provisioning, il deployment, la scalabilità e la gestione delle applicazioni containerizzate senza che sia necessario preoccuparsi dell'infrastruttura sottostante.

Gli sviluppatori possono implementare questa orchestrazione ovunque si trovino i container, in modo da automatizzarne la gestione del ciclo di vita.

Per i team di sviluppo e operazioni aziendali, questo significa andare oltre i processi manuali e passare a un sistema dichiarativo e automatizzato. Invece di specificare come eseguire attività come il deployment di una nuova versione, la scalabilità per soddisfare i picchi di traffico o il ripristino da un guasto hardware, devi semplicemente dichiarare lo stato desiderato della tua applicazione.

Concetti chiave dell'orchestrazione di Kubernetes

L'orchestrazione di Kubernetes funziona gestendo un cluster di macchine e distribuendo i container su di esse in base alle risorse richieste e allo stato desiderato definito dall'utente. Il sistema è composto da diversi concetti chiave che lavorano insieme.

- Container: sono pacchetti leggeri, portatili ed eseguibili che contengono un'applicazione e tutte le sue dipendenze. Kubernetes orchestra il deployment e il ciclo di vita di questi container.

- Cluster: è l'insieme di tutte le macchine, note come nodi, che sono raggruppate e gestite da Kubernetes per eseguire le tue applicazioni.

- Piano di controllo: il piano di controllo è il cervello del cluster Kubernetes. Prende tutte le decisioni globali sul cluster (come la pianificazione) ed è responsabile del rilevamento e della risposta agli eventi del cluster per mantenere lo stato desiderato dall'utente.

- Nodi: un nodo è una singola macchina worker all'interno del cluster, che può essere un server fisico o una macchina virtuale. È il luogo in cui i container vengono effettivamente eseguiti.

- Pod: in Kubernetes, i pod sono gli oggetti più piccoli di cui è possibile eseguire il deployment e rappresentano una singola istanza di un processo in esecuzione. Contengono uno o più container, spazio di archiviazione condiviso e un IP di rete univoco.

Tipi di strumenti di orchestrazione dei container

Le piattaforme di orchestrazione dei container offrono strumenti per automatizzare questo aspetto, nonché la possibilità di installare altre tecnologie open source per il logging, il monitoraggio e l'analisi degli eventi, ad esempio Prometheus.

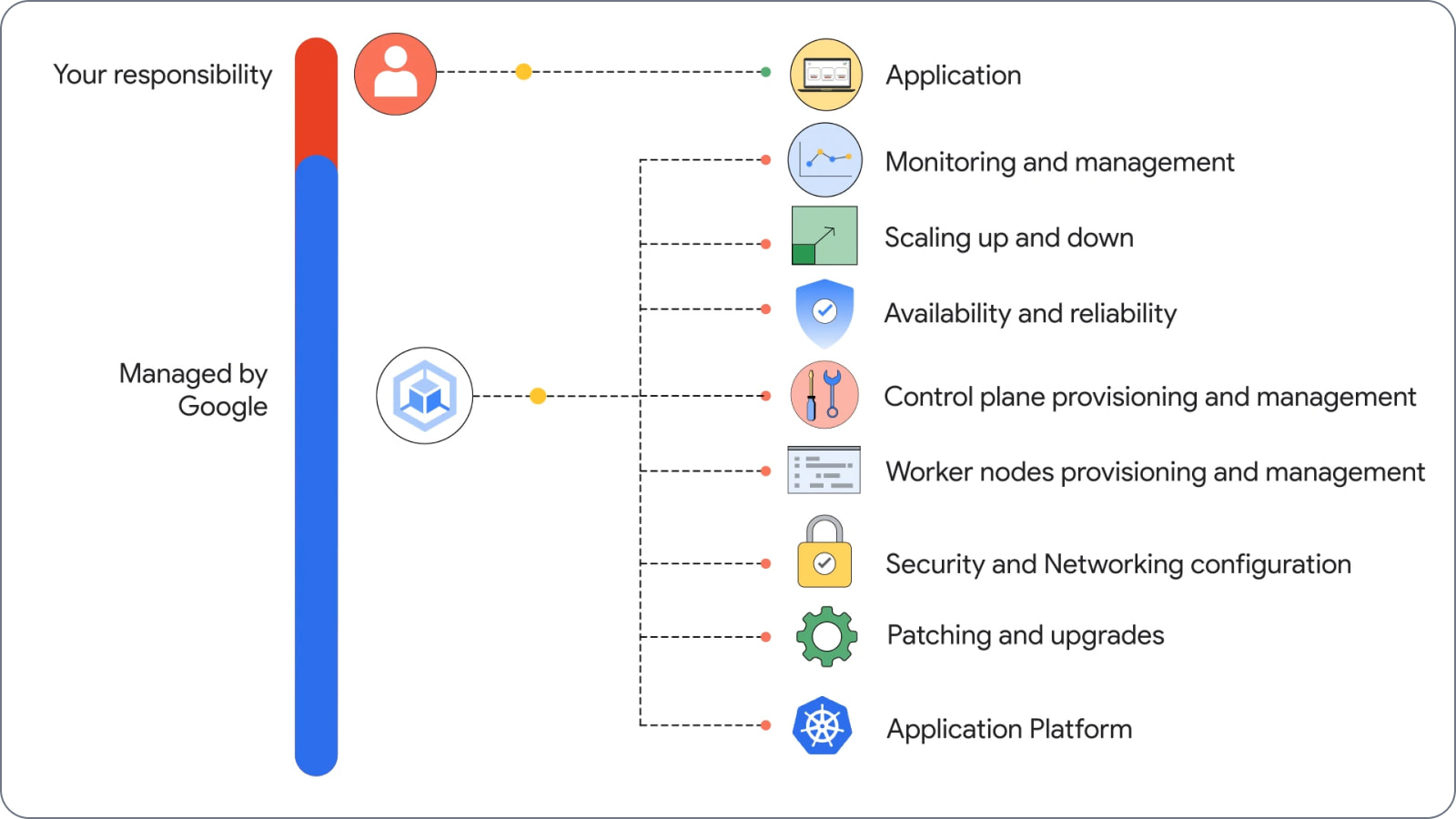

Esistono due tipi principali di piattaforme di orchestrazione dei container: autogestite e gestite.

- Orchestratori di container autogestiti: queste piattaforme, in genere create da zero o sfruttando una piattaforma open source come Kubernetes, offrono il controllo completo della personalizzazione. Tuttavia, richiedono anche di farsi carico della gestione e della manutenzione della piattaforma, incluse attività come l'installazione, la configurazione, gli aggiornamenti e l'applicazione di patch di sicurezza.

- Servizi Kubernetes gestiti: piattaforme come Google Kubernetes Engine (GKE) gestiscono la complessità della configurazione e del funzionamento dell'infrastruttura del cluster sottostante, consentendoti di concentrarti sul deployment e sulla gestione delle tue applicazioni. Il provider cloud è responsabile della gestione dell'installazione e delle operazioni. Di conseguenza, puoi semplicemente utilizzare le funzionalità e concentrarti sull'esecuzione delle tue applicazioni containerizzate.

Sebbene Kubernetes fornisca l'orchestrazione di base, una serie di strumenti per cluster lavorano in concerto per contribuire alla sua sicurezza, semplificare la gestione e consentire la scalabilità. Di seguito è riportato un elenco di strumenti correlati:

- Soluzioni di monitoraggio e logging: strumenti come la suite operativa di Google Cloud (Cloud Monitoring e Cloud Logging) sono essenziali per osservare l'integrità e le prestazioni del cluster e delle applicazioni in esecuzione sopra.

- Strumenti CI/CD: sistemi come Cloud Build si integrano con Kubernetes per automatizzare il processo di creazione di immagini container e il loro deployment nel cluster.

Funzionamento dell'orchestrazione dei container

Gli strumenti di orchestrazione dei container come Google Kubernetes Engine (GKE) semplificano l'esecuzione del deployment e di applicazioni e microservizi containerizzati. Gli orchestratori di container in genere applicano le proprie metodologie e offrono funzionalità diverse, ma consentono a tutte alle organizzazioni di coordinare, gestire e monitorare automaticamente le applicazioni containerizzate.

Sebbene il risultato finale sia lo stesso, ovvero un'applicazione containerizzata gestita in esecuzione, i passaggi e il livello di impegno richiesto differiscono in modo significativo tra Kubernetes e GKE.

Funzioni chiave dell'orchestrazione di Kubernetes

Kubernetes automatizza diverse funzioni critiche che altrimenti richiederebbero un notevole sforzo manuale. Queste funzionalità di base sono ciò che la rende una piattaforma di orchestrazione così potente.

- Deployment: Kubernetes ti aiuta a descrivere lo stato desiderato per l'applicazione di cui hai eseguito il deployment. Il motore di orchestrazione gestisce quindi il rollout delle modifiche, come l'aggiornamento di un'applicazione a una nuova versione, in modo controllato, spesso senza tempi di inattività.

- Scalabilità: in base all'utilizzo della CPU o ad altre metriche personalizzate, Kubernetes può scalare automaticamente il numero di container in esecuzione verso l'alto o verso il basso. Ciò contribuisce a garantire che l'applicazione disponga delle risorse necessarie per gestire il carico, ottimizzando al contempo i costi.

- Autoriparazione: se un container o un nodo non funziona, l'orchestrazione di Kubernetes può rilevare automaticamente l'errore. Quindi riavvierà, sostituirà o riprogrammerà i container sui nodi integri per garantire che l'applicazione rimanga disponibile senza intervento manuale.

- Service Discovery e bilanciamento del carico: Kubernetes può esporre automaticamente un container a internet o ad altri container nel cluster utilizzando un nome DNS stabile. Può anche bilanciare il carico del traffico tra più container che forniscono lo stesso servizio, per garantire che le richieste vengano distribuite in modo efficiente.

- Gestione della configurazione: Kubernetes consente di archiviare e gestire informazioni sensibili, come password e chiavi API, come "secret". Gestisce anche i dati di configurazione dell'applicazione come "ConfigMap", in modo da poter aggiornare le configurazioni senza dover ricompilare le immagini dei container.

Vantaggi dell'orchestrazione dei container Kubernetes

Uno dei maggiori vantaggi dell'orchestrazione dei container è che semplifica le operazioni. L'automazione delle attività non solo aiuta a ridurre al minimo lo sforzo e la complessità della gestione delle app containerizzate, ma offre anche molti altri vantaggi.

Sviluppo di applicazioni affidabili

Sviluppo di applicazioni affidabili

Gli strumenti di orchestrazione dei container aiutano a rendere lo sviluppo di app più rapido e ripetibile. Ciò aumenta la velocità di deployment e permette di supportare approcci di sviluppo agili come DevOps.

Scalabilità

Scalabilità

L'orchestrazione dei container consente di fare lo scale up o lo scale down dei deployment dei container in base ai cambiamenti dei requisiti dei carichi di lavoro. Puoi anche gestire la scalabilità del cloud se scegli un'offerta gestita, oltre a scala on demand l'infrastruttura sottostante.

Riduci i costi

Riduci i costi

I container richiedono meno risorse delle macchine virtuali e permettono di ridurre i costi di infrastruttura e generali. Inoltre, le piattaforme di orchestrazione dei container richiedono meno tempo e capitale umano, con conseguente ulteriore risparmio sui costi.

Sicurezza ottimizzata

Sicurezza ottimizzata

L'orchestrazione dei container consente di gestire i criteri di sicurezza su più piattaforme e contribuisce a ridurre gli errori umani che possono portare a vulnerabilità. Inoltre, i container isolano i processi delle applicazioni, diminuendo le superfici di attacco e migliorando la sicurezza generale.

Alta disponibilità

Alta disponibilità

È più facile rilevare e risolvere i guasti dell'infrastruttura utilizzando strumenti di orchestrazione dei container. In caso di errore di un container, uno strumento di orchestrazione può riavviarlo o sostituirlo automaticamente, contribuendo a mantenere la disponibilità e aumentare l'uptime delle applicazioni.

Aumenta la produttività

Aumenta la produttività

L'orchestrazione dei container aumenta la produttività degli sviluppatori in quanto contribuisce a ridurre le attività ripetitive e a eliminare il carico di installazione, gestione e manutenzione dei container.

Esempi e casi d'uso dell'orchestrazione dei container

Immagina di avere 50 container che devi aggiornare. Potresti fare tutto manualmente, ma quanto tempo e impegno dovrebbe dedicare il tuo team per portare a termine questa attività? Con l'orchestrazione dei container, puoi scrivere un file di configurazione e lo strumento di orchestrazione dei container farà tutto per te. Questo è solo un esempio di come l'orchestrazione dei container può aiutare a ridurre i carichi di lavoro operativi.

Ora, considera quanto tempo ci vorrà per il deployment, la scalabilità e la protezione degli stessi container se tutto venisse sviluppato utilizzando sistemi operativi e linguaggi diversi. E se dovessi spostarli in ambienti diversi? Un approccio dichiarativo può semplificare numerose attività ripetitive e prevedibili necessarie per garantire il corretto funzionamento dei container, ad esempio la configurazione dell'allocazione delle risorse, della gestione delle repliche e del networking. Di seguito sono riportati alcuni casi d'uso comuni dell'orchestrazione dei container:

- Automatizzazione dei deployment: invece di eseguire manualmente il deployment di ogni container, gli strumenti di orchestrazione automatizzano il processo, garantendo deployment coerenti e ripetibili.

- Scalabilità delle applicazioni: quando il traffico aumenta, gli strumenti di orchestrazione scalano automaticamente il numero di container per gestire il carico maggiore, garantendo la disponibilità dell'applicazione.

- Gestione degli aggiornamenti delle applicazioni: gli strumenti di orchestrazione facilitano gli aggiornamenti in sequenza, consentendoti di eseguire il deployment di nuove versioni della tua applicazione senza tempi di inattività.

- Garantire l'alta disponibilità: se un container non funziona, gli strumenti di orchestrazione rilevano automaticamente l'errore e riavviano o sostituiscono il container, garantendo la resilienza dell'applicazione.

- Ottimizzazione dell'utilizzo delle risorse: gli strumenti di orchestrazione impacchettano in modo efficiente i container sulle risorse disponibili, massimizzando l'utilizzo e riducendo al minimo i costi.

Fai il prossimo passo

Inizia a creare su Google Cloud con 300 $ di crediti gratuiti e oltre 20 prodotti Always Free.

Hai bisogno di aiuto per iniziare?

Contatta il team di venditaCollabora con un partner di fiducia

Trova un partnerContinua la navigazione

Visualizza tutti i prodotti