Che cos'è un cluster Kubernetes (K8s)?

Per gli sviluppatori aziendali che creano applicazioni moderne e ne eseguono il deployment, la gestione dei workload containerizzati su larga scala può rappresentare una sfida comune. Kubernetes, spesso abbreviato in K8s, è diventato lo standard per l'orchestrazione dei container. Alla base di questo potente sistema open source c'è il cluster Kubernetes, un ambiente solido progettato per automatizzare il deployment, la scalabilità e la gestione delle applicazioni containerizzate.

Definizione dei cluster Kubernetes

Un cluster Kubernetes è un insieme di nodi o macchine raggruppati per eseguire applicazioni containerizzate. Fornisce un ambiente informatico unificato e astratto, che consente di eseguire il deployment e gestire i servizi senza dover interagire direttamente con i singoli server.

Il ruolo principale di un cluster K8s è l'orchestrazione dei container: automatizza le attività complesse coinvolte nel mantenimento della disponibilità delle applicazioni, nella scalabilità delle risorse in base alla domanda e nell'implementazione di aggiornamenti senza tempo di inattività.

Gestendo l'intero ciclo di vita dei container, i cluster Kubernetes forniscono la piattaforma di base di cui le applicazioni aziendali hanno bisogno per essere scalabili e agili.

Nodi

Un nodo è una macchina worker all'interno di un cluster Kubernetes, che può essere una macchina virtuale (VM) di un cloud provider o un server fisico in un data center. Ogni nodo fornisce le risorse di CPU, memoria e networking necessarie per eseguire i container. Un cluster K8s è composto da un control plane e da uno o più nodi worker, che insieme forniscono la capacità di calcolo del cluster.

Pod

Nel modello a oggetti di Kubernetes, l'unità di cui è possibile eseguire il deployment più piccola e fondamentale è un pod. Rappresenta una singola istanza di un processo attivo all'interno di un cluster e incapsula uno o più container con alto accoppiamento, risorse di spazio di archiviazione condiviso e un indirizzo IP di rete univoco. Sebbene un pod possa includere più container, il pattern più comune è che un pod ospiti un singolo container, creando una mappatura 1:1 tra il pod e l'applicazione containerizzata.

Container

I container sono pacchetti software leggeri, autonomi ed eseguibili che includono tutto il necessario per eseguire un'applicazione: codice, runtime, strumenti di sistema, librerie di sistema e impostazioni. Questo incapsulamento aiuta a garantire che l'applicazione venga eseguita in modo rapido e affidabile da un ambiente informatico all'altro. Poiché sono portabili ed efficienti, i container sono i componenti di base ideali per le applicazioni moderne basate su microservizi.

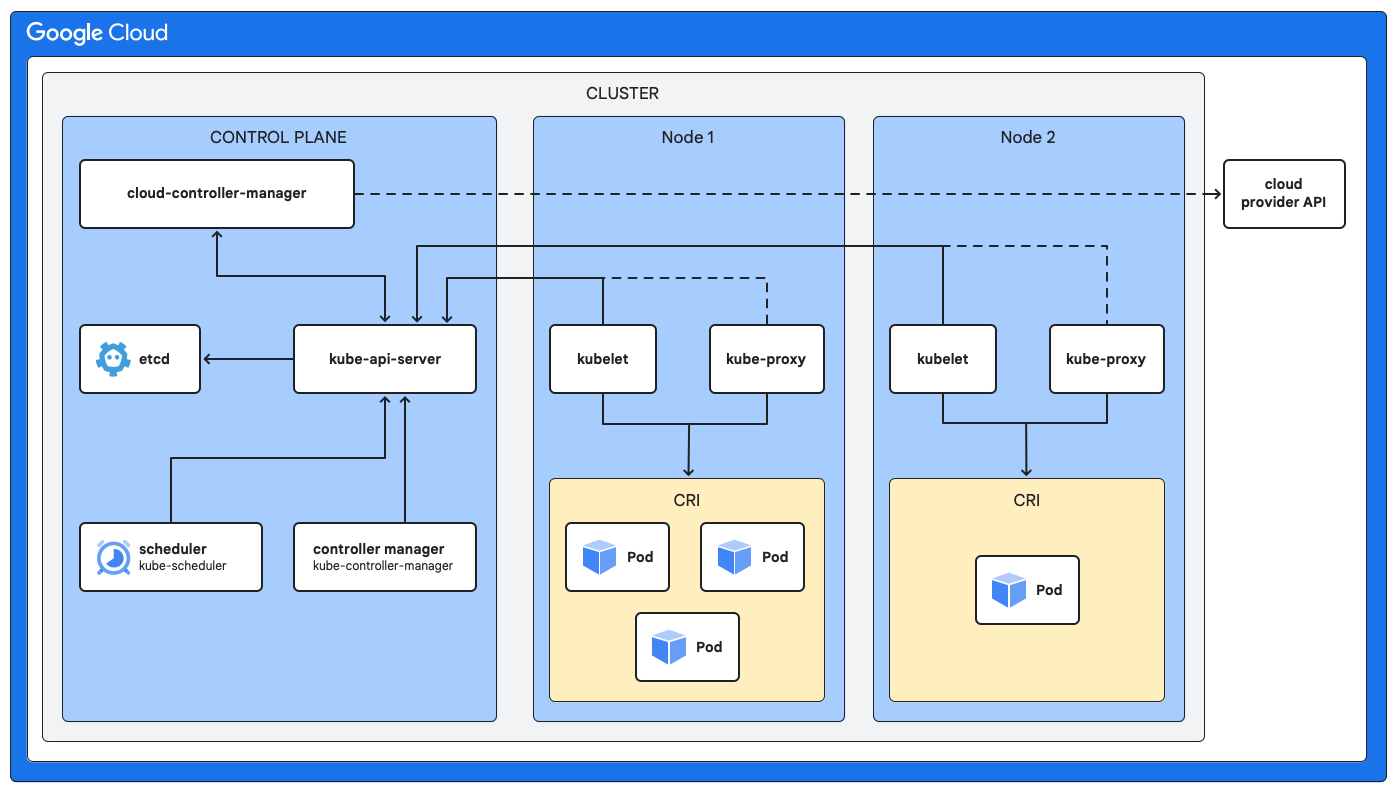

Architettura del cluster K8s

L'architettura di un cluster Kubernetes è costituita da 2 tipi principali di componenti che possono aiutare a creare un sistema a tolleranza di errore per l'esecuzione delle applicazioni.

- Control plane: funge da cervello per gestire i cluster.

- Nodi worker: fungono da braccio fornendo l'ambiente di runtime.

Control plane (nodi master)

Il control plane è responsabile del mantenimento dello stato desiderato dell'intero cluster. Prende decisioni globali sulla pianificazione, risponde agli eventi del cluster e gestisce il ciclo di vita di tutti gli oggetti Kubernetes. I componenti chiave del control plane includono quanto segue.

- Archivio di backup (etcd): un archivio di coppia chiave-valore coerente e a elevata affidabilità utilizzato come archivio di backup di Kubernetes per tutti i dati del cluster.

- Server API (kube-apiserver): funge da front-end del control plane, esponendo l'API Kubernetes. Gestisce e convalida le richieste REST, quindi aggiorna lo stato degli oggetti pertinenti all'interno di etcd.

- Scheduler (kube-scheduler): lo scheduler monitora i pod appena creati a cui non è stato assegnato un nodo e seleziona un nodo su cui eseguirli in base alla disponibilità delle risorse, alle policy e alle specifiche di affinità.

- [Facoltativo] Gestore dei controller (kube-controller-manager): questo componente esegue vari processi di controller che regolano lo stato del cluster. Ad esempio, esistono controller per gestire gli errori dei nodi, mantenere il numero corretto di pod per un deployment e gestire gli endpoint del servizio.

Nodi worker (nodi di computing)

I nodi worker sono le macchine in cui vengono effettivamente eseguite le applicazioni containerizzate. Ogni nodo è gestito dal control plane e contiene i servizi necessari per eseguire i pod. I componenti principali di ogni nodo worker includono quanto segue.

- Kubelet: un agente che viene eseguito su ogni nodo del cluster, il kubelet comunica con il control plane e garantisce che i container descritti nelle specifiche del pod siano in esecuzione e integri.

- [Facoltativo] Kube-proxy: questo proxy di rete viene eseguito su ogni nodo ed è responsabile della gestione delle regole di rete sui nodi. Queste regole di rete consentono la comunicazione di rete ai tuoi pod da sessioni di rete all'interno o all'esterno del tuo cluster.

- Runtime container: questo software gestisce l'esecuzione dei container e supporta vari runtime (containerd è un'opzione molto diffusa).

Utilizzo dei cluster in K8s

I cluster Kubernetes possono essere altamente versatili e affrontare molte delle sfide che i team di sviluppo e operazioni aziendali devono affrontare.

Containerizzazione delle applicazioni esistenti

Containerizzazione delle applicazioni esistenti

Sposta le applicazioni legacy nei container per migliorarne la portabilità, la scalabilità e l'utilizzo delle risorse senza un ampio refactoring.

Creazione di nuove applicazioni cloud-native

Creazione di nuove applicazioni cloud-native

Utilizza un cluster K8s come base per le architetture basate su microservizi, consentendo lo sviluppo, il deployment e la scalabilità indipendenti dei servizi.

DevOps e CI/CD

DevOps e CI/CD

Automatizza la pipeline di creazione, test e deployment integrandola con un cluster Kubernetes, accelerando i cicli di release e migliorando l'affidabilità.

Scalabilità e resilienza

Scalabilità e resilienza

Gestisci carichi di traffico variabili scalando automaticamente le applicazioni verso l'alto o verso il basso e abilita l'autoriparazione riavviando o sostituendo automaticamente i container non idonei.

Uso efficiente delle risorse

Uso efficiente delle risorse

Migliora l'utilizzo dell'infrastruttura impacchettando i container con maggior densità su meno nodi, il che può portare a un notevole risparmio sui costi.

Gestione dei cluster Kubernetes

Sebbene Kubernetes sia incredibilmente potente, la configurazione e la gestione di un cluster K8s sicuro e di livello di produzione comporta un significativo overhead operativo. È qui che un servizio gestito come Google Kubernetes Engine (GKE) può fornire un valore immenso ai team aziendali. GKE può aiutarti a semplificare la gestione dei cluster Kubernetes automatizzando molte delle attività complesse e dispendiose in termini di tempo.

GKE può fornire un control plane completamente gestito, occupandosi della sua disponibilità, delle patch e degli aggiornamenti, in modo che il tuo team non debba farlo. Offre funzionalità come la modalità Autopilot, che automatizza l'intera gestione operativa del cluster, inclusi nodi e scalabilità, per ridurre ulteriormente l'overhead e ottimizzare l'utilizzo delle risorse. Con GKE, gli sviluppatori possono concentrarsi sulla scrittura del codice e sulla creazione di applicazioni, mentre la piattaforma gestisce l'architettura e l'infrastruttura del cluster Kubernetes sottostante, garantendone la sicurezza, l'affidabilità e la scalabilità.

Risorse di apprendimento sui cluster Kubernetes

- Scopri di più su Kubernetes con GKE esplorando il corso Google Skills.

- Leggi la documentazione ufficiale per eseguire il deployment di un cluster e di un workload.

- Segui la documentazione per eseguire il deployment di un'app containerizzata in un cluster GKE.