Qu'est-ce qu'un cluster Kubernetes (K8s) ?

Pour les développeurs d'entreprise qui créent et déploient des applications modernes, la gestion des charges de travail conteneurisées à grande échelle peut représenter un défi courant. Kubernetes, souvent abrégé en K8s, est devenu la norme pour l'orchestration de conteneurs. Au cœur de ce puissant système Open Source se trouve le cluster Kubernetes, un environnement robuste conçu pour automatiser le déploiement, le scaling et la gestion des applications conteneurisées.

Définition des clusters Kubernetes

Un cluster Kubernetes est un ensemble de nœuds, ou machines, regroupés pour exécuter des applications conteneurisées. Il fournit un environnement de calcul unifié et abstrait, qui vous permet de déployer et de gérer vos services sans avoir à interagir directement avec des serveurs individuels.

Le rôle principal d'un cluster Kubernetes est l'orchestration de conteneurs : il automatise les tâches complexes nécessaires pour maintenir la disponibilité des applications, faire évoluer les ressources en fonction de la demande et déployer les mises à jour sans temps d'arrêt.

En gérant l'intégralité du cycle de vie des conteneurs, les clusters Kubernetes fournissent la plate-forme de base dont les applications d'entreprise ont besoin pour être évolutives et agiles.

Nœuds

Un nœud est une machine de nœud de calcul dans un cluster Kubernetes. Il peut s'agir d'une machine virtuelle (VM) d'un fournisseur de services cloud ou d'un serveur physique dans un centre de données. Chaque nœud fournit les ressources de processeur, de mémoire et de mise en réseau nécessaires pour exécuter les conteneurs. Un cluster K8s est composé d'un plan de contrôle et d'un ou plusieurs nœuds de calcul, qui fournissent collectivement la capacité de calcul du cluster.

Pods

Dans le modèle d'objet Kubernetes, l'unité déployable la plus petite et la plus fondamentale est un pod. Il représente une instance unique d'un processus actif dans un cluster et encapsule un ou plusieurs conteneurs étroitement couplés, des ressources de stockage partagées et une adresse IP réseau unique. Bien qu'un pod puisse contenir plusieurs conteneurs, le modèle le plus courant consiste à ce qu'un pod héberge un seul conteneur, ce qui crée un mappage un-à-un entre le pod et l'application conteneurisée.

Conteneurs

Les conteneurs sont des packages logiciels exécutables, autonomes et légers qui incluent tous les éléments nécessaires à l'exécution d'une application : du code, un environnement d'exécution, des outils système, des bibliothèques système et des paramètres. Cette encapsulation permet de garantir que l'application s'exécute rapidement et de manière fiable dans divers environnements informatiques. Grâce à leur portabilité et à leur efficacité, les conteneurs sont les blocs de construction idéaux pour les applications modernes basées sur des microservices.

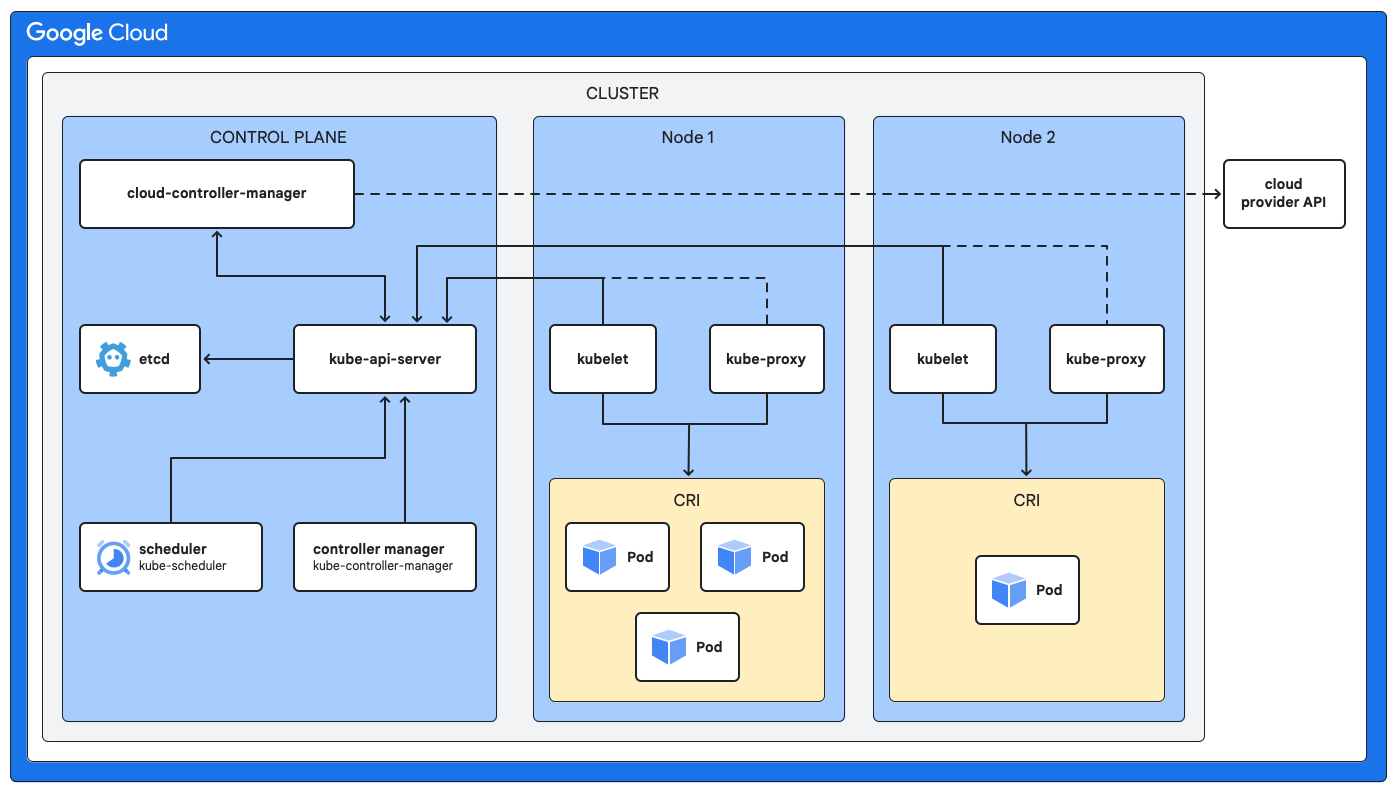

Architecture d'un cluster Kubernetes

L'architecture d'un cluster Kubernetes se compose de deux principaux types de composants qui peuvent aider à créer un système tolérant aux pannes pour exécuter des applications.

- Plan de contrôle : il sert de cerveau pour gérer les clusters.

- Nœuds de calcul : ils fournissent l'environnement d'exécution.

Plan de contrôle (nœuds maîtres)

Le plan de contrôle est chargé de maintenir l'état souhaité de l'ensemble du cluster. Il prend des décisions globales concernant la programmation, répond aux événements de cluster et gère le cycle de vie de tous les objets Kubernetes. Voici les principaux composants du plan de contrôle :

- Magasin de stockage (etcd) : magasin de paires clé/valeur cohérent et à haute disponibilité utilisé comme magasin de stockage de secours de Kubernetes pour toutes les données de cluster.

- Serveur d'API (kube-apiserver) : sert de front-end au plan de contrôle et expose l'API Kubernetes. Il gère et valide les requêtes REST, puis met à jour l'état des objets concernés dans etcd.

- Scheduler (kube-scheduler) : le programmateur surveille les pods nouvellement créés auxquels aucun nœud n'a été attribué. Il sélectionne un nœud sur lequel les exécuter en fonction de la disponibilité des ressources, des règles et des spécifications d'affinité.

- Gestionnaire de contrôleurs (kube-controller-manager) [facultatif] : ce composant exécute divers processus de contrôleur qui régulent l'état du cluster. Par exemple, les contrôleurs gèrent les défaillances de nœuds, maintiennent le nombre correct de pods pour un déploiement et gèrent les points de terminaison de service.

Nœuds de calcul

Les nœuds de calcul sont les machines sur lesquelles vos applications conteneurisées s'exécutent réellement. Chaque nœud est géré par le plan de contrôle et contient les services nécessaires à l'exécution des pods. Les composants de base de chaque nœud de calcul sont les suivants :

- kubelet : agent qui s'exécute sur chaque nœud du cluster. Le kubelet communique avec le plan de contrôle et s'assure que les conteneurs décrits dans les spécifications des pods sont en cours d'exécution et en bon état.

- kube-proxy [facultatif] : ce proxy réseau s'exécute sur chaque nœud et est chargé de gérer les règles réseau sur les nœuds. Ces règles réseau autorisent la communication réseau avec vos pods à partir de sessions réseau à l'intérieur ou à l'extérieur de votre cluster.

- Environnement d'exécution de conteneurs : ce logiciel gère l'exécution des conteneurs et prend en charge différents environnements d'exécution, dont containerd, qui est une option populaire.

Utiliser des clusters dans K8s

Les clusters Kubernetes peuvent être très polyvalents et répondre à de nombreux défis auxquels sont confrontées les équipes de développement et d'exploitation des entreprises.

Conteneuriser les applications existantes

Conteneuriser les applications existantes

Déplacez les applications existantes dans des conteneurs pour améliorer leur portabilité, leur évolutivité et leur utilisation des ressources sans refactorisation importante.

Créer des applications cloud natives

Créer des applications cloud natives

Utilisez un cluster K8s comme base pour les architectures basées sur des microservices, ce qui permet de développer, de déployer et de faire évoluer les services de manière indépendante.

DevOps et CI/CD

DevOps et CI/CD

Automatisez le pipeline de compilation, de test et de déploiement en l'intégrant à un cluster Kubernetes, ce qui accélère les cycles de publication et améliore la fiabilité.

Évolutivité et résilience

Évolutivité et résilience

Gérez les charges de trafic variables en effectuant automatiquement un scaling à la hausse ou à la baisse des applications, et activez l'autoréparation en redémarrant ou en remplaçant automatiquement les conteneurs en échec.

Consommation efficace des ressources

Consommation efficace des ressources

Améliorez l'utilisation de l'infrastructure en regroupant les conteneurs de façon plus dense sur moins de nœuds, ce qui peut entraîner des économies considérables.

Gestion des clusters Kubernetes

Bien que Kubernetes soit incroyablement puissant, la configuration et l'exploitation d'un cluster K8s sécurisé et de niveau production impliquent des frais généraux opérationnels importants. C'est là qu'un service géré comme Google Kubernetes Engine (GKE) peut apporter une immense valeur ajoutée aux équipes d'entreprise. GKE peut vous aider à simplifier la gestion des clusters Kubernetes en automatisant de nombreuses tâches complexes et chronophages.

GKE peut fournir un plan de contrôle entièrement géré, qui gère sa disponibilité, l'application de correctifs et les mises à jour, ce qui vous évite de le faire. Il offre des fonctionnalités telles que le mode Autopilot, qui automatise l'ensemble de la gestion opérationnelle du cluster, y compris les nœuds et le scaling, afin de réduire davantage les frais généraux et d'optimiser l'utilisation des ressources. Avec GKE, les développeurs peuvent se concentrer sur l'écriture de code et la création d'applications, tandis que la plate-forme gère l'architecture et l'infrastructure du cluster Kubernetes sous-jacent, en veillant à ce qu'elles soient sécurisées, fiables et évolutives.

Ressources d'apprentissage sur les clusters Kubernetes

- Pour en savoir plus sur Kubernetes avec GKE, suivez le cours Google Skills.

- Lisez la documentation officielle pour déployer un cluster et une charge de travail.

- Suivez la documentation pour déployer une application en conteneur sur un cluster GKE.