Was ist ein Kubernetes-Cluster?

Für Entwickler in Unternehmen, die moderne Anwendungen erstellen und bereitstellen, kann die Verwaltung von Containerarbeitslasten in großem Umfang eine häufige Herausforderung darstellen. Kubernetes, oft als K8s abgekürzt, hat sich als Standard für die Container-Orchestrierung etabliert. Das Herzstück dieses leistungsstarken Open-Source-Systems ist der Kubernetes-Cluster, eine robuste Umgebung, die für die Automatisierung der Bereitstellung, Skalierung und Verwaltung von Containeranwendungen konzipiert ist.

Definition von Kubernetes-Clustern

Ein Kubernetes-Cluster ist eine Gruppe von Knoten oder Maschinen, die zusammen containerisierte Anwendungen ausführen. Sie bietet eine einheitliche und abstrahierte Rechenumgebung, in der Sie Ihre Dienste bereitstellen und verwalten können, ohne direkt mit einzelnen Servern interagieren zu müssen.

Die Hauptaufgabe eines K8s-Clusters ist die Containerorchestrierung: Er automatisiert die komplexen Aufgaben, die mit der Aufrechterhaltung der Anwendungsverfügbarkeit, der bedarfsgerechten Skalierung von Ressourcen und der Bereitstellung von Updates ohne Ausfallzeiten verbunden sind.

Durch die Verwaltung des gesamten Lebenszyklus von Containern bieten Kubernetes-Cluster die grundlegende Plattform, die Unternehmensanwendungen benötigen, um skalierbar und agil zu sein.

Knoten

Ein Knoten ist eine Worker-Maschine in einem Kubernetes-Cluster. Dabei kann es sich um eine virtuelle Maschine (VM) eines Cloud-Anbieters oder einen physischen Server in einem Rechenzentrum handeln. Jeder Knoten stellt die erforderlichen CPU-, Arbeitsspeicher- und Netzwerkressourcen zum Ausführen von Containern bereit. Ein K8s-Cluster besteht aus einer Steuerungsebene und einem oder mehreren Worker-Knoten, die zusammen die Rechenkapazität des Clusters bereitstellen.

Pods

Im Kubernetes-Objektmodell ist der Pod die kleinste und grundlegendste bereitstellbare Einheit. Sie stellt eine einzelne Instanz eines aktiven Prozesses innerhalb eines Clusters dar und umfasst einen oder mehrere eng gekoppelte Container, gemeinsam genutzte Speicherressourcen und eine eindeutige Netzwerk-IP-Adresse. Ein Pod kann zwar mehrere Container enthalten, aber das häufigste Muster ist, dass ein Pod einen einzelnen Container enthält, wodurch eine 1:1-Zuordnung zwischen dem Pod und der containerisierten Anwendung entsteht.

Container

Container sind schlanke, eigenständige und ausführbare Softwarepakete, die alles enthalten, was zum Ausführen einer Anwendung erforderlich ist: Code, Laufzeit, Systemtools, Systembibliotheken und Einstellungen. Diese Kapselung trägt dazu bei, dass die Anwendung schnell und zuverlässig von einer Computing-Umgebung in der nächsten ausgeführt werden kann. Da sie portierbar und effizient sind, eignen sich Container ideal als Bausteine für moderne, auf Mikrodiensten basierende Anwendungen.

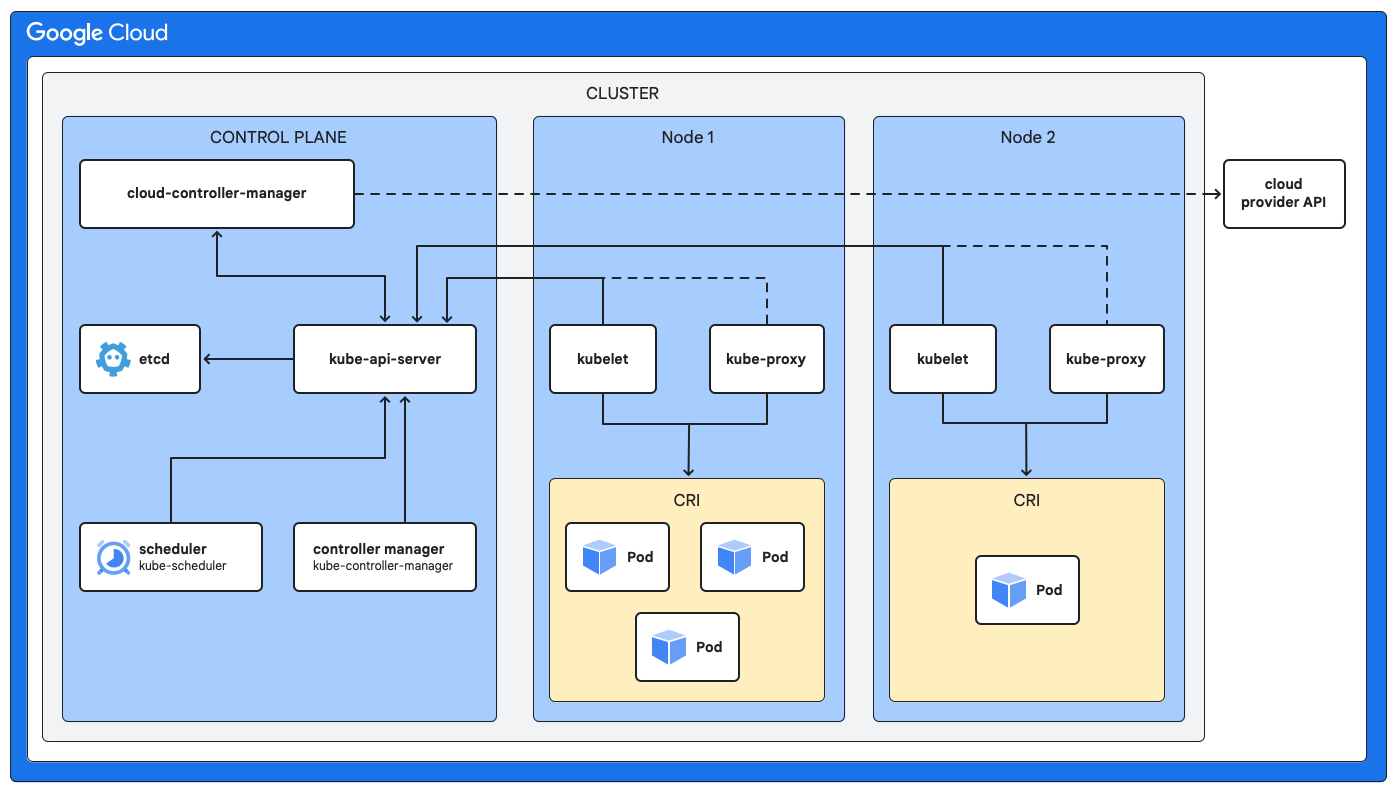

K8s-Clusterarchitektur

Eine Kubernetes-Clusterarchitektur besteht aus zwei Haupttypen von Komponenten, die dazu beitragen können, ein fehlertolerantes System zum Ausführen von Anwendungen zu schaffen.

- Steuerungsebene: Sie fungiert als Gehirn zur Verwaltung der Cluster.

- Worker-Knoten: Sie stellen die Laufzeitumgebung bereit.

Steuerungsebene (Masterknoten)

Die Steuerungsebene ist für die Aufrechterhaltung des gewünschten Zustands des gesamten Clusters verantwortlich. Es trifft globale Entscheidungen zur Planung, reagiert auf Clusterereignisse und verwaltet den Lebenszyklus aller Kubernetes-Objekte. Zu den wichtigsten Komponenten der Steuerungsebene gehören:

- Sicherungsspeicher (etcd): Ein konsistenter und hochverfügbarer Schlüssel/Wert-Speicher, der als Sicherungsspeicher von Kubernetes für alle Clusterdaten verwendet wird.

- API-Server (kube-apiserver): Dient als Frontend der Steuerungsebene und stellt die Kubernetes API bereit. Es verwaltet und validiert REST-Anfragen und aktualisiert anschließend den Status relevanter Objekte in etcd.

- Scheduler (kube-scheduler): Der Scheduler überwacht neu erstellte Pods, denen kein Knoten zugewiesen ist, und wählt einen Knoten für sie aus, auf dem sie ausgeführt werden sollen. Die Auswahl basiert auf Ressourcenverfügbarkeit, Richtlinien und Affinitätsspezifikationen.

- Controller-Manager (kube-controller-manager) [optional]: Diese Komponente führt verschiedene Controllerprozesse aus, die den Zustand des Clusters regeln. Es gibt beispielsweise Controller, die Knotenausfälle beheben, die richtige Anzahl von Pods für ein Deployment aufrechterhalten und Dienstendpunkte verwalten.

Worker-Knoten (Rechenknoten)

Worker-Knoten sind die Maschinen, auf denen Ihre containerisierten Anwendungen tatsächlich ausgeführt werden. Jeder Knoten wird von der Steuerungsebene verwaltet und enthält die Dienste, die zum Ausführen von Pods erforderlich sind. Zu den Kernkomponenten auf jedem Worker-Knoten gehören:

- Kubelet: Ein Agent, der auf jedem Knoten im Cluster ausgeführt wird. Kubelet kommuniziert mit der Steuerungsebene und sorgt dafür, dass die in den Pod-Spezifikationen beschriebenen Container ausgeführt werden und fehlerfrei funktionieren.

- kube-proxy [optional]: Dieser Netzwerk-Proxy wird auf jedem Knoten ausgeführt und ist für die Verwaltung der Netzwerkregeln auf den Knoten verantwortlich. Diese Netzwerkregeln ermöglichen die Netzwerkkommunikation mit Ihren Pods über Netzwerksitzungen innerhalb oder außerhalb Ihres Clusters.

- Containerlaufzeit: Diese Software verwaltet die Ausführung von Containern und unterstützt verschiedene Laufzeiten. Eine beliebte Option ist containerd.

Cluster in Kubernetes verwenden

Kubernetes-Cluster sind äußerst vielseitig und können viele Herausforderungen bewältigen, vor denen Entwicklungs- und Betriebsteams in Unternehmen stehen.

Vorhandene Anwendungen containerisieren

Vorhandene Anwendungen containerisieren

Sie können Legacy-Anwendungen in Container verschieben, um ihre Übertragbarkeit, Skalierbarkeit und Ressourcennutzung ohne umfangreiches Refactoring zu verbessern.

Neue cloudnative Anwendungen entwickeln

Neue cloudnative Anwendungen entwickeln

Verwenden Sie einen K8s-Cluster als Grundlage für auf Mikrodiensten basierende Architekturen, um die unabhängige Entwicklung, Bereitstellung und Skalierung von Diensten zu ermöglichen.

DevOps und CI/CD

DevOps und CI/CD

Automatisieren Sie die Build-, Test- und Bereitstellungspipeline, indem Sie sie in einen Kubernetes-Cluster einbinden. So beschleunigen Sie Release-Zyklen und verbessern die Zuverlässigkeit.

Skalierbarkeit und Ausfallsicherheit

Skalierbarkeit und Ausfallsicherheit

Variable Traffic-Lasten bewältigen, indem Anwendungen automatisch hoch- oder herunterskaliert werden, und Self-Healing ermöglichen, indem ausgefallene Container automatisch neu gestartet oder ersetzt werden.

Ressourceneffizienz

Ressourceneffizienz

Sie können die Infrastrukturnutzung verbessern, indem Sie Container dichter auf weniger Knoten packen, was zu erheblichen Kosteneinsparungen führen kann.

Kubernetes-Clusterverwaltung

Kubernetes ist zwar unglaublich leistungsstark, aber das Einrichten und Betreiben eines sicheren, produktionsreifen K8s-Clusters ist mit einem erheblichen Betriebsaufwand verbunden. Hier kann ein verwalteter Dienst wie die Google Kubernetes Engine (GKE) für Unternehmensteams von großem Nutzen sein. GKE kann die Kubernetes-Clusterverwaltung vereinfachen, indem viele komplexe und zeitaufwendige Aufgaben automatisiert werden.

GKE kann eine vollständig verwaltete Steuerungsebene bereitstellen, die für Verfügbarkeit, Patches und Updates sorgt, sodass sich Ihr Team nicht darum kümmern muss. Er bietet Funktionen wie den Autopilot-Modus, der die gesamte Betriebsverwaltung des Clusters automatisiert, einschließlich Knoten und Skalierung, um den Aufwand weiter zu reduzieren und die Ressourcennutzung zu optimieren. Mit der GKE können sich Entwickler auf das Schreiben von Code und das Erstellen von Anwendungen konzentrieren, während die Plattform die zugrunde liegende Kubernetes-Clusterarchitektur und -Infrastruktur verwaltet und dafür sorgt, dass sie sicher, zuverlässig und skalierbar ist.

Lernressourcen zu Kubernetes-Clustern

- Im Google Skills-Kurs erfahren Sie mehr über Kubernetes mit GKE.

- Lesen Sie die offizielle Dokumentation zum Bereitstellen eines Clusters und einer Arbeitslast.

- Folgen Sie der Anleitung, um eine containerisierte Anwendung in einem GKE-Cluster bereitzustellen.