Dataproc

Apache Spark y Hadoop administrados con Google Dataproc

Ejecuta tus cargas de trabajo de Spark y de código abierto más exigentes de forma más fácil con un servicio administrado, de forma más inteligente con Gemini y de forma más rápida con Lightning Engine.

Spark es una marca comercial de The Apache Software Foundation.

Funciones

Rendimiento líder en la industria

Acelera tus trabajos de Spark más exigentes con Lightning Engine. Nuestro motor de nueva generación ofrece un rendimiento más de 4.3 veces más rápido con optimización administrada, lo que reduce el TCO y el ajuste manual. Ya está disponible en versión preliminar para Dataproc.

Desarrollo y operaciones potenciados por IA

Acelera todo tu flujo de trabajo con Gemini. Obtén asistencia potenciada por IA para escribir y depurar código de PySpark, y usa Gemini Cloud Assist para obtener análisis automatizados de la causa raíz de trabajos fallidos o de ejecución lenta, lo que reduce drásticamente el tiempo que toma solucionar de problemas.

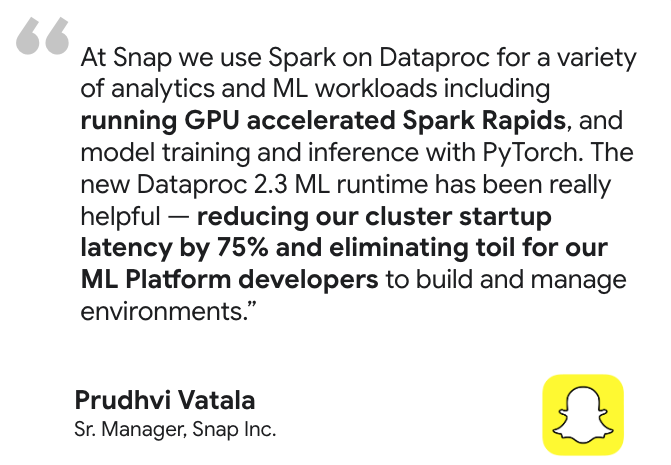

Listo para IA y AA empresarial

Crea y pon en funcionamiento todo tu ciclo de vida de aprendizaje automático. Acelera el entrenamiento de modelos y la inferencia con la compatibilidad de GPU, con la tecnología de NVIDIA RAPIDS™ y los entornos de ejecución de AA preconfigurados. Luego, intégrate en el ecosistema más amplio de IA de Google Cloud para organizar MLOps de extremo a extremo con Vertex AI Pipelines.

Integraciones potentes de lakehouses

Conéctate de forma nativa a una arquitectura de lakehouse abierta. Procesa datos directamente desde BigQuery, organiza MLOps con Vertex AI Pipelines y unifica la administración de tus datos abiertos con BigLake y Dataplex Universal Catalog.

Control y personalización inigualables

Adapta cada clúster de Dataproc a tus necesidades exactas. Desarrolla en Python, Scala o Java, elige entre una amplia variedad de tipos de máquinas, usa acciones de inicialización para instalar software personalizado y trae tus propias imágenes de contenedor para obtener la máxima portabilidad.

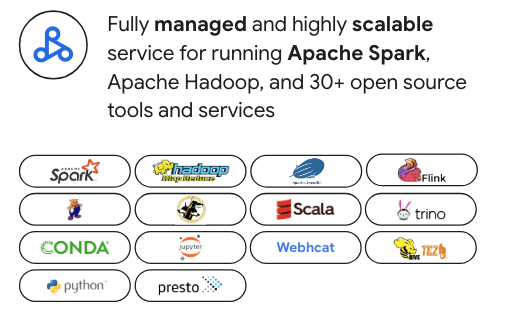

Creado para la pila de datos moderna de código abierto

Evita la dependencia de un solo proveedor. Si bien Dataproc está optimizado para Apache Spark, admite más de 30 herramientas de código abierto, como Apache Hadoop, Flink, Trino y Presto. Se integra a la perfección con organizadores populares como Airflow y se puede extender con Kubernetes y Docker para obtener la máxima flexibilidad.

Seguridad de nivel empresarial

Se integra sin problemas con tu postura de seguridad. Aprovecha IAM para acceder a permisos detallados, Controles del servicio de VPC para obtener seguridad de red y Kerberos para tener una autenticación sólida en tu clúster de Spark.

Usos comunes

Migración a la nube

Migra sin problemas cargas de trabajo locales de Apache Hadoop y Spark con la modalidad lift-and-shift. También es la ruta ideal para pasar de un entorno de Spark autoadministrado de "DIY" a un servicio completamente administrado. La compatibilidad de Dataproc con una amplia gama de versiones de Spark, incluidas las heredadas 2.x, simplifica la migración, ya que reduce la necesidad de refactorizar el código de inmediato. Esto te permite aprovechar las habilidades de código abierto existentes de tu equipo para lograr una ruta más rápida hacia la nube.

Recursos de aprendizaje

Migración a la nube

Migra sin problemas cargas de trabajo locales de Apache Hadoop y Spark con la modalidad lift-and-shift. También es la ruta ideal para pasar de un entorno de Spark autoadministrado de "DIY" a un servicio completamente administrado. La compatibilidad de Dataproc con una amplia gama de versiones de Spark, incluidas las heredadas 2.x, simplifica la migración, ya que reduce la necesidad de refactorizar el código de inmediato. Esto te permite aprovechar las habilidades de código abierto existentes de tu equipo para lograr una ruta más rápida hacia la nube.

Modernización de lakehouse

Usa Dataproc como el potente motor de procesamiento de código abierto para tu data lakehouse moderno. Procesa datos en formatos abiertos como Apache Iceberg directamente desde tu data lake, lo que elimina los silos de datos y el costoso movimiento de datos. Obtén una integración perfecta con BigQuery y Dataplex Universal Catalog para una plataforma de análisis y administración verdaderamente unificada y de múltiples motores.

Recursos de aprendizaje

Modernización de lakehouse

Usa Dataproc como el potente motor de procesamiento de código abierto para tu data lakehouse moderno. Procesa datos en formatos abiertos como Apache Iceberg directamente desde tu data lake, lo que elimina los silos de datos y el costoso movimiento de datos. Obtén una integración perfecta con BigQuery y Dataplex Universal Catalog para una plataforma de análisis y administración verdaderamente unificada y de múltiples motores.

Ingeniería de datos

Crea y organiza canalizaciones de ETL de Spark complejas y de larga duración con confiabilidad y escala de nivel empresarial. Aprovecha funciones potentes como el escalado automático para optimizar el costo y el rendimiento, y usa plantillas de flujos de trabajos para automatizar y administrar tus trabajos más importantes de nivel de producción de extremo a extremo.

Recursos de aprendizaje

Ingeniería de datos

Crea y organiza canalizaciones de ETL de Spark complejas y de larga duración con confiabilidad y escala de nivel empresarial. Aprovecha funciones potentes como el escalado automático para optimizar el costo y el rendimiento, y usa plantillas de flujos de trabajos para automatizar y administrar tus trabajos más importantes de nivel de producción de extremo a extremo.

Ciencia de datos a gran escala

Proporciona a los equipos de ciencia de datos entornos de clústeres de Spark potentes y personalizables para el entrenamiento de modelos a gran escala y la inferencia por lotes. Con los entornos de ejecución de AA preconfigurados y la compatibilidad con GPU, puedes acelerar todo el ciclo de vida del AA y realizar la integración con Vertex AI para crear y poner en funcionamiento canalizaciones de MLOps de extremo a extremo.

Recursos de aprendizaje

Ciencia de datos a gran escala

Proporciona a los equipos de ciencia de datos entornos de clústeres de Spark potentes y personalizables para el entrenamiento de modelos a gran escala y la inferencia por lotes. Con los entornos de ejecución de AA preconfigurados y la compatibilidad con GPU, puedes acelerar todo el ciclo de vida del AA y realizar la integración con Vertex AI para crear y poner en funcionamiento canalizaciones de MLOps de extremo a extremo.

Motores de análisis de OSS flexibles

Ve más allá de Spark y Hadoop sin agregar sobrecarga operativa. Implementa clústeres dedicados con Trino para SQL interactivo, Flink para el procesamiento de transmisión avanzado o cualquier otro motor de código abierto especializado. Dataproc proporciona un plano de control unificado para administrar este ecosistema diverso con la simplicidad de un servicio administrado.

Recursos de aprendizaje

Motores de análisis de OSS flexibles

Ve más allá de Spark y Hadoop sin agregar sobrecarga operativa. Implementa clústeres dedicados con Trino para SQL interactivo, Flink para el procesamiento de transmisión avanzado o cualquier otro motor de código abierto especializado. Dataproc proporciona un plano de control unificado para administrar este ecosistema diverso con la simplicidad de un servicio administrado.

Precios

| Clústeres administrados de Dataproc | Dataproc ofrece precios de pago por uso. Optimiza los costos con VMs interrumpibles y con escalado automático. |

|---|---|

Componentes clave |

|

Ejemplo | P. ej.: Un clúster con 6 nodos (1 principal + 5 trabajadores) de 4 CPUs que se ejecuten durante 2 horas costaría $0.48. Cargo de Dataproc = Cantidad de CPUs virtuales * horas * precio de Dataproc = 24 * 2 * $0.01 = $0.48 |

Clústeres administrados de Dataproc

Dataproc ofrece precios de pago por uso. Optimiza los costos con VMs interrumpibles y con escalado automático.

Componentes clave

- Instancias de Compute Engine (CPU virtual, memoria)

- Tarifa del servicio de Dataproc (por hora de CPU virtual)

- Discos persistentes

Ejemplo

P. ej.: Un clúster con 6 nodos (1 principal + 5 trabajadores) de 4 CPUs que se ejecuten durante 2 horas costaría $0.48. Cargo de Dataproc = Cantidad de CPUs virtuales * horas * precio de Dataproc = 24 * 2 * $0.01 = $0.48

Caso empresarial

Crea tu caso empresarial para Google Dataproc

Los beneficios económicos de Google Cloud Dataproc y Serverless Spark en comparación con soluciones alternativas

Descubre cómo Dataproc ofrece ahorros significativos en el TCO y valor empresarial en comparación con las soluciones locales y otras soluciones en la nube.

Contenido relacionado

En el informe se muestra lo siguiente:

Descubre cómo Dataproc y Serverless for Apache Spark pueden ofrecer un ahorro de costos de entre el 18% y el 60% en comparación con otras alternativas de Spark basadas en la nube.

Explora cómo Google Cloud Serverless para Apache Spark puede proporcionar un rendimiento-precio entre un 21% y un 55% mejor que otras ofertas de Spark sin servidores.

Descubre cómo Dataproc y Google Cloud sin servidores para Apache Spark simplifican las implementaciones de Spark y ayudan a reducir la complejidad operativa.

Preguntas frecuentes

¿Cuándo debo elegir Dataproc en lugar de Google Cloud Serverless for Apache Spark?

Elige Dataproc cuando necesites un control detallado sobre tu entorno de clúster, estés migrando cargas de trabajo existentes de Hadoop o Spark, o requieras un clúster persistente con un conjunto diverso de herramientas de código abierto. Para obtener un desglose detallado de las diferencias en los modelos de administración, las cargas de trabajo ideales y las estructuras de costos,

¿Puedo usar más soluciones además Spark y Hadoop?

Sí. Dataproc es una plataforma unificada para la pila de datos moderna de código abierto. Admite más de 30 componentes, lo que te permite ejecutar clústeres dedicados para herramientas como Flink para el procesamiento de transmisión o Trino para SQL interactivo, todo en un solo servicio administrado.

¿Cuánto control tengo sobre el entorno de clúster?

Tienes un alto grado de control. Dataproc te permite personalizar los tipos de máquinas, los tamaños de los discos y la configuración de red. También puedes usar acciones de inicialización para instalar software personalizado, traer tus propias imágenes de contenedor y aprovechar las VMs Spot para optimizar los costos.