Dataproc

Verwaltetes Apache Spark und Hadoop mit Google Dataproc

Mit einem verwalteten Dienst können Sie Ihre anspruchsvollsten Spark- und Open-Source-Arbeitslasten einfacher, mit Gemini intelligenter und mit der Lightning Engine schneller ausführen.

Apache Spark ist eine Marke der Apache Software Foundation.

Features

Branchenführende Leistung

Mit der Lightning Engine können Sie Ihre anspruchsvollsten Spark-Jobs beschleunigen. Unsere Engine der nächsten Generation bietet dank verwalteter Optimierung eine mehr als 4,3-mal schnellere Leistung, was die Gesamtbetriebskosten und die manuelle Abstimmung reduziert. Jetzt in der Vorabversion für Dataproc verfügbar.

KI-basierte Entwicklung und Abläufe

Mit Gemini können Sie Ihren gesamten Workflow beschleunigen. Sie erhalten KI-Unterstützung beim Schreiben und Debuggen von PySpark-Code und können mit Gemini Cloud Assist eine automatisierte Ursachenanalyse für fehlgeschlagene oder langsam laufende Jobs durchführen, wodurch sich die Zeit für die Fehlerbehebung erheblich verkürzt.

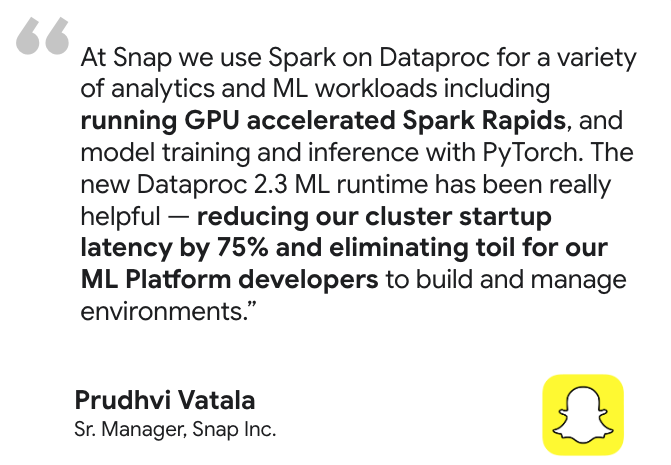

Bereit für KI/ML auf Unternehmenslevel

Sie können den gesamten Lebenszyklus des maschinellen Lernens entwickeln und operationalisieren. Beschleunigen Sie das Modelltraining und die Inferenz mit GPU-Unterstützung durch NVIDIA RAPIDS™ und vorkonfigurierte ML-Laufzeiten. Anschließend können Sie die Lösung in das umfassendere KI-Ökosystem von Google Cloud AI einbinden, um mit Vertex AI Pipelines End-to-End-MLOps zu orchestrieren.

Leistungsstarke Lakehouse-Integrationen

Native Verbindung zu einer offenen Lakehouse-Architektur Verarbeiten Sie Daten direkt aus BigQuery, orchestrieren Sie MLOps mit Vertex AI Pipelines und vereinheitlichen Sie die Governance Ihrer offenen Daten mit BigLake und Dataplex Universal Catalog.

Hervorragende Steuerung und Anpassung

Sie können die einzelnen Dataproc-Cluster genau an Ihre Anforderungen anpassen. Sie können in Python, Scala oder Java entwickeln, aus einer Vielzahl von Maschinentypen auswählen, Initialisierungsaktionen zum Installieren benutzerdefinierter Software verwenden und Ihre eigenen Container-Images für maximale Übertragbarkeit einbinden.

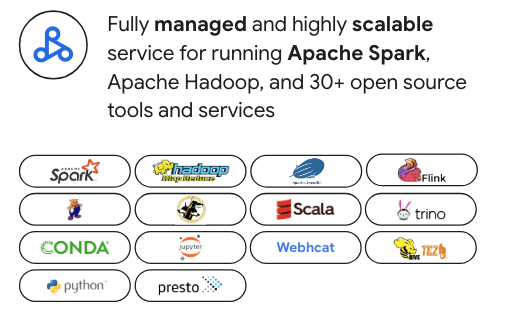

Für moderne Open-Source-Daten-Stacks entwickelt

Vermeiden Sie die Anbieterbindung. Dataproc ist zwar für Apache Spark optimiert, unterstützt aber mehr als 30 Open-Source-Tools, darunter Apache Hadoop, Flink, Trino und Presto. Es lässt sich für maximale Flexibilität nahtlos in beliebte Orchestratoren wie Airflow einbinden und mit Kubernetes und Docker erweitern.

Sicherheit auf Unternehmensniveau:

Nahtlose Einbindung in Ihre Sicherheitsarchitektur. Nutzen Sie IAM für detaillierte Berechtigungen, VPC Service Controls für die Netzwerksicherheit und Kerberos für eine starke Authentifizierung in Ihrem Spark-Cluster.

Gängige Einsatzmöglichkeiten

Cloud-Migration

Nahtloses Lift-and-Shift von lokalen Apache Hadoop- und Spark-Arbeitslasten. Außerdem ist dies der ideale Weg, um von selbstverwaltetem „DIY Spark“ zu einem vollständig verwalteten Dienst zu wechseln. Dataproc unterstützt eine Vielzahl von Spark-Versionen, einschließlich der Legacy-Version 2.x, was die Migration vereinfacht, da kein sofortiges Refactoring des Codes erforderlich ist. So können Sie die vorhandenen Open-Source-Kenntnisse Ihres Teams nutzen, um schneller in die Cloud zu wechseln.

Lernressourcen

Cloud-Migration

Nahtloses Lift-and-Shift von lokalen Apache Hadoop- und Spark-Arbeitslasten. Außerdem ist dies der ideale Weg, um von selbstverwaltetem „DIY Spark“ zu einem vollständig verwalteten Dienst zu wechseln. Dataproc unterstützt eine Vielzahl von Spark-Versionen, einschließlich der Legacy-Version 2.x, was die Migration vereinfacht, da kein sofortiges Refactoring des Codes erforderlich ist. So können Sie die vorhandenen Open-Source-Kenntnisse Ihres Teams nutzen, um schneller in die Cloud zu wechseln.

Lakehouse-Modernisierung

Nutzen Sie Dataproc als leistungsstarke Open-Source-Verarbeitungs-Engine für Ihr modernes Data Lakehouse. Verarbeiten Sie Daten in offenen Formaten wie Apache Iceberg direkt aus Ihrem Data Lake. So vermeiden Sie Datensilos und kostspielige Datenverschiebungen. Die nahtlose Einbindung in BigQuery und den Dataplex Universal Catalog ermöglicht eine wirklich einheitliche, Multi-Engine-Analyse- und Governance-Plattform.

Lernressourcen

Lakehouse-Modernisierung

Nutzen Sie Dataproc als leistungsstarke Open-Source-Verarbeitungs-Engine für Ihr modernes Data Lakehouse. Verarbeiten Sie Daten in offenen Formaten wie Apache Iceberg direkt aus Ihrem Data Lake. So vermeiden Sie Datensilos und kostspielige Datenverschiebungen. Die nahtlose Einbindung in BigQuery und den Dataplex Universal Catalog ermöglicht eine wirklich einheitliche, Multi-Engine-Analyse- und Governance-Plattform.

Data Engineering

Erstellen und orchestrieren Sie komplexe, lang laufende Spark-ETL-Pipelines mit Zuverlässigkeit und Skalierbarkeit auf Unternehmensniveau. Nutzen Sie leistungsstarke Funktionen wie Autoscaling, um Kosten und Leistung zu optimieren, und verwenden Sie Workflow-Vorlagen, um Ihre wichtigsten Produktionsjobs von Anfang bis Ende zu automatisieren und zu verwalten.

Lernressourcen

Data Engineering

Erstellen und orchestrieren Sie komplexe, lang laufende Spark-ETL-Pipelines mit Zuverlässigkeit und Skalierbarkeit auf Unternehmensniveau. Nutzen Sie leistungsstarke Funktionen wie Autoscaling, um Kosten und Leistung zu optimieren, und verwenden Sie Workflow-Vorlagen, um Ihre wichtigsten Produktionsjobs von Anfang bis Ende zu automatisieren und zu verwalten.

Data Science im großen Maßstab

Sie können Data-Science-Teams leistungsstarke, anpassbare Spark-Clusterumgebungen für umfangreiches Modelltraining und Batch-Inferenz zur Verfügung stellen. Dank vorkonfigurierten ML-Laufzeiten und GPU-Unterstützung können Sie den gesamten ML-Lebenszyklus beschleunigen und sich in Vertex AI einbinden, um End-to-End-MLOps-Pipelines zu erstellen und zu operationalisieren.

Lernressourcen

Data Science im großen Maßstab

Sie können Data-Science-Teams leistungsstarke, anpassbare Spark-Clusterumgebungen für umfangreiches Modelltraining und Batch-Inferenz zur Verfügung stellen. Dank vorkonfigurierten ML-Laufzeiten und GPU-Unterstützung können Sie den gesamten ML-Lebenszyklus beschleunigen und sich in Vertex AI einbinden, um End-to-End-MLOps-Pipelines zu erstellen und zu operationalisieren.

Flexible OSS-Analyse-Engines

Sie können mehr als nur Spark und Hadoop nutzen, ohne den Betriebsaufwand zu erhöhen. Erstellen Sie dedizierte Cluster mit Trino für interaktive SQL-Abfragen und Flink für erweiterte Streamverarbeitung oder nutzen Sie andere spezialisierte Open-Source-Engines. Dataproc bietet eine einheitliche Steuerungsebene, um dieses vielfältige Ökosystem mit der Einfachheit eines verwalteten Dienstes zu verwalten.

Lernressourcen

Flexible OSS-Analyse-Engines

Sie können mehr als nur Spark und Hadoop nutzen, ohne den Betriebsaufwand zu erhöhen. Erstellen Sie dedizierte Cluster mit Trino für interaktive SQL-Abfragen und Flink für erweiterte Streamverarbeitung oder nutzen Sie andere spezialisierte Open-Source-Engines. Dataproc bietet eine einheitliche Steuerungsebene, um dieses vielfältige Ökosystem mit der Einfachheit eines verwalteten Dienstes zu verwalten.

Preise

| Verwaltete Dataproc-Cluster | Dataproc bietet nutzungsbasierte Preise. Kosten mit Autoscaling und VMs auf Abruf optimieren. |

|---|---|

Schlüsselkomponenten |

|

Beispiel | Ein Cluster mit 6 Knoten (1 Haupt-+ 5 Worker) von 4 CPUs, die jeweils 2 Stunden lang ausgeführt wurden, würde 0,48 $ kosten. Dataproc-Gebühren = Anzahl der vCPUs * Stunden * Dataproc-Preis = 24 * 2 * 0,01 $ = = 0,48 $ |

Verwaltete Dataproc-Cluster

Dataproc bietet nutzungsbasierte Preise. Kosten mit Autoscaling und VMs auf Abruf optimieren.

Schlüsselkomponenten

- Compute Engine-Instanzen (vCPU, Speicher)

- Dataproc-Dienstgebühr (pro vCPU-Stunde)

- Nichtflüchtige Speicher

Beispiel

Ein Cluster mit 6 Knoten (1 Haupt-+ 5 Worker) von 4 CPUs, die jeweils 2 Stunden lang ausgeführt wurden, würde 0,48 $ kosten. Dataproc-Gebühren = Anzahl der vCPUs * Stunden * Dataproc-Preis = 24 * 2 * 0,01 $ = = 0,48 $

Anwendungsszenario

Business Case für Google Dataproc erstellen

Die wirtschaftlichen Vorteile von Google Cloud Dataproc und Serverless Spark im Vergleich zu alternativen Lösungen

Hier erfahren Sie, wie Sie mit Dataproc im Vergleich zu lokalen und anderen Cloud-Lösungen Ihre Gesamtbetriebskosten deutlich senken und den Geschäftswert steigern können.

Im Bericht gilt Folgendes:

Dataproc und Serverless for Apache Spark können im Vergleich zu anderen cloudbasierten Spark-Alternativen Kosteneinsparungen von 18% bis 60% erzielen.

Google Cloud Serverless for Apache Spark bietet ein 21% bis 55% besseres Preis-Leistungs-Verhältnis als andere serverlose Spark-Angebote.

Hier erfahren Sie, wie Dataproc und Google Cloud Serverless for Apache Spark die Spark-Bereitstellung vereinfachen und die betriebliche Komplexität reduzieren.

FAQs

Wann sollte ich Dataproc und wann Google Cloud Serverless for Apache Spark verwenden?

Wählen Sie Dataproc, wenn Sie eine detaillierte Kontrolle über Ihre Clusterumgebung benötigen, vorhandene Hadoop-/Spark-Arbeitslasten migrieren oder einen persistenten Cluster mit einer Vielzahl an Open-Source-Tools benötigen. Hier finden Sie eine detaillierte Aufschlüsselung der Unterschiede bei Verwaltungsmodellen, idealen Arbeitslasten und Kostenstrukturen:

Kann ich mehr als nur Spark und Hadoop verwenden?

Ja. Dataproc ist eine einheitliche Plattform für moderne Open-Source-Datenstacks. Es unterstützt über 30 Komponenten, sodass Sie dedizierte Cluster für Tools wie Flink für die Streamverarbeitung oder Trino für interaktive SQL-Abfragen ausführen können – alles unter einem einzigen verwalteten Dienst.

Wie viel Kontrolle habe ich über die Clusterumgebung?

Sie haben ein hohes Maß an Kontrolle. Mit Dataproc können Sie Maschinentypen, Laufwerksgrößen und Netzwerkkonfigurationen anpassen. Sie können auch Initialisierungsaktionen verwenden, um benutzerdefinierte Software zu installieren, eigene Container-Images einzubinden und Spot-VMs zu nutzen, um die Kosten zu optimieren.