Questa pagina descrive la gestione del controllo dell'accesso quando esegui il deployment e l'esecuzione di una pipeline che utilizza i cluster Dataproc in un altro progetto. Google Cloud

Scenario

Per impostazione predefinita, quando un'istanza Cloud Data Fusion viene lanciata in un Google Cloud progetto, esegue il deployment ed esegue le pipeline utilizzando i cluster Dataproc all'interno dello stesso progetto. Tuttavia, la tua organizzazione potrebbe richiedere l'utilizzo di cluster in un altro progetto. Per questo caso d'uso, devi gestire l'accesso tra i progetti. La pagina seguente descrive come modificare le configurazioni di base (predefinite) e applicare i controlli di accesso appropriati.

Prima di iniziare

Per comprendere le soluzioni in questo caso d'uso, è necessario il seguente contesto:

- Familiarità con i concetti di base di Cloud Data Fusion

- Familiarità con Identity and Access Management (IAM) per Cloud Data Fusion

- Familiarità con la networking di Cloud Data Fusion

Ipotesi e ambito

Questo caso d'uso presenta i seguenti requisiti:

- Un'istanza privata di Cloud Data Fusion. Per motivi di sicurezza, un'organizzazione potrebbe richiedere di utilizzare questo tipo di istanza.

- Un'origine e un sink BigQuery.

- Controllo dell'accesso con IAM, non con il controllo degli accessi basato sui ruoli (RBAC).

Soluzione

Questa soluzione confronta l'architettura e la configurazione di riferimento e specifiche per i casi d'uso.

Architettura

I seguenti diagrammi confrontano l'architettura del progetto per la creazione di un'istanza Cloud Data Fusion ed l'esecuzione di pipeline quando utilizzi i cluster nello stesso progetto (valore di riferimento) e in un altro progetto tramite il VPC del progetto tenant.

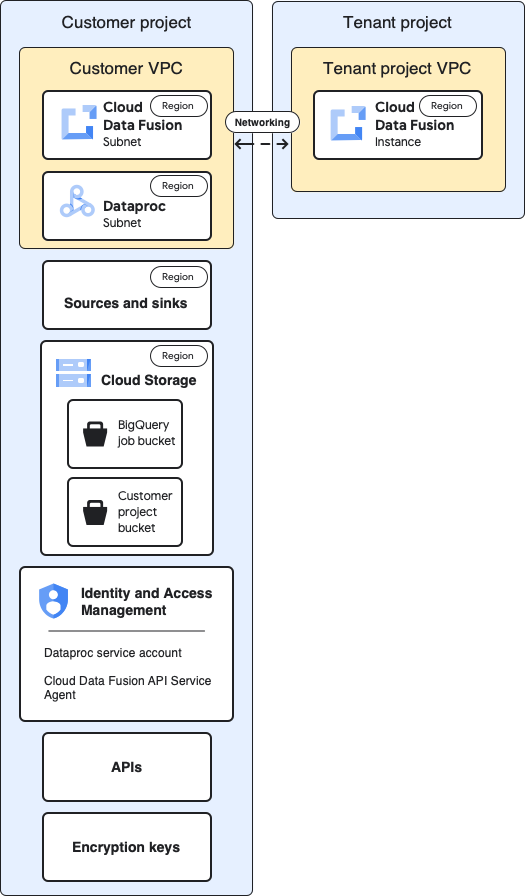

Architettura di riferimento

Questo diagramma mostra l'architettura di riferimento dei progetti:

Per la configurazione di riferimento, crea un'istanza Cloud Data Fusion privata ed esegui una pipeline senza ulteriori personalizzazioni:

- Utilizzi uno dei profili di calcolo integrati

- L'origine e la destinazione si trovano nello stesso progetto dell'istanza

- Non sono stati concessi ruoli aggiuntivi a nessuno degli account di servizio

Per saperne di più sui progetti tenant e dei clienti, consulta Networking.

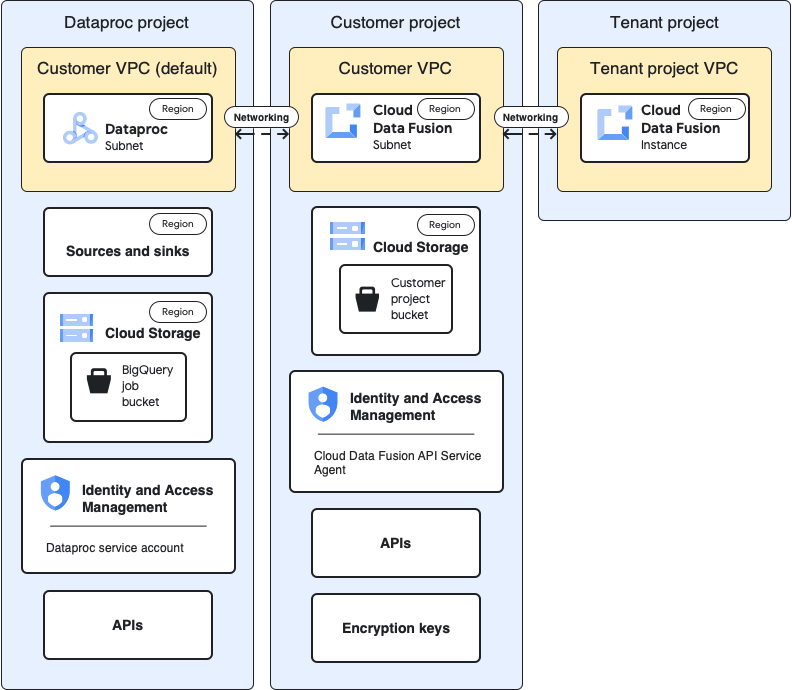

Architettura del caso d'uso

Questo diagramma mostra l'architettura del progetto quando utilizzi i cluster in un altro progetto:

Configurazioni

Le sezioni seguenti confrontano le configurazioni di riferimento con le configurazioni specifiche del caso d'uso per l'utilizzo dei cluster Dataproc in un progetto diverso tramite il VPC del progetto tenant predefinito.

Nelle seguenti descrizioni dei casi d'uso, il progetto del cliente è il luogo in cui viene eseguita l'istanza Cloud Data Fusion e il progetto Dataproc è il luogo in cui viene lanciato il cluster Dataproc.

VPC e istanza del progetto tenant

| Base di riferimento | Caso d'uso |

|---|---|

Nel diagramma dell'architettura di riferimento precedente, il progetto tenant contiene i seguenti componenti:

|

Per questo caso d'uso non è necessaria alcuna configurazione aggiuntiva. |

Progetto del cliente

| Base di riferimento | Caso d'uso |

|---|---|

| Il Google Cloud progetto è il luogo in cui esegui il deployment ed esegui le pipeline. Per impostazione predefinita, i cluster Dataproc vengono avviati in questo progetto quando esegui le pipeline. | In questo caso d'uso, gestisci due progetti. In questa pagina, il progetto del cliente si riferisce al luogo in cui viene eseguita l'istanza Cloud Data Fusion. Il progetto Dataproc si riferisce al luogo in cui vengono avviati i cluster Dataproc. |

VPC del cliente

| Base di riferimento | Caso d'uso |

|---|---|

Dal tuo punto di vista (del cliente), il VPC del cliente è dove si trova Cloud Data Fusion dal punto di vista logico. Apprendimento chiave: puoi trovare i dettagli del VPC del cliente nella pagina Reti VPC del tuo progetto. |

Per questo caso d'uso non è necessaria alcuna configurazione aggiuntiva. |

Sottorete Cloud Data Fusion

| Base di riferimento | Caso d'uso |

|---|---|

Dal tuo punto di vista (del cliente), in questa sottorete si trova Cloud Data Fusion. Apprendimento chiave: la regione di questa sottorete corrisponde alla posizione dell'istanza Cloud Data Fusion nel progetto del tenant. |

Per questo caso d'uso non è necessaria alcuna configurazione aggiuntiva. |

Subnet Dataproc

| Base di riferimento | Caso d'uso |

|---|---|

La subnet in cui vengono lanciati i cluster Dataproc quando esegui una pipeline. Concetti chiave:

|

Si tratta di una nuova subnet in cui vengono avviati i cluster Dataproc quando esegui una pipeline. Concetti chiave:

|

Origini e sink

| Base di riferimento | Caso d'uso |

|---|---|

Le origini da cui vengono estratti i dati e gli sink in cui vengono caricati, come le origini e gli sink BigQuery. Concetto chiave:

|

Le configurazioni di controllo dell'accesso specifiche per i casi d'uso in questa pagina sono destinate alle origini e alle destinazioni BigQuery. |

Cloud Storage

| Base di riferimento | Caso d'uso |

|---|---|

Il bucket di archiviazione nel progetto del cliente che consente di trasferire i file tra Cloud Data Fusion e Dataproc. Concetti chiave:

|

Per questo caso d'uso non è necessaria alcuna configurazione aggiuntiva. |

Bucket temporanei utilizzati dall'origine e dal sink

| Base di riferimento | Caso d'uso |

|---|---|

I bucket temporanei creati dai plug-in per le origini e gli scoli, come i job di caricamento avviati dal plug-in di destinazione BigQuery. Concetti chiave:

|

Per questo caso d'uso, il bucket può essere creato in qualsiasi progetto. |

Bucket che sono origini o destinazioni di dati per i plug-in

| Base di riferimento | Caso d'uso |

|---|---|

| Bucket dei clienti, specificati nelle configurazioni dei plug-in, come il plug-in Cloud Storage e il plug-in FTP to Cloud Storage. | Per questo caso d'uso non è necessaria alcuna configurazione aggiuntiva. |

IAM: Cloud Data Fusion API Service Agent

| Base di riferimento | Caso d'uso |

|---|---|

Quando l'API Cloud Data Fusion è attivata, il

ruolo Agente di servizio API Cloud Data Fusion

( Concetti chiave:

|

Per questo caso d'uso, concedi il ruolo Agente di servizio API Cloud Data Fusion all'account di servizio nel progetto Dataproc. Quindi, concedi i seguenti ruoli nel progetto:

|

IAM: service account Dataproc

| Base di riferimento | Caso d'uso |

|---|---|

L'account di servizio utilizzato per eseguire la pipeline come job all'interno del cluster Dataproc. Per impostazione predefinita, è l'account di servizio Compute Engine. (Facoltativo) Nella configurazione di riferimento, puoi cambiare l'account di servizio predefinito con un altro account di servizio dello stesso progetto. Concedi i seguenti ruoli IAM al nuovo account di servizio:

|

Questo esempio di caso d'uso presuppone che tu utilizzi l'account di servizio Compute Engine predefinito ( Concedi i seguenti ruoli all'account di servizio Compute Engine predefinito nel progetto Dataproc.

Concedi il ruolo Utente account di servizio all'account di servizio Cloud Data Fusion nell'account di servizio Compute Engine predefinito del progetto Dataproc. Questa azione deve essere eseguita nel progetto Dataproc. Aggiungi l'account di servizio Compute Engine predefinito del progetto Dataproc al progetto Cloud Data Fusion. Concedi anche i seguenti ruoli:

|

API

| Base di riferimento | Caso d'uso |

|---|---|

Quando attivi l'API Cloud Data Fusion, vengono attivate anche le seguenti API. Per ulteriori informazioni su queste API, vai alla pagina

API e servizi del tuo progetto.

Quando attivi l'API Cloud Data Fusion, i seguenti account di servizio vengono aggiunti automaticamente al tuo progetto:

|

Per questo caso d'uso, abilita le seguenti API nel progetto che contiene il progetto Dataproc:

|

Chiavi di crittografia

| Base di riferimento | Caso d'uso |

|---|---|

Nella configurazione di riferimento, le chiavi di crittografia possono essere gestite da Google o CMEK Concetti chiave: Se utilizzi CMEK, la configurazione di riferimento richiede quanto segue:

A seconda dei servizi utilizzati nella pipeline, come BigQuery o Cloud Storage, agli account di servizio deve essere concesso anche il ruolo Autore crittografia/decrittografia CryptoKey Cloud KMS:

|

Se non utilizzi CMEK, non sono necessarie modifiche aggiuntive per questo caso d'uso. Se utilizzi CMEK, il ruolo Autore crittografia/decrittografia CryptoKey Cloud KMS deve essere fornito al seguente account di servizio a livello di chiave nel progetto in cui è stato creato:

A seconda dei servizi utilizzati nella pipeline, come BigQuery o Cloud Storage, anche ad altri account di servizio deve essere concesso il ruolo Autore crittografia/decrittografia CryptoKey Cloud KMS a livello di chiave. Ad esempio:

|

Dopo aver apportato queste configurazioni specifiche per i casi d'uso, la pipeline di dati può iniziare a essere eseguita sui cluster di un altro progetto.

Passaggi successivi

- Scopri di più sul networking in Cloud Data Fusion.

- Consulta il riferimento ai ruoli di base e predefiniti IAM.