타겟 캠페인 파이프라인 만들기

Cloud Data Fusion을 사용하여 고객 데이터를 정리, 변환, 처리하여 타겟 캠페인의 후보를 선택하는 방법을 알아봅니다.

Google Cloud 콘솔에서 이 태스크에 대한 단계별 안내를 직접 수행하려면 둘러보기를 클릭합니다.

시나리오

진행 중인 캠페인 프로모션을 위해 커스텀 마케팅 자료를 만들고 고객의 자택 우편함에 자료를 직접 배포하려고 합니다.

캠페인에는 2가지 제약이 있습니다.

- 위치: 캘리포니아, 워싱턴, 오리건의 고객에게만 배달합니다.

- 비용: 연료 절감을 위해 신속하게 접근할 수 있는 고객 자택에 배달합니다. 애비뉴에 거주하는 고객 자택에만 배달합니다.

이 튜토리얼에서는 캠페인의 고객 주소 목록을 생성하는 방법을 설명합니다. 이 튜토리얼에서는 다음 작업을 수행합니다.

- 고객 데이터 정리: 캘리포니아, 워싱턴 또는 오리건의 애비뉴에 거주하는 고객을 필터링합니다.

다음 작업을 수행하는 파이프라인을 만듭니다.

- 필터링된 고객 데이터를 주 약어가 포함된 공개 데이터 세트와 조인합니다.

- BigQuery 웹 인터페이스를 사용하여 쿼리하거나 Looker Studio를 사용하여 분석할 수 있는 BigQuery 테이블에 정리 및 조인된 데이터를 저장합니다.

목표

- Cloud Data Fusion을 데이터 소스 2개에 연결

- 기본 변환 적용

- 데이터 소스 2개 조인

- 출력 데이터를 싱크에 쓰기

시작하기 전에

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Cloud Data Fusion 인스턴스를 만듭니다.

참고: 이 튜토리얼에서는 기본 Compute Engine 서비스 계정을 사용한다고 가정합니다. Google Cloud 콘솔에서 역할 페이지로 이동합니다.

역할 만들기를 클릭합니다.

제목 필드에

Custom Role-Tutorial을 입력합니다.권한 추가를 클릭합니다.

권한 추가 창에서 다음 권한을 선택하고 추가를 클릭합니다.

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

만들기를 클릭합니다.

Cloud Data Fusion 인스턴스 페이지로 이동합니다.

인스턴스의 이름을 클릭합니다.

기본 Dataproc 서비스 계정을 기록해 둡니다. 인스턴스 세부정보 페이지에 이 정보가 포함되어 있습니다.

Dataproc 서비스 계정 이름의 형식은 다음과 같습니다.

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Dataproc 서비스 계정에 대해 자세히 알아봅니다.

IAM 페이지로 이동합니다.

필터 표시줄에 기본 Dataproc 서비스 계정의 이름을 입력합니다.

기본 Compute Engine 서비스 계정에서 수정을 클릭합니다.

다른 역할 추가를 클릭합니다.

역할 선택 필드에서 커스텀 역할 튜토리얼을 선택합니다.

저장을 클릭합니다.

서비스 계정에 이미 Cloud Data Fusion 실행자 역할이 할당되어 있는지 확인합니다.

권한 관리

필요한 커스텀 역할 및 권한을 만들고 할당합니다.

커스텀 역할 만들기 및 권한 추가

기본 Compute Engine 서비스 계정에 커스텀 역할 할당

고객 데이터 준비

이 튜토리얼에는 다음 두 가지 입력 데이터 세트가 필요하며 두 데이터 세트 모두 Cloud Data Fusion 인스턴스와 함께 제공됩니다.

- 샘플 고객 데이터: 이름이

customers.csv인 CSV 파일입니다. - 주 약어: 이름이

state_abbreviations인 BigQuery 테이블입니다.

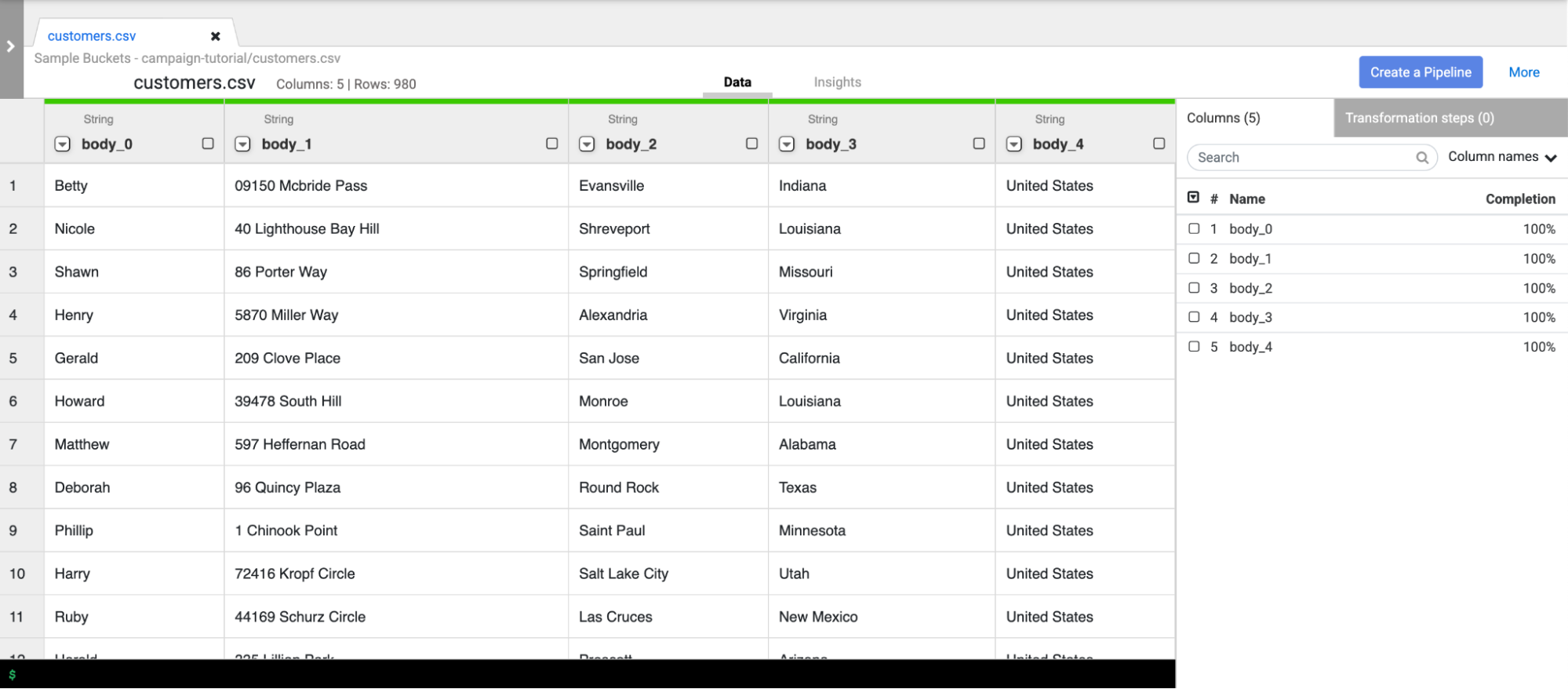

고객 데이터 로드

Cloud Data Fusion 인스턴스 페이지로 이동합니다.

사용 중인 Cloud Data Fusion 인스턴스에 대해 인스턴스 보기를 클릭합니다. Cloud Data Fusion 웹 인터페이스가 새 탭에서 열립니다.

Wrangler를 클릭합니다. Wrangler 페이지가 열립니다.

연결 창에서 GCS > 샘플 버킷을 선택합니다.

campaign-tutorial을 클릭합니다.

customers.csv를 클릭합니다.

파싱 옵션 창에서 다음을 지정합니다.

- 형식:

csv - 따옴표로 묶인 값 사용 설정:

False - 첫 번째 행을 헤더로 사용:

False - 파일 인코딩:

UTF-8

- 형식:

확인을 클릭합니다. 고객 데이터가 Wrangler의 새 탭에 로드됩니다.

고객 데이터 정리

여기에는 두 개의 하위 태스크가 포함됩니다.

- 스키마 설정

- 필요한 공유 대상 그룹만 표시하도록 고객 데이터 필터링

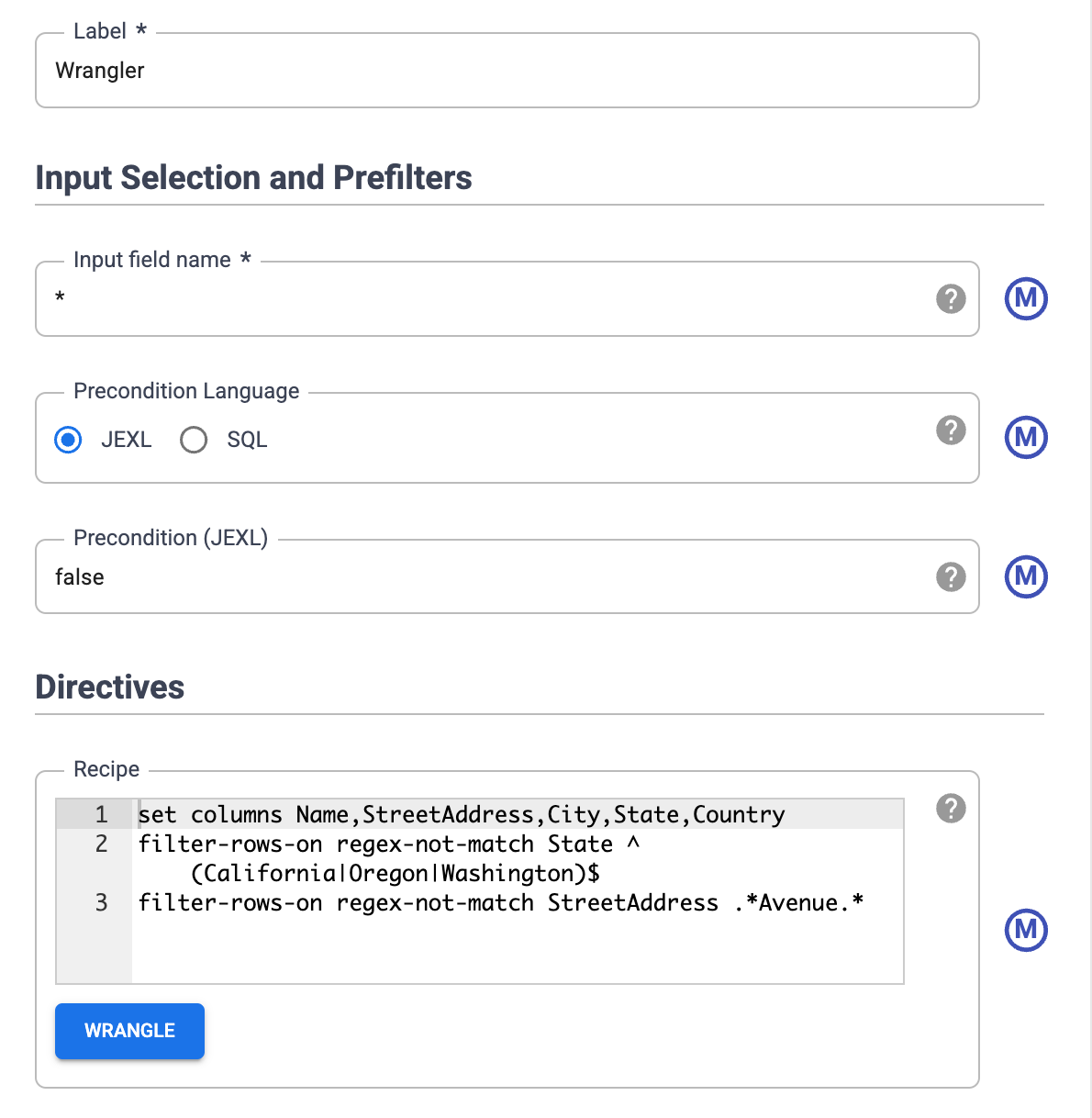

스키마 설정

테이블 열에 적절한 이름을 할당하여 데이터의 스키마를 설정합니다. body_1 및 body_2와 같은 열에 더 유용한 이름을 지정하려면 다음 단계를 따르세요.

- 오른쪽 창에서 열 탭을 클릭합니다.

- 열 이름 드롭다운을 클릭하고 모두 설정을 선택합니다.

열 이름 일괄 설정 대화상자에 다음 열 이름을 쉼표로 구분하여 입력합니다.

Name,StreetAddress,City,State,Country적용을 클릭합니다.

데이터 필터링하기

캘리포니아, 오리건 또는 워싱턴에 거주하는 고객만 표시하도록 데이터를 필터링합니다.

이러한 상태 이외의 값이 포함된 모든 행을 삭제합니다.

- 상태 열 드롭다운을 클릭하고 필터를 선택합니다.

필터 창에서 다음 작업을 수행합니다.

- 행 유지를 클릭합니다.

- If 드롭다운을 클릭하고 값이 정규식과 일치를 선택합니다.

다음 정규 표현식을 입력합니다.

^(California|Oregon|Washington)$적용을 클릭합니다.

주 열의 값은 California, Oregon, Washington입니다.

애비뉴에 거주하는 고객만 표시하도록 데이터를 필터링합니다. Avenue 문자열이 포함된 주소만 유지합니다.

- StreetAddress 열 드롭다운을 클릭하고 StreetAddress를 선택합니다.

- 필터 창에서 다음 작업을 수행합니다.

- 행 유지를 클릭합니다.

- If 드롭다운에서 값이 다음을 포함을 선택하고

Avenue를 입력합니다. - 대/소문자 무시를 선택합니다.

- 적용을 클릭합니다.

전체 데이터 세트에 동시 처리 작업을 수행하기 전에는 랭글러에 데이터 세트의 처음 1,000개 값만 표시됩니다. 일부 데이터를 필터링했으므로 고객 몇 명만 랭글러 화면에 남아 있습니다.

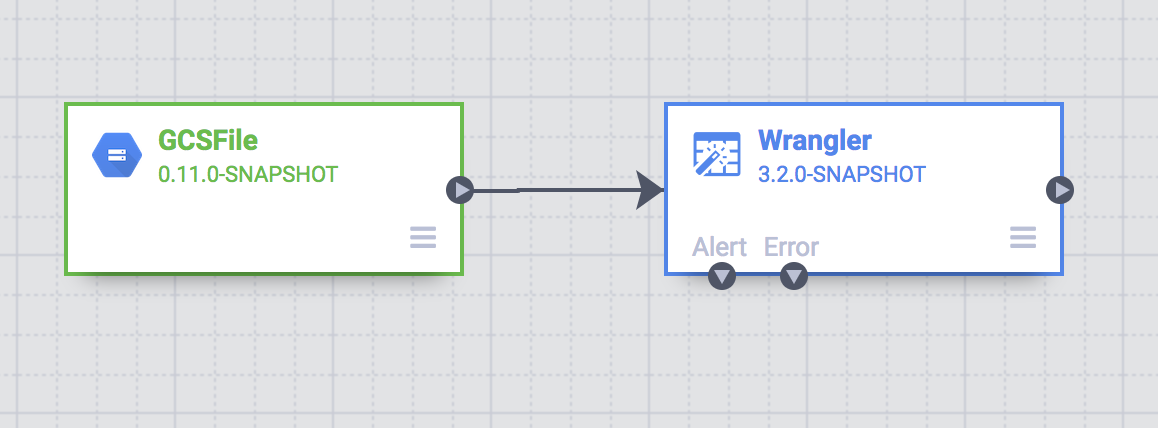

배치 파이프라인 만들기

지금까지 데이터를 정리하고 데이터의 하위 집합에 변환을 실행했습니다. 이제 전체 데이터 세트에 변환을 실행하는 일괄 파이프라인을 만들 수 있습니다.

Cloud Data Fusion은 Studio에서 빌드하는 파이프라인을 병렬로 또는 임시 Dataproc 클러스터에서 변환을 수행하는 Apache Spark 프로그램으로 변환합니다. 이 프로세스를 사용하면 인프라를 수정할 필요 없이 확장 가능하고 안정적인 방법으로 대량의 데이터에 대해 복잡한 변환을 수행할 수 있습니다.

- Wrangler 페이지에서 파이프라인 만들기를 클릭합니다.

- 일괄 파이프라인을 선택합니다. Studio 페이지가 열립니다.

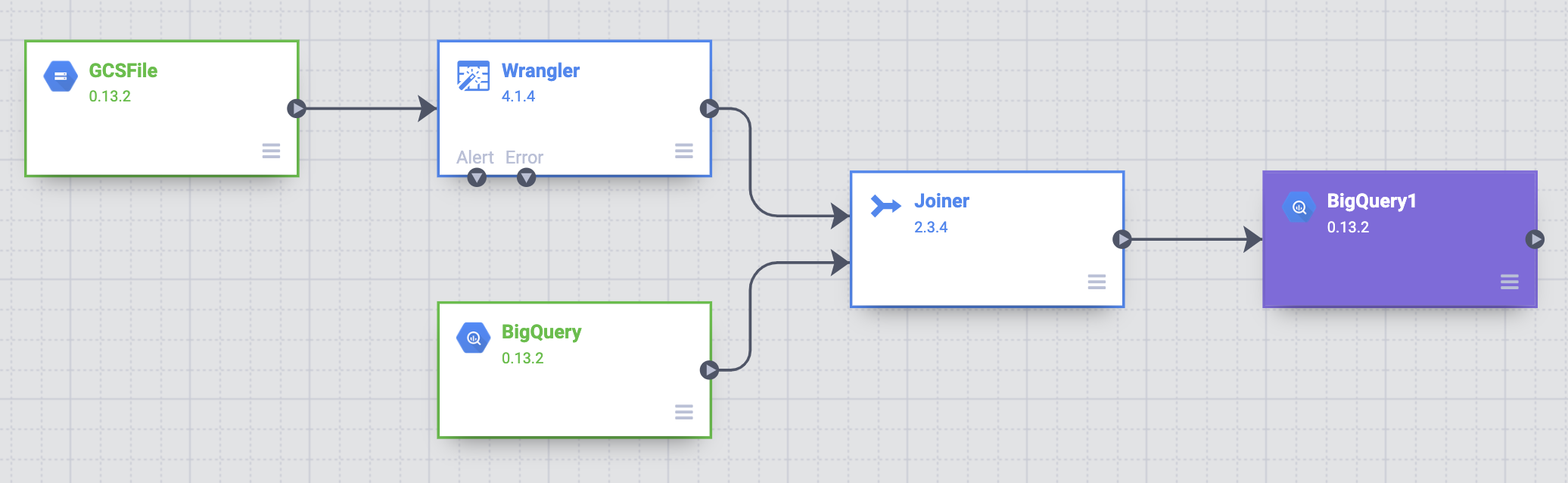

Studio 페이지에서 GCSFile 소스 노드는 GCSFile 노드에 연결됩니다.

Wrangler 페이지에 적용한 변환이 Studio 페이지의 Wrangler 노드에 표시됩니다.

적용한 변환을 보려면 Wrangler 노드 위에 마우스 포인터를 올려놓고 속성을 클릭합니다.

적용한 변환은 지시어 아래에 표시됩니다.

검증을 클릭합니다.

닫기를 클릭합니다.

예를 들어 값이 항상 USA이므로 국가 열이 필요하지 않습니다. 다음 단계를 따라 열을 삭제합니다.

- Wrangle을 클릭합니다.

- 국가 옆에 있는 아래쪽 화살표를 클릭하고 열 삭제를 선택합니다.

- 적용을 클릭합니다. Wrangler 페이지가 닫히고 Wrangler 속성 창이 Studio 페이지에서 열립니다. 지시어에

drop Country가 표시됩니다. - 닫기를 클릭합니다.

주 이름 축약

배송 차량의 내비게이션 시스템은 축약된 주 이름(California 대신 CA)이 포함된 주소만 인식하며, 고객 데이터에는 전체 주 이름이 포함되어 있습니다.

공개 BigQuery state_abbreviations 테이블에는 주 전체 이름이 있는 열 1개와 축약된 주 이름이 있는 열 1개 등 열이 총 2개 있습니다.

이 테이블을 사용하여 고객 데이터의 주 이름을 업데이트할 수 있습니다.

BigQuery에서 주 이름 데이터 보기

별도의 탭에서 BigQuery Studio 페이지로 이동합니다.

SQL 쿼리 만들기를 클릭하고 쿼리 편집기에 다음 쿼리를 입력합니다.

SELECT * FROM `dis-user-guide.campaign_tutorial.state_abbreviations`실행을 클릭합니다.

BigQuery는 주 이름과 해당 약어 목록을 표시합니다.

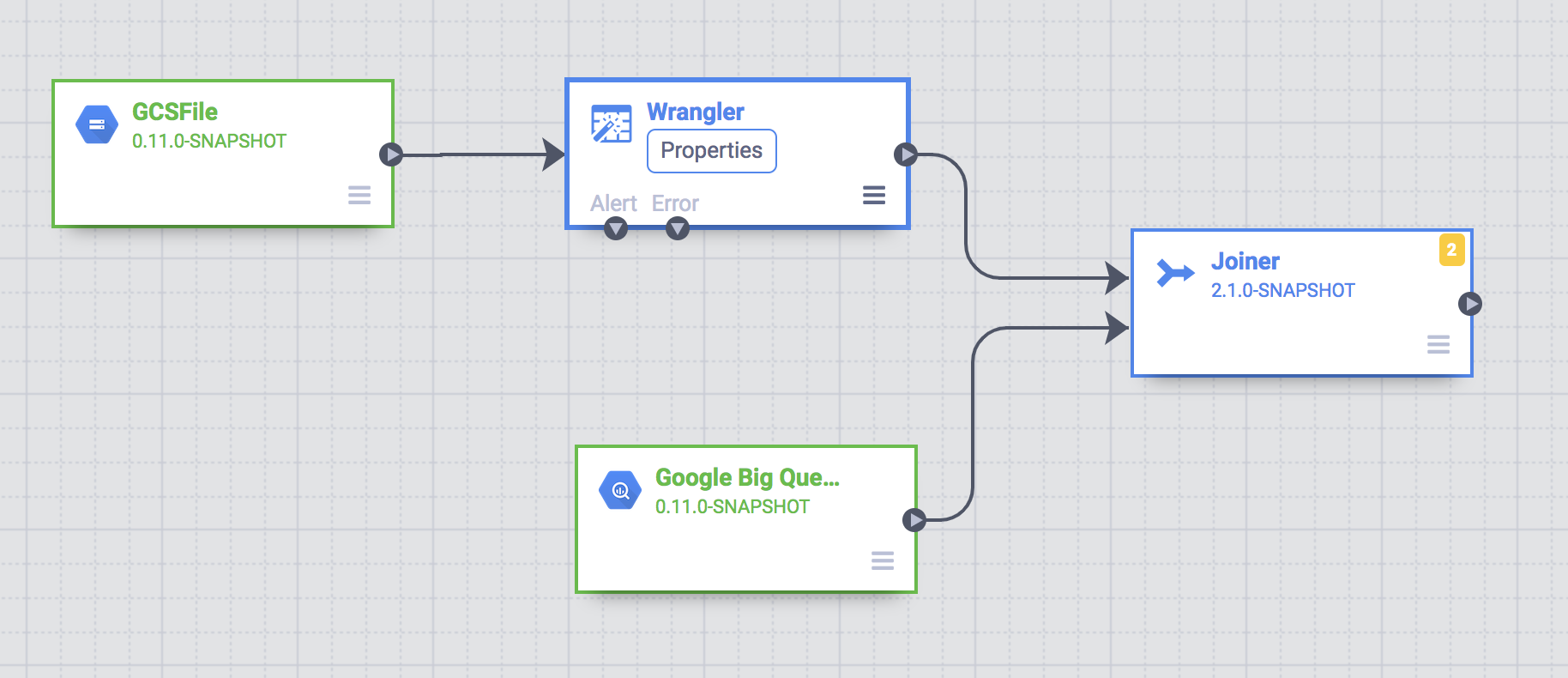

BigQuery 테이블에 액세스

BigQuery state_abbreviations 테이블에 액세스할 파이프라인에 소스를 추가합니다.

- Cloud Data Fusion Studio 페이지로 이동하고 소스 메뉴를 확장합니다.

BigQuery를 클릭합니다.

BigQuery 소스 노드가 다른 2개 노드와 함께 캔버스에 표시됩니다.

BigQuery 소스 노드 위에 마우스 포인터를 올려놓고 속성을 클릭합니다.

- 데이터 세트 프로젝트 ID 필드에

dis-user-guide를 입력합니다. - 참조 이름 필드에

state_abbreviations를 입력합니다. - 데이터 세트 필드에

campaign_tutorial을 입력합니다. - 테이블 필드에

state_abbreviations를 입력합니다.

- 데이터 세트 프로젝트 ID 필드에

스키마 가져오기를 클릭하여 BigQuery에서 테이블의 스키마를 채웁니다.

닫기를 클릭합니다.

데이터 소스 2개 조인

축약된 주 이름의 고객 데이터가 포함된 출력을 생성하려면 두 개의 데이터 소스인 고객 데이터와 주 축약어를 조인합니다.

- Cloud Data Fusion Studio 페이지로 이동하고 분석 메뉴를 확장합니다.

연결자를 클릭합니다.

SQL 조인과 비슷한 작업을 나타내는 Joiner 노드가 캔버스에 나타납니다.

Wrangler 노드와 BigQuery 노드를 Joiner 노드에 연결합니다. 소스 노드의 오른쪽 가장자리에 있는 연결 화살표를 드래그하여 대상 노드에 놓습니다.

Joiner 노드 위에 마우스 포인터를 올려놓고 속성을 클릭합니다.

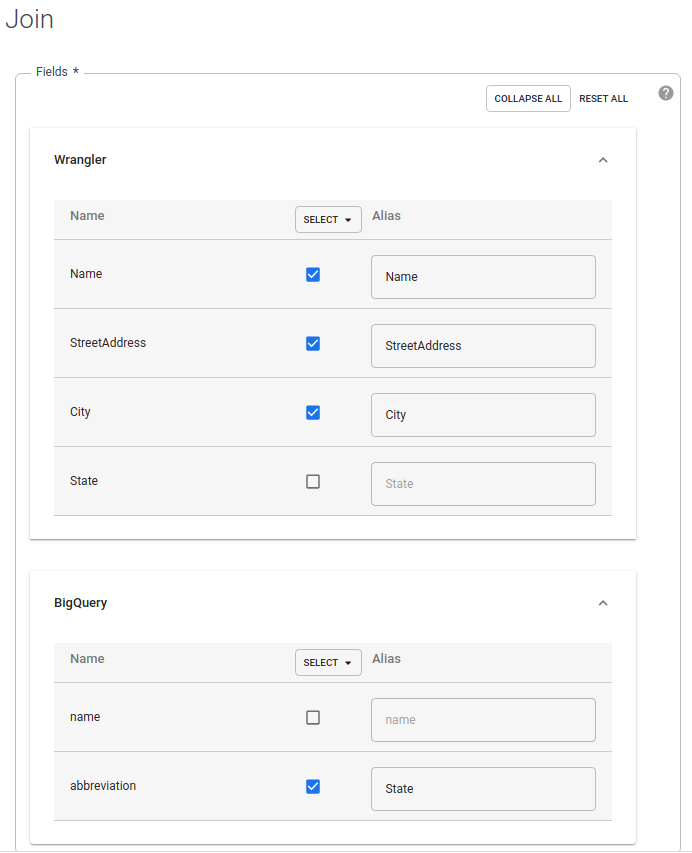

필드 섹션에서 Wrangler와 BigQuery를 펼칩니다.

- Wrangler 주 체크박스를 선택 해제합니다.

- 주 전체 이름이 아니라 축약된 주 이름만 필요하므로 BigQuery 이름 체크박스를 선택 해제합니다.

BigQuery 약어 체크박스를 선택한 상태로 두고 별칭을

State로 변경합니다.

조인 유형 필드에서 값을 외부로 둡니다. 필수 입력에서 Wrangler 체크박스를 선택합니다.

조인 조건 섹션에서 Wrangler에 주를 선택합니다. BigQuery의 경우 이름을 선택합니다.

결과 조인의 스키마를 생성합니다. 스키마 가져오기를 클릭합니다.

검증을 클릭합니다.

닫기를 클릭합니다.

BigQuery에 출력 저장

파이프라인 결과를 BigQuery 테이블에 저장합니다. 데이터를 저장하는 위치를 싱크라고 합니다.

- Cloud Data Fusion Studio 페이지로 이동하여 싱크를 펼칩니다.

- BigQuery를 클릭합니다.

Joiner 노드를 BigQuery 노드에 연결합니다.

BigQuery 노드 위에 마우스 포인터를 올려놓고 속성을 클릭합니다.

- 데이터 세트 필드에

dis_user_guide를 입력합니다. - 테이블 필드에서

customer_data_abbreviated_states를 선택합니다. - 닫기를 클릭합니다.

- 데이터 세트 필드에

파이프라인 배포 및 실행

- Studio 페이지에서 파이프라인 이름 지정을 클릭하고

CampaignPipeline을 입력합니다. - 저장을 클릭합니다.

- 오른쪽 상단 모서리에 있는 배포를 클릭합니다.

- 배포가 완료되면 실행을 클릭합니다.

파이프라인을 실행하는 데 몇 분 정도 걸릴 수 있습니다. 기다리는 동안 파이프라인 전환 상태가 Provisioning(프로비저닝 중) > Starting(시작 중) > Running(실행 중) > Deprovisioning(프로비저닝 해제 중) > Succeeded(성공)로 진행되는 과정을 확인할 수 있습니다.

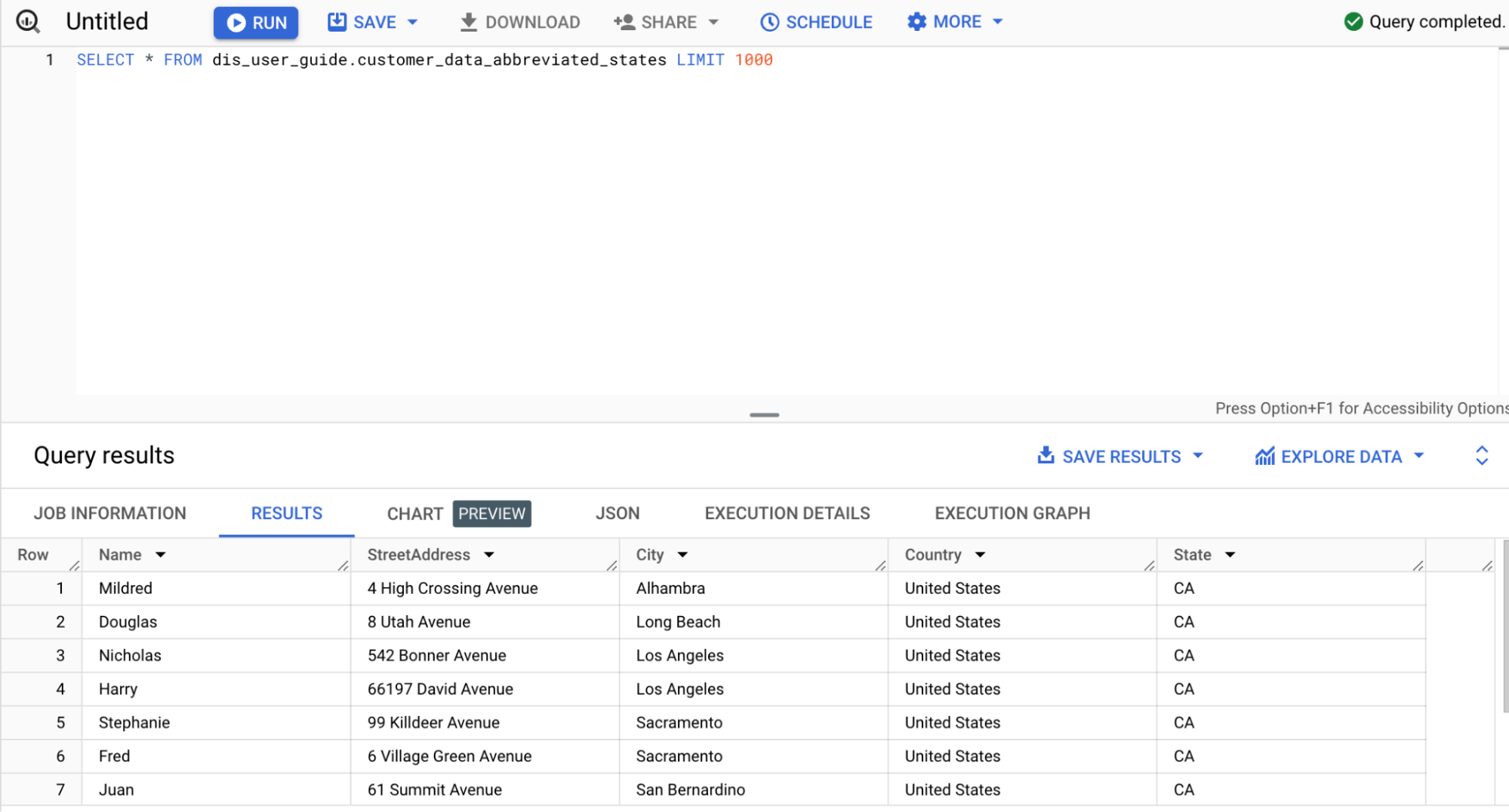

결과 보기

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

SQL 쿼리 만들기를 클릭합니다.

customer_data_abbreviated_states테이블을 쿼리합니다.SELECT * FROM dis_user_guide.customer_data_abbreviated_states LIMIT 1000

데이터 파이프라인이 생성되었습니다.

삭제

이 페이지에서 사용한 리소스 비용이 Google Cloud 계정에 청구되지 않도록 하려면 다음 단계를 수행합니다.

BigQuery 데이터 세트 삭제

이 튜토리얼에서 만든 BigQuery 데이터 세트를 삭제하려면 다음을 수행합니다.

- Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

dis_user_guide데이터 세트를 선택합니다.- delete 데이터 세트 삭제를 클릭합니다.

Cloud Data Fusion 인스턴스 삭제

다음 안내에 따라 Cloud Data Fusion 인스턴스를 삭제합니다.

프로젝트 삭제

비용이 청구되지 않도록 하는 가장 쉬운 방법은 튜토리얼에서 만든 프로젝트를 삭제하는 것입니다.

프로젝트를 삭제하는 방법은 다음과 같습니다.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

다음 단계

- Cloud Data Fusion 자세히 알아보기